實時文生圖速度提升5-10倍,清華LCM/LCM-LoRA爆火,瀏覽超百萬

文生圖、圖生圖已經不是什么新鮮事。但在使用這些工具的過程中,我們發現它們通常運行緩慢,導致我們要等一段時間才能拿到生成結果。

但最近,一種名叫「LCM」的模型改變了這種情況,它甚至能做到實時的連續生圖。

圖源:https://twitter.com/javilopen/status/1724398666889224590

LCM 的全稱是 Latent Consistency Models(潛在一致性模型),由清華大學交叉信息研究院的研究者們構建。在這個模型發布之前,Stable Diffusion 等潛在擴散模型(LDM)由于迭代采樣過程計算量大,生成速度非常緩慢。通過一些創新性的方法,LCM 只用少數的幾步推理就能生成高分辨率圖像。據統計,LCM 能將主流文生圖模型的效率提高 5-10 倍,所以能呈現出實時的效果。

- 論文鏈接:https://arxiv.org/pdf/2310.04378.pdf

- 項目地址:https://github.com/luosiallen/latent-consistency-model

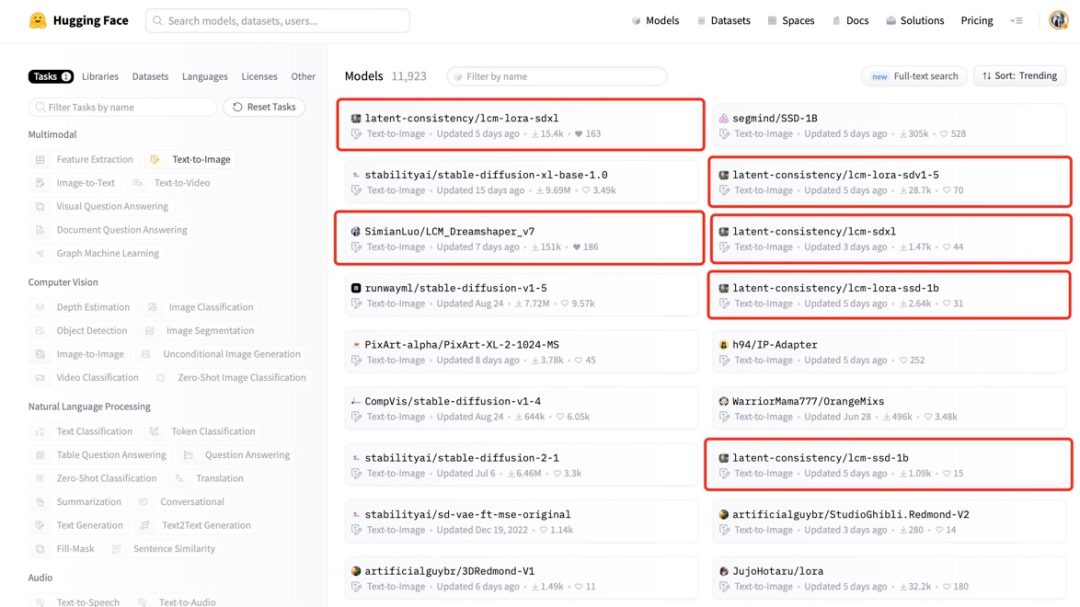

該文章發布一個月內瀏覽量超百萬,作者也被邀請在 Hugging Face、Replicate、浦源等多個平臺部署新研發的 LCM 模型和 demo。其中 Hugging Face 平臺上 LCM 模型下載量已超 20 萬次,而在 Replicate 中在線 API 調用已超 54 萬次。

在此基礎上,研究團隊進一步提出 LCM-LoRA,可以將 LCM 的快速采樣能力在未經任何額外訓練的情況下遷移到其他 LoRA 模型上,為開源社區已經存在的大量不同畫風的模型提供了一個直接而有效的解決方案。

技術報告鏈接:https://arxiv.org/pdf/2311.05556.pdf

潛在一致性模型的快速生成能力為圖像生成技術開辟了新的應用領域。這種模型可以快速地根據輸入的文本(Prompt)處理和渲染實時捕捉到的畫面,從而實現高速圖像生成。這意味著用戶可以自定義他們想要展示的場景或視覺效果。

在 X 平臺上,不少研究者也曬出了他們利用該模型實現的生成效果,包括圖生圖、視頻生成、圖像編輯、實時視頻渲染等各類應用。

圖源:https://twitter.com/javilopen/status/1724398666889224590

圖源:https://twitter.com/javilopen/status/1724398708052414748

作者團隊現已完全開源 LCM 的代碼,并開放了基于 SD-v1.5、SDXL 等預訓練模型在內蒸餾得到的模型權重文件和在線 demo。此外,Hugging Face 團隊已經將潛在一致性模型集成進入 diffusers 官方倉庫,并在兩個接連的正式版本 v0.22.0 和 v0.23.0 中先后更新了 LCM 和 LCM-LoRA 的相關代碼框架,提供了對潛在一致性模型的良好支持。在 Hugging Face 上開放的模型在今日的熱度榜中達到全平臺文生圖模型熱度第一,全類別模型熱度第三。

接下來,我們將分別介紹 LCM 和 LCM-LoRA 這兩項研究成果。

LCM:只用幾步推理就能生成高分辨率圖像

AIGC 時代,包括 Stable Diffusion 和 DALL-E 3 等基于擴散模型的文生圖模型受到了廣泛關注。擴散模型通過向訓練數據添加噪聲,然后逆轉這一過程來生成高質量圖像。然而,擴散模型生成圖片需要進行多步采樣,這一過程相對較慢,增加了推理成本。緩慢的多步采樣問題是部署這類模型時的主要瓶頸。

OpenAI 的宋飏博士在今年提出的一致性模型(Consistency Model,CM)為解決上述問題提供了一個思路。一致性模型被指出在設計上具有單步生成的能力,展現出極大的加速擴散模型的生成的潛力。然而,由于一致性模型局限于無條件圖片生成,導致包括文生圖、圖生圖等在內的許多實際應用還難以享受這一模型的潛在優勢。

潛在一致性模型(Latent Consistency Model,LCM)就是為解決上述問題而誕生的。潛在一致性模型支持給定條件的圖像生成任務,并結合了潛在編碼、無分類器引導等諸多在擴散模型中被廣泛應用的技術,大大加速了條件去噪過程,為諸多具有實際應用意義的任務打開了一條通路。

LCM 技術細節

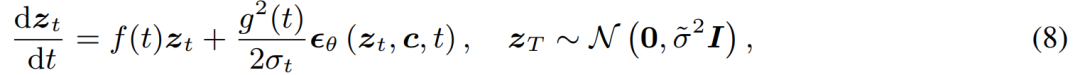

具體而言,潛在一致性模型將擴散模型的去噪問題解讀為求解如下所示的增廣概率流常微分方程的過程。

傳統的擴散模型采用數值方法對常微分方程進行迭代求解,雖然可以通過設計更加精確的求解器來改善每一步的求解精度,減少所需要的迭代次數,但是這些方法中最好的也仍然需要 10 步左右的迭代步數來得到足夠好的求解結果。

不同于迭代求解這一常微分方程,潛在一致性模型要求對常微分方程進行直接的單步求解,直接預測方程的最終解,從而在理論上能夠在單步內生成圖片。

為了訓練得到潛在一致性模型,該研究指出可以通過對于預訓練的擴散模型(例如,Stable Diffusion)進行參數微調,在極少的資源消耗下賦予模型快速生成的效果。這一蒸餾過程基于對宋飏博士提出的一致性損失函數的優化。為了在文生圖任務上獲得更好的表現并減少計算開銷,本文提出了三點關鍵技術:

(1)使用預訓練的自動編碼器將原始圖片編碼到潛在空間,在壓縮圖片中冗余信息的同時讓圖片在語義上具有更好的一致性;

(2)將無分類器引導作為模型的一個輸入參數蒸餾進潛在一致性模型中,在享受無分類器引導帶來的更好的圖片 - 文本的一致性的同時,由于無分類器引導幅度被作為輸入參數蒸餾進了潛在一致性模型,從而能夠減少推理時的所需要的計算開銷;

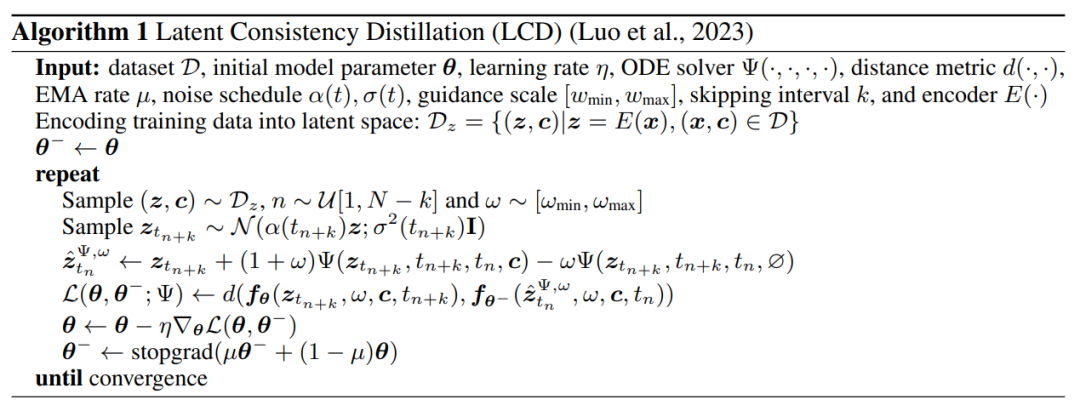

(3)使用跳步策略來計算一致性損失,大大加快了潛在一致性模型的蒸餾過程。潛在一致性模型的蒸餾算法的偽代碼見下圖。

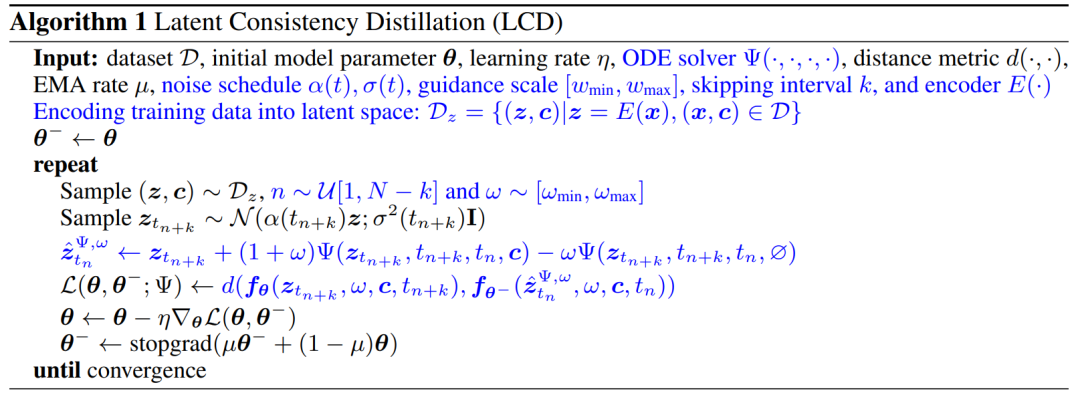

定性和定量化的結果展示了潛在一致性模型的快速生成能力,該模型能夠在 1~4 步內生成高質量圖片。通過比較實際的推理時間和生成質量指標 FID,可以看到,潛在一致性模型相比于現有的最快的采樣器之一的 DPM solver++ 能夠在保持同等生成質量的前提下實現約 4 倍的實際推理時間加速。

LCM 生成的圖像

LCM-LORA: 一個通用的 Stable Diffusion 加速模塊

在潛在一致性模型的基礎上,作者團隊隨后進一步發布了他們關于 LCM-LoRA 的技術報告。由于潛在一致性模型的蒸餾過程可以被視作是對于原有的預訓練模型的微調過程,從而可以使用 LoRA 等高效微調技術來訓練潛在一致性模型。得益于 LoRA 技術帶來的資源節省,作者團隊在 Stable Diffusion 系列中參數量最大的 SDXL 模型上進行了蒸餾,成功得到了能夠在極少步數內生成與 SDXL 數十步相媲美的潛在一致性模型。

在論文 INTRODUCTION 部分,該研究表示盡管潛在擴散模型(LDM)在文生圖、線稿生圖等方面取得了成功,但其固有的緩慢反向采樣過程阻礙了實時應用,影響了用戶體驗。目前的開源模型和加速技術還無法在標準消費級 GPU 上實現實時生成。

加速 LDM 的方法一般分為兩類:第一類涉及先進的 ODE 求解器,如 DDIM、DPMSolver 和 DPM-Solver++,以加快生成過程。第二類涉及蒸餾 LDM 以簡化其功能。ODE - 求解器減少了推理步驟,但仍需要大量的計算開銷,尤其是在采用無分類器指導時。同時,蒸餾方法(如 Guided-Distill)雖然前景廣闊,但由于其密集的計算要求而面臨實際限制。在 LDM 生成圖像的速度和質量之間尋求平衡仍然是該領域的一項挑戰。

最近,受一致性模型(Consistency Model,CM)的啟發,潛在一致性模型(Latent Consistency Model,LCM)出現了,作為圖像生成中緩慢采樣問題的一種解決方案。LCM 將反向擴散過程視為增強概率流 ODE(PF-ODE)問題。這類模型創新性地預測了潛空間中的解,不需要通過數值 ODE 求解器進行迭代求解。因此,它們合成高分辨率圖像的效率非常高,只需 1 到 4 個推理步驟。此外,LCM 在蒸餾效率方面也很突出,只需用 A100 個訓練 32 個小時就能完成最小步驟的推理。

在此基礎上,Latent Consistency Finetuning(LCF)被開發為一種無需從教師擴散模型開始就能對預訓練 LCM 進行微調的方法。對于專業數據集,如動漫、真實照片或奇幻圖像數據集,它還需要額外的步驟,如采用潛在一致性蒸餾法(LCD)將預訓練的 LDM 蒸餾為 LCM,或直接使用 LCF 對 LCM 進行微調。然而,這種額外的訓練可能會阻礙 LCM 在不同數據集上的快速部署,這就提出了一個關鍵問題:是否可以在自定義數據集上實現快速、無需訓練的推理。

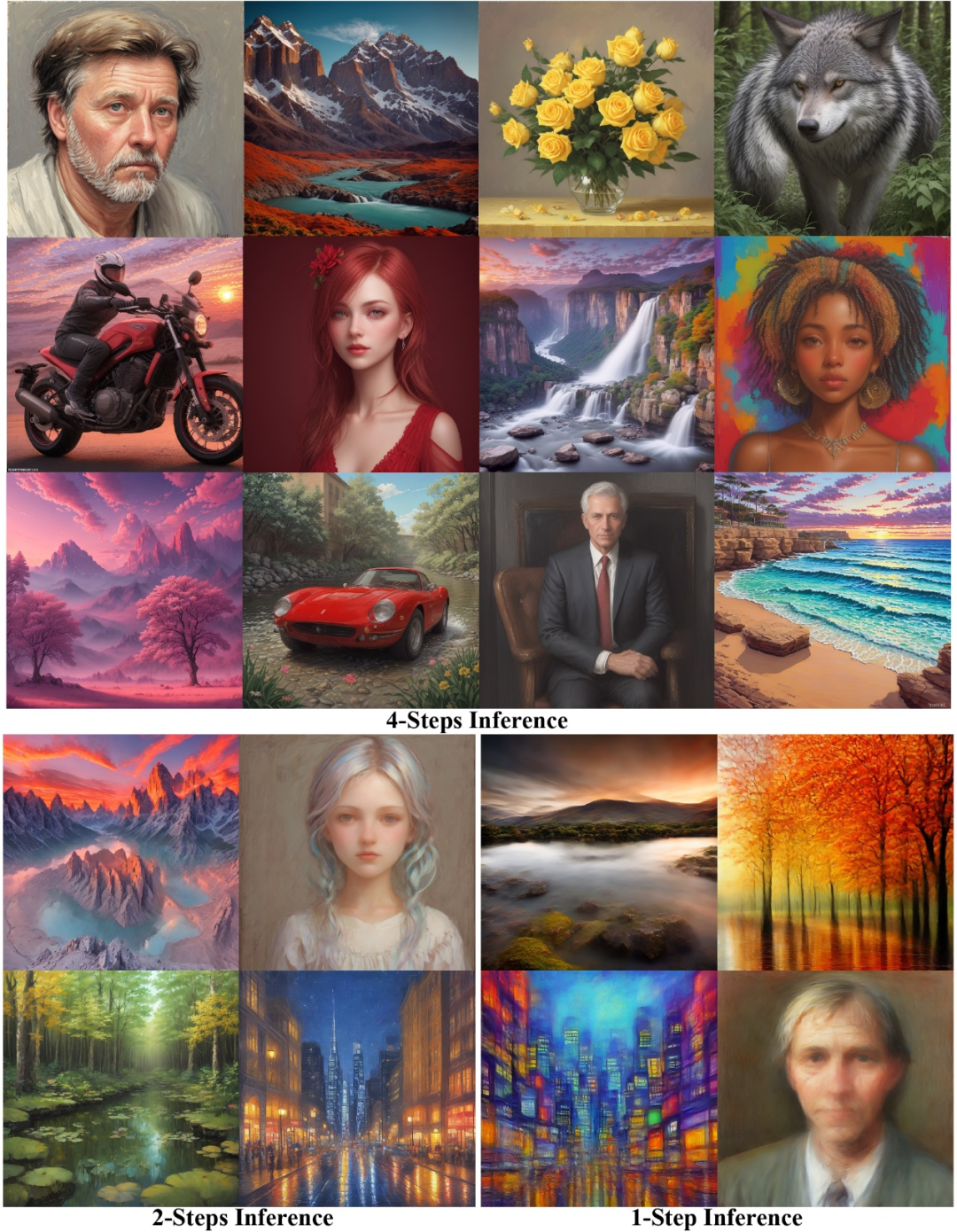

為了回答上述問題,研究者提出了 LCM-LoRA,它是一種通用的免訓練加速模塊,可以直接插入各種 Stable-Diffusion(SD)微調模型或 SD LoRA 中,以最少的步驟支持快速推理。與 DDIM、DPM-Solver 和 DPM-Solver++ 等早期數值概率流 ODE(PF-ODE)求解器相比,LCM-LoRA 代表了一類基于神經網絡的新型 PF-ODE 求解器模塊。它在各種微調的 SD 模型和 LoRA 中展示了強大的泛化能力。

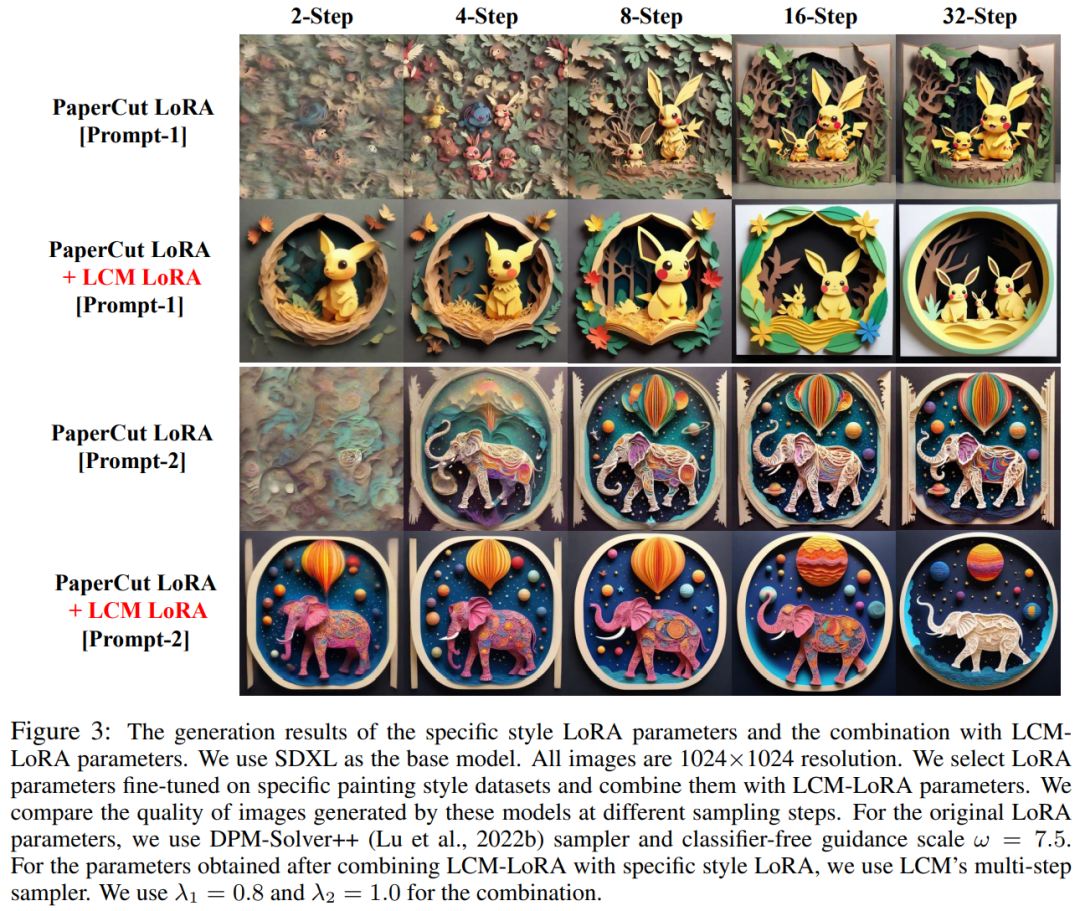

LCM-LoRA 概況圖。通過在 LCM 的蒸餾過程中引入 LoRA,該研究大大減少了蒸餾的內存開銷,這使得他們能夠利用有限的資源訓練更大的模型,例如 SDXL 和 SSD-1B。更重要的是,通過 LCM-LoRA 訓練獲得的 LoRA 參數(acceleration vector)可以直接與在特定風格數據集上微調獲得的其他 LoRA 參數(style vetcor)相結合。無需任何訓練,通過 acceleration vector 和 style vetcor 的線性組合獲得的模型就能以最少的采樣步驟生成特定繪畫風格的圖像。

LCM-LoRA 技術細節

通常來講,潛在一致性模型的訓練采用單階段指導蒸餾方式進行,這種方法利用預訓練的自編碼器潛在空間將指導擴散模型蒸餾為 LCM。此過程涉及增強概率流 ODE,我們可以將其理解為一種數學公式,這樣一來可確保生成的樣本遵循生成高質量圖像的軌跡。

值得一提的是,蒸餾的重點是保持這些軌跡的保真度,同時顯著減少所需的采樣步驟數量。算法 1 提供了 LCD 的偽代碼。

由于 LCM 的蒸餾過程是在預訓練擴散模型的參數上進行的,因此我們可以將潛在一致性蒸餾視為擴散模型的微調過程,從而就可以采用一些高效的調參方法,如 LoRA。

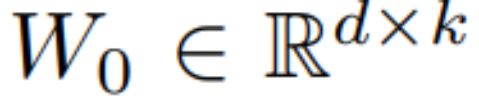

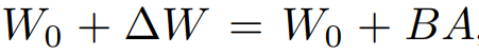

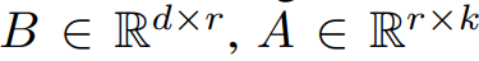

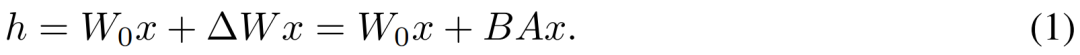

LoRA 通過應用低秩分解來更新預訓練的權重矩陣。具體而言,給定一個權重矩陣 ,其更新方式表述為

,其更新方式表述為 ,其中

,其中 ,訓練過程中,W_0 保持不變,梯度更新只應用于 A 和 B 兩個參數。因而對于輸入 x,前向傳播的更改表述為:

,訓練過程中,W_0 保持不變,梯度更新只應用于 A 和 B 兩個參數。因而對于輸入 x,前向傳播的更改表述為:

h 代表輸出向量,從公式(1)可以觀察到,通過將完整參數矩陣分解為兩個低秩矩陣的乘積,LoRA 顯著減少了可訓練參數的數量,從而降低了內存使用量。

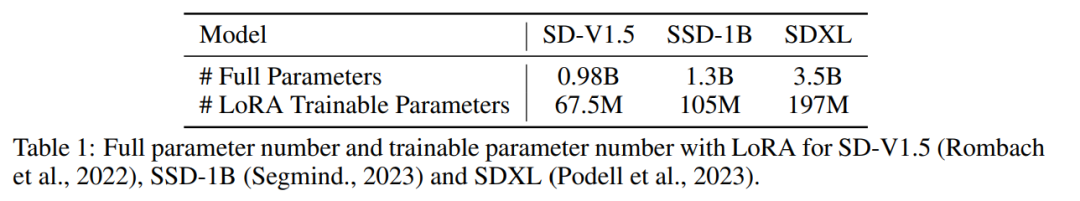

下表將完整模型中的參數總數與使用 LoRA 技術時的可訓練參數進行了比較。顯然,通過在 LCM 蒸餾過程中結合 LoRA 技術,可訓練參數的數量顯著減少,有效降低了訓練的內存需求。

該研究通過一系列實驗表明 :LCD 范式可以很好地適應更大的模型如 SDXL 、 SSD-1B ,不同模型的生成結果如圖 2 所示。

除了使用 LoRA 技術來讓蒸餾過程更加高效,作者還發現了由此訓練得到的 LoRA 參數可以被作為一種泛用的加速模塊,直接與其他 LoRA 參數結合。

如上圖 1 所示,作者團隊發現,只需要將在特定風格數據集上微調得到的 “風格參數” 與經過潛在一致性蒸餾得到的 “加速參數” 進行簡單的線性組合,就可以獲得兼具快速生成能力和特定風格的全新潛在一致性模型。這一發現為現有開源社區內已存在的大量開源模型提供了極強的助力,使得這些模型甚至可以在無需任何額外訓練的情況下享受潛在一致性模型帶來的加速效果。

下圖展示了使用這一方法改善 “剪紙畫風” 模型后得到的新的模型的生成效果。

總之,LCM-LoRA 是一種用于 Stable-Diffusion (SD) 模型的通用免訓練加速模塊。其可以作為獨立且高效的基于神經網絡的求解器模塊來預測 PF-ODE 的解,從而能夠在各種微調的 SD 模型和 SD LoRA 上以最少的步驟進行快速推理。大量的文本到圖像生成實驗證明了 LCM-LoRA 強大的泛化能力和優越性。

團隊介紹

論文作者成員全部來自清華叉院,兩位共同一作分別是駱思勉,譚亦欽。

駱思勉是清華叉院二年級碩士,導師為趙行老師。本科畢業于復旦大學大數據學院。研究方向為多模態生成模型,研究興趣為擴散模型,一致性模型,AIGC加速,致力于研發下一代生成模型。此前也以一作身份多篇論文發表在ICCV,NeurIPS頂會上。

譚亦欽是清華叉院二年級碩士,導師為黃隆波老師。本科畢業于清華大學電子工程系。研究方向包括深度強化學習、擴散模型。此前以一作身份在ICLR等會議上發表spotlight論文和口頭報告。

值得一提的是,兩位共一是在叉院李建老師的高等計算機理論課上,提出了LCM的想法,并最后作為期末課程項目進行了展示。三位指導老師中,李建和黃隆波是清華交叉信息院副教授,趙行是清華交叉信息院助理教授。

第一行(從左到右):駱思勉、譚亦欽。第二行(從左到右):黃隆波、李建、趙行。