更高清寫實的人體生成模型HyperHuman來了,基于隱式結構擴散,刷新多項SOTA

- 論文地址: https://arxiv.org/pdf/2310.08579.pdf

- Github 地址: https://github.com/snap-research/HyperHuman

1. 研究背景與動機

隨著擴散模型的興起,一些典型的模型例如 Stable Diffusion, DALL-E 2 等在文本生成圖像任務上展現了令人震撼的能力。但一個明顯的不足是,這些模型在文本生成人體圖片的任務上表現得不盡如人意,甚至很難生成具有合理結構或自然姿態的人體(例如正確的四肢數目和符合人體物理結構的幾何拓撲)。背后的主要原因在于:自然環境下的人體是鉸接的,且包含剛性和非剛性的形變;生成高質量的人體圖片需要文本難以描述的結構信息。

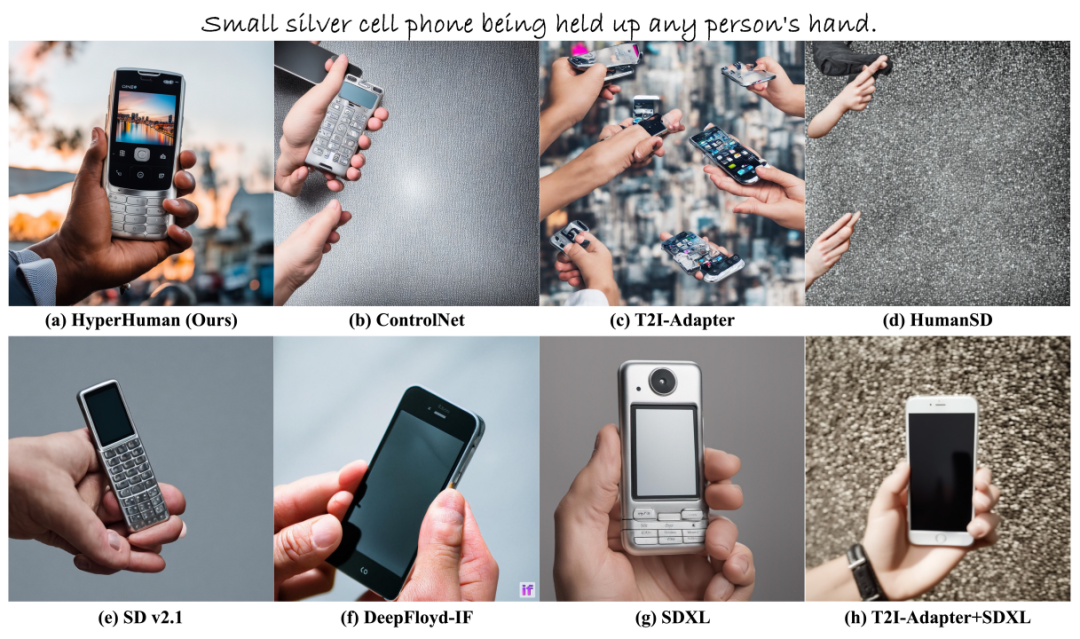

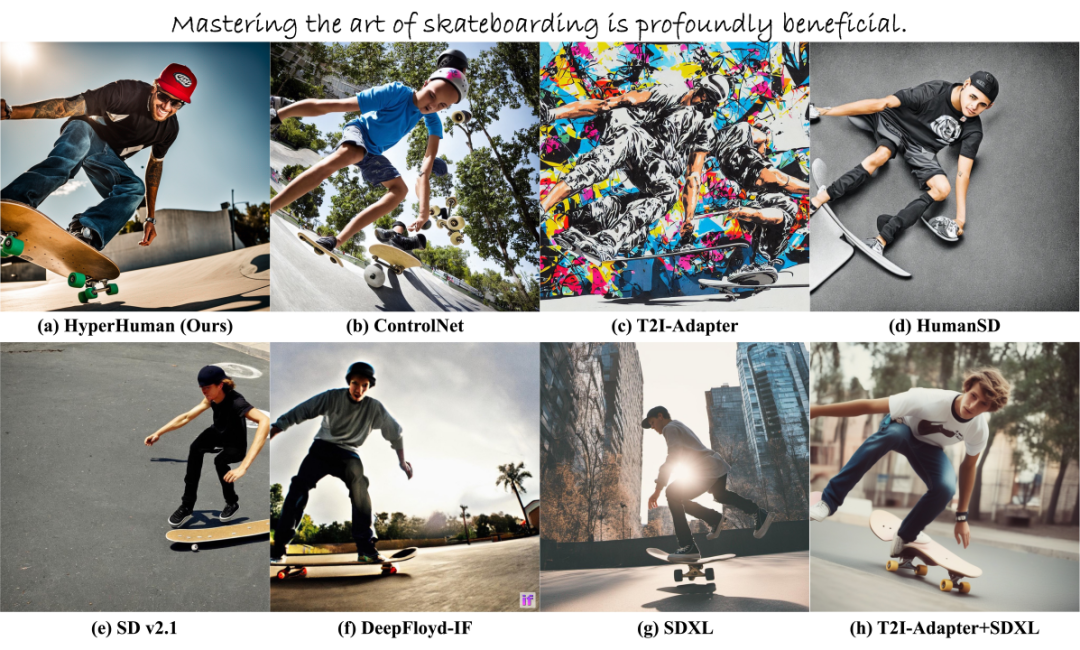

為了在文生圖中引入結構控制信息,近期的代表工作如 ControlNet [1],T2I-Adapter [2] 添加了非常輕量的、即插即用的可學習分支,用以調節預訓練的文生圖擴散模型。然而,原本擴散模型分支和新加入的可學習分支之間的特征差距,往往會導致生成結果與控制信號的不一致。

為了解決這個問題, HumanSD [3] 使用了一種原生的控制引導方式,即直接將人體骨架圖與擴散模型輸入在特征維度進行拼接。盡管一定程度上解決了生成 - 條件不對齊的問題,但局限于生成藝術畫風的圖片,在生成質量、多樣性以及寫實性上仍有欠缺。此外,之前的大部分工作僅僅把控制信號作為一種輸入或引導條件,卻忽略了人體外觀與不同結構信息之間多層級的關聯。如何生成一個逼真的、結構合理的人體圖片仍然是一個未解決的問題。

在本文中,Snap 研究院、香港中文大學、香港大學、南洋理工大學團隊推出了最新的高寫實人體生成模型 HyperHuman,通過對顯式的人體外觀與隱式的多層級人體結構進行聯合學習,在 zero-shot 的 MS-COCO 數據集上取得了最佳的圖片質量(FID, FID_CLIP, KID)與生成 - 人體姿態一致性(AP, AR)指標結果,且獲得了優異的文本 - 圖像對齊指標(CLIP score)結果,并在廣泛的用戶主觀評測中取得了最優的結果。

2. 核心方法

為了引入人體骨架圖以進行姿態控制,最簡單的方法是通過特征殘差或輸入串聯。然而,這種做法仍然存在幾個問題:(1)稀疏關鍵點僅描繪了粗略的人體結構,而忽略了細粒度的人體幾何結構和前景 - 背景關系。此外,原始的擴散模型訓練僅由 RGB 信號進行監督,無法獲得數據集圖片中蘊含的結構信息。(2)圖像 RGB 和結構表示在空間上對齊,但在特征空間分布上有很大的不同。如何對它們進行聯合建模仍然具有挑戰性。

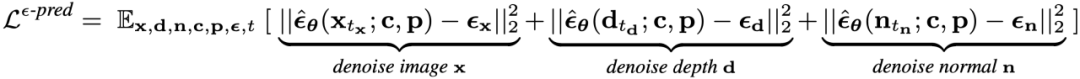

(1)Unified Model for Simultaneous Denoising.

我們對第一個問題的解決方案是同時對深度圖、表面法向圖以及合成的 RGB 圖像進行去噪。選擇它們作為額外的學習目標有兩個原因:1)深度和表面法向可以很容易地對大規模數據集進行自動標注獲得,這也被廣泛用于最近的可控文生圖模型中 [1,2] 。2) 作為兩種常用的結構指導,它們補充了空間關系和幾何信息,其中深度圖和表面法向圖在最近的三維視覺研究中被證明是大有幫助的 [4] 。為此,一種簡單的方法是訓練三個獨立的網絡來分別對 RGB、深度圖和表面法向進行去噪。但它們之間的空間對齊性很難保持。因此,我們提出在統一的模型框架中通過同時去噪來學習三者的聯合分布,可以用如下損失函數進行訓練:

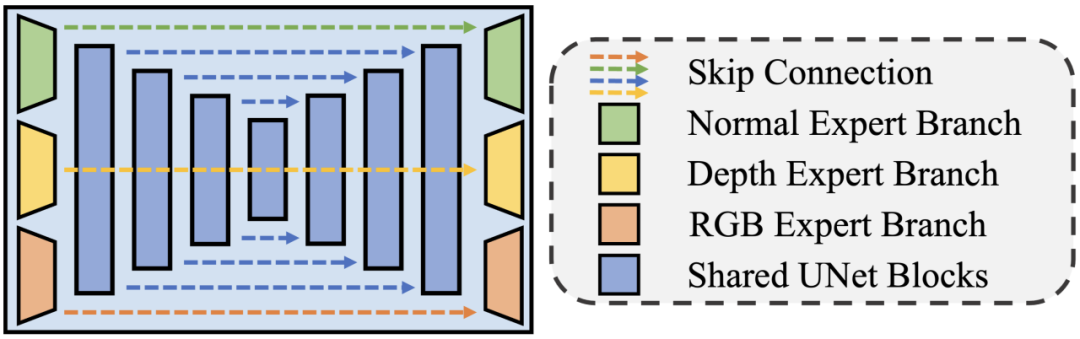

(2)Structural Expert Branches with Shared Backbone.

為了能讓一個擴散模型的 UNet 同時處理來自三個不同分布的 RGB、深度圖、表面法向圖,并且為三種模態分別輸出去噪信號,我們提出對 UNet 骨干網絡的最前幾層降采樣模塊和最后幾層上采樣模塊進行復制,用以作為三種不同學習目標的結構專家去噪分支。實驗發現,模塊復制的層數會權衡三種輸出之間的空間對齊性以及各自的分布學習精準度:(1)一方面,更少的獨立分支參數 + 更多的共享骨干網絡參數能帶來更強的輸出相似性,從而讓擴散模型輸出的 RGB、深度圖、表面法向圖在空間上更加對齊。(2)另一方面,一組對應的 RGB、深度圖、表面法向圖可以看做是同一張圖片的不同形態。在經過共享骨干網絡后,我們可以得到相同的中間層網絡特征。根據相同的特征得到同一張圖的不同形態 / 表征 / 風格,在本質上和圖片 - 圖片變換問題 (Image-to-Image Translation) 非常相似。所以,我們有需要有足夠多的獨立網絡參數來完成這個任務。可以考慮一個極端的例子:如果不同去噪分支的參數只包含一層 conv 層,那么我們就需要僅用一層卷積網絡把同樣的特征映射到 RGB、深度圖和表面法向圖輸出,這顯然是無法做到的。經過充分的實驗后,我們選擇拷貝原始擴散模型 UNet 的輸入卷積層(conv_in)、第一層降采樣模塊 (DownBlock)、最后一層上采樣模塊(UpBlock),以及輸出卷積層(conv_out)。這樣既保證了輸出的 RGB、深度圖和表面法向圖之間的空間對齊,又能對三種不同模態的表征分布進行準確的學習,具體的網絡結構示意圖如下:

除了以上兩個主要貢獻,文中還有對聯合學習中的噪聲層級采樣策略以及如何利用一階段估計的結構信息得到更高分辨率、更細節、更逼真的生成結果進行了精心設計,具體內容請參考論文。

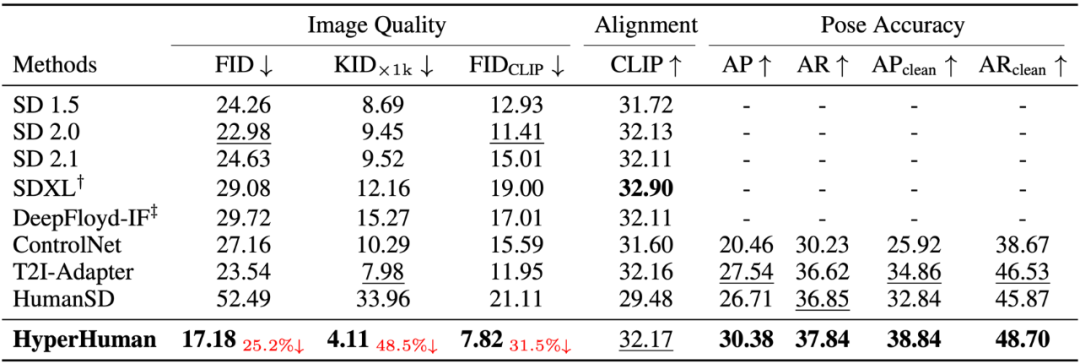

3. 實驗結果

HyperHuman 在 zero-shot 的 MS-COCO 數據集上取得了最佳的圖片質量(FID, FID_CLIP, KID)與生成 - 人體姿態一致性(AP, AR)指標結果,且獲得了優異的文本 - 圖像對齊指標(CLIP score)結果。其中,SDXL [5] 使用了兩個文本編碼器,并且使用了 3 倍大小的擴散模型 UNet 骨干網絡,因而具有更多的文本 - 圖像 cross-attention 層,在 CLIP score 上表現最佳。盡管如此,HyperHuman 在 CLIP score 上仍然取得了相似的結果,并且和其余具有相同文本編碼器參數的文生圖模型相比,具有更優的文本 - 圖像一致性表現:

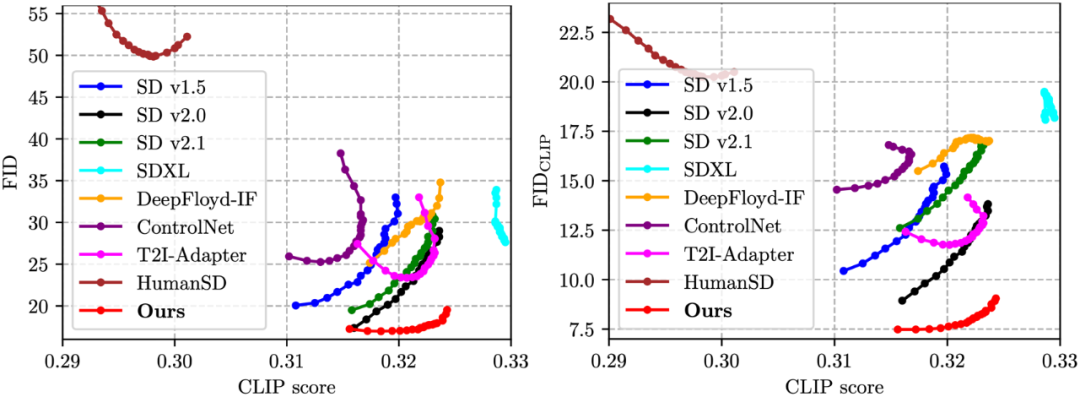

此外,我們還額外展示了 FID-CLIP 以及 FID_CLIP-CLIP 曲線,用以展示不同模型在不同 Classifier-free Guidance (CFG)下的表現。我們可以看到,HyperHuman 可以很好地對圖片生成質量以及圖文一致性進行權衡,尤其是在大家實際場景下會使用的 CFG 數值取得了明顯的提升(即圖片右下角的區域):

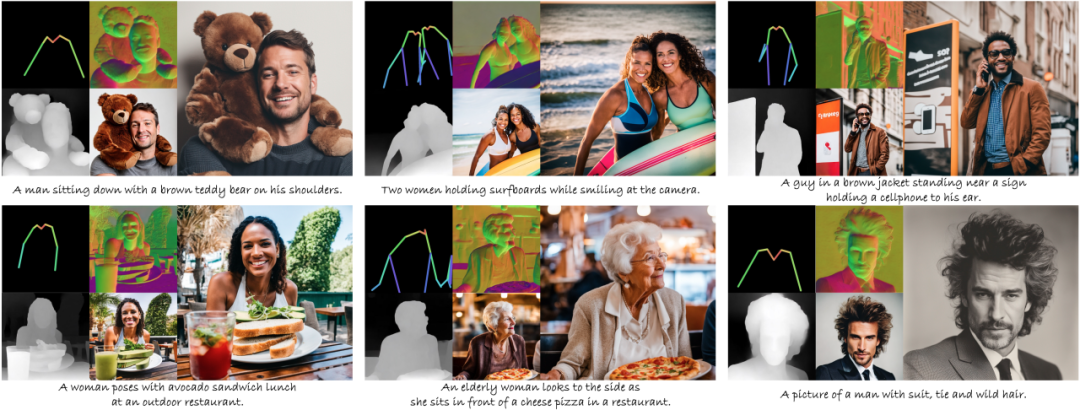

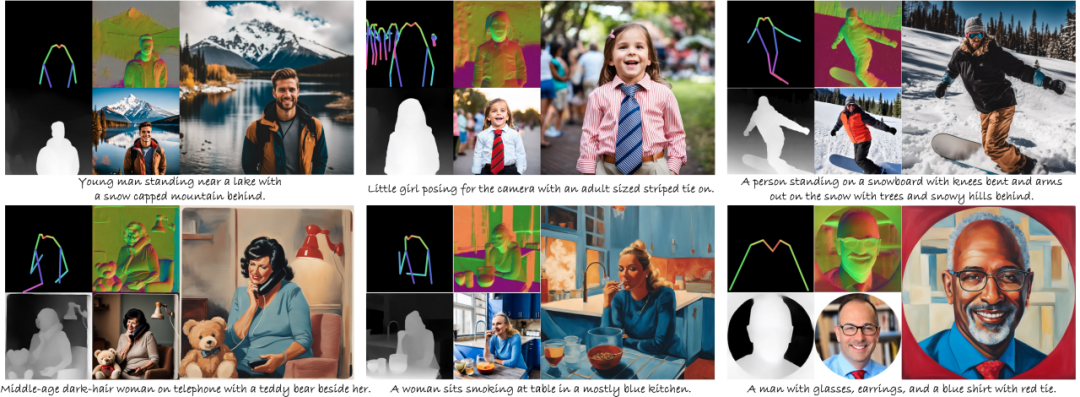

下面是一些 HyperHuman 生成的樣本。其中在左側的 2x2 網格中,左上角是輸入的人體骨架圖,其余三個分別是同時去噪生成的表面法向圖、深度圖以及一階段 512x512 分辨率的 RGB 圖片結果;右側是 1024x1024 分辨率下的高清圖片生成結果:

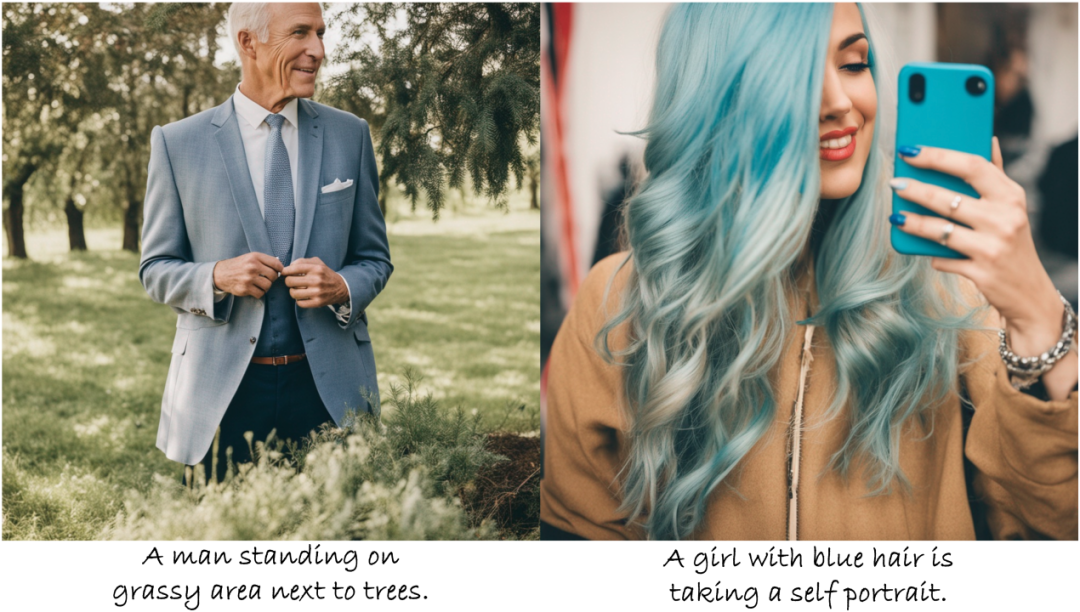

以下是更多高清的生成結果:

以下是與以往工作生成結果的對比:

更多樣本請參考文章附錄。

3. 總結與未來工作

本文提出 HyperHuman,一種高寫實的人體生成模型。HyperHuman 提出兩點核心貢獻:(1)設計了隱式結構去噪模型,通過同時去噪獲得圖像 RGB、深度圖以及表面法向圖,用統一的框架刻畫了圖片的外觀紋理、空間關系以及幾何結構信息;(2)設計了結構引導的精細化模塊,能夠魯棒地根據一階段生成的結構表征獲得高清、高質量的人體生成結果。總體來說,HyperHuman 能夠生成自然場景下多種外觀、多種姿態的高清寫實人,在圖片質量、寫實性、多樣性、可控性等方面均超越了以往的工作。

未來工作:

1. 由于現有的人體姿態、深度圖以及表面法向圖估計網絡在效果上有局限性,一些非常細節的紋理特征諸如眼鏡、手指仍然存在生成誤差。如何有效地解決這些問題,生成超精細粒度的高清人體仍然是值得探索的問題;

2. 目前的框架要求用戶輸入一張骨架圖作為引導,雖然這是一種非常易獲得的控制信號,用戶可以通過拖拽骨骼關鍵點獲得,也增強了用戶的主觀控制性,但仍然使大規模快速使用此模型需要額外的輸入。一種潛在的方式是利用 LLM 由文本生成人體骨架,再使用 HyperHuman 生成高清的人體圖。

更多研究資料見:

- Webpage: https://snap-research.github.io/HyperHuman/

- Short Demo (3min): https://www.youtube.com/watch?v=eRPZW1pwxog

- Long Demo (10min): https://www.youtube.com/watch?v=CxGfbwZOcyU