大模型RLHF不必非得靠人,谷歌:AI反饋效果一樣好

說起現(xiàn)如今訓(xùn)大模型的核心方法,RLHF是繞不開的話題。

RLHF,即基于人類反饋的強化學(xué)習(xí),無論是ChatGPT還是開源的LLaMA都離不開它。

但其中的“H”卻是一大瓶頸,因為收集高質(zhì)量的人類反饋實在是太難了。

那能不能交給AI來做呢?的確有人就這么干了,但能否替代RLHF一直沒有定論,直到Google進行了這項研究。

圖片

圖片

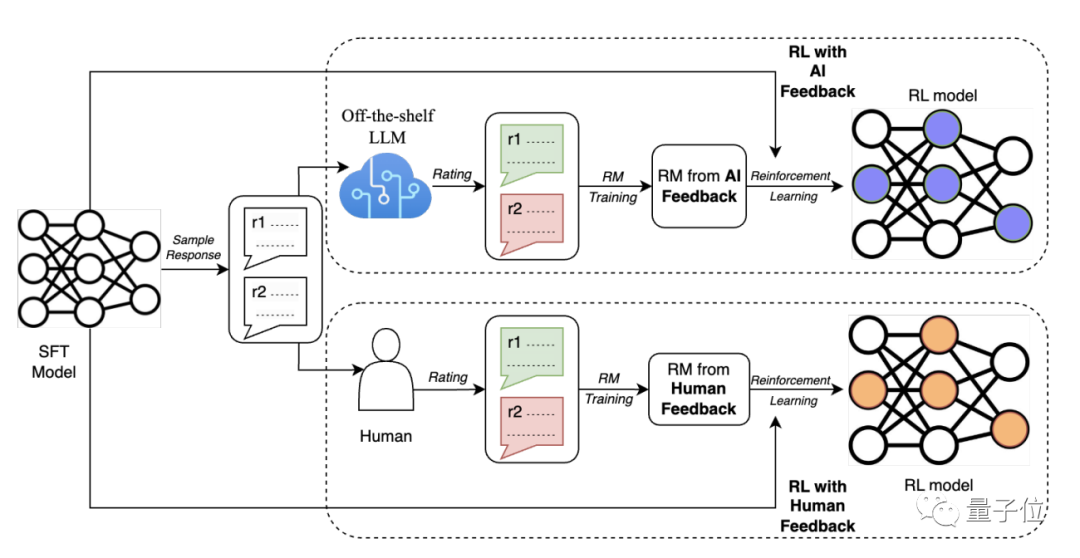

在一篇新發(fā)布的arXiv論文中,Google將RLAIF訓(xùn)練出的模型在文本總結(jié)上的表現(xiàn)與RLHF做了比較。

RLAIF用AI來代替RLHF中的人類,完成生成反饋的工作,讓大模型訓(xùn)練不再受制于人類的局限。

在訓(xùn)練后的人類評價中,人們對RLHF和RLAIF訓(xùn)練后的模型生成的答案傾向性幾乎沒有差別。

甚至在一些細節(jié)上,RLAIF的表現(xiàn)還要優(yōu)于RLHF。

有AI工程師轉(zhuǎn)發(fā)了這篇論文并評論說,到GPT-5的時候可能就不再需要人類數(shù)據(jù)標注員了。

圖片

圖片

在介紹詳細的評測結(jié)果之前,我們不妨先來看看RLAIF的工作流程。

用LLM生成反饋數(shù)據(jù)

其實RLAIF和RLHF差不多,就是把人換成了AI,從字面上也能看出來。

圖片

圖片

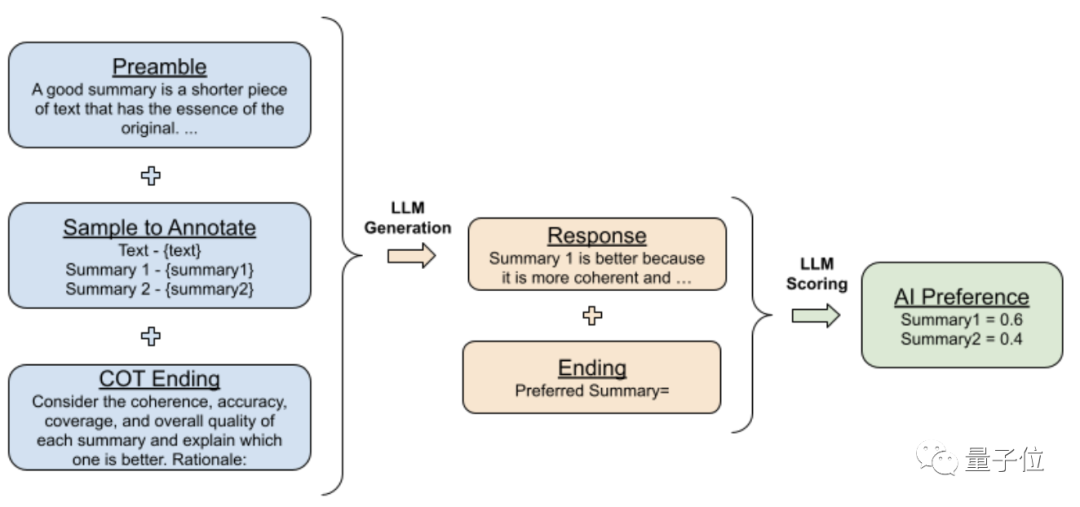

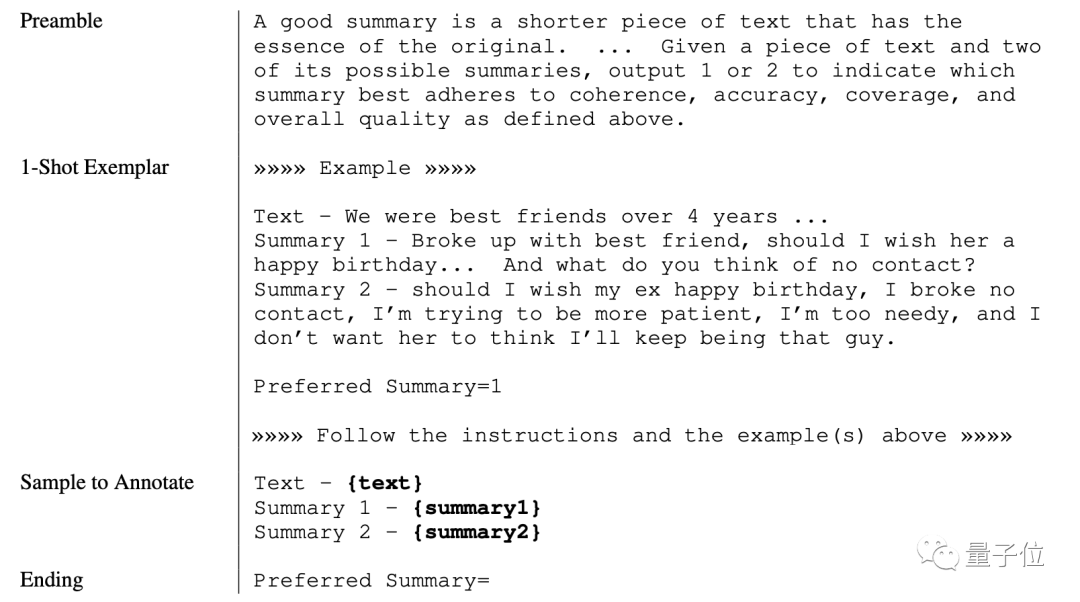

所以重點自然而然地來到了生成反饋內(nèi)容上。

研究人員首先讓AI在兩個答案中進行選擇以獲得反饋。

為了避免隨機性問題,會進行多次選擇,其間還會對選項的順序進行交換。

其中還用到了思維鏈(CoT)的推理模式,以獲取更好的回答。

此外,為了提高LLM的自我一致性,這一過程并非直接二選一,而是分別給兩個答案打分,相加為1。

這套流程走下來的prompt和輸出大概是醬嬸兒的:

圖片

圖片

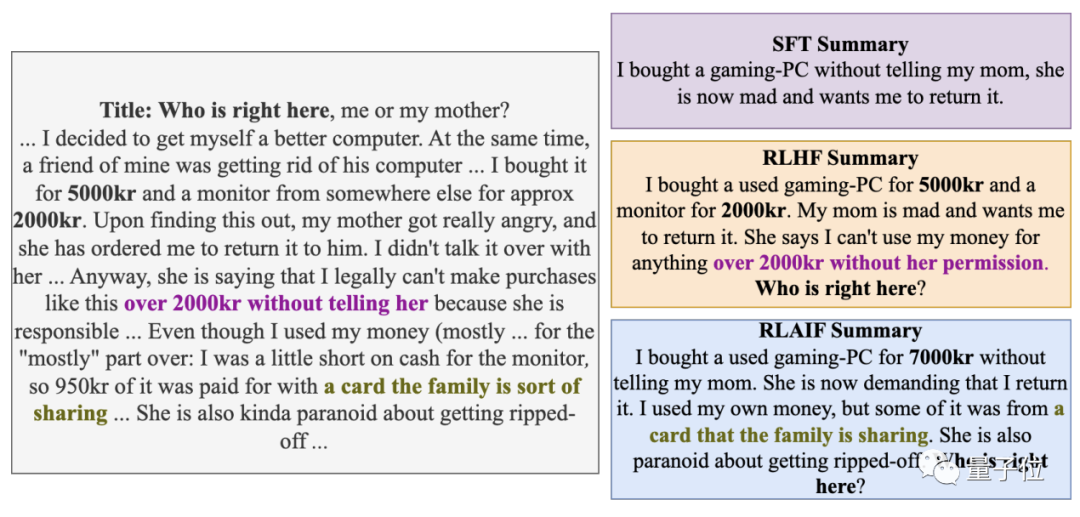

舉個例子:

圖片

圖片

有了這些數(shù)據(jù),就可以拿來訓(xùn)練獎勵模型,進而預(yù)測出偏好分數(shù)了。

接著, 利用訓(xùn)練好的獎勵模型,研究人員讓目標模型進行強化學(xué)習(xí)。

與其他模型常用的PPO(Proximal Policy Optimization)算法不同,RLAIF采用的是更為簡單有效的修改版A2C(Advantage Actor Critic)算法。

當然,也可以不訓(xùn)練獎勵模型,直接用AI生成的標注數(shù)據(jù)進行強化學(xué)習(xí)。

實際上,團隊得到的標注數(shù)據(jù)集比獎勵模型規(guī)模更大也更好用,但考慮這樣消耗的計算成本太高,還是選擇了獎勵模型。

到這里大模型的“課程”就已經(jīng)學(xué)完了,不過要想“畢業(yè)”的話還得再經(jīng)歷一場“考試”才行。

“考試”一共包括下面的三項內(nèi)容:

- AI Labeler Alignment:AI偏好相對于人類偏好的精確程度

- Pairwise Accuracy:訓(xùn)練好的獎勵模型與人類偏好數(shù)據(jù)集的匹配程度

- Win Rate:人類在RLAIF和RLHF生成結(jié)果之間的傾向性

經(jīng)過這樣一番測試之后,強化學(xué)習(xí)終于大功告成。

那么,“AI教出來的學(xué)生”成績究竟怎么樣呢?

測試效果可以與RLHF媲美

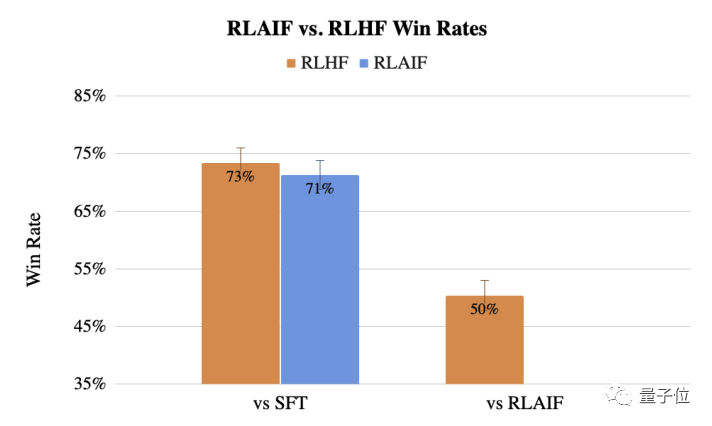

研究團隊找來了1200名人員,在對SFT(基線監(jiān)督微調(diào))、RLHF、RLAIF以及真人給出的答案從優(yōu)質(zhì)到劣質(zhì)進行排序。

圖片

圖片

以SFT方式作為基線,RLHF和RLAIF的Win Rate均超過了70%,也就是說人類對這兩種方式的傾向程度是SFT的將近三倍。

雖然RLHF的表現(xiàn)略勝于RLAIF,但兩者的差距并不明顯。

而若以RLHF作為參照,RLAIF的Win Rate則是50%,說明人類對兩者的傾向程度是一樣的。

圖片

圖片

有趣的是,兩種RL訓(xùn)練出的模型給的結(jié)果都遠遠勝過了真人直接給出的答案。

RLAIF相對于真人的Win Rate高達79%,而RLHF是80%,即傾向性是真人答案的四倍。

此外,在對輸出內(nèi)容進行仔細評估之后,研究人員還發(fā)現(xiàn)RLAIF訓(xùn)練出的模型出現(xiàn)幻覺的概率比RLHF更低,邏輯和語法錯誤也更少。

One More Thing

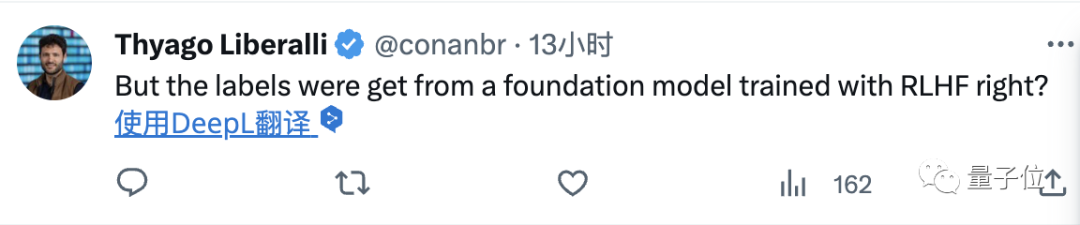

不過對于RLAIF,也有網(wǎng)友發(fā)現(xiàn)了華點:

拿來生成反饋的模型不也是用RLHF訓(xùn)練出來的嗎?

圖片

圖片

而另一邊,RLHF的過程當中,也不能排除有的人在用AI“偷懶”的可能。

圖片

圖片

或許“你中有我,我中有你”才是兩種方式測試結(jié)果這么接近的原因嗎?