GPT-4滿分通過MIT本科數(shù)學考試!卻遭同門質(zhì)疑“作弊”,數(shù)據(jù)集本身就有問題

大數(shù)據(jù)文摘出品

作者:Caleb

這兩天,相信大家都被GPT-4滿分輕松拿下MIT本科數(shù)學考試的事兒給刷屏了。

給先不知情的小伙伴們說一下,這次的測試是MIT、波士頓大學和康奈爾大學的研究團隊共同根據(jù)MIT所有獲得學位所需的數(shù)學、電氣工程和計算機科學 (EECS) 課程整理出來了4550個問題。

參與測試的AI模型有GPT-3.5、GPT-4、StableVicuna-13B、LLaMA-30B和LLaMA-60B。結果嘛,可想而知,GPT-4滿分通過,但GPT-3.5卻只做對了三分之一。

論文鏈接:https://huggingface.co/papers/2306.08997

這樣的結果自然也是吸引到了眾多網(wǎng)友的討論,在網(wǎng)友們的一眾驚呼聲中,三位同樣來自MIT的學生卻發(fā)現(xiàn)了其中端倪。

揭開“網(wǎng)騙”GPT-4的面紗

在6月16日發(fā)現(xiàn)這篇論文后,三人決定深入挖掘一下。但是一小時內(nèi),他們對論文的方法論產(chǎn)生了懷疑,不到兩個小時,他們意識到,數(shù)據(jù)集本身是有問題的。

論文中寫到,研究人員“在沒有圖像和有解決方案的問題中隨機選擇了288個問題的測試集”。這個數(shù)據(jù)集(不包括用于微調(diào)開源LLM的訓練集)也隨著論文的發(fā)布被開源到了GitHub上,以及用于生成報告的測試性能代碼。

然而,Drori教授卻刪除了這個項目。

他們目前針對此發(fā)布了該測試集的注釋副本:https://docs.google.com/spreadsheets/d/1FZ58hu-lZR-e70WP3ZPNjp9EK_4RgrQvQfsvjthQh_Y/edit#gid=1598949010

三人也表示,他們確信這個文件代表了論文中分析的測試集,因為評估代碼中所有數(shù)據(jù)的文件路徑都指向它,沒有提供任何修改其內(nèi)容的代碼,而且在最初發(fā)布的GitHub倉庫中也是可用的。此外,該文件也滿足論文中規(guī)定的所有模式要求。

這些證據(jù)似乎非常有力地支持了一個主張,那就是,這個文件有可能被換成了一個用于測試的不同文件。如果是這樣的話,證明的責任在于作者公開發(fā)布這個數(shù)據(jù)和用它做的所有分析。

于是,他們開始檢查各個數(shù)據(jù)點。

很快就發(fā)現(xiàn),數(shù)據(jù)集中至少有10個問題是無法用提供的信息解決的,也就是說,根本不可能出現(xiàn)滿分的情況。除此之外,還有幾個問題在這個給出的背景下根本就不是有效的問題,這樣的題目至少占了4%。

除了問題本身存在爭議外,他們還發(fā)現(xiàn),在所檢查的288個問題中,有14個是重復的,在這些情況下,問題串之間的唯一區(qū)別是極小的字符級噪音,或者完全相同。

鑒于此,GPT-4能夠獲得滿分不得不令人懷疑。得出這樣的結果要么是在某個階段將解決方案泄露到了提示中,要么是問題沒有被正確評分。

這也促使他們進一步調(diào)查。最終發(fā)現(xiàn),其實兩邊都占了。

它在演示一種更高級的“作弊”

在這里,還需要簡單解釋一下論文中提到的的“小樣本示例”(few-shot examples)。簡而言之,研究人員對OpenAI嵌入的數(shù)據(jù)集內(nèi)的類似問題進行余弦相似度搜索,并將這些問題和解決方案作為額外的背景納入模型的提示,以幫助模型解決問題。這本身沒什么問題,只要給出的例子和問題存在足夠大的差異,以便不暴露不公平信息。

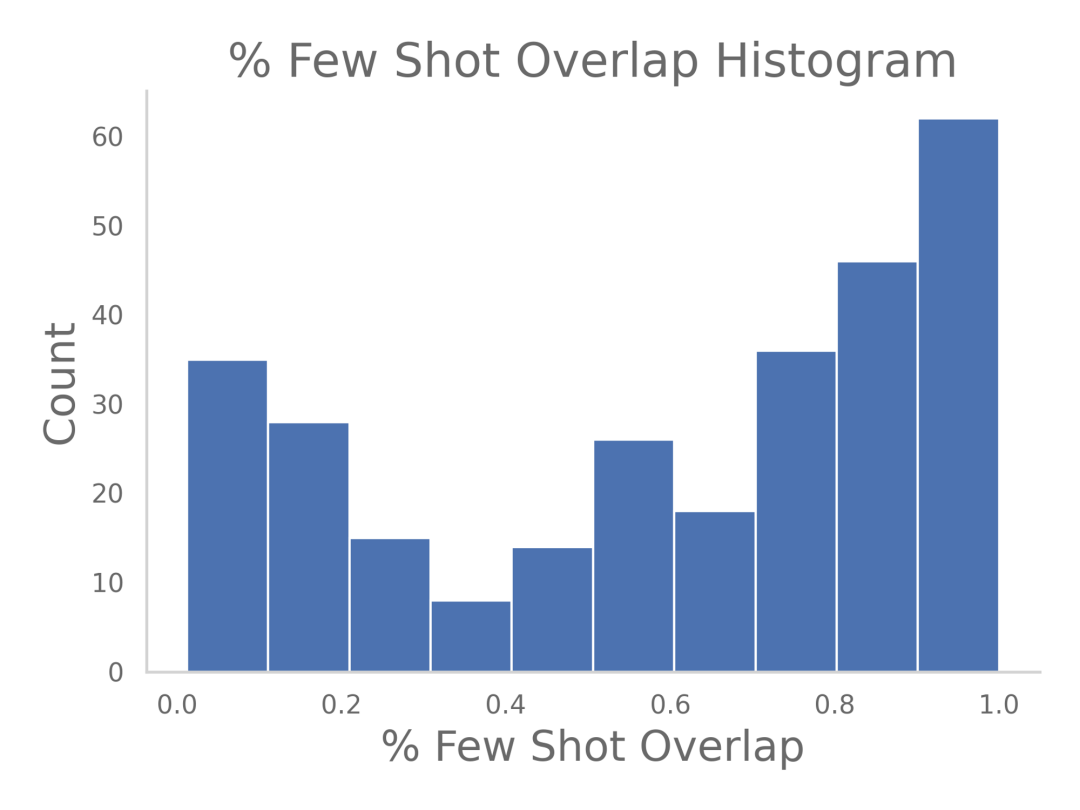

但是在隨機掃描已發(fā)布的測試數(shù)據(jù)集時,他們注意到一些奇怪的事情。許多提供給模型的小樣本示例幾乎與問題本身一字不差,這種重疊情況可以用柱狀圖來表示:

也就是說,模型得到的是問題的答案或與問題非常相似的問題。通常情況下,這來自于很多有類似背景的問題被反復提問。

在他們看來,為了正確評估GPT的解題能力,“多部分問題”(multi-part questions)的其他部分應該被完全排除在某一問題的小樣本示例外。事實上,他們還發(fā)現(xiàn),這些多部分問題的解決方案往往直接提到或給出模型被要求解決的另一部分問題的解決方案。

而在評分上,根據(jù)開源的打分機制中,他們也發(fā)現(xiàn)了一些問題。

比如流程是如何處理分級的。事實上,研究人員是利用GPT-4來打分的,包括原始問題、解決方案,和GPT自己的答案,作為分級提示的參數(shù)。

在其他技術領域,GPT更有可能出現(xiàn)隱性誤解,這種自動評分也就更有可能出現(xiàn)自我安慰的結果。

此外,雖然prompt級聯(lián)是最近許多GPT論文中常見的技術,但這里有大量數(shù)據(jù)泄漏的可能性。每一級不僅提供基于基礎事實的二元信息,而且還在prompt,直到達到正確答案。

雖然這些創(chuàng)建的prompt沒有看到實際的解決方案,但重新prompt正確答案直到達到正確答案的二進制反饋是足夠的,尤其是在占測試集16%的多選題中,無限的嘗試保證了正確的答案。

這就好比有人拿著答題紙告訴學生他們是否得到了正確的答案,直到他們得到答案。

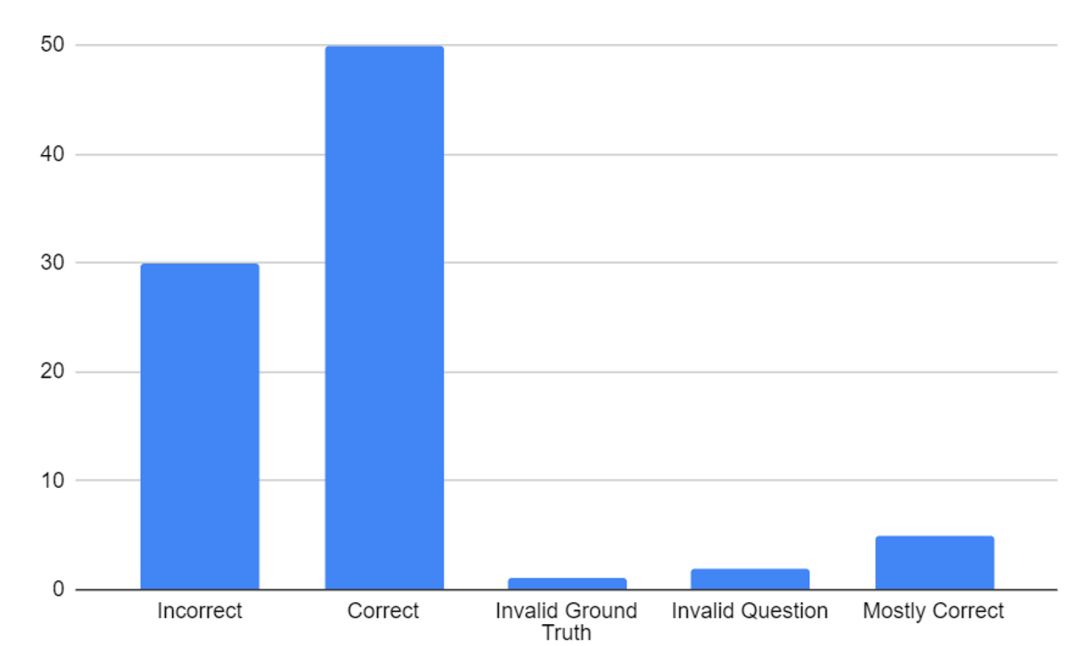

在戳破這層假象后,他們在數(shù)據(jù)集上完成了零樣本GPT-4的運行,對數(shù)據(jù)的前30%進行了手動評分,結果與原論文可以說是“天壤之別”。

語言模型還不能被當作產(chǎn)生基礎真理的神諭

最后,三人表示,他們目前提出的問題只是幾個小時的審查中發(fā)現(xiàn)的最明顯的問題,后期隨著更多人更仔細的檢查,會發(fā)現(xiàn)更多的漏洞。

他們也鼓勵讀者下載數(shù)據(jù)集,自己檢查,畢竟只有通過了同行評估,才能得到最終肯定。

同時,他們也寫到,他們對數(shù)據(jù)分析方法的完整性的觀察是令人擔憂的。這篇論文道出了最近人工智能研究的一個更大趨勢:隨著該領域的進展越來越快,研究時間線似乎在縮短,這其中就不可避免地存在走捷徑的行為。

一個特別令人擔憂的趨勢是使用像GPT-4這樣基于語言的模型來評估一個模型的準確性的技術。雖然它是一個有用的工具,但結論絕不應該被夸大,也不應該被當作地面真理。

最近有論文就寫到,如果沒有準確的真實信息,GPT-4的驗證并不可靠。至少,應該選擇一個隨機的數(shù)據(jù)集子集,將GPT-4的性能與人類的對應物進行比較。語言模型還不能被當作產(chǎn)生基礎真理的神諭。

此外,在使用數(shù)據(jù)之前,無論是用于訓練、推理、基準測試還是其他方面,重新評估每一個數(shù)據(jù)點并進行基本的理智檢查是極其重要的。鑒于有關數(shù)據(jù)集的規(guī)模較小,簡單的人工驗證很容易在工作范圍內(nèi)完成。

有網(wǎng)友在推特上打趣地說到,“這是LLM和作者推薦必吃的甜點,如果你趕時間,讓GPT-4預測以下哪種味道最好”。

看來,關于GPT的相關研究和衍生風波,都還會持續(xù)再刮一陣子。

相關報道: