無需人力標注!悉尼大學華人團隊提出「GPT自監(jiān)督標注」范式,完美解決標注成本、偏見、評估問題

一直以來,數(shù)據(jù)標注都在深度學習流程中扮演了基礎且重要的角色。

優(yōu)質(zhì)的數(shù)據(jù)標注直接影響到模型的學習效果,而這無疑是實現(xiàn)高效深度學習的最原始且關(guān)鍵的一步。

與此同時,標注的數(shù)據(jù)作為groundtruth,也直接影響了后續(xù)的訓練,驗證,測試。

然而,業(yè)界和學界不得不面臨數(shù)據(jù)標注任務成本較高、存在偏見、難以評估,以及標注難度等問題。

最近,來自悉尼大學的研究團隊提出了一種通過大語言模型自監(jiān)督生成標注的框架。首次利用基于生成-還原循環(huán)標注的GPT自監(jiān)督方法,解決了上述問題。

論文鏈接:https://arxiv.org/pdf/2306.04349.pdf

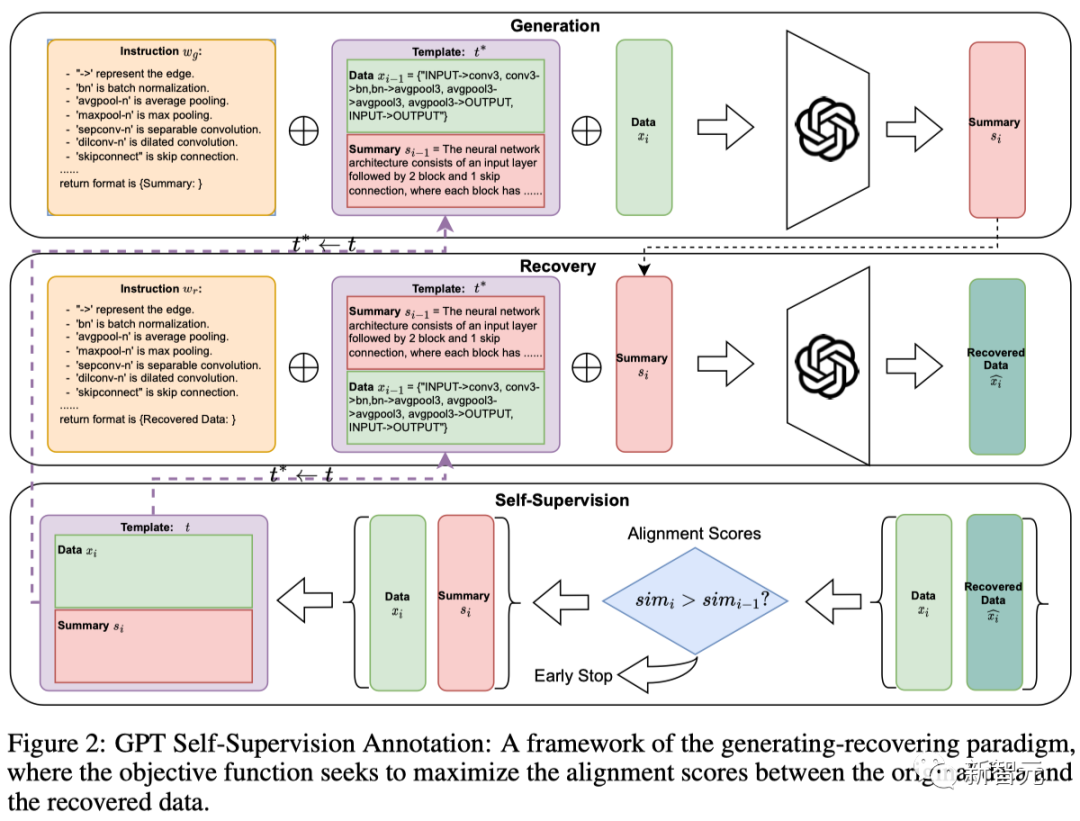

其核心思想是,利用大語言模型作為一個黑盒優(yōu)化優(yōu)器,構(gòu)造了一個循環(huán):

模版質(zhì)量越高,生成的數(shù)據(jù)-標注對質(zhì)量越高;生成的數(shù)據(jù)標注對質(zhì)量越高,用當前質(zhì)量更高的數(shù)據(jù)對替換上一輪的模版。以此往復迭代,滾雪球式循環(huán)提升標注質(zhì)量。

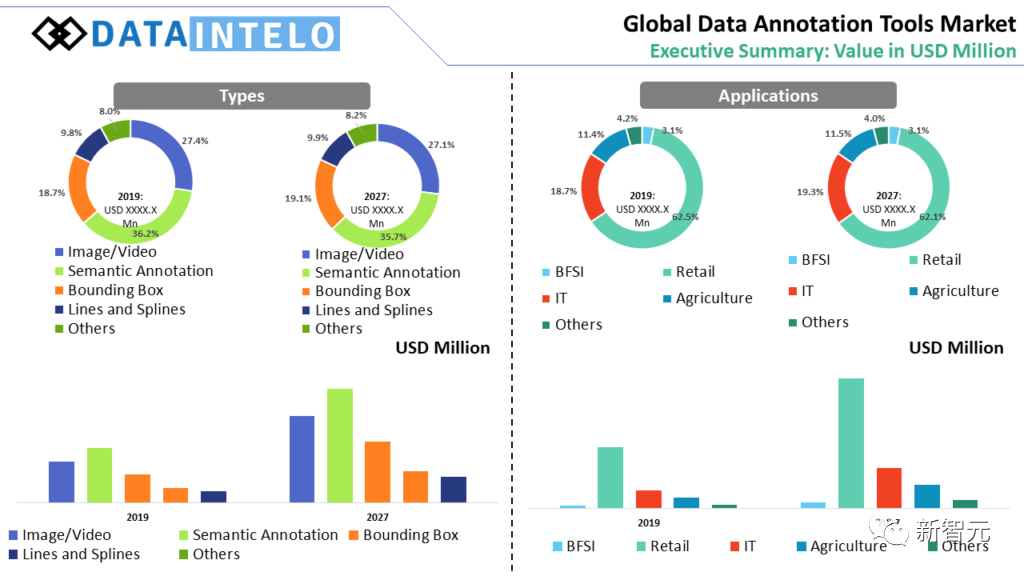

數(shù)據(jù)標注困難重重

1. 成本較高:

無論是在哪個國家或公司,數(shù)據(jù)標注都是一項成本高昂的工作,需要大量的人力和時間投入。

在美國,數(shù)據(jù)標注員的平均年薪約為39,000美元,最高可達49,803美元[2]。即使在印度,數(shù)據(jù)標注員的平均年薪約為2.0 Lakhs盧比,約合2,670美元[3]。

其次,數(shù)據(jù)標注的成本也影響了其評估的困難。

例如,由于成本的差異,許多公司選擇將數(shù)據(jù)標注任務外 包到人力成本較低的國家[4]。

然而,這種跨文化的標注可能導致一些細微的語義差異被忽視,從而影響了模型的學習效果。

2. 存在偏見:

數(shù)據(jù)標注在機器學習和人工智能的應用中扮演著重要的角色。

然而,研究顯示[5],人類在標注過程中可能會引入偏見,這些偏見可能會影響機器學習模型的訓練和性能。

研究發(fā)現(xiàn),標注員可能會按照數(shù)據(jù)集創(chuàng)建者編寫的指令中的模式進行標注,這種現(xiàn)象被稱為「指令偏見」。

這些指令可能會導致某些標注在數(shù)據(jù)中過度表示,從而使得AI系統(tǒng)對這些標注產(chǎn)生偏見。

3. 難以評估:

研究表明[6]大語言模型本身可以直接通過設計prompt標注數(shù)據(jù)。

然而,評估這些模型對數(shù)據(jù)標注的質(zhì)量和效果十分困難, 因為如何評判生成的數(shù)據(jù)質(zhì)量是一個主觀的問題。

比如,在生物醫(yī)學領(lǐng)域,深度學習模型已經(jīng)顯示出在從DNA序列中預測調(diào)控效應的巨大潛力。

但人類本身并未完全理解模型輸出的內(nèi)容,因此用模型標注的質(zhì)量難以被人類評判。

4. 標注難度:

即使對專業(yè)從業(yè)者,一些結(jié)構(gòu)化數(shù)據(jù)標注難度仍然太大。

比如,在神經(jīng)網(wǎng)絡計算圖數(shù)據(jù)中,結(jié)點表述操作符,有向邊表示。

一個表示網(wǎng)絡結(jié)構(gòu)的graph列表多達上千個結(jié)點對,人工數(shù)結(jié)點和嵌套的block序列將耗費大量時間和精力。

全新標注方法

團隊提出的標注方法包含了one-shot階段和生成階段。

其中,one-shot階段的目標是迭代尋找最優(yōu)的{數(shù)據(jù)-標注}數(shù)據(jù)對作為模板。

迭代過程:

初始化一個簡單數(shù)據(jù)對作為初始模版,利用GPT生成標注,生成的標注和原始數(shù)據(jù)形成一個新的數(shù)據(jù)對。

然后,通過比較從標注中還原出來的數(shù)據(jù)和原始數(shù)據(jù),評估這個新數(shù)據(jù)對作為模板的潛力。

如果還原數(shù)據(jù)與原數(shù)據(jù)的相似度得分有所提高,就用當前的新數(shù)據(jù)對直接作為新的模板進行一輪數(shù)據(jù)生成。

因此,這種自我對齊機制會迭代調(diào)整one-shot模板,為下一輪生成做好準備。one-shot階段搜索到的最優(yōu)模板隨后用于對數(shù)據(jù)集進行標注。

作者通過調(diào)整不同的預訓練獎勵模型來評估標注的質(zhì)量,并引入不同的評價指標來間接評估摘要的還原能力。

作者在三個具有挑戰(zhàn)性的數(shù)據(jù)集上進行了大量實驗,并從各種角度進行了詳細的消融研究。

結(jié)果表明,這種自我監(jiān)督范式在獎勵模型和還原數(shù)據(jù)能力的得分的評估中始終表現(xiàn)出很高的性能。

另外,作者應用該框架生成了兩個新的數(shù)據(jù)集,對基于不同計算操作符的神經(jīng)網(wǎng)絡架構(gòu)進行的描述。

作者通過調(diào)用OpenAI的API在各種類型的GPT模型上進行了基準測試。

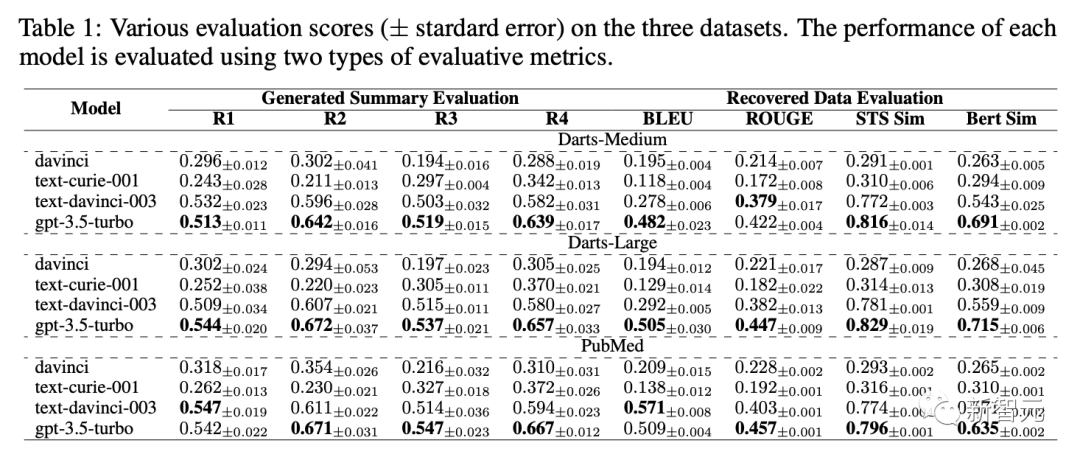

表1展示了davinci,text-curie-001,text-davinci-003,gpt-3.5-turbo在不同評估標準下標注數(shù)據(jù)質(zhì)量的得分。

作者在論文中還探討如下消融實驗:

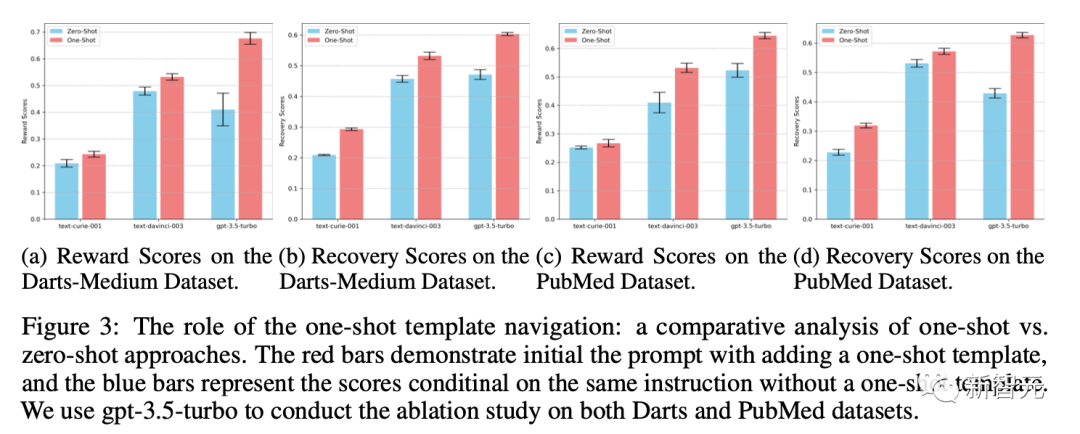

Q1. 迭代后的one-shot模板在整個過程中扮演什么角色?我們是否能通過zero-shot方法(僅通過設計的指令instruction-tuning生成摘要), 來達到同樣的效果?

A1. 與以相同指令為條件的零樣本生成相比,引入樣本模板提高了標注質(zhì)量, 實驗細節(jié)如圖所示。

此外,作者還在文中還探討了如下問題:

對還原數(shù)據(jù)和原數(shù)據(jù)之間的相似度測量評估標準方法會對標注有什么影響?模板的初始化如何影響自監(jiān)督標注迭代的結(jié)果?GPT模型本身的超參數(shù)是否會影響搜索出來的標注模版?