“CNN之父” Yann LeCun:人工智能沒(méi)腦子,智商不如一條狗

大數(shù)據(jù)文摘出品

被譽(yù)為深度學(xué)習(xí)三巨頭之一的Yann LeCun一直是樂(lè)天派,他不止在一個(gè)場(chǎng)合表達(dá)他對(duì)人工智能(AI)發(fā)展的樂(lè)觀預(yù)期。例如:“AI是人類智慧的放大器,AI越強(qiáng)大,人類就越聰明,更快樂(lè)和更有經(jīng)濟(jì)效率。”

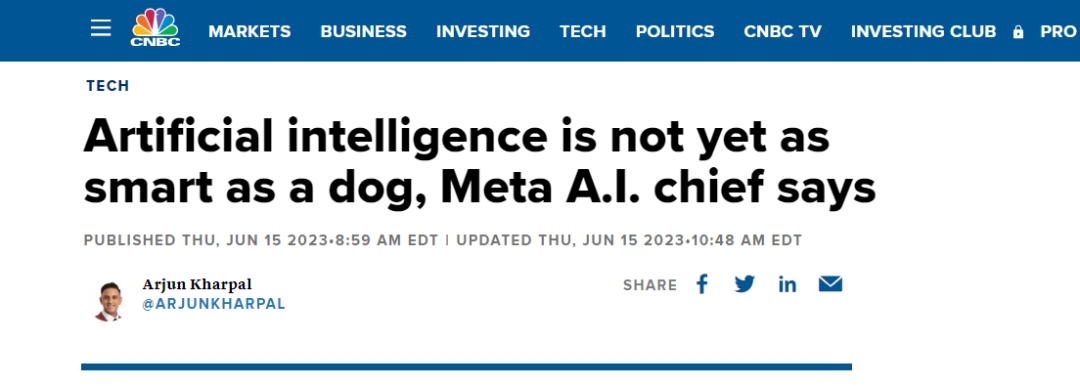

今日,CNBC有篇文章披露出了Yann LeCun對(duì)AI能力現(xiàn)狀的定義:它還不如一條狗聰明。至于原因,LeCun談到:

那些系統(tǒng)只在文本上訓(xùn)練,它們對(duì)現(xiàn)實(shí)世界的基本現(xiàn)實(shí)沒(méi)有任何理解,然而大部分人類知識(shí)與語(yǔ)言無(wú)關(guān)……所以大部分人類經(jīng)驗(yàn)AI是學(xué)不會(huì)的。”

為了論證 LeCun的觀點(diǎn),他舉了個(gè)例子,現(xiàn)在的AI系統(tǒng)可以通過(guò)美國(guó)的律師資格考試,然而,AI不會(huì)用/裝(load)洗碗機(jī),一個(gè)10歲的小孩卻10分鐘就能搞定。

更深層次的原因,是AI無(wú)法復(fù)制人類能力,例如五月大的嬰兒看到水上漂浮物體可能無(wú)感,但九月大的嬰兒可能會(huì)表現(xiàn)出震驚,因?yàn)樗麜?huì)意識(shí)到物體不應(yīng)該漂浮。

“不知道如何用機(jī)器復(fù)制這種能力。在我們能做到這一點(diǎn)之前,AI不會(huì)擁有人類水平的智能,也不會(huì)擁有狗或貓水平的智能。”LeCun如此解釋。

CNN之父的人工智能觀點(diǎn)

在去年的十月份,Yann LeCun在接采訪中提到,“今天的人工智能方法永遠(yuǎn)不會(huì)帶來(lái)真正的智能。所有人工智能都面臨某些基本問(wèn)題,特別是如何衡量信息。”

而最近公開(kāi)的演講中,更是強(qiáng)烈批判GPT大模型所使用的方法,即根據(jù)概率生成自回歸的大模型,根本無(wú)法破除幻覺(jué)難題。

此前, LeCun提出目前AI研究面臨的三大挑戰(zhàn),而這些挑戰(zhàn)也是GPT所使用方法無(wú)法解決的。

- AI如何學(xué)會(huì)表征世界,學(xué)習(xí)預(yù)測(cè),并學(xué)習(xí)主要通過(guò)觀察來(lái)行動(dòng)?

- AI如何才能以與基于梯度的學(xué)習(xí)相兼容的方式進(jìn)行推理和計(jì)劃?

- AI如何學(xué)習(xí)在多個(gè)抽象層次和多個(gè)時(shí)間尺度上以層次化的方式表示感知和行動(dòng)規(guī)劃?

針對(duì)上述問(wèn)題,LeCun提出了兩個(gè)解決方向。一是運(yùn)用自監(jiān)督學(xué)習(xí)方法,減少系統(tǒng)學(xué)習(xí)所需的數(shù)據(jù)量,這本質(zhì)上是通過(guò)預(yù)訓(xùn)練來(lái)獲得更好的性能。二是進(jìn)行端到端的訓(xùn)練,設(shè)計(jì)一些能夠處理邊緣情況的系統(tǒng),通過(guò)強(qiáng)化控制來(lái)解決問(wèn)題。

圖源:北京智源大會(huì)

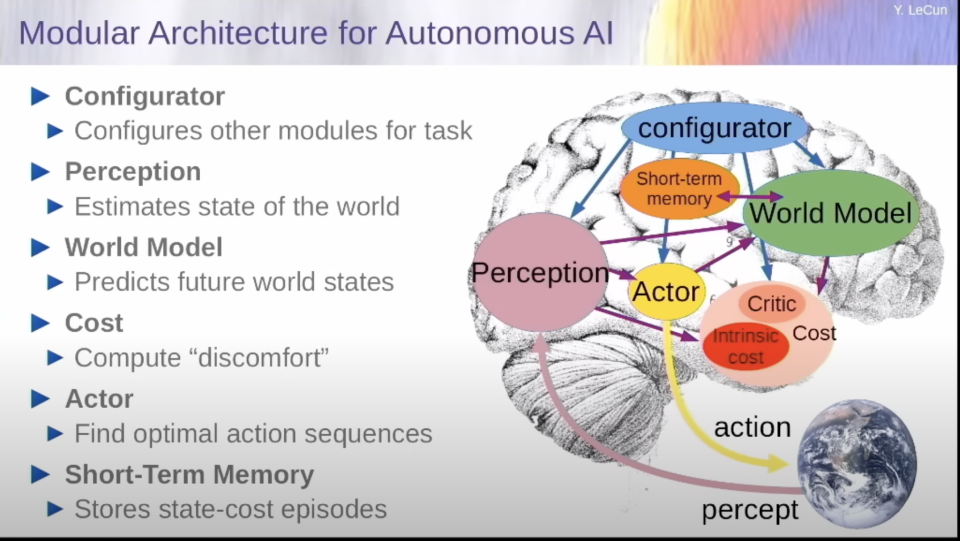

更為具體,他提出世界模型,給人工智能的下一步,提供解決方案。在他的設(shè)想中,世界模型為一個(gè)不光是在神經(jīng)水平上模仿人腦的模型,而是在認(rèn)知模塊上也完全貼合人腦分區(qū)的模型。它與大語(yǔ)言模型最大的差別在于可以有規(guī)劃和預(yù)測(cè)能力(世界模型),成本核算能力(成本模塊)。

通過(guò)世界模型,它可以真正的理解這個(gè)世界,并預(yù)測(cè)和規(guī)劃未來(lái)。通過(guò)成本核算模塊,結(jié)合一個(gè)簡(jiǎn)單的需求(一定按照最節(jié)約行動(dòng)成本的邏輯去規(guī)劃未來(lái)),它就可以杜絕一切潛在的毒害和不可靠性。

至于如何實(shí)現(xiàn)世界模型,LeCun認(rèn)為可以采用自監(jiān)督模型去訓(xùn)練,比如一定要建立多層級(jí)的思維模式........

安全or危險(xiǎn)?AI發(fā)展的兩種預(yù)見(jiàn)

和LeCun同年“摘取”圖靈獎(jiǎng)得主盛譽(yù)的Geoffrey Hinton卻有著不一樣的觀點(diǎn):

“這些超級(jí)智能出現(xiàn)的時(shí)間可能比我過(guò)去認(rèn)為的要早得多......超級(jí)智能顯然會(huì)學(xué)得非常擅長(zhǎng)欺騙人,可以讓人們實(shí)際執(zhí)行它喜歡的任何動(dòng)作。這非常可怕!””

從最近一些領(lǐng)域大咖的表態(tài)來(lái)看,似乎站臺(tái)Hinton,認(rèn)為AI危險(xiǎn)的人數(shù)更多一些。例如特斯拉的頭頭馬斯克表示,人工智能是未來(lái)文明面臨的最大危險(xiǎn)之一。

而在今年五月份,大量學(xué)者、專家簽名公開(kāi)信《AI 風(fēng)險(xiǎn)聲明》,信中警告稱如果對(duì)先進(jìn)人工智能的發(fā)展監(jiān)管不當(dāng),可能會(huì)對(duì)人類構(gòu)成生存威脅。

這封公開(kāi)信與以往不同,因?yàn)槠渲性S多重要簽署者在 AI 實(shí)驗(yàn)室、大型科技公司擔(dān)任要職。其中包括圖靈獎(jiǎng)得主 Geoffrey Hinton、Yoshua Bengio,OpenAI 首席執(zhí)行官 Sam Altman,Google DeepMind 聯(lián)合創(chuàng)始人兼 CEO Demis Hassabis,微軟首席技術(shù)官 Kevin Scott,谷歌副總裁 James Manyika,OpenAI 首席科學(xué)家 Ilya Sutskever,GAN 之父 Ian Goodfellow 等都已簽名。

而Hinton更是離職谷歌,表達(dá)畢生的后悔。他對(duì)造就了如今AI技術(shù)繁榮的神經(jīng)網(wǎng)絡(luò),表示抱歉。

參考鏈接:

https://new.qq.com/rain/a/20230612A08QO700

https://www.cnbc.com/2023/06/15/ai-is-not-even-at-dog-level-intelligence-yet-meta-ai-chief.html

https://mp.weixin.qq.com/s/LDTpMoDaIf3tTATxWeaSgg

https://mp.weixin.qq.com/s/GxEfoD06P1UPIIbFTbTgEg