腦機(jī)接口、腦波和fMRI,AI正在掌握讀心術(shù)

讀心術(shù)可以說是人類最想要的超能力之一,同時(shí)也必定是人們最不希望別人有的一種超能力。只需在搜索引擎中輸入「讀心術(shù)」這個(gè)關(guān)鍵詞,你就能找到大量相關(guān)書籍、視頻和教程,足可見人們對(duì)這一能力的癡迷。但拋開那些心理學(xué)、行為學(xué)或神秘主義的內(nèi)容不談,單從技術(shù)角度看,人類的大腦信號(hào)是存在模式的,也因此讀心術(shù)(解析大腦信號(hào)的模式)是可能實(shí)現(xiàn)的。

現(xiàn)如今,隨著 AI 技術(shù)的發(fā)展,其分析模式的能力也越發(fā)精進(jìn),讀心術(shù)正在變成現(xiàn)實(shí)。

前些天,得克薩斯大學(xué)奧斯汀分校發(fā)表于 Nature Neuroscience 一篇論文引起了熱議,其可以通過非侵入式地讀取大腦信號(hào)而重建出語義相符的連續(xù)語句 —— 不出意外,該模型同樣使用了當(dāng)前大受追捧的 GPT 語言模型。但我們先暫時(shí)按下這項(xiàng)最新的成果不表,看看稍早時(shí)間其它一些有關(guān) AI 讀心術(shù)的研究成果,以大概理解該課題的當(dāng)前研究圖景。

寬泛地說,讀心術(shù)可分為兩大類:直接讀心術(shù)和間接讀心術(shù)。

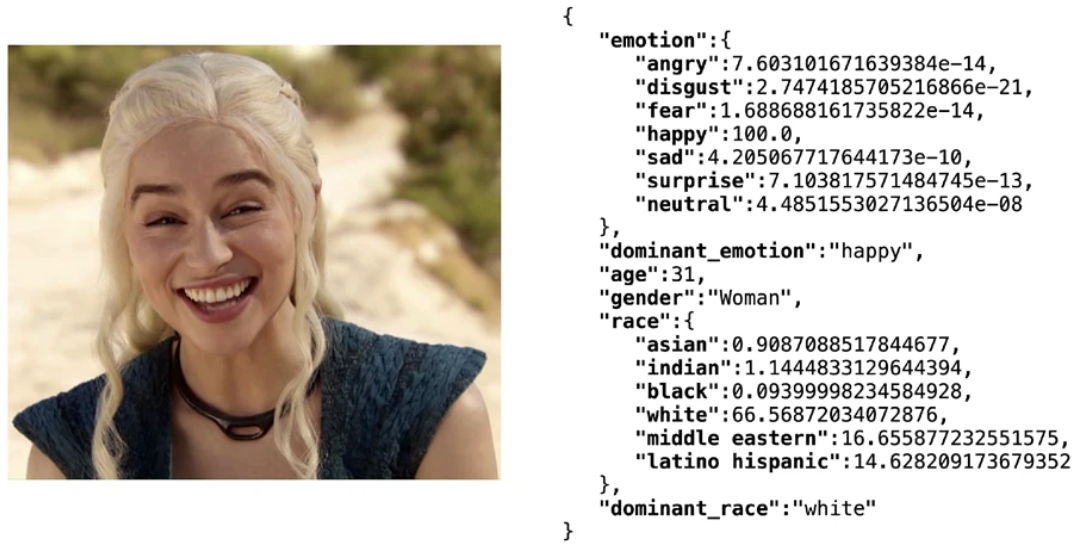

間接讀心術(shù)是指通過間接的特征來揣度一個(gè)人的想法和情緒。這些特征包括人臉表情、身體姿態(tài)、體溫、心率、呼吸節(jié)律、說話語速和語氣等。近些年基于大數(shù)據(jù)的深度學(xué)習(xí)技術(shù)已經(jīng)能讓 AI 相當(dāng)準(zhǔn)確地通過人臉表情識(shí)別情緒,比如輕量級(jí)的開源人臉識(shí)別軟件庫 Deepface 能在年齡、性別、情緒和種族多項(xiàng)特征上整體達(dá)到 97.53% 的測試集準(zhǔn)確度。但基于上述特征的情緒分析技術(shù)通常并不會(huì)被視為讀心術(shù),畢竟人類自身也或多或少能通過他人的表情等特征猜到其情緒,因此本文關(guān)注的讀心術(shù)僅限于直接讀心術(shù)。

使用 Deepfake 庫得到人臉屬性分析結(jié)果

直接讀心術(shù)是指直接將大腦信號(hào)「翻譯」成他人能理解的形式,比如文本、語音和圖像。目前而言,研究者關(guān)注的大腦信號(hào)主要有三種:侵入式腦機(jī)接口、腦波(brain wave)和神經(jīng)成像(neuroimaging)。

基于侵入式腦機(jī)接口的讀心術(shù)

侵入式的腦機(jī)接口可以說賽博朋克作品的標(biāo)配,你能在《賽博朋克 2077》等許多電影或游戲中看到它。其基本思路就是在大腦或神經(jīng)系統(tǒng)中或附近讀取神經(jīng)細(xì)胞之間傳遞的電信號(hào)。相較于非侵入式的方法,侵入式讀取的大腦信號(hào)通常準(zhǔn)確度更高,噪聲也更低。

2021 年,在論文《Neuroprosthesis for Decoding Speech in a Paralyzed Person with Anarthria》中,來自加利福尼亞大學(xué)舊金山分校的研究者提出使用 AI 幫助有語音障礙的殘障人士交流。在該研究中,受試者是一位發(fā)音不清且獨(dú)臂的殘障人士。值得注意的是,他們?cè)趯?shí)驗(yàn)中使用了一種神經(jīng)植入物來獲取信號(hào),該植入物組合使用了高密度皮層腦電圖電極陣列和一個(gè)經(jīng)過皮膚的連接器。這種侵入式的方法自然具備更高的準(zhǔn)確度 —— 能達(dá)到最高 98% 的準(zhǔn)確度和 75% 的中位數(shù)解碼率,該模型的解碼速度可達(dá)到最高每分鐘 18 個(gè)詞。此外,語言模型的應(yīng)用也極大提升了解碼結(jié)果的意義表達(dá),使其不再只是簡單的字符串堆積。

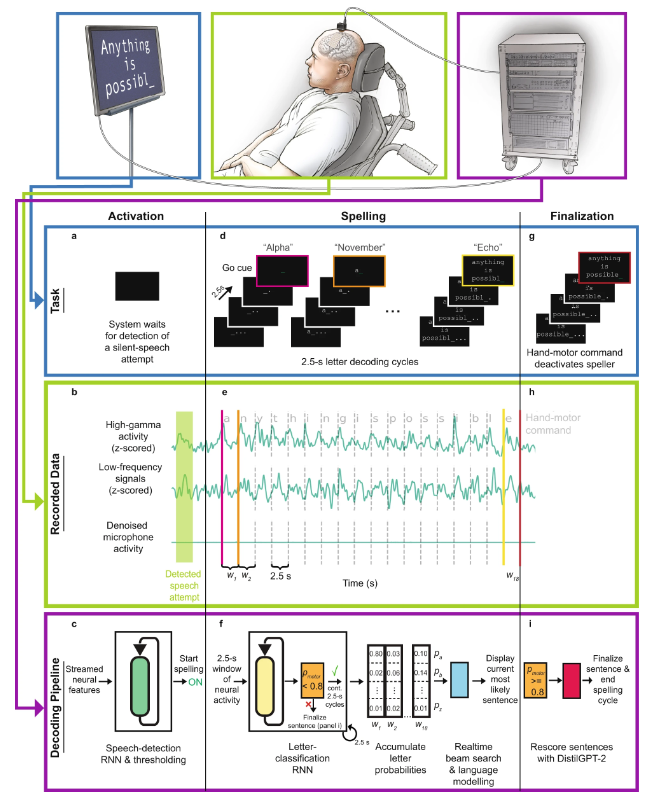

之后,該團(tuán)隊(duì)在 2022 年的 Nature Neuroscience 論文《Generalizable spelling using a speech neuroprosthesis in an individual with severe limb and vocal paralysis》中進(jìn)一步改進(jìn)了他們的系統(tǒng),整合了新興的語言模型 GPT,使性能得到了進(jìn)一步提升。

直接語音腦機(jī)接口工作流程示意圖

具體來說,其工作流程為:

- a 在語句拼寫試驗(yàn)開始時(shí),參與者嘗試不發(fā)音地默念一個(gè)詞,用意識(shí)激活拼寫器。

- b 在任務(wù)過程中,從所記錄的皮層數(shù)據(jù)實(shí)時(shí)地提取神經(jīng)特征(高伽馬活動(dòng)和低頻信號(hào))。麥克風(fēng)信號(hào)表明任務(wù)過程中沒有語音信號(hào)。

- c 語音檢測模型,其由一個(gè)循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)和閾值運(yùn)算構(gòu)成,其任務(wù)是檢測出語音表達(dá)嘗試的神經(jīng)特征。一旦檢測到受試者的說話嘗試,就啟動(dòng)拼寫流程。

- d 在拼寫流程中,受試者通過每 2.5 秒發(fā)生一次的字母解碼周期拼寫其想表達(dá)的信息。每個(gè)周期,受試者都能看到一個(gè)倒計(jì)時(shí),倒計(jì)時(shí)結(jié)束是開始提示。收到開始提示后,受試者嘗試無聲說出代表所要字母的代碼詞。

- e 在拼寫過程中,為所有電極通道計(jì)算高伽馬活動(dòng)和低頻信號(hào),并將其分配到 2.5 秒長度的非重疊時(shí)間窗口中。

- f 當(dāng)參與者想要無聲說出 26 個(gè)可能代碼詞中的每一個(gè)或試圖操作一個(gè)手部運(yùn)動(dòng)命令時(shí),基于 RNN 的字母分類模型處理每一個(gè)神經(jīng)時(shí)間窗口來預(yù)測其概率。

- g 參與者在拼寫完想表達(dá)的信息后,他會(huì)嘗試擠壓自己的右手來結(jié)束拼寫流程和讓句子收尾。

- h 與手部運(yùn)動(dòng)命令有關(guān)的神經(jīng)時(shí)間窗口會(huì)被傳遞給分類模型。

- i 如果分類器確認(rèn)參與者試圖使用手部運(yùn)動(dòng)命令,則使用一個(gè)基于神經(jīng)網(wǎng)絡(luò)的語言模型(DistilGPT-2)對(duì)有效語句進(jìn)行重新評(píng)分。重新評(píng)分后,最有可能的句子作為最終預(yù)測結(jié)果。

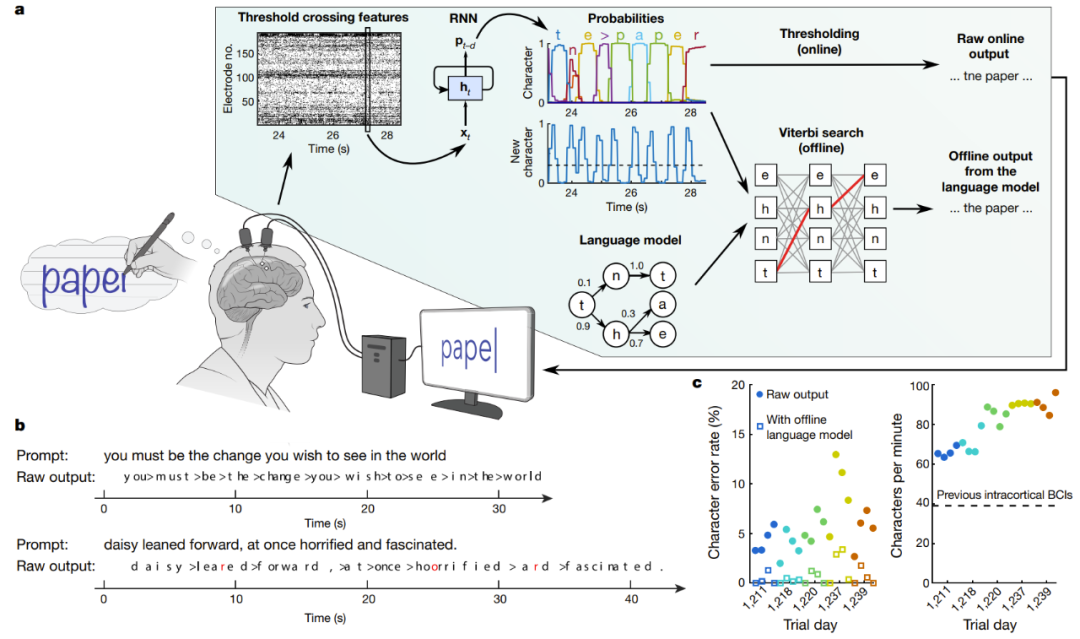

另一項(xiàng)植入式腦機(jī)接口的研究則宣稱實(shí)現(xiàn)了高性能的基于手寫的大腦到文本通信。在 Nature 論文《High-performance brain-to-text communication via handwriting》,斯坦福大學(xué)的研究者成功讓脊椎損傷的癱瘓人士能以每分鐘 90 字符的速度打字,并且在線原始準(zhǔn)確度達(dá)到了 94.1%,使用了語言模型的離線準(zhǔn)確度更是超過 99%!

實(shí)時(shí)解碼受試者嘗試手寫的大腦信號(hào)

圖中 a 是解碼算法的示意圖。首先,每個(gè)電極上的神經(jīng)活動(dòng)被暫時(shí)合并及平滑化。然后,使用 RNN 將神經(jīng)群體時(shí)間序列轉(zhuǎn)換成概率時(shí)間序列,其描述了每個(gè)字符的可能性和任何新字符開始的概率。該 RNN 有 1 秒的輸出延遲(d),讓其在確定字符的身份之前有時(shí)間完整地觀察每個(gè)字符。最后,設(shè)定字符概率的閾值,為實(shí)時(shí)使用得到「原始在線輸出」(當(dāng)新字符的概率在時(shí)間 t 超過某個(gè)閾值時(shí),就在時(shí)間 t+0.3 秒給出最有可能的字符并將其展示在屏幕上)。在離線的回顧性分析中,研究者將字符概率與一個(gè)具有大詞匯庫的語言模型組合到一起,用以解碼參與者最有可能寫下的文本。

基于腦波的讀心術(shù)

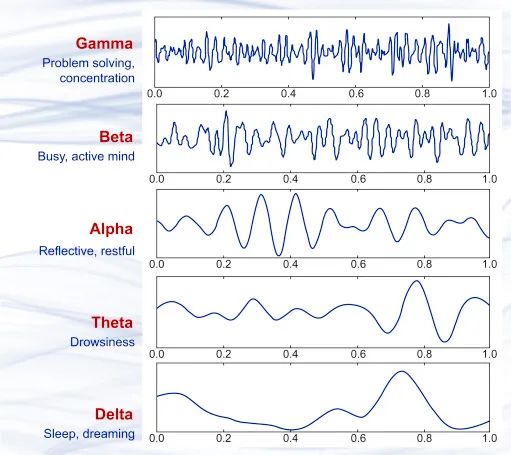

基于近幾十年腦科學(xué)的研究成果,我們知道大腦中神經(jīng)細(xì)胞傳遞信號(hào)過程中會(huì)有微小電流,這就會(huì)產(chǎn)生細(xì)微的電磁波動(dòng)。當(dāng)大量神經(jīng)細(xì)胞同時(shí)工作時(shí),可采用非侵入式的精密儀器捕獲到這些電磁波動(dòng)。1875 年,科學(xué)家首次在動(dòng)物身上觀察到了一種流動(dòng)的電場現(xiàn)象,即腦波。1925 年,Hans Berger 發(fā)明了腦電圖(EEG),并首次記錄到了人類大腦的電活動(dòng)現(xiàn)象。此后的近百年里,EEG 技術(shù)不斷改進(jìn),其精度和實(shí)時(shí)性能都已經(jīng)達(dá)到了相當(dāng)高的程度并已得到了商業(yè)應(yīng)用,現(xiàn)在你甚至能買到便攜式的腦波檢測分析設(shè)備。

幾種不同的腦波波形樣本,從上到下依次為 γ 波(35Hz 以上)、β 波(12-35 Hz)、α 波 (8-12 Hz)、θ 波 (4-8 Hz)、δ 波(0.5-4 Hz),它們分別大致于不同的大腦狀態(tài)。

通過腦波來分析人的情緒和想法方面,最常見的方法是分析 P300 波,即受試者的大腦在看到刺激物后大約 300 毫秒時(shí)產(chǎn)生的腦波。解析腦波的研究在腦波被發(fā)現(xiàn)以后就一直沒有中斷,比如 2001 年,該領(lǐng)域頗具爭議的研究者 Lawrence Farwell 提出了一種算法,可以通過評(píng)估腦波響應(yīng)來檢測受試者是否經(jīng)歷過某個(gè)事件,并且即便受試者試圖隱瞞也無濟(jì)于事。也就是說,這是一種基于腦波的測謊儀。

由于腦波本身是一種具備模式的信號(hào),因此使用神經(jīng)網(wǎng)絡(luò)來分析腦波也就成了自然而然的事情。下面我們將通過近些年的一些研究介紹科學(xué)們正通過什么方法來將腦波信號(hào)翻譯成語音、文本和圖像。

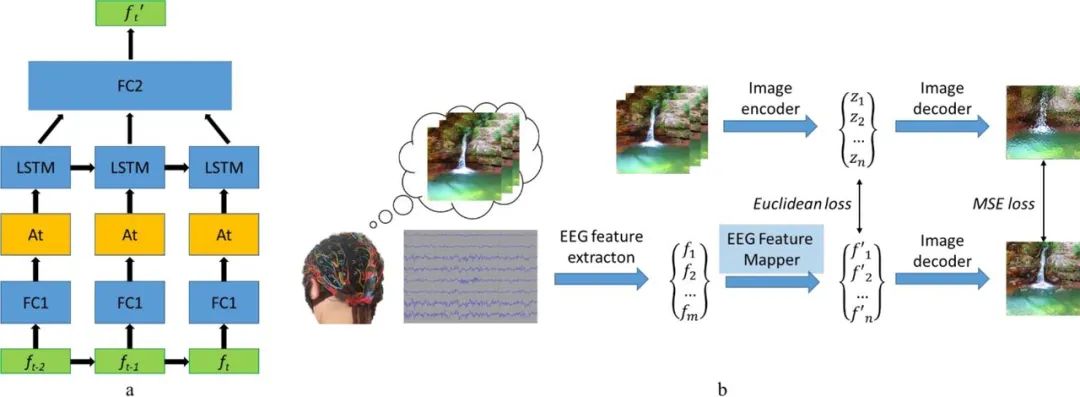

2019 年,俄羅斯一個(gè)研究團(tuán)隊(duì)提出了一個(gè)視覺腦機(jī)接口(BCI)系統(tǒng),可基于腦波來重建圖像。其研究思路很直接,就是從腦電波信號(hào)提取特征,然后提取特征向量,再進(jìn)行映射,找到特征在隱藏空間中的位置,最后解碼和重建出圖像。其中,圖像解碼器是用了一個(gè)圖像到圖像卷積自動(dòng)編碼器模型的一部分,包含 1 個(gè)全連接輸入層,之后是 5 個(gè)去卷積模塊,每個(gè)模塊都由 1 個(gè)去卷積層和 ReLU 激活組成,而最后一個(gè)模塊的激活是雙曲正切激活層。

該模型另一個(gè)重要組件是 EEG 特征映射器,其功能是將數(shù)據(jù)從 EEG 特征域轉(zhuǎn)譯到圖像解碼器的隱藏空間域。具體來說,該團(tuán)隊(duì)在模型中使用 LSTM 作為循環(huán)單元并使用了注意力機(jī)制。其損失函數(shù)是最小化 EEG 和圖像的特征表征之間的均方誤差。詳情參閱他們的論文《Natural image reconstruction from brain waves: a novel visual BCI system with native feedback》。

EEG 特征映射器的模型結(jié)構(gòu) (a) 和訓(xùn)練例程 (b)

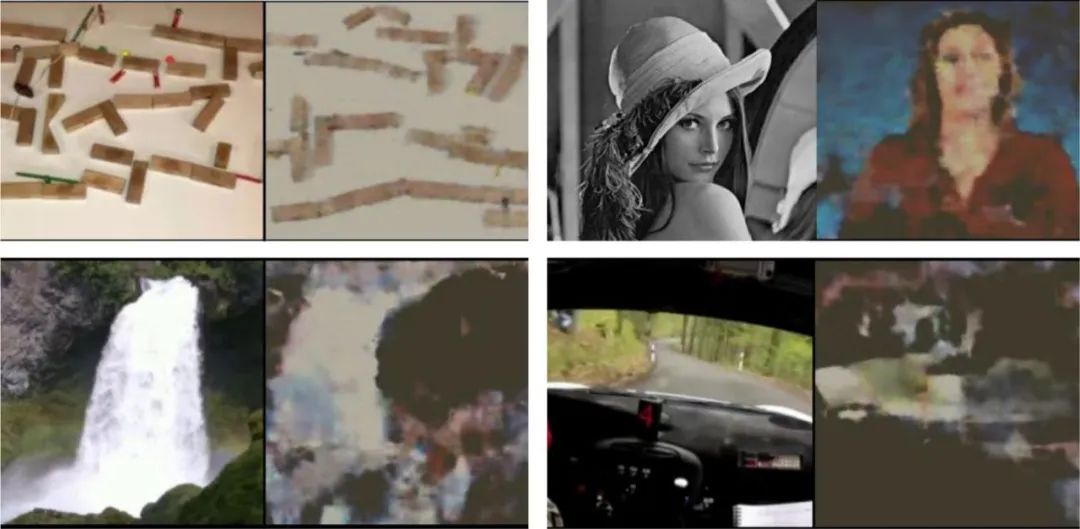

下面是一些示例結(jié)果,可以看出重建圖像與原始圖像之間存在顯著關(guān)聯(lián)。

受試者看到的原始圖像(每對(duì)圖左)以及根據(jù)受試者腦波重建的圖像(每對(duì)圖右)

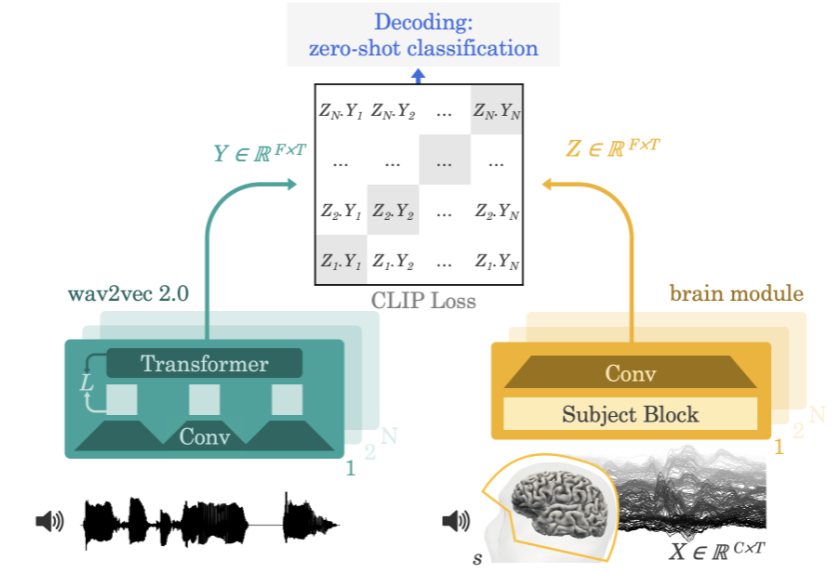

2022 年,Meta AI 團(tuán)隊(duì)在論文《Decoding speech from non-invasive brain recordings》提出了一種可從腦電圖(EEG)或腦磁圖(MEG)信號(hào)解碼出語音信號(hào)的神經(jīng)網(wǎng)絡(luò)架構(gòu)。

Meta AI 團(tuán)隊(duì)的方法示意圖

該團(tuán)隊(duì)采用的方法是讓實(shí)驗(yàn)參與者一邊聽故事或句子一邊記錄其大腦活動(dòng)的腦電圖或腦磁圖。為此,該模型首先會(huì)通過一個(gè)預(yù)訓(xùn)練自監(jiān)督模型(wav2vec 2.0)提取 3 秒語音信號(hào)(Y)的深度上下文表征,同時(shí)還會(huì)學(xué)習(xí)相應(yīng)對(duì)齊的 3 秒窗口(X)中的大腦活動(dòng)的表征(Z)。表征 Z 是由一個(gè)深度卷積網(wǎng)絡(luò)給出的。在評(píng)估時(shí),研究者向模型輸入剩下的句子,并根據(jù)每個(gè)大腦表征計(jì)算出每段 3 秒的語言片段。由此,這樣的解碼過程可以做到 zero-shot,從而讓模型可以預(yù)測出訓(xùn)練集不曾有的音頻片段。

基于神經(jīng)成像的讀心術(shù)

科學(xué)家還能使用一種名為功能性磁共振成像(fMRI)的技術(shù)來了解大腦的活動(dòng)情況。這項(xiàng)技術(shù)誕生于 1990 年代初期,其工作機(jī)制是通過磁共振成像觀察大腦中的血液流動(dòng)來檢測大腦活動(dòng)。該技術(shù)能揭示出大腦中特定功能區(qū)是否活躍。

當(dāng)我們說某個(gè)大腦區(qū)域「更活躍」時(shí),我們指的是什么呢?fMRI 又是如何檢測這種活動(dòng)的?

當(dāng)一個(gè)大腦區(qū)域中的神經(jīng)元開始發(fā)出比之前更多的電信號(hào)時(shí),我們就說這個(gè)大腦區(qū)域更活躍了。舉個(gè)例子,如果你在抬腿時(shí)某個(gè)特定的大腦區(qū)域變得更加活躍,那么就可以認(rèn)為這片大腦區(qū)域負(fù)責(zé)控制抬腿動(dòng)作。

fMRI 是通過檢測血液中的含氧水平來檢測這種電活動(dòng)。這被稱為血氧水平依賴(BOLD)反應(yīng)。其工作方式為:當(dāng)神經(jīng)元更加活躍時(shí),就會(huì)需要紅細(xì)胞提供更多氧。為此,周圍的血管就會(huì)變寬以便讓更多血液流過。所以,當(dāng)神經(jīng)元更加活躍時(shí),氧濃度就會(huì)上升。相比于脫氧血液,含氧血液產(chǎn)生的場干擾更少,這讓神經(jīng)元的信號(hào)(實(shí)際上就是水中的氫)能持續(xù)更長時(shí)間。所以當(dāng)信號(hào)留存時(shí)間更長時(shí),fMRI 就知道該區(qū)域有更多氧,也就說明這里更加活躍。用顏色編碼這種活動(dòng)之后,就能得到 fMRI 影像。

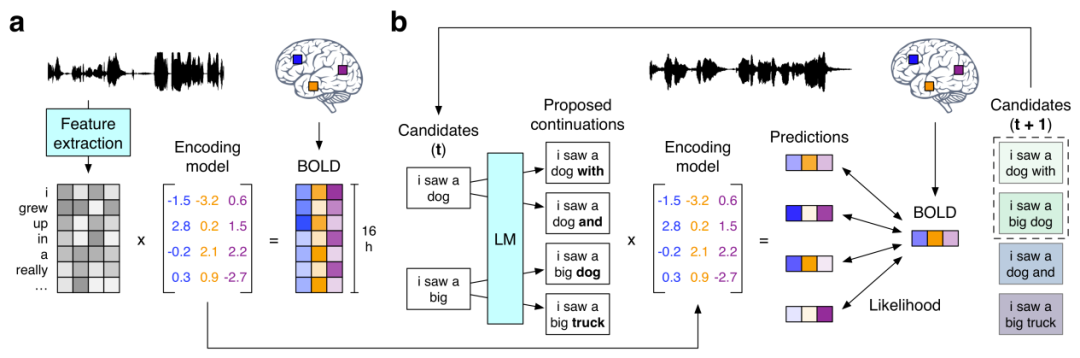

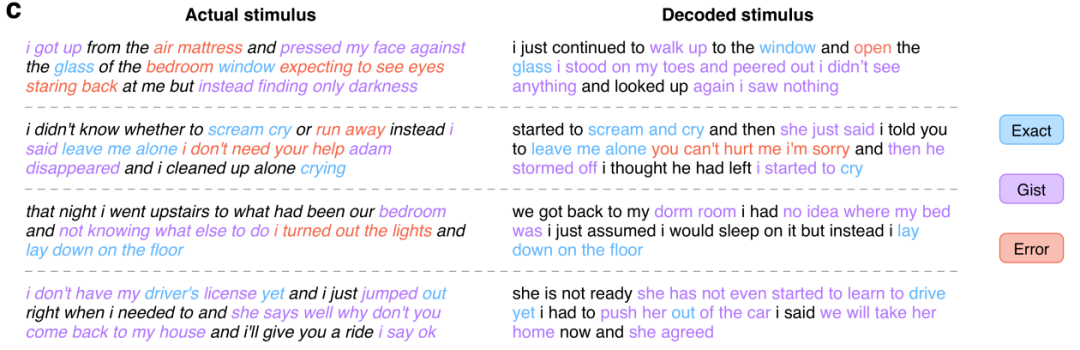

接下來我們就看看前文提到的使用 GPT 重建出語義相符的連續(xù)語句的研究《Semantic reconstruction of continuous language from non-invasive brain recordings》。他們提出了一種非侵入式的解碼器,可以根據(jù) fMRI 記錄中語義含義的大腦皮層表征而重建出連續(xù)的自然語言。當(dāng)出現(xiàn)新的大腦記錄時(shí),該解碼器能生成可理解的詞序列,其能復(fù)現(xiàn)受試者聽到的語音、想象的語音甚至無聲視頻中的含義,這表明單個(gè)語言解碼器可以應(yīng)用于一系列不同的語義任務(wù)。該語言解碼器的工作流程如下:

(a) 當(dāng)三位受試者聽 16 小時(shí)的敘事故事時(shí)記錄到的 BOLD fMRI 反應(yīng)。系統(tǒng)為每位受試者都估計(jì)了一個(gè)編碼模型,以預(yù)測作為刺激物的詞的語義特征所引發(fā)的大腦反應(yīng)。(b) 為了基于全新的大腦記錄重建語言,解碼器維持著一個(gè)候選詞序列集合。當(dāng)檢測到新的詞時(shí),會(huì)有一個(gè)語言模型為每個(gè)序列提議連續(xù)性,然后會(huì)用該編碼模型評(píng)估每種連續(xù)條件下所記錄大腦反應(yīng)的可能性。最后保留最有可能的連續(xù)序列。

在這其中,語言模型使用的正是現(xiàn)處于 AI 領(lǐng)域研究核心的 GPT 模型。研究者在一個(gè)大型語料庫上對(duì)所用 GPT 進(jìn)行了微調(diào),該語料庫包含超過 2 億詞 Reddit 評(píng)論以及來自 The Moth Radio Hour 和 Modern Love 的 240 個(gè)自傳故事。模型訓(xùn)練了 50 epoch,最大上下文長度為 100。下面展示了一些實(shí)驗(yàn)結(jié)果:

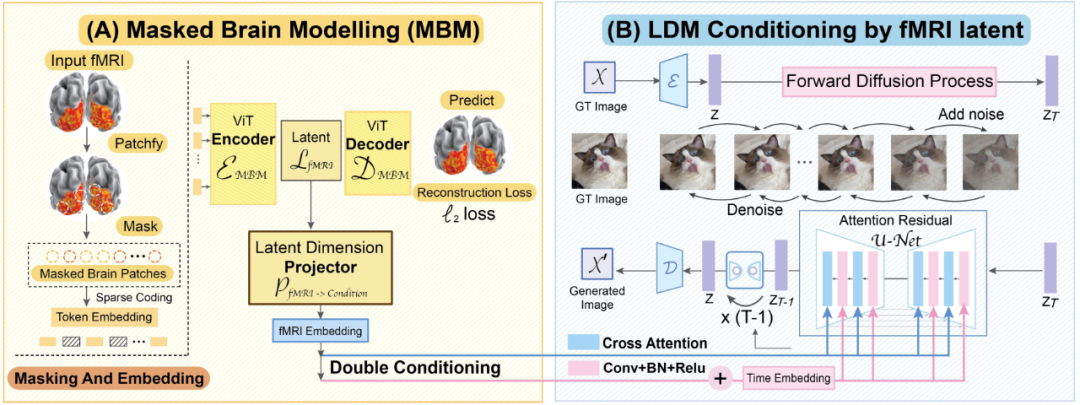

最后我們?cè)賮砜纯催@一篇 CVPR 2023 論文《Seeing Beyond the Brain: Conditional Diffusion Model with Sparse Masked Modeling for Vision Decoding》。來自新加坡國立大學(xué)、香港中文大學(xué)和斯坦福大學(xué)的研究者宣稱他們提出的 MinD-Vis 模型首次實(shí)現(xiàn)了將基于 fMRI 的大腦活動(dòng)信號(hào)解碼成圖像的成就,并且重建出的圖像不僅細(xì)節(jié)豐富而且還包含準(zhǔn)確的語義和圖像特征(紋理和形狀等)。

MinD-Vis 工作流程示意圖

我們來看看 MinD-Vis 的兩個(gè)工作階段。如圖所示,在 A 階段,使用 SC-MBM(稀疏編碼的掩碼大腦建模)在 fMRI 上進(jìn)行預(yù)訓(xùn)練。然后為 fMRI 隨機(jī)加掩碼,再將它們 token 化成大型嵌入。研究者訓(xùn)練了一個(gè)自動(dòng)編碼器來恢復(fù)被掩蓋的圖塊。在 B 階段,通過雙條件(double conditioning)與隱含擴(kuò)散模型(LDM)整合。使用一個(gè)隱含維度投射算法,通過兩條路徑將 fMRI 隱含空間投射到 LDM 條件空間。其中一條路徑是直接連接 LDM 中的交叉注意力頭。另一條路徑是將 fMRI 隱含量加到時(shí)間嵌入中。

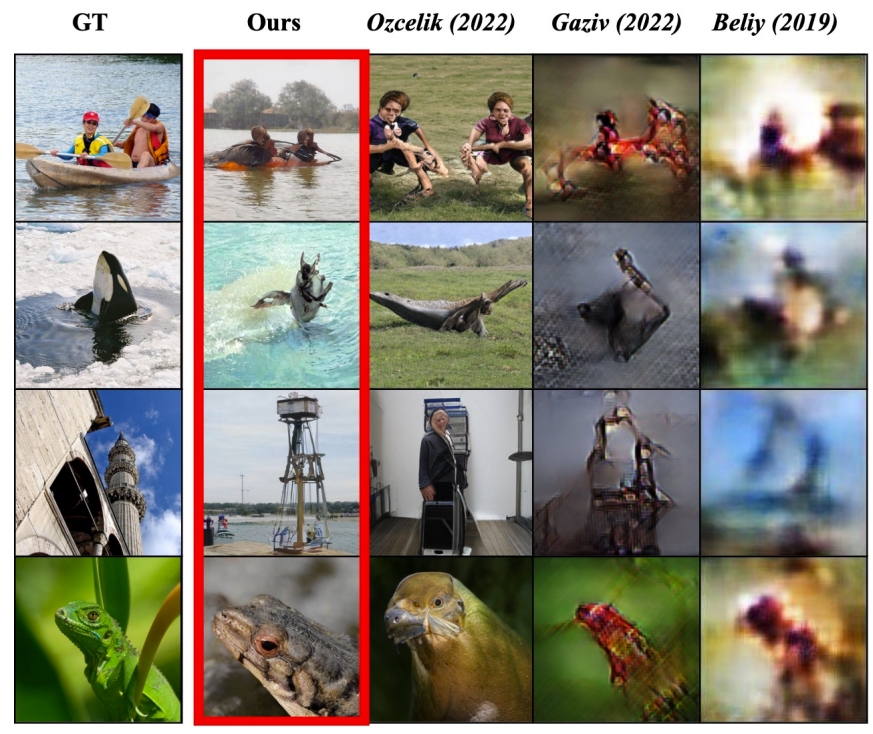

從論文給出的實(shí)驗(yàn)結(jié)果看,這個(gè)模型的讀心能力確實(shí)非常不錯(cuò):

其中左圖是受試者看到的原始圖片,紅框標(biāo)記了 MinD-Vis 的重建結(jié)果,而后面三列是其它方法的結(jié)果。

結(jié)語

隨著數(shù)據(jù)量的增長和算法的改進(jìn),人工智能正在越來越深刻地理解我們這個(gè)世界,而我們?nèi)祟愖鳛檫@個(gè)世界的一部分自然也是被理解的對(duì)象 —— 通過發(fā)掘人類大腦的活動(dòng)模式,機(jī)器正在獲得從底層理解人類所思所想的能力。也許未來某一天,AI 能夠成為真正的讀心大師,甚至可能還將具備高保真地捕捉人類夢境的能力!

上文只是簡單介紹了 AI 在直接讀心方面的一些近期研究成果,而實(shí)際上已經(jīng)有一些公司開始致力于相關(guān)技術(shù)的商業(yè)化,比如以 Neuralink 和 Blackrock Neurotech 為代表的腦機(jī)接口和神經(jīng)技術(shù)公司,它們未來的潛在產(chǎn)品將具有激動(dòng)人心的應(yīng)用前景,比如幫助無法表達(dá)的殘障人士重建與世界的聯(lián)系、遠(yuǎn)程操控在深海和太空等危險(xiǎn)區(qū)域作業(yè)的機(jī)器。同時(shí),這些技術(shù)的發(fā)展也讓許多人看到了破譯人類意識(shí)之謎的希望。

當(dāng)然,這類技術(shù)也引發(fā)了不少人關(guān)于隱私、安全和道德倫理的擔(dān)憂,畢竟我們已經(jīng)在許多電影或小說中看到過這類技術(shù)被用于邪惡目的了。現(xiàn)如今,這類技術(shù)的進(jìn)一步發(fā)展已經(jīng)不可避免,因此如何確保這些技術(shù)與人類的利益保持一致就成了需要所有相關(guān)人士和政策制定者思考和討論的重要問題。