何愷明MIT求職演講現場:提前三小時就有排隊,超百頁PPT回顧CV發展,以及“大神月半了”

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

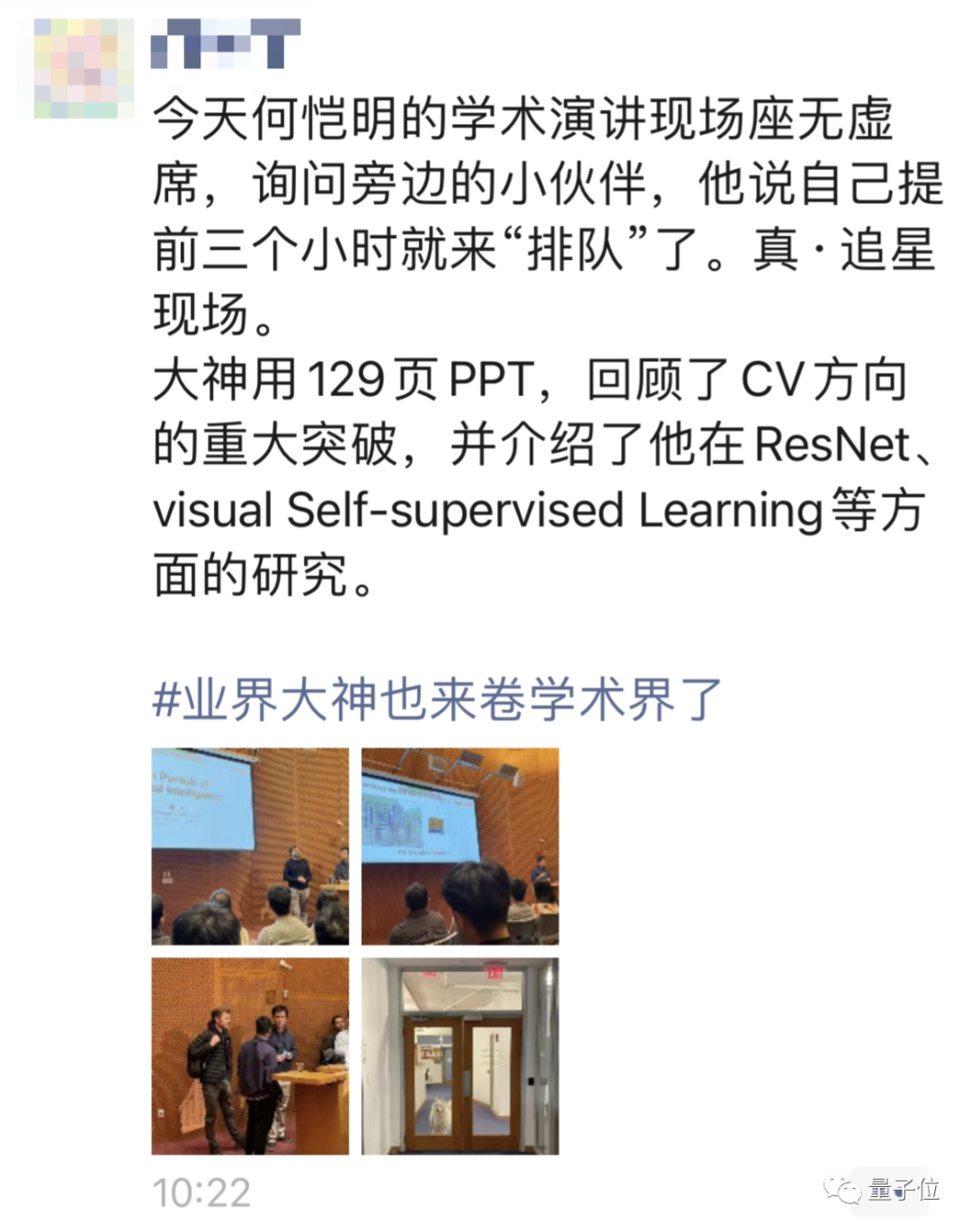

何愷明MIT求職演講,真成AI圈大型追星現場了!

據量子位身處現場的聽眾朋友傳回的消息,有同學提前3個小時已經蹲在門口排隊了。

到演講開始前半個小時,門口的隊伍據說都打了好幾個彎……

△后續更正,PPT不止129頁

來淺淺感受一下現場的氛圍:

此前何愷明回歸學界的消息傳出,咱們就聊過,這次Job Talk(求職演講)代表何愷明至少已經通過了MIT的簡歷篩選,研究成果和能力得到了初步認可。

對于這次演講,何愷明也是準備了超129頁PPT,回顧了他在CV領域所做的工作,涵蓋ResNet、Faster RCNN、Mask RCNN、MoCO和MAE。

在談到未來工作方向時,何愷明還提到了AI for Science。

除了關心大神的演講本身,還有網友注意到了何愷明的最新變化:

何愷明重返學界

目前,尚不能確定何愷明最后是否會和MIT成功牽手。但此次演講,是他尋求教職傳聞的靴子落地。

還有網友發現,如果何愷明最終成功入職,那么他將成為MIT被引次數最高的人。

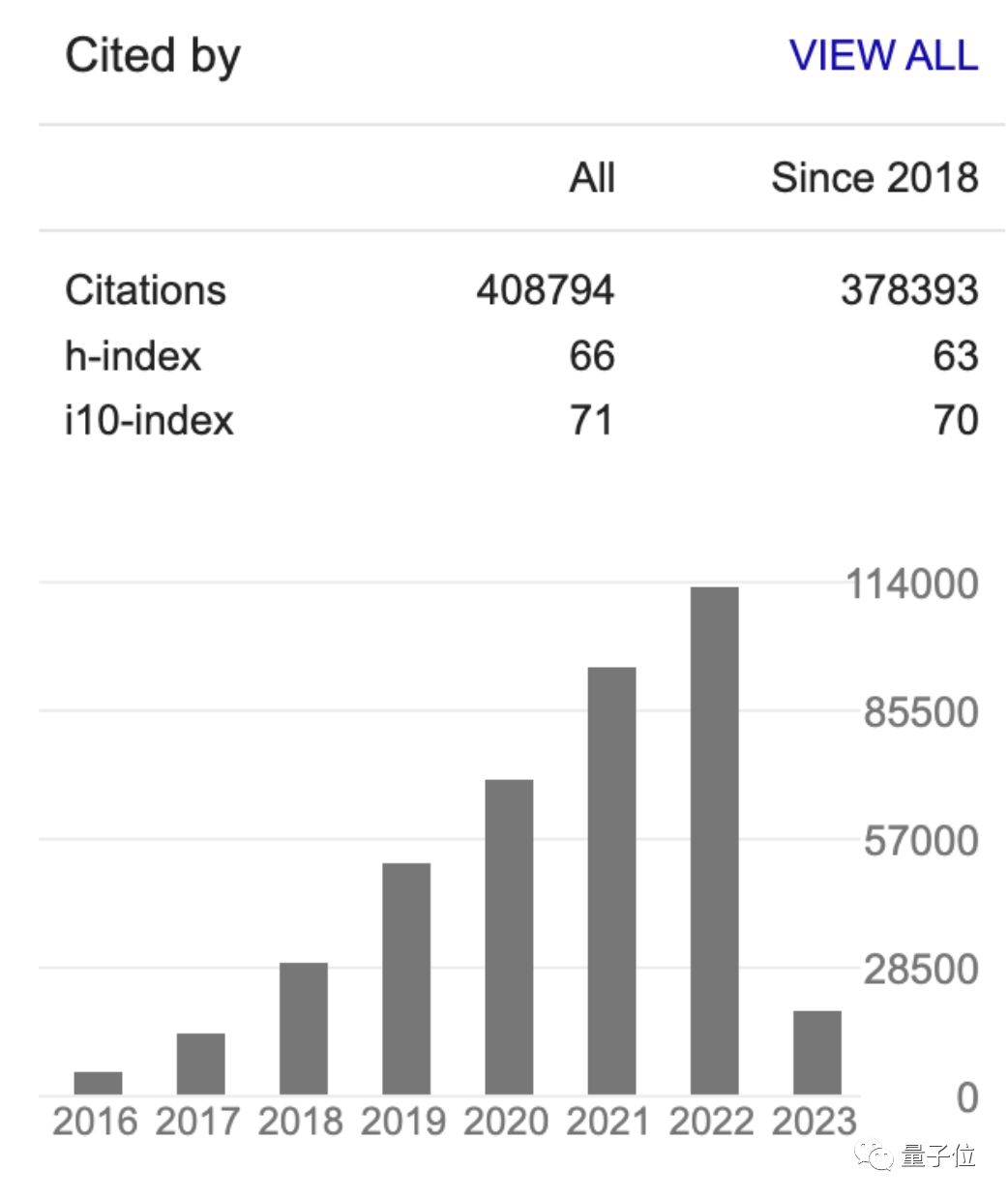

目前,MIT全校被引用次數最高的,是化學與生物醫學工程系的重量級教授Robert Langer,次數為38萬+。

而何愷明被引用次數高達40萬+。

其中,何愷明最出圈的研究,非ResNet莫屬,在2021年底突破10萬大關,如今已經漲到15萬。

ResNet本身雖為計算機視覺領域研究,但其核心思想殘差連接已經跨界成為現代深度學習模型的基本組件。

開啟上一次AI熱潮的AlphaGo Zero就是結合了ResNet+強化學習+蒙特卡洛搜索共同完成。而開啟最新AI熱潮的ChatGPT,其中的“T”也就是Transformer網絡中同樣使用了殘差連接。

在計算機視覺上,何愷明的主要貢獻還包括Faster R-CNN及后續的Mask R-CNN等一系列研究,在很多年都是目標檢測的主流方法。

他的近期主要研究興趣是無監督學習,21年底提出的MAE,將語言模型的掩碼預訓練方法用在視覺模型上,為視覺大規模無監督預訓練大模型開路。最近他還將掩碼方法引入眾多AI繪畫應用的基礎模型CLIP,把訓練速度提升了3.7倍。

不過也有知乎匿名用戶從現場發來看法:整個Talk的質量并不好,何愷明沒用一個好的故事把工作串聯起來。

這是不是說明就連何愷明也不知道怎么講好CV故事了。