Diffusion+目標(biāo)檢測(cè)=可控圖像生成!華人團(tuán)隊(duì)提出GLIGEN,完美控制對(duì)象的空間位置

隨著Stable Diffusion的開(kāi)源,用自然語(yǔ)言進(jìn)行圖像生成也逐漸普及,許多AIGC的問(wèn)題也暴露了出來(lái),比如AI不會(huì)畫(huà)手、無(wú)法理解動(dòng)作關(guān)系、很難控制物體的位置等。

其主要原因還是在于「輸入接口」只有自然語(yǔ)言,無(wú)法做到對(duì)畫(huà)面的精細(xì)控制。

最近來(lái)自威斯康星大學(xué)麥迪遜分校、哥倫比亞大學(xué)和微軟的研究熱源提出了一個(gè)全新的方法GLIGEN,以grounding輸入為條件,對(duì)現(xiàn)有「預(yù)訓(xùn)練文本到圖像擴(kuò)散模型」的功能進(jìn)行擴(kuò)展。

論文鏈接:https://arxiv.org/pdf/2301.07093.pdf

項(xiàng)目主頁(yè):https://gligen.github.io/

體驗(yàn)鏈接:https://huggingface.co/spaces/gligen/demo

為了保留預(yù)訓(xùn)練模型的大量概念知識(shí),研究人員沒(méi)有選擇對(duì)模型進(jìn)行微調(diào),而是通過(guò)門(mén)控機(jī)制將輸入的不同grounding條件注入到新的可訓(xùn)練層中,以實(shí)現(xiàn)對(duì)開(kāi)放世界圖像生成的控制。

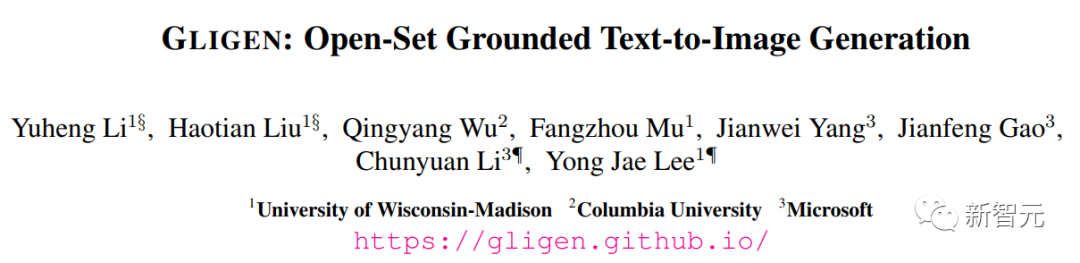

目前GLIGEN支持四種輸入。

(左上)文本實(shí)體+box (右上)圖像實(shí)體+box

(左下)圖像風(fēng)格+文本+box (右下)文本實(shí)體+關(guān)鍵點(diǎn)

實(shí)驗(yàn)結(jié)果也顯示,GLIGEN 在 COCO 和 LVIS 上的zero-shot性能大大優(yōu)于目前有監(jiān)督layout-to-image基線。

可控圖像生成

在擴(kuò)散模型之前,生成對(duì)抗網(wǎng)絡(luò)(GANs)一直是圖像生成領(lǐng)域的一哥,其潛空間和條件輸入在「可控操作」和「生成」方面得到了充分的研究。

文本條件自回歸和擴(kuò)散模型表現(xiàn)出驚人的圖像質(zhì)量和概念覆蓋率,得益于其更穩(wěn)定的學(xué)習(xí)目標(biāo)和對(duì)網(wǎng)絡(luò)圖像-文本配對(duì)數(shù)據(jù)的大規(guī)模訓(xùn)練,并迅速出圈,成為輔助藝術(shù)設(shè)計(jì)和創(chuàng)作的工具。

但現(xiàn)有的大規(guī)模文本-圖像生成模型不能以「文本之外」的其他輸入模式為條件,缺乏精確定位概念或使用參考圖像來(lái)控制生成過(guò)程的能力,限制了信息的表達(dá)。

比如說(shuō),使用文本很難描述一個(gè)物體的精確位置,而邊界框(bounding

boxes)或關(guān)鍵點(diǎn)(keypoints)則可以很容易實(shí)現(xiàn)。

現(xiàn)有的一些工具如inpainting, layout2img生成等可以利用除文本以外的模態(tài)輸入,但卻很少將這些輸入結(jié)合起來(lái)用于可控的text2img生成。

此外,先前的生成模型通常是在特定任務(wù)的數(shù)據(jù)集上獨(dú)立訓(xùn)練的,而在圖像識(shí)別領(lǐng)域,長(zhǎng)期以來(lái)的范式是通過(guò)從「大規(guī)模圖像數(shù)據(jù)」或「圖像-文本對(duì)」上預(yù)訓(xùn)練的基礎(chǔ)模型開(kāi)始建立特定任務(wù)的模型。

擴(kuò)散模型已經(jīng)在數(shù)十億的圖像-文本對(duì)上進(jìn)行了訓(xùn)練,一個(gè)很自然的問(wèn)題是:我們能否在現(xiàn)有的預(yù)訓(xùn)練的擴(kuò)散模型的基礎(chǔ)上,賦予它們新的條件輸入模式?

由于預(yù)訓(xùn)練模型所具有的大量概念知識(shí),可能能夠在其他生成任務(wù)上取得更好的性能,同時(shí)獲得比現(xiàn)有文本-圖像生成模型更多的可控性。

GLIGEN

基于上述目的和想法,研究人員提出的GLIGEN模型仍然保留文本標(biāo)題作為輸入,但也啟用了其他輸入模態(tài),如grounding概念的邊界框、grounding參考圖像和grounding部分的關(guān)鍵點(diǎn)。

這里面的關(guān)鍵難題是在學(xué)習(xí)注入新的grounding信息的同時(shí),還保留預(yù)訓(xùn)練模型中原有的大量概念知識(shí)。

為了防止知識(shí)遺忘,研究人員提出凍結(jié)原來(lái)的模型權(quán)重,并增加新的可訓(xùn)練的門(mén)控Transformer層以吸收新的grouding輸入,下面以邊界框?yàn)槔?/span>

指令輸入?

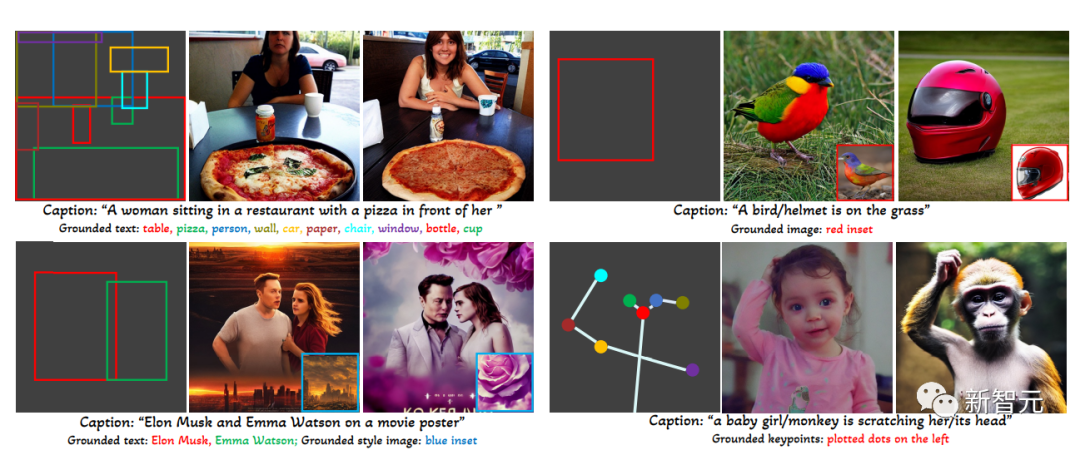

每個(gè)grouding文本實(shí)體都被表示為一個(gè)邊界框,包含左上角和右下角的坐標(biāo)值。

需要注意的是,現(xiàn)有的layout2img相關(guān)工作通常需要一個(gè)概念詞典,在評(píng)估階段只能處理close-set的實(shí)體(如COCO類(lèi)別),研究人員發(fā)現(xiàn)使用編碼圖像描述的文本編碼器即可將訓(xùn)練集中的定位信息泛化到其他概念上。

訓(xùn)練數(shù)據(jù)?

用于生成grounding圖像的訓(xùn)練數(shù)據(jù)需要文本c和grounding實(shí)體e作為條件,在實(shí)踐中可以通過(guò)考慮更靈活的輸入來(lái)放松對(duì)數(shù)據(jù)的要求。

主要有三種類(lèi)型的數(shù)據(jù)

1. grounding數(shù)據(jù)

每張圖片都與描述整張圖片的標(biāo)題相關(guān)聯(lián);名詞實(shí)體從標(biāo)題中提取,并標(biāo)上邊界框。

由于名詞實(shí)體直接取自自然語(yǔ)言的標(biāo)題,它們可以涵蓋更豐富的詞匯,有利于開(kāi)放世界詞匯的grounding生成。

2. 檢測(cè)數(shù)據(jù) Detection data

名詞實(shí)體是預(yù)先定義的close-set類(lèi)別(例如COCO中的80個(gè)物體類(lèi)別),選擇使用classifier-free引導(dǎo)中的空標(biāo)題token作為標(biāo)題。

檢測(cè)數(shù)據(jù)的數(shù)量(百萬(wàn)級(jí))大于基礎(chǔ)數(shù)據(jù)(千級(jí)),因此可以大大增加總體訓(xùn)練數(shù)據(jù)。

3. 檢測(cè)和標(biāo)題數(shù)據(jù) Detection and Caption data

名詞實(shí)體與檢測(cè)數(shù)據(jù)中的名詞實(shí)體相同,而圖像是單獨(dú)用文字標(biāo)題描述的,可能存在名詞實(shí)體與標(biāo)題中的實(shí)體不完全一致的情況。

比如標(biāo)題只給出了對(duì)客廳的高層次描述,沒(méi)有提到場(chǎng)景中的物體,而檢測(cè)標(biāo)注則提供了更精細(xì)的物體層次的細(xì)節(jié)。

門(mén)控注意力機(jī)制?

研究人員的目標(biāo)是為現(xiàn)有的大型語(yǔ)言-圖像生成模型賦予新的空間基礎(chǔ)能力,

大型擴(kuò)散模型已經(jīng)在網(wǎng)絡(luò)規(guī)模的圖像文本上進(jìn)行了預(yù)訓(xùn)練,以獲得基于多樣化和復(fù)雜的語(yǔ)言指令合成現(xiàn)實(shí)圖像所需的知識(shí),由于預(yù)訓(xùn)練的成本很高,性能也很好,在擴(kuò)展新能力的同時(shí),在模型權(quán)重中保留這些知識(shí)是很重要的,可以通過(guò)調(diào)整新的模塊來(lái)逐步適應(yīng)新能力。

在訓(xùn)練過(guò)程中,使用門(mén)控機(jī)制逐漸將新的grounding信息融合到預(yù)訓(xùn)練的模型中,這種設(shè)計(jì)使生成過(guò)程中的采樣過(guò)程具有靈活性,以提高質(zhì)量和可控性。

實(shí)驗(yàn)中也證明了,在采樣步驟的前半部分使用完整的模型(所有層),在后半部分只使用原始層(沒(méi)有門(mén)控Transformer層),生成的結(jié)果能夠更準(zhǔn)確反映grounding條件,同時(shí)具有較高的圖像質(zhì)量。

實(shí)驗(yàn)部分

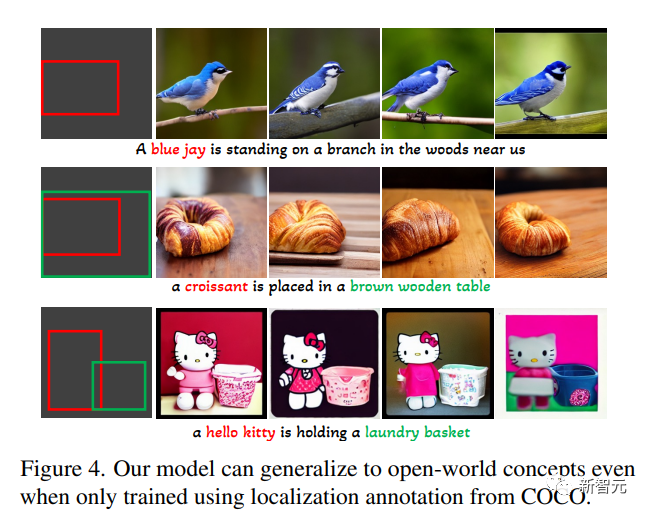

在開(kāi)放集合grounded文本到圖像生成任務(wù)中,首先只用COCO(COCO2014CD)的基礎(chǔ)標(biāo)注進(jìn)行訓(xùn)練,并評(píng)估GLIGEN是否能生成COCO類(lèi)別以外的基礎(chǔ)實(shí)體。

可以看到,GLIGEN可以學(xué)會(huì)新的概念如「藍(lán)鴉」、「羊角面包」,或新的物體屬性如「棕色木桌」,而這些信息沒(méi)有出現(xiàn)在訓(xùn)練類(lèi)別中。

研究人員認(rèn)為這是因?yàn)镚LIGEN的門(mén)控自注意力學(xué)會(huì)了為接下來(lái)的交叉注意力層重新定位與標(biāo)題中的接地實(shí)體相對(duì)應(yīng)的視覺(jué)特征,并且由于這兩層中的共享文本空間而獲得了泛化能力。

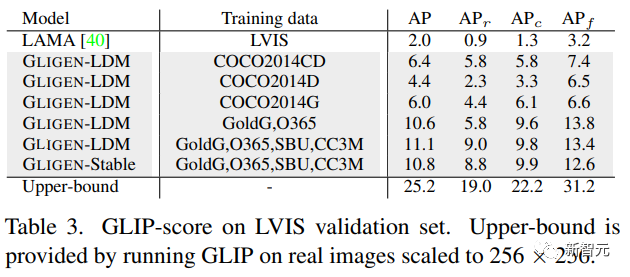

實(shí)驗(yàn)中還定量評(píng)估了該模型在LVIS上的zero-shot生成性能,該模型包含1203個(gè)長(zhǎng)尾物體類(lèi)別。使用GLIP從生成的圖像中預(yù)測(cè)邊界框并計(jì)算AP,并將其命名為GLIP得分;將其與為layout2img任務(wù)設(shè)計(jì)的最先進(jìn)的模型進(jìn)行比較,

可以發(fā)現(xiàn),盡管GLIGEN模型只在COCO標(biāo)注上進(jìn)行了訓(xùn)練,但它比有監(jiān)督的基線要好得多,可能因?yàn)閺念^開(kāi)始訓(xùn)練的基線很難從有限的標(biāo)注中學(xué)習(xí),而GLIGEN模型可以利用預(yù)訓(xùn)練模型的大量概念知識(shí)。

總的來(lái)說(shuō),這篇論文:

1. 提出了一種新的text2img生成方法,賦予了現(xiàn)有text2img擴(kuò)散模型新的grounding可控性;

2. 通過(guò)保留預(yù)訓(xùn)練的權(quán)重和學(xué)習(xí)逐漸整合新的定位層,該模型實(shí)現(xiàn)了開(kāi)放世界的grounded text2img生成與邊界框輸入,即綜合了訓(xùn)練中未觀察到的新的定位概念;

3. 該模型在layout2img任務(wù)上的zero-shot性能明顯優(yōu)于之前的最先進(jìn)水平,證明了大型預(yù)訓(xùn)練生成模型可以提高下游任務(wù)的性能