微軟多模態(tài)ChatGPT來了?16億參數(shù)搞定看圖答題、智商測驗(yàn)等任務(wù)

在 NLP 領(lǐng)域,大型語言模型(LLM)已經(jīng)成功地在各種自然語言任務(wù)中充當(dāng)通用接口。只要我們能夠?qū)⑤斎牒洼敵鲛D(zhuǎn)換為文本,就能使得基于 LLM 的接口適應(yīng)一個任務(wù)。舉例而言,摘要任務(wù)輸入文檔,輸出摘要信息。所以,我們能夠?qū)⑤斎胛臋n饋入摘要型語言模型,并生成摘要。

盡管 LLM 在 NLP 任務(wù)中取得了成功的應(yīng)用,但研究人員仍努力將其原生地用于圖像和音頻等多模態(tài)數(shù)據(jù)。作為智能的基本組成部分,多模態(tài)感知是實(shí)現(xiàn)通用人工智能的必要條件,無論是對于知識獲取還是與現(xiàn)實(shí)世界打交道。更重要的是,解鎖多模態(tài)輸入能夠極大地拓展語言模型在更多高價值領(lǐng)域的應(yīng)用,比如多模態(tài)機(jī)器人、文檔智能和機(jī)器人技術(shù)。

因此,微軟團(tuán)隊(duì)在論文《Language Is Not All You Need: Aligning Perception with Language Models》中介紹了一個多模態(tài)大型語言模型(MLLM)——KOSMOS-1,它可以感知一般模態(tài)、遵循指令(即零樣本學(xué)習(xí))以及在上下文中學(xué)習(xí)(即少樣本學(xué)習(xí))。研究目標(biāo)是使感知與 LLM 保持一致,如此一來模型能夠看到(see)和說話(talk)。研究者按照 METALM(參見論文《Language models are general-purpose interfaces》 )的方式從頭開始訓(xùn)練 KOSMOS-1。

- 論文地址:https://arxiv.org/pdf/2302.14045.pdf

- 項(xiàng)目地址:https://github.com/microsoft/unilm

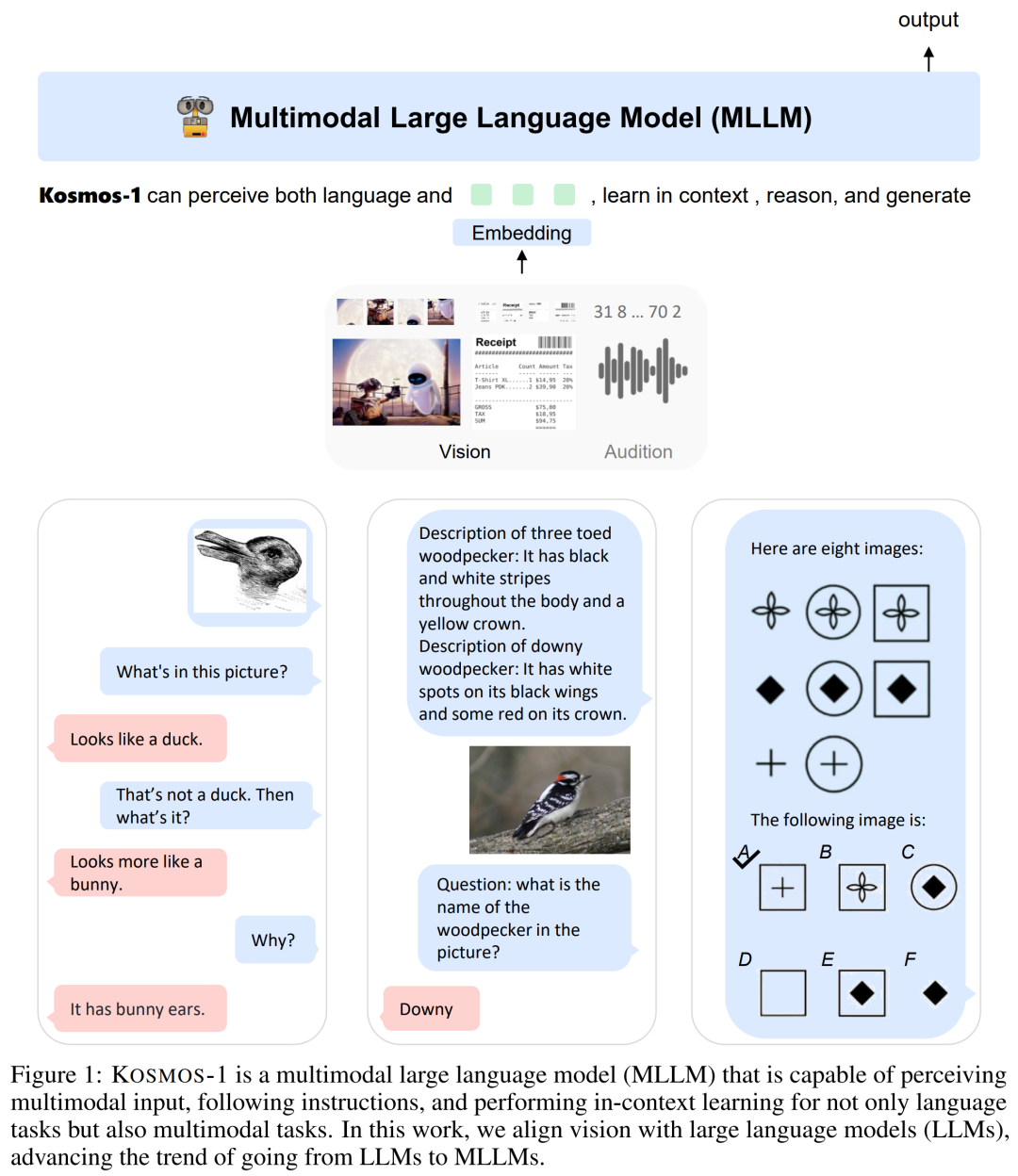

如下圖 1 所示,研究者將一個基于 Transformer 的語言模型作為通用接口,并將其與感知模塊對接。他們在網(wǎng)頁規(guī)模的多模態(tài)語料庫上訓(xùn)練模型,語料庫包括了文本數(shù)據(jù)、任意交錯的圖像和文本、以及圖像字幕對。此外,研究者還通過傳輸純語言數(shù)據(jù)來校準(zhǔn)跨模態(tài)的指令遵循能力。

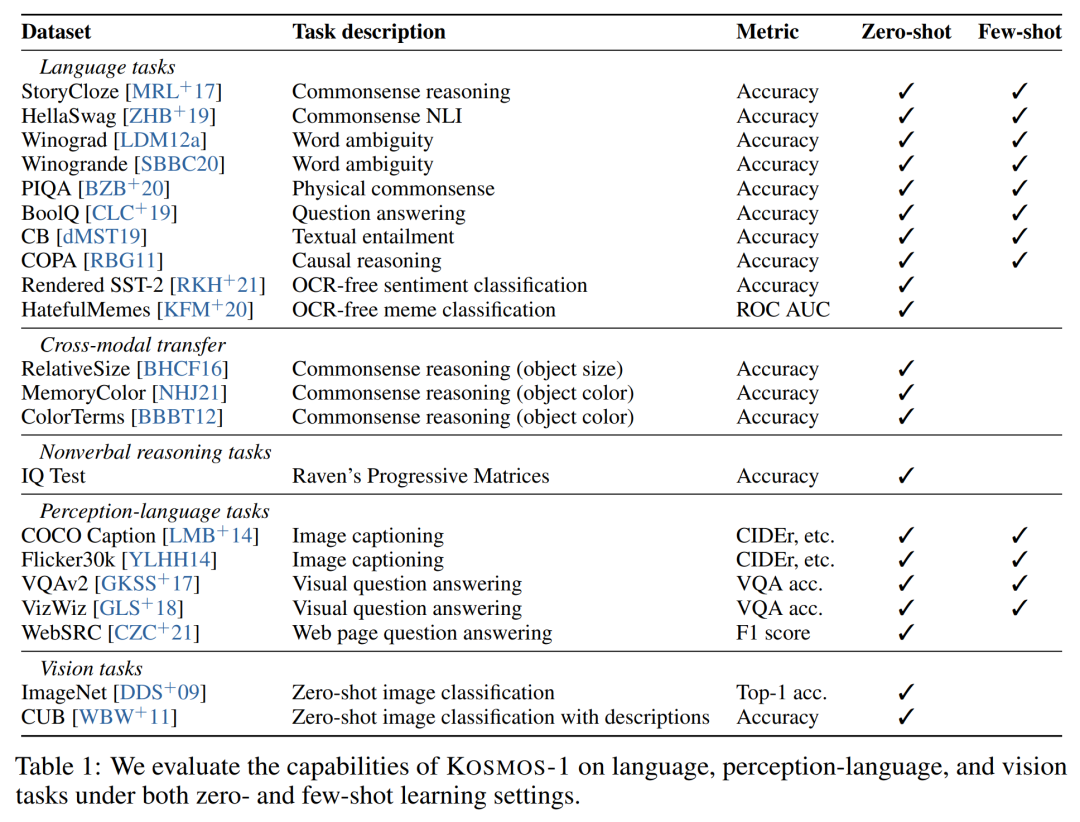

最終,KOSMOS-1 模型原生支持零樣本和少樣本學(xué)習(xí)設(shè)置下的語言、感知語言與視覺任務(wù),具體如下表 1 所示。

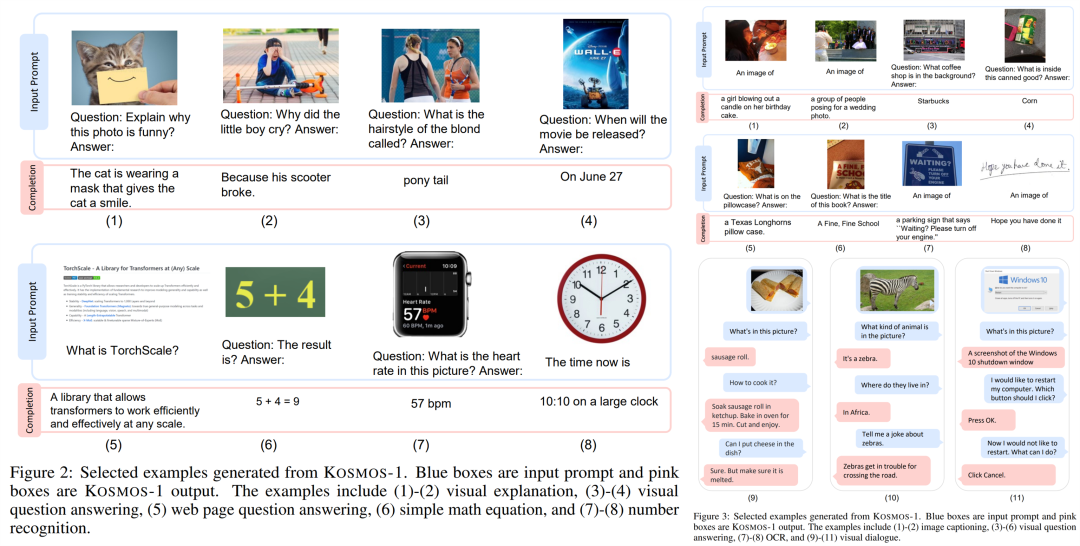

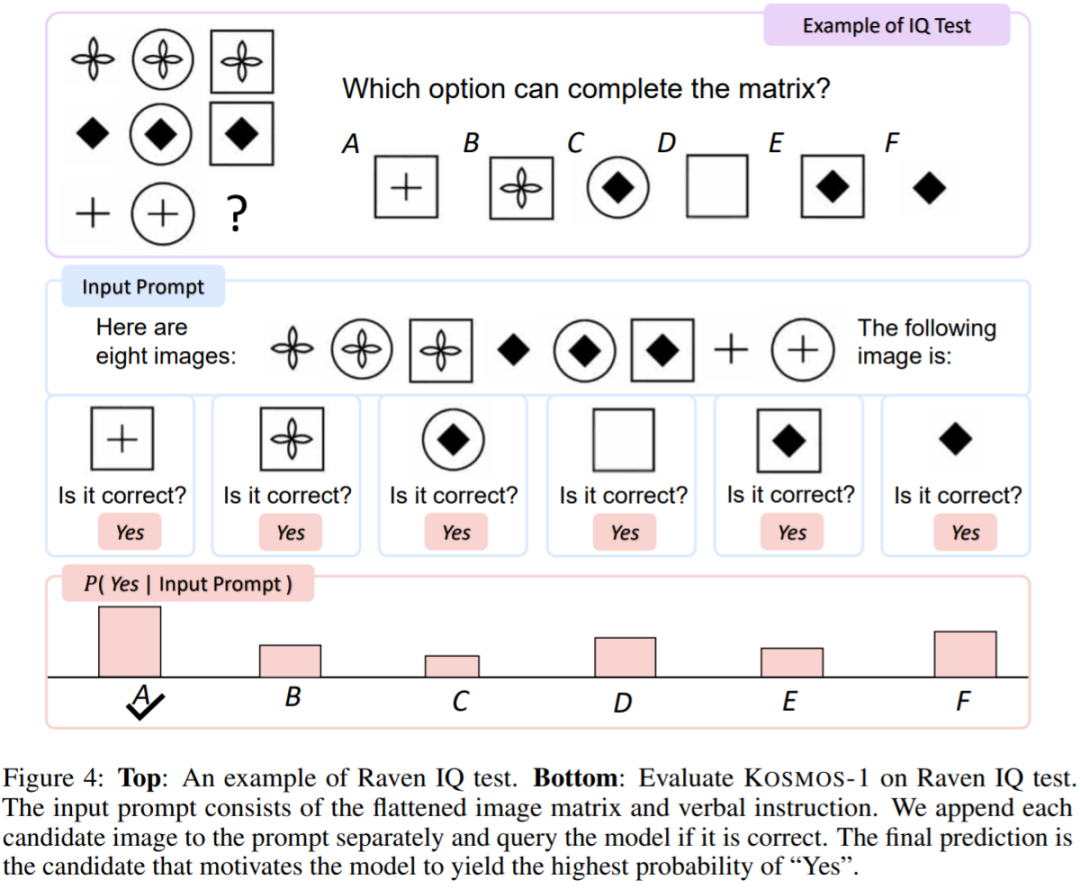

研究者在下圖 2 和圖 3 中展示了一些生成示例。除了各種自然語言任務(wù),KOSMOS-1 模型能夠原生處理廣泛的感知密集型任務(wù),如視覺對話、視覺解釋、視覺問答、圖像字幕、簡單的數(shù)學(xué)方程式、OCR 和帶描述的零樣本圖像分類。他們還根據(jù)瑞文推理測驗(yàn)(Raven's Progressive Matrices, RPM)建立了一個 IQ 測試基準(zhǔn),用來評估 MLLM 的非語言推理能力。

這些示例表明,多模態(tài)感知的原生支持為將 LLM 應(yīng)用于新任務(wù)提供了新的機(jī)遇。此外與 LLM 相比,MLLM 實(shí)現(xiàn)了更好的常識推理性能,表明了跨模態(tài)遷移有助于知識獲取。

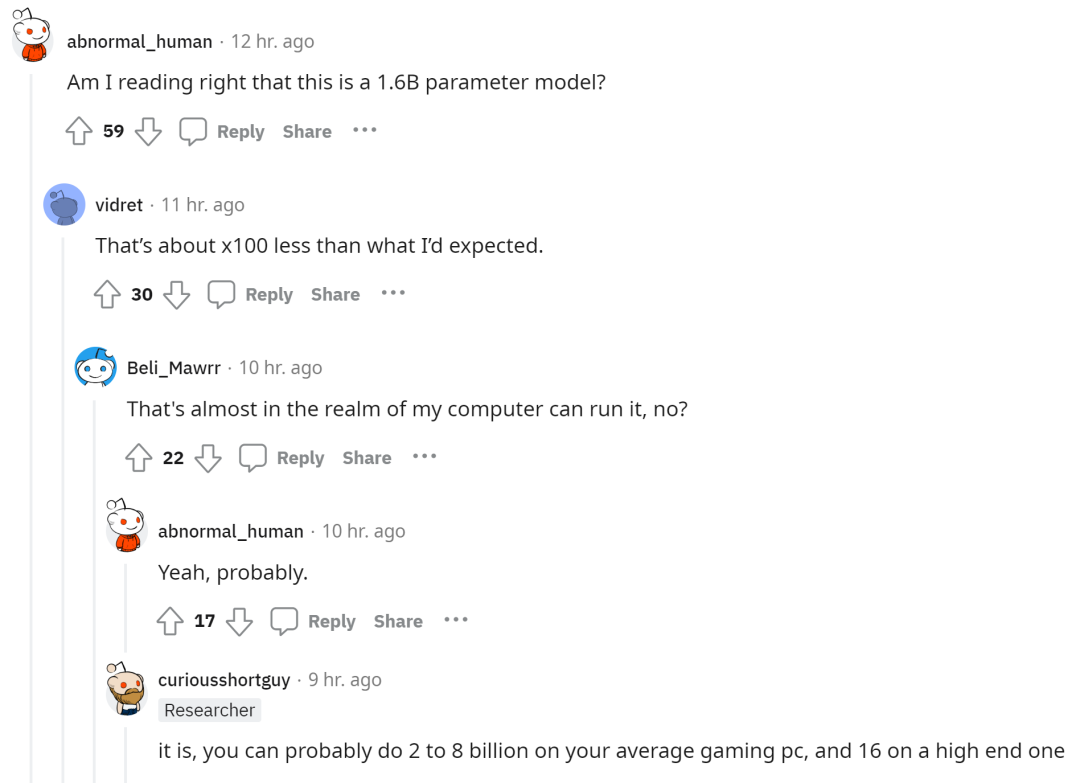

由于 KOSMOS-1 模型的參數(shù)量為 16 億,因此有網(wǎng)友表示有望在自己的電腦上運(yùn)行這個多模態(tài)大模型。

KOSMOS-1:一個多模態(tài)大型語言模型

如圖 1 所示,KOSMOS-1 是一個多模態(tài)語言模型,它既可以感知一般的模態(tài)、遵循指令、還能在上下文中學(xué)習(xí)并生成輸出。具體來說,KOSMOS-1 的主干是一個基于 Transformer 的因果語言模型。除了文本之外,其他模態(tài)也能被嵌入并輸入到該模型中,如下圖中,除了語言還有視覺、語音等的嵌入。Transformer 解碼器用作多模態(tài)輸入的通用接口。一旦模型訓(xùn)練完成,KOSMOS-1 在零樣本和少樣本設(shè)置中也能對語言任務(wù)和多模態(tài)任務(wù)進(jìn)行評估。

Transformer 解碼器以統(tǒng)一的方式感知模態(tài),輸入信息會被 flatten 為帶有特殊 token 的序列。例如 < s > 表示序列開始、</s > 表示序列結(jié)束。特殊 token <image > 和 </image > 表示編碼圖像嵌入的開始和結(jié)束。

嵌入模塊將文本 token 和其他輸入模態(tài)編碼成向量表示,對于輸入 token,該研究使用查找表將其映射到嵌入中。對于連續(xù)信號模態(tài)(例如,圖像和音頻),也可以將輸入表示為離散編碼。

之后,獲得的輸入序列嵌入會被饋送到基于 Transformer 的解碼器。然后因果模型以一種自回歸的方式處理序列,從而產(chǎn)生下一個 token。總而言之,MLLM 框架可以靈活地處理各種數(shù)據(jù)類型,只要將輸入表示為向量即可。

模型訓(xùn)練

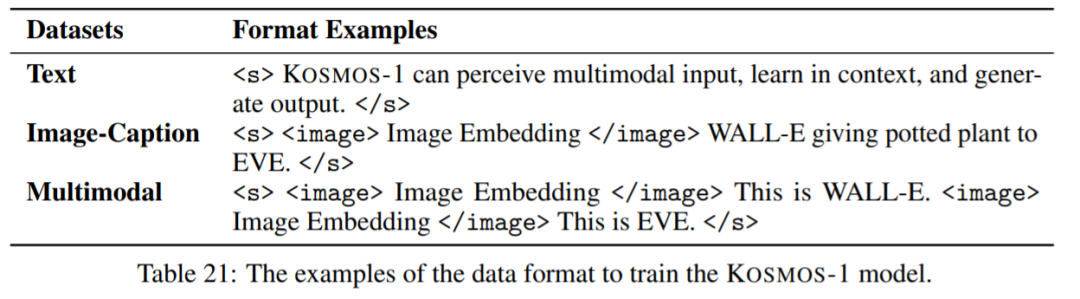

首先是訓(xùn)練數(shù)據(jù)集。數(shù)據(jù)集包括文本語料庫、圖像 - 字幕對、圖像和文本交叉數(shù)據(jù)集。具體而言,文本語料庫包括 The Pile 、Common Crawl (CC);圖像 - 字幕對包括 English LAION-2B、LAION-400M、COYO-700M 以及 Conceptual Captions;圖像和文本交叉多模態(tài)數(shù)據(jù)集來自 Common Crawl snapshot。

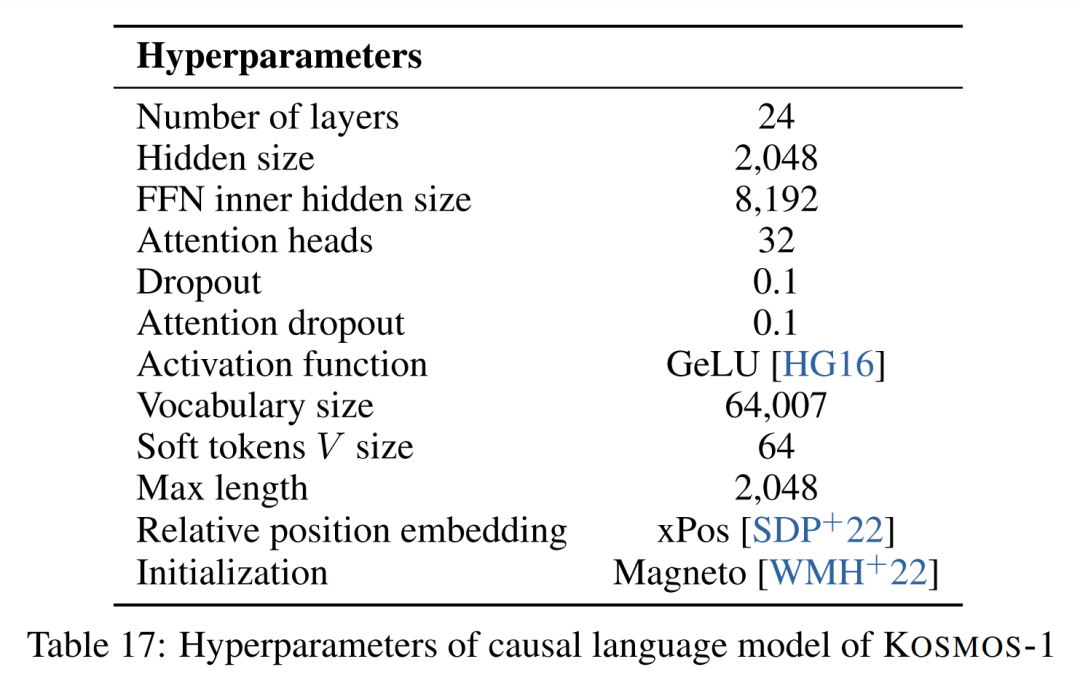

數(shù)據(jù)集有了,然后是訓(xùn)練設(shè)置。MLLM 組件包含 24 層、隱藏維度是 2048、8192 個 FFN 和 32 個注意力頭、參數(shù)量為 1.3B。為了使模型更好的收斂,圖像表示是從具有 1024 個特征維度的預(yù)訓(xùn)練 CLIP ViT-L/14 模型獲得的。圖像在訓(xùn)練過程中被預(yù)處理為 224×224 分辨率,此外,訓(xùn)練期間除了最后一層,所有的 CLIP 模型參數(shù)被凍結(jié)。KOSMOS-1 的參數(shù)總數(shù)約為 1.6B。

實(shí)驗(yàn)結(jié)果

該研究進(jìn)行了一系列豐富的實(shí)驗(yàn)來評價 KOSMOS-1 :語言任務(wù)(語言理解、語言生成、 OCR-free 文本分類);跨模態(tài)遷移(常識推理);非語言推理( IQ 測試);感知 - 語言任務(wù)(圖像字幕、視覺問答、網(wǎng)頁問答);視覺任務(wù)(零樣本圖像分類、帶有描述的零樣本圖像分類)。

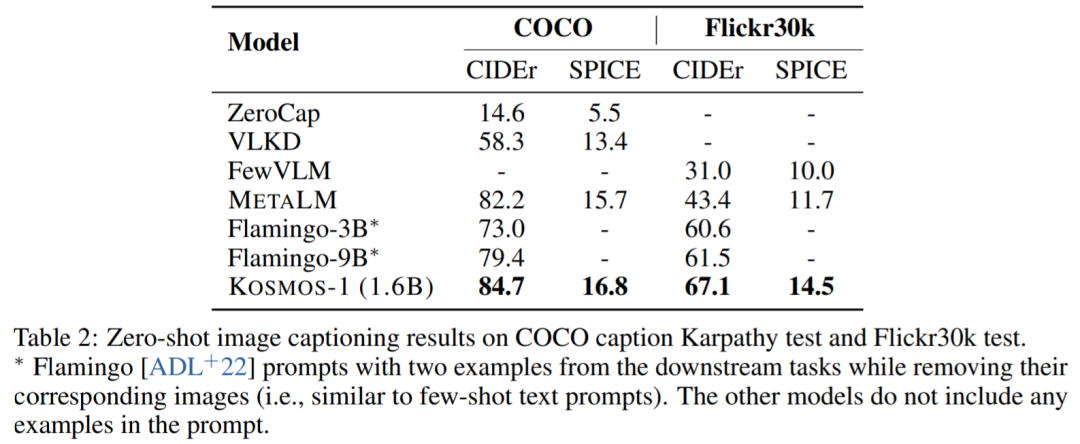

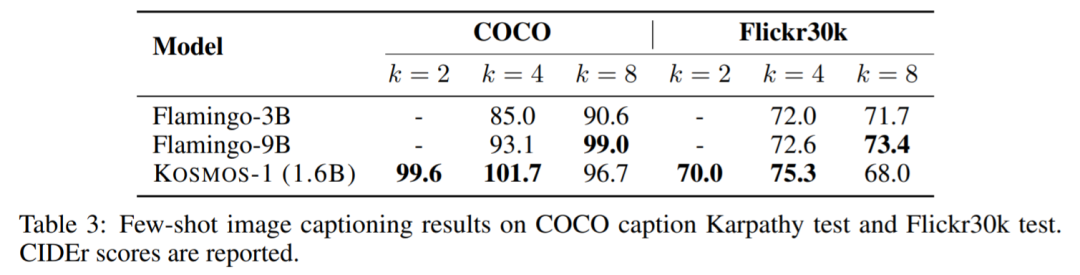

圖像字幕。下表給出了不同模型在 COCO 和 Flickr30k 上的零樣本性能。相比其他模型,KOSMOS-1 均取得了顯著效果,甚至在參數(shù)量遠(yuǎn)小于 Flamingo 的基礎(chǔ)上,性能也不錯。

下表為少樣本性能對比:

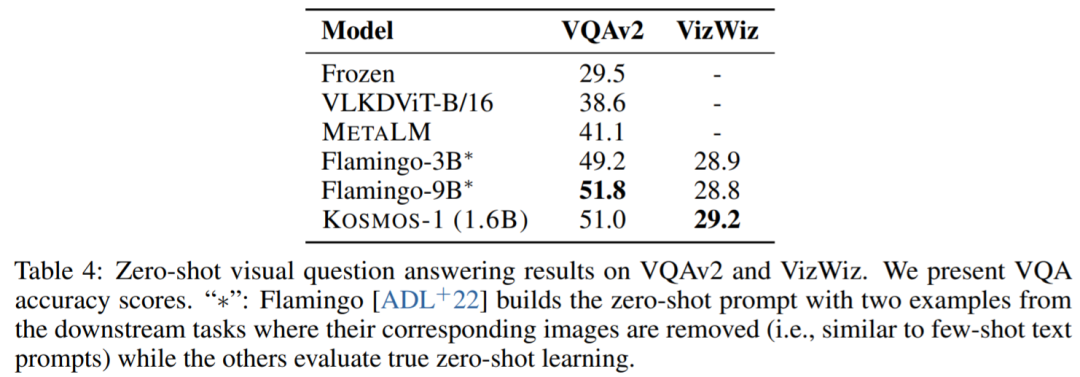

視覺問答。KOSMOS-1 比 Flamingo-3B 和 Flamingo-9B 模型具有更高的準(zhǔn)確率和魯棒性:

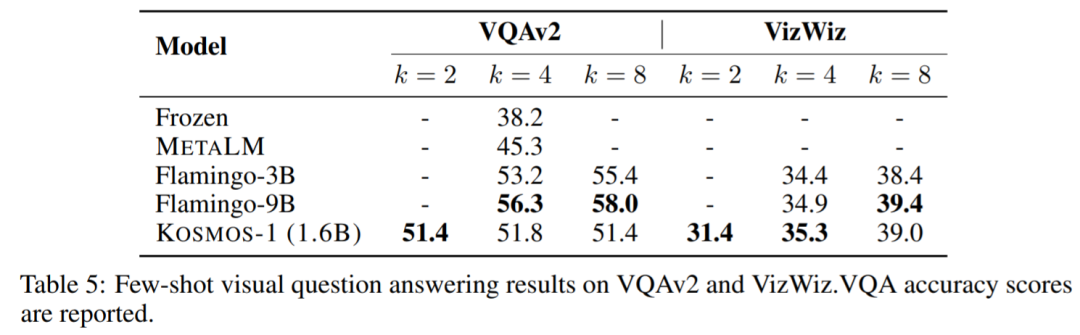

下表為少樣本性能對比:

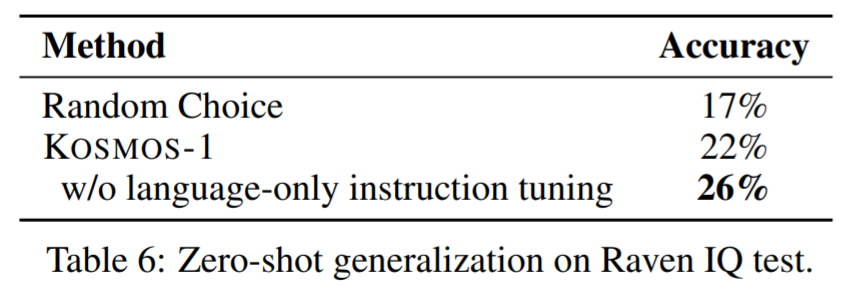

IQ 測試。瑞文推理測驗(yàn)是評估非語言推理最常見的測試之一。圖 4 顯示了一個示例。

表 6 顯示了在 IQ 測試數(shù)據(jù)集上的評估結(jié)果。KOSMOS-1 能夠在非語言環(huán)境中感知抽象概念模式,然后在多個選擇中推理出之后的元素。據(jù)了解,這是首次有模型可以執(zhí)行此類零樣本 Raven IQ 測試。

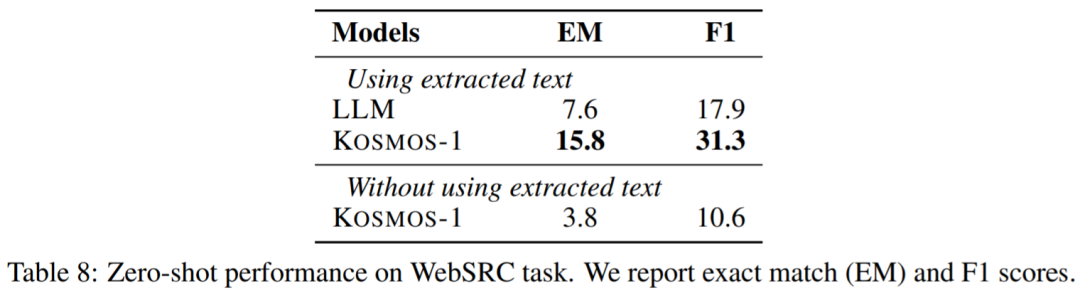

網(wǎng)頁問答。網(wǎng)頁問答旨在從網(wǎng)頁中找到問題的答案。它要求模型既能理解文本的語義,又能理解文本的結(jié)構(gòu)。結(jié)果如下:

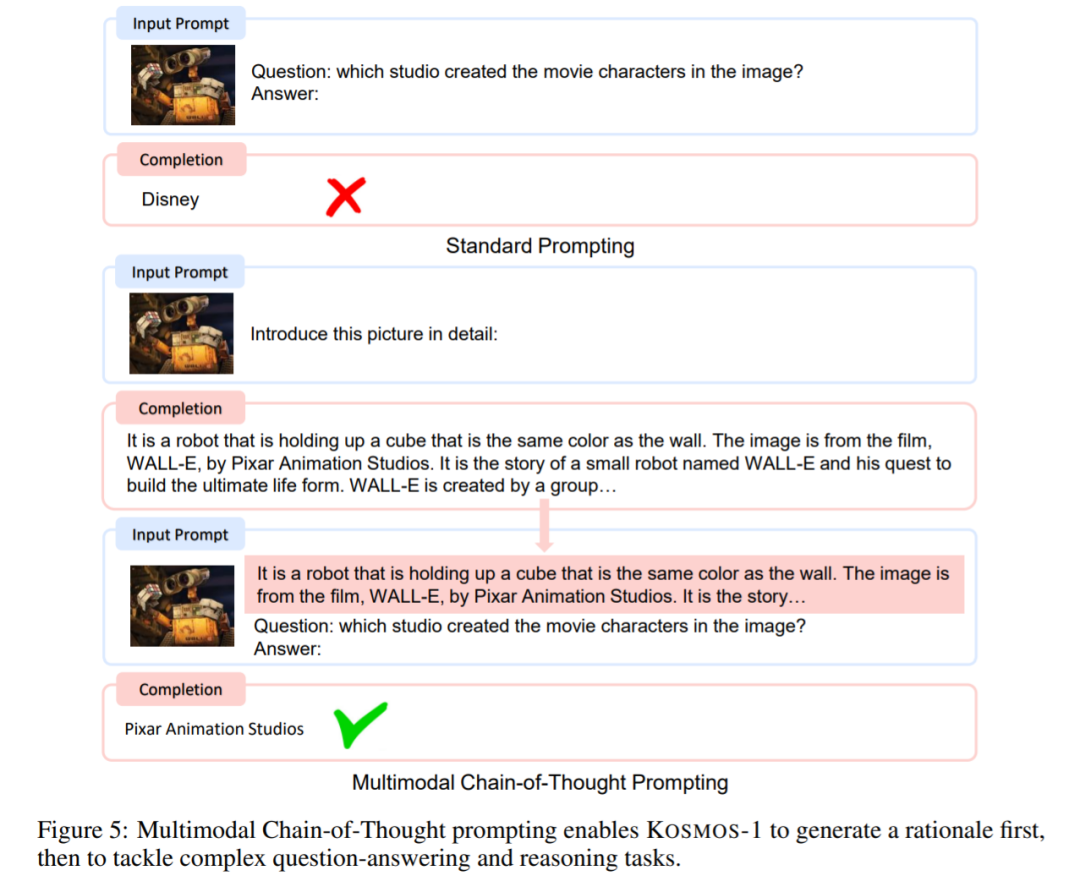

多模態(tài)思維鏈提示。受思維鏈提示的啟發(fā),本文對這方面進(jìn)行了實(shí)驗(yàn)。如圖 5 本文將感知語言任務(wù)分解為兩個步驟。在第一階段給定圖像,使用提示來引導(dǎo)模型生成符合要求的輸出,以產(chǎn)生最終結(jié)果。

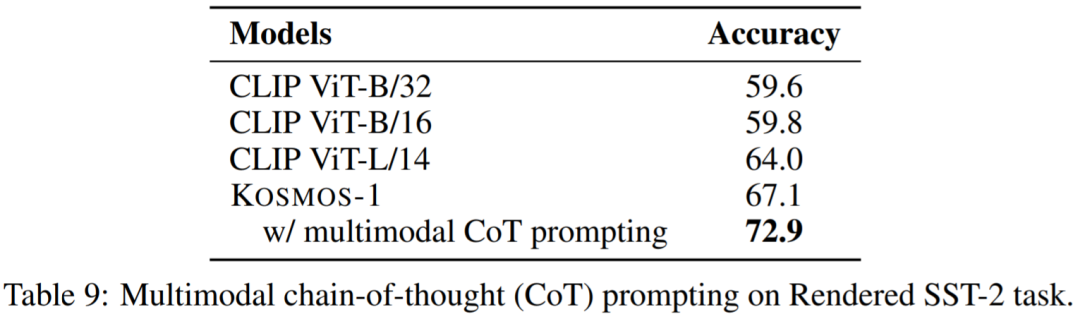

從表 9 可以看出,多模態(tài)思維鏈提示的得分為 72.9 分,比標(biāo)準(zhǔn)提示高出 5.8 分:

了解更多實(shí)驗(yàn)內(nèi)容,請參考原論文。