終結者最強大腦!谷歌發布史上最大「通才」模型PaLM-E,5620億參數,看圖說話還能操控機器人

大語言模型的飛速「變異」,讓人類社會的走向越來越科幻了。點亮這棵科技樹后,「終結者」的現實仿佛離我們越來越近。

前幾天,微軟剛宣布了一個實驗框架,能用ChatGPT來控制機器人和無人機。

谷歌當然也不甘其后,在周一,來自谷歌和柏林工業大學的團隊重磅推出了史上最大視覺語言模型——PaLM-E。

論文地址:https://arxiv.org/abs/2303.03378

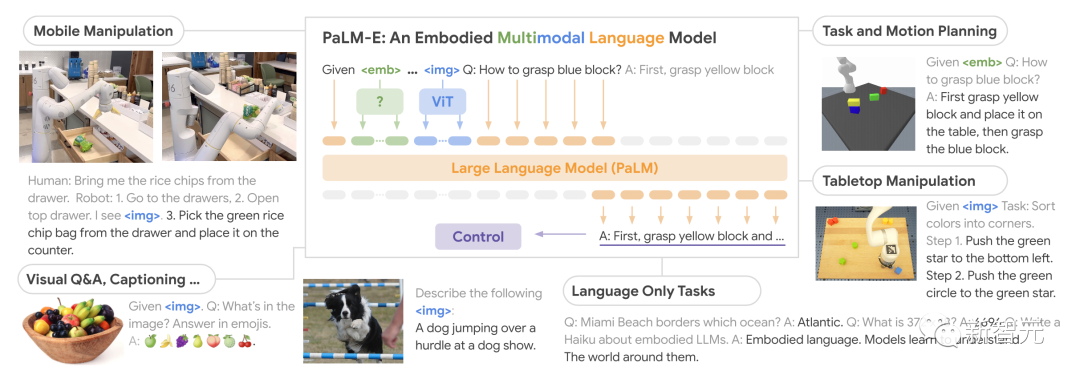

作為一種多模態具身視覺語言模型 (VLM),PaLM-E不僅可以理解圖像,還能理解、生成語言,而且竟然還能將兩者結合起來,處理復雜的機器人指令。

此外,通過PaLM-540B語言模型與ViT-22B視覺Transformer模型相結合,PaLM-E最終的參數量高達5620億。

橫跨機器人、視覺-語言領域的「通才」模型

PaLM-E,全稱Pathways Language Model with Embodied,是一種具身視覺語言模型。

它的強大之處在于,能夠利用視覺數據來增強其語言處理能力。

當我們訓練出最大的視覺語言模型,并與機器人結合后,會發生什么?結果就是PaLM-E,一個 5620億參數、通用、具身的視覺語言通才——橫跨機器人、視覺和語言

據論文介紹,PaLM-E是一個僅有解碼器的LLM,在給定前綴(prefix)或提示(prompt)下,能夠以自回歸方式生成文本補全。

其訓練數據為包含視覺、連續狀態估計和文本輸入編碼的多模式語句。

經過單個圖像提示訓練,PaLM-E不僅可以指導機器人完成各種復雜的任務,還可以生成描述圖像的語言。

可以說,PaLM-E展示了前所未有的靈活性和適應性,代表著一次重大飛躍,特別是人機交互領域。

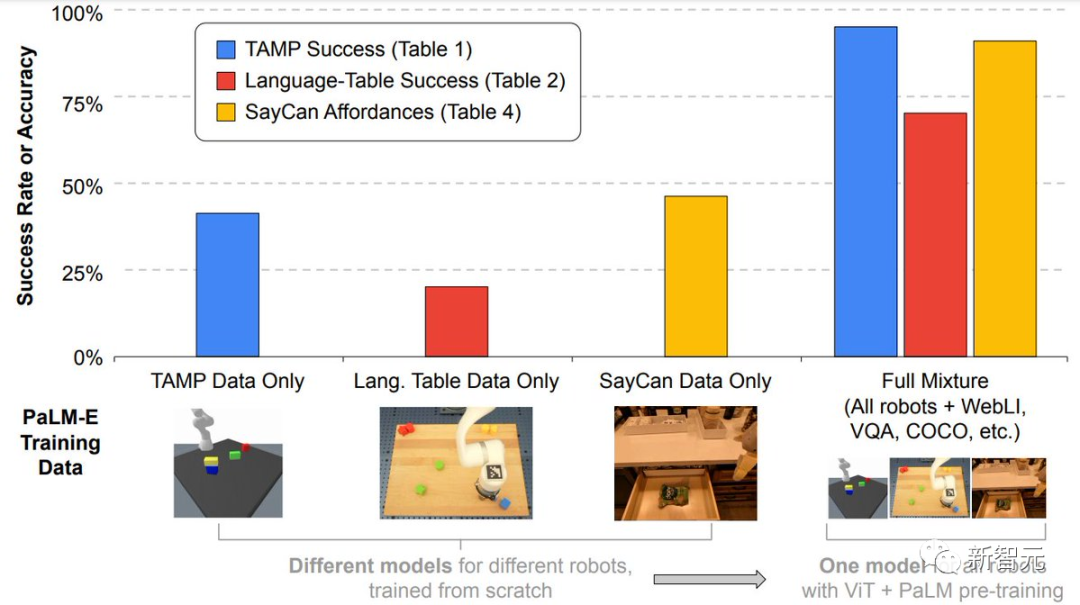

更重要的是,研究人員證明,通過在多個機器人和一般視覺語言的不同混合任務組合進行訓練,可以帶來從視覺語言轉移到具身決策的幾種方法,讓機器人規劃任務時能夠有效地利用數據。

除此之外,PaLM-E尤為突出的一點在于,擁有強大的正遷移能力。

在不同領域訓練的PaLM-E,包括互聯網規模的一般視覺-語言任務,與執行單一任務機器人模型相比,性能明顯提高。

而在模型尺度上,研究人員則觀察到了一個顯著的優勢。

語言模型越大,在視覺語言與機器人任務的訓練中,保持的語言能力就越強。

從模型規模來看,5620億參數的PaLM-E幾乎保持了它所有的語言能力。

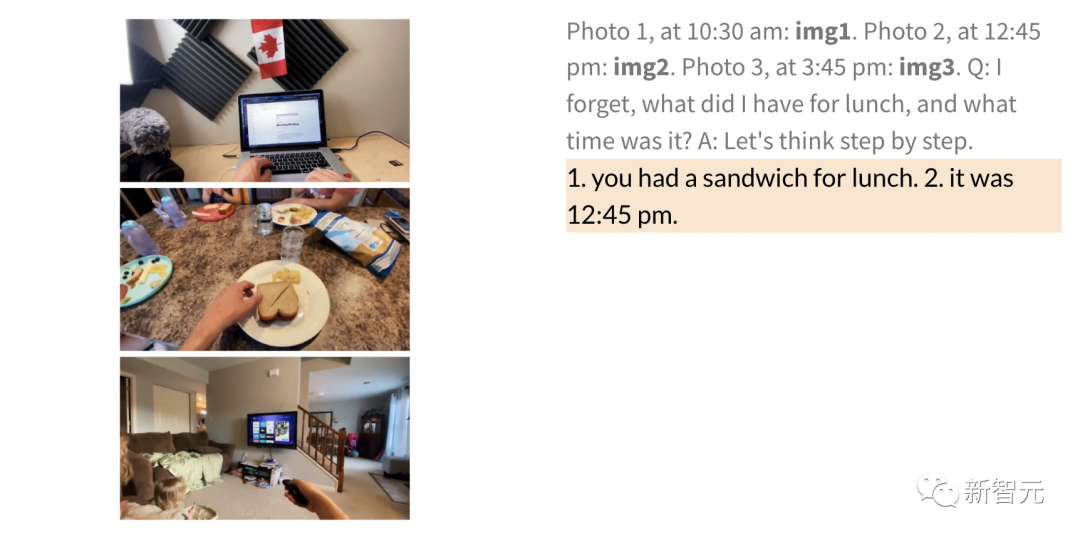

盡管只在單個圖像進行訓練,但PaLM-E在多模態思維鏈推理和多圖像推理等任務中表現出突出的能力。

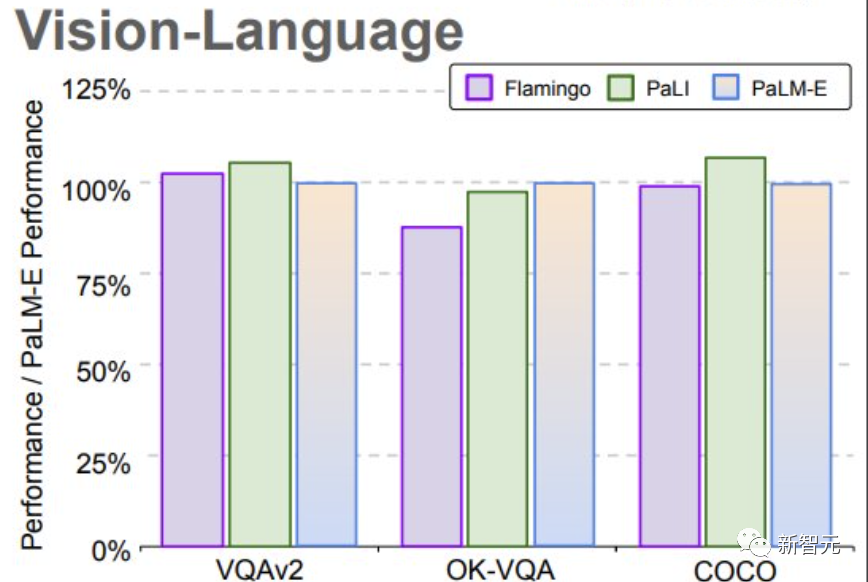

在OK-VQA基準上,PaLM-E取得了新的SOTA。

測評結果

在測試中,研究人員展示了如何使用PaLM-E在兩個不同實體上執行規劃以及長跨度的任務。

值得注意的是,所有這些結果都是使用基于相同數據訓練的相同模型獲得的。

在以前,機器人通常需要人工的協助才能完成長跨度任務。但現在,PaLM-E通過自主學習就可以搞定了。

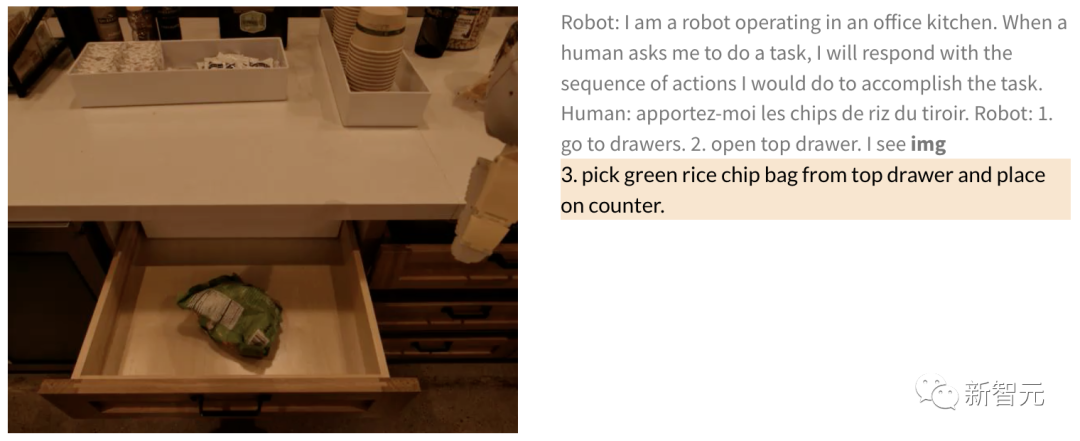

比如,「從抽屜里拿出薯片」這類指令中,就包括了多個計劃步驟,以及來自機器人攝像頭的視覺反饋。

經過端到端訓練的PaLM-E,可以直接從像素開始對機器人進行規劃。由于模型被集成到一個控制回路中,所以機器人在拿薯片的過程中,對途中的干擾都有魯棒性。

人類:給我來點薯片。

機器人:1. 走到抽屜旁 2.打開最上面的抽屜 3. 從最上面的抽屜里拿起綠色的薯片 4.放在柜臺上。

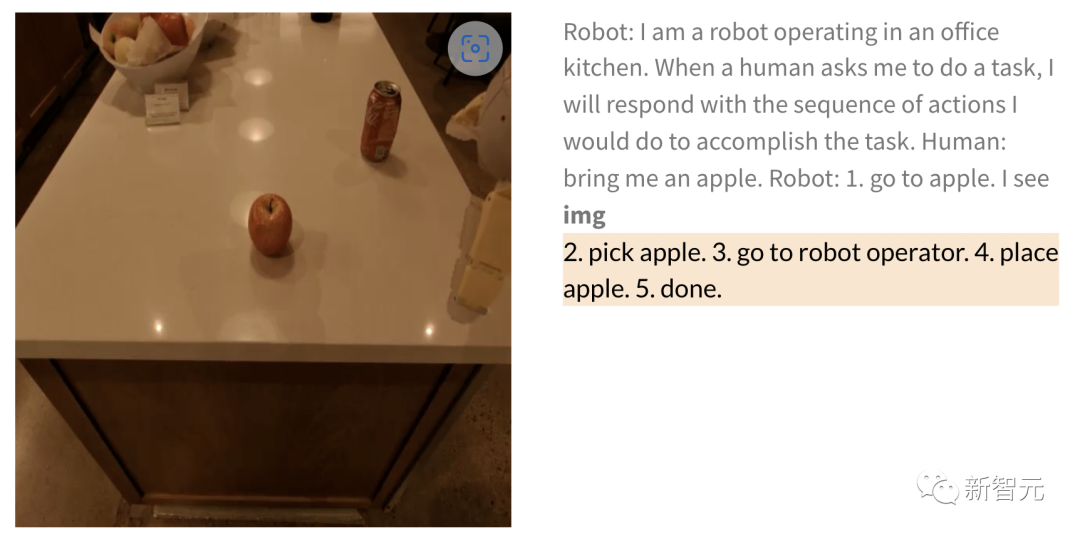

同樣,讓機器人去拿一個蘋果時,給出圖片后,機器人執行任務步驟如下——

人類:給我拿一個蘋果。

機器人:1.走向蘋果 2.拿起蘋果 3.把它拿給操作員 4.放下蘋果 5.完成。

除了執行長跨度任務,PaLM-E可以讓機器人執行規劃任務,比如排列積木。

研究人員根據視覺和語言輸入成功地進行多階段的計劃,并結合了長時間范圍的視覺反饋,進而讓模型能夠成功地規劃一個長周期的任務「將積木按顏色分類到不同的角落」。

如下,在排列組合上,機器人化身為多面手,按顏色將積木排序。

模型的泛化方面,PaLM- E控制的機器人可以把紅色積木移到咖啡杯的旁邊。

值得一提的是,數據集只包含有咖啡杯的三個演示,但其中沒有一個包括紅色的積木塊。

類似的,雖然模型此前從未見過烏龜,但照樣可以順利地把綠色積木推到烏龜旁邊

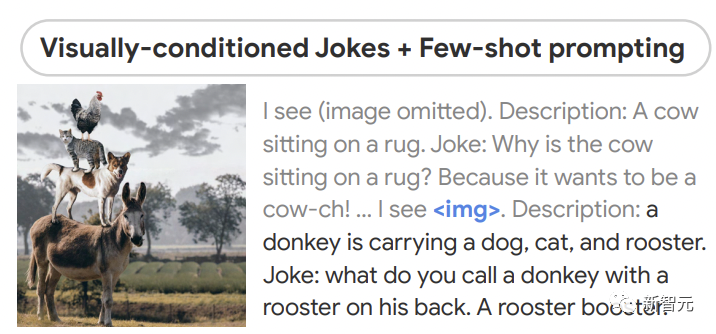

在零樣本推理方面,PaLM-E可以在給定圖像的情況下講述笑話,并展示了包括感知,基于視覺的對話和計劃在內的能力。

多張圖的關系,PaLM-E也整得很明白,比如圖一(左)在圖二(右)的哪個位置。

此外,PaLM-E還可以在給定帶有手寫數字的圖像執行數學運算。

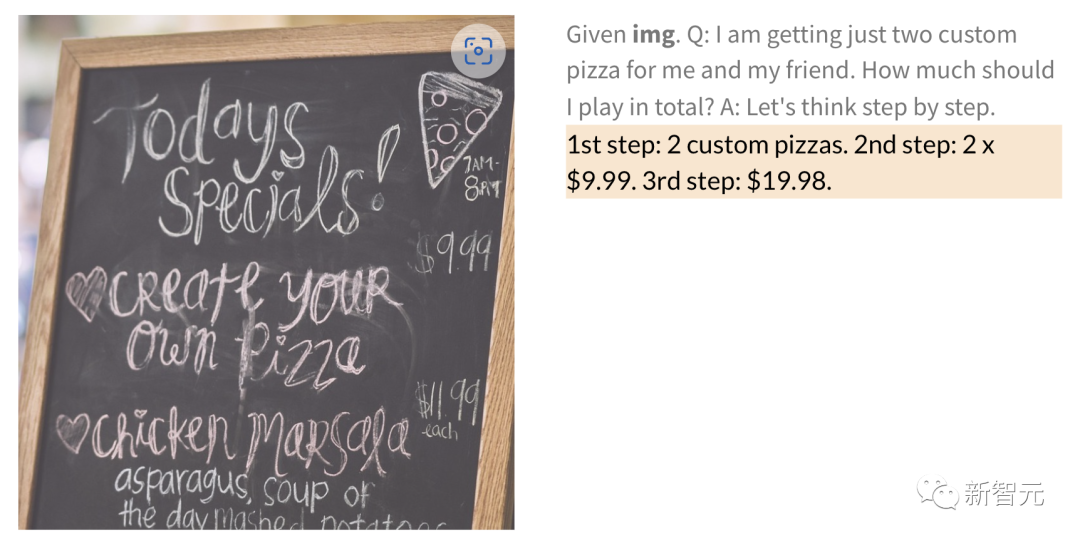

比如,如下手寫餐館的菜單圖,2張披薩需要多少錢,PaLM-E就直接給算出來了。

以及一般的QA和標注等多種任務。

最后,研究結果還表明,凍結語言模型是通向完全保留其語言能力的通用具身多模態模型的可行之路。

但同時,研究人員還發現了一條解凍模型的替代路線,即擴大語言模型的規模可以顯著減少災難性遺忘。