Google AI年終總結第六彈:沒有波士頓動力的谷歌機器人,發展得怎么樣了?

波士頓動力的一個后空翻,讓我們看到了人造機器人所帶來的無限可能。?

盡管谷歌已于2017年把波士頓動力出手了,但谷歌仍然繼續他們的機器人開發之路,不只是在「身體」上逼近人類,在「智力」也追求更好的理解人類指令。

由Jeff Dean領銜的Google Research年終總結系列「Google Research, 2022 & beyond」已經更新到第六期,本期的主題是「機器人」,作者為高級產品經理 Kendra Byrne和谷歌機器人研究科學家Jie Tan

?在我們的有生之年,一定能看到機器人技術參與到人類的日常生活中,幫助提高人類的生產力和生活質量。

在機器人技術廣泛應用于以人為中心的空間(即為人而設計的空間,而不是機器)中的日常實際工作之前,需要確保它們能夠安全地為人們提供幫助。

在2022年,谷歌關注的挑戰是使機器人更有助于人類:

- 讓機器人和人類更有效和自然地交流;

- 使機器人能夠理解和應用現實世界中的常識知識;

- 擴大機器人在非結構化環境中有效執行任務所需的低層次技能的數量。

當LLM遇上機器人

大型語言模型(LLM)的一個特性是能夠將描述和上下文編碼成「人和機器都能理解」的格式。

當把LLM應用到機器人技術中時,可以讓用戶僅通過自然語言指令就能給機器人分配任務;當與視覺模型和機器人學習方法相結合時,LLM 為機器人提供了一種理解用戶請求的上下文的方法,并能夠對完成請求所采取的行動進行規劃。

其中一個基本方法是使用 LLM 來提示其他預先訓練的模型獲取信息,以構建場景中正在發生的事情的上下文,并對多模態任務進行預測。整個過程類似于蘇格拉底式的教學方法,教師問學生問題,引導他們通過一個理性的思維過程來解答。

在「蘇格拉底模型」中,研究人員證明了這種方法可以在zero-shot圖像描述和視頻文本檢索任務中實現最先進的性能,并且還能支持新的功能,比如回答關于視頻的free-form問題和預測未來的活動,多模態輔助對話,以及機器人感知和規劃。

論文鏈接:https://arxiv.org/abs/2204.00598

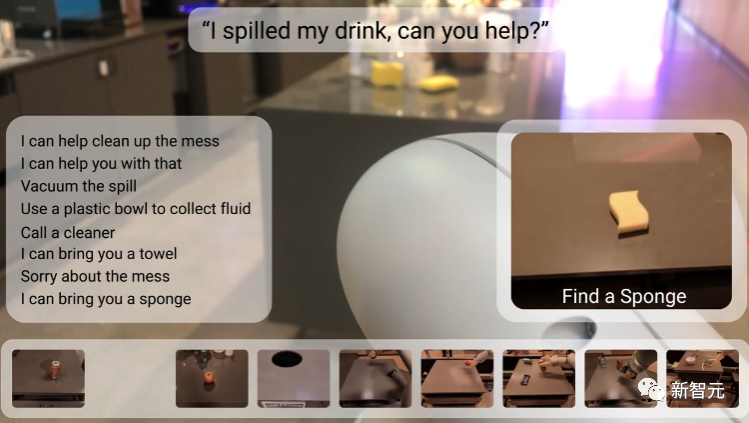

在「邁向有益的機器人: 機器人可用性的基礎語言」一文中,研究人員與Everyday Robots合作,在機器人可用性模型中基于PaLM語言模型規劃長期任務。

博客鏈接:https://ai.googleblog.com/2022/08/towards-helpful-robots-grounding.html

在之前的機器學習方法中,機器人只能接受諸如「撿起海綿」等簡短的硬編碼命令,并且難以推理完成任務所需的步驟,如果任務是一個抽象的目標,比如「你能幫忙清理這些灑出來的東西嗎?」,就更難處理了。

研究人員選擇使用 LLM 來預測完成長期任務的步驟順序,以及一個表示機器人在給定情況下實際能夠完成的技能的affordance 模型。

強化學習模型中的價值函數可以用來建立affordance 模型,即一個機器人在不同狀態下可以執行的動作的抽象表示,從而將現實世界中的長期任務,如「整理臥室」與完成任務所需的短期技能,如正確挑選、放置和安排物品等聯系起來。

論文鏈接:https://arxiv.org/abs/2111.03189

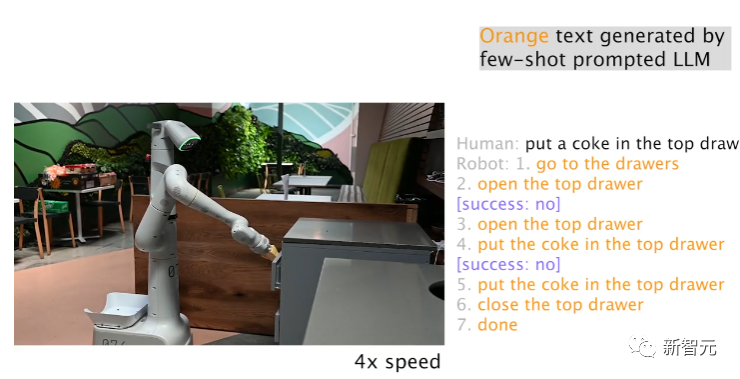

同時擁有 LLM 和affordance 模型并不意味著機器人能夠成功地完成任務,通過內心獨白( Inner Monologue),可以結束基于 LLM 的任務規劃中的循環;利用其他信息來源,如人工反饋或場景理解,可以檢測機器人何時無法正確完成任務。

論文鏈接:https://arxiv.org/abs/2207.05608

利用Everyday Robots中的一個機器人,研究人員發現 LLM 可以有效地重新規劃當前或以前的失敗計劃步,機器人可以從失敗中恢復并完成復雜的任務,比如「把一個可樂放在最上面的抽屜里」。

在基于 LLM 的任務規劃中,其中一個突出能力就是機器人可以對高級目標中間任務的變化做出反應:例如,用戶可以告訴機器人在發生的事,通過提供快速糾正或重定向機器人到另一個任務,從而可以改變已經規劃好的行動,對于讓用戶交互式地控制和定制機器人任務特別有用。

雖然自然語言使人們更容易指定和修改機器人的任務,但還有一個挑戰是對人類描述做出實時反應。

研究人員提出了一個大規模的模仿學習框架,用于生產實時的、開放詞匯的、以語言為條件的機器人,能夠處理超過87,000個獨特的指令,估計平均成功率為93.5% ;作為該項目的一部分,谷歌還發布了當下規模最大的語言標注機器人數據集 Language-Table

論文鏈接:https://arxiv.org/pdf/2210.06407.pdf

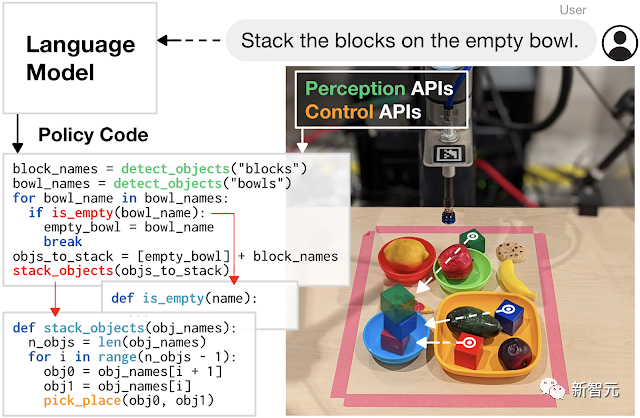

并且,用LLM 編寫代碼來控制機器人動作也是一個有前景的研究方向。

研究人員開發的代碼編寫方法展示了增加任務復雜性的潛力,機器人可以通過自主生成新代碼來重新組合 API 調用,合成新函數,并表達反饋循環來在運行時合成為新行為。

論文鏈接:https://arxiv.org/abs/2209.07753

將機器人學習轉化為一個可擴展的數據問題

大型語言和多模態模型可以幫助機器人理解他們操作的環境,比如場景中發生了什么以及機器人應該做什么;但是機器人也需要低層次的物理技能來完成物理世界中的任務,比如拾起和精確放置物體。

雖然人類經常認為這些身體技能是理所當然的,無需思考的情況下就能完成各種動作,但對機器人來說卻是個難題。

比如,機器人在拾取物體時,需要感知和理解環境,推導出手爪與物體之間的空間關系和接觸動力學,精確地驅動高自由度手臂,并施加適當的力量以穩定地抓取物體而不破壞物體。

學習到這些低層次技能的難題被稱為莫拉維克悖論:推理只需要很少的計算,但感覺運動和知覺技能需要大量的計算資源。

受到 LLM 的成功啟發,研究人員采用一種數據驅動的方法,將學習低層次物理技能的問題轉變為一個可擴展的數據問題:LLM 表明,大型Transformer模型的通用性和性能隨著數據量的增加而增加。

論文鏈接:https://robotics-transformer.github.io/assets/rt1.pdf

研究人員提出機器人Transformer -1 (RT-1) 模型,訓練了一個機器人操作策略,用到的訓練數據為13萬個episodes的大規模現實世界的機器人數據集,使用了來自Everyday Robots的13個機器人,覆蓋了700多個任務,并顯示了機器人技術的相同趨勢,即增加數據的規模和多樣性可以提高模型對新任務、環境和對象的泛化。

在語言模型和機器人學習方法(如 RT-1)的背后,都是 Transformer模型基于互聯網規模的數據訓練得到的;但與 LLM 不同的是,機器人學面臨著不斷變化的環境和有限計算的多模態表示的挑戰。

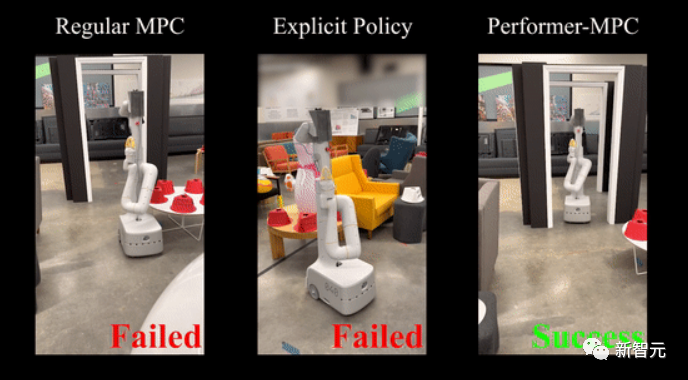

2020年,谷歌提出了一種能夠提高Transformer計算效率的方法Performers,影響到包括機器人技術在內的多個應用場景。

最近研究人員擴展該方法,引入一類新的隱式控制策略,結合了模擬學習的優勢和對系統約束的魯棒處理(模型預估計控制的約束)。

論文鏈接:https://performermpc.github.io/

與標準的 MPC 策略相比,實驗結果顯示機器人在實現目標方面有40% 以上的進步,在人類周圍導航時,social指標上有65% 以上的提升;Performance-MPC 為8.3 M 參數模型的延遲僅為8毫秒,使得在機器人上部署Transformer變得可行。

谷歌的研究團隊還證明,數據驅動方法通常適用于不同環境中的不同機器人平臺,以學習范圍廣泛的任務,包括移動操作、導航、運動和乒乓球等,也為學習低層次機器人技能指明了一條明確的道路:可擴展的數據收集。

與互聯網上豐富的視頻和文本數據不同,機器人數據極其稀缺,難以獲取,收集和有效使用代表真實世界交互的豐富數據集的方法是數據驅動方法的關鍵。

仿真是一種快速、安全和易于并行化的選擇,但是在仿真中很難復制完整的環境,特別是物理環境和人機交互環境。

論文鏈接:https://arxiv.org/abs/2207.06572

在 i-Sim2Real 中,研究人員展示了一種方法,通過從簡單的人類行為模型中自舉,并在模擬訓練和在現實世界中部署之間交替進行,來解決仿真與現實之間的不匹配問題,并學習與人類對手打乒乓球,在每次迭代中,人類行為模型和策略都會得到細化。

雖然模擬可以輔助收集數據,但是在現實世界中收集數據對于微調模擬策略或在新環境中適應現有策略至關重要。

在學習過程中,機器人很容易失敗,并可能會對它自身和周圍環境造成損害,特別是在探索如何與世界互動的早期學習階段,需要安全地收集訓練數據,使得機器人不僅學習技能,還可以從故障中自主恢復。

論文鏈接:https://arxiv.org/abs/2110.05457

研究人員提出了一個安全的 RL 框架,在「學習者策略」和「安全恢復策略」之間進行切換,前者優化為執行所需任務,后者防止機器人處于不安全狀態;訓練了一個復位策略,這樣機器人就能從失敗中恢復過來,比如在跌倒后學會自己站起來。

雖然機器人的數據很少,但是人類執行不同任務的視頻卻很多,當然機器人和人的構造有不同之處,因此讓機器人向人類學習的想法引發了「 跨不同實體遷移學習」的問題。

論文鏈接:https://arxiv.org/pdf/2106.03911.pdf

研究人員開發了交叉具身反向強化學習(Cross-Embodiment Inverse Reinforcement Learning),通過觀察人類來學習新的任務,并非是試圖像人類那樣精確地復制任務,而是學習高層次的任務目標,并以獎勵函數的形式總結這些知識,示范學習可以讓機器人通過觀看互聯網上隨時可用的視頻來學習技能。

另一個方向是提高學習算法的數據效率,這樣就不再僅僅依賴于擴展數據收集:通過合并先驗信息,包括預測信息、對抗性動作先驗和指導策略,提高了 RL 方法的效率。

論文鏈接:https://arxiv.org/abs/2210.10865

利用一種新的結構化動力系統體系結構,將 RL 與軌跡優化相結合,在新型求解器的支持下,得到了進一步的改進,先驗信息有助于緩解勘探的挑戰,更好地規范數據,并大大減少了所需的數據量。

此外,機器人團隊還投入了大量的資金在更有效的數據模擬學習上,實驗證明了一種簡單的模仿學習方法 BC-Z 可以對訓練中沒有看到的新任務進行zero-shot泛化。

論文鏈接:https://arxiv.org/pdf/2210.02343.pdf

并且還引入了一個迭代模仿學習算法 GoalsEye,從游戲中學習和目標條件行為克隆相結合,用于高速高精度的乒乓球游戲。

論文鏈接:https://sites.google.com/view/goals-eye

在理論方面,研究人員研究了表征模擬學習樣本復雜性的動態系統穩定性,以及捕獲演示數據中的失效和恢復以更好地調節小數據集離線學習的作用。

論文鏈接:https://proceedings.mlr.press/v168/tu22a.html

總結

人工智能領域大型模型的進步促進了機器人學習能力的飛躍。

在過去的一年里,可以看到 LLM 中捕捉到的上下文感覺和事件順序幫助解決機器人技術的長期規劃,并使機器人更容易與人互動和完成任務。還可以看到用可擴展的路徑來學習魯棒性和泛化機器人行為,通過應用Transformer模型架構的機器人學習。

谷歌承諾將繼續開放源代碼數據集,在新的一年繼續發展有用的機器人。