ChatGPT之后何去何從?LeCun新作:全面綜述下一代「增強(qiáng)語言模型」

ChatGPT算是點(diǎn)燃了語言模型的一把火,NLP的從業(yè)者都在反思與總結(jié)未來的研究方向。

最近圖靈獎(jiǎng)得主Yann LeCun參與撰寫了一篇關(guān)于「增強(qiáng)語言模型」的綜述,回顧了語言模型與推理技能和使用工具的能力相結(jié)合的工作,并得出結(jié)論,這個(gè)新的研究方向有可能解決傳統(tǒng)語言模型的局限性,如可解釋性、一致性和可擴(kuò)展性問題。

論文鏈接:https://arxiv.org/abs/2302.07842

增強(qiáng)語言模型中,推理意為將復(fù)雜的任務(wù)分解為更簡(jiǎn)單的子任務(wù),工具包括調(diào)用外部模塊(如代碼解釋器、計(jì)算器等),LM可以通過啟發(fā)式方法單獨(dú)使用或組合利用這些增強(qiáng)措施,或者通過演示學(xué)習(xí)實(shí)現(xiàn)。

在遵循標(biāo)準(zhǔn)的missing token預(yù)測(cè)目標(biāo)的同時(shí),增強(qiáng)的LM可以使用各種可能是非參數(shù)化的外部模塊來擴(kuò)展上下文處理能力,不局限于純語言建模范式,可以稱之為增強(qiáng)語言模型(ALMs, Augmented Language Models)。

missing token的預(yù)測(cè)目標(biāo)可以讓ALM學(xué)習(xí)推理、使用工具甚至行動(dòng)(act),同時(shí)仍然能夠執(zhí)行標(biāo)準(zhǔn)的自然語言任務(wù),甚至在幾個(gè)基準(zhǔn)數(shù)據(jù)集上性能超過大多數(shù)常規(guī)LM。

增強(qiáng)語言模型

大型語言模型(LLMs)推動(dòng)了自然語言處理的巨大進(jìn)步,并且已經(jīng)逐步成為數(shù)百萬用戶所用產(chǎn)品的技術(shù)核心,包括寫代碼助手Copilot、谷歌搜索引擎以及最近發(fā)布的ChatGPT。

Memorization 與Compositionality 能力相結(jié)合,使得LLM能夠以前所未有的性能水平執(zhí)行各種任務(wù),如語言理解或有條件和無條件的文本生成,從而為更廣泛的人機(jī)互動(dòng)開辟了一條實(shí)用的道路。

然而,目前LLM的發(fā)展仍然受到諸多限制,阻礙了其向更廣泛應(yīng)用場(chǎng)景的部署。

比如LLMs經(jīng)常提供非事實(shí)但看似合理的預(yù)測(cè),也被稱為幻覺(hallucinations),很多錯(cuò)誤其實(shí)完全是可以避免的,包括算術(shù)問題和在推理鏈中出現(xiàn)的小錯(cuò)誤。

此外,許多LLM的突破性能力似乎是隨著規(guī)模的擴(kuò)大而出現(xiàn)的,以可訓(xùn)練參數(shù)的數(shù)量來衡量的話,之前的研究人員已經(jīng)證明,一旦模型達(dá)到一定的規(guī)模,LLM就能夠通過few-shot prompting來完成一些BIG-bench任務(wù)。

盡管最近也有工作訓(xùn)練出了一些較小的LMs,同時(shí)還能保留一些大模型的能力,但當(dāng)下LLMs的規(guī)模和對(duì)數(shù)據(jù)的需求對(duì)于訓(xùn)練和維護(hù)都是不切實(shí)際的:大型模型的持續(xù)學(xué)習(xí)仍然是一個(gè)開放的研究問題。

Meta的研究人員們認(rèn)為這些問題源于LLMs的一個(gè)基本缺陷:其訓(xùn)練過程就是給定一個(gè)參數(shù)模型和有限的上下文(通常是n個(gè)前后的詞),然后進(jìn)行統(tǒng)計(jì)語言建模。

雖然近年來,由于軟件和硬件的發(fā)展,上下文尺寸n一直在增長(zhǎng),但大多數(shù)模型仍然使用相對(duì)較小的上下文尺寸,所以模型的巨大規(guī)模是儲(chǔ)存沒有出現(xiàn)在上下文知識(shí)的一個(gè)必要條件,對(duì)于執(zhí)行下游任務(wù)來說也很關(guān)鍵。

因此,一個(gè)不斷增長(zhǎng)的研究趨勢(shì)就是用稍微偏離上述的純統(tǒng)計(jì)語言建模范式的方式來解決這些問題。

例如,有一項(xiàng)工作是通過增加從「相關(guān)外部文件中提取的信息」計(jì)算相關(guān)度來規(guī)避LLM的有限語境尺寸的問題。通過為L(zhǎng)Ms配備一個(gè)檢索模塊,從數(shù)據(jù)庫(kù)中檢索出給定語境下的此類文檔,從而實(shí)現(xiàn)與更大規(guī)模LM的某些能力相匹配,同時(shí)擁有更少的參數(shù)。

需要注意的是,現(xiàn)在產(chǎn)生的模型是非參數(shù)化的,因?yàn)樗梢圆樵兺獠繑?shù)據(jù)源。更一般的,LM還可以通過推理策略改善其上下文,以便在生成答案之前生成更相關(guān)的上下文,通過更多的計(jì)算來提升性能。

另一個(gè)策略是允許LM利用外部工具,用LM的權(quán)重中不包含的重要缺失信息來增強(qiáng)當(dāng)前語境。盡管這些工作大多旨在緩解上述LM的缺點(diǎn),但可以直接想到,更系統(tǒng)地用推理和工具來增強(qiáng)LM,可能會(huì)導(dǎo)致明顯更強(qiáng)大的智能體。

研究人員將這些模型統(tǒng)稱為增強(qiáng)語言模型(ALMs)。

隨著這一趨勢(shì)的加速,跟蹤和理解眾多模型變得十分困難,需要對(duì)ALMs的工作進(jìn)行分類,并對(duì)有時(shí)出于不同目的而使用的技術(shù)術(shù)語進(jìn)行定義。

推理Reasoning

在ALM的背景下,推理是將一個(gè)潛在的復(fù)雜任務(wù)分解成更簡(jiǎn)單的子任務(wù),LM可以自己或使用工具更容易地解決。

目前有各種分解子任務(wù)的方法,例如遞歸或迭代,在某種意義上來說,推理類似于LeCun于2022年發(fā)表論文「通往自主機(jī)器智能的路線」中定義的計(jì)劃。

論文鏈接:https://openreview.net/pdf?id=BZ5a1r-kVsf

在這篇survey中,推理指的是提高LM中推理能力的各種策略,比如利用少量的幾個(gè)例子進(jìn)行step-by-step推理。雖然目前還沒有完全理解LM是否真的在推理,或者僅僅是產(chǎn)生了一個(gè)更大的背景,增加了正確預(yù)測(cè)missing tokens的可能性。

鑒于目前的技術(shù)水平,推理可能是一個(gè)被濫用的說法,但這個(gè)術(shù)語已經(jīng)在社區(qū)內(nèi)廣泛使用了。在ALM的語境中,推理的一個(gè)更務(wù)實(shí)的定義是在得出prompt的答案之前給模型更多的計(jì)算步驟。

工具Tool

對(duì)于ALM來說,工具是一個(gè)外部模塊,通常使用一個(gè)規(guī)則或一個(gè)特殊的token來調(diào)用,其輸出包含在ALM的上下文中。

工具可以用來收集外部信息,或者對(duì)虛擬或物理世界產(chǎn)生影響(一般由ALM感知):比如說文件檢索器可以用來作為獲取外部信息的工具,或者用機(jī)器臂對(duì)外部影響進(jìn)行感知。

工具可以在訓(xùn)練時(shí)或推理時(shí)被調(diào)用,更一般地說,模型需要學(xué)習(xí)與工具的互動(dòng),包括學(xué)習(xí)調(diào)用其API

行為Act

對(duì)于ALM來說,調(diào)用一個(gè)對(duì)虛擬或物理世界有影響的工具并觀察其結(jié)果,通常是將其納入ALM的當(dāng)前上下文。

這篇survey中介紹的一些工作討論了在網(wǎng)絡(luò)中搜索(seraching the web),或者通過LMs進(jìn)行機(jī)械臂操縱。在略微濫用術(shù)語的情況下,有時(shí)會(huì)把ALM對(duì)一個(gè)工具的調(diào)用表示為一個(gè)行動(dòng)(action),即使沒有對(duì)外部世界產(chǎn)生影響。

為什么要同時(shí)討論推理和工具?

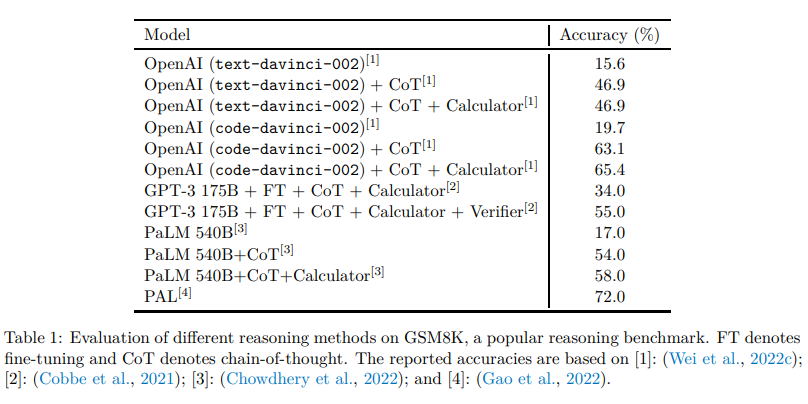

LM中推理和工具的結(jié)合應(yīng)該允許在沒有啟發(fā)式的情況下解決廣泛的復(fù)雜任務(wù),即具有更好的泛化能力。

通常情況下,推理會(huì)促進(jìn)LM將一個(gè)給定的問題分解成可能更簡(jiǎn)單的子任務(wù),而工具則有助于正確地完成每個(gè)步驟,例如從數(shù)學(xué)運(yùn)算中獲得結(jié)果。

換句話說,推理是LM結(jié)合不同工具以解決復(fù)雜任務(wù)的一種方式,而工具則是避免推理失敗和有效分解的一種方式。

兩者都應(yīng)該受益于對(duì)方,并且推理和工具可以放在同一個(gè)模塊里,因?yàn)槎叨际峭ㄟ^增強(qiáng)LM的上下文來更好地預(yù)測(cè)missing tokens,盡管是以不同的方式。

為什么要同時(shí)討論工具和行動(dòng)?

收集額外信息的工具和對(duì)虛擬或物理世界產(chǎn)生影響的工具可以被LM以同樣的方式調(diào)用。例如,輸出python代碼解決數(shù)學(xué)運(yùn)算的LM和輸出python代碼操縱機(jī)械臂的LM之間似乎沒有什么區(qū)別。這篇綜述中討論的一些工作已經(jīng)在使用對(duì)虛擬或物理世界產(chǎn)生影響的LM,在這種觀點(diǎn)下,我們可以說LM有行動(dòng)的潛力,并期望在LM作為自主智能體的方向上取得重要進(jìn)展。分類方法

研究人員將綜述中介紹的工作分解上述三個(gè)維度,并分別介紹,最后還討論了其他維度的相關(guān)工作。對(duì)讀者來說,應(yīng)該記得,其中很多技術(shù)最初是在LM之外的背景下引入的,如果需要的話,盡可能查看提到的論文的介紹和相關(guān)工作。最后,盡管綜述專注于LLM,但并非所有的相關(guān)工作都采用了大模型,而是以LM的正確性為宗旨。