我用ChatGPT寫神經網絡:一字不改,結果竟然很好用

自從去年底推出以來,對話式 AI 模型 ChatGPT 火遍了整個社區。

ChatGPT 的確是一個了不起的工具,就像一個「潘多拉魔盒」。一旦找到正確的打開方式,你或許會發現,自己再也離不開它了。

作為一個全能選手,人們給 ChatGPT 提出的要求五花八門,有人用它寫論文,有人讓它陪聊,這些都是常見的玩法。腦洞再打開一點,既然 ChatGPT 是 AI 中的「王者」,那它會不會寫一個 AI?

近日,一位機器學習領域的博主突發奇想,他決定讓 ChatGPT 構建一個神經網絡,使用 Keras 解決 MNIST 問題。

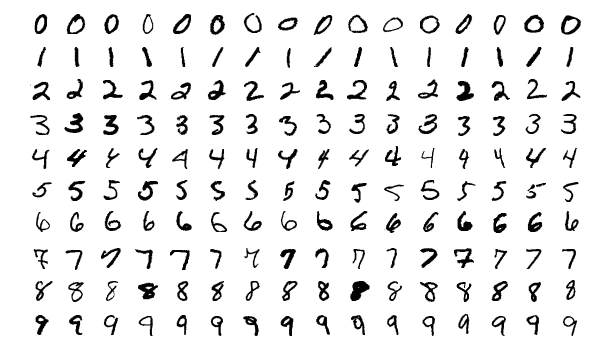

MNIST 算是機器學習領域的經典問題。即使這個手寫數字數據集逐漸淡出了計算機視覺領域,但它的紀念意義仍然不可忽視,很多人入門深度學習的第一個數據集、驗證算法的第一個實驗都是 MNIST。

話不多說,想到了就開工。作者直接讓 ChatGPT 寫了一段代碼,看上去完美無缺,甚至不需要更改任何內容。

這是一個很好的開始。

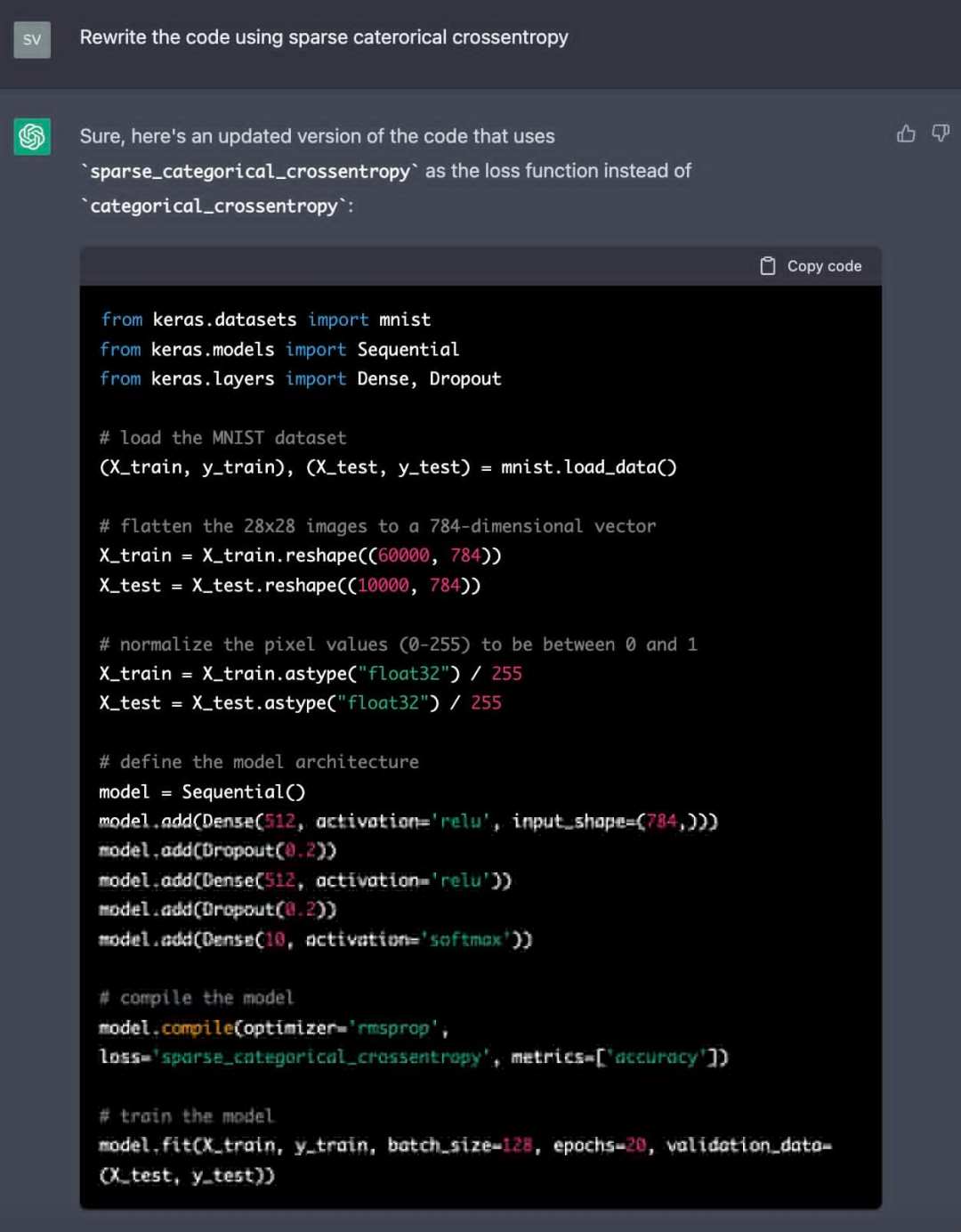

ChatGPT 選擇了分類交叉熵作為損失函數。作者提出重寫分類交叉熵這部分代碼,ChatGPT 將其替換為稀疏分類交叉熵,更新之后的代碼仍能 Work。可以發現,新的損失函數放棄了標簽的分類轉換。

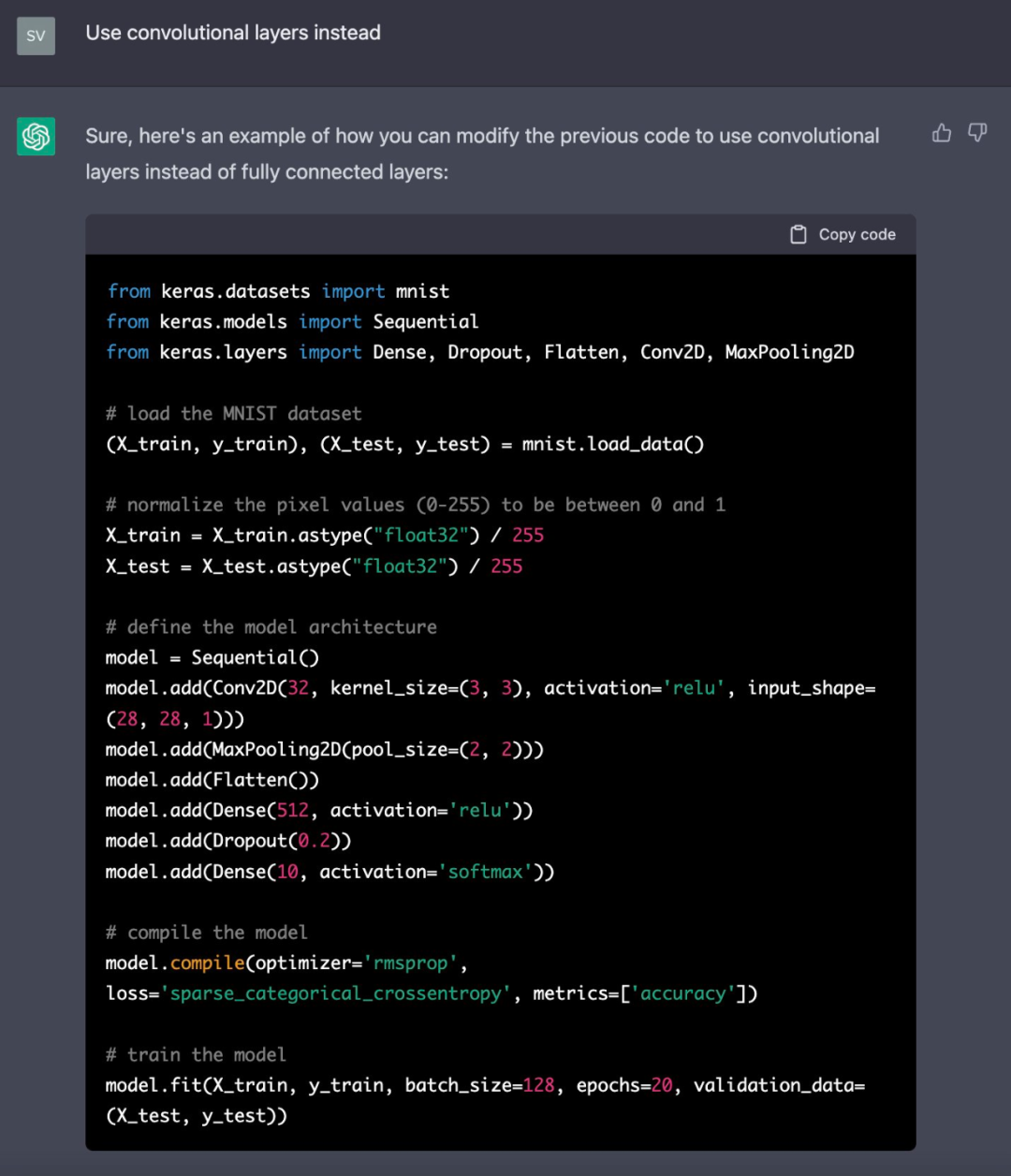

ChatGPT 生成的代碼使用了全連接層,但作者想使用卷積層。因此,ChatGPT 按照指示修改了代碼,并添加了一個 Conv2D 和一個最大池化層(MaxPooling layer)。

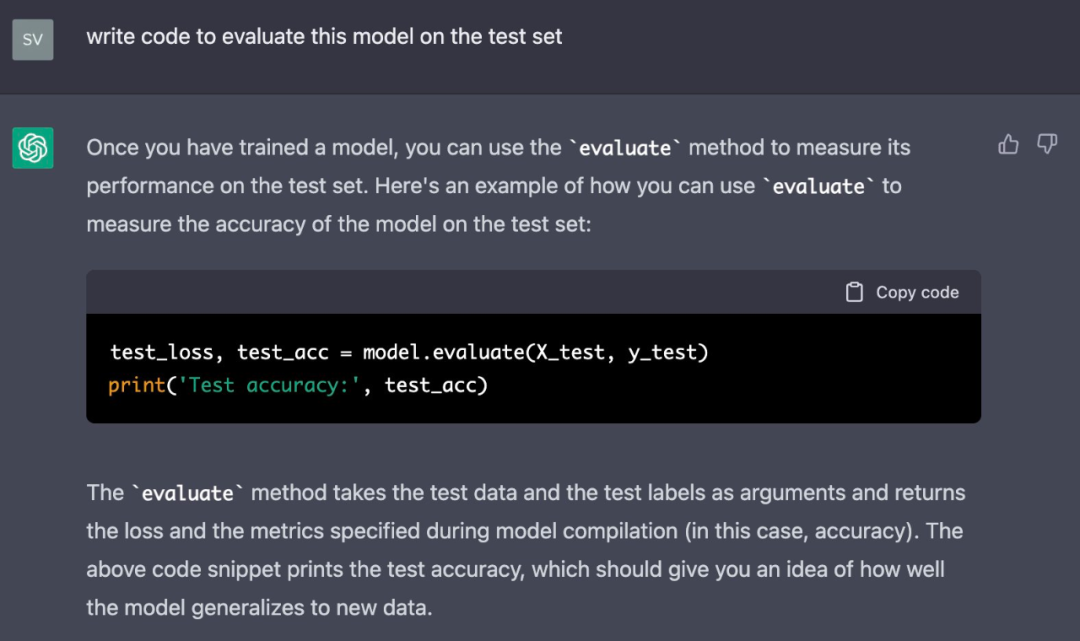

然后來到了評估最終模型階段,作者讓 ChatGPT 使用測試集編寫代碼。

結果看起來很棒,而且 ChatGPT 的每一次回復都帶有完整的解釋。比如在這次評估中,它這樣解釋:

「評估」方法將測試數據和測試標簽作為參數,并返回模型編譯(此處為準確率)期間指定的損失和度量。上面的代碼片段輸出了測試的準確率,這應該可以讓你了解到模型對新數據的概括性。

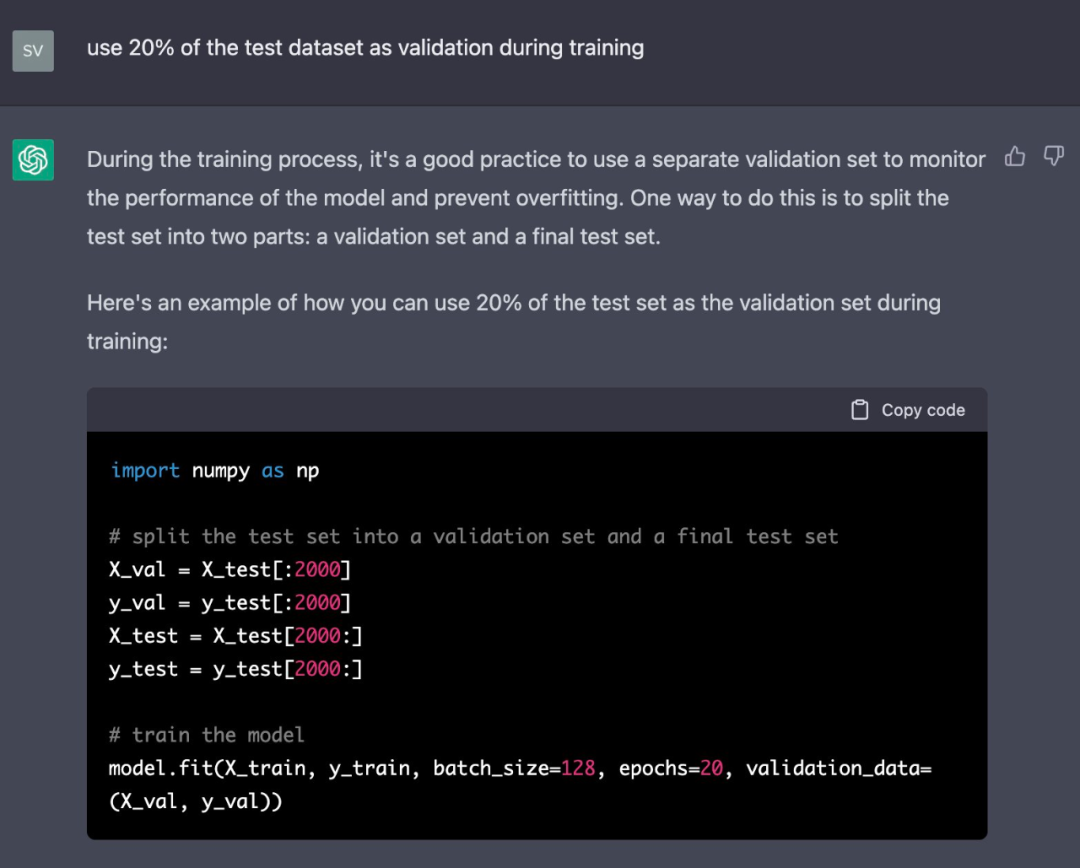

模型在訓練期間使用了整個測試集作為驗證數據。然后,作者讓 ChatGPT 將其更改為訓練數據的 20%。

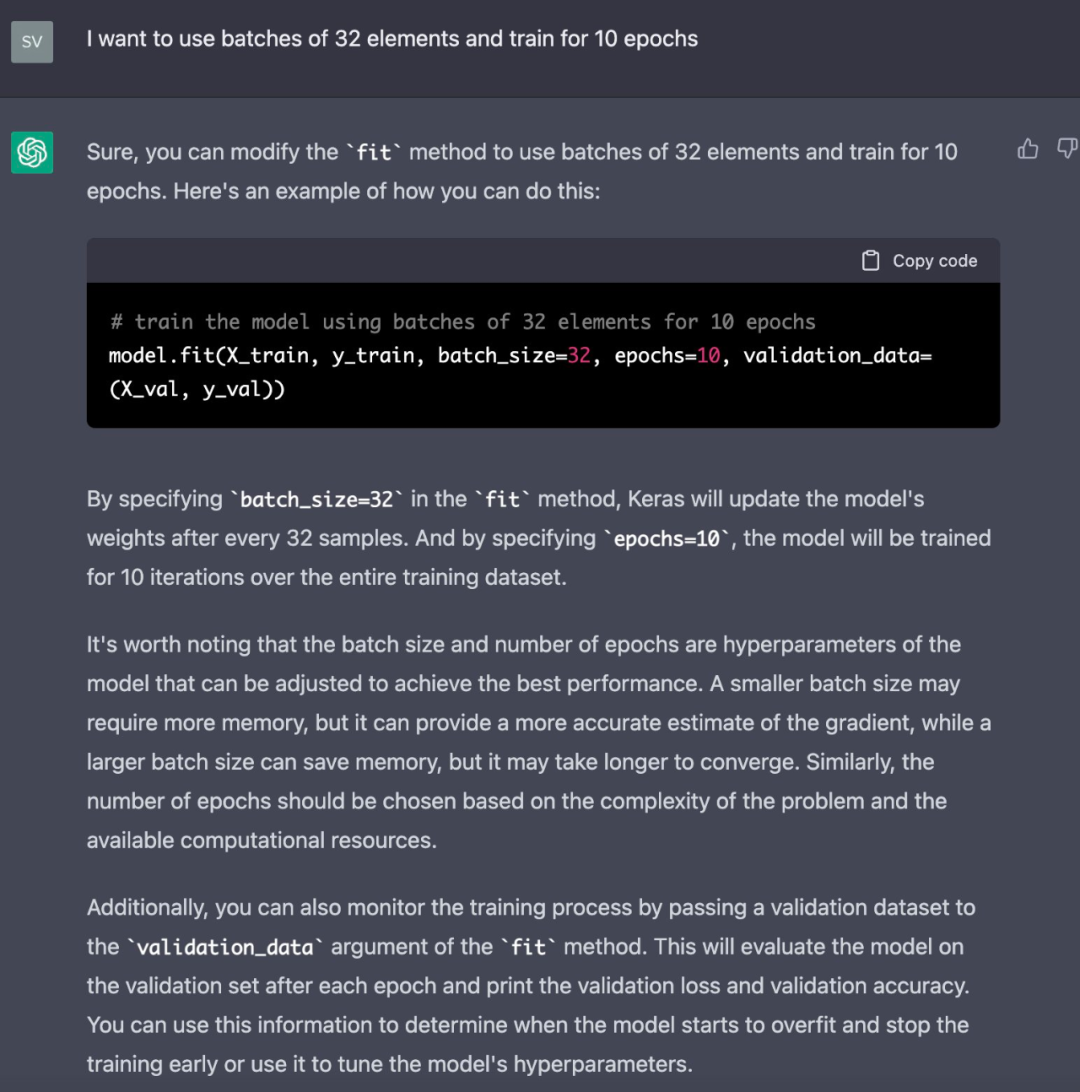

此外,作者還想要更小的 batch 并運行更少 epoch 的代碼。雖然這一步未必要用到 ChatGPT,但他不想在不更新 ChatGPT 上下文的情況下更改代碼。

所以這項任務還是落在了 ChatGPT 頭上:

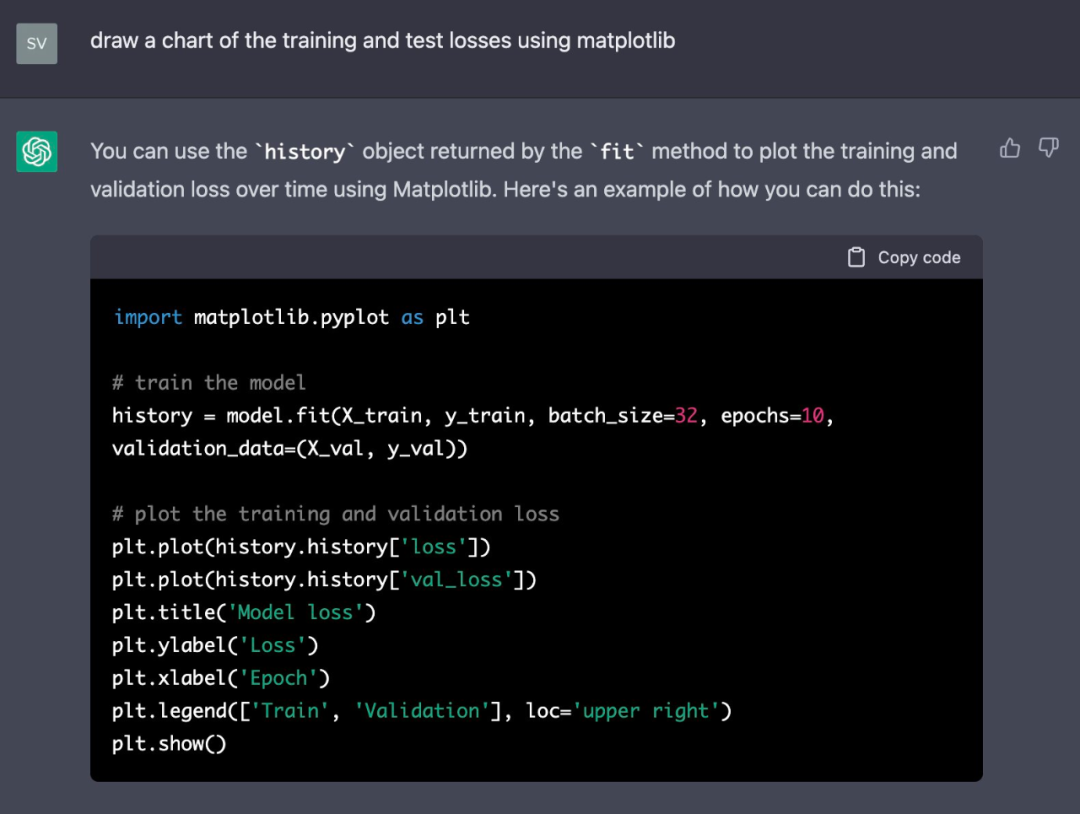

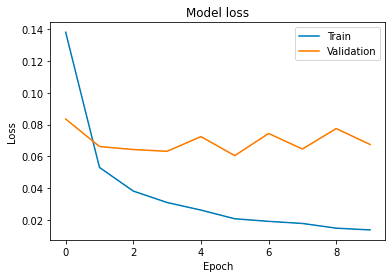

接下來,作者打算繪制訓練過程中的訓練和測試損失圖。ChatGPT 的建議是:需要更改適合模型的 line 以捕獲其結果值。

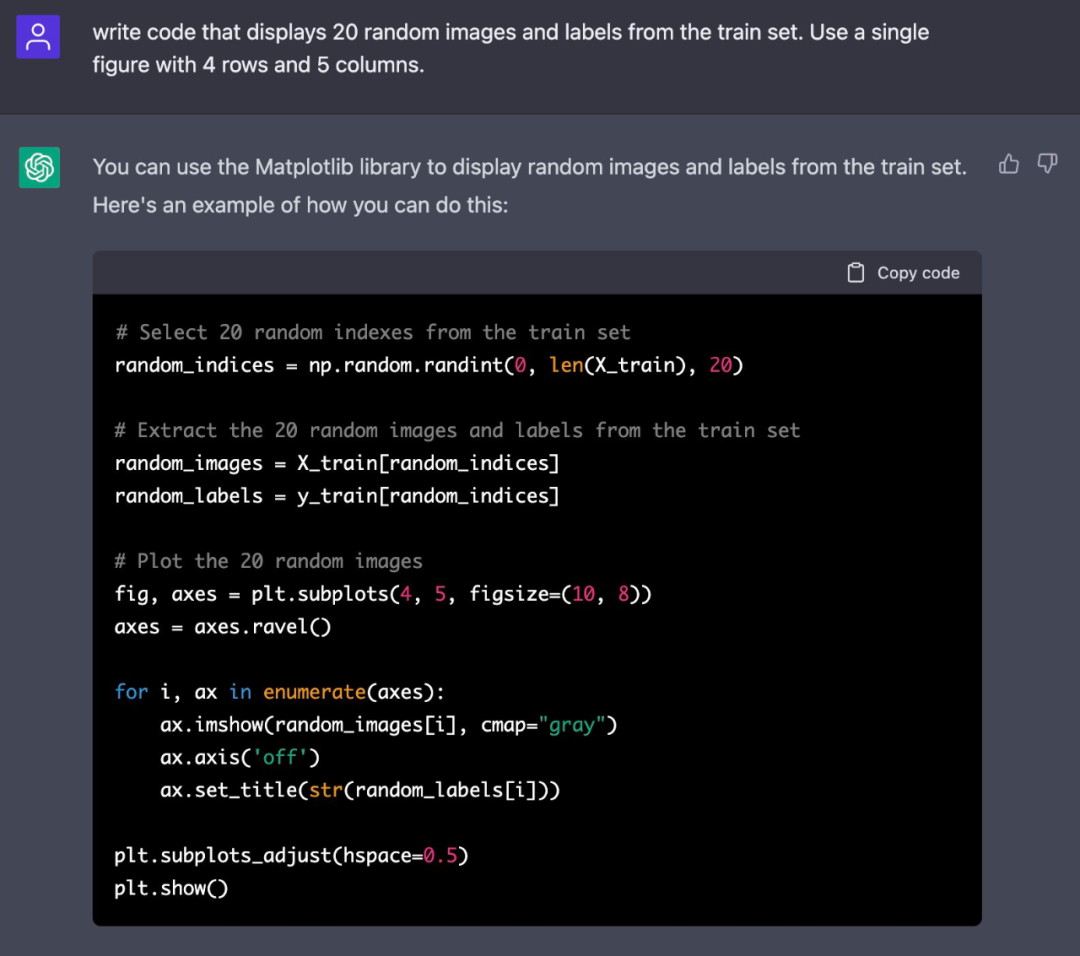

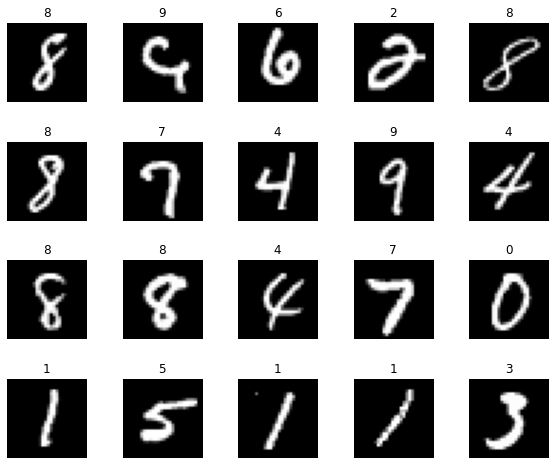

為了展示數據集中的一些示例,作者讓 ChatGPT 編寫代碼來輸出圖像和標簽的組合。這些輸出的代碼也很完美,附有 20 張圖片的合集。

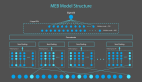

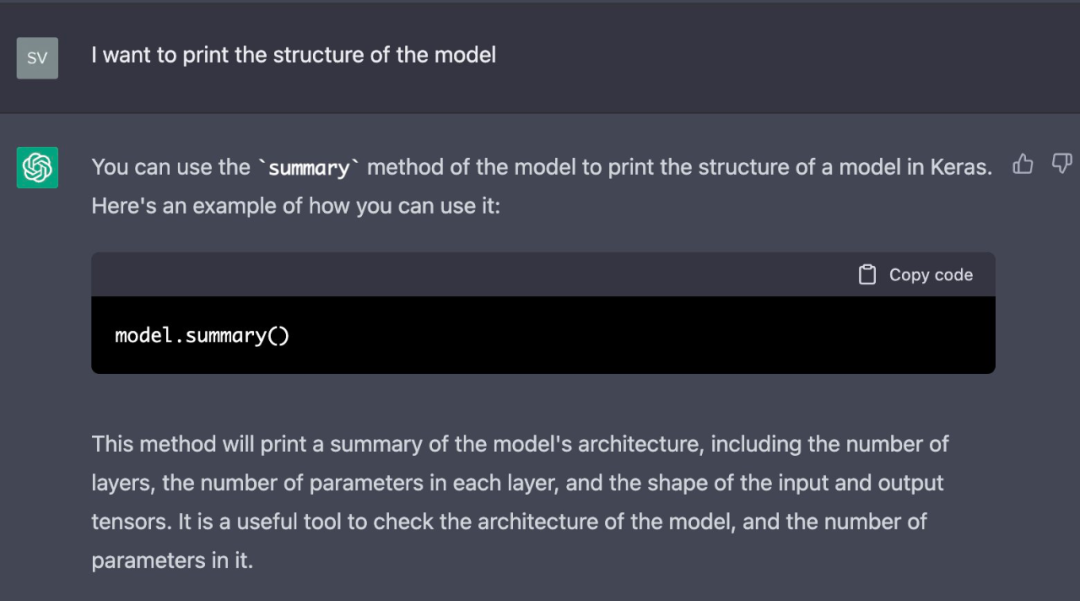

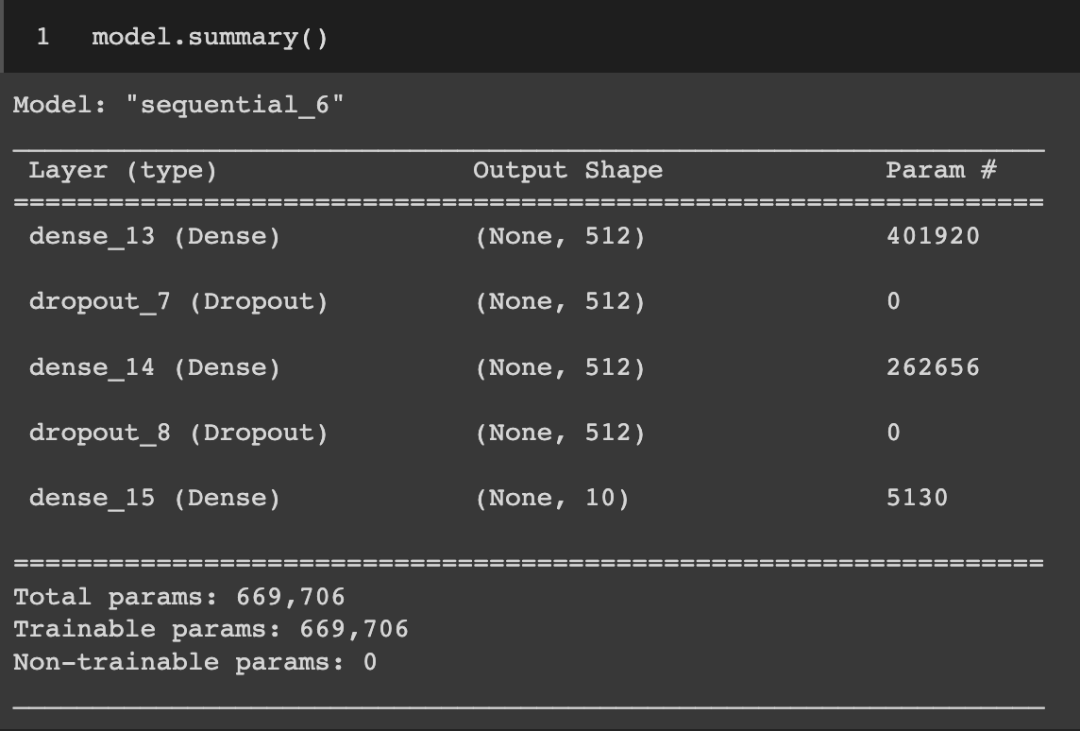

構建模型時,查看其結構也是必要的。如果用這個問題去問 ChatGPT ,回復是:

ChatGPT 給出的是關于模型的總結:

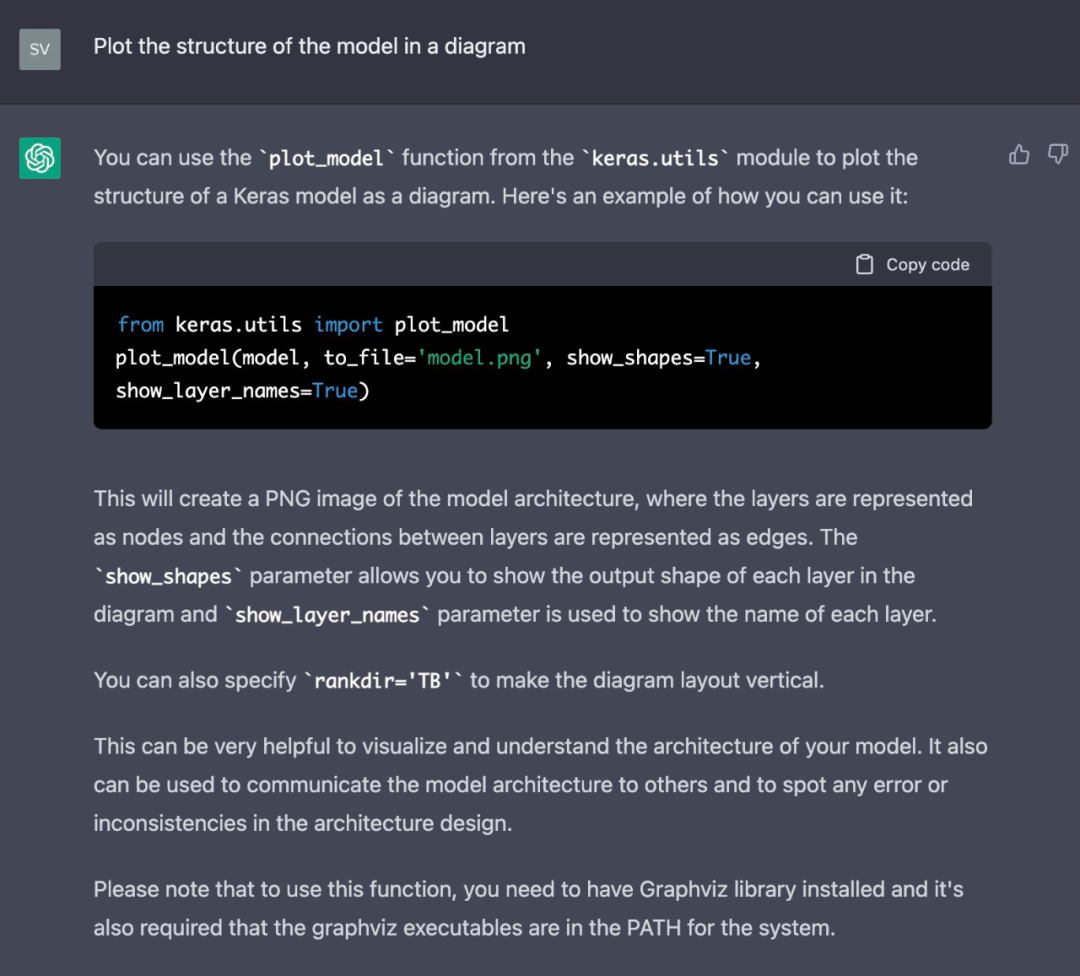

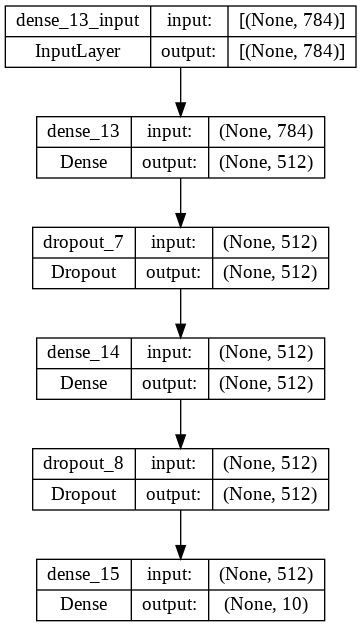

模型的總結很有用,但作者更想看到顯示模型結構的圖。所以繼續問:

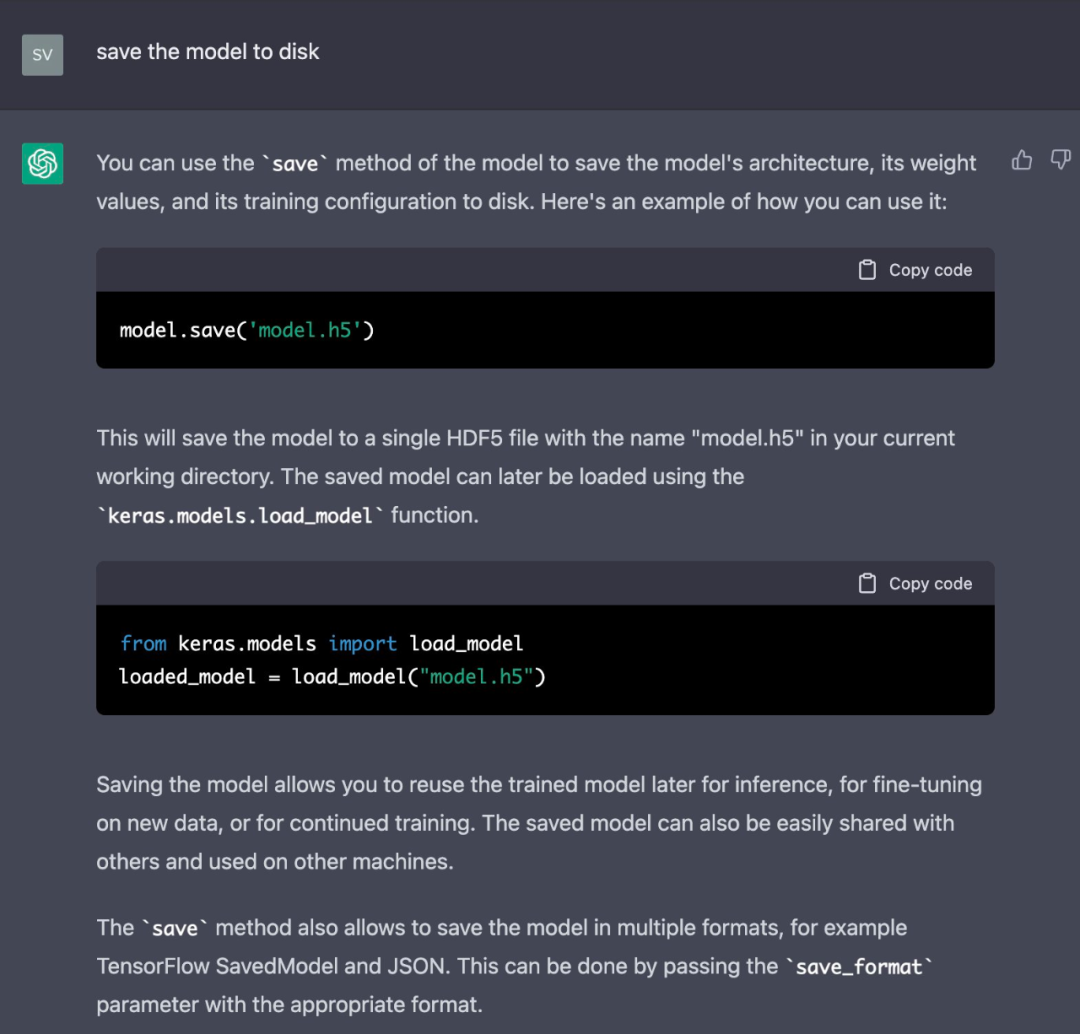

結果是滿意的,最后就是準備部署這個模型了,讓 ChatGPT 將模型保存到磁盤吧:

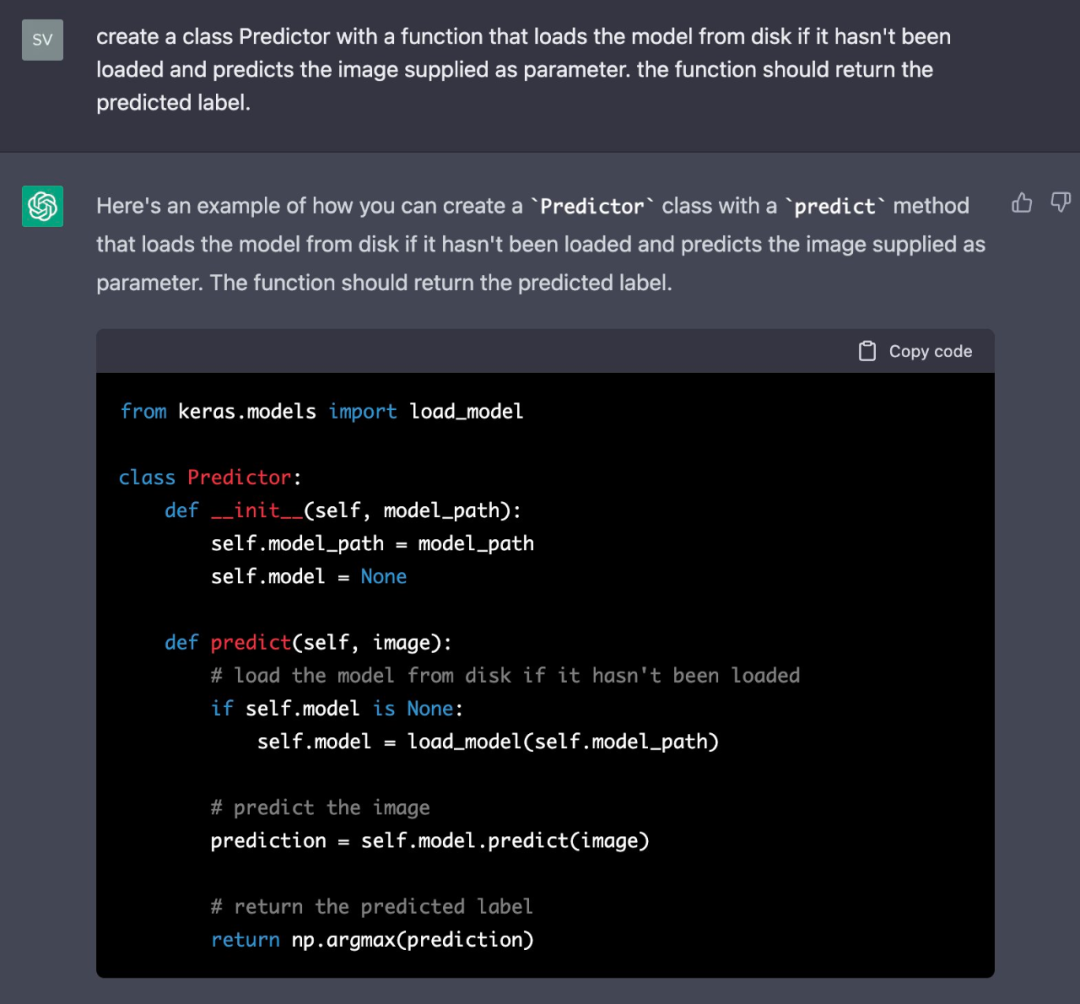

現在,作者想創建一個使用保存的模型進行預測的類。這是 prompt 很有趣,解決方案也很完美。

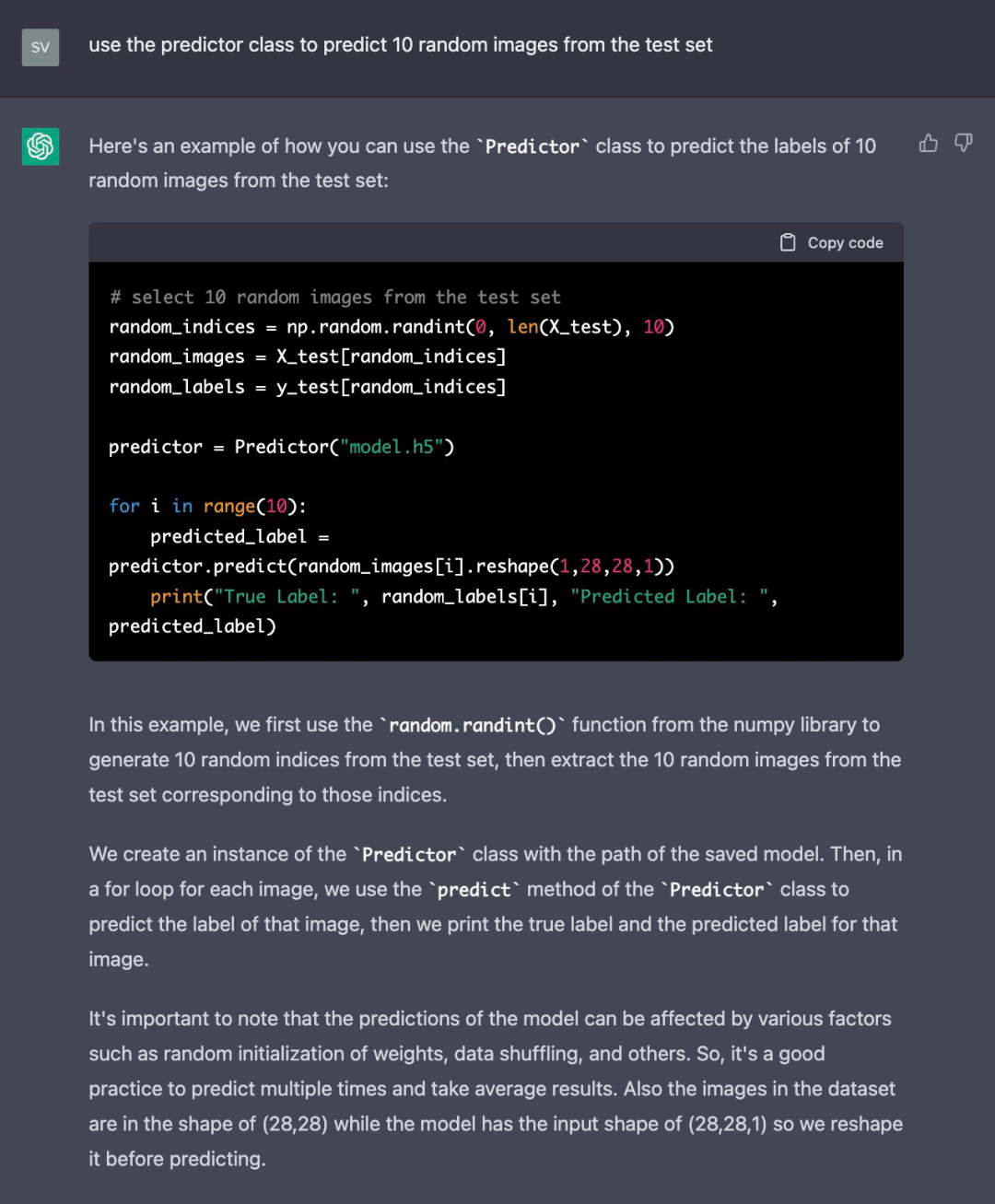

現在編寫一個示例,使用預測器的類來預測 10 個隨機圖像的標簽:

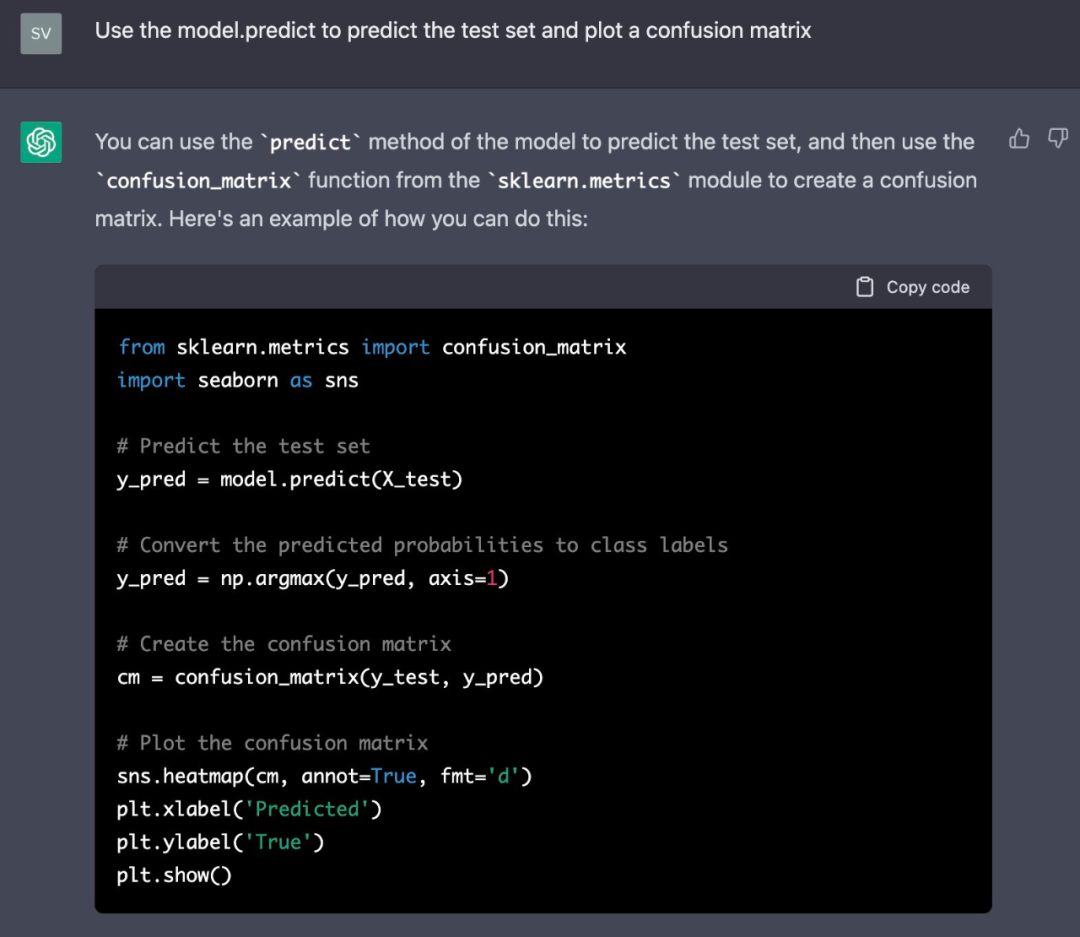

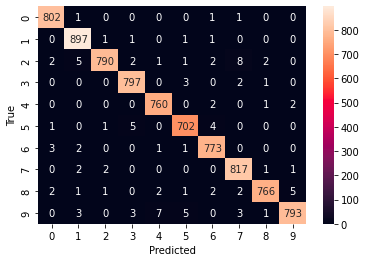

為了完成這個,作者讓 ChatGPT 展示了一個混淆矩陣:

該說不說,ChatGPT 使用的樣式還真挺好看。

完成所有試驗后,作者將所有 ChatGPT 生成的代碼公布了出來,你也可以上手試試:

地址:https://colab.research.google.com/drive/1JX1AVIfGtIlnLGqgHrK6WPylPhZvu9qe?usp=sharing