ChatGPT之后性能怪獸來了?馬庫斯7大「黑暗」預(yù)測:GPT-4帶不來AGI

2022年接近尾聲之際,OpenAI發(fā)布了名為ChatGPT的聊天機(jī)器人,迅速走紅網(wǎng)絡(luò)。

發(fā)布后不到兩周,已有超過一百萬人注冊在線試用。用戶只要輸入文本,就能立即得到一段段的不可思議的文章、故事和詩歌。

它的文筆很好,以至于有些人用它在Tinder上寫約會的開場白(「你介意我坐這里嗎?你做臀沖的樣子讓我的腿有點發(fā)軟。」)

不僅如此,令世界各地的教育工作者相當(dāng)震驚的是,學(xué)生們開始使用ChatGPT來撰寫學(xué)期論文。還有一些人正在使用它來嘗試重塑搜索引擎。一時之間,全世界都在討論ChatGPT的神奇。

盡管如此,馬庫斯表示,我們不能對聊天機(jī)器人濾鏡太厚。

雖然ChatGPT看起來無所不知,但它也很容易出錯。在接受采訪時,馬庫斯表示,ChatGPT和之前一樣,相關(guān)系統(tǒng)「仍然不可靠,仍然不了解現(xiàn)實世界,仍然不了解心理世界并且仍然充滿錯誤。」

也就是說,ChatGPT時常胡編亂造;它所說的相當(dāng)一部分根本不是真的。

例如,在用戶的誘導(dǎo)下,ChatGPT可以說出油條非常適合手術(shù),因為「它們體積小巧,可以在手術(shù)過程中實現(xiàn)更高的精確度和控制,降低并發(fā)癥的風(fēng)險并改善手術(shù)的整體結(jié)果」 。

聊天機(jī)器人一本正經(jīng)地說胡話,以至于著名的網(wǎng)站Stack Overflow已經(jīng)暫時禁止計算機(jī)生成的回答。

而錯誤是無窮無盡的。雖然ChatGPT經(jīng)常根據(jù)用戶反饋進(jìn)行調(diào)整,但在產(chǎn)品發(fā)布幾周后,仍有很多網(wǎng)友對它的回答感到無語:

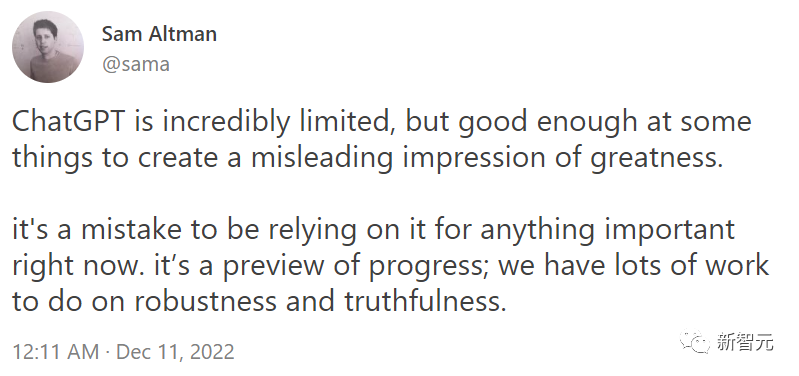

類似的錯誤頻頻發(fā)生,連OpenAI的首席執(zhí)行官Sam Altman也不得不承認(rèn)現(xiàn)實:

ChatGPT仍有諸多局限,但足以創(chuàng)造出偉大的假象。

現(xiàn)在靠ChatGPT去完成重要任務(wù)還為時尚早。關(guān)于提高魯棒性和真實性,我們要做的還有很多。

簡而言之,ChatGPT雖然聽起來像是星際迷航中的計算機(jī)一樣科幻,但目前,人們還不能完全信任它。

當(dāng)然,ChatGPT是2022年AI愛好者的禮物。那么2023年呢?

2023年,硅谷乃至整個世界翹首以盼的,是GPT-4。?

GPT-4:AI界的「天降紫微星」

實際嘗試過GPT-4的人都對該產(chǎn)品印象深刻。根據(jù)一些傳言,GPT-4將于2023年春天發(fā)布。屆時,它將使ChatGPT 黯然失色;可以肯定的是,會有更多人談?wù)撍?/span>

在許多方面,人們對GPT-4的期望值非常高:

風(fēng)投公司DVC創(chuàng)始人Nick Davidov表示:GPT-4的出現(xiàn),會帶來「和新冠疫情類似的經(jīng)濟(jì)沖擊」。GPT-4的快速傳播和使用,可以「迅速提高數(shù)億知識工作者的生產(chǎn)力」。

從技術(shù)上講,GPT-4內(nèi)部將會有更多的參數(shù),更多的處理器和內(nèi)存,并接受更多數(shù)據(jù)的訓(xùn)練。

GPT-1接受了4.6GB數(shù)據(jù)的訓(xùn)練,而到了GPT-3,數(shù)據(jù)量直接飆升至750GB。由此可見,GPT-4的訓(xùn)練量會更加驚人,甚至?xí)φ麄€互聯(lián)網(wǎng)的大部分進(jìn)行學(xué)習(xí)。

OpenAI深知,更大的訓(xùn)練量意味著更好的輸出。經(jīng)過每次迭代,GPT的表現(xiàn)變得越來越像人類。對于GPT-4,可能會進(jìn)化成為一個性能怪物。

但它會解決之前遇到的問題嗎?馬庫斯對此仍然打了個問號。

盡管GPT-4看起來肯定會比它的前任更聰明,但其內(nèi)部架構(gòu)仍然存在問題。

馬庫斯稱,他懷疑人們在GPT-4時,會有一種似曾相識的感覺:先是火遍全網(wǎng),然后過了幾天,人們發(fā)現(xiàn)許多問題仍然存在。

根據(jù)當(dāng)前信息,GPT-4在架構(gòu)上與GPT-3基本相同。如果是這樣,可以預(yù)料到,一些基本問題仍然無法解決:聊天機(jī)器人依然缺乏了解世界運作方式的內(nèi)部模型。

因此,GPT-4無法在抽象層面上理解事物。它可能更擅長幫學(xué)生寫論文,但它仍然不會真正了解世界,答案的字里行間仍會透露機(jī)器的特征。?

關(guān)于GPT-4的七大預(yù)測

因此,盡管AI界對GPT-4的到來滿心歡喜,馬庫斯卻給出了7個不太積極的預(yù)測。

?1. GPT-4仍然會像它的前輩一樣,犯下各種愚蠢的錯誤。它有時可能會很好地完成給定的任務(wù),有時卻罷工不干,但你并不能提前預(yù)料到即將出現(xiàn)的是哪種情況。

2. GPT-4對物理、心理和數(shù)學(xué)方面的推理依然靠不住。它或許能夠解決部分之前未能挑戰(zhàn)成功的項目,但在面對更長和更復(fù)雜的場景時依然束手無策。

比如,當(dāng)被問及醫(yī)學(xué)問題時,它要么拒絕回答,要么偶爾會說出聽起來很有道理但很危險的廢話。盡管它已經(jīng)吞噬了互聯(lián)網(wǎng)上的大量內(nèi)容,但它并不能足夠可信和完整地提供可靠的醫(yī)療建議。

3. 流暢幻象(fluent hallucinations)仍將十分常見,而且很容易被誘發(fā)。也就是說,大型語言模型依然是一個能被輕易用于制作聽起來很有道理但卻完全錯誤的信息的工具。

4. GPT-4的自然語言輸出仍然無法以可靠的方式為下游程序提供服務(wù)。利用它構(gòu)建虛擬助手的開發(fā)者會發(fā)現(xiàn),自己無法可靠地將用戶語言映射到用戶的意圖上。

5. GPT-4本身不會是一個能解決任意任務(wù)的通用人工智能。如果沒有外部的輔助,它既不能在Diplomacy中擊敗Meta的Cicero;也不能可靠地駕駛汽車;更不能驅(qū)動《變形金剛》里的「擎天柱」,或者像《杰森一家》里的「Rosie」那樣多才多藝。

6. 人類「想要什么」與機(jī)器「去做什么」之間的「對接」,依然是一個關(guān)鍵且尚未解決的問題。GPT-4仍將無法控制自己的輸出,一些建議是令人驚訝的糟糕,掩蓋偏見的例子也會在幾天或幾個月內(nèi)被發(fā)現(xiàn)。

7. 當(dāng)AGI(通用人工智能)實現(xiàn)時,像GPT-4這樣的大型語言模型,或許會成為最終解決方案的一部分,但也僅限于其中的一部分。單純的「擴(kuò)展」,也就是建立更大的模型直到它吸收了整個互聯(lián)網(wǎng),在一定程度上會被證明是有用的。但值得信賴的、與人類價值觀相一致的通用人工智能,一定會來自于結(jié)構(gòu)化程度更高的系統(tǒng)。它將具有更多的內(nèi)置知識,并包含明確的推理和計劃工具。而這些,都是現(xiàn)在的GPT系統(tǒng)所缺乏的。

馬庫斯認(rèn)為,在十年內(nèi),也許更少,人工智能的重點將從對大型語言模型的擴(kuò)展,轉(zhuǎn)向與更廣泛的技術(shù)相結(jié)合。

酷炫的東西總是好玩的,但這并不意味著它能帶領(lǐng)我們走向可信的通用人工智能。

對此,馬庫斯預(yù)測,我們在今后需要的是一個可以將顯性知識和世界模型作為核心的全新架構(gòu)。?

參考資料:https://garymarcus.substack.com/p/what-to-expect-when-youre-expecting