Habitat Challenge 2022冠軍技術(shù):字節(jié)AI Lab提出融合傳統(tǒng)和模仿學(xué)習(xí)的主動(dòng)導(dǎo)航

物體目標(biāo)導(dǎo)航 (Object Navigation) 是智能機(jī)器人的基本任務(wù)之一。在此任務(wù)中,智能機(jī)器人在一個(gè)未知的新環(huán)境中主動(dòng)探索并找到人指定的某類物體。物體目標(biāo)導(dǎo)航任務(wù)面向未來家庭服務(wù)機(jī)器人的應(yīng)用需求,當(dāng)人們需要機(jī)器人完成某些任務(wù)時(shí),例如拿一杯水,機(jī)器人需要先尋找并移動(dòng)到水杯的位置,進(jìn)而幫人們?nèi)〉剿?/p>

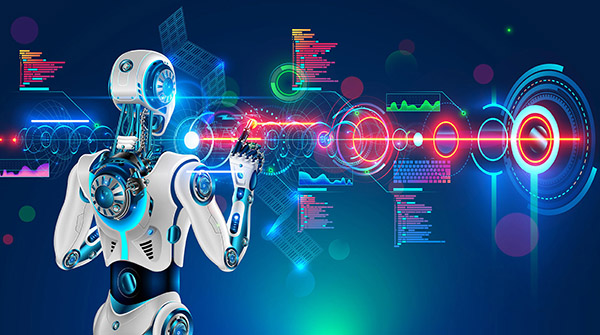

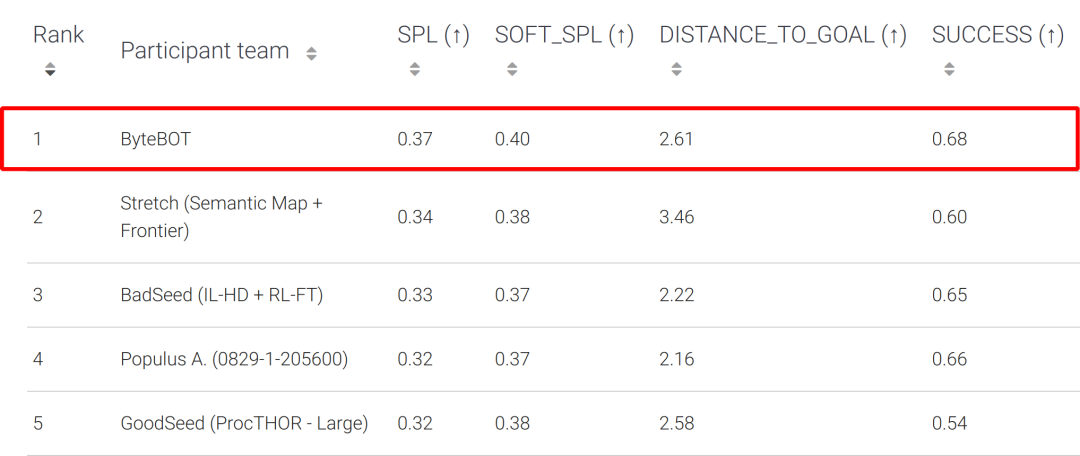

Habitat Challenge 挑戰(zhàn)賽由 Meta AI 等機(jī)構(gòu)聯(lián)合舉辦,是物體目標(biāo)導(dǎo)航領(lǐng)域的知名賽事之一,截至 2022 今年已連續(xù)舉辦 4 屆,本次比賽共有 54 支參賽隊(duì)參加。在比賽中,字節(jié)跳動(dòng) AI Lab-Research 團(tuán)隊(duì)的研究者針對(duì)現(xiàn)有方法的不足,提出了一種全新的物體目標(biāo)導(dǎo)航框架。該框架巧妙地將模仿學(xué)習(xí)與傳統(tǒng)方法結(jié)合,從一眾方法中脫穎而出獲得冠軍。在關(guān)鍵指標(biāo) SPL 中大幅度超過了第二名及其他參賽隊(duì)伍的結(jié)果。歷史上該賽事的冠軍隊(duì)伍一般是 CMU、UC Berkerly、Facebook 等知名研究機(jī)構(gòu)。

Test-Standard 榜單

Test-Challenge 榜單

Habitat Challenge 比賽官網(wǎng):https://aihabitat.org/challenge/2022/

Habitat Challenge 比賽 LeaderBoard:https://eval.ai/web/challenges/challenge-page/1615/leaderboard

1. 研究動(dòng)機(jī)

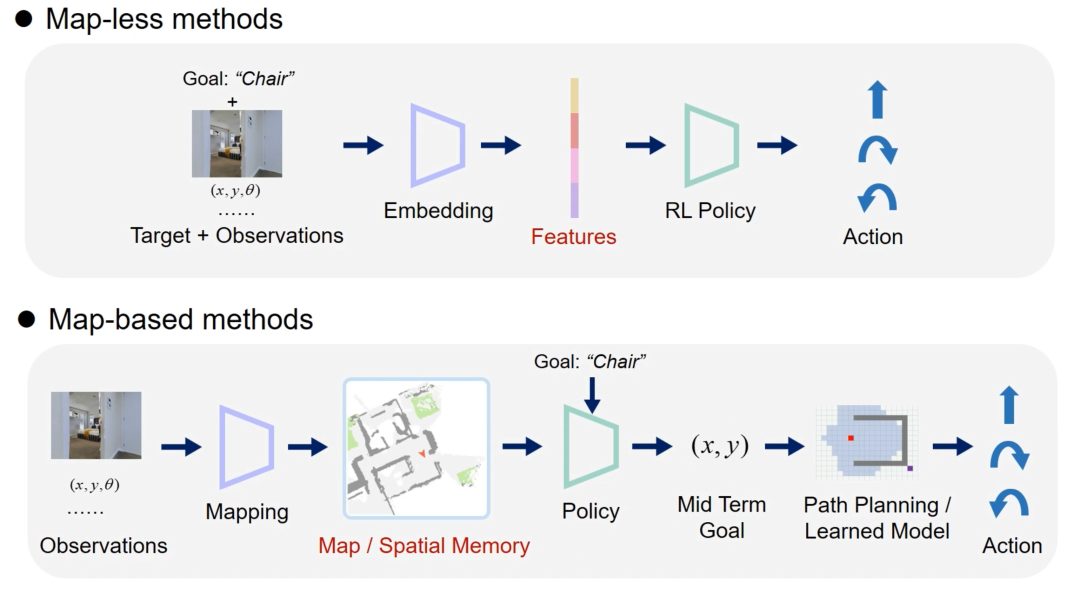

目前的物體目標(biāo)導(dǎo)航方法可以大致分為端到端的方法和基于地圖的方法兩大類。端到端的方法提取輸入的傳感器數(shù)據(jù)的特征,再送入一個(gè)深度學(xué)習(xí)模型中得到 action,此類方法一般基于強(qiáng)化學(xué)習(xí)或模仿學(xué)習(xí)(如圖1Map-less methods);基于地圖的方法一般會(huì)構(gòu)建顯式或隱式地圖,然后通過強(qiáng)化學(xué)習(xí)等方法在地圖上選取一個(gè)目標(biāo)點(diǎn),最后規(guī)劃路徑并得到 action(如圖1Map-based method)。

圖1 端到端的方法(上)和基于地圖的方法(下)流程示意圖

在經(jīng)過大量實(shí)驗(yàn)對(duì)比兩類方法后,研究者們發(fā)現(xiàn)這兩類方法各有優(yōu)劣:端到端的方法不需要構(gòu)建環(huán)境的地圖,因此更加簡潔,且不同場景的泛化能力更強(qiáng)。但由于網(wǎng)絡(luò)需要學(xué)習(xí)編碼環(huán)境的空間信息,依賴大量的訓(xùn)練數(shù)據(jù),且難以同時(shí)學(xué)習(xí)一些簡單的行為,比如在目標(biāo)物體附近停下。而基于地圖的方法使用柵格來存儲(chǔ)特征或語義,具有顯式空間信息,因此這類行為的學(xué)習(xí)門檻較低。但它非常依賴準(zhǔn)確的定位結(jié)果,而且在一些如樓梯等環(huán)境中,需要人工設(shè)計(jì)感知和路徑規(guī)劃策略。

基于上述結(jié)論,字節(jié)跳動(dòng) AI Lab-Research 團(tuán)隊(duì)的研究者們希望將兩類方法的優(yōu)勢結(jié)合起來。然而這兩類方法的算法流程差異很大,難以直接組合;此外也很難設(shè)計(jì)出一種策略直接融合兩種方法的輸出。因此研究者設(shè)計(jì)了一種簡單但有效的策略,使兩類方法根據(jù)機(jī)器人的狀態(tài)交替進(jìn)行主動(dòng)探索和物體搜索,從而將各自的優(yōu)勢最大程度地發(fā)揮出來。

2. 競賽方法

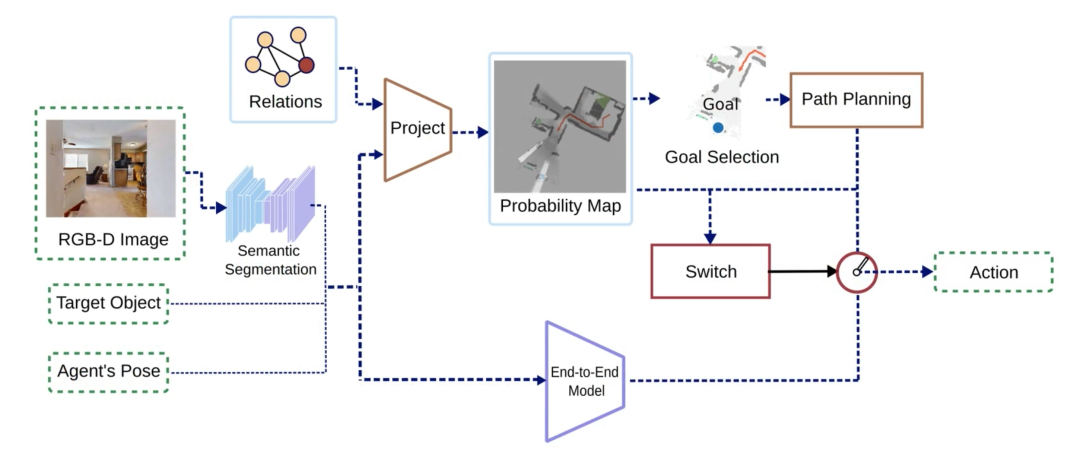

算法主要有兩個(gè)分支組成:基于概率地圖的分支和端到端的分支。算法的輸入是第一視角的 RGB-D 圖像和機(jī)器人位姿,以及需要尋找的目標(biāo)物體類別,輸出是下一步動(dòng)作 (action)。首先對(duì) RGB 圖像進(jìn)行實(shí)例分割,并將其與其他原始輸入數(shù)據(jù)一起傳給兩個(gè)分支。兩個(gè)分支分別輸出各自的 action,并由一個(gè)切換策略決定最終輸出的 action。

圖2 算法流程示意圖

基于概率地圖的分支

基于概率地圖的分支借鑒了 Semantic linking map[2] 的思想,對(duì)作者原來發(fā)表在 IROS 機(jī)器人頂會(huì)的論文[3]的方法進(jìn)行了簡化。該分支根據(jù)輸入的實(shí)例分割結(jié)果、深度圖和機(jī)器人位姿,一方面構(gòu)建 2D 語義地圖;另一方面基于預(yù)先學(xué)習(xí)的物體間關(guān)聯(lián)概率,對(duì)一張概率地圖進(jìn)行更新。

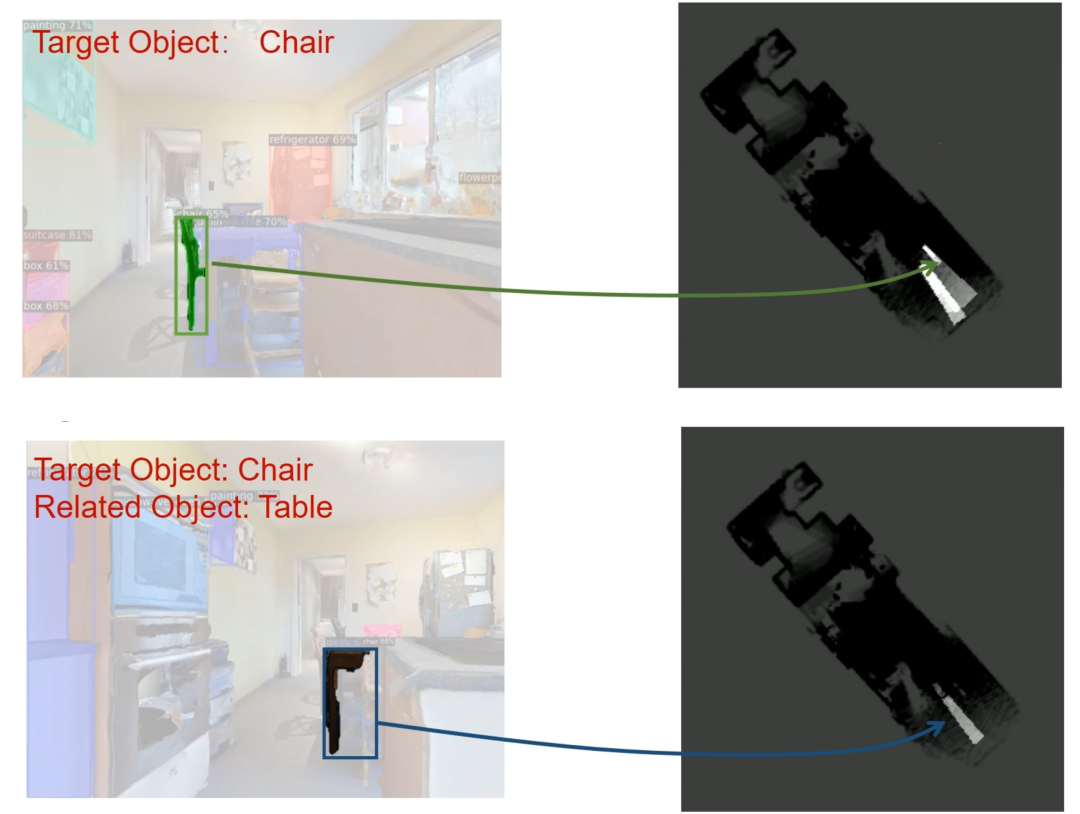

概率地圖的更新方式包括以下幾種:當(dāng)檢測到目標(biāo)物體但沒有足夠把握時(shí)(置信概率 confidence score 低于閾值),此時(shí)應(yīng)該繼續(xù)靠近觀察,因此概率地圖上相應(yīng)區(qū)域的概率值應(yīng)該提高(如圖 3 上方所示);同理,如果檢測到和目標(biāo)物體有關(guān)聯(lián)的物體(例如桌子和椅子放在一起的概率比較高),則相應(yīng)區(qū)域的概率值也會(huì)提高(如圖 3 下方所示)。算法通過選擇概率最高的區(qū)域作為目標(biāo)點(diǎn),鼓勵(lì)機(jī)器人靠近潛在目標(biāo)物體以及關(guān)聯(lián)物體進(jìn)一步觀察,直到找到置信概率高于閾值的目標(biāo)物體。

圖3 概率地圖更新方式示意圖

端到端的分支

端到端分支的輸入包括 RGB-D 圖像、實(shí)例分割結(jié)果、機(jī)器人位姿,以及目標(biāo)物體類別,并直接輸出 action。端到端分支的主要作用是引導(dǎo)機(jī)器人像人類一樣尋找物體,因此采用了 Habitat-Web[4] 方法的模型和訓(xùn)練流程。該方法基于模仿學(xué)習(xí),通過在訓(xùn)練集中收集人類尋找物體的示例樣本訓(xùn)練網(wǎng)絡(luò)。

切換策略

切換策略主要根據(jù)概率地圖和路徑規(guī)劃的結(jié)果,在概率地圖分支和端到端分支輸出的兩個(gè) action 中選擇一個(gè)作為最終輸出。當(dāng)概率地圖中沒有概率大于閾值的柵格,機(jī)器人需要對(duì)環(huán)境進(jìn)行探索;當(dāng)?shù)貓D上無法規(guī)劃出可行路徑時(shí),此時(shí)機(jī)器人可能處于一些特殊環(huán)境(如樓梯),這兩種情況下會(huì)采用端到端分支,使機(jī)器人具備足夠的環(huán)境適應(yīng)能力。其他情況則選擇概率地圖分支,充分發(fā)揮其在尋找目標(biāo)物體方面的優(yōu)勢。

該切換策略的效果如視頻所示,機(jī)器人一般情況下利用端到端分支高效地探索環(huán)境,一旦發(fā)現(xiàn)了可能的目標(biāo)物體或關(guān)聯(lián)物體,則切換到概率地圖分支靠近觀察,如果目標(biāo)物體的置信概率大于閾值,則在目標(biāo)物體處停下;否則該區(qū)域的概率值會(huì)不斷降低,直到?jīng)]有概率大于閾值的柵格,機(jī)器人重新切換回端到端繼續(xù)探索。

從視頻中可以看出,這種方法兼具了端到端方法和基于地圖的方法的優(yōu)勢。兩個(gè)分支各司其職,端到端方法主要負(fù)責(zé)探索環(huán)境;概率地圖分支負(fù)責(zé)靠近感興趣區(qū)域進(jìn)行觀察。因此該方法不僅能夠在復(fù)雜場景探索(如樓梯),還降低了端到端分支的訓(xùn)練要求。

3. 總結(jié)

針對(duì)物體主動(dòng)目標(biāo)導(dǎo)航任務(wù),字節(jié)跳動(dòng) AI Lab-Research 團(tuán)隊(duì)提出了一種結(jié)合經(jīng)典概率地圖與現(xiàn)代模仿學(xué)習(xí)的框架。該框架是對(duì)傳統(tǒng)方法與端到端方法相結(jié)合的一次成功的嘗試。在 Habitat 競賽中,字節(jié)跳動(dòng) AI Lab-Research 團(tuán)隊(duì)提出的方法大幅度超出了第二名及其他參賽隊(duì)伍的結(jié)果,證明了算法的先進(jìn)性。通過將傳統(tǒng)方法引入目前主流的 Embodied AI 端到端方法,來進(jìn)一步彌補(bǔ)端到端方法的一些不足,從而使得智能機(jī)器人在幫助人、服務(wù)人的道路上更進(jìn)一步。

近期,字節(jié)跳動(dòng) AI Lab-Research 團(tuán)隊(duì)在機(jī)器人領(lǐng)域的研究還被 CoRL、IROS、ICRA 等機(jī)器人頂會(huì)收錄,其中包括物體位姿估計(jì)、物體抓取、目標(biāo)導(dǎo)航、自動(dòng)裝配、人機(jī)交互等機(jī)器人核心任務(wù)。

【CoRL 2022】Generative Category-Level Shape and Pose Estimation with Semantic Primitives

- 論文地址:https://arxiv.org/abs/2210.01112

【IROS 2022】3D Part Assembly Generation with Instance Encoded Transformer

- 論文地址:https://arxiv.org/abs/2207.01779

【IROS 2022】Navigating to Objects in Unseen Environments by Distance Prediction

- 論文地址:https://arxiv.org/abs/2202.03735

【EMNLP 2022】Towards Unifying Reference Expression Generation and Comprehension

- 論文地址:https://arxiv.org/pdf/2210.13076

【ICRA 2022】Learning Design and Construction with Varying-Sized Materials via Prioritized Memory Resets

- 論文地址:https://arxiv.org/abs/2204.05509

【IROS 2021】Simultaneous Semantic and Collision Learning for 6-DoF Grasp Pose Estimation

- 論文地址:https://arxiv.org/abs/2108.02425

【IROS 2021】Learning to Design and Construct Bridge without Blueprint

- 論文地址:https://arxiv.org/abs/2108.02439

4. 參考文獻(xiàn)

[1] Yadav, Karmesh, et al. "Habitat-Matterport 3D Semantics Dataset." arXiv preprint arXiv:2210.05633 (2022).

[2] Zeng, Zhen, Adrian R?fer, and Odest Chadwicke Jenkins. "Semantic linking maps for active visual object search." 2020 IEEE International Conference on Robotics and Automation (ICRA). IEEE, 2020.

[3] Minzhao Zhu, Binglei Zhao, and Tao Kong. "Navigating to Objects in Unseen Environments by Distance Prediction." arXiv preprint arXiv:2202.03735 (2022).

[4] Ramrakhya, Ram, et al. "Habitat-Web: Learning Embodied Object-Search Strategies from Human Demonstrations at Scale." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022.

5. 關(guān)于我們

字節(jié)跳動(dòng) AI Lab NLP&Research 專注于人工智能領(lǐng)域的前沿技術(shù)研究,涵蓋了自然語言處理、機(jī)器人等多個(gè)技術(shù)研究領(lǐng)域,同時(shí)致力于將研究成果落地,為公司現(xiàn)有的產(chǎn)品和業(yè)務(wù)提供核心技術(shù)支持和服務(wù)。團(tuán)隊(duì)技術(shù)能力正通過火山引擎對(duì)外開放,賦能 AI 創(chuàng)新。

字節(jié)跳動(dòng) AI-Lab NLP&Research 聯(lián)系方式

- 招聘咨詢:fankaijing@bytedance.com

- 學(xué)術(shù)合作:luomanping@bytedance.com