最早2026?全球優質語言數據「存量」告急!網友:杞人憂天

作為人工智能的三要素之一,數據的作用舉足輕重。

但大家有沒有想過:假如有一天,全世界的數據都用完了那咋整?

實際上,提出這個問題的人絕對沒有精神問題,因為這一天——可能真的快來了!!!

近日,研究員Pablo Villalobos等人一篇名為《我們會用完數據嗎?機器學習中數據集縮放的局限性分析》的論文,發表在了arXiv上。

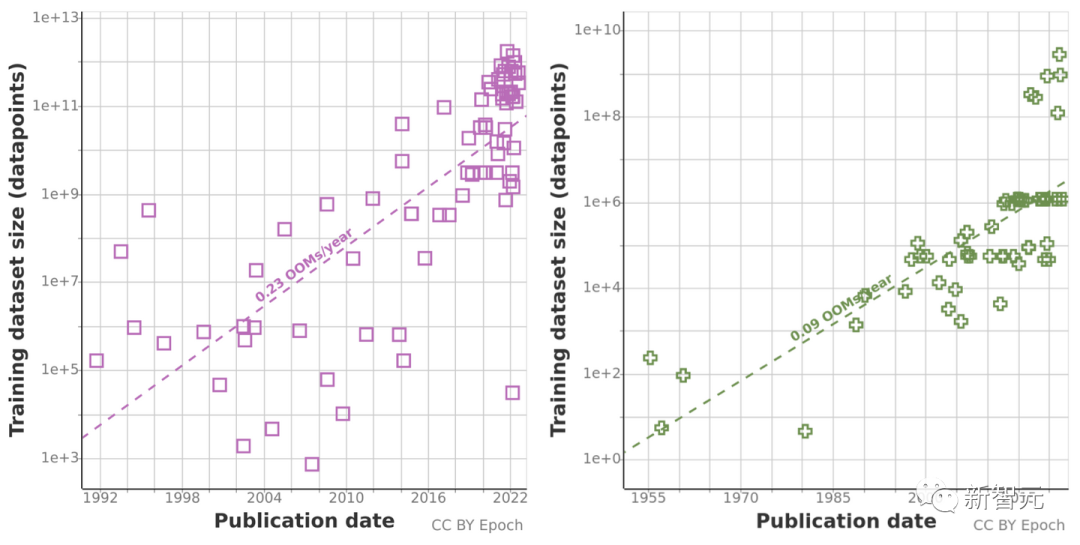

他們根據之前對數據集大小趨勢的分析,預測了語言和視覺領域數據集大小的增長,估計了未來幾十年可用未標記數據總存量的發展趨勢。

他們的研究表明:最早在2026年,高質量語言數據就將全部消耗殆盡!機器學習發展的速度也將因此而放緩。實在不容樂觀。

兩方法雙管齊下,結果不容樂觀

這篇論文的研究團隊由11名研究員和3位顧問組成,成員遍布世界各地,致力于縮小AI技術發展與AI戰略之間的差距,并為AI安全方面的關鍵決策者提供建議。

Chinchilla是DeepMind的研究人員提出的一種新型預測計算優化模型。

實際上,此前在對Chinchilla進行實驗時,就曾有研究員提出「訓練數據很快就會成為擴展大型語言模型的瓶頸」。

因此他們分析了用于自然語言處理和計算機視覺的機器學習數據集大小的增長,并使用了兩種方法進行推斷:使用歷史增長率,并為未來預測的計算預算估計計算最佳數據集大小。

在此之前,他們一直在收集有關機器學習輸入趨勢的數據,包括一些訓練數據等,還通過估計未來幾十年互聯網上可用未標記數據的總存量,來調查數據使用增長。

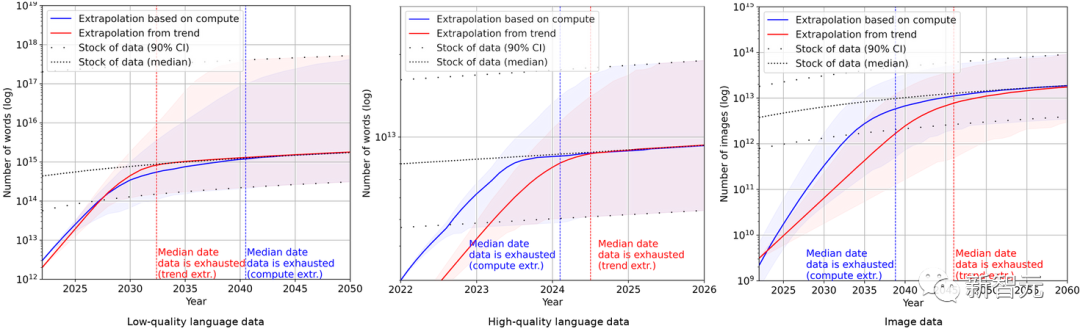

由于歷史預測趨勢可能會受過去十年計算量異常增長的「誤導」,研究團隊還使用了Chinchilla縮放定律,來估計未來幾年的數據集大小,提升計算結果的準確性。

最終,研究人員使用一系列概率模型估計未來幾年英語語言和圖像數據的總存量,并比較了訓練數據集大小和總數據庫存的預測,結果如下圖所示。

這說明數據集的增長速度將遠快于數據存量。

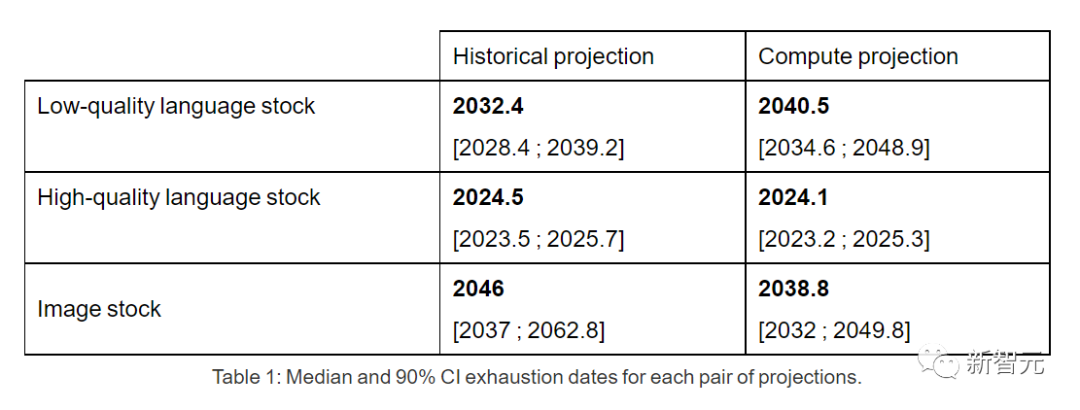

因此,如果當前趨勢繼續保持下去,數據存量被用光將是不可避免的。下表則顯示了預測曲線上每個交叉點的中值耗盡年數。

高質量的語言數據庫存最早可能在2026年之前用盡。

相比之下,低質量的語言數據和圖像數據情況略好:前者將在2030年至2050年間用光,后者將在2030年至2060年之間。

在論文的最后,研究團隊給出結論:如果數據效率沒有大幅提高或新的數據來源可用,當前依賴巨大數據集不斷膨脹的機器學習模型,它的增長趨勢很可能會放緩。

網友:杞人憂天,Efficient Zero了解一下

不過在這篇文章的評論區里,大多數網友卻認為作者杞人憂天。

Reddit上,一位名為ktpr的網友表示:

「自我監督學習有啥毛病么?如果任務指定得好,它甚至可以組合擴展數據集大小。」

名為lostmsn的網友則更加不客氣。他直言:

「Efficient Zero都不了解一下?我認為作者已經嚴重脫離時代了。」

Efficient Zero是一種能高效采樣的強化學習算法,由清華大學的高陽博士提出。

在數據量有限的情況下,Efficient Zero一定程度上解決了強化學習的性能問題,并在算法通用測試基準Atari Game上獲得了驗證。

在這篇論文作者團隊的博客上,就連他們自己也坦言:

「我們所有的結論都基于不切實際的假設,即當前機器學習數據使用和生產的趨勢將繼續保持下去,并且數據效率不會有重大提升。」

「一個更加靠譜的模型應該考慮到機器學習數據效率的提高、合成數據的使用以及其他算法和經濟因素。」

「因此就實際情況來說,這種分析有嚴重的局限性。模型的不確定性非常高。」

「不過總體而言,我們仍認為由于缺乏訓練數據,到2040年時機器學習模型的擴展有大約有20%的可能性會顯著放緩。」