顛覆三觀!谷歌最新研究:用性能差的模型計(jì)算「相似度」反而更準(zhǔn)?

計(jì)算圖像之間的相似度是計(jì)算機(jī)視覺中的一個開放性問題。

在圖像生成火遍全球的今天,如何定義「相似度」,也是評估生成圖像真實(shí)度的關(guān)鍵問題。

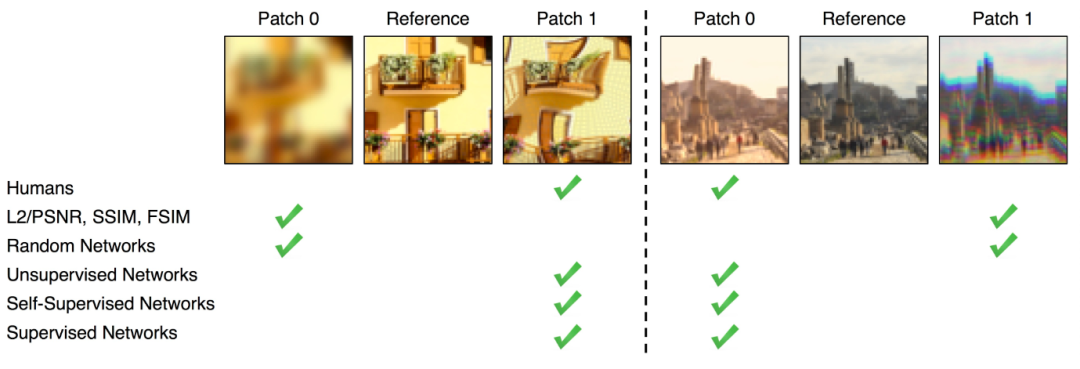

雖然當(dāng)下有一些相對直接的方法來計(jì)算圖像相似度,比如測量像素上的差異(如FSIM, SSIM),但這種方法獲得的相似性差異和人眼感知到的差異相去深遠(yuǎn)。

深度學(xué)習(xí)興起后,一些研究人員發(fā)現(xiàn)一些神經(jīng)網(wǎng)絡(luò)分類器,如AlexNet, VGG, SqueezeNet等在ImageNet上訓(xùn)練后得到的中間表征可以用作感知相似性的計(jì)算。

也就是說,embedding比像素更貼近人對于多張圖像相似的感知。

當(dāng)然,這只是一個假設(shè)。

最近Google發(fā)表了一篇論文,專門研究了ImageNet分類器是否能夠更好地評估感知相似度。

論文鏈接:?https://openreview.net/pdf?id=qrGKGZZvH0?

雖然已經(jīng)有工作在2018年發(fā)布的BAPPS數(shù)據(jù)集基礎(chǔ)上,在第一代ImageNet分類器上研究了感知評分(perceptual scores),為了進(jìn)一步評估準(zhǔn)確率和感知評分的相關(guān)性,以及各種超參數(shù)的影響,論文中增加了對最新ViT模型的研究結(jié)果。

準(zhǔn)確率越高,感知相似度越差?

眾所周知,通過在ImageNet上的訓(xùn)練學(xué)到的特性可以很好地遷移到許多下游任務(wù),提升下游任務(wù)的性能,這也使得在ImageNet預(yù)訓(xùn)練成了一個標(biāo)準(zhǔn)操作。

此外,在ImageNet上取得更高的準(zhǔn)確率通常意味著在一組多樣化的下游任務(wù)上有更好的性能,例如對破損圖片的魯棒性、對out-of-distribution數(shù)據(jù)的泛化性能和對較小分類數(shù)據(jù)集的遷移學(xué)習(xí)。

但在感知相似度計(jì)算上,一切好像反過來了。

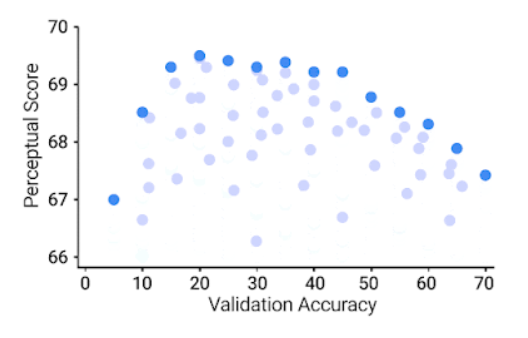

在ImageNet上獲得高精度的模型反而具有更差的感知分?jǐn)?shù),而那些成績「中游」的模型在感知相似度任務(wù)上性能最好。

ImageNet 64 × 64驗(yàn)證精度(x 軸) ,64 × 64 BAPPS 數(shù)據(jù)集上的感知評分(y 軸),每個藍(lán)點(diǎn)代表一個 ImageNet 分類器

可以看到,更好的 ImageNet 分類器在一定程度上實(shí)現(xiàn)了更好的感知評分,但超過某一閾值,提高準(zhǔn)確性反而會降低感知評分,分類器的準(zhǔn)確度適中(20.0-40.0) ,可以獲得最佳的感知評分。

文中同時研究了神經(jīng)網(wǎng)絡(luò)超參數(shù)對感知分?jǐn)?shù)的影響,如寬度、深度、訓(xùn)練步數(shù)、權(quán)重衰減、標(biāo)簽平滑和dropout

對于每個超參數(shù),存在一個最優(yōu)精度,提高精度可以改善感知評分,但這個最優(yōu)值相當(dāng)?shù)停⑶以诔瑓?shù)掃描中很早就可以達(dá)到。

除此之外,分類器精度的提高會導(dǎo)致更差的感知評分。

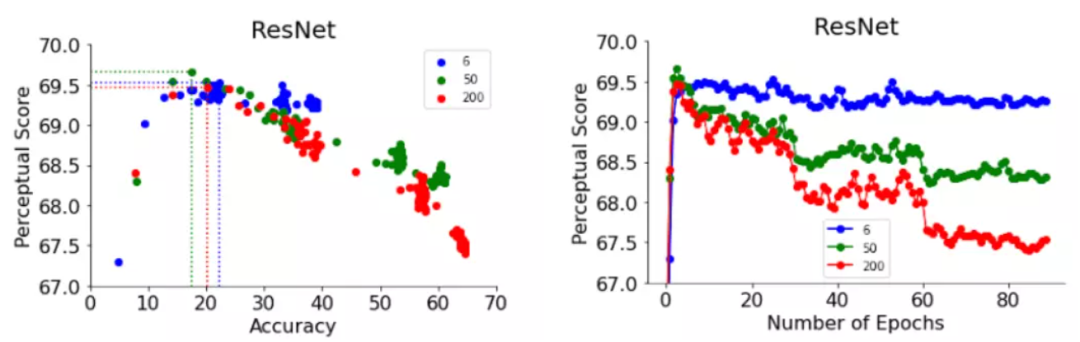

舉個例子,文中給出了感知評分相對于兩個超參數(shù)的變化: ResNets中的訓(xùn)練steps和ViTs中的寬度。

提前停止的ResNets在6, 50和200的不同深度設(shè)置下獲得了最佳感知評分

ResNet-50和ResNet-200的感知評分在訓(xùn)練的前幾個epoch達(dá)到最高值,但在峰值后,性能更好的分類器感知評分值下降更為劇烈。

結(jié)果顯示,ResNets的訓(xùn)練與學(xué)習(xí)率調(diào)整可以隨step增加提升模型的準(zhǔn)確性。同樣,在峰值之后,模型也表現(xiàn)出與這種逐步提高的精度相匹配的感知相似度評分逐步下降。

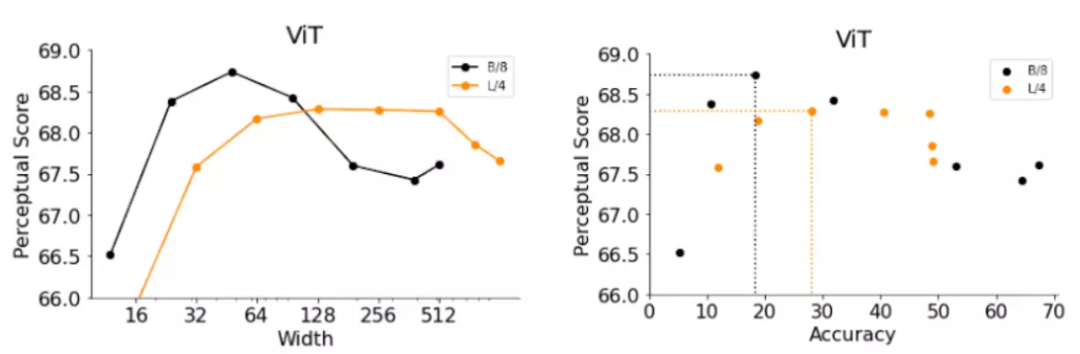

ViTs由應(yīng)用于輸入圖像的一組Transformer塊組成,ViT模型的寬度是單個Transformer塊的輸出神經(jīng)元數(shù),增加寬度可以有效提高模型的精度。

研究人員通過更換兩個ViT變體的寬度,獲得兩個模型B/8(即Base-ViT模型,patch尺寸為4)和L/4(即Large-ViT模型) ,并評估準(zhǔn)確性和感知評分。

結(jié)果還是與提前停止的ResNets觀察結(jié)果相似,精度較低的較窄的ViT比默認(rèn)寬度表現(xiàn)得更好。

不過ViT-B/8和 ViT-L/4的最佳寬度分別是它們默認(rèn)寬度的6% 和12% ,論文中還提供了對于其他超參數(shù)的更詳細(xì)實(shí)驗(yàn)列表,如寬度、深度、訓(xùn)練步數(shù)、權(quán)重衰減、標(biāo)簽平滑和跨 ResNet 和 ViTs 的dropout。

所以想提升感知相似度,那策略就簡單了,適當(dāng)降低準(zhǔn)確率即可。

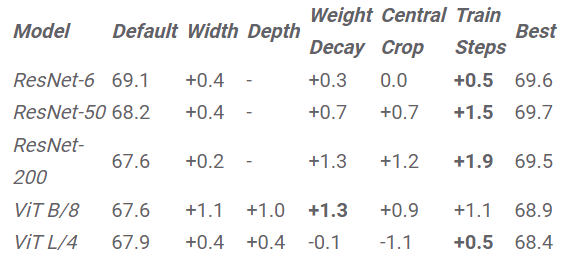

通過縮小ImageNet模型來提高感知評分,表格中的值表示通過在帶有默認(rèn)超參數(shù)的模型上縮放給定超參數(shù)的模型而獲得的改進(jìn)

根據(jù)上述結(jié)論,文中提出了一個簡單的策略來改善架構(gòu)的感知評分:縮小模型來降低準(zhǔn)確性,直至達(dá)到最佳的感知得分。

在實(shí)驗(yàn)結(jié)果中還可以看到,通過在每個超參數(shù)上縮小每個模型所獲得的感知評分改進(jìn)。除了 ViT-L/4,提前停止可以在所有架構(gòu)中產(chǎn)生最高的評分改進(jìn)度,并且提前停止是最有效的策略,不需要進(jìn)行費(fèi)時的網(wǎng)格搜索。

全局感知函數(shù)

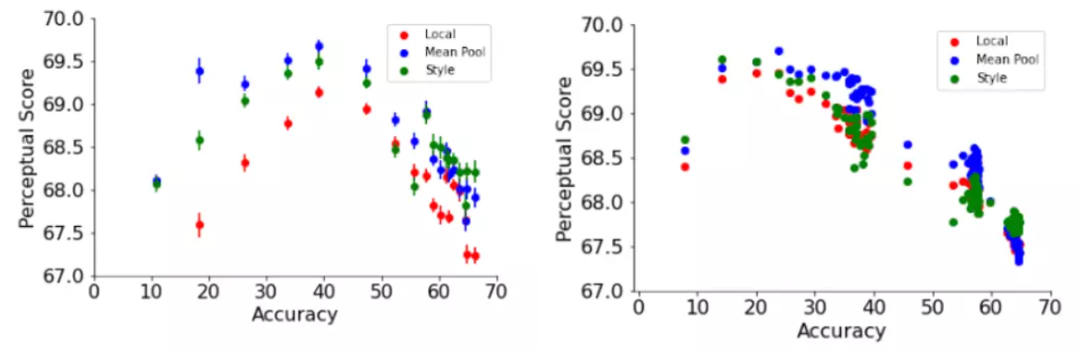

在先前的工作中,感知相似度函數(shù)使用跨圖像空間維度的歐氏距離來計(jì)算。

這種方式假定了像素之間存在直接對應(yīng)關(guān)系,但這種對應(yīng)關(guān)系可能不適用于彎曲、平移或旋轉(zhuǎn)的圖像。

在這篇文章中,研究人員采用了兩個依賴于圖像全局表示的感知函數(shù),即捕捉兩個圖像之間的風(fēng)格相似性的神經(jīng)風(fēng)格遷移工作中的風(fēng)格損失函數(shù)和歸一化的平均池距離函數(shù)。

樣式損失函數(shù)比較兩幅圖像之間的通道間cross-correlation矩陣,而平均池函數(shù)比較空間平均的全局表示。

全局感知函數(shù)一致地改善了兩個網(wǎng)絡(luò)訓(xùn)練的默認(rèn)超參數(shù)和ResNet-200作為訓(xùn)練epoch函數(shù)的感知評分

文中還探討了一些假設(shè)來解釋精確度和感知評分之間的關(guān)系,并得出了一些額外的見解。

例如,沒有常用的skip連接的模型準(zhǔn)確性也與感知評分成反比,與接近輸入的層相比,更接近輸出的層平均具有較低的感知評分。

同時還進(jìn)一步探索了失真靈敏度(distortion sensitivity)、 ImageNet類別粒度和空間頻率靈敏度。

總之,這篇論文探討了提高分類精度是否會產(chǎn)生更好的感知度量的問題,研究了不同超參數(shù)下ResNets和ViTs上精度與感知評分之間的關(guān)系,發(fā)現(xiàn)感知評分與精度呈現(xiàn)倒U型關(guān)系,其中精度與感知評分在一定程度上相關(guān),呈現(xiàn)倒U型關(guān)系。

最后,文章詳細(xì)討論了精度與感知評分之間的關(guān)系,包括skip連接、全局相似函數(shù)、失真敏感度、分層感知得分、空間頻率敏感度和ImageNet類別粒度。

雖然對于ImageNet精確度和感知相似度之間的權(quán)衡現(xiàn)象的確切解釋仍然是一個謎,但這篇論文向前邁出了第一步。