李飛飛兩位高徒聯(lián)合指導(dǎo):能看懂「多模態(tài)提示」的機(jī)器人,zero-shot性能提升2.9倍

人工智能領(lǐng)域的下一個(gè)發(fā)展機(jī)會(huì),有可能是給AI模型裝上一個(gè)「身體」,與真實(shí)世界進(jìn)行互動(dòng)來學(xué)習(xí)。

相比現(xiàn)有的自然語言處理、計(jì)算機(jī)視覺等在特定環(huán)境下執(zhí)行的任務(wù)來說,開放領(lǐng)域的機(jī)器人技術(shù)顯然更難。

比如prompt-based學(xué)習(xí)可以讓單個(gè)語言模型執(zhí)行任意的自然語言處理任務(wù),比如寫代碼、做文摘、問答,只需要修改prompt即可。

但機(jī)器人技術(shù)中的任務(wù)規(guī)范種類更多,比如模仿單樣本演示、遵照語言指示或者實(shí)現(xiàn)某一視覺目標(biāo),這些通常都被視為不同的任務(wù),由專門訓(xùn)練后的模型來處理。

最近來自英偉達(dá)、斯坦福大學(xué)、瑪卡萊斯特學(xué)院、加州理工、清華大學(xué)和得克薩斯大學(xué)奧斯汀分校的研究人員共同提出一個(gè)基于Transformer的通用機(jī)器人智能體VIMA,利用多模態(tài)的prompt,實(shí)現(xiàn)極高的泛化性能,能夠處理大量的機(jī)器人操作任務(wù)。

論文鏈接:https://arxiv.org/abs/2210.03094

項(xiàng)目鏈接:https://vimalabs.github.io/

代碼鏈接:https://github.com/vimalabs/VIMA

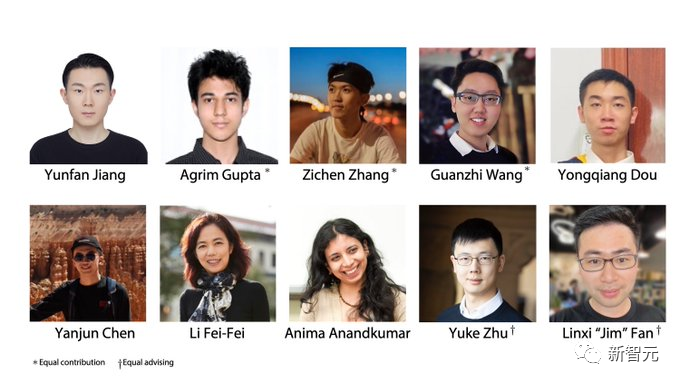

輸入prompt為交錯(cuò)使用的文字和視覺符號(hào)。

為了訓(xùn)練和評(píng)估VIMA,研究人員提出了一個(gè)新的模擬基準(zhǔn)數(shù)據(jù)集,包含上千個(gè)由程序生成的帶有多模態(tài)提示的桌面任務(wù),和60多萬條專家軌跡用于模仿學(xué)習(xí),以四個(gè)等級(jí)來評(píng)估模型的泛化性能。

在同等尺寸的模型、等量訓(xùn)練數(shù)據(jù)的情況下,VIMA在最難的zero-shot的泛化設(shè)置下任務(wù)成功率為當(dāng)下sota方法的2.9倍。

在訓(xùn)練數(shù)據(jù)減少10倍的情況下,VIMA的表現(xiàn)仍然比其他方法好2.7倍。

目前所有的代碼、預(yù)訓(xùn)練模型、數(shù)據(jù)集和模擬基準(zhǔn)都已完全開源。

論文的第一作者是Yunfan Jiang,斯坦福大學(xué)碩士二年級(jí)學(xué)生,目前在英偉達(dá)研究院實(shí)習(xí)。2020年本科畢業(yè)于愛丁堡大學(xué)。他的主要研究方向?yàn)榫呱砣斯ぶ悄埽╡mbodied AI),即通過與環(huán)境的互動(dòng)來學(xué)習(xí)。具體研究?jī)?nèi)容為如何利用大規(guī)模的基礎(chǔ)模型來實(shí)現(xiàn)開放式的的具身智能體(embodied agents)

論文包含兩位導(dǎo)師,均為李飛飛曾經(jīng)的學(xué)生。

朱玉可,本科畢業(yè)于浙江大學(xué),并取得了浙江大學(xué)和加拿大西蒙弗雷澤大學(xué)的雙學(xué)位。碩士和博士研究生就讀于斯坦福大學(xué),師從李飛飛,并于2019年8月取得博士學(xué)位。朱玉可現(xiàn)任UT Austin計(jì)算機(jī)科學(xué)系助理教授,同時(shí)是機(jī)器人感知和學(xué)習(xí)實(shí)驗(yàn)室的主任,以及英偉達(dá)研究院高級(jí)研究科學(xué)家。

范麟熙,博士畢業(yè)于斯坦福大學(xué),師從李飛飛,目前是NVIDIA AI的研究科學(xué)家。主要研究方向?yàn)殚_發(fā)通用且強(qiáng)大的自主智能體(generally capable autonomous agents),具體的研究工作涵蓋了基礎(chǔ)模型、策略學(xué)習(xí)、機(jī)器人技術(shù)、多模式學(xué)習(xí)和大規(guī)模系統(tǒng)。

機(jī)器人與多模態(tài)prompt

Transformer在NLP領(lǐng)域多任務(wù)已經(jīng)實(shí)現(xiàn)相當(dāng)高的性能,僅一個(gè)模型就能同時(shí)完成問答、機(jī)器翻譯、文本摘要等。

實(shí)現(xiàn)不同任務(wù)的接口就在于輸入的文本提示,從而將具體的任務(wù)需求傳遞給通用大模型。

能不能把這種prompt接口用在通用機(jī)器人智能體上呢?

對(duì)于一個(gè)家務(wù)機(jī)器人來說,理想情況下,只需要輸入給我拿<杯子的圖像>,機(jī)器人就可以按照?qǐng)D片把杯子拿過來。

當(dāng)機(jī)器人需要學(xué)習(xí)新技能時(shí),最好可以通過輸入視頻演示就能學(xué)習(xí)。如果機(jī)器人需要與不熟悉的物體進(jìn)行互動(dòng)時(shí),只需要通過圖例即可輕松解釋。

同時(shí)為了確保安全部署,用戶可以進(jìn)一步指定視覺約束,比如不要進(jìn)入<圖像>房間

為了實(shí)現(xiàn)這些功能,VIMA模型主要包含三部分:

1、 形式化多模態(tài)提示,將機(jī)器人操縱任務(wù)轉(zhuǎn)化為一個(gè)序列建模問題;

2、一個(gè)新的機(jī)器人智能體模型,能夠進(jìn)行多任務(wù)操作

3、一個(gè)具有不同任務(wù)的大規(guī)模基準(zhǔn),以系統(tǒng)地評(píng)估智能體的可擴(kuò)展性和通用性

首先,由多模態(tài)提示帶來的靈活性可以讓開發(fā)者指定和構(gòu)建一個(gè)模型即可支持大量的任務(wù)規(guī)范,這篇論文中主要考慮六類任務(wù):

1、簡(jiǎn)單物體操縱(Simple object manipulation),任務(wù)提示形如put <object> into <container>,其中對(duì)應(yīng)的槽位為物體的圖像;

2、實(shí)現(xiàn)視覺目標(biāo)(Visual goal reaching),操縱物體實(shí)現(xiàn)目標(biāo)設(shè)置,比如重新排列(rearragement);

3、接納新概念(Novel concept grounding),提示中包含一些不常見的詞,例如dax, blicket等,可以通過在提示內(nèi)的圖像進(jìn)行解釋,然后直接在指令中使用,可以測(cè)試智能體對(duì)新概念的認(rèn)知速度;

4、單樣本視頻模仿(One-shot video imitation),觀看視頻演示,并學(xué)習(xí)如何以相同的移動(dòng)路徑對(duì)一個(gè)特定物體進(jìn)行復(fù)現(xiàn);

5、滿足視覺限制(Visual constraint satisfaction),機(jī)器人必須小心地操縱物體,來避免觸犯安全性限制;

6、視覺推理(Visual reasoning),有一些任務(wù)要求智能體需要會(huì)推理,比如「把所有和<object>相同紋理的物體都放到一個(gè)容器中」,或者要求視覺記憶,如「把<object>放到容器中,然后再放回到原位」

需要注意的是,這六類任務(wù)并非互斥,比如有的任務(wù)可能會(huì)通過演示視頻(imitation)引入了一個(gè)之前沒見過的動(dòng)詞(Novel Concept)

新基準(zhǔn)VIM-BENCH

巧婦難為無米之炊,為了訓(xùn)練模型,研究人員同時(shí)準(zhǔn)備了一些配套數(shù)據(jù)作為多模態(tài)機(jī)器人學(xué)習(xí)基準(zhǔn)VIMA-BENCH。

在仿真環(huán)境(Simulation Environment)上,現(xiàn)有的基準(zhǔn)一般都是針對(duì)特定的任務(wù)規(guī)范,目前還沒有一個(gè)基準(zhǔn)能夠提供豐富的多模態(tài)任務(wù)套件和全面的測(cè)試平臺(tái)來有針對(duì)性地探測(cè)代理能力。

為此,研究人員通過擴(kuò)展Ravens機(jī)器人模擬器來建立VIMA-BENCH,支持可擴(kuò)展的物體和紋理集合,以組成多模態(tài)提示,并按程序生成大量的任務(wù)。

具體來說,VIMA-BENCH提供了17個(gè)帶有多模態(tài)提示模板的元任務(wù),可以被實(shí)例化為1000個(gè)獨(dú)立的任務(wù)。每個(gè)元任務(wù)屬于上述6種任務(wù)規(guī)范方法中的一種或多種。

VIMA-BENCH可以通過腳本化的oracle智能體生成大量的模仿學(xué)習(xí)數(shù)據(jù)。

在觀察和行動(dòng)(Observation and Actions)上,模擬器的觀察空間包括從正視圖和自上而下視圖渲染的RGB圖像,基準(zhǔn)還提供真實(shí)的物體分割和邊界框,用于訓(xùn)練以物體為中心的模型。

VIM-BENCH從前人工作中繼承了高級(jí)動(dòng)作空間,由最基礎(chǔ)的運(yùn)動(dòng)技能組成,如「取放」、「擦拭」等,具體由終端效果的姿勢(shì)所決定。

模擬器還具有腳本化的oracle程序,可以通過使用特權(quán)模擬器的狀態(tài)信息,如所有物體的精確位置,以及多模態(tài)指令的基礎(chǔ)解釋,生成專家示范。

最終,研究人員通過預(yù)編程的oracles生成了一個(gè)大型的專家軌跡離線數(shù)據(jù)集用于模仿學(xué)習(xí)。數(shù)據(jù)集包括每個(gè)元任務(wù)的5萬條軌跡,共計(jì)65萬條成功的軌跡。

同時(shí)保留一個(gè)物體模型和紋理的子集方便評(píng)估,并將17個(gè)元任務(wù)中的4個(gè)用于zero-shot泛化性測(cè)試。

VIMA-BENCH的每個(gè)任務(wù)標(biāo)準(zhǔn)只有成功和失敗,不存在中間狀態(tài)的獎(jiǎng)勵(lì)信號(hào)。

在測(cè)試時(shí),研究人員在物理模擬器中執(zhí)行智能體策略,以計(jì)算出成功率,所有評(píng)估的元任務(wù)的平均成功率為最終報(bào)告的指標(biāo)。

評(píng)估協(xié)議包含四個(gè)層次以系統(tǒng)地探測(cè)智能體的泛化能力,每一級(jí)都更多地偏離訓(xùn)練分布,因此嚴(yán)格來說一級(jí)比一級(jí)難。

1、放置泛化(Placement generalization):在訓(xùn)練過程中,所有的提示都是逐字逐句的,但在測(cè)試時(shí),桌面上的物體放置是隨機(jī)的。

2、組合泛化(Combinatorial generalization):所有的材料(形容詞)和三維物體(名詞)在訓(xùn)練中都能看到,但在測(cè)試中會(huì)出現(xiàn)一些新的組合形式。

3、新物體泛化(Novel object generalization):測(cè)試提示和模擬的工作空間包括新的形容詞和物體。

4、新任務(wù)泛化(Novel task generalization):測(cè)試時(shí)帶有新提示模板的新型元任務(wù)

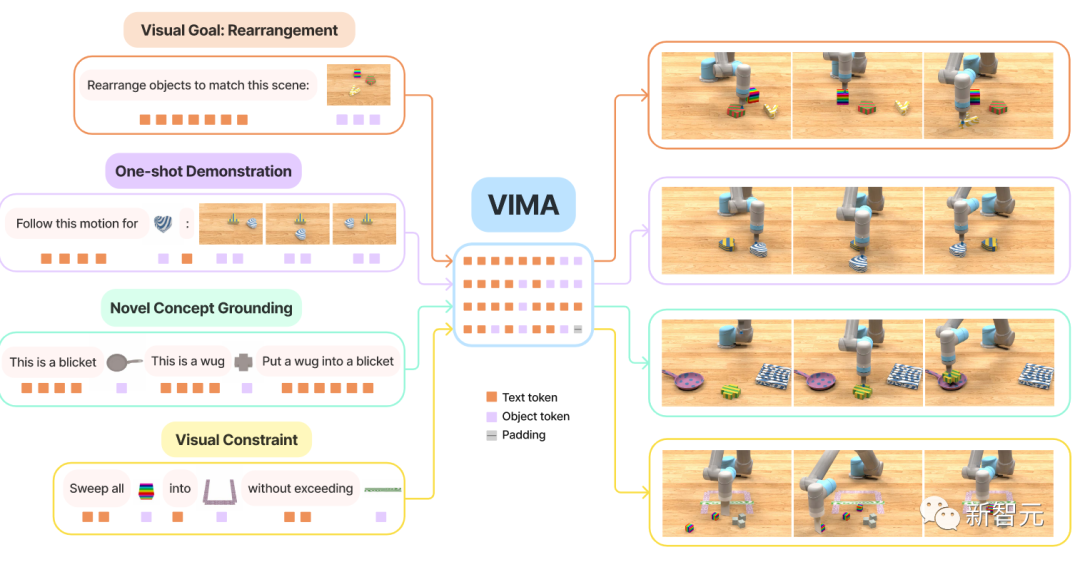

VIMA模型

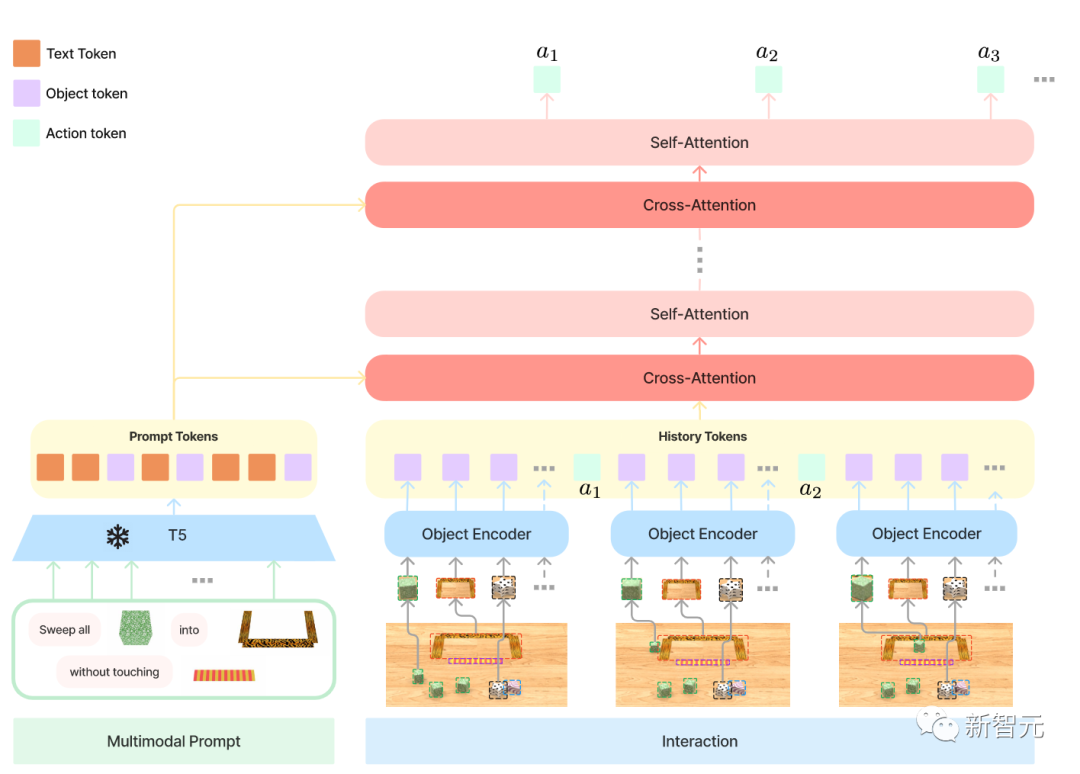

多模態(tài)prompt中總共包含三種格式:

1、文本,使用預(yù)訓(xùn)練的T5模型進(jìn)行分詞及獲取詞向量;

2、整個(gè)桌面的場(chǎng)景,首先使用Mask R-CNN識(shí)別出所有的獨(dú)立物體,每個(gè)物體由一個(gè)bounding box和裁剪圖像表示,然后使用一個(gè)bounding bo編碼器和ViT分別進(jìn)行編碼。

3、單個(gè)物體的圖像,同樣使用ViT獲得tokens,然后將結(jié)果序列輸入到預(yù)訓(xùn)練的T5編碼器模型中。

機(jī)器人控制器(Robot Controller),即解碼器的輸入為提示序列上進(jìn)行多次交叉注意力層后的表示和軌跡歷史序列。

這樣的設(shè)計(jì)可以增強(qiáng)對(duì)prompt的連接度;更好地保留且更深地處理原始prompt tokens;更好的計(jì)算效率。

在測(cè)試階段的實(shí)驗(yàn)設(shè)計(jì),主要為了回答三個(gè)問題:

1、VIMA和之前的SOTA基于Transformer的智能體在多模態(tài)提示的多種任務(wù)上的性能對(duì)比;

2、VIMA在模型容量和數(shù)據(jù)量上的縮放性(scaling properties);

3、不同的視覺分詞器,條件提示和條件編碼是否會(huì)影響到最終的決策。

對(duì)比的基線模型包括Gato, Flamingo和Decision Transformer(DT)

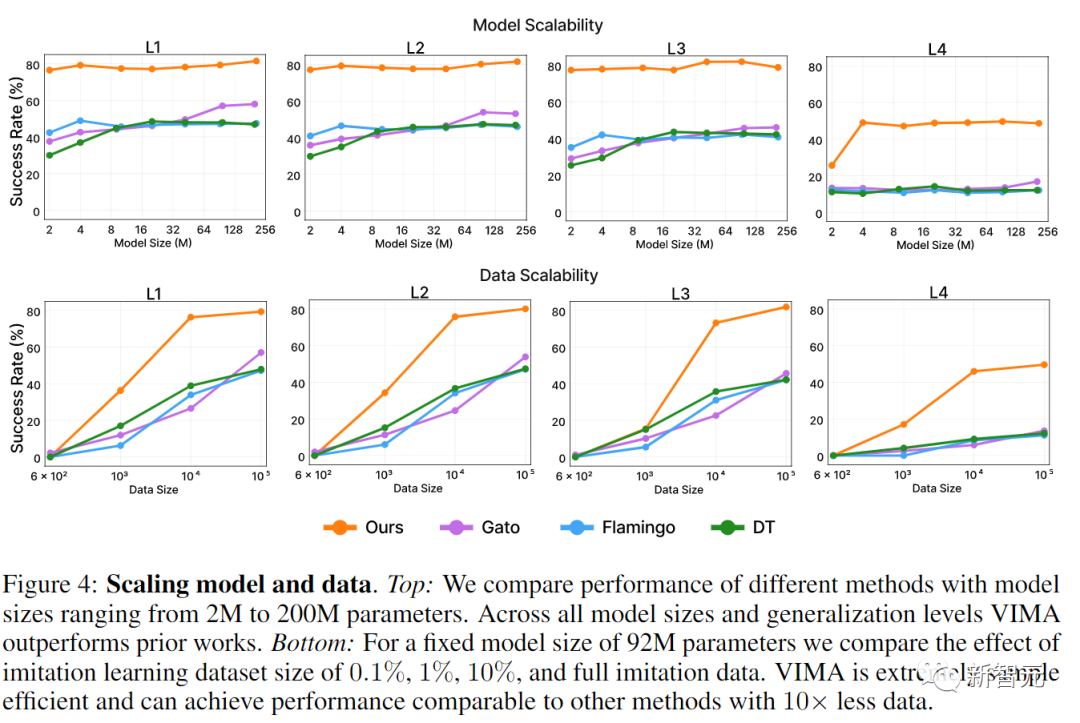

首先在模型縮放(Model scaling)上,研究人員對(duì)所有方法從2M到200M參數(shù)量進(jìn)行訓(xùn)練,編碼器的尺寸始終保持為T5-base,在所有層次的zero-shot泛化性評(píng)估上,VIMA都絕對(duì)好于其他工作。

盡管Gato和Flamingo在更大尺寸的模型上性能有所提升,VIMA也仍然好于所有模型。

在數(shù)據(jù)縮放(Data scaling)上,研究人員對(duì)各個(gè)方法的訓(xùn)練數(shù)據(jù)采取0.1%, 1%, 10%和全量模仿學(xué)習(xí)數(shù)據(jù)集的不同實(shí)驗(yàn),VIMA僅需1%的數(shù)據(jù),就能實(shí)現(xiàn)其他方法用10倍的數(shù)據(jù)訓(xùn)練的L1和L2泛化性指標(biāo)。在L4指標(biāo)上,僅需1%的訓(xùn)練數(shù)據(jù),VIMA就已經(jīng)要比其他模型在全量數(shù)據(jù)上訓(xùn)練效果要好了。

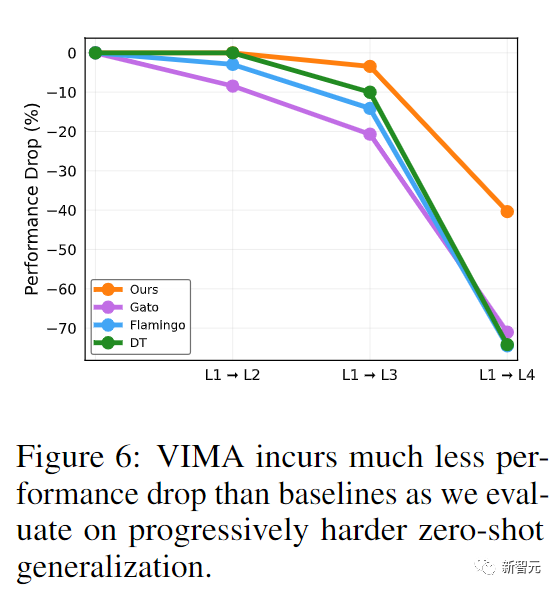

在漸進(jìn)泛化(Progressive Generalization)性能對(duì)比中,在面向更難的泛化任務(wù)中,沒有采用任何微調(diào)。VIMA模型的性能倒退最少,尤其是從L1到L2和L1到L3,而其他模型退化超過了20%,這也意味著VIMA學(xué)習(xí)到了更泛化的策略,更健壯的表征。

參考資料:

https://arxiv.org/abs/2210.03094