機(jī)器學(xué)習(xí)中的集成方法概述

?想象一下,你正在網(wǎng)上購(gòu)物,你發(fā)現(xiàn)有兩家店鋪銷售同一種商品,它們的評(píng)分相同。然而,第一家只有一個(gè)人的評(píng)分,第二家有 100 人評(píng)分。您會(huì)更信任哪個(gè)評(píng)分呢?最終您會(huì)選擇購(gòu)買哪家的商品呢?大多數(shù)人的答案很簡(jiǎn)單。100 個(gè)人的意見肯定比只有一個(gè)人的意見更值得信賴。這被稱為“群眾的智慧”,這也是集成方法有效的原因。

集成方法

通常,我們只從訓(xùn)練數(shù)據(jù)中創(chuàng)建一個(gè)學(xué)習(xí)者(學(xué)習(xí)者=訓(xùn)練模型)(即,我們只在訓(xùn)練數(shù)據(jù)上訓(xùn)練一個(gè)機(jī)器學(xué)習(xí)模型)。而集成方法是讓多個(gè)學(xué)?習(xí)者解決同一個(gè)問題,然后將他們組合在一起。這些學(xué)習(xí)者被稱為基礎(chǔ)學(xué)習(xí)者,可以有任何底層算法,如神經(jīng)網(wǎng)絡(luò),支持向量機(jī),決策樹等。如果所有這些基礎(chǔ)學(xué)習(xí)者都由相同的算法組成那么它們被稱為同質(zhì)基礎(chǔ)學(xué)習(xí)者,而如果它們由不同的算法組成那么它們被稱為異質(zhì)基礎(chǔ)學(xué)習(xí)者。與單個(gè)基礎(chǔ)學(xué)習(xí)者相比,集成具有更好的泛化能力,從而獲得更好的結(jié)果。

當(dāng)集成方法由弱學(xué)習(xí)者組成時(shí)。因此,基礎(chǔ)學(xué)習(xí)者有時(shí)被稱為弱學(xué)習(xí)者。而集成模型或強(qiáng)學(xué)習(xí)者(是這些弱學(xué)習(xí)者的組合)具有更低的偏差/方差,并獲得更好的表現(xiàn)。這種集成方法將弱學(xué)習(xí)者轉(zhuǎn)變?yōu)閺?qiáng)?學(xué)習(xí)者的能力之所以普及,是因?yàn)樵趯?shí)踐中更容易獲得弱學(xué)習(xí)者。

近年來,集成方法不斷贏了各種在線比賽。除了在線比賽之外,集成方法也被應(yīng)用于現(xiàn)實(shí)生活中,如目標(biāo)檢測(cè)、識(shí)別和跟蹤等計(jì)算機(jī)視覺技術(shù)。

集成方法的主要類型

弱學(xué)習(xí)者是如何產(chǎn)生的?

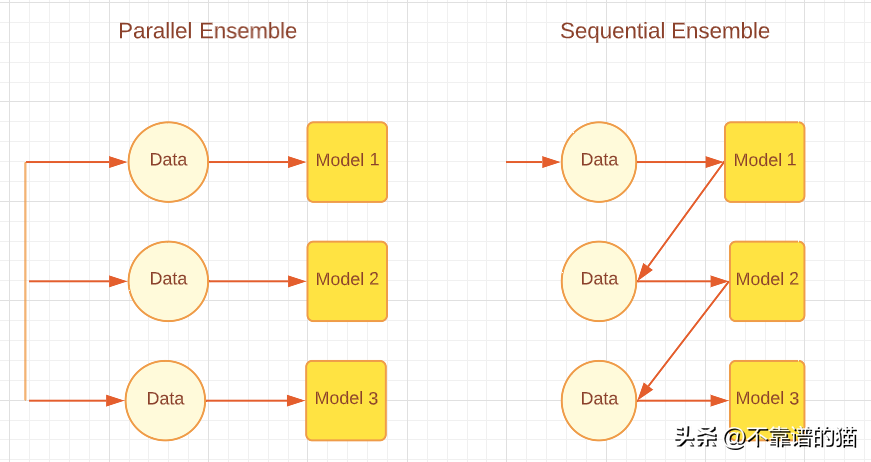

根據(jù)基礎(chǔ)學(xué)習(xí)者的生成方式,?集成方法可以分為兩大類,即順序集成方法和并行集成方法。顧名思義,在Sequential ensemble 方法中,基礎(chǔ)學(xué)習(xí)者是按順序生成的,然后組合起來進(jìn)行預(yù)測(cè),例如AdaBoost等Boosting算法。而在Parallel ensemble 方法中,基礎(chǔ)學(xué)習(xí)者是并行生成的,然后組合起來進(jìn)行預(yù)測(cè),例如隨機(jī)森林和Stacking等Bagging算法算法。下圖顯示了解釋并行和順序方法的簡(jiǎn)單架構(gòu)。

根據(jù)基礎(chǔ)學(xué)習(xí)者的生成方式不同,集成方法可分為兩大類:順序集成方法和并行集成方法。顧名思義,在順序集成方法中,基學(xué)習(xí)者是?按順序生成的,然后組合起來進(jìn)行預(yù)測(cè),例如AdaBoost等Boosting算法。在并行集成方法中,基學(xué)習(xí)者是并行生成的,然后組合在一起進(jìn)行預(yù)測(cè),例如隨機(jī)森林和Stacking等Bagging算法。下圖展示了一個(gè)簡(jiǎn)單的體系結(jié)構(gòu),解釋了并行和順序方法。

并行與順序集成方法

順序?qū)W習(xí)方法利用弱學(xué)習(xí)者之間的依賴關(guān)系,以殘差遞減的方式提高整體性能,使后學(xué)習(xí)者更多地關(guān)注前學(xué)習(xí)者的錯(cuò)誤。粗略地說(對(duì)于回歸問題),boosting方法所得到的集成模型誤差的減小主要是通過降低弱學(xué)習(xí)者的高偏差來實(shí)現(xiàn)的,盡管有時(shí)也會(huì)觀察到方差的減小。另一方面,并行集成方法通過組合獨(dú)立弱學(xué)習(xí)者來減小誤差,即它利用了弱學(xué)習(xí)者之間的獨(dú)立性。這種誤差的減小是由于機(jī)器學(xué)習(xí)模型方差的減小。因此,我們可以歸納為,boosting主要通過減小機(jī)器學(xué)習(xí)模型的偏差來減小誤差,而bagging通過減小機(jī)器學(xué)習(xí)模型的方差來減小誤差。這是很重要的,因?yàn)檫x擇哪種集成方法將取決于弱學(xué)習(xí)者是否有高方差或高偏差。

弱學(xué)習(xí)者如何組合?

在生成這些所謂的基礎(chǔ)學(xué)習(xí)者之后,我們不會(huì)選擇這些學(xué)習(xí)者中最好的,而是將它們組合在一起以實(shí)現(xiàn)更好的泛化,我們這樣做的方式在集成方法中起著重要作用。

平均:當(dāng)輸出是數(shù)字時(shí),最常見的組合基礎(chǔ)學(xué)習(xí)者的方法是平均。平均可以是簡(jiǎn)單平均或加權(quán)平均。對(duì)于回歸問題,簡(jiǎn)單平均將是所有基礎(chǔ)模型的誤差之和除以學(xué)習(xí)者總數(shù)。加權(quán)平均的組合輸出是通過給每個(gè)基礎(chǔ)學(xué)習(xí)者賦予不同的權(quán)重來實(shí)現(xiàn)的。對(duì)于回歸問題,我們將每個(gè)基學(xué)習(xí)者的誤差與給定的權(quán)重相乘,然后求和。

投票:投票是?組合基礎(chǔ)學(xué)習(xí)者最常用的方式。投票可以是不同的類型,如絕對(duì)多數(shù)投票、相對(duì)多數(shù)投票、加權(quán)投票和軟投票。

對(duì)于分類問題,絕對(duì)多數(shù)投票給每個(gè)學(xué)習(xí)者一票,他們投票給一個(gè)類標(biāo)簽。無論哪個(gè)類獲得超過 50% 的選票,都是集成的預(yù)測(cè)結(jié)果。但是,如果沒有一個(gè)類標(biāo)簽獲得超過 50% 的選票,則會(huì)給出拒絕選項(xiàng),這意味著組合集成無法做出任何預(yù)測(cè)。在相對(duì)多數(shù)投票中,獲得最多票數(shù)的類標(biāo)簽是預(yù)測(cè)結(jié)果,超過50%的票數(shù)對(duì)類不是必需的。意思是,如果我們有三個(gè)輸出標(biāo)簽,三個(gè)得到的結(jié)果都少于50%,比如40% 30% 30%,那么獲得40%的類標(biāo)簽就是集合模型的預(yù)測(cè)結(jié)果。加權(quán)投票,就像加權(quán)平均一樣,根據(jù)分類器的重要性和特定學(xué)習(xí)者的強(qiáng)度為分類器分配權(quán)重。軟投票用于概率(0到1之間的值)而不是標(biāo)簽(二進(jìn)制或其他)類的輸出。軟投票進(jìn)一步分為簡(jiǎn)單軟投票(對(duì)概率進(jìn)行簡(jiǎn)單平均)和加權(quán)軟投票(將權(quán)重分配給學(xué)習(xí)者,概率乘以這些權(quán)重并相加)。

學(xué)習(xí):另一種組合方法是通過學(xué)習(xí)進(jìn)行組合,這是stacking集成方法使用的。在這種方法中,一個(gè)稱為元學(xué)習(xí)者的單獨(dú)學(xué)習(xí)者在新數(shù)據(jù)集上進(jìn)行訓(xùn)練,以組合從原始機(jī)器學(xué)習(xí)數(shù)據(jù)集生成的其他基礎(chǔ)/弱學(xué)習(xí)者。

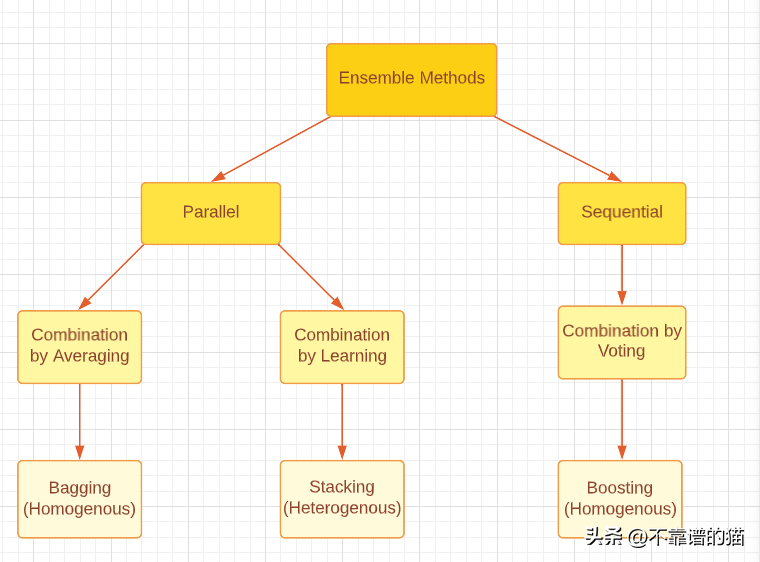

請(qǐng)注意,無論是 boosting、bagging還是 stacking,所有這三種集成方法都可以使用同質(zhì)或異質(zhì)弱學(xué)習(xí)者生成。最常見的做法是使用同質(zhì)弱學(xué)習(xí)者進(jìn)行 Bagging 和 Boosting,使用異質(zhì)弱學(xué)習(xí)者進(jìn)行 Stacking。下圖很好地分類了三種主要的集成方法。

對(duì)集成方法的主要類型進(jìn)行分類

集成多樣性

集成多樣性是指基礎(chǔ)學(xué)習(xí)者之間的差異有多大,這對(duì)于生成良好的集成模型具有重要意義。理論上已經(jīng)證明,通過不同的組合方法,完全獨(dú)立(多樣化)的基礎(chǔ)學(xué)習(xí)者可以最大程度地減少錯(cuò)誤,而完全(高度)相關(guān)的學(xué)習(xí)者不會(huì)帶來任何改進(jìn)。這在現(xiàn)實(shí)生活中確實(shí)是一個(gè)具有挑戰(zhàn)性的問題,因?yàn)槲覀冋谟?xùn)練所有弱學(xué)習(xí)者通過使用相同的數(shù)據(jù)集來解決相同的問題,從而導(dǎo)致高相關(guān)性。在此之上,我們需要確保弱學(xué)習(xí)者不是真正糟糕的模型,因?yàn)檫@甚至可能導(dǎo)致集成性能惡化。另一方面,將強(qiáng)而準(zhǔn)確的基礎(chǔ)學(xué)習(xí)者組合起來,也可能沒有將一些弱學(xué)習(xí)者和一些強(qiáng)學(xué)習(xí)者組合起來的效果好。因此,需要在基礎(chǔ)學(xué)習(xí)者的準(zhǔn)確程度與基礎(chǔ)學(xué)習(xí)者之間的差異之間取得平衡。

如何實(shí)現(xiàn)集成多樣性?

1. 數(shù)據(jù)處理

我們可以將我們的數(shù)據(jù)集劃分為子集供基礎(chǔ)學(xué)習(xí)者使用。如果機(jī)器學(xué)習(xí)數(shù)據(jù)集很大,我們可以簡(jiǎn)單地將數(shù)據(jù)集分成相等的部分,然后輸入到機(jī)器學(xué)習(xí)模型中。如果數(shù)據(jù)集很小,我們可以使用隨機(jī)抽樣替換,從原始數(shù)據(jù)集生成新的數(shù)據(jù)集。Bagging方法使用bootstrapping技術(shù)來生成新的數(shù)據(jù)集,它基本上是帶替換的隨機(jī)抽樣。通過bootstrapping,我們能夠創(chuàng)造一些隨機(jī)性,因?yàn)樗猩傻臄?shù)據(jù)集都必須擁有一些不同的值。然而,請(qǐng)注意,大多數(shù)值(根據(jù)理論約為67%)仍然會(huì)重復(fù),因此數(shù)據(jù)集不會(huì)完全獨(dú)立。

2.輸入特征

所有數(shù)據(jù)集都包含提供有關(guān)數(shù)據(jù)信息的特征。我們可以創(chuàng)建特征子集并生成不同的數(shù)據(jù)集并將其輸入模型,而不是使用一個(gè)模型中的所有特征。這種方法被隨機(jī)森林技術(shù)采用,當(dāng)數(shù)據(jù)中存在大量冗余特征時(shí)有效。當(dāng)數(shù)據(jù)集中的特征很少時(shí),有效性會(huì)降低。

3.學(xué)習(xí)參數(shù)

該技術(shù)通過對(duì)基礎(chǔ)學(xué)習(xí)算法應(yīng)用不同的參數(shù)設(shè)置,即超參數(shù)調(diào)優(yōu),在基礎(chǔ)學(xué)習(xí)者中產(chǎn)生隨機(jī)性。例如,通過改變正則化項(xiàng),可以將不同的初始權(quán)重分配給各個(gè)神經(jīng)網(wǎng)絡(luò)。

集成剪枝

最后,集成剪枝技術(shù)在某些情況下有助于獲得更好的集成性能。集成剪枝(Ensemble Pruning)的意思是,我們只組合學(xué)習(xí)者的子集,而不是組合所有弱學(xué)習(xí)者。除此之外,更小的集成可以節(jié)省存儲(chǔ)和計(jì)算資源,從而提高效率。

最后

本文僅僅是機(jī)器學(xué)習(xí)集成方法概述。希望大家能夠更加深入地進(jìn)行研究,更重要的是能購(gòu)將研究應(yīng)用于現(xiàn)實(shí)生活中。