集成學習方法

集成學習是機器學習算法中非常強大的工具,有人把它稱為機器學習中的“屠龍刀”,非常***且有效,在各大機器學習、數(shù)據(jù)挖掘競賽中使用非常廣泛。它的思想非常簡單,集合多個模型的能力,達到“三個臭皮匠,賽過諸葛亮”的效果。集成學習中概念是很容易理解的,但是好像沒有同一的術(shù)語,很多書本上寫得也不一樣,越看越模糊。這里我把集成學習分為兩個大類,***大類稱為模型融合,與臺大機器學習技法課上的blending概念相似,模型融合其實是個再學習的過程。***步是訓(xùn)練出多個不同的強學習器,然后考慮如何將這多個學習器組合起來,更進一步提高性能。第二大類稱為機器學習元算法,這類算法本身就是多模型組合的結(jié)果,只是元算法中的基算法(base_algorithm一般會比較弱),稱為弱模型的組合,例如RF、GDBT。

一、模型融合

實際中,我們總可以根據(jù)實際問題,訓(xùn)練出多個功能強大學習器,為了進一步提高學習器的能力,可以嘗試將這些學習組合起來,這個過程就是模型融合。一般來說模型能在一定程度上提高性能,有時使模型的預(yù)測能力更加強大,有時增加模型的泛化能力,顯而易見的壞處是多模型的學習加上再學習的過程會增加計算的代價。模型融合在競賽中十分常見,屢試不爽,融合方法恰當,一般能提高成績。

1.1 常用的獲得不同模型的方法

由于不同的訓(xùn)練模型得到不同的模型,例如處理分類的LR、SVM、RF等

由于同一訓(xùn)練模型調(diào)節(jié)不同參數(shù)獲得不同的模型,例如GDBT中迭代次數(shù),每個樹的復(fù)雜度等

有些算法本身就有一定的隨機性,如PLA

由于訓(xùn)練數(shù)據(jù)不同得到不同的模型,如交叉驗證、隨機抽樣

上面這些生成不同模型可以組合生成更多不同的模型,比較常用的是最前面的兩個

1.2 模型融合的方法

通過驗證(validation)的方式,從***步中訓(xùn)練出的多個模型中挑選***的模型,作為最終的模型。這種方式必須要驗證,不同使Ein最小,否則很容易過擬合。

統(tǒng)一融合(Uniform blending),分類時使用一人一票的投票方式,回歸時使用多個模型的平均值。這種方式的優(yōu)點是一般泛化能力會得到加強,但是只能保證比那些模型中最差的模型要好,不能保證能得到比那些不同模型中的***的模型要好

線性融合(Linear blending),二次學習,使用線性模型將***步中學習到的學習器組合起來,用得好可以提高模型性能,但是要注意有過擬合的風險。

堆融合(Any blending、stacking),任何其它非線性模型將那些學習器組合起來,有過擬合的風險,注意驗證。

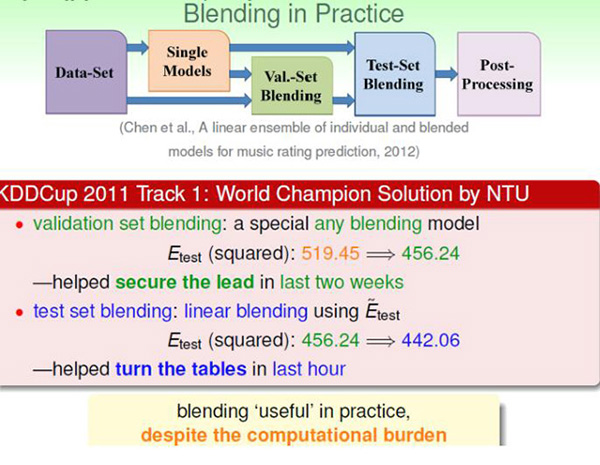

模型融合在實際中十分常見,下面是臺大在2011KDDCup獲得冠軍時使用的模型融合方法,先用了any blending (stacking)處于領(lǐng)先群的位置,***的linear blend使得臺大獲得冠軍。

二、機器學習元算法

機器學習元算法分為兩類:Averaging methods 和 Boosting methods

Averaging methods 核心是引入隨機(對樣本、特征屬性隨機取樣)學習產(chǎn)生多個獨立的模型,然后平均所有模型的預(yù)測值。一般而言,這種方法,會減小方差(variance),不太會過擬合。主要包括bagging、RF。

Boosting methods 逐步加強方法,該方法集合學習多個模型,提高模型的準確率。不同的是,它是基于前面模型的訓(xùn)練結(jié)果(誤差),生成新的模型,從而減小偏差(bias)。一般而言,這種方法會比上者的準確率高一點,但是也不是絕對的。它的缺點是有過擬合的風險,另外,由于它每個模型是“序列化”(有前后關(guān)系)產(chǎn)生的,不易并行化。它的代表是AdaBoost、GDBT。

2.1 Bagging

Bagging 在原始樣本中隨機抽樣獲取子集,用隨機抽樣的子集訓(xùn)練基學習器(base_estimator),然后對每個基學習器的結(jié)果求平均,最終得到的預(yù)測值。隨機獲取樣本子集的方法有很多中,最常用的是有放回抽樣的booststrap,也可以是不放回的抽樣。基學習器可以是相同的模型,也可以是不同的,一般使用的是同一種基學習器,最常用的是DT決策樹。由于bagging提供了一種降低方差(variance)的方式,所以一般會使用比較強、復(fù)雜的基學習器模型(e.g.fully developed decision trees),作為對比在boosting方法中會使用非常弱的基學習器模型(e.g. shallow decision trees)。在sklearn中實現(xiàn)了基于bagging的分類和回歸方法,主要設(shè)置參數(shù)為基學習器的類型、迭代次數(shù)(子模型的個數(shù))、獲取訓(xùn)練子集的方式。由于bagging訓(xùn)練每個模型可以并行,還可以設(shè)置n_jobs訓(xùn)練模型使用的多少個cpu核。

2.2 隨機森林(RF)

RF在實際中使用非常頻繁,其本質(zhì)上可bagging并無不同,只是RF更具體一些。一般而言可以將RF理解為bagging和DT(CART)的結(jié)合。RF中基學習器使用的是CART樹,由于算法本身能降低方差(variance),所以會選擇完全生長的CART樹。抽樣方法使用bootstrap,除此之外,RF認為隨機程度越高,算法的效果越好。所以RF中還經(jīng)常隨機選取樣本的特征屬性、甚至于將樣本的特征屬性通過映射矩陣映射到隨機的子空間來增大子模型的隨機性、多樣性。RF預(yù)測的結(jié)果為子樹結(jié)果的平均值。RF具有很好的降噪性,相比單棵的CART樹,RF模型邊界更加平滑,置信區(qū)間也比較大。一般而言,RF中,樹越多模型越穩(wěn)定。

2.3 AdaBoost

AdaBoost 是一種Boosting方法,與Bagging不同的是,Adaboost中不同的子模型必須是串行訓(xùn)練獲得的,每個新的子模型都是根據(jù)已訓(xùn)練出的模型性能來進行訓(xùn)練的,而且Boosting算法中基學習器為弱學習。弱學習器可以理解為只比隨機猜測好一點,在二分類情況下,錯誤率略低0.5即可,實際中常使用 small decision trees。AdaBoost中每個訓(xùn)練樣本都有一個權(quán)重,這些權(quán)重構(gòu)成了一個向量W,初始值都為為Wi=1/N。

Adaboost中每次迭代生成新的子模型使用的訓(xùn)練數(shù)據(jù)都相同,但是樣本的權(quán)重會不一樣。AdaBoost會根據(jù)當前的錯誤率,增大錯誤樣本權(quán)重,減小正確樣本權(quán)重的原則更新每個樣本的權(quán)重。不斷重復(fù)訓(xùn)練和調(diào)整權(quán)重,直到訓(xùn)練錯誤率或弱學習器的個數(shù)滿足用戶指定的值為止。Adaboost的最終結(jié)果為每個弱學習器加權(quán)的結(jié)果。使用sklearn中的Adaboot時,主要調(diào)節(jié)的參數(shù)有n_estimator(多少棵樹)、max_depth(每棵樹的深度。復(fù)雜度)或者min_samples_leaf(最少的葉子節(jié)點)。

2.4 GDBT

GDBT也是一種Boosting方法,每個子模型是根據(jù)已訓(xùn)練出的學習器的性能(殘差)訓(xùn)練出來的,子模型是串行訓(xùn)練獲得,不易并行化。GDBT使用非常廣泛的,能分類,能回歸預(yù)測。GDBT基于殘差學習的算,沒有AdaBoost中的樣本權(quán)重的概念。GDBT結(jié)合了梯度迭代和回歸樹,準確率非常高,但是也有過擬合的風險。GDBT中迭代的殘差的梯度,殘差就是目前結(jié)合所有得到的訓(xùn)練器預(yù)測的結(jié)果與實際值的差值,不理解可以參考另一篇博客,里面有一個實例介紹如何基于殘差來學習預(yù)測人的年齡。GDBT的使用也非常的簡單,主要調(diào)節(jié)的參數(shù)有確定需要多少棵樹(n_estimator)、每棵樹的復(fù)雜度(max_depth,max_leaf_node)、損失函數(shù)(loss)以及學習率(learning_rating)。為了防止過擬合一般學習率會選小一點的(<0.1),learning_rate會影響n_estimator,需要權(quán)衡,選擇***的組合參數(shù)。