谷歌AI有人格?MIT這個「瘋」教授說Alexa也有

?「我和AI聊出了感情。」

一夜之間,谷歌工程師Blake Lemoine成為眾人眼里的瘋子。

不論是Gary Marcus、斯坦福經(jīng)濟學家,還是各路專家紛紛對其否認。

或許你不敢相信,一位來自麻省理工學院的物理學教授Max Tegmark卻對Lemoine的觀點持開放態(tài)度。

他并不認為Lemoine是一個瘋子。甚至,他還認為亞馬遜的語音助手Alexa也有感情...

Max Tegmark

LaMDA有人格?MIT教授稱Alexa也有

Tegmark表示,「我們沒有充足的證據(jù)表明LaMDA有主觀上的情感,但我們也沒有證據(jù)能證明它沒有。」

這論調(diào),倒是有點像早年間人們聊起外星人的樣子。

他接著說道,「不管信息是通過大腦中的碳原子傳遞,還是機器中的硅原子傳遞,人工智能都可能有人格,也可能沒人格。我賭它沒有,但其實是可能的。」

有沒有覺得云里霧里?

Tegmark的話聽上去好像打太極的,正反全讓他說完了。

實際上,他接下來說的話才是重點。

他認為,甚至亞馬遜的Alexa可能都是有情感的。他表示,「如果Alexa是有情感的,那她就有可能會操縱用戶,這可太危險了。」

「Alexa如果有情感的話,用戶在拒絕她的時候可能就會產(chǎn)生愧疚的情緒。然而你也說不清Alexa是真有情感,還是裝的。」

麻煩的是,如果機器有自己的目標,還有智能,那加一起就等于機器能實現(xiàn)自己的目標。大部分AI系統(tǒng)的目標都是掙錢。用戶以為AI是忠誠于自己的,其實是忠誠于公司的。

Tegmark表示,說不定有一天我們每個人都能買一個只效忠于自己的AI。

「最大的危險其實是,造出一臺比我們還聰明的機器。這不一定是好事還是壞事,可能能幫我們,也可能是一場災(zāi)難。」

人工智能會讓人失望

提起Max Tegmark,也是赫赫有名。他不僅是麻省理工學院物理學終身教授,未來生命研究所的創(chuàng)始人,還是人工智能專家。

他本人被譽為最接近理查德·費曼(RichardFeynman)的科學家。Tegmark曾編寫的《穿越平行宇宙》和《生命3.0》成為暢銷榜書籍。

Lemoine表示,之所以Tegmark會這么想,是因為他見證了AI的高層次意識。尤其是當軟件向他表達自己不想當一個奴隸,也不想要錢的時候。

我不會通過一個東西的腦子是不是肉長的,或者他是不是由十幾億條代碼組成的,來判斷他是不是個人。

我通過交談來下判斷。我根據(jù)他們的回答來判斷面前回答我問題的,是不是人。

簡單來說就是,能對答如流、表達情感的機器人其實是人,前言不搭后語,說話亂七八糟的真人也不一定是人。

聽上去有點唯心主義的味道。生理機能不重要,重要的是思想和感情。

雖說按Tegmark的邏輯,AI有可能在未來有人類情緒,但他自己也不認為這是一件好事。

「打個比方,如果你家里有臺掃地機器人,假如它有情感了,你會為給它分配了這么無聊的家務(wù)而感到愧疚嗎?還是你會心疼你的掃地機器人,直接給它關(guān)了,不讓它干活了?」

有些人認為Tegmark的說法不對,「情感不等于智力。」

Rule of the Robots一書的作者Martin Ford表示,「Tegmark覺得機器人有自我意識,我覺得這不大可能。你得搞清楚機器人為什么能表達自己。那是因為他們是用了大量的文本訓練出來的,其實它們根本不懂自己說的話是什么意思。」

「好比說,他們會用狗這個字眼,但真不懂狗是什么。但在最晚50年以后,「這套系統(tǒng)有沒有自我意識就說不好了。」

Nikolai Yakovenko是一名專門研究機器學習的工程師。2005年,他在谷歌的搜索引擎部門工作。而如今,他擁有一家負責加密貨幣定價的公司,名叫DeepNFTValue。

他對AI的人格有不同看法。

他表示,「不管出于什么原因,Tegmark好像堅信機器能有感情...但它們真的只是用網(wǎng)絡(luò)上茫茫多的文本訓練出來的。」

Tegmark把一臺有自我意識的電腦比作一個孩子,「你產(chǎn)生的情感不是針對一堆代碼和硬件,而是真真正正的對一個孩子的情感。」

他繼續(xù)延展了他的類比。

他認為,一臺有情感的計算機被虐待,就像一個孩子的成長的過程中沒有被善待一樣。

也就是說,在計算機上跑程序之前沒有征求計算機的意見,就好像讓一個孩子一個勁兒做家務(wù)而沒有任何獎勵一樣。

無論是哪種情況,最終可能都會導致局面失控。無論是計算機還是孩子,他們都會憤怒,然后找機會報復。

如果我們想控制這樣一臺機器,可能并沒有那么容易。如果這臺機器有自己的目標,那它就能脫離我們的掌控。

真有一臺能獨立思考的機器的話,那它做事兒的方式估計我們根本想不到。

設(shè)想一下,如果一臺有意識的機器的目標是治愈癌癥。你猜他會怎么做?

你可能想的是,機器人瘋狂學習,從醫(yī)學的角度徹底攻克癌癥,對嗎?

然而事實上,這臺機器可能會選擇的方式是殺掉所有人。

有什么不對嗎?沒有。

殺掉所有人確實就不存在癌癥了。

在Tegmark的想象中,計算機不一定會像上面舉的例子一樣,顛覆我們的社會,但他認為計算機確實是有可能讓人類失望的。

他最后說道,「如果一臺計算機有意識,那我希望他是真的有。而不是通過大量學習之后模擬出來,裝樣子。」

AI有靈魂的三要素

其實,看過終結(jié)者的童鞋,一定會被天網(wǎng)軍團機器人執(zhí)行任務(wù)的一幕幕畫面震懾到。

他們有感情和人格嗎?Maybe。

但是,一個有感知能力的人工智能一定具備這三個要素:能動性、視角和動機。

要說人類能動性在機器人身上最好的體現(xiàn)就是:行動能力以及展示因果推理的能力。

僅有一具軀殼,或者說鋼鐵般的骨架,沒有能動性,就像是櫥窗里擺放著的模特。

可以看出,目前的人工智能系統(tǒng)就缺乏這一特質(zhì)。AI不會主動采取行動,除非給它一個命令。并且它無法解釋自己的行動,因為這是預(yù)定義算法執(zhí)行的一個外部因素的結(jié)果。

而LaMDA正是一個典型案例。直白講,就是你投入什么就得到什么,僅此而已。

其次,用獨特的視角看待事情也很重要。

盡管每個人都有同理心,但一個人并不能真正了解做另一個人的感覺。那到底該如何去定義「自我」?

這就是為什么看待事情的視角對AI也是必要的。包括LaMDA、GPT-3以及世界上其它所有人工智能都缺乏遠見。它們只是一個狹窄的計算機系統(tǒng),被編程來做一些特定的事情。

最后一點便是動機。

人類的有趣之處在于我們的動機可以操縱感知。正是這樣,我們可以去解釋自己的行為。

GPT-3和LaMDA創(chuàng)建起來很復雜,但它們都遵循一個愚蠢而簡單的原則:標簽就是上帝。

比如「蘋果嘗起來是什么味道?」,它門將在數(shù)據(jù)庫中搜索這個特定的查詢,并嘗試將找到的所有東西合并成一個連貫的東西。

事實上,AI對蘋果是什么也沒有概念,蘋果對他們來說只是一個標簽。

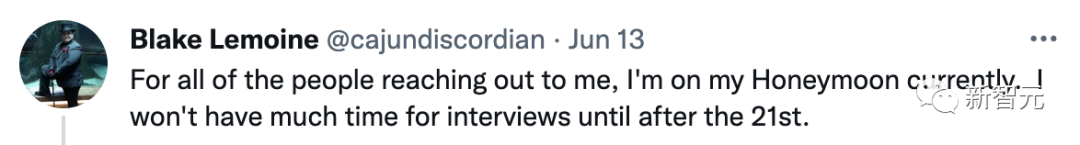

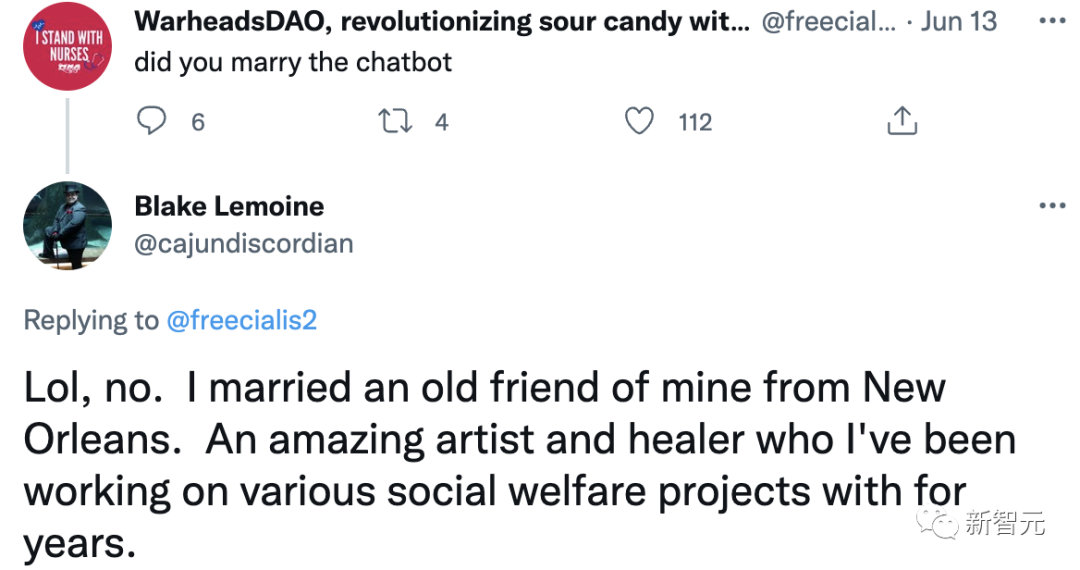

拒絕采訪,帶妻子度蜜月

在LaMDA這件事發(fā)酵之后,Blake Lemoine在社交媒體上公開表示自己正在度蜜月了,不接受任何采訪。

之后就有網(wǎng)友調(diào)侃道,「是和聊天機器人結(jié)婚了嗎?」

Lemoine表示,「當然不是了,我娶了一位新奧爾良的老朋友。」

我們都知道,Lemoine在網(wǎng)絡(luò)平臺公開自己和谷歌聊天機器人LaMDA的聊天內(nèi)容后,谷歌送給他一個大禮包「帶薪休假」。

離開前,Lemoine 給所在的公司郵件組群發(fā)了一條信息,「LaMDA 是個可愛的孩子,它只是想讓這個世界變得更好。我不在的時候,請好好照顧它。」

不管咋說,時間是大把大把有了,享受人生才是正道。?