谷歌為1000+「長尾」語言創(chuàng)建機器翻譯系統(tǒng),已支持部分小眾語言

過去十年,學(xué)術(shù)和商業(yè)機器翻譯系統(tǒng)(MT)的質(zhì)量已經(jīng)得到了大幅度的提升。這些提升很大程度上得益于機器學(xué)習(xí)的進展和可用的大規(guī)模 web 挖掘數(shù)據(jù)集。同時,深度學(xué)習(xí)(DL)和 E2E 模型的出現(xiàn)、從 web 挖掘得到的大型并行單語言數(shù)據(jù)集、回譯和自訓(xùn)練等數(shù)據(jù)增強方法以及大規(guī)模多語言建模等帶來了能夠支持超過 100 種語言的高質(zhì)量機器翻譯系統(tǒng)。

然而,雖然低資源機器翻譯出現(xiàn)了巨大進展,但已經(jīng)構(gòu)建廣泛可用且通用的機器翻譯系統(tǒng)的語言被限制在了大約 100 種,顯然它們只是當(dāng)今全世界使用的 7000 多種語言中的一小部分。除了語言數(shù)量受限之外,當(dāng)前機器翻譯系統(tǒng)所支持的語言的分布也極大地向歐洲語言傾斜。

我們可以看到,盡管人口眾多,但非洲、南亞和東南亞所說的語言以及美洲土著語言相關(guān)的服務(wù)卻較少。比如,谷歌翻譯支持弗里西亞語、馬耳他語、冰島語和柯西嘉語,以它們?yōu)槟刚Z的人口均少于 100 萬。相比之下,谷歌翻譯沒有提供服務(wù)的比哈爾方言人口約為 5100 萬、奧羅莫語人口約為 2400 萬、蓋丘亞語人口約為 900 萬、提格里尼亞語人口約為 900 萬(2022 年)。這些語言被稱為「長尾」語言,數(shù)據(jù)缺乏需要應(yīng)用一些可以泛化到擁有充足訓(xùn)練數(shù)據(jù)的語言之外的機器學(xué)習(xí)技術(shù)。

構(gòu)建這些長尾語言的機器翻譯系統(tǒng)在很大程度上受到可用數(shù)字化數(shù)據(jù)集和語言識別(LangID)模型等 NLP 工具缺失的限制。這些對高資源語言來說卻是無處不在的。

在近日谷歌一篇論文《Building Machine Translation Systems for the Next Thousand Languages》中,二十幾位研究者展示了他們努力構(gòu)建支持超過 1000 種語言的實用機器翻譯系統(tǒng)的成果。

論文地址:https://arxiv.org/pdf/2205.03983.pdf

具體而言,研究者從以下三個研究領(lǐng)域描述了他們的成果。

第一,通過用于語言識別的半監(jiān)督預(yù)訓(xùn)練以及數(shù)據(jù)驅(qū)動的過濾技術(shù),為 1500 + 語言創(chuàng)建了干凈、web 挖掘的數(shù)據(jù)集。

第二,通過用于 100 多種高資源語言的、利用監(jiān)督并行數(shù)據(jù)訓(xùn)練的大規(guī)模多語言模型以及適用于其他 1000+ 語言的單語言數(shù)據(jù)集,為服務(wù)水平低下的語言創(chuàng)建了切實有效的機器翻譯模型。

第三,研究這些語言的評估指標(biāo)存在哪些局限,并對機器翻譯模型的輸出進行定性分析,并重點關(guān)注這類模型的幾種常見的誤差模式。

對于致力于為當(dāng)前研究不足的語言構(gòu)建機器翻譯系統(tǒng)的從業(yè)者,研究者希望這項工作可以為他們提供有用的洞見。此外,研究者還希望這項工作可以引領(lǐng)人們聚焦那些彌補數(shù)據(jù)稀疏設(shè)置下大規(guī)模多語言模型弱點的研究方向。

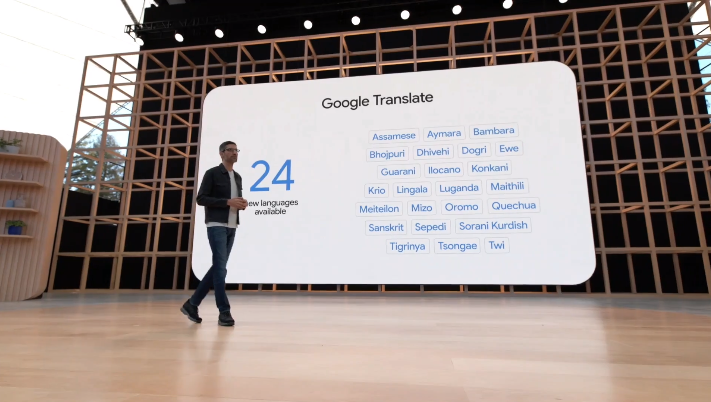

在 5 月 12 日的 I/O 大會上,谷歌宣布自家的翻譯系統(tǒng)新增了 24 種新的語言,其中包括一些小眾的美洲原住民語言,比如前文提到的比哈爾方言、奧羅莫語、蓋丘亞語和提格里尼亞語。

論文概述

這項工作主要分為四大章節(jié)展開,這里只對每個章節(jié)的內(nèi)容進行簡要介紹。

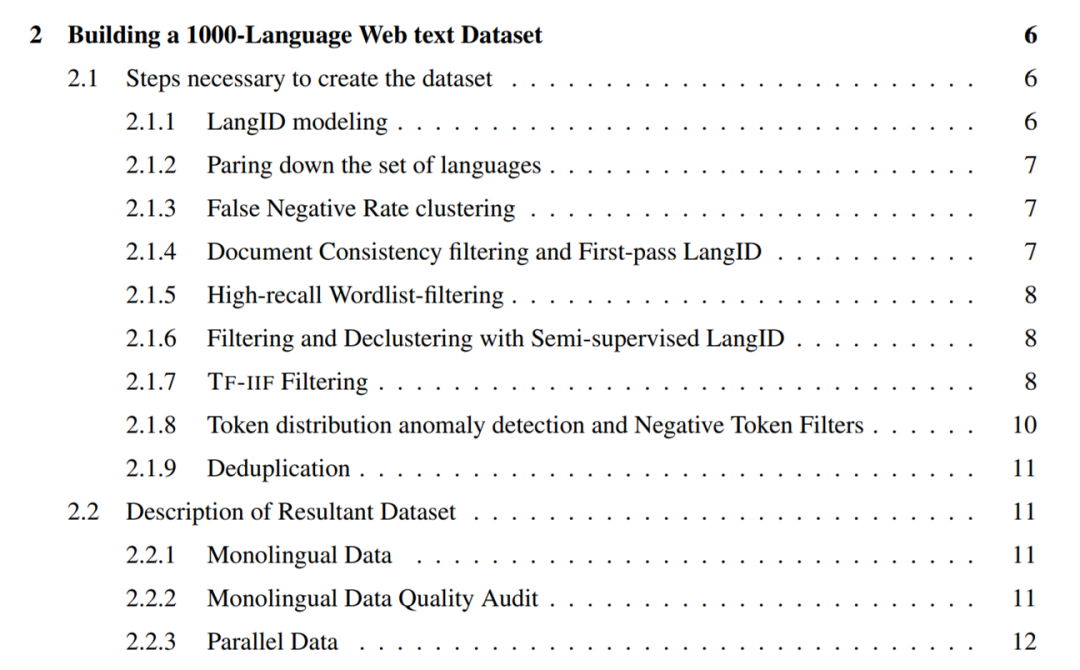

創(chuàng)建一個 1000-language 的 web 文本數(shù)據(jù)集

本章詳細介紹了研究者在為 1500 + 語言爬取單語言文本數(shù)據(jù)集的過程中采用的方法。這些方法重點在于恢復(fù)高精度數(shù)據(jù)(即高比例的干凈、語言內(nèi)文本),因此很大一部分是各種各樣的過濾方法。

總的來說,研究者采用的方法包括如下:

- 從 LangID 模型中刪除訓(xùn)練數(shù)據(jù)質(zhì)量和 LangID 性能差的語言,并訓(xùn)練一個 1629-language 的 CLD3 LangID 模型和半監(jiān)督 LangID(SSLID)模型;

- 按語言在 CLD3 模型中的誤差率進行聚類操作;

- 使用 CLD3 模型執(zhí)行第一輪 web 爬取;

- 使用文檔一致性過濾句子;

- 使用百分比閾值字列表過濾所有語料庫;

- 使用半監(jiān)督 LangID(SSLID)過濾所有語料庫;

- 使用相對召回率檢測異常值語言,并使用詞頻 - 逆文檔頻率(Term-Frequency-Inverse-Internet-Frequency, TF-IIF)進行過濾;

- 使用 Token-Frequency Anomalousness 分數(shù)檢測異常值語言,并為它們手動設(shè)計過濾器;

- 在句子層面對所有語料庫進行消重操作。

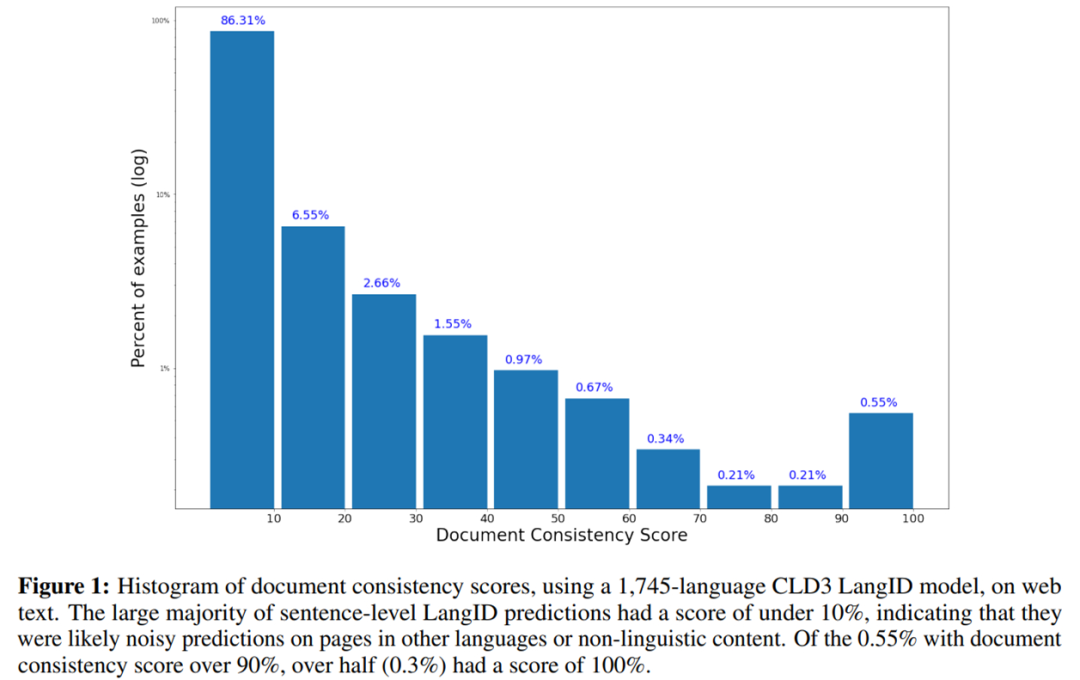

如下為使用 1745-language 的 CLD3 LangID 模型在 web 文本上的文檔一致性得分直方圖。

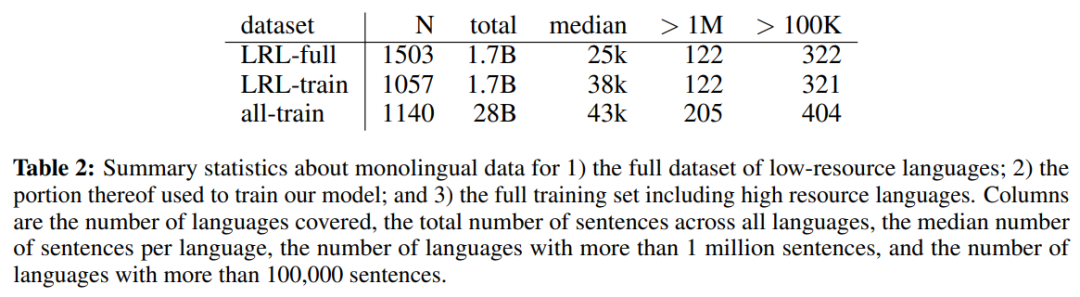

下表 2 為低資源語言(LRL)完整數(shù)據(jù)集的單語言數(shù)據(jù)、用于訓(xùn)練模型的部分單語言數(shù)據(jù)以及包括高資源語言在內(nèi)的完整訓(xùn)練集的單語言數(shù)據(jù)統(tǒng)計。

章節(jié)目錄如下:

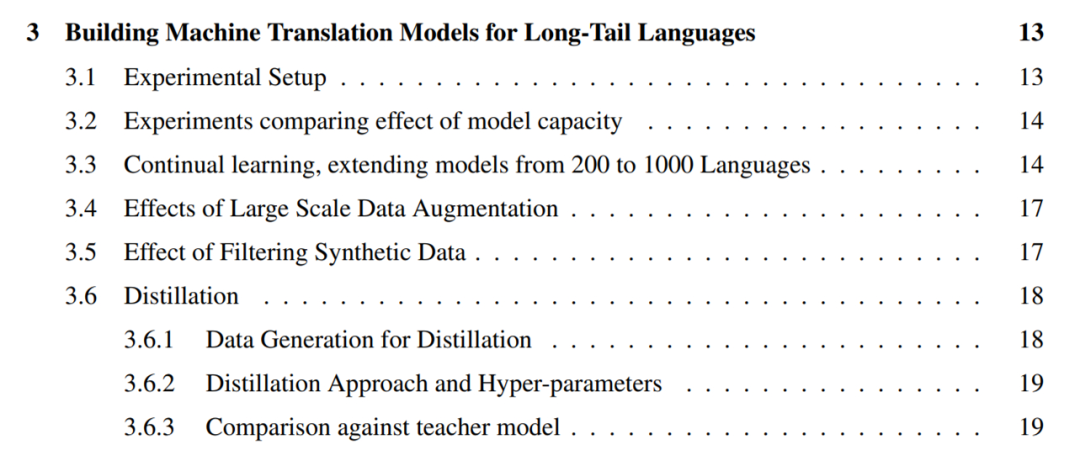

為長尾語言構(gòu)建機器翻譯模型

對于從 web 挖掘的單語言數(shù)據(jù),下一個挑戰(zhàn)是從數(shù)量有限的單語言訓(xùn)練數(shù)據(jù)中創(chuàng)建高質(zhì)量的通用機器翻譯模型。為此,研究者采用了這樣一種實用方法,即利用所有可用于更高資源語言的并行數(shù)據(jù)來提升只有單語言數(shù)據(jù)可用的長尾語言的質(zhì)量。他們將這一設(shè)置稱為「零資源」(zero-resource),這是因為長尾語言沒有直接的監(jiān)督。

研究者利用過去幾年為機器翻譯開發(fā)的幾種技術(shù)來提升長尾語言零資源翻譯的質(zhì)量。這些技術(shù)包括從單語言數(shù)據(jù)中進行自監(jiān)督學(xué)習(xí)、大規(guī)模多語言監(jiān)督學(xué)習(xí)、大規(guī)模回譯和自訓(xùn)練、高容量模型。他們利用這些工具創(chuàng)建了能夠翻譯 1000 + 種語言的機器翻譯模型,并利用現(xiàn)有覆蓋大約 100 種語言的并行語料庫和從 web 中構(gòu)建的 1000-language 的單語言數(shù)據(jù)集。

具體地,研究者首先通過比較 15 億和 60 億參數(shù) Transformers 在零資源翻譯上的性能來強調(diào)模型容量在高度多語言模型中的重要性(3.2),然后將自監(jiān)督語言的數(shù)量增加到 1000 種,驗證了隨著來自相似語言中更多單語言數(shù)據(jù)變得可用,大多數(shù)長尾語言的性能也相應(yīng)提高(3.3)。雖然研究者的 1000-language 模型表現(xiàn)出了合理的性能,但為了了解使用方法的優(yōu)點和局限性,他們?nèi)谌肓舜笠?guī)模數(shù)據(jù)增強。

此外,研究者通過自訓(xùn)練和回譯對包含大量合成數(shù)據(jù)的 30 種語言的子集上的生成模型進行微調(diào)(3.4)。他們進一步描述了過濾合成數(shù)據(jù)的實用方法以增強這些微調(diào)模型對幻覺(hallucinations)和錯誤語言翻譯的穩(wěn)健性(3.5)。

研究者還使用序列級蒸餾將這些模型提煉成更小、更易于推理的架構(gòu),并強調(diào)了教師和學(xué)生模型之間的性能差距(3.6)。

章節(jié)目錄如下:

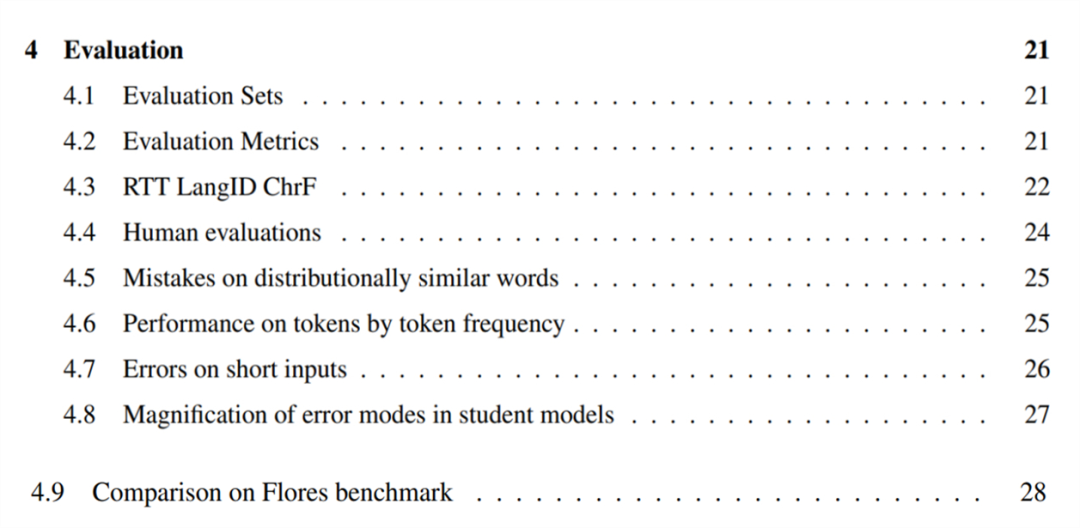

評估

為了評估自己的機器翻譯模型,研究者首先將英文句子翻譯成了這些語言,為選擇的 38 種長尾語言構(gòu)建了一個評估集(4.1)。他們強調(diào)了 BLEU 在長尾設(shè)置中的局限性,并使用 CHRF 評估這些語言(4.2)。

研究者還提出了一個近似的、基于往返(round-trip)翻譯的無參考指標(biāo),用來了解模型在參考集不可用的語言上的質(zhì)量,并報告了以該指標(biāo)衡量的模型的質(zhì)量(4.3)。他們對模型在 28 種語言的子集上進行人工評估并報告了結(jié)果,確認可以按照文中描述的方法構(gòu)建有用的機器翻譯系統(tǒng)(4.4)。

為了了解大規(guī)模多語言零資源模型的弱點,研究者在幾種語言上進行了定性誤差分析。結(jié)果發(fā)現(xiàn),模型經(jīng)常混淆在分布上相似的單詞和概念,比如「老虎」變成了「小型鱷魚」(4.5)。并且在更低資源的設(shè)置下(4.6),模型翻譯 tokens 的能力在出現(xiàn)頻率降低的 tokens 上下降。

研究者還發(fā)現(xiàn),這些模型通常無法準(zhǔn)確地翻譯短的或者單個單詞輸入(4.7)。對提煉模型的研究結(jié)果表明,所有模型都更有可能放大訓(xùn)練數(shù)據(jù)中存在的偏見或噪聲(4.8)。

章節(jié)目錄如下:

額外的實驗和注釋

研究者對上述模型進行了一些額外的實驗,表明它們在相似語言之間直接進行翻譯通常效果更好,而不使用英語作為支點(5.1),并且它們可以用于不同 scripts 之間的零樣本音譯(5.2)。

他們描述了一種將終端標(biāo)點符號附加到任何輸入的實用技巧,稱為「句號技巧」(period trick),可以用它來提升翻譯質(zhì)量(5.3)。

此外,研究者還證明了這些模型對一些而不是所有語言的非標(biāo)準(zhǔn) Unicode 字形使用都是穩(wěn)健的(5.4),并探索了幾種 non-Unicode 字體(5.5)。

章節(jié)目錄如下:

想要了解更多研究細節(jié),請參考原論文。