單張GPU搞定GPT-3超參數!先訓練小模型,再“一鍵遷移”

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

不不不,現在情況有變——

在單個GPU上完全可以調整大規模模型的超參數。

怎么說?

原來有人發現了一種新的調參方法,無論模型規模怎么變化,所得的最優超參數都能保持性能穩定。

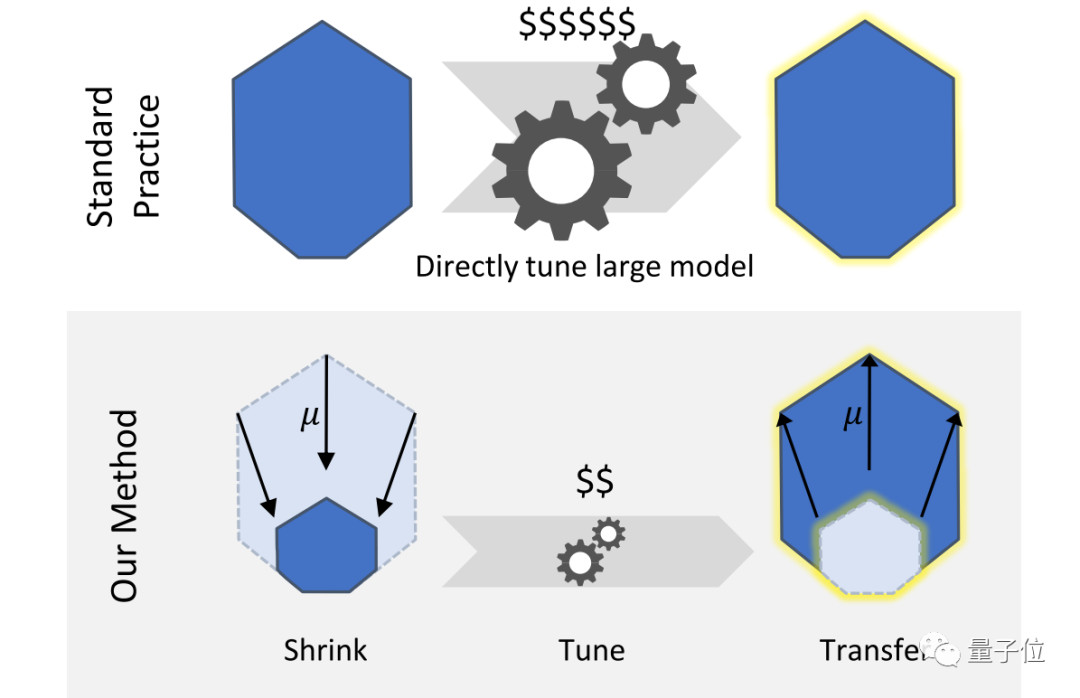

由此一來,我們可以先訓練一個小版本的模型,在上面間接調整好超參,然后以零樣本的方式直接將它們復制到全尺寸模型上,就能獲得相當不錯的性能。

這對手里GPU資源不夠的人來說簡直不要太好了吧。

目前,相關帖子也在Reddit上引起熱議,得到了300+的點贊支持。

在一個GPU上調參GPT-3大模型

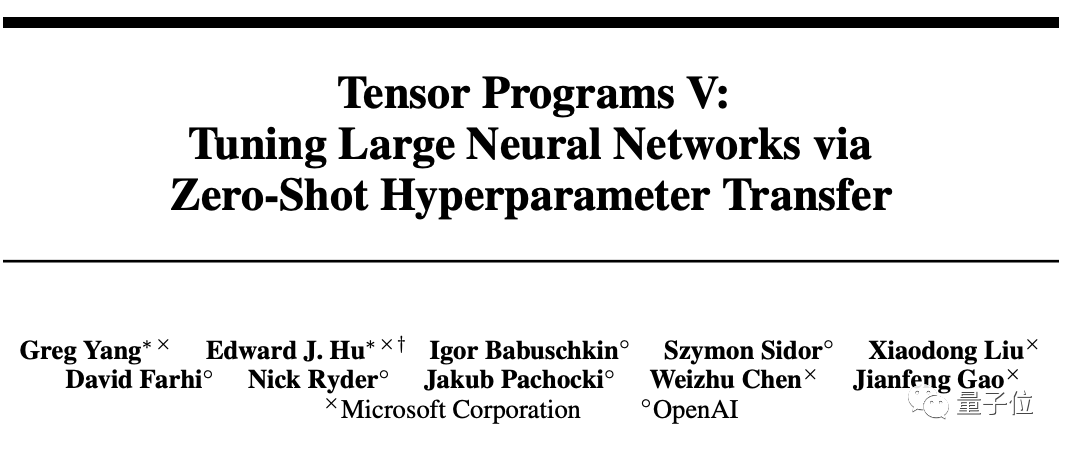

方法名叫muP (Maximal Update Parametrization),作者分別來自微軟和OpenAI。

想法很簡單,利用的是他們在之前的工作中發現的一個叫做μP的特殊參數化思路:

窄神經網絡和寬神經網絡共享同一組最優超參數,即使寬度無限大(width->∞)時也一樣。

具體原理可以參見論文《Feature Learning in Infinite-Width Neural Networks》。

可共享的超參數包括學習率learning rate、learning rate schedule、initialization、parameter multipliers……甚至可以單獨針對每個參數張量。

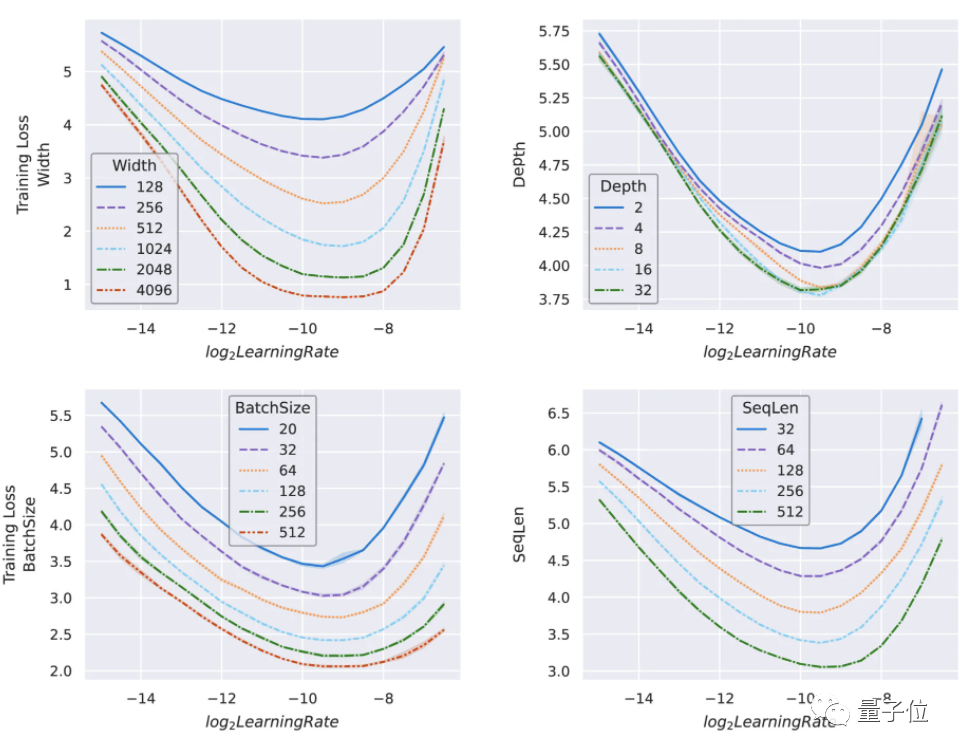

作者在寬度高達4096的Transformer以及ResNet上驗證了這一結論。

因此,資源匱乏的煉丹er就可以在單張GPU上對一個小版本的GPT-3模型進行超參數調整:

如果在這個小模型上得到的參數接近最優,那么在大模型上也可以得到一樣的結果。

ps. 這種調參方式又被命名為“μ遷移(μTransfer)”。

具體效果如何?

作者訓練了一個只有4000萬參數規模的小型GPT-3,它小到可以直接跑在一張GPU上。

然后把它的超參數“μ遷移”到一個有67億參數的大規模GPT-3上,結果發現它的性能和原始的GPT-3完全相當——盡管原GPT-3的參數規模還是它的兩倍!

而這一調整成本只占整個預訓練成本的7%。

由于模型規模增大,直接調整小型模型的成本仍大致相同,如果用該方式來調參175億規模的GPT-3,其成本可能最多只有總預訓練成本的0.3%。

好了,這時你可能會問:能不能只縮小模型的寬度呢?

作者表示,對于“non-width stuff”,沒有理論保證。

不過好消息是,他們在preLN Transformer的合理范圍內對depth、batch size、sequence length和timestep的遷移效果進行了測試。

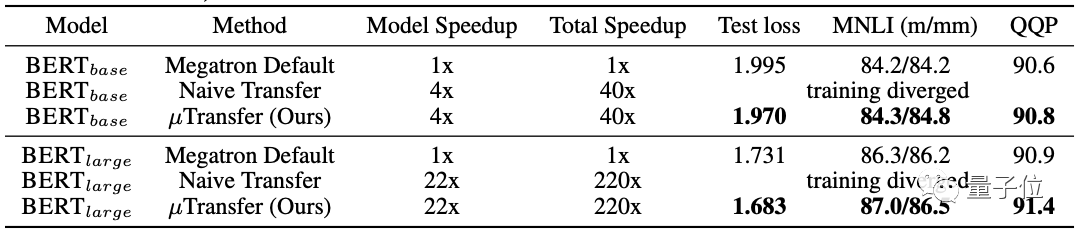

其中,他們將BERT-base和BERT-large在寬度和深度上縮小到同樣的規模, 然后同時進行超參數調整后發現:

相比已經調優的megatron BERT基線,兩者的性能都得到了改善,尤其是BERT-large提升更大。

由此也總結出一個道理:

遷移后的模型規模越大,收益越高。

所以作者還調侃道,雖然我們沒有測試175億規模的GPT-3,但保證結果能讓你“流口水”。

說了這么多,到底如何實現?

下表概括了如何通過fan-in或fan-out調整你的模型的initialization和learning rate。

其中粉色文本為μP,括號中的灰色文本為pytorch默認值。

當然,如果你不想自己手動操作,作者也開源了Pytorch實現,通過pip install mup就可以應用到你的模型中。

關于作者

一作名叫Greg Yang,微軟高級研究員。

通訊作者為微軟研究院深度學習技術中心合伙人研究經理、IEEE Fellow高劍峰。

還有兩位華人作者分別為來自微軟的Liu Xiaodong(北京郵電大學校友)和Chen Weizhu (已在微軟工作16年)。

他們的這篇成果已被NeurIPS 2021接收。

GitHub鏈接:

??https://github.com/microsoft/mup??

論文地址:

??https://arxiv.org/abs/2203.03466??