CVPR 2021發表視頻慢動作的新sota,還發了160FPS的數據集

把視頻變慢動作你可能會想到插幀的方法,但這種方法無法處理高速運動的物體,可能會導致模糊、過曝等問題!華為在CVPR2021發表了一篇文章,同時使用事件相機和普通相機進行插幀,畫質提升到新高度!

如何把一段正常的視頻變慢?

常見的方法就是插幀,在視頻的關鍵幀之間預測圖像中的物體運動狀態生成中間幀。

在缺少額外信息的情況下,必須借助光流(optical flow)進行一階近似(first-order approximations),但這種方法能夠建模的物體運動類型比較少,從而可能導致在高度動態的場景下插幀錯誤的情況。

事件相機(event camera)是一種新型傳感器,可以通過在幀間的盲時間(blind-time)內提供輔助視覺信息來解決這一限制。通過異步測量每個像素亮度的變化,事件相機能夠以高時間分辨率(temporal resolution)和低延遲來實現這種效果。

事件相機不同于傳統相機拍攝一幅完整的圖像,事件相機主要拍攝的是事件,可以理解為像素亮度的變化就是一個事件。

傳統相機的拍攝過程需要一個曝光時間,這個幀率極大的限制了事件捕獲的延遲,即便幀率達到1000Hz,仍然存在1ms的延遲,對于拍攝慢動作來說這個延遲已經很高了。如果物體存在高速運動,就會產生模糊。

并且過曝現象也比較常見,在光線極差或者亮度極高時,相機獲取的信息有限,丟失了應有的細節。

事件相機從硬件的設計上來解決上述問題,它的原理就是當某個像素的亮度變化累計達到一定閾值后,輸出一個事件,這個閾值是相機的固有參數。

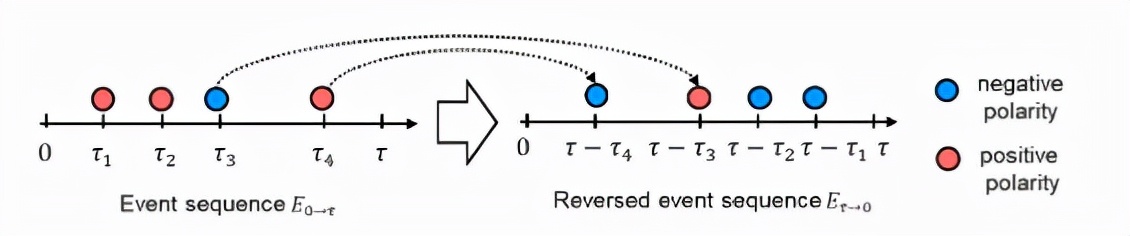

事件相機中的事件具有三要素:時間戳、像素坐標與極性,也就是在什么時間,哪個像素點,發生了亮度的增加或減小。

當場景中由物體運動或光照改變造成大量像素變化時,會產生一系列的事件,這些事件以事件流(Events stream)方式輸出。事件流的數據量遠小于傳統相機傳輸的數據,且事件流沒有最小時間單位,所以可以做到非常低的延遲。

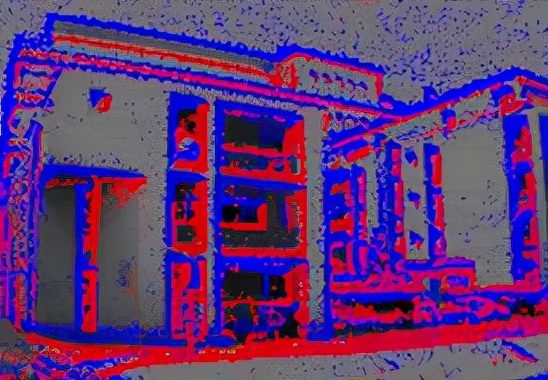

在事件相機眼中,世界只有明暗的變化,如下圖紅色和藍色分別表示當前像素亮度的增加或減小,也是一組事件流積累獲得的一組事件。

事件相機具有低延遲(<)、高動態范圍()、極低功耗()等特性。

然而事件相機也并非萬能,雖然這些方法可以捕捉非線性運動,但它們會受到重影的影響,并且在事件較少的低紋理區域中表現不好。

所以基于合成和基于流的方法應當是互補而非對立的。

針對這個問題,華為技術(Huawei Technologies)在蘇黎世的研究中心研究院在CVPR 2021 上發表了一篇文章,介紹了一個新模型Time Lens,能夠同時利用兩種相機的優點。

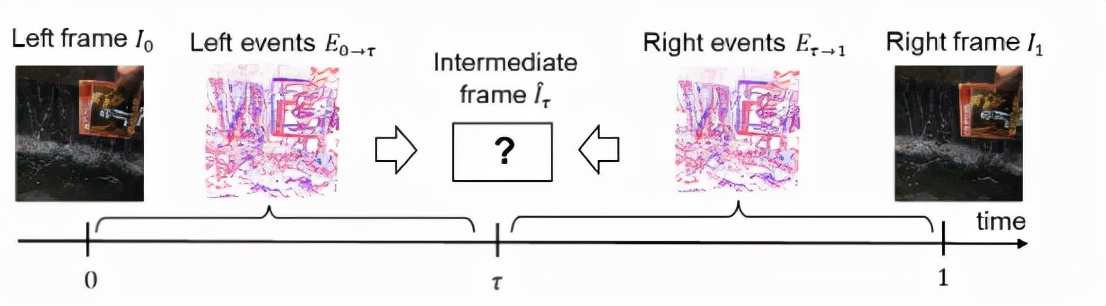

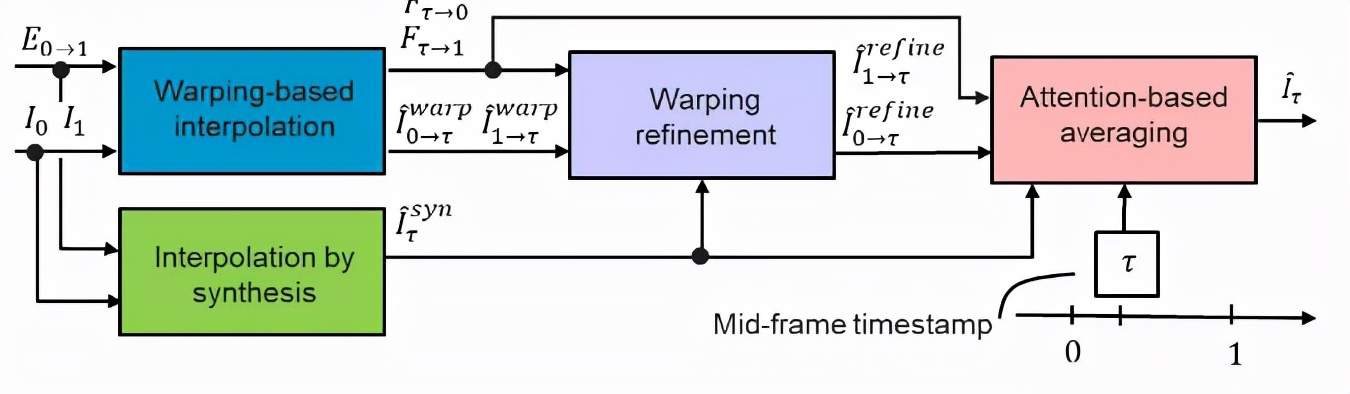

Time Lens是一個基于學習的框架,由四個專用模塊組成,這些模塊互相之間可以進行補充插值,能夠同時進行基于warping和合成的插值。

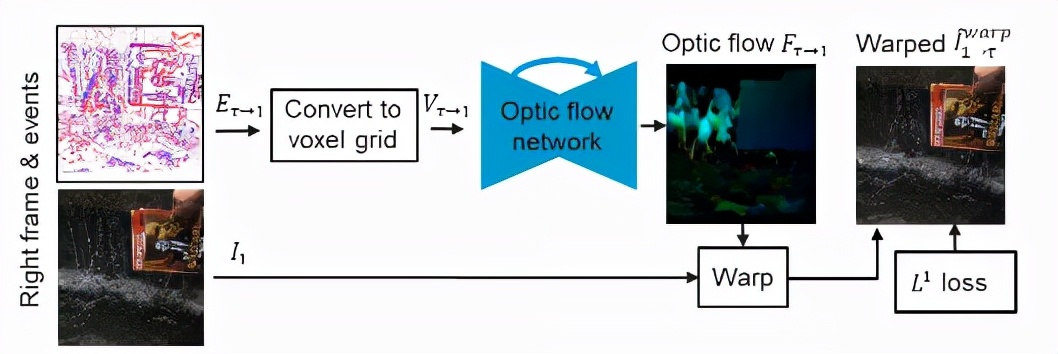

1、基于warping的插值模塊(Interpolation by synthesis),通過使用從各個事件序列估計的光流warping邊界RGB關鍵幀來估計新幀;

首先通過反轉事件序列,分別使用事件的邊界關鍵幀I0和I1之間的新幀估計光流。使用計算出的光流,使用可微干涉在時間步長τ中warping邊界關鍵幀,從而產生兩個新的幀估計值。

與傳統基于warping的插值方法主要區別在于后者使用幀本身計算關鍵幀之間的光流,然后使用線性運動假設近似潛在中間幀和邊界之間的光流。當幀之間的運動是非線性的且關鍵幀受到運動模糊的影響時,此方法不起作用。

相比之下,論文的方法計算來自事件的光流,因此可以自然地處理模糊和非線性運動。盡管事件是稀疏的,但只要產生的流足夠密集,尤其是在具有主要運動的紋理區域就很有效,這對于插值也最為重要。

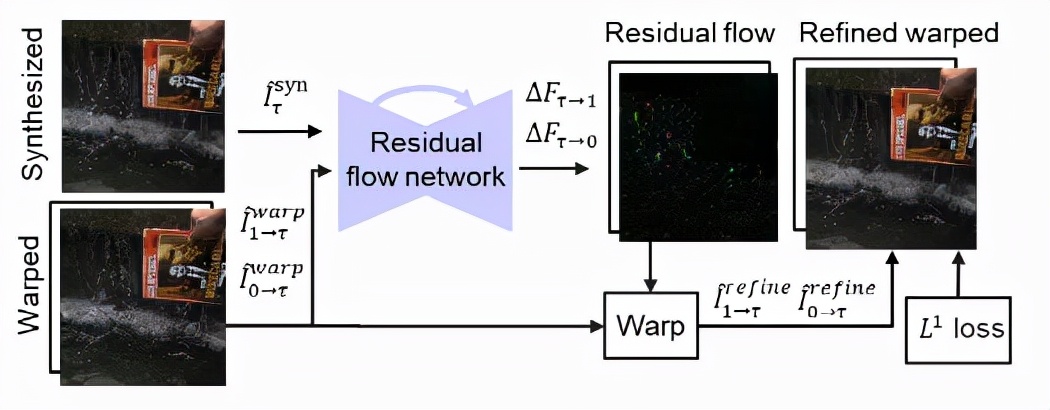

2、warping refinement模塊通過計算剩余光流來改進這種幀估計;

通過估算剩余光流,細化模塊能夠基于warping之間的插值結果計算細化的插入幀。然后通過估計的剩余光流再次測量τ。細化模塊的靈感來源于光流和奇偶性細化模塊的有效性,也來源于研究人員觀察到的合成插值結果通常與實際標注真值新框架完全一致。除了計算剩余流外,warping細化模塊還通過填充對值附近的阻塞區域進行修復。

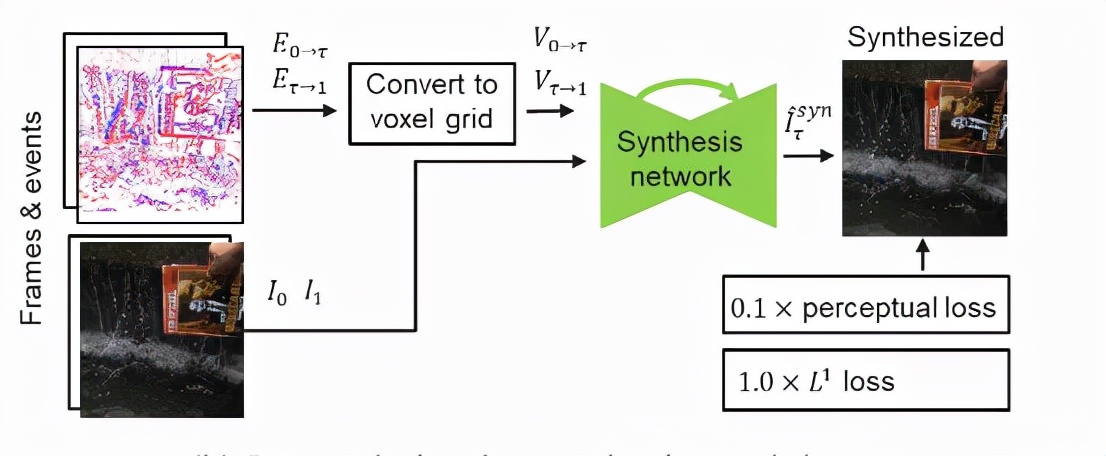

3、合成插值模塊通過直接融合來自邊界關鍵幀和事件序列的輸入信息來估計新幀;

在給定左幀I0和右幀I1的RGB關鍵幀和事件序列E0的情況下,直接回歸新幀。該插值方案的優點在于處理照明變化的能力,如水反射和場景中新對象的突然出現都能有效處理。與基于warping的方法不同,它不依賴于亮度恒定性假設。但主要缺點是,當事件信息因高對比度閾值而有噪聲或不足時,圖像邊緣和紋理會失真。

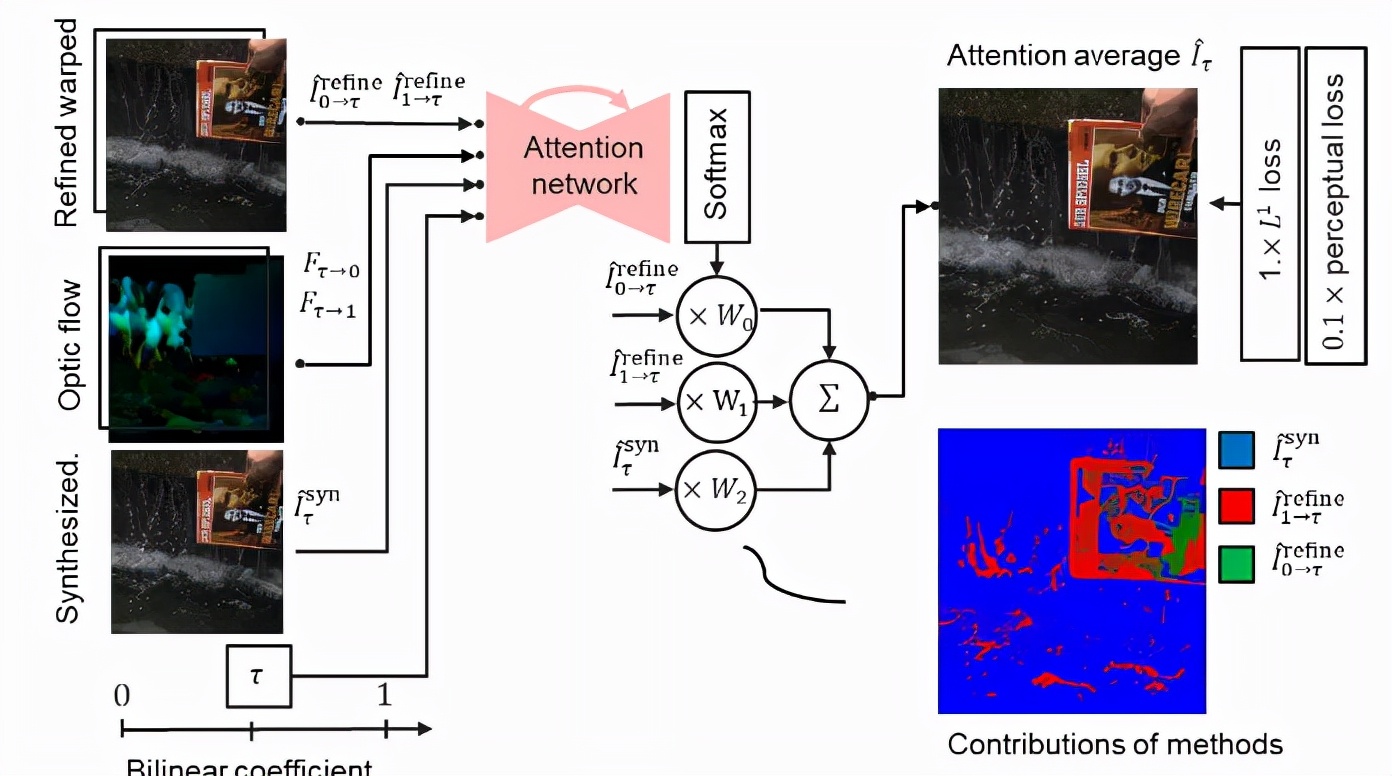

4、基于注意力的平均模塊結合了基于warping和基于合成的插值結果。

注意力平均模塊,以像素方式混合合成和基于warping的插值結果來獲得最終插值結果。利用基于warping和合成的插值方法的互補性,其PSNR比兩種方法的結果高1.73 dB。

其他的研究使用了類似的策略,但是這些工作僅混合了基于warping的插值結果以填充遮擋區域,而這篇論文中混合了基于warping和合成的結果,因此也可以處理光線變化。使用一個以插值結果為輸入的張力網絡來估計混合系數,光流結果和雙線性系數τ取決于新幀作為具有常量值的通道的位置。

Time Lens的框架能夠使生成的插入幀成為具有顏色和高紋理細節的新幀,同時能夠處理非線性運動、光線變化和運動模糊。在整個工作流中,所有的模塊都使用相同的骨架結構沙漏網絡(hourglass network),沙漏網絡能夠在收縮和擴張部分之間進行跳躍連接(skip connections)。

在用于編碼事件序列的學習表示時,所有模塊都使用voxel grid表示。

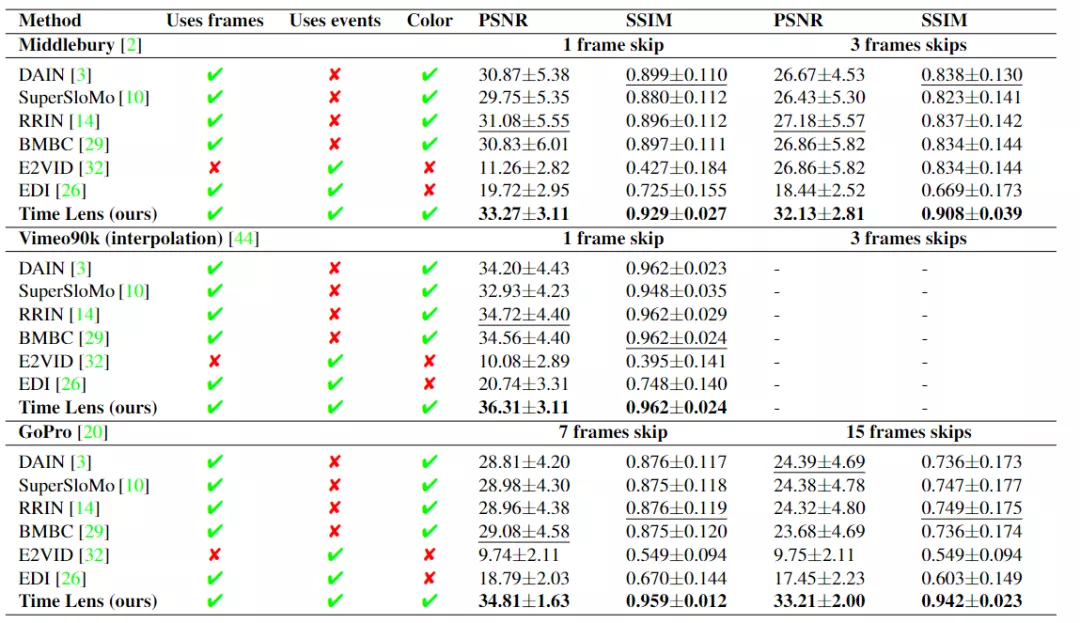

在三個合成基準和兩個真實基準上對的方法進行評估后,實驗結果顯示,與最先進的基于幀和基于事件的方法相比,PSNR指標提高了5.21 dB,畫質有所提升。

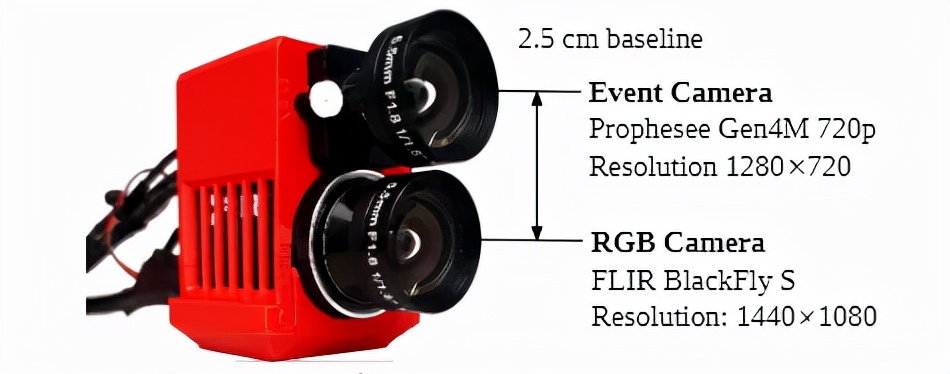

除此之外,研究人員還在高動態的場景中發布了一個新的大規模數據集,使用一個事件相機和RGB相機同時拍攝,記錄室內和室外各種條件下的數據。序列記錄在室外的曝光時間低至100μs,在室內曝光時間為1000μs。

該數據集的幀速率為160 FPS,相比以往的數據集要高得多,并且使用真實彩色幀創建更大的跳幀。該數據集包括具有非線性運動的高度動態近距離場景和主要以cam時代自我運動為特征的遠距離場景。

對于遙遠的場景,立體校正足以實現良好的每像素對齊。對于每個序列,根據深度通過立體校正或使用基于特征的單應估計來執行對齊。在RGB圖像和E2VID重建之間執行標準立體校準,并相應地校正圖像和事件。對于動態近景,還通過匹配這兩個圖像之間的SIFT特征來估計全局同調。