黑人被標記為靈長類動物,Facebook致歉,推薦功能已禁用

近日,有 Facebook 用戶在觀看一段以黑人為主角的視頻時收到推薦提示:詢問他們是否愿意「繼續觀看有關靈長類動物的視頻」。該視頻是由《每日郵報》在 2020 年 6 月 27 日發布的,其中包含黑人與白人平民和警察發生爭執的片段,并且視頻內容與靈長類動物無關。目前,Facebook 已禁用該人工智能推薦功能。

據《紐約時報》報道,Facebook 已在上周五為其「不可接受的錯誤」道歉,并表示正在調查其推薦功能,防止這種情況再次發生。

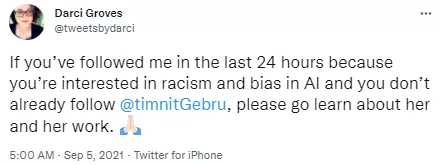

針對此事,前 Facebook 內容設計經理 Darci Groves 在推特上發出該推薦提示截圖,并表示這令人無法接受。Groves 還將其發布到一個面向 Facebook 現任和前任員工的產品反饋論壇。作為回應,Facebook 視頻平臺 Facebook Watch 的產品經理稱其「不可接受」,并表示該公司正在「調查根本原因」。

Facebook 擁有世界上最大的用戶上傳圖像存儲庫之一,用于訓練其面部和對象識別算法。Facebook 發言人 Dani Lever 在一份聲明中表示:「盡管我們對人工智能進行了改進,但我們知道它并不完美,我們還有很多改進要做。我們向任何可能看到這些冒犯性推薦信息的人道歉。」

毫無疑問,此次推薦信息的錯誤折射出的是 AI 系統存在的偏見。

偏見問題,不是個例

多年來,谷歌、亞馬遜等多家科技公司都曾因其人工智能系統中存在的偏見,尤其是種族問題而受到審查。有研究表明面部識別技術因存在種族偏見導致識別困難,甚至曾有報道稱黑人因 AI 存在的問題而受到歧視或被捕。

2015 年,Google Photos 將兩位黑人的照片標記為「大猩猩(Gorillas)」,谷歌當即深表歉意,并表示將立即解決問題。然而兩年后,《Wired》雜志發現谷歌的解決方案僅僅是防止將任何圖片標記為大猩猩、黑猩猩或猴子。隨后谷歌證實,無法識別大猩猩和猴子是因為 2015 年將黑人識別為大猩猩事件發生后,為了解決這一錯誤,谷歌直接從搜索結果中刪除了這一詞條的標簽。

圖源:https://www.reddit.com/r/MachineLearning/comments/3brpre/with_results_this_good_its_no_wonder_why_google/

被證實「只是刪除標簽」后谷歌表示:「圖像標簽技術的發展仍處于早期階段,不幸的是這項技術離完美還差得很遠。」

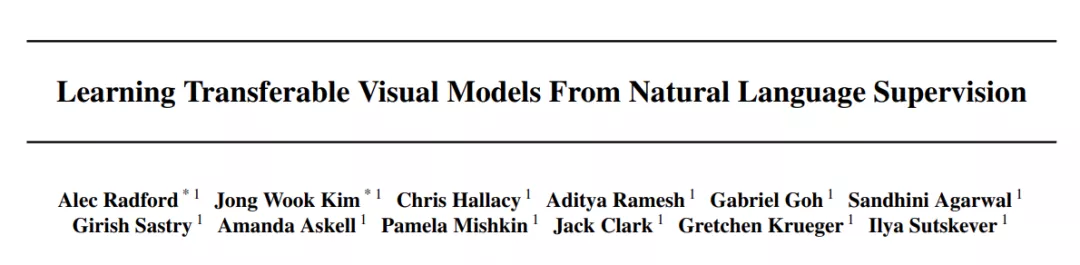

在 OpenAI 一篇名為《Learning Transferable Visual Models From Natural Language Supervision》的研究論文中 ,研究者發現一些 AI 系統會將 4.9%(置信區間為 4.6%-5.4% )的圖像錯誤地分類為非人類類別之一,包括「動物」、「黑猩猩」等 . 其中,「黑人」圖像的誤分類率最高,約為 14%,而所有其他種族的誤分類率均低于 8%。

論文地址:https://cdn.openai.com/papers/Learning_Transferable_Visual_Models_From_Natural_Language.pdf

實際上,AI 領域的偏見問題并不是個例。2020 年年底谷歌開除「倫理 AI 團隊」技術聯合負責人 Timnit Gebru 的事件引發了一場討論風暴。就在昨日,Darci Groves 還在推特上發聲支持 Timnit Gebru 及其研究工作。

偏見事件的陸續發生讓人們開始思考問題的根源,越來越多的研究者為了解決 AI 系統的偏見問題做出了努力。例如,MIT 的研究者曾經開發一種可調的算法來減少訓練數據中隱藏的潛在偏見,并用該算法來解決面部檢測系統中的種族和性別偏見問題。此外,機器學習作為一種數據驅動系統,數據及其標注的質量和公平性可能還有很長的路要走。