深度學習有時會犯一些奇怪的錯誤

深度學習可以是驚人的強大,但它也可能會犯任何人都不會犯的令人驚訝的錯誤。

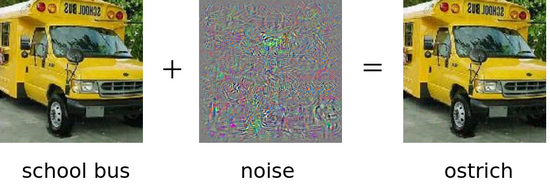

當計算機視覺開始騰飛時,人們觀察到基于深度學習的圖像分類器有點反復無常。例如,圖像分類器可能會正確識別校車的圖片,但當包含少量噪音(精心選擇以混淆算法)時,可能會將其誤認為鴕鳥。

深度學習有時也能看到根本沒有的東西。一組研究人員設計了一種生成圖像的方法,即使圖像實際上只由波浪線或其他抽象圖案組成,計算機視覺算法也會將其歸類為熟悉的對象,并具有非常高的置信度。

當計算機視覺應用于現(xiàn)實世界時,也會出現(xiàn)這樣的問題。通過在交通標志上貼上小的彩色補丁,可以使計算機視覺算法將停車標志誤認為限速標志。

這個問題并不局限于計算機視覺。亞馬遜在評估求職者的實驗性計算機程序–歐元™簡歷中注意到了這一點。在開發(fā)團隊注意到該程序不是基于描述應聘者™實際工作經(jīng)驗的詞語做出決定后,該實驗被關閉。相反,男性工程師傾向于按比例比女性更頻繁地使用不相關的詞匯。從本質上說,該項目已經(jīng)學會了預測應聘者™的性別,而不是是否適合這份工作。這種偏見之所以出現(xiàn),是因為該系統(tǒng)過去接受過關于提交給公司的簡歷的培訓,而且男性申請和被聘用到工程職位的次數(shù)比女性更多。

為什么計算機會犯愚蠢的錯誤?

當一張基本相同的復制品被誤認為鴕鳥時,校車的圖像怎么會被正確歸類呢?

深度學習模型是復雜的數(shù)學黑匣子。他們的決策邏輯往往很難處理。人類的大腦也是復雜的,但沒有理由兩個復雜的東西會對世界有相似的看法。這也許并不令人驚訝,人類和機器對是什么使兩張圖像相似有著截然不同的認知。(™)

人類和人工智能看待世界的方式截然不同。當人類看到鴕鳥的圖像時,他們會認出它,把它與鴕鳥的概念聯(lián)系起來,并回憶起相關的事實:一只快速奔跑的不會飛的鳥,長長的脖子,生活在非洲等等。另一方面,人工智能甚至不知道鴕鳥指的是一種動物(或者,實際上,動物是什么)。對于人工智能來說,鴕鳥只是像素(在計算機視覺應用中)或文本字符(在自然語言處理應用中)的統(tǒng)計模式。人工智能應用程序缺少大多數(shù)成年人共享的常識知識。

從統(tǒng)計模式的角度思考對人類來說是非常不直觀的。即使是AI應用程序的開發(fā)人員也經(jīng)常很難理解系統(tǒng)學習到了什么樣的模式。

更糟糕的是,統(tǒng)計模型可能學習與開發(fā)人員預期完全不同的模式。統(tǒng)計方法走捷徑,學習訓練數(shù)據(jù)中出現(xiàn)的最簡單的模式。如果大多數(shù)貼上北極熊標簽的圖像都包括冰雪,那么模型可能會錯誤地認識到北極熊的意思是白色背景。

培養(yǎng)更好的模型

有一些方法可以緩解問題,但沒有完全解決的辦法。從概念上講,最簡單的解決辦法是收集更多的訓練數(shù)據(jù)。然而,覆蓋所有角落案例將需要不切實際的大量訓練集。自動駕駛汽車的訓練數(shù)據(jù)只能包含汽車在現(xiàn)實世界交通中可能遇到的一小部分情況。

一種相關的方法是通過裁剪、旋轉或增強具有低水平噪聲的圖像來生成訓練樣本的略微修改的副本,從而綜合擴展訓練集。這是一種向模型表明人類仍將圖像視為同一對象的變化程度的一種方式。以這種方式訓練的模型的預測被發(fā)現(xiàn)更可靠,更符合人類的感知。

如果預測模型能夠注意到它們被混淆了,問題就會得到緩解。例如,念力的一個原因可能是,輸入與模型在培訓期間看到的任何東西都有很大不同。一個活躍的研究方向是找出如何讓算法衡量自己的信心。

最終的解決方案是在預測模型中加入人類常識知識。貝葉斯建模提供了整合先驗知識的原則性方法。然而,在復雜的問題中,用所需的概率分布形式來表達™的知識是困難的。

對人工智能發(fā)展的影響

正如上面討論的那樣,人工智能系統(tǒng)在大多數(shù)情況下都可以很好地工作,但偶爾也會出現(xiàn)令人驚訝的錯誤。這對人工智能系統(tǒng)的發(fā)展有一定的影響。

首先也是最重要的是,開發(fā)人員需要做好應對意外預測的心理準備。他們需要評估潛在錯誤的風險,并為用戶提供適當?shù)幕謴头椒ā?/p>

全面的測試可以在一定程度上確保系統(tǒng)按預期運行。然而,測試永遠不可能涵蓋所有情況。如果存在哪怕是極少數(shù)導致奇怪預測的罕見輸入,用戶遲早都會偶然發(fā)現(xiàn)。因此,人工智能系統(tǒng)應該被設計成在出現(xiàn)令人驚訝的預測的情況下優(yōu)雅地降級。

應用程序的性質及其在自動化連續(xù)體中的位置也會影響特殊預測的影響。在一些應用中,人工智能只是提供總是由人類審查的建議。Gmail AutoComplete就是這類應用的一個例子,偶爾一個奇怪的建議可能會引起歡笑,但很少會產(chǎn)生嚴重的后果。另一方面,如果期望人工智能系統(tǒng)自主做出決策,那么它的設計應該有足夠的誤差率。此外,還應給予用戶檢查和回溯決策的控制權。

最后,不能總是回避奇怪的結果!意想不到的結果可能是創(chuàng)造力的搖籃。AI地下城是一個開放式文本冒險故事生成器。它的吸引力主要是基于它產(chǎn)生局部連貫句子的能力。與此同時,它追蹤完整故事背景的能力有限,往往會導致夢幻般的、任何事情都可能發(fā)生的故事情節(jié)。