ResNet也能用在3D模型上了,清華「計圖」團隊新研究已開源

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

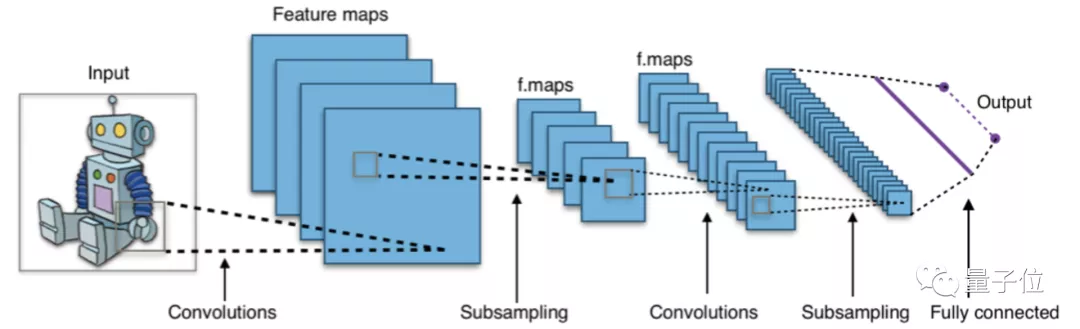

用AI處理二維圖像,離不開卷積神經(jīng)網(wǎng)絡(luò)(CNN)這個地基。

不過,面對三維模型,CNN就沒有那么得勁了。

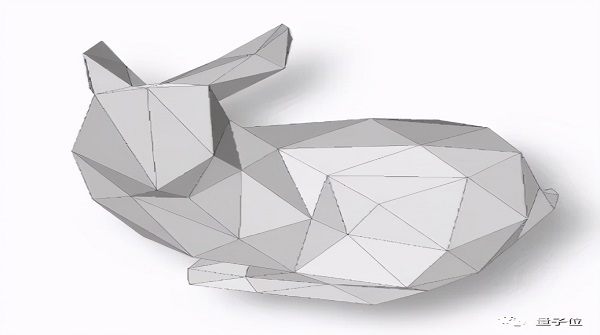

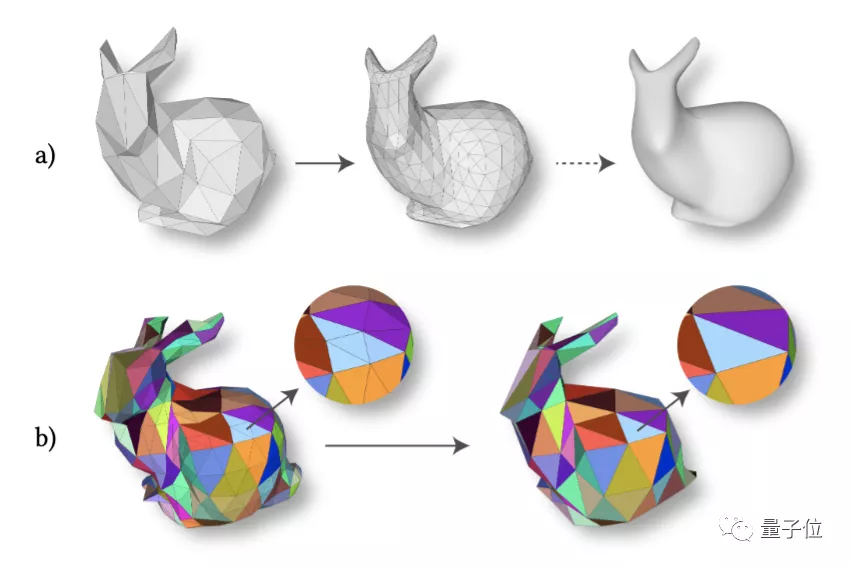

主要原因是,3D模型通常采用網(wǎng)格數(shù)據(jù)表示,類似于這樣:

這些三角形包含了點、邊、面三種不同的元素,缺乏規(guī)則的結(jié)構(gòu)和層次化表示,這就讓一向方方正正的CNN犯了難。

△CNN原理圖,圖源:維基百科

那么像VGG、ResNet這樣成熟好用的CNN骨干網(wǎng)絡(luò),就不能用來做三維模型的深度學(xué)習(xí)了嗎?

并不是。

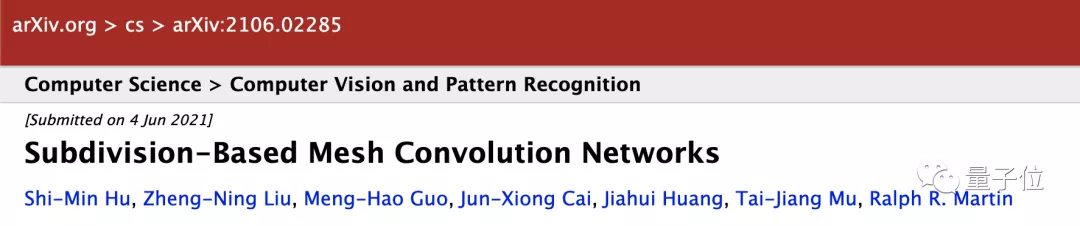

最近,清華大學(xué)計圖(Jittor)團隊,就首次提出了一種針對三角網(wǎng)格面片的卷積神經(jīng)網(wǎng)絡(luò)SubdivNet。

基于SubdivNet,就可以將成熟的圖像網(wǎng)絡(luò)架構(gòu)遷移到三維幾何學(xué)習(xí)中。

并且,相關(guān)論文和代碼均已開源。

基于細(xì)分結(jié)構(gòu)的網(wǎng)格卷積網(wǎng)絡(luò)

所以,SubdivNet是如何打破2D到3D之間的壁壘的呢?

具體而言,這是一種基于細(xì)分結(jié)構(gòu)的網(wǎng)格卷積網(wǎng)絡(luò)。

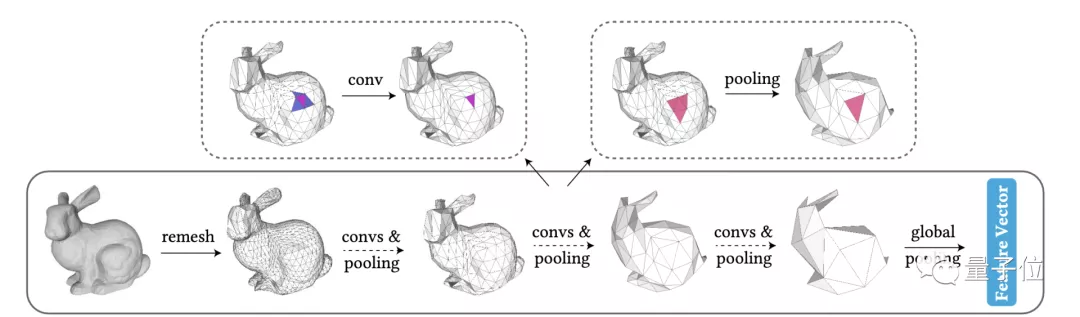

對于輸入的網(wǎng)格數(shù)據(jù),先進行重網(wǎng)格化(remesh),構(gòu)造細(xì)分結(jié)構(gòu),得到一般網(wǎng)格的多分辨率表示;而后,再上重頭戲——面片卷積方法和上下采樣方法。

面片卷積方法

以往的網(wǎng)格深度學(xué)習(xí)方法,通常是將特征存儲在點或者邊上,這就帶來了一個問題:點的度數(shù)是不固定的,而邊的卷積并不靈活。

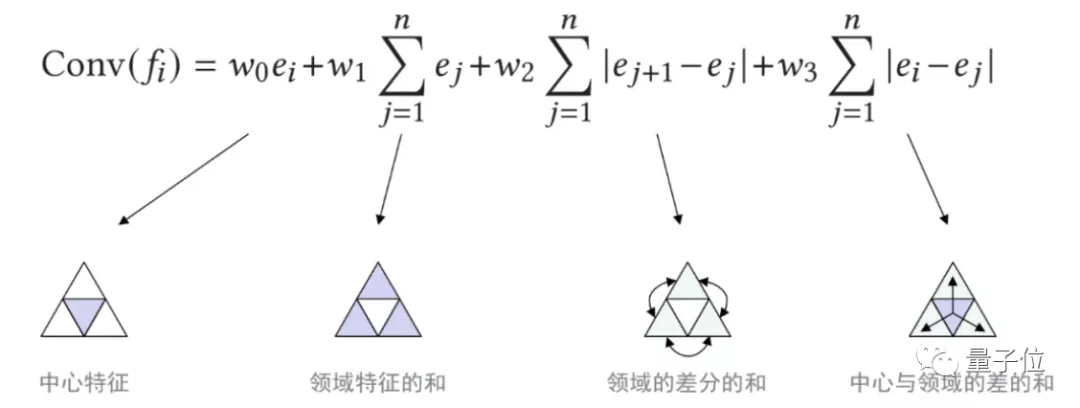

于是,計圖團隊提出了一種在面片上的網(wǎng)格卷積方法,以充分利用每個面片與三個面片相鄰的規(guī)則性質(zhì)。

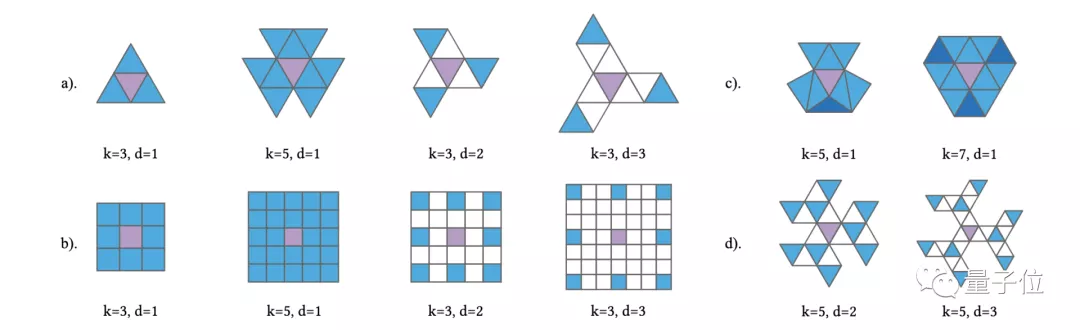

并且,基于這樣的規(guī)則性質(zhì),研究團隊進一步依據(jù)面片之間的距離,設(shè)計了多種不同的卷積模式。

△k為卷積核大小,d為空洞長度

由于三維數(shù)據(jù)格式中的面片順序不固定,SubdivNet在計算卷積結(jié)果時,通過取鄰域均值、差分均值等方式,使得計算結(jié)果與面片順序無關(guān),滿足排列不變性。

上下采樣方法

再來看上下采樣的部分。

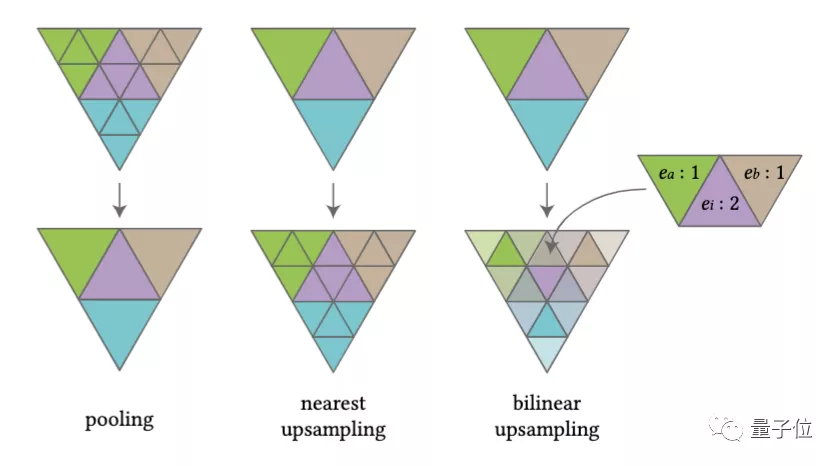

SubdivNet受到傳統(tǒng)的Loop細(xì)分曲面建模的啟發(fā),構(gòu)造了一種基于細(xì)分結(jié)構(gòu)的上下采樣方法。

也就是說,在池化(下采樣)過程中,由于網(wǎng)格數(shù)據(jù)已經(jīng)經(jīng)過重網(wǎng)格化,其面片具有細(xì)分連接結(jié)構(gòu),就可以4片變1片,從高分辨率轉(zhuǎn)為低分辨率,實現(xiàn)面片特征的池化操作。

而在上采樣的過程中,則反過來,讓面片一分為四。

如此一來,上下采樣方式就是規(guī)則且均勻的,還可以實現(xiàn)雙線性插值等需求。

結(jié)合面片卷積方法和上下采樣方法,像VGG、ResNet、DeepLabV3+這樣經(jīng)典2D卷積網(wǎng)絡(luò),就可以輕松遷移到3D模型的深度學(xué)習(xí)中。

值得一提的是,SubdivNet方法是基于清華大學(xué)的深度學(xué)習(xí)框架計圖(Jittor)實現(xiàn)的。其中,計圖框架提供了高效的重索引算子,無需額外的C++代碼,即可實現(xiàn)鄰域索引。

實驗結(jié)果

至于SubdivNet的效果如何,不妨直接看看實驗結(jié)果。

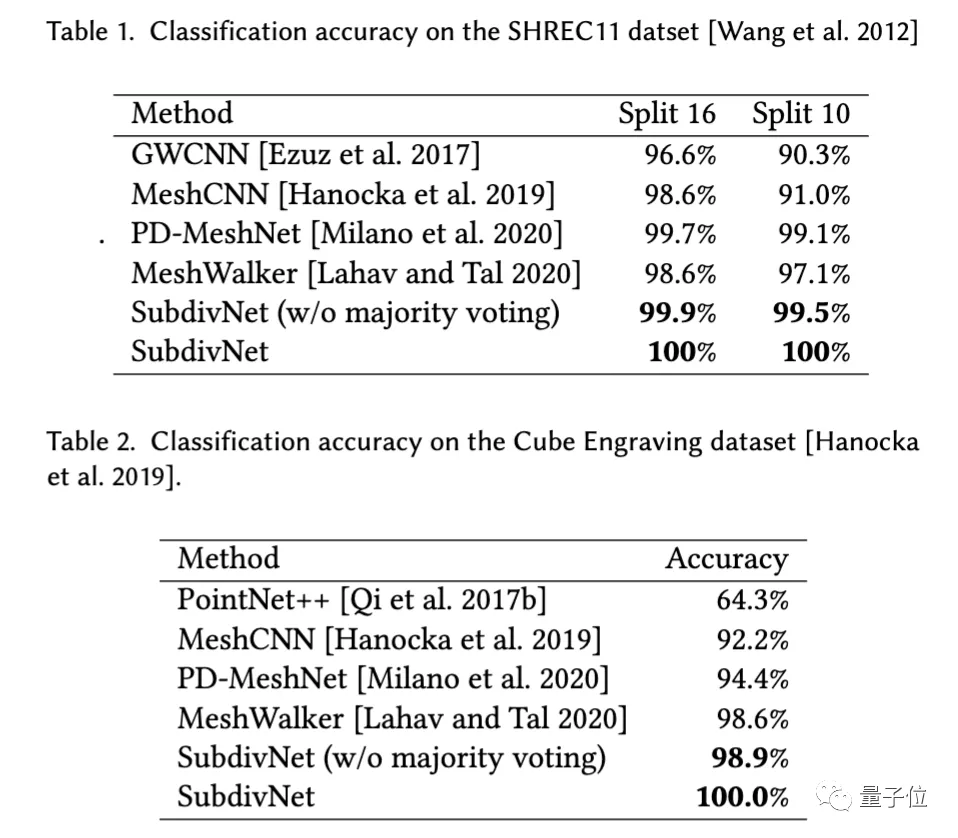

首先,在網(wǎng)格分類數(shù)據(jù)集上,SubdivNet在SHREC11和Cube Engraving兩個數(shù)據(jù)集中,首次達(dá)到了100%的分類正確率。

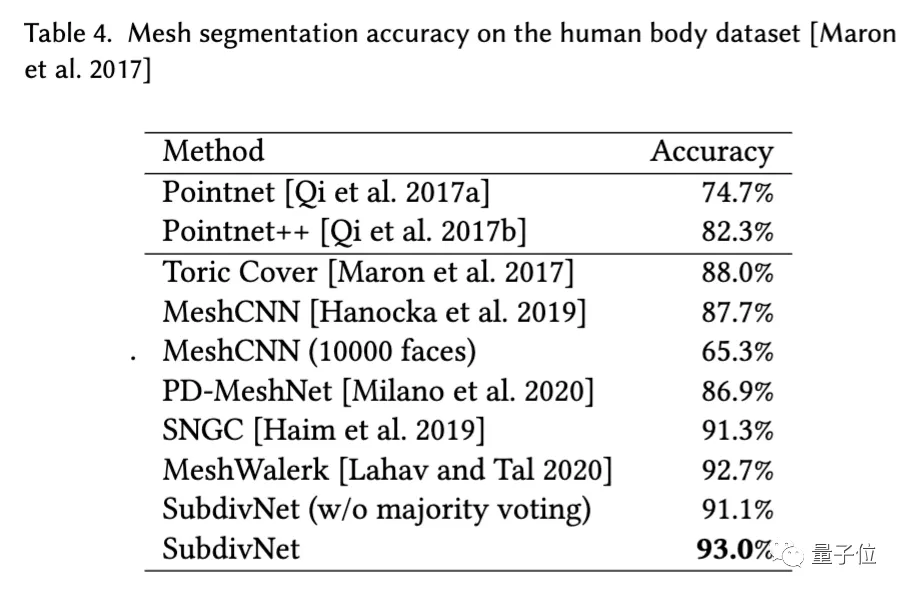

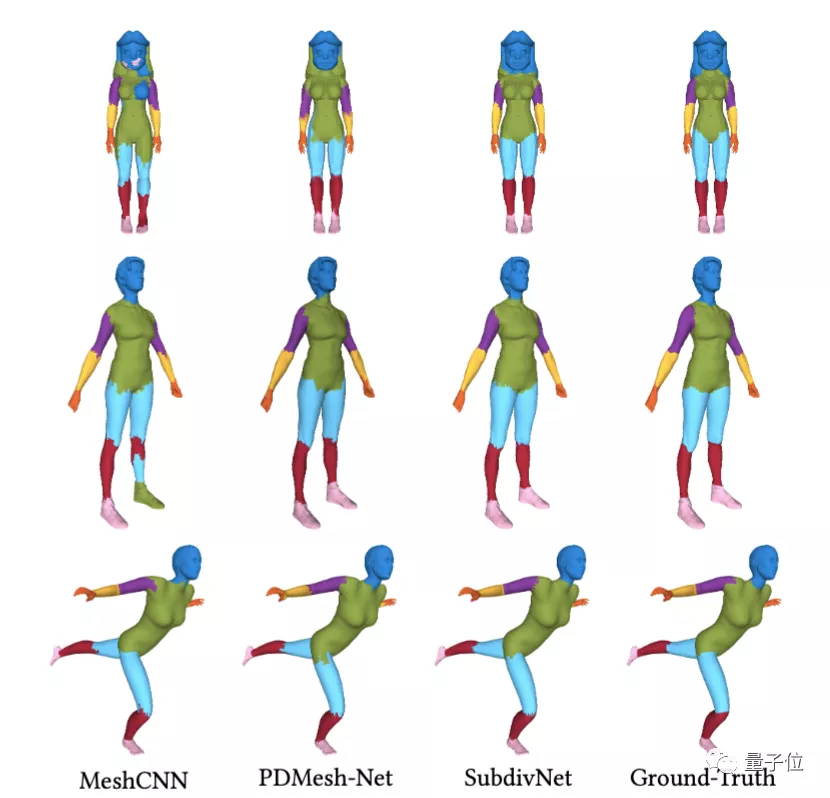

在網(wǎng)格分割方面,量化指標(biāo)下,SubdivNet的分割準(zhǔn)確率均高于用于對比的點云、網(wǎng)格方法。

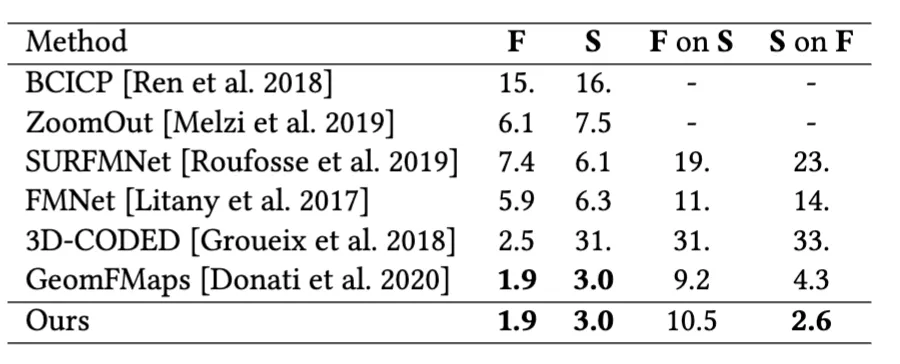

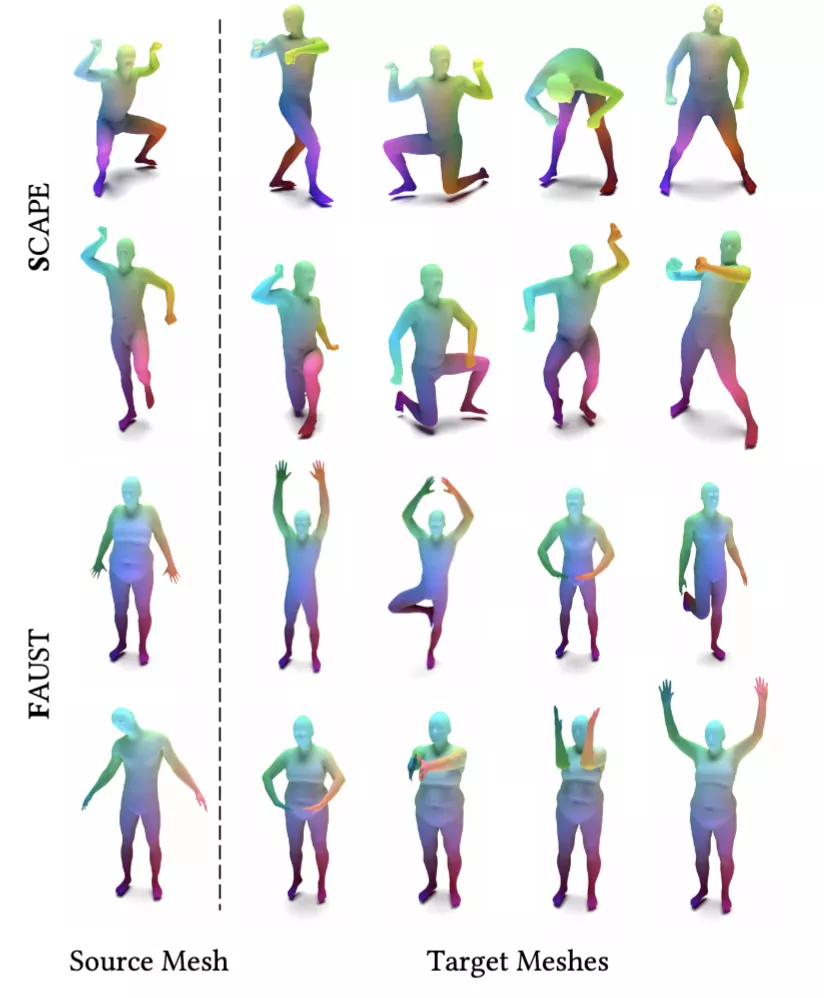

而在形狀對應(yīng)實驗中,SubdivNet也達(dá)到了SOTA水準(zhǔn)。

關(guān)于作者

這篇論文來自清華大學(xué)計算機系胡事民教授團隊。

作者是胡事民及其博士生劉政寧、國孟昊、黃家輝等,還有卡迪夫大學(xué)Ralph Martin教授。

同時,他們也是清華“計圖”框架團隊成員。

計圖是首個由中國高校開源的深度學(xué)習(xí)框架,開發(fā)團隊均來自清華大學(xué)計算機系圖形學(xué)實驗室,負(fù)責(zé)人是胡事民教授。

該實驗室的主要研究方向是計算機圖形學(xué)、計算機視覺、智能信息處理、智能機器人、系統(tǒng)軟件等,在ACM TOG, IEEE TVCG, IEEE PAMI, ACM SIGGRAPH, IEEE CVPR, IEEE ICRA, USENIX ATC等重要國際刊物上發(fā)表論文100余篇。

目前,開發(fā)計圖的主力,是該實驗室梁盾、楊國燁、楊國煒、周文洋、劉政寧、李相利、國孟昊和辛杭高等一批博士生。

與TensorFlow、PyTorch不同,計圖是一個完全基于動態(tài)編譯,使用元算子和統(tǒng)一計算圖的深度學(xué)習(xí)框架。

此前,在可微渲染、動態(tài)圖推理等方面,計圖都有超越PyTorch的表現(xiàn)。

論文地址:

https://arxiv.org/abs/2106.02285

項目地址:

https://github.com/lzhengning/SubdivNet

參考鏈接:

https://mp.weixin.qq.com/s/tJjarzqU7MvS_pHWWO3JYQ