GPT-3和AlphaFold 2震撼2020,2021年AI最大看點在哪兒?

2020年并不缺重磅新聞,但人工智能依然夠殺出重圍,走進主流視野。

尤其是GPT-3,它展示了人工智能即將以全新的方式深入我們的日常生活。

這些進步賦予了未來很多可能,預測未來變得并不容易,但伴隨著技術應用的成熟,另一些領域的突破也是可預見的。

以下是2021年人工智能有望取得突破的幾個方面。

GPT-3和AlphaFold背后的Transformer

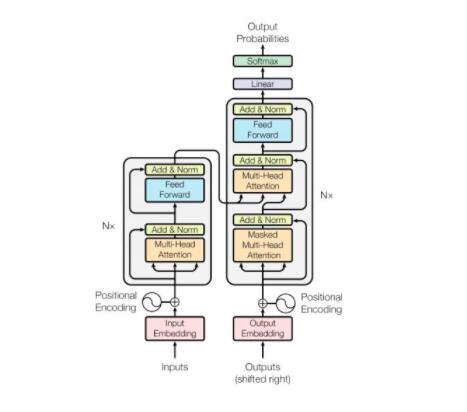

2020年最大的兩項人工智能成就悄無聲息地共享著相同的基本結構。OpenAI 的 GPT-3和 DeepMind 的 AlphaFold 都是基于Transformer.

盡管 Transformer 自2017年以來就已經存在,但 GPT-3和 Alphafold 展示了 Transformer 的非凡能力,它比上一代序列模型學習得更深入、更快,并且在自然語言處理(NLP)之外的問題上也表現出色。

與循環神經網絡(RNN)和 長短期記憶網絡(LSTMs)等之前的序列模型結構不同。

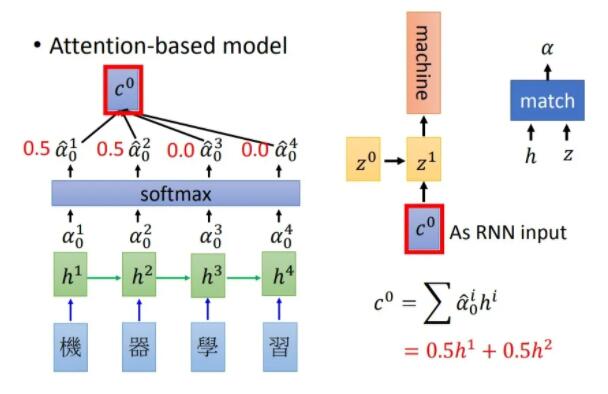

Transformer能夠一次處理整個輸入序列,并且引入「注意力」機制來了解輸入的哪些部分與其他部分相關。

這樣,Transformer就能夠輕松解決「長期記憶」的問題,這是循環模型一直在努力解決的問題。

另外,Transformer還允許并行訓練,能夠更好地利用近年來出現的大規模并行處理器,大大減少了訓練時間。

毫無疑問,2021年研究人員將為Transformer尋找新的用武之地,對Transformer將要帶來突破也充滿信心。

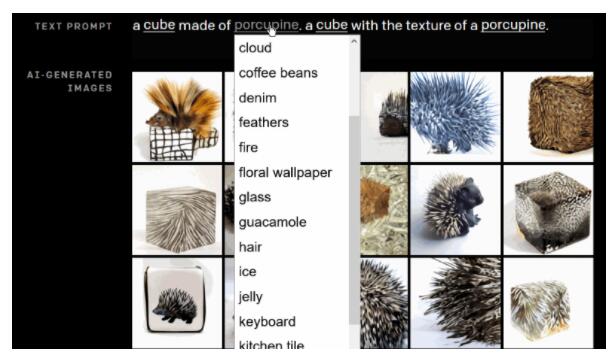

2021年,OpenAI 已經修改了 GPT-3,發布了DALL-E,使其完成從文本描述生成圖像。Transformer已經準備好要在2021年大展拳腳了。

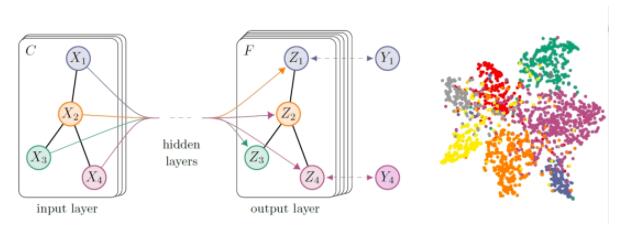

2021年,圖神經網絡(GNN)發展的兩大看點

許多領域的數據自然而然地適用于圖形結構,比如計算機網絡、社交網絡、分子/蛋白質和運輸路線等。

圖神經網絡(GNNs)使深度學習應用于圖形結構化數據,我們期望 GNN在未來發揮更大的作用。

2021年,我們預計在幾個關鍵領域的方法進步將推動更廣泛地應用GNN.

「動態圖」是第一個重要的領域。盡管迄今為止大多數 GNN 研究都假定了一個靜態圖,但這些情況會慢慢發生變化: 例如,在社交網絡中,新成員的加入會產生新的節點 ,關系也會發生變化。

在2020年,我們看到了一些將時間演化圖建模為一系列快照的做法,2021年這個新生的研究方向將會擴展,側重于將動態圖表建模為連續時間序列的方法。

這樣的連續建模,除了通常的拓撲結構外,還應該使 GNN 能夠發現和學習圖中的時態結構。

對「消息傳遞范式」的改進將是另一大可操作的進展。消息傳遞是實現圖神經網絡的一種常用方法,它是通過沿著連接鄰居的邊「傳遞」信息來聚集節點信息的一種方法。

雖然直觀,消息傳遞難以捕捉到需要信息在圖上長距離傳播的效果。

2021年,我們期待突破這一范式,例如通過迭代學習哪些信息傳播路徑是最相關的,甚至學習一個全新的關系數據集的因果圖。

2021年的AI應用

去年許多頭條新聞都強調了AI在實際應用中的新進展,2021年這些進展有望投入市場。

值得說明的是,由于GPT-3的API將更加可行,依賴于自然語言理解的應用程序也會越來越多。API允許用戶訪問GPT-3的功能,并且無需耗費精力訓練自己的AI。

Microsoft已經獲得了GPT-3獨家使用授權,這項技術也許會出現在Microsoft的產品中。

在2021年,其他應用領域也將從AI技術中獲益。AI和機器學習雖然已經進入了網絡安全領域,但2021年將會爆發更大的潛力。

正如太陽風黑客事件所揭露的那樣,一些公司已經面臨網絡犯罪分子和先進的惡意勒索軟件的威脅。

而AI和行為分析對于幫助識別新威脅甚至早期威脅至關重要。所以在2021年,希望能夠推動最新的行為來分析AI,增強網絡防御系統。

2021年,我們還期待有更多默認在邊緣設備上運行機器學習模型的應用程序。

像谷歌的 Coral這樣具有TPU的設備,隨著處理能力和量化技術的進步,也能夠推廣普及。

圖為Carol加速器模塊,帶有Google Edge TPU的新型多芯片模塊。

Edge AI則消除了把數據發送到云上參照的需求,既節省了帶寬又減少了執行時間,這兩點對醫療保健等領域都至關重要。

邊緣計算的應用程序還可以在一些需要隱私、安全和低延遲的區域,甚至世界上無法訪問高速Internet的區域中打開。

未來難測,未來可期

隨著AI技術在實際領域的運用越來越廣泛,Transformer和GNN的進步也會促使它們在現有的AI技術和算法更進一步。以上只是重點介紹了幾個有望在今年取得進展的領域,不過相信伴隨進展的還會有更多的驚喜。

未來難測,但無論對錯,2021年對于AI都將是令人興奮的一年。