深度策略梯度算法是真正的策略梯度算法嗎?

近期深度強(qiáng)化學(xué)習(xí)取得了很多成功,但也存在局限性:缺乏穩(wěn)定性、可復(fù)現(xiàn)性差。來自 MIT 和 Two Sigma 的研究者重新檢驗了深度強(qiáng)化學(xué)習(xí)方法的概念基礎(chǔ),即目前深度強(qiáng)化學(xué)習(xí)的實踐多大程度上反映了其概念基礎(chǔ)框架的原則?該研究重點探討深度策略梯度方法。

深度強(qiáng)化學(xué)習(xí)是現(xiàn)代機(jī)器學(xué)習(xí)最為人所知的成就,它造就了 AlphaGO 這樣廣為人知的應(yīng)用。對很多人來說,該框架展示了機(jī)器學(xué)習(xí)對現(xiàn)實世界的影響力。但是,不像當(dāng)前的深度(監(jiān)督)學(xué)習(xí)框架,深度強(qiáng)化學(xué)習(xí)工具包尚未支持足夠的工程穩(wěn)定性。的確,近期的研究發(fā)現(xiàn)當(dāng)前***的深度強(qiáng)化學(xué)習(xí)算法對超參數(shù)選擇過于敏感,缺乏穩(wěn)定性,且可復(fù)現(xiàn)性差。

這表明或許需要重新檢驗深度強(qiáng)化學(xué)習(xí)方法的概念基礎(chǔ),準(zhǔn)確來說,該研究要解決的重要問題是:目前深度強(qiáng)化學(xué)習(xí)的實踐多大程度上反映了其概念基礎(chǔ)框架的原則?

該論文重點研究深度策略梯度方法,這是一種廣泛使用的深度強(qiáng)化學(xué)習(xí)算法。研究目標(biāo)是探索這些方法的當(dāng)前***實現(xiàn)多大程度上體現(xiàn)了通用策略梯度框架的關(guān)鍵基元。

該論文首先檢驗重要的深度策略梯度方法近端策略優(yōu)化(PPO)。研究發(fā)現(xiàn) PPO 的性能嚴(yán)重依賴于非核心算法的優(yōu)化,這表明 PPO 的實際成功可能無法用其理論框架來解釋。

這一觀察促使研究者進(jìn)一步檢查策略梯度算法及其與底層框架之間的關(guān)系。研究者對這些算法在實踐中展示的關(guān)鍵強(qiáng)化學(xué)習(xí)基元進(jìn)行了細(xì)致地檢查。具體而言,研究了:

- 梯度估計(Gradient Estimation):研究發(fā)現(xiàn),即使智能體的獎勵有所提升,用于更新參數(shù)的梯度估計通常與真實梯度不相關(guān)。

- 價值預(yù)測(Value Prediction):實驗表明價值網(wǎng)絡(luò)能夠訓(xùn)練并成功解決監(jiān)督學(xué)習(xí)任務(wù),但無法擬合真正的價值函數(shù)。此外,將價值網(wǎng)絡(luò)作為基線函數(shù)僅能稍微降低梯度估計的方差(但能夠顯著提升智能體的性能)。

- ***化 Landscape:研究發(fā)現(xiàn)***化 Landscape 通常無法反映其真正獎勵的潛在 Landscape,后者在相關(guān)的采樣方案(sample regime)中通常表現(xiàn)不佳。

- 置信域:研究發(fā)現(xiàn)深度策略梯度算法有時會與置信域產(chǎn)生理論沖突。實際上,在近端策略優(yōu)化中,這些沖突來源于算法設(shè)計的基礎(chǔ)問題。

研究者認(rèn)為以上問題以及我們對相關(guān)理論知識的缺乏是深度強(qiáng)化學(xué)習(xí)脆弱性和低復(fù)現(xiàn)性的主要原因。這表明構(gòu)建可信賴的深度強(qiáng)化學(xué)習(xí)算法要求拋棄之前以基準(zhǔn)為中心的評估方法,以便多角度地理解這些算法的非直觀行為。

論文:Are Deep Policy Gradient Algorithms Truly Policy Gradient Algorithms?

論文鏈接:https://arxiv.org/pdf/1811.02553.pdf

摘要:本文研究了深度策略梯度算法對促進(jìn)其發(fā)展的底層概念框架的反映程度。我們基于該框架的關(guān)鍵要素對當(dāng)前***方法進(jìn)行了精細(xì)分析,這些方法包括梯度估計、價值預(yù)測、***化 landscape 和置信域分析。我們發(fā)現(xiàn),從這個角度來看,深度策略梯度算法的行為通常偏離其概念框架的預(yù)測。我們的分析開啟了鞏固深度策略梯度算法基礎(chǔ)的***步,尤其是,我們可能需要拋棄目前以基準(zhǔn)為中心的評估方法。

檢查深度策略梯度算法的基元

1. 梯度估計的質(zhì)量

策略梯度方法的核心前提是恰當(dāng)目標(biāo)函數(shù)上的隨機(jī)梯度上升帶來優(yōu)秀的策略。具體來說,這些算法使用(代理)獎勵函數(shù)的梯度作為基元:

這些方法的理論背后的底層假設(shè)是,我們能夠獲取對梯度的合理估計,即我們能夠使用有限樣本(通常大約 103 個)的經(jīng)驗平均值準(zhǔn)確估計上面的期望項。因此研究者對實踐中該假設(shè)的有效性很感興趣。

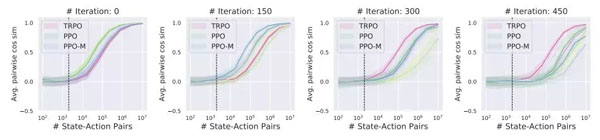

我們計算出的梯度估計準(zhǔn)確度如何?為了解決該問題,研究者使用了評估估計質(zhì)量最自然的度量標(biāo)準(zhǔn):經(jīng)驗方差(empirical variance)和梯度估計向「真正」梯度的收斂情況。

圖 2

圖 2:梯度估計的經(jīng)驗方差在 MuJoCo Humanoid 任務(wù)中可作為狀態(tài)-動作對關(guān)于數(shù)量的函數(shù),x 軸為狀態(tài)-動作對,y 軸是梯度估計的經(jīng)驗方差。

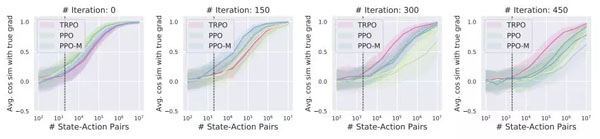

圖 3

圖 3:MuJoCo Humanoid 任務(wù)中梯度估計向「真正」期望梯度的收斂情況。

2. 價值預(yù)測

圖 4

圖 4:對于訓(xùn)練用于解決 MuJoCo Walker2d-v2 任務(wù)的智能體,在留出狀態(tài)-動作對上的價值預(yù)測質(zhì)量(度量指標(biāo)為平均相對誤差 MRE)。

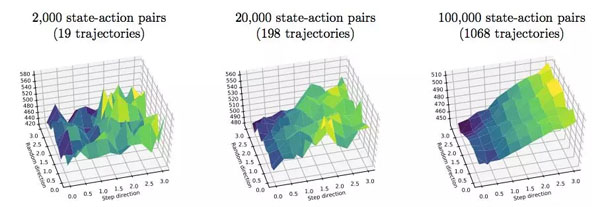

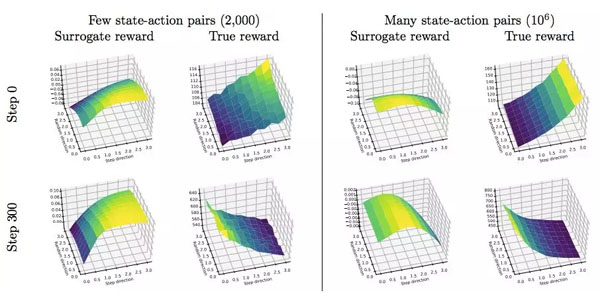

3. 探索***化 landscape

策略梯度算法的另一個基礎(chǔ)假設(shè)是對策略參數(shù)使用一階更新可以帶來性能更好的策略。因此接下來我們就來看該假設(shè)的有效性。

圖 6:在 Humanoid-v2 MuJoCo 任務(wù)上,TRPO 的真正獎勵函數(shù) Landscape。

圖 8:在 Humanoid-v2 MuJoCo 任務(wù)上,PPO 的真正和代理獎勵函數(shù) Landscape。

4. 置信域的優(yōu)化

圖 9

圖 9:對于訓(xùn)練用于解決 MuJoCo Humanoid 任務(wù)的智能體,每一步的平均獎勵、***速率(maximum ratio)、平均 KL 和 maximum versus mean KL 情況。

為深度強(qiáng)化學(xué)習(xí)奠定更好的基礎(chǔ)

深度強(qiáng)化學(xué)習(xí)算法根植于基礎(chǔ)穩(wěn)固的經(jīng)典強(qiáng)化學(xué)習(xí)框架,在實踐中展示了巨大的潛力。但是,該研究調(diào)查顯示,該底層框架無法解釋深度強(qiáng)化學(xué)習(xí)算法的很多行為。這種分裂妨礙我們深入理解這些算法成功(或失敗)的原因,而且成為解決深度強(qiáng)化學(xué)習(xí)所面臨重要挑戰(zhàn)的極大障礙,比如廣泛的脆弱性和薄弱的可復(fù)現(xiàn)性。

為了解決這種分類,我們需要開發(fā)更加貼近底層理論的方法,或者構(gòu)建能夠捕捉現(xiàn)有策略梯度算法成功原因的理論。不管哪種情況,***步都要準(zhǔn)確指出理論和實踐的分岔點。這部分將分析和鞏固前一章的發(fā)現(xiàn)和結(jié)果。

- 梯度估計。上一章的分析表明策略梯度算法使用的梯度估計的質(zhì)量很差。即使智能體還在提升,此類梯度估計通常與真正的梯度幾乎不相關(guān)(見圖 3),彼此之間也不相關(guān)(見圖 2)。這表明遵循現(xiàn)有理論需要算法獲取更好的梯度估計。或者,我們需要擴(kuò)展理論,以解釋現(xiàn)代策略梯度算法為什么在如此差的梯度估計情況下還能取得成功。

- 價值預(yù)測。研究結(jié)果說明兩個關(guān)鍵問題。一,盡管價值網(wǎng)絡(luò)成功解決了接受過訓(xùn)練的監(jiān)督學(xué)習(xí)任務(wù),但它無法準(zhǔn)確建模「真正」的價值函數(shù)。二,將該價值網(wǎng)絡(luò)作為基線會降低梯度方差。但與「真」價值函數(shù)提供的方差減少程度對比來說則太少了。這些現(xiàn)象促使我們發(fā)問:建模真價值函數(shù)的失敗是在所難免的嗎?價值網(wǎng)絡(luò)在策略梯度方法中的真正作用是什么?

- ***化 Landscape。由上一章可知,現(xiàn)代策略梯度算法的***化 Landscape 通常無法反映底層真正獎勵的 Landscape。事實上,在策略梯度方法使用的采樣方案中,真獎勵的 Landscape 有噪聲,且代理獎勵函數(shù)通常具備誤導(dǎo)性。因此我們需要深入理解為什么這些方有這么問題還能成功,更寬泛一點來看,如何更準(zhǔn)確地展現(xiàn)真獎勵函數(shù)的 Landscape。

- 置信域近似。該研究的發(fā)現(xiàn)表明策略需要局部類似可能存在大量原因,包括帶噪聲的梯度估計、較差的基線函數(shù)和代理 Landscape 未對齊。底層理論的置信域優(yōu)化不僅未察覺到這些因素,將該理論轉(zhuǎn)換成高效算法也非常困難。因此深度策略梯度方法放松對置信域的約束,這使得其性能難以理解和分析。因此,我們需要一種更加嚴(yán)格地執(zhí)行置信域的技術(shù),或者對于置信域放松的更嚴(yán)謹(jǐn)理論。

【本文是51CTO專欄機(jī)構(gòu)“機(jī)器之心”的原創(chuàng)譯文,微信公眾號“機(jī)器之心( id: almosthuman2014)”】