數據缺失的坑,無監督學習這樣幫你補了

無監督學習(UL)有很多沒開發的潛力。它是一門從“未標記”數據中推導一個函數來描述其隱藏結構的藝術。但首先,從數據中找到其結構是什么意思呢? 讓我們來看以下兩個例子:

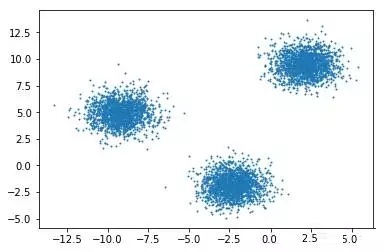

Blobs

氣泡狀分布:這個簡單。任何人看到這張圖都會認為它是由三個不同的簇組成的。如果你對統計學非常熟悉,你可能還會猜想它由三個隱藏的高斯分布構成。對一個新的數據樣本,查看它的位置,人們就能推斷出它屬于哪一簇。

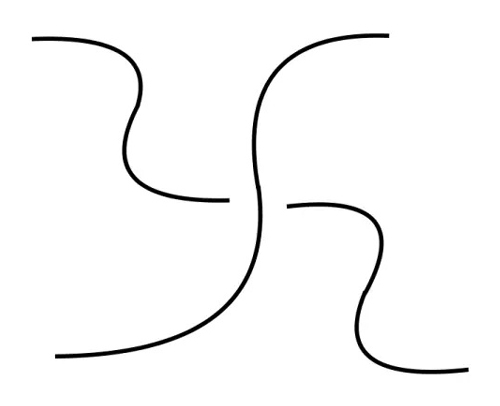

Wavy hi

波浪分布:這個就有難度了。它有明確的結構,但我怎么教計算機提取出這一結構呢?為了讓你更好地理解這個問題,想象一下我找來1000人,問他們在這張圖中看到了幾個簇。結果很可能是這樣,回答2的人最多,也有人回答3、4,甚至1!

所以說對數據的結構,連人都無法達成共識,那怎么可能教計算機學會呢?這里的癥結在于,對于什么是簇,或者廣義地說什么是“結構”,沒有統一的定義。人們可以研究一下日常生活的某個方面,看它有沒有結構,但這也會根據環境或其中涉及的人的變化而變化。

很多著名的無監督學習算法,比如層次聚類,K-Means,混合高斯模型或隱馬爾可夫模型,對同一問題可能得到不同的答案,依我拙見,對于找結構問題,沒有所謂更好的或更正確的普適方法(真的嗎?又是沒有免費的午餐定理?)

那么讓我們動手探索吧——

聚類方法

- K-Means(scikit learn)

- 模糊K-Means(scikit fuzzy)

- 混合高斯模型(scikit learn)

用K-Means算法產生簇通常被稱為“硬劃分”,因為對一個樣本和一個簇,只有屬于和不屬于兩種關系。K-Means的改進版模糊K-Means算法是“軟劃分”或“模糊”,因為一個樣本對每個簇都有隸屬度。基于這些隸屬度來更新簇的質心。

混合高斯模型https://github.com/abriosi/gmm-mml

這個包是論文Unsupervised learning of finite mixture models(有限混合模型的無監督學習)中提出的方法,用一個算法實現估計和模型選擇。

數據集

1. 占有率檢測:

這是一個沒有缺失值的時間序列數據集,因此要人為刻意地進行空缺數據補全。

這一數據集相對較小,有20560個樣本和7個特征,其中一個模型預測變量為是否占有。(二元分類問題)。

2. Sberbank俄羅斯房價市場數據集:

這也是一個時序數據集,來自數月前結束的Kaggle競賽。

將訓練數據與俄羅斯宏觀經濟和金融部門的數據合并后,得到30471個樣本,389個特征,其中一個是要預測的價格(回歸問題)。

它有93列有缺失數據,有些NaNs(非指定類型數據)占比很大(> 90%)。

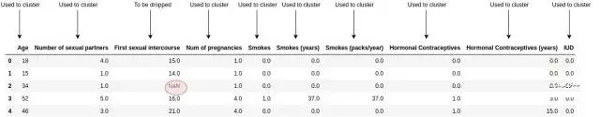

3.子宮頸癌(危險因素)數據集:

這一數據集有858個樣本和32個特征,4個目標變量(不同醫學測試指標的二元輸出)取眾數轉化成1個目標變量。

它有26個特征有空缺值,有些NaNs(非指定類型數據)占比很大(> 90%)。

數據缺失值補全過程

先刪去訓練集和測試集中所有含有缺失數據的特征。利用留下的特征,對訓練集應用聚類算法,并預測兩組中每個樣本的簇。加上刪去的列,計算按照簇分組后每個特征的平均值(或均值,如果是定性的話)。所以現在我們有了每個簇未補全時的特征的平均值。

“普通”和加權補全方法:

- 這里“普通補全”指的是每個樣本都用以計算其所屬簇的平均值/眾數。

- 加權方法則用樣本對每個簇的“歸屬度”。比如,在混合高斯模型(GMM)中,歸屬度是樣本屬于各個簇的可能性,在K-Means方法中,歸屬度基于樣本與各個簇的質心的距離。

評分方法

- 除標準化之外,幾乎沒對數據集做任何處理。

- 對于時間序列數據集,從***個樣本算起對時間標記排序,在占有率檢測數據集中轉化成按秒計數,同理在俄羅斯房價市場數據集中按天計數。

- 完成插補后,用XGBoost在測試集進行評分。用負對數損失和均方誤差作為評分度量。

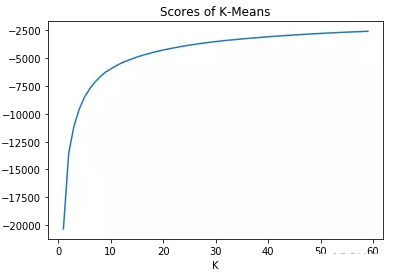

得到簇的數目

最初考慮了“肘”或者說“膝”方法。當簇的數量取值在一定范圍內時,畫出不同聚簇方法的得分并從圖中尋找肘部。

比如,上圖的肘部在8到12之間。缺點是這種方法需要人的參與來選擇肘部,而實際應用上應該自動。但自動選擇肘部效果并不理想,因此可以考慮一種新方法。

通過交叉驗證,得到了一種比較有效但計算成本昂貴的方法。它是怎么工作的呢?首先選擇一個分類器,然后對于一系列質心數目,進行無監督插補,并用該分類器進行K-fold交叉驗證。***選擇在交叉驗證中表現更好的質心數目。

結果

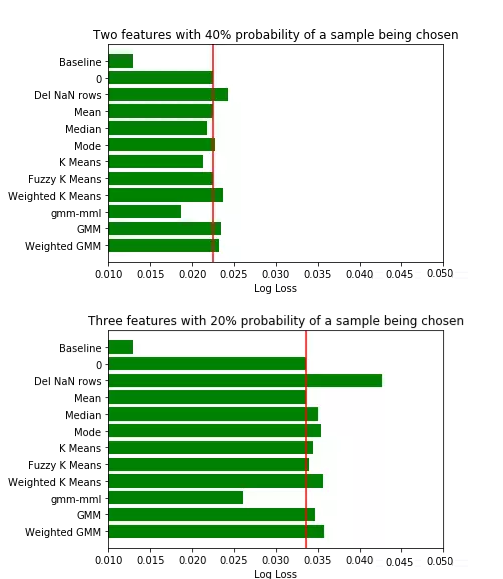

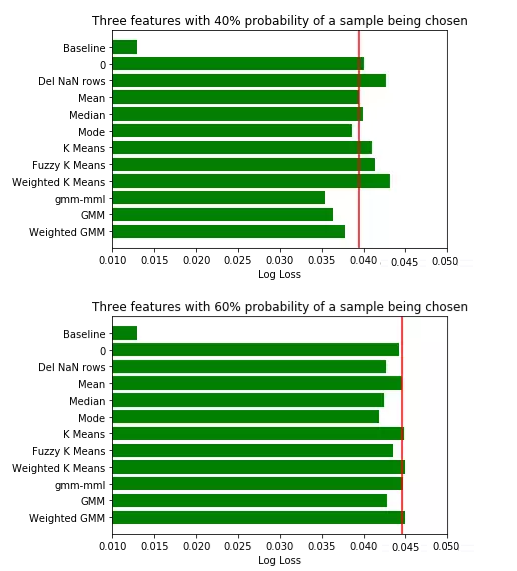

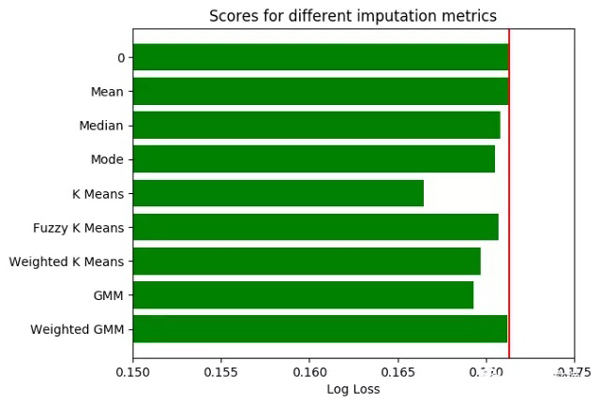

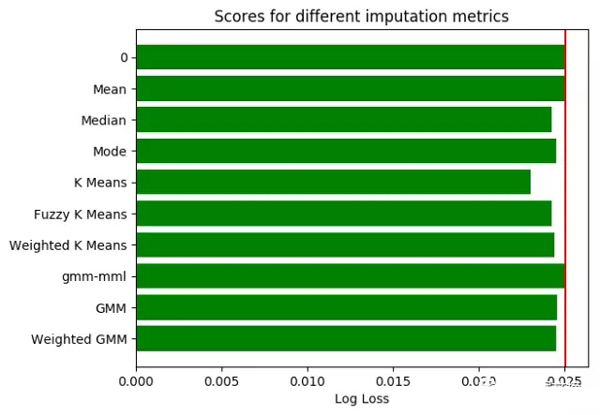

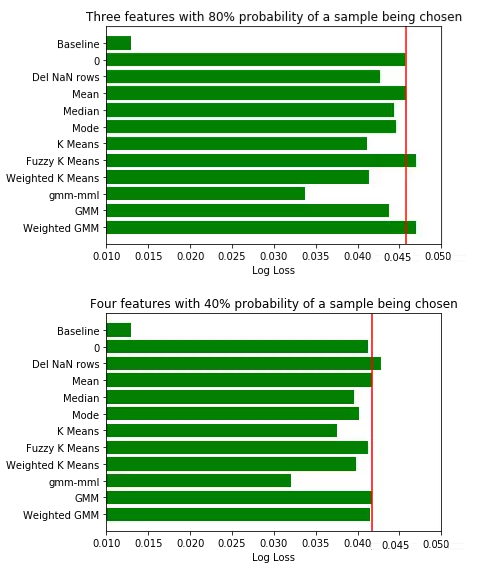

在條形圖中,用紅線標記平均值插補的分數,以便進行比較。

占有率檢測數據集:

誠如之前提到的,這個數據集并沒有缺失數據,所以只能模擬補缺行為。

對將要補缺的數據特征和樣本應當謹慎挑選。不僅特別選擇了數據特征,而且對是否選擇樣本設定了概率。如果概率為0.5,有50%的機會該樣本將被丟棄。由于每次填補缺失值的樣本選擇都不同,我們將每三輪不同樣本補缺的評分結果取均值,***再對所有結果取均值。

房產市場數據集:

由于該數據集的數據量過大,怎樣在有限的內存中完成聚類分析值得研究一番。我們放棄了使用全量數據做歸類計算的打算,隨機抽取了適合電腦內存的樣本數據量(本次測試我選用了5000條記錄)。

在原始數據集中使用隨機抽樣的方法抽取樣本,也盡量保持了數據的時間結構。樣本的數據量越大,反映的時間結構越準確。

子宮頸癌數據集:

結果分析

根據結果,在數據分群的基礎上選擇補缺方式的表現比一般方法要好。

對于占有率檢測數據集,表現最優的是GMM_MML分類算法,而對于房產市場數據和宮頸癌數據集,K_Means聚類算法更好。我們并沒有對房產市場數據使用GMM_MML算法,因為它包含太多特征,而協方差的計算對于多特征數據比多樣本量數據更加困難。

在增加占有率檢測數據集的缺失數據后,整體上可以觀測到,無監督的補缺方法比均值補缺表現要好。因此,當數據集有缺失值占比較高時,先探索數據結構再補缺方法反而形成一種優勢。

大家會注意到,當使用檢測數據集的缺失數據特征從2個增加到4個,且用于聚類的特征數量減少時,無監督補缺方法比均值補缺表現稍好。這種反常的現象可能是由于特定的數據集和選擇的特征造成的。

同時,自然的,當缺失數據占比增加時,評分與基線分數的差距越來越大。

在三種K_Means算法中,普通型表現優于其他兩種。這種算法每次迭代的計算量也最小,是較佳選擇。

基于GMM方法的表現優于K-Means算法,這一現象十分合理,因為K-Means算法是GMM算法在歐式距離計算上的啟發式算法。歐式距離能有效測量低維數據,但在高維空間上,其含義開始失真。如想了解更多信息,請看這里(https://stats.stackexchange.com/questions/99171/why-is-euclidean-distance-not-a-good-metric-in-high-dimensions/)。GMM算法是基于樣本所屬概率密度函數的可能性,能更好的衡量高維空間距離。

結論

盡管基于聚類的缺失值補充算法沒有明顯高過其他算法的優勝者,我們還是建議選擇基于GMM的算法。

想找到模型混合的較佳數量,使用交叉驗證法會更好。盡管AIC準則和BIC準則需要大量計算,他們可以用于檢測模型混合數量的范圍。較佳數量會令準則值達到最小。

計算協方差矩陣有很多方法。這里介紹兩種最常使用的:

- 對角協方差:每個部分都有自己的對角矩陣。

- 全協方差:這種協方差用于統計檢測。每個部分有自己的廣義協方差矩陣。

數據集中如果特征維度太多,使用GMM算法計算協方差矩陣,可能因為樣本量不足計算錯誤,也可能因為使用全量數據耗時太久。因此建議使用對角協方差,更加平衡模型大小和計算質量。

如果數據量大大超過內存容量,應當從訓練集中生成隨機樣本做聚類分析。

均值補缺的表現沒有比基于聚類補缺方法差很多,因此也可以考慮使用。

后續工作

數據整理也可以嘗試新方法:不再丟棄有缺失數據的特征,可以用均值或中位數填補缺失值,對修改后的數據集使用聚類分析。補缺可以在每個樣本被標記后完成。

Finite Mixture Models (McLachlan和Peel著)這本書中提到NEC和ICL都是很好的方法。

也有更多無監督方法值得研究檢測,例如,不同距離度量方法下的分級聚類。當然,普適的方法可能并不存在,畢竟沒有免費的午餐。