CMU&FAIR ICCV論文:通過傳遞不變性實現自監督視覺表征學習

通過自監督學習學習視覺表征在計算機視覺領域逐漸開始流行。本文提出可通過不變性的傳遞實現視覺表征自監督學習,該網絡在多種識別任務中均表現不俗,在表面正常評估任務中的表現甚至優于 ImageNet 網絡。

論文:Transitive Invariance for Self-supervised Visual Representation Learning

論文地址:https://arxiv.org/abs/1708.02901

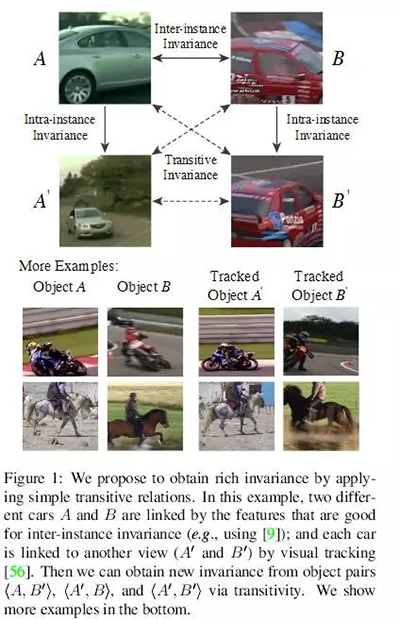

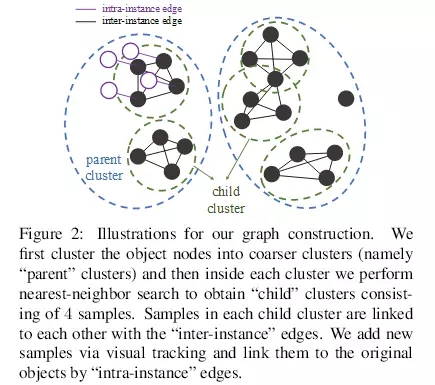

通過自監督學習學習視覺表征在計算機視覺領域逐漸開始流行。該方法是為了設計可隨意獲取標簽的輔助任務。大多數輔助任務最終將提供數據來學習特定種類的有助于識別的不變性(invariance)。在本論文中,我們提出利用不同的自監督方法學習表征,這些表征與 (i) 實例間變體(inter-instance variation,相同類別的兩個對象應該具備相似的特征)、(ii) 實例內變體(intra-instance variation,視角、姿勢、變形、亮度等)無關。我們沒有將這兩種方法與多任務學習聯結起來,而是組織和推理具備多種不變性的數據。具體來說,我們提出使用從成百上千個視頻中挖掘出的數百萬個對象生成一個圖。這些對象由分別對應兩種不變性的兩種邊緣(edge)聯結起來:「具備相似的觀點和類別的不同實例」和「相同實例的不同觀點」。通過將簡單的傳遞性(transitivity)應用到帶有這些邊緣的圖上,我們能夠獲取具備更加豐富視覺不變性的成對圖像。我們使用這些數據訓練帶有 VGG16 的 Triplet-Siamese 網絡作為基礎架構,將學得的表征應用到不同的識別任務中。關于物體檢測,我們使用 Fast R-CNN 在 PASCAL VOC 2007 數據集上達到了 63.2% mAP(ImageNet 的預訓練結果是 67.3%)。而對于有難度的 COCO 數據集,使用我們的方法得出的結果(23.5%)與 ImageNet-監督的結果(24.4%)驚人地接近。我們還證明了我們的網絡在表面正常評估(surface normal estimation)任務中的表現優于 ImageNet 網絡。

圖 1:我們提出使用簡單的傳遞關系獲取豐富的不變性。在該示例中,兩輛不同的汽車 A 和 B 被有利于實例間不變性的特征聯結起來;每輛車通過視覺追蹤與另一個視角(A′和 B′)聯系起來。之后,我們能夠借助傳遞性從物體對〈A, B′〉、〈A′, B〉和〈A′, B′〉中獲取新的不變性。

圖 2:圖構建描述。我們首先將物體節點聚集到更加粗糙的集群(叫作「父」集群),然后我們在每個集群內執行最近鄰搜索(nearest-neighbor search)來得到包含 4 個樣本的「子」集群。每個子集群內的樣本通過「實例內」邊緣互相聯結。我們通過視覺追蹤增加新樣本,并通過「實例間」邊緣將其與原始物體聯結起來。

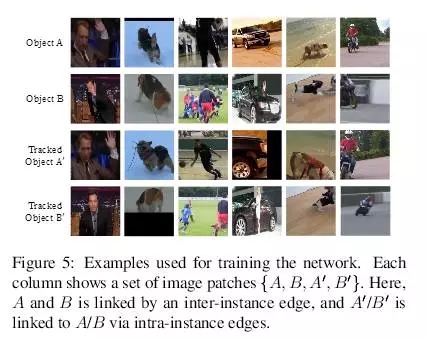

圖 5:訓練網絡所用樣本。每一列是一系列圖像塊 {A, B, A′, B′}。這里,A 和 B 通過實例間邊緣聯結,而 A′/B′與 A/B 通過實例內邊緣聯結。

圖 6:我們的 Triplet-Siamese 網絡。我們向該網絡輸入樣本的不同聯結。

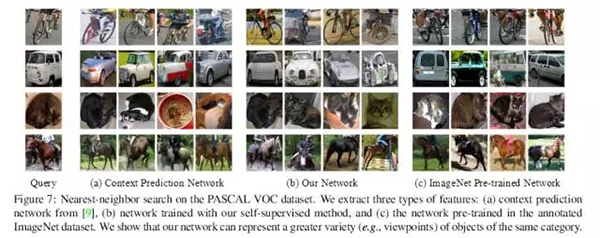

圖 7:PASCAL VOC 數據集上的最近鄰搜索。我們抽取三種特征:(a)語境預測網絡,(b)使用我們的自監督方法訓練的網絡,(c)標注 ImageNet 數據集中預訓練的網絡。我們證明我們的網絡可以展示出相同類別物體的更多種類(如視角)。

【本文是51CTO專欄機構“機器之心”的原創譯文,微信公眾號“機器之心( id: almosthuman2014)”】