基礎深度學習概念備忘錄

深度學習可能對于很多初學者是一頭霧水,在高速發(fā)展的同時有很多新的概念名詞被拋出,而本文則是對一些常見名詞的備忘介紹。

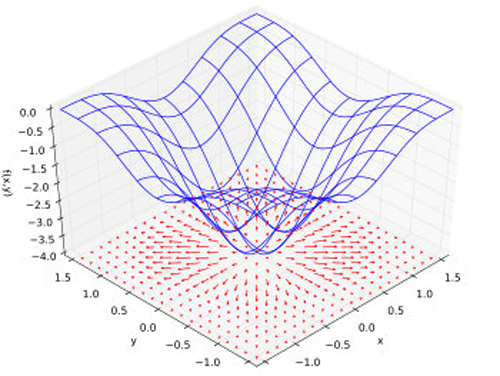

Gradient ∇ (微分算符):梯度

梯度即是某個函數(shù)的偏導數(shù),其允許輸入多個向量然后輸出單個值,某個典型的函數(shù)即是神經網絡中的損失函數(shù)。梯度會顯示出隨著變量輸入的增加輸出值增加的方向,換言之,如果我們要降低損失值則反梯度逆向前行即可。

Back Propagation:反向傳播

簡稱為Back prop,即將前向傳播輸入值計算得出的誤差反向傳遞到輸入值中,經常用于微積分中的鏈式調用。

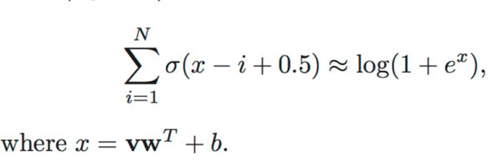

Sigmoid σ

用于將神經元的輸出結果限制在[0,1]范圍內的閾值函數(shù),該函數(shù)的輸出圖形看起來有點像S型,在希臘語中就是所謂Sigma。Sigmoid函數(shù)是Logistic函數(shù)的某個特例。

Rectified Linear Units or ReLU

Sigmoid函數(shù)的輸出間隔為[0,1],而ReLU的輸出范圍為[0,infinity],換言之Sigmoid更合適Logistic回歸而ReLU更適合于表示正數(shù)。深度學習中ReLU并不會受制于所謂的梯度消失問題(Vanishing Gradient Problem)。

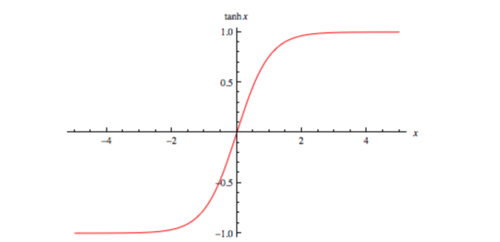

Tanh

Tanh函數(shù)有助于將你的網絡權重控制在[-1,1]之間,而且從上圖中可以看出,越靠近0的地方梯度值越大,并且梯度的范圍位于[0,1]之間,和Sigmoid函數(shù)的范圍一致,這一點也能有助于避免梯度偏差。

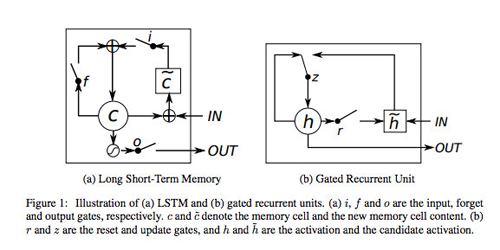

LSTM/GRU

最早見于Recurrent Neural Networks,不過同樣可以用于其他內存單元較少的地方。其主要可以在訓練中保持輸入的狀態(tài),從而避免之前因為RNN丟失輸入先驗上下文而導致的梯度消失問題。

Softmax

Softmax函數(shù)常用于神經網絡的末端以添加分類功能,該函數(shù)主要是進行多元邏輯斯蒂回歸,也就可以用于多元分類問題。通常會使用交叉熵作為其損失函數(shù)。

L1 & L2 Regularization

正則化項通過對系數(shù)添加懲罰項來避免過擬合,正則化項也能夠指明模型復雜度。L1與L2的區(qū)別在于L1能夠保證模型的稀疏性。引入正則化項能夠保證模型的泛化能力并且避免在訓練數(shù)據(jù)中過擬合。

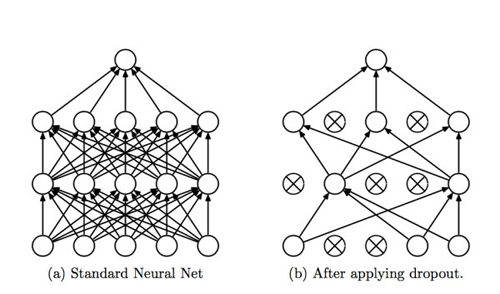

Drop out

Drop out同樣可以避免過擬合,并且能以近似指數(shù)的時間來合并多個不同的神經網絡結構。該方法會隨機地在每一層中選擇一些顯性層與隱層,在我們的實踐中通常會由固定比例的層Drop out決定。

Batch Normalization

在深度學習中,如果有太多的層次會導致所謂的Internal Covariate Shift,也就是訓練過程中因為網絡參數(shù)的變化導致網絡激活分布的變化。如果我們能減少這種變量遷移,我們能夠更快地訓練網絡。Batch Normalization則通過將每個處理塊進行正則化處理來解決這個問題。

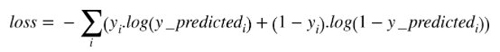

Objective Functions

也就是損失函數(shù)或者Optimization Score Function,某個深度學習網絡的目標即是最小化該函數(shù)值從而提升網絡的準確度。

F1/F Score

用于衡量某個模型的準確度的標準:

- F1 = 2 * (Precision * Recall) / (Precision + Recall)Precision = True Positives / (True Positives + False Positives)Recall = True Positives / (True Positives + False Negatives)

用于計算預測標簽值與真實標簽值之間的差距,基本的定義如下:

【本文是51CTO專欄作者“張梓雄 ”的原創(chuàng)文章,如需轉載請通過51CTO與作者聯(lián)系】