剖析DeepMind神經(jīng)網(wǎng)絡(luò)記憶研究:模擬動(dòng)物大腦實(shí)現(xiàn)連續(xù)學(xué)習(xí)

一、引言

我發(fā)現(xiàn)網(wǎng)絡(luò)上鋪天蓋地的人工智能相關(guān)信息中的絕大多數(shù)都可以分為兩類:一是向外行人士解釋進(jìn)展情況,二是向其他研究者解釋進(jìn)展。我還沒找到什么好資源能讓有技術(shù)背景但對(duì)不了解更前沿的進(jìn)展的人可以自己充電。我想要成為這中間的橋梁——通過(guò)為前沿研究提供(相對(duì))簡(jiǎn)單易懂的詳細(xì)解釋來(lái)實(shí)現(xiàn)。首先,讓我們從《Overcoming Catastrophic Forgetting in Neural Networks》這篇論文開始吧。

二、動(dòng)機(jī)

實(shí)現(xiàn)通用人工智能的關(guān)鍵步驟是獲得連續(xù)學(xué)習(xí)的能力,也就是說(shuō),一個(gè)代理(agent)必須能在不遺忘舊任務(wù)的執(zhí)行方法的同時(shí)習(xí)得如何執(zhí)行新任務(wù)。然而,這種看似簡(jiǎn)單的特性在歷史上卻一直未能實(shí)現(xiàn)。McCloskey 和 Cohen(1989)首先注意到了這種能力的缺失——他們首先訓(xùn)練一個(gè)神經(jīng)網(wǎng)絡(luò)學(xué)會(huì)了給一個(gè)數(shù)字加 1,然后又訓(xùn)練該神經(jīng)網(wǎng)絡(luò)學(xué)會(huì)了給數(shù)字加 2,但之后該網(wǎng)絡(luò)就不會(huì)給數(shù)字加 1 了。他們將這個(gè)問(wèn)題稱為「災(zāi)難性遺忘(catastrophic forgetting)」,因?yàn)樯窠?jīng)網(wǎng)絡(luò)往往是通過(guò)快速覆寫來(lái)學(xué)習(xí)新任務(wù),而這樣就會(huì)失去執(zhí)行之前的任務(wù)所必需的參數(shù)。

克服災(zāi)難性遺忘方面的進(jìn)展一直收效甚微。之前曾有兩篇論文《Policy Distillation》和《Actor-Mimic: Deep Multitask and Transfer Reinforcement Learning》通過(guò)在訓(xùn)練過(guò)程中提供所有任務(wù)的數(shù)據(jù)而在混合任務(wù)上實(shí)現(xiàn)了很好的表現(xiàn)。但是,如果一個(gè)接一個(gè)地引入這些任務(wù),那么這種多任務(wù)學(xué)習(xí)范式就必須維持一個(gè)用于記錄和重放訓(xùn)練數(shù)據(jù)的情景記憶系統(tǒng)(episodic memory system)才能獲得良好的表現(xiàn)。這種方法被稱為系統(tǒng)級(jí)鞏固(system-level consolidation),該方法受限于對(duì)記憶系統(tǒng)的需求,且該系統(tǒng)在規(guī)模上必須和被存儲(chǔ)的總記憶量相當(dāng);而隨著任務(wù)的增長(zhǎng),這種記憶的量也會(huì)增長(zhǎng)。

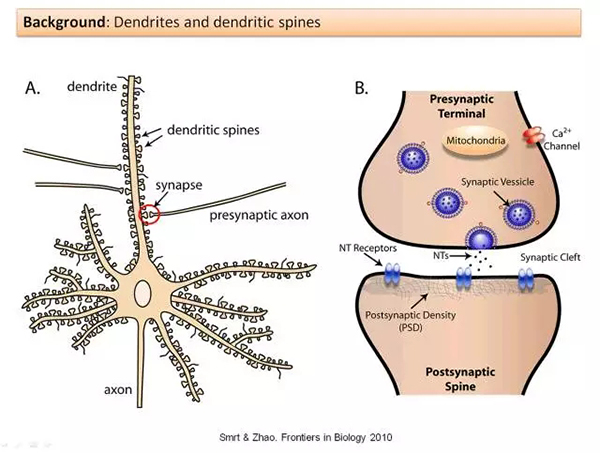

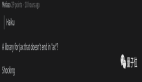

然而,你可能也直覺地想到了帶著一個(gè)巨大的記憶庫(kù)來(lái)進(jìn)行連續(xù)學(xué)習(xí)是錯(cuò)誤的——畢竟,人類除了能學(xué)會(huì)走路,也能學(xué)會(huì)說(shuō)話,而不需要維持關(guān)于學(xué)習(xí)如何走路的記憶。哺乳動(dòng)物的大腦是如何實(shí)現(xiàn)這一能力的?Yang, Pan and Gan (2009) 說(shuō)明學(xué)習(xí)是通過(guò)突觸后樹突棘(postsynaptic dendritic spines)隨時(shí)間而進(jìn)行的形成和消除而實(shí)現(xiàn)的。樹突棘是指「神經(jīng)元樹突上的突起,通常從突觸的單個(gè)軸突接收輸入」,如下所示:

具體而言,這些研究者檢查了小鼠學(xué)習(xí)過(guò)針對(duì)特定新任務(wù)的移動(dòng)策略之后的大腦。當(dāng)這些小鼠學(xué)會(huì)了***的移動(dòng)方式之后,研究者觀察到樹突棘形成出現(xiàn)了顯著增多。為了消除運(yùn)動(dòng)可能導(dǎo)致樹突棘形成的額外解釋,這些研究者還設(shè)置了一個(gè)進(jìn)行運(yùn)動(dòng)的對(duì)照組——這個(gè)組沒有觀察到樹突棘形成。然后這些研究者還注意到,盡管大多數(shù)新形成的樹突棘后面都消失了,但仍有一小部分保留了下來(lái)。2015 年的另一項(xiàng)研究表明當(dāng)特定的樹突棘被擦除時(shí),其對(duì)應(yīng)的技能也會(huì)隨之消失。

Kirkpatrick et. 在論文《Overcoming catastrophic forgetting in neural networks》中提到:「這些實(shí)驗(yàn)發(fā)現(xiàn)……說(shuō)明在新大腦皮層中的連續(xù)學(xué)習(xí)依賴于特定于任務(wù)的突觸鞏固(synaptic consolidation),其中知識(shí)是通過(guò)使一部分突觸更少塑性而獲得持久編碼的,所以能長(zhǎng)時(shí)間保持穩(wěn)定。」我們能使用類似的方法(根據(jù)每個(gè)神經(jīng)元的重要性來(lái)改變單個(gè)神經(jīng)元的可塑性)來(lái)克服災(zāi)難性遺忘嗎?

這篇論文的剩余部分推導(dǎo)并演示了他們的初步答案:可以。

三、直覺

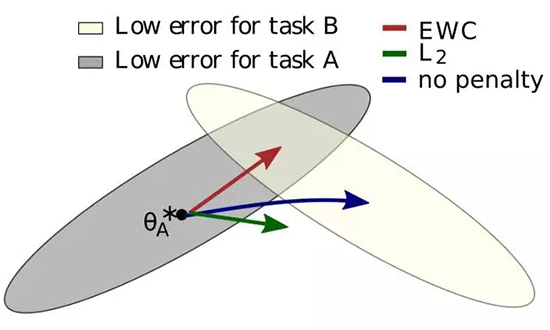

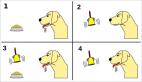

假設(shè)有兩個(gè)任務(wù) A 和 B,我們想要一個(gè)神經(jīng)網(wǎng)絡(luò)按順序?qū)W習(xí)它們。當(dāng)我們談到一個(gè)學(xué)習(xí)任務(wù)的神經(jīng)網(wǎng)絡(luò)時(shí),它實(shí)際上意味著讓神經(jīng)網(wǎng)絡(luò)調(diào)整權(quán)重和偏置(統(tǒng)稱參數(shù)/θ)以使得神經(jīng)網(wǎng)絡(luò)在該任務(wù)上實(shí)現(xiàn)更好的表現(xiàn)。之前的研究表明對(duì)于大型網(wǎng)絡(luò)而言,許多不同的參數(shù)配置可以實(shí)現(xiàn)類似的表現(xiàn)。通常,這意味著網(wǎng)絡(luò)被過(guò)參數(shù)化了,但是我們可以利用這一點(diǎn):過(guò)參數(shù)化(overparameterization)能使得任務(wù) B 的配置可能接近于任務(wù) A 的配置。作者提供了有用的圖形:

在圖中,θ∗A 代表在 A 任務(wù)中表現(xiàn)***的 θ 的配置,還存在多種參數(shù)配置可以接近這個(gè)表現(xiàn),灰色表示這一配置的集合;在這里使用橢圓來(lái)表示是因?yàn)橛行﹨?shù)的調(diào)整權(quán)重比其他參數(shù)更大。如果神經(jīng)網(wǎng)絡(luò)隨后被設(shè)置為學(xué)習(xí)任務(wù) B 而對(duì)記住任務(wù) A 沒有任何興趣(即遵循任務(wù) B 的誤差梯度),則該網(wǎng)絡(luò)將在藍(lán)色箭頭的方向上移動(dòng)其參數(shù)。B 的***解也具有類似的誤差橢圓體,上面由白色橢圓表示。

然而,我們還想記住任務(wù) A。如果我們只是簡(jiǎn)單使參數(shù)固化,就會(huì)按綠色箭頭發(fā)展,則處理任務(wù) A 和 B 的性能都將變得糟糕。***的辦法是根據(jù)參數(shù)對(duì)任務(wù)的重要程度來(lái)選擇其固化的程度;如果這樣的話,神經(jīng)網(wǎng)絡(luò)參數(shù)的變化方向?qū)⒆裱t色箭頭,它將試圖找到同時(shí)能夠很好執(zhí)行任務(wù) A 和 B 的配置。作者稱這種算法「彈性權(quán)重鞏固(EWC/Elastic Weight Consolidation)」。這個(gè)名稱來(lái)自于突觸鞏固(synaptic consolidation),結(jié)合「彈性的」錨定參數(shù)(對(duì)先前解決方案的約束限制參數(shù)是二次的,因此是彈性的)。

四、數(shù)學(xué)解釋

在這里存在兩個(gè)問(wèn)題。***,為什么錨定函數(shù)是二次的?第二,如何判定哪個(gè)參數(shù)是「重要的」?

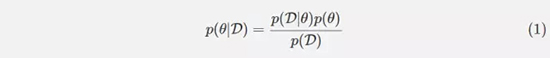

在回答這兩個(gè)問(wèn)題之前,我們先要明白從概率的角度來(lái)理解神經(jīng)網(wǎng)絡(luò)的訓(xùn)練意味著什么。假設(shè)我們有一些數(shù)據(jù) D,我們希望找到***可能性的參數(shù),它被表示為 p(θ|D)。我們可以是用貝葉斯規(guī)則來(lái)計(jì)算這個(gè)條件概率。

如果我們應(yīng)用對(duì)數(shù)變換,則方程可以被重寫為:

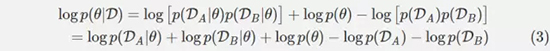

假設(shè)數(shù)據(jù) D 由兩個(gè)獨(dú)立的(independent)部分構(gòu)成,用于任務(wù) A 的數(shù)據(jù) DA 和用于任務(wù) B 的數(shù)據(jù) DB。這個(gè)邏輯適用于多于兩個(gè)任務(wù),但在這里不用詳述。使用獨(dú)立性(independence)的定義,我們可以重寫這個(gè)方程:

看看(3)右邊的中間三個(gè)項(xiàng)。它們看起來(lái)很熟悉嗎?它們應(yīng)該。這三個(gè)項(xiàng)是方程(2)的右邊,但是 D 被 DA 代替了。簡(jiǎn)單來(lái)說(shuō),這三個(gè)項(xiàng)等價(jià)于給定任務(wù) A 數(shù)據(jù)的網(wǎng)絡(luò)參數(shù)的條件概率的對(duì)數(shù)。這樣,我們得到了下面這個(gè)方程:

讓我們先解釋一下方程(4)。左側(cè)仍然告訴我們?nèi)绾斡?jì)算整個(gè)數(shù)據(jù)集的 p(θ| D),但是當(dāng)求解任務(wù) A 時(shí)學(xué)習(xí)的所有信息都包含在條件概率 p(θ| DA)中。這個(gè)條件概率可以告訴我們哪些參數(shù)在解決任務(wù) A 中很重要。

下一步是不明確的:「真實(shí)的后驗(yàn)概率是難以處理的,因此,根據(jù) Mackay (19) 對(duì)拉普拉斯近似的研究,我們將該后驗(yàn)近似為一個(gè)高斯分布,其帶有由參數(shù)θ∗A 給定的均值和一個(gè)由 Fisher 信息矩陣 F 的對(duì)角線給出的對(duì)角精度。」

讓我們?cè)敿?xì)解釋一下。首先,為什么真正的后驗(yàn)概率難以處理?論文并沒有解釋,答案是:貝葉斯規(guī)則告訴我們

p(θ|DA) 取決于 p(DA)=∫p(DA|θ′)p(θ′)dθ′,其中θ′是參數(shù)空間中的參數(shù)的可能配置。通常,該積分沒有封閉形式的解,留下數(shù)值近似以作為替代。數(shù)值近似的時(shí)間復(fù)雜性相對(duì)于參數(shù)的數(shù)量呈指數(shù)級(jí)增長(zhǎng),因此對(duì)于具有數(shù)億或更多參數(shù)的深度神經(jīng)網(wǎng)絡(luò),數(shù)值近似是不實(shí)際的。

然后,Mackay 關(guān)于拉普拉斯近似的工作是什么,跟這里的研究有什么關(guān)系?我們使用θ*A 作為平均值,而非數(shù)值近似后驗(yàn)分布,將其建模為多變量正態(tài)分布。方差呢?我們將把每個(gè)變量的方差指定為方差的倒數(shù)的精度。為了計(jì)算精度,我們將使用 Fisher 信息矩陣 F。Fisher 信息是「一種測(cè)量可觀察隨機(jī)變量 X 攜帶的關(guān)于 X 所依賴的概率的未知參數(shù)θ的信息的量的方法。」在我們的例子中,我們感興趣的是測(cè)量來(lái)自 DA 的每個(gè)數(shù)據(jù)所攜帶的關(guān)于θ的信息的量。Fisher 信息矩陣比數(shù)值近似計(jì)算更可行,這使得它成為一個(gè)有用的工具。

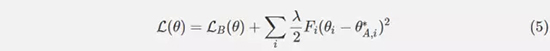

因此,我們可以為我們的網(wǎng)絡(luò)在任務(wù) A 上訓(xùn)練后在任務(wù) B 上再定義一個(gè)新的損失函數(shù)。讓 LB(θ)僅作為任務(wù) B 的損失。如果我們用 i 索引我們的參數(shù),并且選擇標(biāo)量λ來(lái)影響任務(wù) A 對(duì)任務(wù) B 的重要性,則在 EWC 中最小化的函數(shù) L 是:

作者聲稱,EWC 具有相對(duì)于網(wǎng)絡(luò)參數(shù)的數(shù)量和訓(xùn)練示例的數(shù)量是線性的運(yùn)行時(shí)間。

五、實(shí)驗(yàn)和結(jié)果

1. 隨機(jī)模式

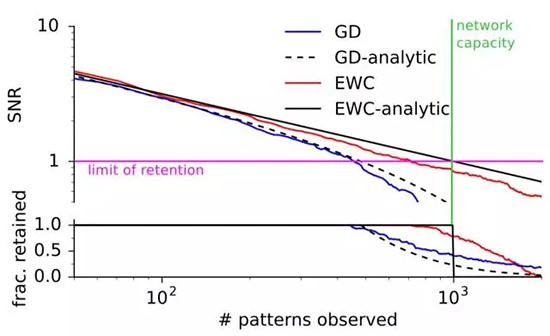

EWC 的***個(gè)測(cè)試是簡(jiǎn)單地看它能否比梯度下降(GD)更長(zhǎng)時(shí)間地記住簡(jiǎn)單的模式。這些研究者訓(xùn)練了一個(gè)可將隨機(jī)二元模式和二元結(jié)果關(guān)聯(lián)起來(lái)的神經(jīng)網(wǎng)絡(luò)。如果該網(wǎng)絡(luò)看到了一個(gè)之前見過(guò)的二元模式,那么就通過(guò)觀察其信噪比是否超過(guò)了一個(gè)閾值來(lái)評(píng)價(jià)其是否已經(jīng)「記住」了該模式。使用這種簡(jiǎn)單測(cè)試的原因是其具有一個(gè)分析解決方案。隨著模式數(shù)量的增加,EWC 和 GD 的表現(xiàn)都接近了它們的***答案。但是 EWC 能夠記憶比 GD 遠(yuǎn)遠(yuǎn)更多的模式,如下圖所示:

2. MNIST

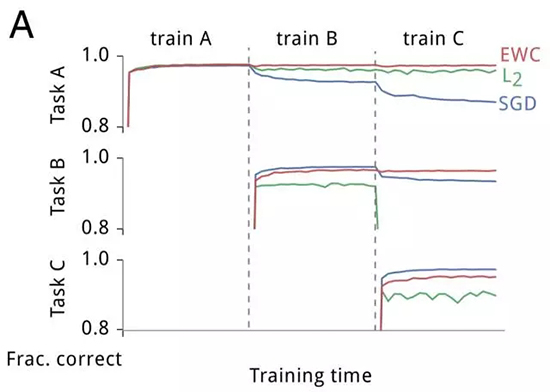

這些研究者為 EWC 所進(jìn)行的第二個(gè)測(cè)試是一個(gè)修改過(guò)的 MNIST 版本。其沒有使用被給出的數(shù)據(jù),而是生成了三個(gè)隨機(jī)的排列(permutation),并將每個(gè)排列都應(yīng)用到該數(shù)據(jù)集中的每張圖像上。任務(wù) A 是對(duì)被***個(gè)排列轉(zhuǎn)換過(guò)的 MNIST 圖像中的數(shù)字進(jìn)行分類,任務(wù) B 是對(duì)被第二個(gè)排列轉(zhuǎn)換過(guò)的圖像中的數(shù)字進(jìn)行分類,任務(wù) C 類推。這些研究者構(gòu)建了一個(gè)全連接的深度神經(jīng)網(wǎng)絡(luò)并在任務(wù) A、B 和 C 上對(duì)該網(wǎng)絡(luò)進(jìn)行了訓(xùn)練,同時(shí)在任務(wù) A(在 A 上的訓(xùn)練完成后)、B(在 B 上的訓(xùn)練完成后)和 C(在 C 上的訓(xùn)練完成后)上測(cè)試了該網(wǎng)絡(luò)的表現(xiàn)。訓(xùn)練是分別使用隨機(jī)梯度下降(SGD)、使用 L2 正則化的均勻參數(shù)剛度(uniform parameter-rigidity using L2 regularization)、EWC 獨(dú)立完成的。下面是它們的結(jié)果:

如預(yù)期的一樣,SGD 出現(xiàn)了災(zāi)難性遺忘;在任務(wù) B 上訓(xùn)練后在任務(wù) A 上的表現(xiàn)出現(xiàn)了快速衰退,在任務(wù) C 上訓(xùn)練后更是進(jìn)一步衰退。使參數(shù)更剛性能維持在***個(gè)任務(wù)上的表現(xiàn),但卻不能學(xué)習(xí)后續(xù)的任務(wù)。而 EWC 能在成功學(xué)習(xí)新任務(wù)的同時(shí)記住如何執(zhí)行之前的任務(wù)。隨著任務(wù)數(shù)量的增加,EWC 也能維持相對(duì)較好的表現(xiàn),相對(duì)地,帶有 dropout 正則化的 SGD 的表現(xiàn)會(huì)持續(xù)下降,如下所示:

3. Atari 2600

DeepMind 曾在更早的一篇論文中表明:當(dāng)一次訓(xùn)練和測(cè)試一個(gè)游戲時(shí),深度 Q 網(wǎng)絡(luò)(DQN)能夠在多種 Atari 2600 游戲上實(shí)現(xiàn)超人類的表現(xiàn)。為了了解 EWC 可以如何在這種更具挑戰(zhàn)性的強(qiáng)化學(xué)習(xí)環(huán)境中實(shí)現(xiàn)連續(xù)學(xué)習(xí),這些研究者對(duì)該 DQN 代理進(jìn)行了修改,使其能夠使用 EWC。但是,他們還需要做出一項(xiàng)額外的修改:在哺乳動(dòng)物的連續(xù)學(xué)習(xí)中,為了確定一個(gè)代理當(dāng)前正在學(xué)習(xí)的任務(wù),必需要一個(gè)高層面的系統(tǒng),但該 DQN 代理完全不能做出這樣的確定。為了解決這個(gè)問(wèn)題,研究者為其添加了一個(gè)基于 forget-me-not(FMN)過(guò)程的在線聚類算法,使得該 DQN 代理能夠?yàn)槊恳粋€(gè)推斷任務(wù)維持各自獨(dú)立的短期記憶緩存。

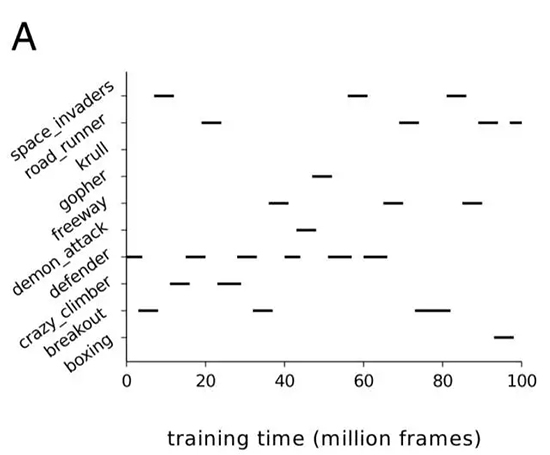

這就得到了一個(gè)能夠跨兩個(gè)時(shí)間尺度進(jìn)行學(xué)習(xí)的 DQN 代理。在短期內(nèi),DQN 代理可以使用 SGD 等優(yōu)化器(本案例中研究者使用了 RMSProp)來(lái)從經(jīng)歷重放(experience replay)機(jī)制中學(xué)習(xí)。在長(zhǎng)期內(nèi),該 DQN 代理使用 EWC 來(lái)鞏固其從各種任務(wù)上學(xué)習(xí)到的知識(shí)。研究者從 DQN 實(shí)現(xiàn)了人類水平表現(xiàn)的 Atari 游戲(共 19 個(gè))中隨機(jī)選出了 10 個(gè),然后該代理在每個(gè)單獨(dú)的游戲上訓(xùn)練了一段時(shí)間,如下所示:

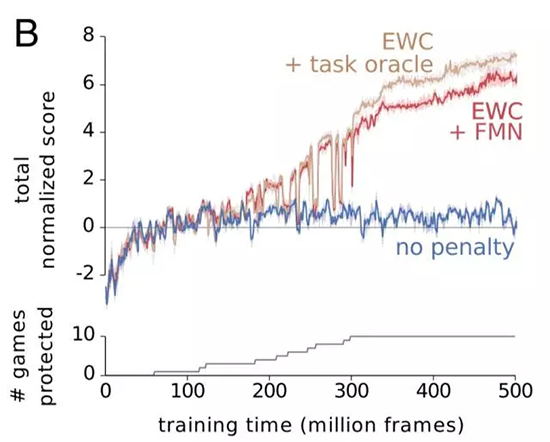

這些研究者對(duì)三個(gè)不同的 DQN 的代理進(jìn)行了比較。藍(lán)色代理沒有使用 EWC,紅色代理使用了 EWC 和 forget-me-not 任務(wù)標(biāo)識(shí)符。褐色代理則使用 EWC,并被提供了真實(shí)任務(wù)標(biāo)簽。在一個(gè)任務(wù)上實(shí)現(xiàn)人類水平的表現(xiàn)被規(guī)范化為分?jǐn)?shù) 1。如你所見,EWC 在這 10 個(gè)任務(wù)上都實(shí)現(xiàn)了接近人類水平的表現(xiàn),而非 EWC 代理沒能在一個(gè)以上的任務(wù)上做到這一點(diǎn)。該代理是否被給出了一個(gè)真實(shí)標(biāo)簽或是否必須對(duì)任務(wù)進(jìn)行推導(dǎo)對(duì)結(jié)果的影響不大,但我認(rèn)為這也表明了 FMN 過(guò)程的成果,而不僅僅是 EWC 的成功。

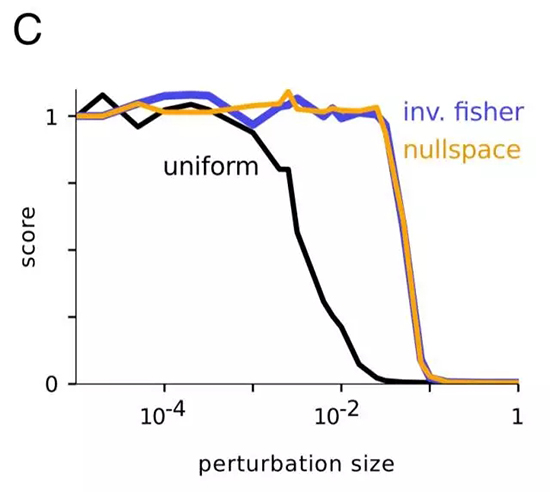

接下來(lái)的這個(gè)部分非常酷。如前所述,EWC 并沒有在這 10 個(gè)任務(wù)上實(shí)現(xiàn)人類水平的表現(xiàn)。為什么會(huì)這樣?一個(gè)可能的原因是 Fisher 信息矩陣可能對(duì)參數(shù)重要程度的估計(jì)不佳。為了實(shí)際驗(yàn)證這一點(diǎn),這些研究者研究了在僅一個(gè)游戲上訓(xùn)練的代理的權(quán)重。不管這個(gè)游戲是什么游戲,它們都表現(xiàn)出了以下模式:如果權(quán)重受到了一個(gè)均勻隨機(jī)擾動(dòng)的影響,隨著該擾動(dòng)的增加,該代理的表現(xiàn)(規(guī)范化為 1)會(huì)下降;而如果權(quán)重受到的擾動(dòng)得到了 Fisher 信息的對(duì)角線的逆的影響,那么該分?jǐn)?shù)在面臨更大的擾動(dòng)時(shí)也能保持穩(wěn)定。這說(shuō)明 Fisher 信息在確定參數(shù)的真正重要性方面是很好的。

然后,研究者嘗試在 null 空間中進(jìn)行擾動(dòng)。這本來(lái)應(yīng)該是無(wú)效的,但實(shí)際上研究者觀察到了與逆 Fisher 空間中的結(jié)果類似的結(jié)果。這說(shuō)明使用 Fisher 信息矩陣會(huì)導(dǎo)致將一些重要參數(shù)標(biāo)記為不重要的情況——「因此很有可能當(dāng)前實(shí)現(xiàn)的主要限制是其低估了參數(shù)的不確定性。」

六、討論

1. 貝葉斯說(shuō)明

作者們對(duì) EWC 給出了非常好的貝葉斯解讀:「正式來(lái)說(shuō),當(dāng)需要學(xué)習(xí)新的任務(wù)時(shí),網(wǎng)絡(luò)參數(shù)被先驗(yàn)所調(diào)節(jié),也就是先前任務(wù)在給定數(shù)據(jù)參數(shù)上的后驗(yàn)分布。這能實(shí)現(xiàn)先驗(yàn)任務(wù)被約束的更快的參數(shù)學(xué)習(xí)率,并為重要的參數(shù)降低學(xué)習(xí)率。」

2. 重疊

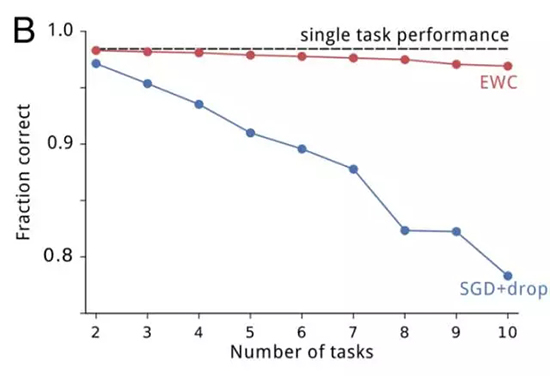

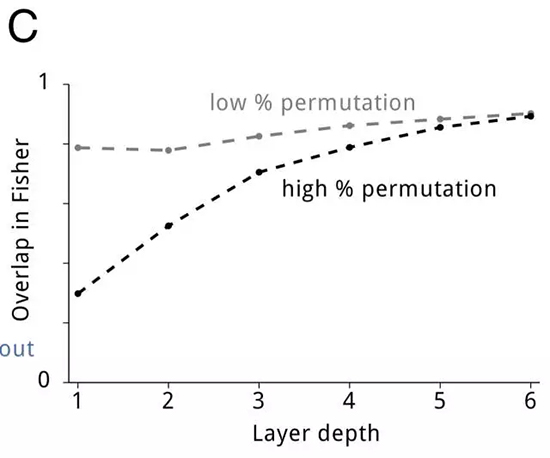

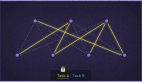

在剛開始時(shí),我提到神經(jīng)網(wǎng)絡(luò)的過(guò)參數(shù)化(overparameterization)讓 EWC 能實(shí)現(xiàn)優(yōu)異的表現(xiàn)。有一個(gè)很合理的問(wèn)題就是:為了每個(gè)不同的任務(wù)將網(wǎng)絡(luò)劃分到特定部分,這些神經(jīng)網(wǎng)絡(luò)能否給出更好的表現(xiàn)?或者通過(guò)共享表征,這些網(wǎng)絡(luò)是否能高效地使用其能力?為了解答這個(gè)問(wèn)題,作者們測(cè)量了任務(wù)對(duì)在 Fisher 信息矩陣上的重疊情況(Fisher Overlap)。對(duì)高度類似的任務(wù)(例如只有一點(diǎn)不同的兩個(gè)隨機(jī)排列)而言,F(xiàn)isher Overlap 相當(dāng)高。即使不相似的任務(wù),F(xiàn)isher Overlap 也高于 0。隨著網(wǎng)絡(luò)深度的增加,F(xiàn)isher Overlap 也會(huì)增加。下圖演示了該結(jié)果:

3. 突觸可塑性的理論

研究者還討論了 EWC 可能能為神經(jīng)可塑性方面的研究提供信息。級(jí)聯(lián)(Cascade)理論企圖構(gòu)建突觸狀態(tài)的模型來(lái)對(duì)可塑性和穩(wěn)定性建模。盡管 EWC 不能隨時(shí)間緩和參數(shù),也因此不能遺忘先前的信息,但 EWC 和級(jí)聯(lián)都能通過(guò)讓突觸更不可塑而延展記憶穩(wěn)定性。最近的一項(xiàng)研究提出除了存儲(chǔ)自身的實(shí)際權(quán)重之外,突觸也存儲(chǔ)當(dāng)前權(quán)重的不確定性。EWC 是該思路的延展:在 EWC 中,每個(gè)突觸存儲(chǔ)三個(gè)值:權(quán)重、均值和方差。

七、總結(jié)

- 沒有遺忘的連續(xù)學(xué)習(xí)任務(wù)對(duì)智能而言很有必要;

- 研究表明哺乳動(dòng)物大腦中的突觸鞏固有助于實(shí)現(xiàn)連續(xù)學(xué)習(xí);

- EWC 通過(guò)讓重要參數(shù)變的更可塑,從而模擬人工神經(jīng)網(wǎng)絡(luò)中的突觸鞏固;

- EWC 應(yīng)用于神經(jīng)網(wǎng)絡(luò)時(shí)表現(xiàn)出了比 SGB 更好的表現(xiàn),而且在更大范圍上有一致的參數(shù)穩(wěn)定性;

- EWC 提供了說(shuō)明權(quán)重鞏固是連續(xù)學(xué)習(xí)的基礎(chǔ)的線索證據(jù)。

原文:http://rylanschaeffer.github.io/content/research/overcoming_catastrophic_forgetting/main.html

【本文是51CTO專欄機(jī)構(gòu)機(jī)器之心的原創(chuàng)譯文,微信公眾號(hào)“機(jī)器之心( id: almosthuman2014)”】