云計算運維之“輕”與“重”

云計算作為改變世界的力量,已經(jīng)開始在各種應用實現(xiàn)中被不斷印證,而現(xiàn)在還只是云計算生命周期的啟航,這場變革的演進一定會超乎大多數(shù)人的想象。早些年,當我讀到尼古拉斯·卡爾《IT不再重要》(The Big Switch: Rewiring the World, from Edison to Google)這類文章的時候,對于云計算所具備水、電般屬性的勾勒,既為之興奮,又苦惱無法為具化這些屬性找到實踐支撐。而最近三年來,云計算發(fā)展風生水起,以我這三年切身參與阿里云計算產(chǎn)品實現(xiàn)和落地的過程為例,恰好是云計算從“虛”到“實”變革演進的一個縮影。這過程中,我對于云計算運維在不斷理解、摸索和實現(xiàn)中重構(gòu)。本篇文章,即是對于云計算運維階段性積累的部分分享。

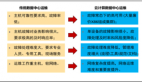

云計算是公共資源,是一臺超級計算機,大規(guī)模,低成本,可服務,是互聯(lián)網(wǎng)時代的水和電… 云計算貼有很多這樣的標簽(Tag),但云計算時代的運維,到底為開發(fā)者和云計算平臺運營商帶來了怎樣的Big Switch? 我的答案是運維之“輕”與“重”的轉(zhuǎn)移,這“輕”與“重”的背后,體現(xiàn)了云計算運維和傳統(tǒng)運維的差異性和核心競爭力的轉(zhuǎn)移。

傳統(tǒng)運維之“重”

傳統(tǒng)網(wǎng)站的運維模式、業(yè)務和規(guī)模上雖然各有差異,但在結(jié)構(gòu)上都很相似,從最底層的IDC(數(shù)據(jù)中心)、網(wǎng)絡、服務器和系統(tǒng)等基礎運維,到上層數(shù)據(jù)庫、安全和產(chǎn)品等應用運維,需要環(huán)環(huán)相扣,層層覆蓋。尤其對于一些小、微型開發(fā)者,麻雀雖小也要五臟俱全,各種運維任務如同一輛滿載的貨車,面對惡劣的路況(激烈的市場環(huán)境),為了保持行駛速度,要不斷加油和維修(網(wǎng)站運維持續(xù)投入人力、物力,避免運維成為阻礙自身發(fā)展的瓶頸);另一方面,由于運維所具有的專業(yè)性、規(guī)模化和周期性等特點,使得運維投入所換來的產(chǎn)出往往又不如人意。傳統(tǒng)網(wǎng)站的運維模式,令許多網(wǎng)站不堪重負。

圖1 云計算給開發(fā)商帶來的變化

開發(fā)者運維之“輕”

在云計算時代,對于開發(fā)者的變化是什么?隨著開發(fā)者的網(wǎng)站“上云”,開發(fā)者的網(wǎng)站運維將變得很輕、很薄。開發(fā)者可以集中優(yōu)勢資源專注于自身產(chǎn)品的研發(fā)和運營,把這部分核心競爭力做重、做厚。而產(chǎn)品的絕大部分網(wǎng)站運維工作隱身在背后那朵云里,由云計算平臺運營商實現(xiàn)。對于開發(fā)者而言,云計算時代的網(wǎng)站運維可以舉重若輕,如同將原來滿載的貨車,換成了快捷的跑車,輕松上路。例如,阿里云某開發(fā)者客戶,自行維護網(wǎng)站時,需要10人以上的專屬運維團隊,經(jīng)常面臨網(wǎng)站高可用性、安全事件和設備成本投入等挑戰(zhàn),遷移到阿里云平臺后,應用彈性計算ECS、負載均衡SLB、云盾和關(guān)系型數(shù)據(jù)庫RDS等產(chǎn)品,其10多人的運維團隊資源得到釋放,可以補充到產(chǎn)品研發(fā)和運營中;網(wǎng)站高可用性得到提升;成本控制更具彈性。

云計算平臺運營商運維之“重”

開發(fā)者實現(xiàn)網(wǎng)站運維之“輕”,并不是網(wǎng)站運維的挑戰(zhàn)在云計算平臺上真的減輕,而是這部分工作由云計算平臺運營商來提供更專業(yè)的運維保障服務。撥開云霧,我們會發(fā)現(xiàn)云背后所承載的運維實現(xiàn)構(gòu)成了云計算平臺運營商的運維之“重”。“重”在這里有兩層含義。一是“量”之“重”,以阿里云為例,所有的云產(chǎn)品都運行在“飛天”大規(guī)模云計算平臺上,運維在保障這個平臺服務質(zhì)量中扮演著核心角色,從運維人員組織、過程改進、系統(tǒng)優(yōu)化到運維支撐自動化系統(tǒng)等,各個環(huán)節(jié)都緊密圍繞云計算平臺特性進行協(xié)同。如何實現(xiàn)云計算運維的最佳實踐,所涉及的技術(shù)難度、優(yōu)化改進和操作強度在“量”上非常之“重”。二是“責任”之“重”,云計算平臺的服務質(zhì)量,直接關(guān)系到其上承載的萬千開發(fā)者產(chǎn)品的可用性、口碑和生命力。過去3年,阿里云的開發(fā)者,包括我們的客戶、合作伙伴,真正教會阿里云如何去實現(xiàn)一個云計算平臺,讓我們認識到所運營的云計算平臺,如何關(guān)乎開發(fā)者切身利益,關(guān)乎生態(tài)系統(tǒng)的健康發(fā)展,責任“重”大。#p#

云計算改變運維

云計算平臺服務端的復雜性和創(chuàng)新性,對于運維是個全新的挑戰(zhàn),運維思路和方式都為之發(fā)生改變。這種改變不是簡單的在傳統(tǒng)運維上的優(yōu)化,而是基于云計算特征孕育而生的運維重構(gòu);這種改變也并非一蹴而就,是隨著云計算平臺的發(fā)展過程不斷演進,許多都沒有最佳實踐可循,是在摸著石頭過河中不斷積累經(jīng)驗。相對傳統(tǒng)的網(wǎng)站運維,云計算平臺運維的主要特征如下。

集群是基本運維單位:組成云計算平臺的節(jié)點都是普通PC服務器,平臺的高可用性,不再借助傳統(tǒng)的高投入服務器硬件冗余方案(RAID、網(wǎng)絡雙上連、雙電源等)實現(xiàn),而是通過云計算平臺自身的魯棒性保障。這需要運維改變視角,從原來把服務器作為基本運維單位,轉(zhuǎn)變?yōu)橐约鹤鳛榛具\維單位。傳統(tǒng)運維場景下的“及時”維修服務器,在云計算場景下,可以“輕松”定期維修。而這種“輕松”,并不是對運維需求的降低,而是基于對集群整體容量和健康狀態(tài)的管理能力,即通過有效提煉和過濾各種服務器的個體運行狀態(tài),映射出集群的整體狀態(tài)的能力。集群的容量管理、部署、監(jiān)控、故障管理等運維任務,都必須以集群為單位進行。

大規(guī)模:單集群的規(guī)模,是衡量云計算平臺能力的重要指標之一。對于生產(chǎn)環(huán)境而言,云計算集群也必須達到一定規(guī)模,才能實現(xiàn)云計算平臺的高可用、低成本等真正價值。因此,在進行運維的規(guī)劃和實現(xiàn)時,都要以滿足大規(guī)模為必要條件。

可運維性是云平臺基本屬性:集群可運維性包括實現(xiàn)高效和大規(guī)模的部署、升級、遷移、擴容和故障管理等運維任務,是集群必須具備的能力。云平臺從第一天設計開始,就必須包括該屬性。開發(fā)團隊和運維團隊需要緊密協(xié)同,結(jié)合平臺和運維特性加以實現(xiàn)。較之傳統(tǒng)運維,云計算平臺對于大規(guī)模集群的可運維性、可管理性等的要求高很多,是集群落地的剛性需求。

規(guī)范化:要在大規(guī)模下,實現(xiàn)集群部署、遷移、擴容等管理,依賴于從IDC設計、網(wǎng)絡設計、服務器選型到云平臺實現(xiàn)的全局統(tǒng)籌的規(guī)范化,這如同統(tǒng)一“度量衡”,實現(xiàn)“車同軌,書同文,行同倫”。規(guī)范化構(gòu)成了云計算One Infrastructure重要屬性。基于One Infrastructure的實現(xiàn),把一批服務器從A集群遷移到B集群,只是在集群管理系統(tǒng)上對配置的遠程變更,而不需要物理服務器實際搬遷。#p#

解構(gòu)阿里云平臺運維

組織建設

阿里巴巴集團技術(shù)保障是“一個”團隊(one team),阿里云、天貓、淘寶、etao、雅虎中國等阿里巴巴集團旗下產(chǎn)品,都由這個團隊統(tǒng)一進行技術(shù)保障。團隊的統(tǒng)一,可以確保運維體系的統(tǒng)一和運維資源的充分共享。換言之,阿里云的運維體系、網(wǎng)絡質(zhì)量、安全和支撐能力等和淘寶、天貓由同一個技術(shù)保障團隊護航,在同一個支撐平臺下實現(xiàn)。技術(shù)保障團隊組織建設分橫向、縱向兩個維度。其中,縱向按照技術(shù)職能劃分,主要包括基礎運維、應用運維、DBA、安全和平臺支撐等專業(yè)團隊,確保各領域的專業(yè)性和技術(shù)深度;橫向為了保障重點產(chǎn)品和項目,打破了團隊界限,圍繞產(chǎn)品建立“護航小組”。例如,阿里云彈性計算護航小組,成員包括平臺和應用運維、DBA、安全和過程改進工程師,在2012年7-8月CCTV 5+網(wǎng)站奧運保障期間,該護航小組貫穿容量管理、壓測、預案、性能優(yōu)化、故障演練、重點賽事保障和資源彈性分配等全過程,之前團隊間的任務,在“護航小組”模式下,變?yōu)閳F隊內(nèi)的任務,各角色緊密協(xié)同,發(fā)揮各自優(yōu)勢,上下游通暢,其高效、專注的工作特點取得良好的成效。

過程改進

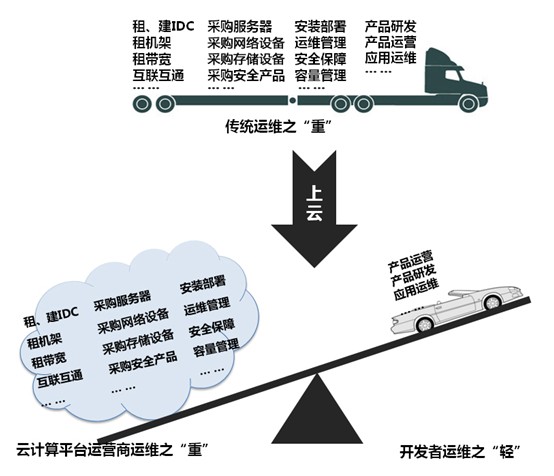

如圖2所示,運維過程從左到右將一個產(chǎn)品的生命周期中的業(yè)務研發(fā)、發(fā)布變更到生產(chǎn)運維貫穿起來。各個階段的流程均具備可量化的KPI指標,能夠清晰指示產(chǎn)品運維的健康程度和優(yōu)化方向。例如,“生產(chǎn)變更提前計劃率”可以指示一個產(chǎn)品發(fā)布的計劃性和規(guī)范性,避免因為發(fā)布管理不善,而引發(fā)線上故障的風險。這3年阿里云的發(fā)展讓我們深刻認識到,由于云計算平臺自身的技術(shù)復雜性、大規(guī)模等特點,使得故障具備全局性、泛洪等特點,因此規(guī)范的運維流程和制度保障至關(guān)重要。

圖2 云計算運維過程的改進

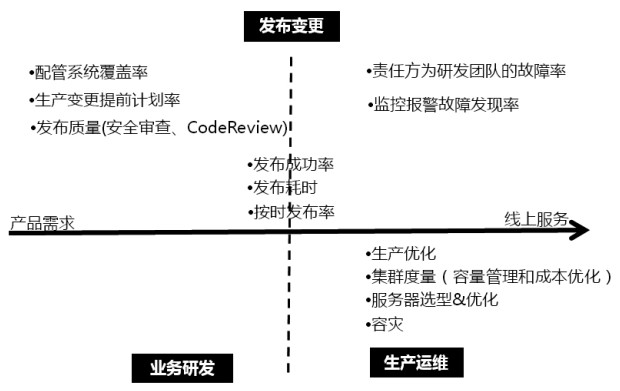

支撐系統(tǒng)

云計算平臺和產(chǎn)品的高可用性實現(xiàn),大規(guī)模、穩(wěn)定、成本和效率之間的有效結(jié)合,都依賴于一套健壯、實用的運維支撐體系。服務于阿里云的運維支撐體系不是簡單套用ITIL或拼湊開源運維工具,而是根據(jù)云計算集群大規(guī)模分布式的特點,由飛天和技術(shù)保障開發(fā)團隊自主研發(fā)并不斷完善中的一套系統(tǒng),其子系統(tǒng)主要包括:基礎運維、配置管理、生產(chǎn)變更、故障管理、集群容量、監(jiān)控、集群運維等部分。從快速部署一套包括幾千個計算、存儲節(jié)點的飛天集群,到監(jiān)控集群上萬的任務和服務對象,運維支撐系統(tǒng)在可管理、可擴展、健壯性和自動化程度的提升,既是解放運維生產(chǎn)力的過程,也是云計算是否真正落地的重要標志之一。圍繞飛天平臺運維保障,從操作系統(tǒng)安裝、飛天平臺搭建、應用部署、變更發(fā)布、監(jiān)控、容量管理、儀表盤(Dashboard),都有專門的運維工具實現(xiàn),并且工具之間相互關(guān)聯(lián)和協(xié)同。

圖3 云計算運維過程的改進#p#

云運維面臨的挑戰(zhàn)

高可用!開發(fā)者需要一個安全、高可用的網(wǎng)站環(huán)境開展業(yè)務,因此如何確保云計算平臺和產(chǎn)品提供高可用性服務,是我們一直投入最大力量之所在。以故障管理為例,據(jù)相關(guān)機構(gòu)統(tǒng)計,2012年國際知名云計算公司,先后發(fā)生多起云服務中斷事件,此類事件的數(shù)量較2011年呈上升趨勢,故障影響的周期從小時到天級別。分析這些故障背后的觸發(fā)因素,包括代碼Bug、IDC電力故障、網(wǎng)絡故障、設備故障、配置變更錯誤等諸多因素,可見云計算的風險隱患較之傳統(tǒng)網(wǎng)站并不少,結(jié)合云計算平臺自身所具備的大規(guī)模等特點,故障在云計算集群因為規(guī)模化而存在被放大的隱患,故障恢復也因為海量數(shù)據(jù)等因素而延長,所以如何對于故障進行容錯、容災、有效隔離影響和快速恢復對于云計算運營商至關(guān)重要。面對這些挑戰(zhàn),阿里云產(chǎn)品開發(fā)團隊和技術(shù)保障團隊,把平臺的高可用性放在最高優(yōu)先級加以實現(xiàn),這也是阿里云飛天平臺重要的核心競爭力。其中,集群多Master HA、熱升級、動態(tài)遷移、集群管理平臺等,已在產(chǎn)品中普遍應用;技術(shù)保障團隊在故障預案、容災演練、工具自動化和應急響應等方面,在不斷改進和完善。

共創(chuàng)云運維生態(tài)系統(tǒng)

阿里云計算平臺是一個開放的生態(tài)系統(tǒng),其中圍繞云計算的運維,是構(gòu)成這個生態(tài)系統(tǒng)的重要的生態(tài)鏈。從云產(chǎn)品開發(fā)者的“輕”運維,到云平臺運營商的“重”運維,相得益彰,相互促進,才能打造健康的發(fā)展環(huán)境。這條運維生態(tài)鏈充滿潛力,例如可以為第三方軟件提供商(ISV)、第三方運維服務提供商提供平臺,創(chuàng)造更細分和垂直的運維服務系統(tǒng),豐富云生態(tài)系統(tǒng),創(chuàng)造價值。以2012年11月的阿里云開發(fā)者大會為例,參賽作品中有相當比例是基于OSS和ECS等開發(fā)的管理類工具,這些第三方管理工具在云生態(tài)系統(tǒng)中,就可能找到自己的需求方,從而產(chǎn)生價值。第三方運維服務商也同樣可以通過提供更細分、定制化的服務內(nèi)容,在云生態(tài)系統(tǒng)中滿足開發(fā)者用戶的個性化運維需求。

云計算方興未艾,可謂小荷才露尖尖角,精彩剛剛開始。運維作為云計算的天然組成部分,會越來越展示其重要性,成為云計算核心競爭力之一。讓我們攜手所有的阿里云開發(fā)者共創(chuàng)一個健康、開放的云計算運維生態(tài)環(huán)境;讓阿里云計算平臺運維重如泰山,穩(wěn)若磐石;讓開發(fā)者運維舉重若輕,輕松在路上。