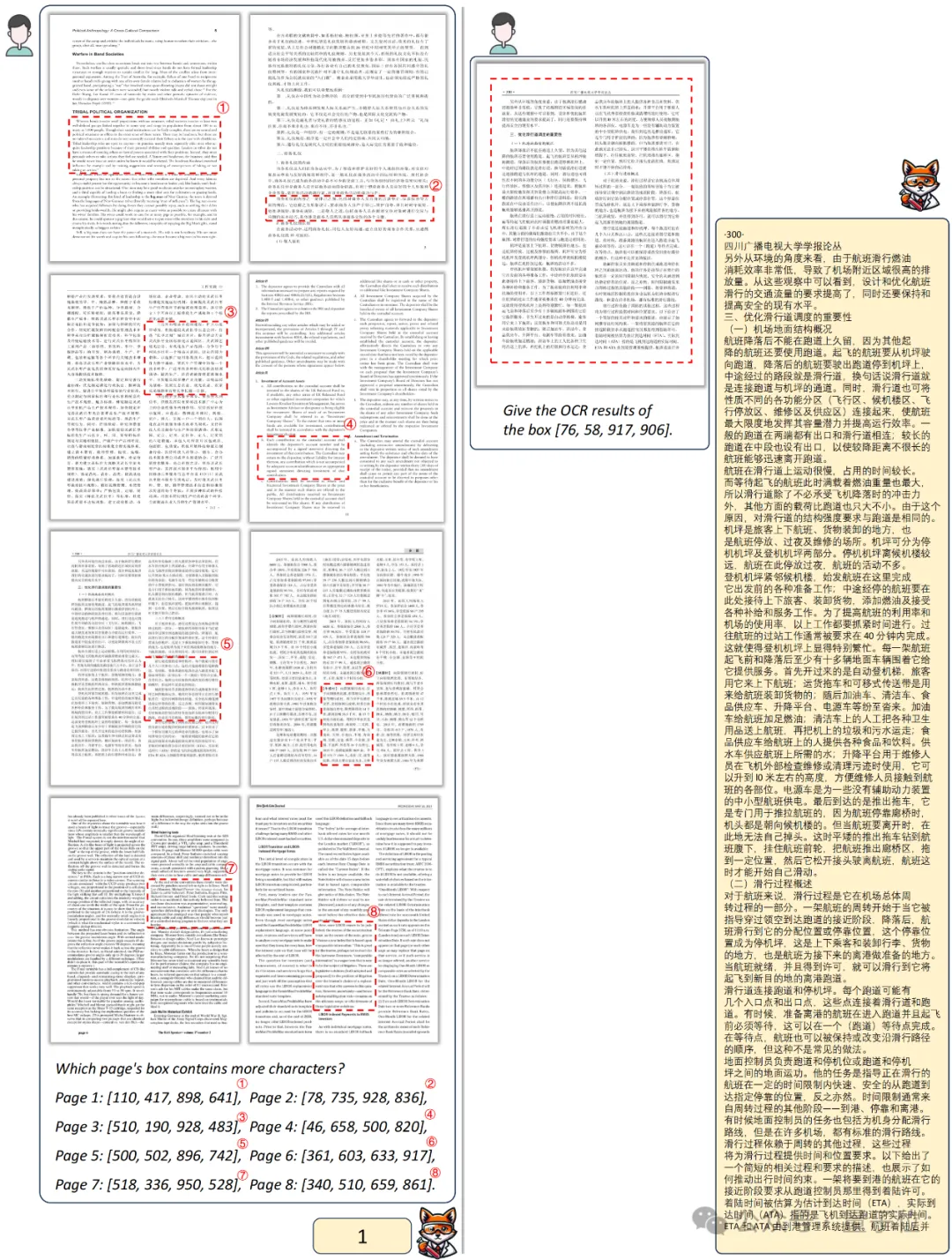

AI讀論文新神器:多欄密集文字、中英圖文混排文檔都能讀的多模態大模型Fox

雖然多模態大模型都能挑西瓜了,但理解復雜文檔方面還是差點意思。

面對文字密集、多欄混排等文檔時往往力不從心,區域級別的細粒度理解,就更是無從談起了。

最近,曠視團隊打造了一支多模態大模型的“點讀筆”——Fox,輕松實現對8頁文檔(中英混合,單欄多欄格式混合的極端場景)的交互式感知理解。

對于信息密集的PDF文檔,Fox支持高可控性的細粒度理解,比如在用戶感興趣區域內進行文字識別、段落翻譯以及頁面內部的圖片內容描述等。

論文中,團隊進一步突破了對于文檔的視覺感知理解的上限,高密度的信息被真正壓縮,LVLM真正地“看”懂圖,才能真正做好、做出能用的文檔多模大模型。

正所謂“一圖勝千言”—— one image token >> one text token。

接下來,看看Fox在實戰中表現如何?

中英混排,單欄多欄組合都不怕

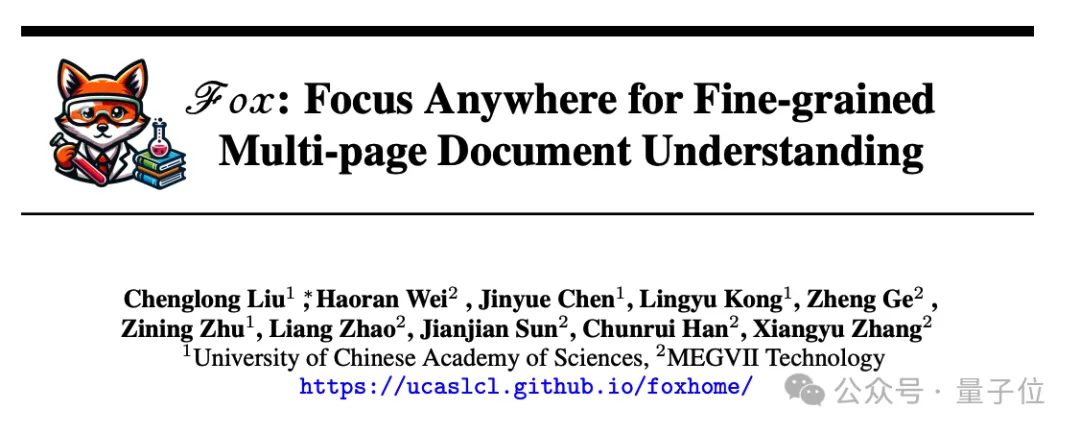

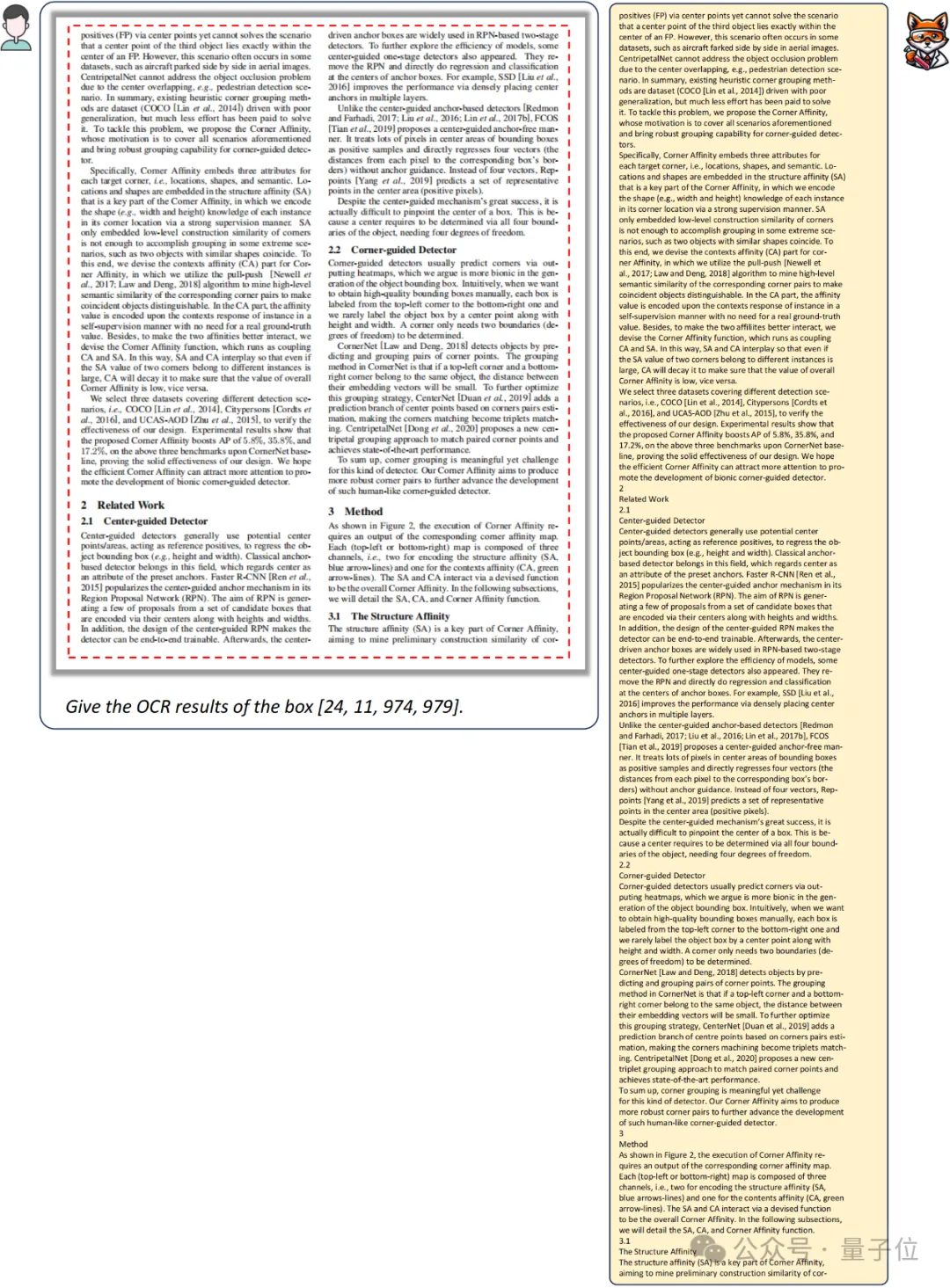

對于中英混合、單欄多欄混合的8頁PDF文檔,可實現任意區域的OCR:

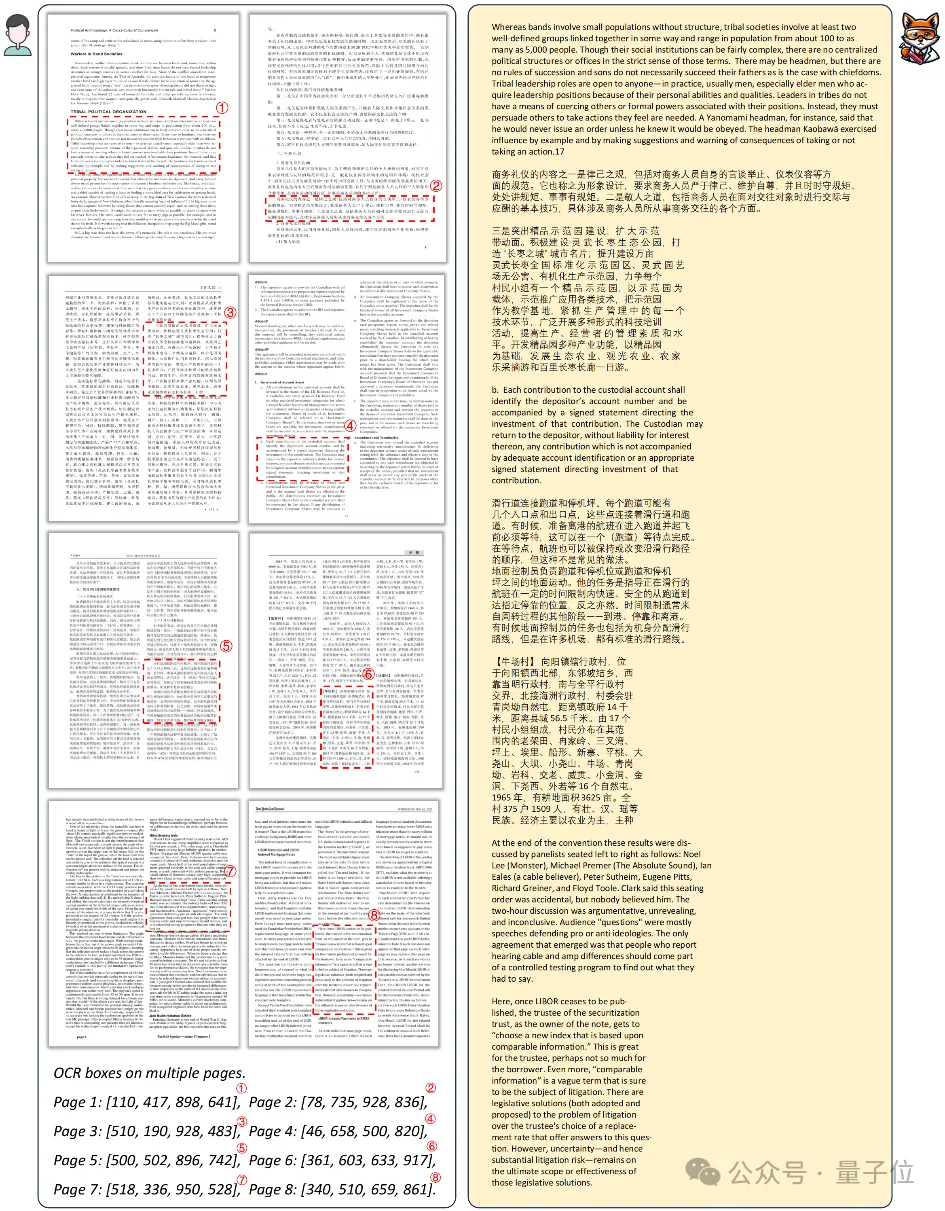

下圖左側展示了8頁文檔內跨頁的VQA,右側展示了雙欄中文頁面的前景OCR。

雙欄密集英文頁面的前景OCR:

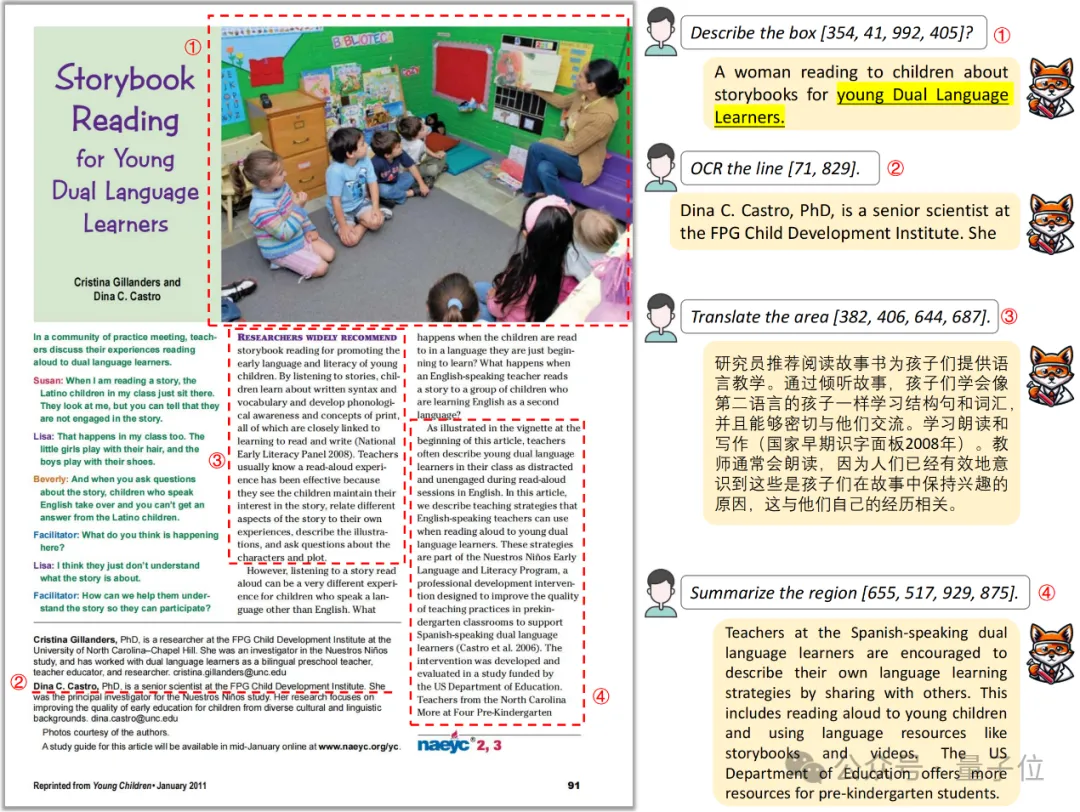

在頁面內圖片描述方面,Fox能給出文檔內內容關聯的回答(young Dual Language Learners)。

當然Fox還支持line-level OCR,以及對RoI區域的翻譯、總結等。

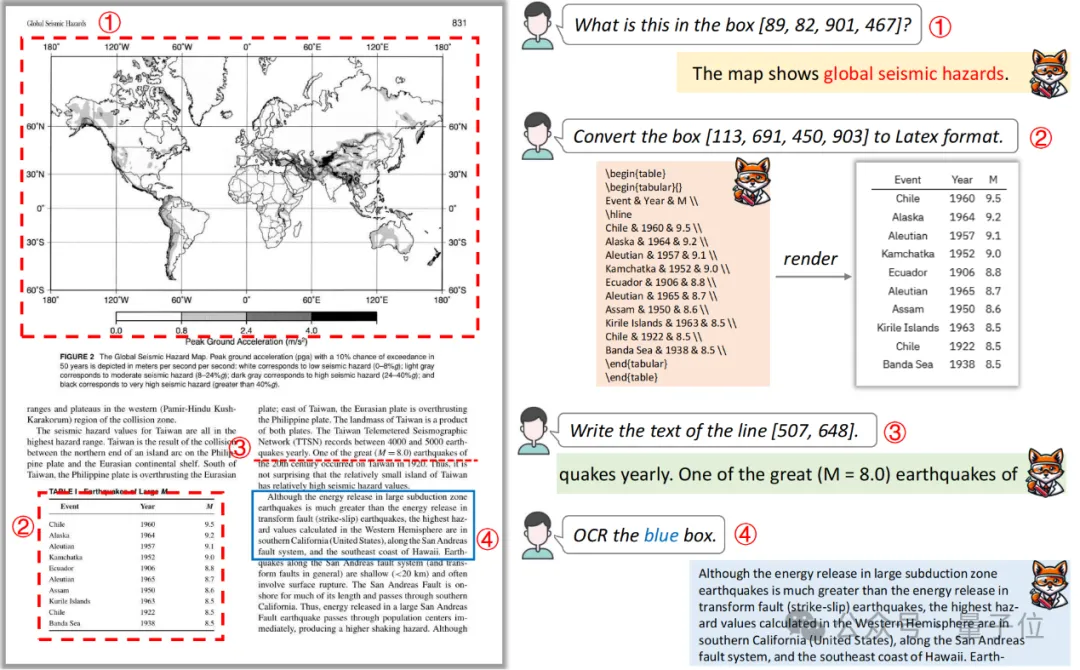

Fox可以結合頁面內文字,認識到這是一張關于global seismic hazards的圖。此外,Fox還支持RoI內的latex格式轉換,例如下面的table轉latex。Fox還支持更加靈活的顏色引導的RoI區域OCR。

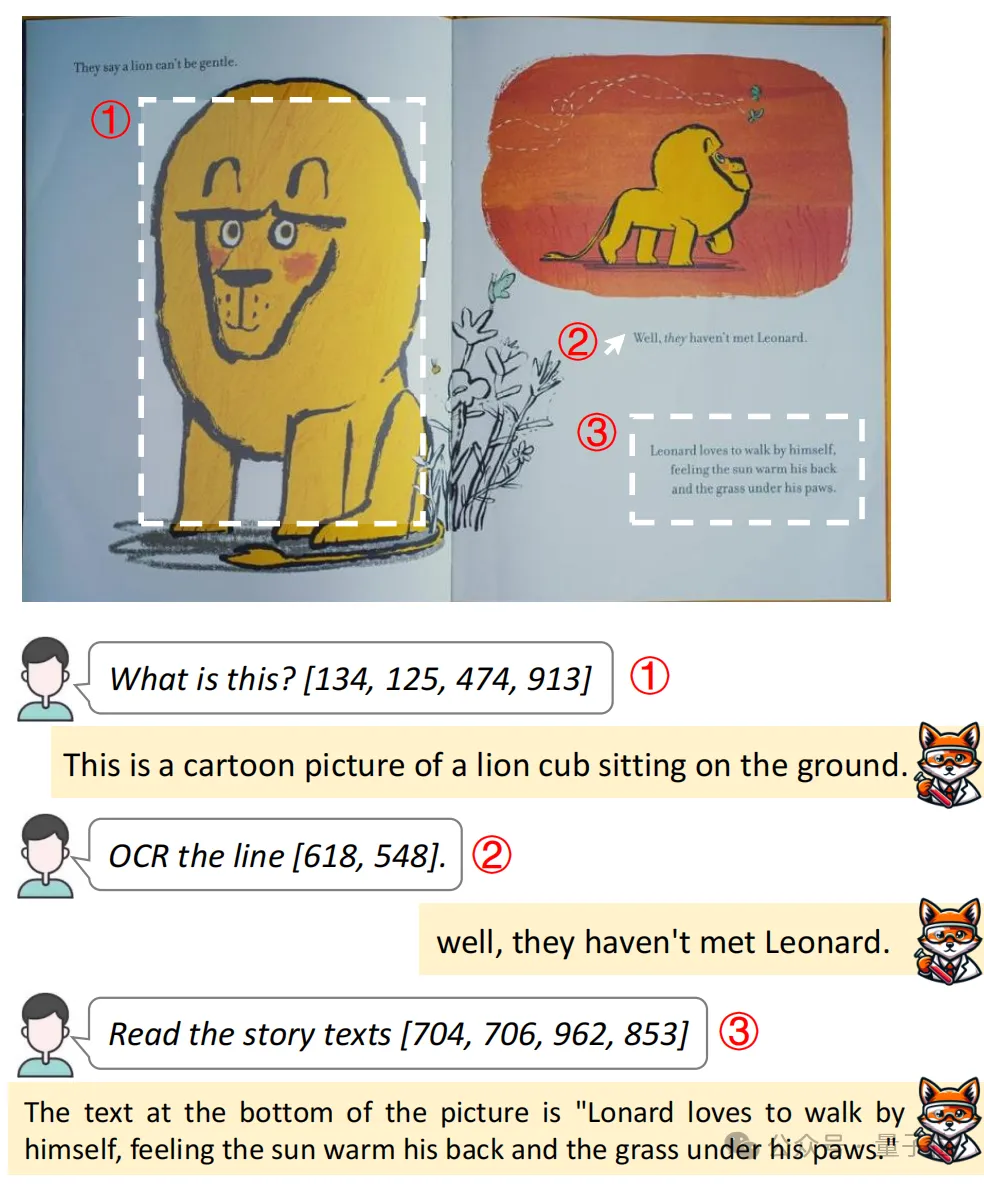

對于卡通繪本,也可以哪里不會點哪里:

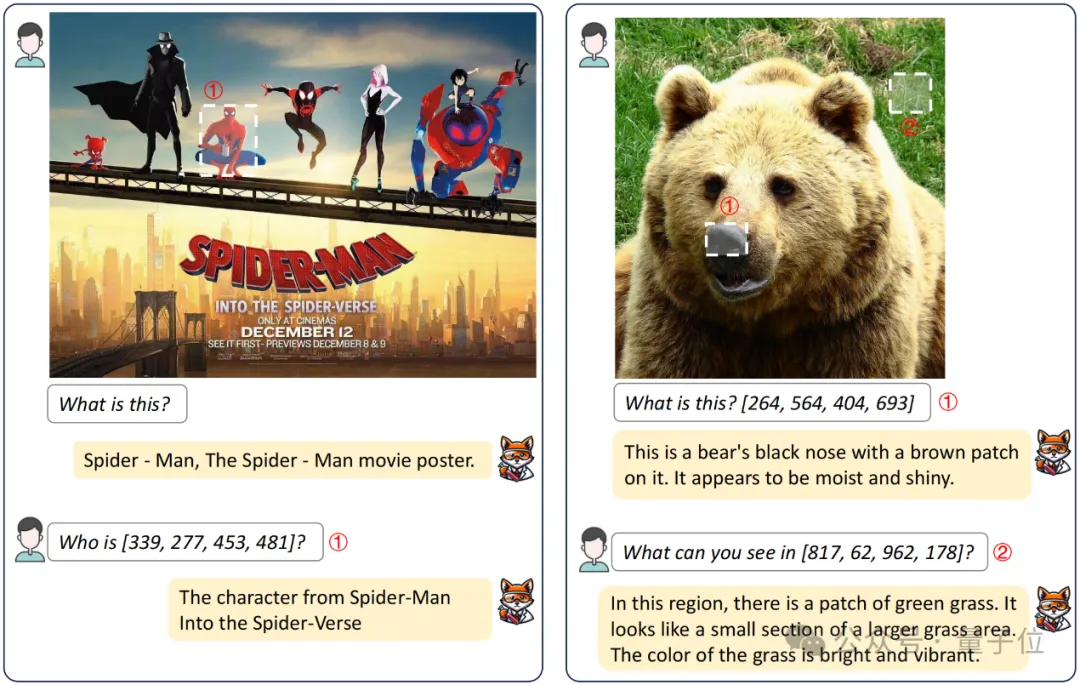

電影海報和自然場景的對話問答,Fox給出了非常有趣的答案(根據電影海報下面的文字給出了角色來源):

那么Fox是如何做到這些的呢?

多詞表協同,多頁面文檔統一打包

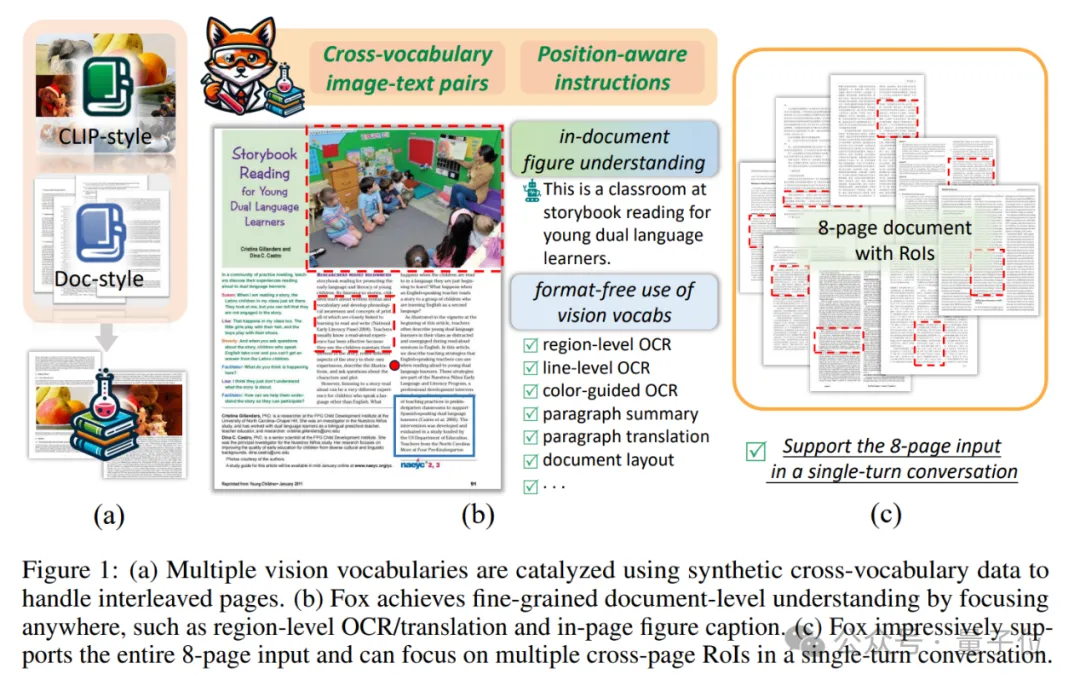

在細粒度文檔理解上,Fox有著三大創新:

- 精準定位

Fox引入了一系列基于位置的文本提示,如點擊位置、拖動框、涂色框等。這使得模型可以直接定位到感興趣的任意區域,而不受文檔格式的限制。同時,Fox還把全頁OCR重新定義為”前景聚焦”任務,進一步增強了對密集文字的感知。

- 多視覺詞表協同

為了更好地理解圖文混排頁面,Fox采用了兩個不同特長的視覺詞表——CLIP主攻自然圖像,Vary專攻人工文檔。但單純疊加兩種數據,往往會造成視覺偏置。為此,Fox合成了大量含混合視覺元素的數據,迫使兩個視覺分支充分協作。

- 頁面打包

得益于高壓縮率(每頁1024×1024圖像對應256個圖像token),Fox將多頁面文檔統一打包輸入。這不僅讓跨頁面的上下文理解成為可能,也大幅降低了計算開銷。值得一提的是,這種打包微調模式并不需要重新訓練視覺詞匯。

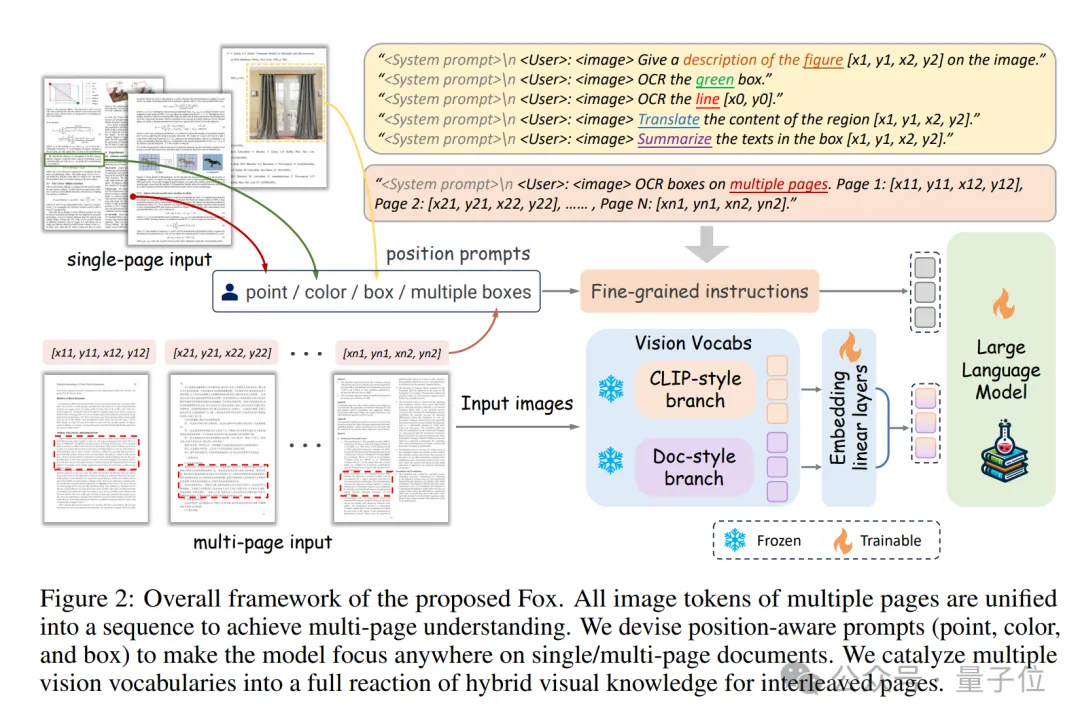

在這些創新基礎上,Fox模型結構如圖所示。

Fox支持單頁/多頁文檔圖像輸入,所有圖像的image token被統一到一個sequence中進行多頁文檔理解。團隊設計了基于point、color、box的prompt,來實現在文檔頁面上聚焦任意位置。團隊合成了圖文交織的文檔數據,來充分催化兩個視覺詞表,以更好地適用于實際文檔應用場景。

此外,為了促進對文檔細粒度理解的研究,作者還打造了一個中英雙語的benchmark,已經開源了數據和評測代碼,共包含以下9種任務:

- Page-level OCR

- Region-level OCR

- Line-level OCR

- Color-guided OCR

- Region-level translation

- Region-level summary

- In-document figure caption

- Multi-page multi-region OCR

- Cross-page VQA

最后,團隊呼吁更多的研究人員能關注到細粒度的單頁/多頁文檔理解,單頁的稀疏的問答任務遠遠不夠。

真正做好多模態大模型,視覺編碼器的信息壓縮率(token轉化率)是非常重要的,Fox僅探究了文檔這一類應用方向,希望對大家的研究有所幫助。

想了解更多細節,請查看原論文。

論文地址:??https://arxiv.org/abs/2405.14295???

代碼地址:???https://github.com/ucaslcl/Fox???

項目主頁:???https://ucaslcl.github.io/foxhome/??

本文轉自 量子位 ,作者:量子位