蘋果超強視覺預訓練模型助力下游任務拿SOTA!(分類、檢測、分割、深度估計) 精華

文章鏈接:??https://arxiv.org/pdf/2405.08911??

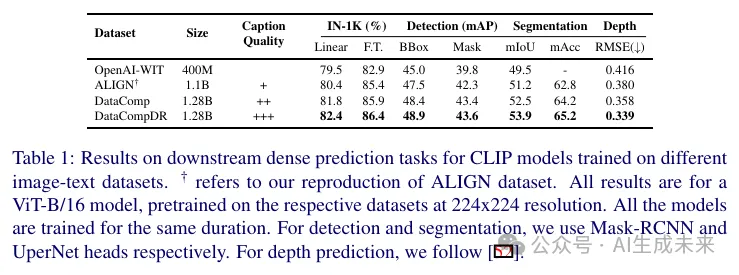

CLIP 模型在zero-shot分類和檢索任務中表現非常出色。但最近的研究表明,CLIP 中學習到的表示并不適用于目標檢測、語義分割或深度估計等密集預測任務。為了緩解 CLIP 在下游任務中表現不佳的問題,最近引入了多階段訓練方法。

在這項工作中,發現簡單地提高圖文數據集中描述的質量可以改善 CLIP 的視覺表示質量,從而顯著提升其在下游密集預測視覺任務中的表現。事實上,使用高質量描述進行 CLIP 預訓練可以超越最近的監督、自監督和弱監督預訓練方法。

本文展示了當使用 ViT-B/16 作為圖像編碼器的 CLIP 模型在經過良好對齊的圖文對進行訓練時,在語義分割和深度估計任務上分別比最新的 Masked Image Modeling (MIM) 預訓練方法(如 Masked Autoencoder (MAE))高出 12.1% 的 mIoU 和低 11.5% 的 RMSE。發現移動端架構也顯著受益于 CLIP 預訓練。最近的一種移動端視覺架構 MCi2 通過 CLIP 預訓練在語義分割任務上的表現與在 ImageNet-22k 上預訓練的 Swin-L 相當,而其模型尺寸小了 6.1 倍。此外,還展示了提高描述質量在進行密集預測任務微調時提高了 10 倍的數據效率。

介紹

在計算機視覺領域,先在大規模語料庫上進行預訓練然后在目標任務上進行微調是一個常見的范式。在過去十年里,一種常見的預訓練策略是在 ImageNet 上進行有監督的預訓練。最近,諸如對比語言-圖像預訓練(CLIP)、BEiT和 DINO等在大規模數據集上訓練的模型顯示出能夠學習到通用且高度可遷移的視覺表示。這些預訓練模型隨后被用作初始化,并在各種下游任務(如目標檢測、語義分割和深度估計)中進行微調。

盡管存在多種預訓練方法,但沒有一種方法能夠對所有下游任務表現最佳。此前,CLIP 預訓練在密集預測任務(如目標檢測和深度估計)上的表現相比 MIM 預訓練方法(例如 MAE)和自監督學習(SSL)方法(例如 DINO)不盡如人意。在這項工作中,我們實證研究了以下研究問題:相比 MIM,CLIP 是否在本質上是一個不適合密集預測任務的預訓練選擇?

在 CLIP 預訓練中,學習了一個圖像編碼器和一個文本編碼器,以對齊來自(圖像,文本)對的embedding。通過網絡爬蟲收集的大規模(圖像,文本)數據通常是噪聲較大的:文本和圖像內容可能不太匹配。Cherti 等人表明,預訓練數據集的規模顯著影響 CLIP 圖像和文本編碼器學習到的表示質量。在這項工作中,展示了描述(文本模態)的質量顯著影響視覺表示(圖像模態)的質量。我們發現,通過對齊的描述訓練的 CLIP 圖像編碼器特征不僅在語義區分任務中遷移良好,還在密集預測視覺任務中帶來了顯著的性能提升。

CLIP 預訓練在移動架構上效果很好。大多數移動架構,如[23, 29, 45, 46],要么是CNN-Transformer混合設計,要么是純卷積設計。像MAE這樣的預訓練方法是為Transformers量身定制的,不能直接應用于移動端架構。CLIP在DataCompDR上的預訓練提高了移動架構在密集預測任務(如目標檢測和語義分割)上的性能。后面將發布微調代碼及所有checkpoints。

本工作的主要貢獻如下:

- 通過系統實驗,證明了CLIP能夠學習適用于密集預測任務的視覺特征,前提是預訓練數據集中的圖文對是對齊的。

- 詳細比較了CLIP和MAE的預訓練策略。展示了在不同的訓練計劃下,若數據集包含高質量的描述,CLIP預訓練可以超過MAE。

- 詳細分析了CLIP預訓練在密集預測任務中的數據擴展趨勢。展示了提高描述質量能夠提升數據效率。

- 證明了CLIP預訓練即使在移動架構上也有顯著益處,在檢測、分割和深度估計等視覺任務上實現了最先進的準確率-延遲權衡。

背景

在計算機視覺中學習可遷移表示是一項活躍的研究領域。一個常見的范式是先進行預訓練,然后在下游任務(如檢測、分割、深度估計等)上進行微調。有監督的預訓練被廣泛使用,其中模型在大規模標注數據集上進行訓練。但大規模獲取準確標簽是一項挑戰,而且大多數大規模標注數據集(如 JFT)是私有的。

最近,自監督預訓練取得了顯著進展。大多數這些方法不需要準確標注的數據集,而是使用預訓練策略,例如實例對比學習、拼圖解謎、聯合embedding或mask區域重建。特別是,MAE顯示出能夠學習高度可遷移的表示。但 MAE 存在局限性——Singh 等人表明,較小的圖像編碼器如 ViT-B/16 無法從數據集擴展中受益。在[43]中,MAE 之后進行弱監督預訓練的第二階段,以在下游任務上獲得進一步的顯著改進。

CLIP

CLIP 是一種圖像-文本模型,將圖像和文本映射到一個聯合embedding空間中。CLIP 由圖像和文本編碼器組成,訓練數據集是大規模的配對圖像-文本樣本,以使得相似的圖像和文本被映射得更近,而不同的樣本被映射得更遠。給定一批個圖像-文本對,用,表示 CLIP 模型的圖像和文本的維embedding。令表示embedding向量v和embedding矩陣 U之間的相似度,經過溫度參數的 Softmax 歸一化。

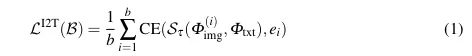

CLIP 損失由圖像到文本的損失和文本到圖像的損失組成,其中圖像到文本的部分定義如下:

其中,CE 表示交叉熵損失, 是一個在第i個坐標上為 1,其他地方為 0 的b維一熱向量。類似地,文本到圖像的損失是通過交換文本和圖像embedding來定義的。

數據質量對 CLIP 的重要性

CLIP 在下游分類任務中展示了顯著的zero-shot能力,而無需在特定任務數據上進行微調。在 CLIP中,一個多模態模型使用來自網絡的圖像及其噪聲文本標注進行訓練。最近,數據集規模顯著擴大,CLIP 預訓練在zero-shot圖像分類和檢索性能上顯示出顯著的改進。

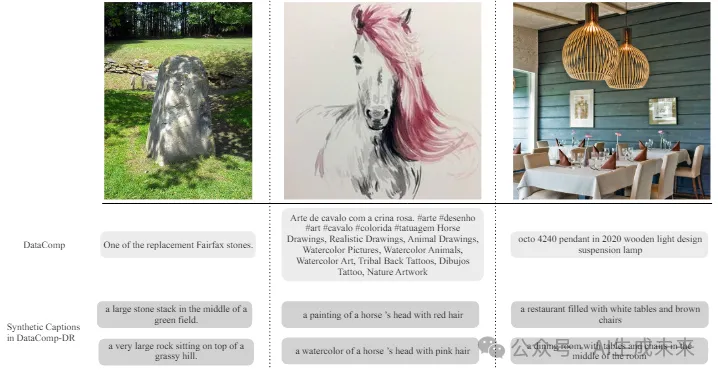

Fang 等人表明,CLIP 預訓練數據分布的質量和多樣性可以解釋其新興的zero-shot能力。基于這一觀察,Gadre 等人提出了 DataComp 基準,用于尋找最佳的 CLIP 訓練集,并提出了 DataComp-1B(BestPool 過濾),使用公共數據集顯著改進了 CLIP 訓練,與之前的數據集 LAION-2B相比。最近,Vasu 等人引入了 DataCompDR,除了其他信息,還在大規模的 DataComp-1B 中添加了合成描述,這些描述更干凈且對齊良好。

此前,尚未研究過規模和質量對 CLIP 預訓練在下游密集預測任務中的影響。Nguyen 等人研究了改進描述以提高圖像檢索和圖像描述生成的性能。Wei 等人觀察到 CLIP 預訓練在密集預測任務上表現不如其他預訓練方法,并建議增加一個微調步驟以改進 CLIP 圖像編碼器。文獻[49]中的結果僅限于早期在相對較小的數據集上訓練的 CLIP 模型。相比之下,我們發現,使用更大規模的 DataComp進行 CLIP 預訓練,與其他預訓練方法相比具有高度競爭力。在這項工作中,展示了在改進描述質量的數據集(如 DataCompDR)上訓練的 CLIP 模型顯著提高了下游密集預測任務的視覺表示質量。

分析

使用合成描述的 CLIP

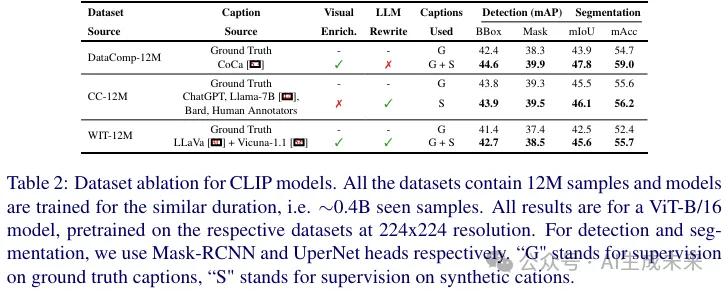

雖然 DataComp 使用過濾啟發式方法來獲得高質量的描述,但最近的方法已經使用大型視覺基礎模型和語言模型生成高質量的合成描述。與來自網絡的噪聲文本相比,這些描述通常與相應圖像更好地對齊且質量更高。我們比較了最近 MobileCLIP、LaCLIP 和 VeCLIP工作中,使用真實描述和合成高質量描述預訓練的 CLIP 模型的微調性能。LaCLIP 主要使用大語言模型(LLMs)重寫描述,VeCLIP 使用 LLaVA 模型和一個 LLM 為他們的數據集(稱為 VeCap)生成描述。

MobileCLIP 使用 CoCa 模型為 DataComp數據集生成描述,從而形成 DataCompDR。VeCap 和 DataCompDR 通過使用視覺語言基礎模型生成視覺豐富的描述,而 LaCLIP 僅依賴于 LLM 重述現有的描述。從表2可以看出,改進描述質量導致圖像編碼器在密集預測任務中具有更好的遷移能力。我們還發現,使用視覺豐富描述預訓練的 CLIP 模型在密集預測任務中表現更好。

CLIP 與 MAE

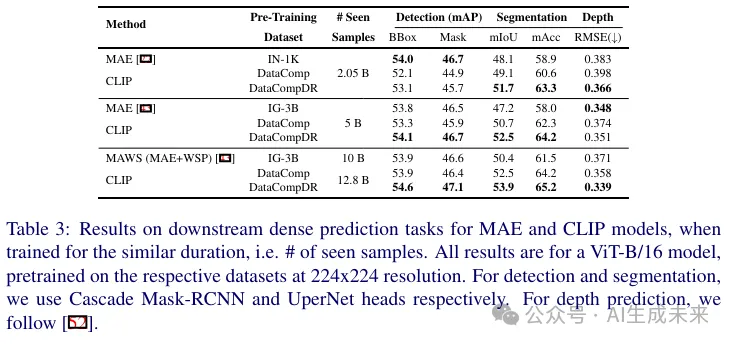

為了公平比較這兩種流行的方法,在 DataComp 和 DataCompDR數據集上訓練了一個 CLIP 模型,并在兩個預訓練方法之間匹配所見樣本數量(即全局批量大小 × 總迭代次數)。在下表3中,對于 2.05B 個所見樣本,我們觀察到在目標檢測任務中 MAE 比 CLIP 高出 0.9 mAP,但在 DataCompDR 上預訓練的 CLIP 在分割任務中比 MAE 高出 3.6 mIoU,在深度估計任務中 RMSE 低 4.4%。

當 MAE 預訓練擴展到包含 3B 個獨特圖像和 28K 類別的 IG-3B 數據集時,我們在檢測和分割任務中沒有看到任何改進。而 CLIP 預訓練在目標檢測任務中超過了 MAE,并在分割任務中進一步提高了 4.4 mIoU。在這個規模上,MAE 僅在深度估計任務中表現優于 CLIP 預訓練。當在與 MAWS相似的規模上在 DataCompDR 上訓練更長時間的 CLIP 模型時,它在所有下游密集預測任務中都超過了 MAE 和 MAWS。

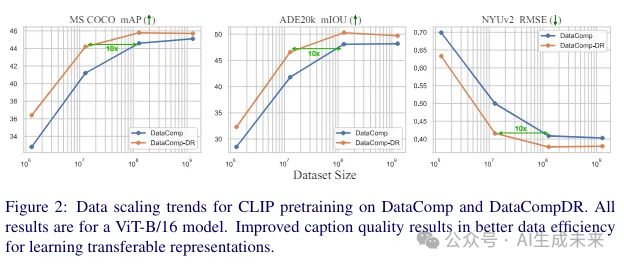

數據擴展

為了理解擴展數據集規模的效果,在 DataComp 和 DataCompDR 上訓練 CLIP 模型,子集范圍從 1.28M 到全部 1.28B 樣本,并在下圖2中比較它們的微調性能。對于所有實驗,預訓練 20k 次迭代,全局批量大小為 65k(相當于在 1.28B 上訓練一個周期)。使用第4節中描述的設置,微調圖像編碼器以進行下游任務。從下圖2中,發現改進描述質量在微調密集預測任務時提高了數據效率。在 MS COCO 上,預訓練在 DataCompDR 的 12.8M 子集上的 CLIP 模型獲得了 44.2 的 mAP,略低于在 DataComp 的 128M 子集上預訓練獲得的 44.6 mAP(用于目標檢測任務)。CLIP 模型可以在 DataCompDR 的 10倍小的子集上進行預訓練,以獲得與在 DataComp 的較大子集上預訓練相似的性能。

表示分析

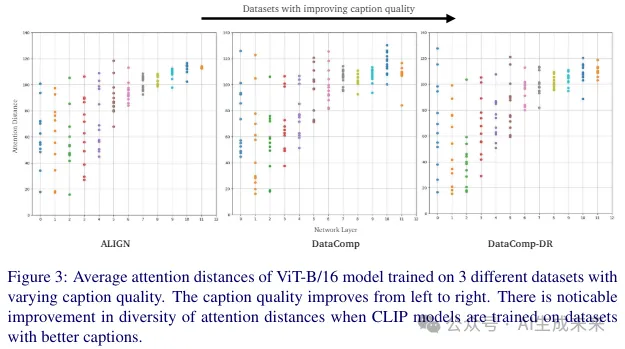

為了理解描述質量的影響,繪制了整個 ImageNet-1K 驗證集上的平均注意力距離。這有助于我們理解信息流,因為它部分反映了每個注意力頭的感受野大小。按照[49]中的描述,[CLS] token 被忽略在平均計算中。從下圖3中,我們注意到每個頭的平均注意力距離有差異,特別是對于在 DataComp 和 DataCompDR 上訓練的描述更干凈和更對齊的模型。

對于在包含噪聲描述的 ALIGN 數據集上訓練的 CLIP 模型,注意到注意力距離的多樣性較少,特別是在較深層次。這直觀上表明,最后幾層可能存在冗余,模型的容量可能未被充分利用,如[52]所述。當在 DataCompDR 中引入更對齊的描述時,注意到注意力頭趨向于更局部,同時保持層內的多樣性。正如[31, 49]中觀察到的那樣,局部注意力對密集預測任務更有利。因此,在描述噪聲較少且與圖像更對齊的數據集上訓練的 CLIP 模型在密集預測任務中表現更好。

實驗

本文評估了 CLIP 模型的視覺編碼器在四個下游任務中的性能:圖像分類、實例分割、語義分割和深度估計。主要關注所有任務的端到端微調性能。

CLIP 預訓練。遵循 [28, 47] 中的方法,在 DataComp 和 DataCompDR 上訓練 CLIP 模型。對真實描述和合成描述最小化 CLIP 的對比損失,如 [28, 47] 中常見的方法。選擇 DataComp 和 DataCompDR 進行實驗是因為它們的規模,即 12.8 億圖文對。其他公開可用的數據集如 [16, 28] 僅包含 2 到 4 億圖文對。詳細的超參數列表將在補充材料中提供。對于移動架構,直接使用 [47] 中在 DataCompDR 上預訓練的 CLIP 模型。

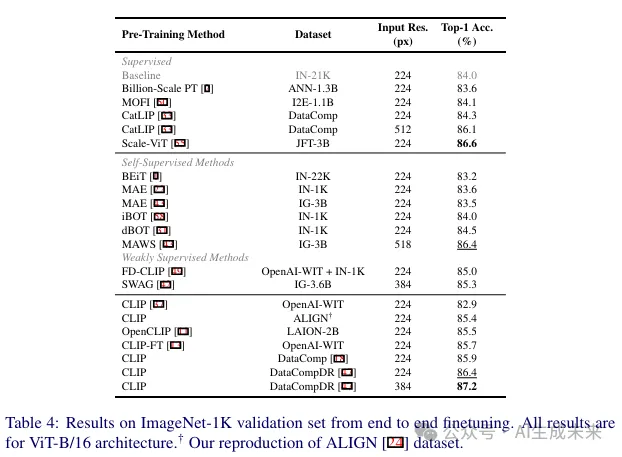

圖像分類。在 ImageNet-1K 數據集上微調視覺編碼器 100 個周期,遵循 [31, 49] 中的設置。關于具體設置的更多細節將在補充材料中提供。在表4中,我們將監督基線(灰色)與最近的自監督和弱監督方法進行了比較。從下表4可以明顯看出,在具有大規模高質量描述的數據集上進行 CLIP 預訓練的效果優于最近的最先進預訓練方法和在較大噪聲描述數據集上訓練的其他 CLIP 模型。

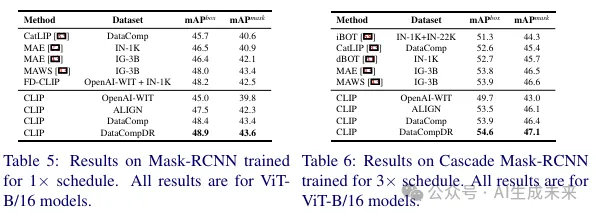

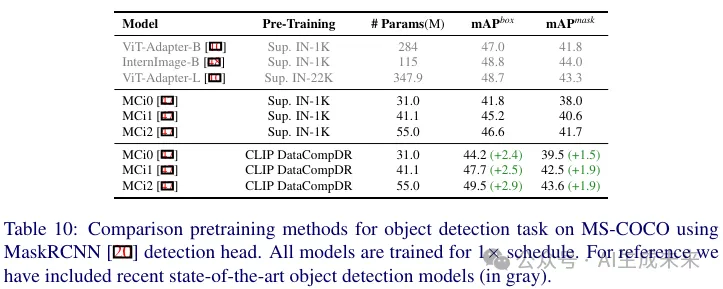

目標檢測和實例分割。報告了在 MS-COCO數據集上使用 MaskRCNN 頭和 Cascade-MaskRCNN 頭進行實例分割的所有模型的性能。模型使用 MMDetection 庫 進行訓練。MaskRCNN 模型使用 1× 計劃進行訓練,采用單尺度測試,如 [49] 中描述。Cascade-MaskRCNN 模型使用 3× 計劃進行訓練,采用單尺度測試。遵循 [31, 49] 中描述的微調設置,更多細節在補充材料中提供。從下表5和表6中可以看出,ViT B/16 在 DataComp 和 DataCompDR 上進行 CLIP 預訓練的效果優于最近的最先進預訓練方法。

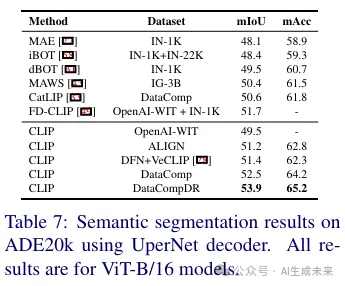

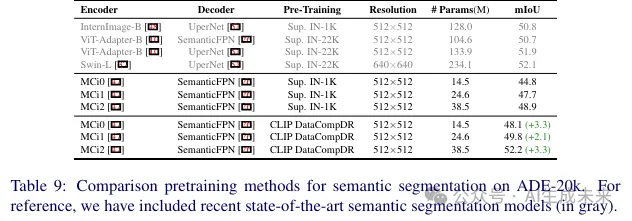

語義分割。使用 UperNet頭并遵循 [31] 中描述的設置。模型使用 MMSegmentation 庫進行訓練。對于移動端模型,使用 SemanticFPN頭并按照 [45] 中描述的設置進行訓練。更多細節將在補充材料中提供。從下表7中可以看出,CLIP 預訓練顯著有利于分割任務。事實上,在噪聲 ALIGN數據集上訓練的 CLIP 也優于 MAWS。當在 DataCompDR 上進行預訓練時,我們觀察到 mIoU 有顯著的 3.5(6.9%)的提升。

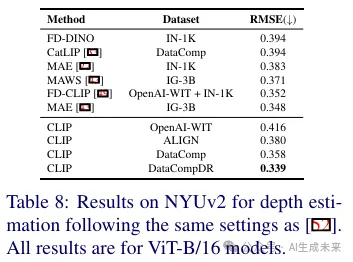

深度估計。在 NYUv2 數據集上報告了均方根誤差(RMSE)。使用 [49, 52] 中描述的相同設置,更多細節將在補充材料中提供。從下表8中可以看出,DataCompDR 上預訓練的 ViT-B/16 優于最近的最先進預訓練方法和多階段預訓練方法,如 [43, 49]。

LIP 預訓練對移動架構的影響

前面分析了在 DataCompDR 上進行 CLIP 預訓練對較大架構(即 ViT-B/16)的影響。本節分析 CLIP 預訓練對移動架構的好處。具體來說,微調了最近開源的 MobileCLIP 圖像編碼器。將廣泛使用的 ImageNet-1K 上的監督預訓練與 DataCompDR 上的 CLIP 預訓練進行了比較。

從下表9可以看出,CLIP 在 DataCompDR 上進行預訓練使最小架構的 mIoU 提高了 3.3。MCi2 模型獲得了 52.2 的 mIoU,類似于更大架構如 Swin-L 和 ViT-Adapter-B模型。

在下表10中,觀察到最小模型的邊界框 mAP 提高了 2.4,mask mAP 提高了 1.5。MCi2 模型獲得了 49.5 的邊界框 mAP,這與較大架構如 ViT-Adapter-L相當,甚至優于較新的專用架構如 InternImage-B。

結論

這項工作中,分析了 CLIP 預訓練對下游密集預測任務的性能影響。發現預訓練數據集的規模和描述的質量有顯著的區別。系統地與 MAE(一個流行的視覺Transformer自監督預訓練方法)進行了比較。與之前的工作相比,表明 CLIP 預訓練在與 MAE 競爭時非常有競爭力,甚至在規模上超過 MAE 和最近的 MAWS 預訓練方法。表明在具有良好質量描述的數據集上進行大規模 CLIP 預訓練會產生一個圖像編碼器,它能夠學習到高度可遷移的表示。此外還表明,CLIP 預訓練對較小的架構也有好處。

本文轉自 AI生成未來,作者:Apple