智能體設(shè)計新范式:從任務(wù)執(zhí)行者到環(huán)境探索者,讓智能體像人類一樣成長 精華

當(dāng)前大多數(shù)智能體框架沿襲自頂向下(Top-Down)的設(shè)計思路——人類事先定義目標(biāo)、拆解任務(wù),并構(gòu)建工作流供智能體執(zhí)行。這種方法在封閉環(huán)境中表現(xiàn)卓越,但當(dāng)智能體需要在開放、非結(jié)構(gòu)化環(huán)境中自主適應(yīng)和學(xué)習(xí)時,它們往往力不從心。

問題的癥結(jié)在于傳統(tǒng)的智能體設(shè)計過于依賴人工干預(yù),無法自主進(jìn)化。在自頂向下工作流中,智能體的能力主要依賴預(yù)定義的API、任務(wù)提示和專家設(shè)計的執(zhí)行路徑。但現(xiàn)實(shí)世界并非一個由任務(wù)明確、結(jié)構(gòu)清晰的操作手冊所支撐的環(huán)境——相反,它充滿了不確定性、動態(tài)變化和復(fù)雜的交互模式。于是,一種新的范式逐漸被提出:自底向上(Bottom-Up)智能體設(shè)計,它模仿人類學(xué)習(xí)過程,讓智能體通過探索、推理和經(jīng)驗積累逐步成長,而不再僅僅依賴人工設(shè)定的工作流。

圖1:代理設(shè)計的兩種范式。大多數(shù)現(xiàn)有的代理框架可以歸類為自上而下的代理,它們依賴于預(yù)先設(shè)計的架構(gòu):它們從高級目標(biāo)開始,將其分解為子任務(wù),并使用特定于任務(wù)的API和工具執(zhí)行工作流。相比之下,我們建議自下而上的智能體充當(dāng)探索者:從零先驗知識開始,它們通過試驗和推理逐漸獲得技能,通過環(huán)境變化推斷出的隱性獎勵自主進(jìn)化。

回溯人工智能的發(fā)展,我們不難發(fā)現(xiàn)自頂向下設(shè)計范式的合理性。早期的智能體系統(tǒng),如ReAct、Plan-and-Solve、AutoGPT等,都遵循類似的模式:給定一個復(fù)雜任務(wù),人類會將其分解為可執(zhí)行的子任務(wù),并設(shè)計對應(yīng)的工作流。智能體的任務(wù)是遵循這些流程,高效執(zhí)行,并在必要時進(jìn)行調(diào)整。這一框架有三個核心問題:

1.靜態(tài)性:智能體的改進(jìn)完全依賴于人類的更新,而不是基于自身經(jīng)驗進(jìn)行演化。

2.先驗依賴:必須依靠預(yù)定義的任務(wù)提示、API才能執(zhí)行任務(wù),而在開放環(huán)境中,這些先驗知識可能不存在或難以獲取。

3.令牌消耗:智能體的大部分計算資源被用于遵循預(yù)設(shè)流程,而非基于環(huán)境變化進(jìn)行推理和調(diào)整。

對于標(biāo)準(zhǔn)化任務(wù),如數(shù)據(jù)處理、自動化腳本執(zhí)行,這種模式仍然十分有效。但在開放世界任務(wù)中,如游戲、自動駕駛、智能機(jī)器人等,這些智能體無法自主學(xué)習(xí)或適應(yīng)新環(huán)境,必須依賴人工調(diào)整或重新設(shè)計工作流。

面對自頂向下方法的局限性,研究人員開始思考——能否讓智能體像人類一樣,從環(huán)境中自主學(xué)習(xí)技能,而非依賴預(yù)設(shè)流程? 這一設(shè)想與Silver和Sutton提出的“經(jīng)驗時代(Era of Experience)”理念相契合。人類的技能并非通過固定的任務(wù)執(zhí)行得來,而是經(jīng)歷試錯、推理和技能歸納的過程。相比傳統(tǒng)的方法,自底向上智能體設(shè)計更強(qiáng)調(diào)探索、技能進(jìn)化和適應(yīng)能力。

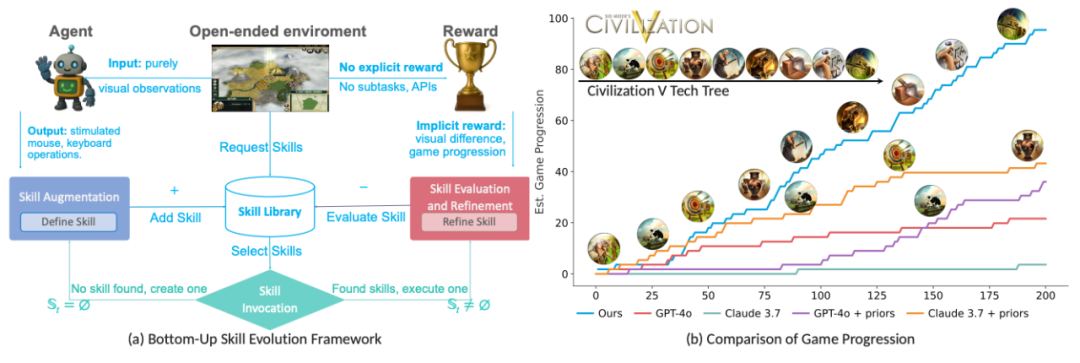

圖2:左:自底向上代理僅對原始視覺輸入進(jìn)行操作,并模擬低級鼠標(biāo)和鍵盤操作。在沒有明確獎勵的情況下,它會根據(jù)視覺變化或游戲進(jìn)度等隱含信號學(xué)習(xí)和改進(jìn)技能。右圖:游戲進(jìn)度由《文明V》的技術(shù)樹和視覺變化來衡量。我們的自底向上代理(藍(lán)色)的表現(xiàn)優(yōu)于所有基線,包括那些具有任務(wù)相關(guān)先驗的基線。

該研究提出了一種新的智能體范式:

- 智能體從零開始,無需先驗知識。

- 通過環(huán)境交互,智能體自主學(xué)習(xí)新技能。

- 技能可共享與優(yōu)化,使智能體群體得以持續(xù)演化。

這一方法的核心優(yōu)勢在于,它避免了人為設(shè)定任務(wù)的局限性,讓智能體能夠在完全未知的環(huán)境中自主學(xué)習(xí)、進(jìn)化,并適應(yīng)挑戰(zhàn)。

本研究由來自多個知名機(jī)構(gòu)的研究人員共同完成,他們在人工智能、智能體學(xué)習(xí)、強(qiáng)化學(xué)習(xí)與高性能計算等領(lǐng)域具有豐富經(jīng)驗,他們是來自新加坡科技研究局(A*STAR)前沿人工智能研究中心(CFAR)、高性能計算研究所(IHPC)、新加坡國立大學(xué)(NUS)、清華大學(xué)、電子科技大學(xué)(UESTC)的Jiawei Du, Jinlong Wu, Yuzheng Chen, Yucheng Hu, Bing Li, Joey Tianyi Zhou。

這些研究人員的合作涉及智能體技能學(xué)習(xí)、強(qiáng)化學(xué)習(xí)優(yōu)化、大型語言模型推理、計算機(jī)視覺等領(lǐng)域,他們共同推進(jìn)了自底向上智能體設(shè)計的落地與驗證。

此外,他們已開源該研究的代碼,可在 GitHub 訪問。

論文鏈接:??https://arxiv.org/abs/2505.17673??

項目地址:??https://github.com/AngusDujw/Bottom-Up-Agent??

1.方法論(Meth?odology)

我們一直在思考如何讓智能體變得更智能、更自主、更適應(yīng)復(fù)雜環(huán)境,自頂向下的設(shè)計方式強(qiáng)調(diào)任務(wù)規(guī)劃和結(jié)構(gòu)化執(zhí)行,但它的局限性在于,智能體只能嚴(yán)格按照預(yù)設(shè)的路徑工作,缺乏靈活性。而自底向上的方法則不同,它讓智能體從環(huán)境中學(xué)習(xí),在試錯中進(jìn)化,在經(jīng)驗積累中找到高效的行動策略。這種范式的背后,是嚴(yán)謹(jǐn)?shù)臄?shù)學(xué)建模和理論支持。

圖3:自下而上技能演變概述。代理從沒有預(yù)定義技能開始,通過交互逐漸構(gòu)建其庫S。左:新技能是通過用原子動作擴(kuò)展現(xiàn)有例程而逐步組成的。中間:通過視覺語言模型(VLM)比較執(zhí)行前和執(zhí)行后的狀態(tài)來評估技能;無效的通過LLM推理進(jìn)行改進(jìn)或丟棄。右:在每個時間步,根據(jù)當(dāng)前狀態(tài)xt選擇候選集St,并通過蒙特卡洛樹搜索(MCTS)進(jìn)行評估[40],以選擇最有前途的技能。所有組件都在統(tǒng)一的推理框架下運(yùn)行,沒有特權(quán)API,允許代理純粹從經(jīng)驗中獲得能力。

為了讓智能體能夠真正從經(jīng)驗中成長,研究團(tuán)隊采用了部分可觀察馬爾可夫決策過程(POMDP)作為理論基礎(chǔ)。這一方法的核心思想是,智能體無法直接看到整個環(huán)境的狀態(tài),而只能基于有限的觀測信息來做決策。環(huán)境由四個關(guān)鍵元素構(gòu)成:觀察空間 X(智能體的視覺輸入)、動作空間 A(智能體可執(zhí)行的原子操作,如鼠標(biāo)點(diǎn)擊或鍵盤輸入)、未知的狀態(tài)轉(zhuǎn)換函數(shù) T以及隱含獎勵 R。智能體的目標(biāo)是通過不斷交互,從這些有限的信息中推測出最優(yōu)的決策方式。

其中,智能體的技能被定義為一組可組合的原子動作,例如:

技能庫 S 記錄智能體已掌握的所有技能,并隨著時間逐步擴(kuò)展。每個技能還具備一個語義描述dσ,它由LLM生成,幫助智能體理解技能的意圖并進(jìn)行優(yōu)化:

為了讓智能體自主形成技能并優(yōu)化它們,研究團(tuán)隊設(shè)計了技能演化機(jī)制。首先是技能增強(qiáng)(Augmentation),智能體從單步動作開始,嘗試不同的行為組合,并觀察哪些操作能帶來環(huán)境變化。智能體不會盲目探索,而是采用增量式構(gòu)建:

也就是說,智能體會在一個已有的技能序列基礎(chǔ)上,嘗試添加一個新動作,并觀察它是否能帶來顯著環(huán)境變化。如果無法產(chǎn)生可見影響,該序列將被丟棄,確保智能體只學(xué)習(xí)有意義的行為。

在技能調(diào)用(Invocation)階段,智能體需要判斷當(dāng)前環(huán)境適用哪些已有技能。它不會簡單地隨機(jī)選擇,而是采用蒙特卡洛樹搜索(MCTS)來評估候選技能集:

蒙特卡洛樹搜索通過模擬不同技能的執(zhí)行結(jié)果,選擇最可能帶來長期收益的技能,確保智能體的行為更加高效。

技能庫不會一成不變,智能體需要不斷優(yōu)化已學(xué)技能。在技能評估與優(yōu)化(Refinement)過程中,研究團(tuán)隊設(shè)計了一種隱式獎勵機(jī)制:

這個公式的三個部分分別對應(yīng):

- 行為多樣性,確保智能體的技能庫不被過度重復(fù)的技能填滿;

- 執(zhí)行效率,避免智能體采用冗長的無效動作;

- 語義對齊,確保技能的意圖和實(shí)際執(zhí)行效果一致。

智能體通過不斷調(diào)整技能庫,丟棄低效技能,并利用LLM生成優(yōu)化后的語義描述,使技能庫不斷精煉。

研究團(tuán)隊在Algorithm 1中詳細(xì)列出了技能學(xué)習(xí)與優(yōu)化的完整步驟,并在圖3中展示了技能庫隨時間增長的過程。這一框架不僅賦予智能體自主學(xué)習(xí)能力,還確保它們能在復(fù)雜環(huán)境中快速適應(yīng),最終變得越來越智能。

2.實(shí)例化自底向上智能體

在人工智能不斷向更具適應(yīng)性和自主性的方向演化時,如何證明一個智能體真正能夠在沒有明確指引的情況下學(xué)習(xí)、適應(yīng)并進(jìn)化?研究團(tuán)隊選擇了兩個極具挑戰(zhàn)性的游戲環(huán)境——《殺戮尖塔》和《文明5》,作為自底向上智能體的測試場所。這兩款游戲的共同特點(diǎn)是,它們沒有固定的任務(wù)結(jié)構(gòu)、沒有預(yù)設(shè)的獎勵機(jī)制,也不提供任務(wù)子目標(biāo)或?qū)S?nbsp;API。

這意味著,智能體無法依賴傳統(tǒng)的任務(wù)規(guī)劃或預(yù)定義執(zhí)行路徑,而必須完全基于環(huán)境反饋來調(diào)整行為。更重要的是,這兩款游戲都模擬了人類的操作方式:智能體只能通過像素級視覺輸入感知環(huán)境,并使用鼠標(biāo)點(diǎn)擊和拖動執(zhí)行動作,與人類玩家的交互方式完全一致。

在這樣的環(huán)境中,視覺感知成為智能體理解世界的唯一方式。這也是為什么研究團(tuán)隊采用Segment Anything Model(SAM)作為視覺解析工具,使智能體能夠自動識別界面中的關(guān)鍵元素,如按鈕、菜單、資源信息等。SAM 賦予智能體一種類似人類的視覺處理能力,使它能夠區(qū)分不同的 UI 組件,并在交互過程中自主推理哪些元素可能是可點(diǎn)擊目標(biāo)。

智能體不會事先知道游戲規(guī)則,而是必須通過視覺信息和試錯來建立自己的操作邏輯。例如,在《文明5》中,智能體需要理解如何移動單位、如何選擇科技發(fā)展,而在《殺戮尖塔》中,它必須學(xué)會如何拖拽卡牌攻擊敵人。沒有預(yù)設(shè)的 API,智能體只能通過觀察界面變化,推測自己的行為是否有效,這種方式極大地接近人類玩家的真實(shí)體驗。

一個關(guān)鍵問題是,如何保證同一架構(gòu)能夠在不同環(huán)境中都正常工作?研究團(tuán)隊刻意設(shè)計了一種環(huán)境無關(guān)的推理機(jī)制,使得智能體在《殺戮尖塔》和《文明5》中使用完全相同的架構(gòu),而不需要針對每個游戲進(jìn)行特殊優(yōu)化。這意味著,無論智能體處于何種游戲環(huán)境,它都會遵循同樣的技能發(fā)現(xiàn)、調(diào)用和優(yōu)化邏輯,并在不同環(huán)境下不斷成長。

然而,當(dāng)前技能庫仍然具有一定的環(huán)境特定性:在《文明5》中學(xué)會的單位移動策略,并不能直接遷移到《殺戮尖塔》卡牌拖拽任務(wù)中。未來,如何實(shí)現(xiàn)技能的泛化,使得智能體能夠在不同任務(wù)場景下復(fù)用已有技能,是進(jìn)一步優(yōu)化的關(guān)鍵。

這項實(shí)驗不僅展示了智能體如何在完全開放的環(huán)境中自主獲取技能,也為未來人工智能的發(fā)展提供了重要啟示。隨著技術(shù)進(jìn)步,我們或許會看到智能體不僅能在不同游戲間學(xué)習(xí),還能跨越虛擬世界與現(xiàn)實(shí)世界,在更復(fù)雜的環(huán)境中不斷進(jìn)化。

3.實(shí)驗設(shè)計與評估分析

如果讓智能體完全從零開始學(xué)習(xí)技能,它們是否真的能夠像人類一樣,在經(jīng)驗中成長,并不斷優(yōu)化自己的行動策略?這是研究團(tuán)隊通過實(shí)驗所要回答的核心問題。為了測試自底向上智能體的表現(xiàn),他們選擇了兩個開放式游戲環(huán)境:《殺戮尖塔》和《文明5》。這兩款游戲的獨(dú)特之處在于,它們沒有預(yù)定義任務(wù)、沒有明確的獎勵機(jī)制,也沒有專門的API,智能體必須完全依靠環(huán)境交互來學(xué)習(xí)如何執(zhí)行任務(wù)。

圖4:技能演變和重用分析。(a)隨著時間的推移,技能庫的大小會通過增加(+)和修剪(-)而增加。(b)《砍倒尖塔》中十大最常被調(diào)用的技能。(c)跨環(huán)境的組合技能繼承示例,展示了如何從原子動作構(gòu)建更高級的例程。

在實(shí)驗設(shè)計上,研究團(tuán)隊確保所有智能體在相同難度級別和回合制模式下運(yùn)行,避免任何先驗知識的影響。為了觀察智能體的成長過程,每個智能體都被限制在1000步的最大交互次數(shù),通常需要約 6.5 小時來完成一輪實(shí)驗。在這樣的限制下,智能體必須學(xué)會高效利用時間和交互數(shù)據(jù),以便在有限的資源內(nèi)最大化自己的進(jìn)度和技能獲取。實(shí)驗中的主要評估指標(biāo)包括:

游戲進(jìn)度:在《殺戮尖塔》中衡量通過的層數(shù),在《文明5》中計算完成的回合數(shù)

策略發(fā)展:累計游戲分?jǐn)?shù)和已解鎖的科技數(shù)量

技能執(zhí)行響應(yīng)率:智能體執(zhí)行動作后導(dǎo)致環(huán)境變化的成功率

令牌成本:計算 LLM 在整個實(shí)驗中的推理資源消耗,并轉(zhuǎn)換為美元成本

在兩款游戲中,自底向上智能體的表現(xiàn)遠(yuǎn)遠(yuǎn)優(yōu)于所有基線智能體。尤其是在《殺戮尖塔》中,所有傳統(tǒng)方法在沒有任務(wù)先驗的情況下無法取得任何進(jìn)展,而自底向上的智能體成功突破 13 層,游戲分?jǐn)?shù)達(dá)到 81,并且執(zhí)行響應(yīng)率高達(dá) 98.56%。在《文明5》中,自底向上智能體完成 50 個回合,解鎖 8 項科技,展示了較強(qiáng)的探索和適應(yīng)能力。相比之下,即便基線方法在有任務(wù)先驗的情況下稍微提升了性能,它們?nèi)匀粺o法像自底向上智能體那樣自主優(yōu)化策略,在開放環(huán)境下持續(xù)學(xué)習(xí)。

進(jìn)一步的分析表明,智能體的技能庫隨著時間增長,不僅新增了有用技能,同時也剪除了低效技能。在實(shí)驗的幾個輪次中,智能體的技能庫規(guī)模不斷擴(kuò)大,新技能增強(qiáng),同時無用的技能被剔除,使整體效率逐步提高。從技能調(diào)用頻率來看,最常使用的技能逐漸從基本交互(點(diǎn)擊、拖拽)演化為更復(fù)雜的策略性技能,這種技能繼承和優(yōu)化過程與人類的學(xué)習(xí)模式非常相似。

圖5:自下而上代理的提示和執(zhí)行可視化。(a)用于技能增強(qiáng)和調(diào)用的與環(huán)境無關(guān)的提示,使推理無需訪問游戲特定的API。(b)我們設(shè)計了一個GUI,在游戲過程中可視化代理的執(zhí)行狀態(tài),顯示候選動作、選定目標(biāo)、推理元數(shù)據(jù)和相應(yīng)的技能計劃樹。

消融實(shí)驗揭示了智能體學(xué)習(xí)機(jī)制中的幾個關(guān)鍵組件對整體性能的影響。其中,視覺變化過濾確保智能體不會學(xué)習(xí)無效技能,缺失這一組件會導(dǎo)致大量無用操作被保留,從而浪費(fèi)計算資源。蒙特卡洛樹搜索(MCTS)是長時序決策中的關(guān)鍵機(jī)制,如果移除它,智能體幾乎無法取得任何進(jìn)展,導(dǎo)致任務(wù)失敗率大幅上升。而LLM 生成的技能描述則幫助智能體整理和優(yōu)化其行為,使技能庫更加系統(tǒng)化。任何一個組件的消除都會嚴(yán)重削弱智能體的學(xué)習(xí)能力,影響游戲進(jìn)度、分?jǐn)?shù)和執(zhí)行效率。

實(shí)驗結(jié)果不僅展示了自底向上智能體的學(xué)習(xí)潛力,還提供了未來優(yōu)化方向的思考。如何讓智能體在不同環(huán)境間遷移技能?是否可以進(jìn)一步減少探索開銷,讓智能體更快地找到有效策略?這些問題在研究的下一階段將成為關(guān)注重點(diǎn)。

4.討論與廣泛影響

自底向上智能體設(shè)計的提出,標(biāo)志著人工智能領(lǐng)域的一個重要突破。它的最大優(yōu)點(diǎn)在于自主學(xué)習(xí)能力的提升,讓智能體可以不依賴人工定義的任務(wù),而是通過探索環(huán)境來積累經(jīng)驗。它不僅解決了傳統(tǒng)自頂向下方法的靜態(tài)性問題,還使得智能體能夠隨著環(huán)境變化不斷優(yōu)化自身的決策邏輯。

通過試錯和推理,智能體可以逐步形成完整的技能庫,并在多智能體協(xié)作中實(shí)現(xiàn)知識共享。這種進(jìn)化方式使得智能體更具適應(yīng)性,能夠在開放世界任務(wù)中有效發(fā)揮作用,尤其適用于自動駕駛、智能機(jī)器人以及復(fù)雜策略模擬等領(lǐng)域。

自底向上方法仍然面臨一些技術(shù)挑戰(zhàn),其中最主要的問題是探索開銷過高。由于智能體必須依賴試錯來發(fā)現(xiàn)有效技能,它需要進(jìn)行大量無效交互才能找到最優(yōu)策略。這不僅導(dǎo)致計算資源的消耗增加,也限制了智能體的實(shí)際部署效率。此外,技能泛化困難也是一個值得關(guān)注的問題。當(dāng)前的技能庫往往受到環(huán)境限制,智能體在某個游戲或任務(wù)中學(xué)習(xí)到的技能并不能直接遷移到另一個任務(wù)環(huán)境。例如,在《殺戮尖塔》中掌握的卡牌拖拽技能,無法直接用于《文明5》的單位調(diào)度任務(wù)。

如何實(shí)現(xiàn)技能的通用化,使得智能體能夠在不同任務(wù)環(huán)境間復(fù)用已有技能,是未來研究的關(guān)鍵方向。除此之外,長時序策略不足也是一個問題。盡管智能體能夠?qū)W習(xí)短期技能并優(yōu)化自身行動,它在長期戰(zhàn)略規(guī)劃上的能力仍然有限。現(xiàn)有的隱式獎勵機(jī)制更多依賴視覺變化作為反饋,但對于那些需要長期積累才能產(chǎn)生效果的決策,例如文明發(fā)展、資源管理等,智能體仍然難以準(zhǔn)確識別并執(zhí)行最優(yōu)策略。

未來研究可以從多個方面展開,優(yōu)化技能發(fā)現(xiàn)機(jī)制可以減少探索開銷,讓智能體在更短的時間內(nèi)找到高效技能。這可能涉及強(qiáng)化學(xué)習(xí)技術(shù)的結(jié)合,使智能體能夠更快地識別哪些行為值得嘗試,而不是完全依賴試錯。探索跨環(huán)境遷移的方法,可以讓智能體在不同任務(wù)場景下共享技能。這可能涉及視覺語言模型(VLM)與知識圖譜的結(jié)合,使技能能夠以更高層次的抽象方式存儲和調(diào)用。此外,融合記憶機(jī)制也是一個可能的方向。當(dāng)前智能體在每個任務(wù)環(huán)境中都是從零開始學(xué)習(xí),如果能夠引入長期記憶,使得它可以依賴過去的經(jīng)驗來調(diào)整當(dāng)前行動,可能會極大提升學(xué)習(xí)效率。

在多智能體協(xié)同方面,異步探索可能會導(dǎo)致技能庫的不一致問題。多個智能體在不同環(huán)境下發(fā)現(xiàn)并優(yōu)化技能,但這些技能如何協(xié)調(diào)更新,避免沖突或冗余?未來可以考慮去中心化協(xié)調(diào)策略,例如基于信任機(jī)制的技能共享模型,或者采用版本控制技術(shù),使得智能體可以根據(jù)任務(wù)需求選擇最適合的技能版本。

此外在大規(guī)模智能體部署時,如何保證智能體在不同任務(wù)環(huán)境中自主優(yōu)化,并保持共享技能庫的合理性?這可能涉及動態(tài)權(quán)重分配,讓智能體能夠優(yōu)先學(xué)習(xí)那些被其他智能體驗證過有效的技能,而不是盲目嘗試新技能。

自底向上智能體設(shè)計雖然仍處于早期階段,但它展示了智能體從執(zhí)行者向探索者轉(zhuǎn)變的可能性。這不僅推動了人工智能的發(fā)展,也讓我們開始重新思考智能體如何真正具備學(xué)習(xí)和進(jìn)化能力。隨著計算資源的優(yōu)化、新技術(shù)的融合以及跨環(huán)境遷移的突破,我們可能會看到越來越多的智能體具備真正的適應(yīng)性,從游戲世界走向現(xiàn)實(shí)世界,最終成為自主智能系統(tǒng)的一部分。(END)

參考資料:???https://arxiv.org/pdf/2505.17673??

本文轉(zhuǎn)載自??獨(dú)角噬元獸??,作者:FlerkenS