AI大模型本地化方案:Xinference 本地運(yùn)行大模型

一、Xinference簡(jiǎn)介

Xorbits Inference(Xinference)是一個(gè)開(kāi)源的分布式推理框架,專(zhuān)為大規(guī)模模型推理任務(wù)設(shè)計(jì)。它支持大語(yǔ)言模型(LLM)、多模態(tài)模型、語(yǔ)音識(shí)別模型等多種模型的推理,極大簡(jiǎn)化了這些模型的部署過(guò)程。

二、Xinference Docker部署

在部署Xinference時(shí),選擇使用Docker容器可以帶來(lái)許多便利。首先,需要拉取Xinference的Docker鏡像文件,但請(qǐng)注意,該鏡像文件較大,約為17.7GB,拉取過(guò)程可能需要較長(zhǎng)時(shí)間。拉取命令如下:

拉取完成后,可以創(chuàng)建一個(gè)目錄用于存放Xinference的緩存文件和日志文件,以便更好地管理數(shù)據(jù)。

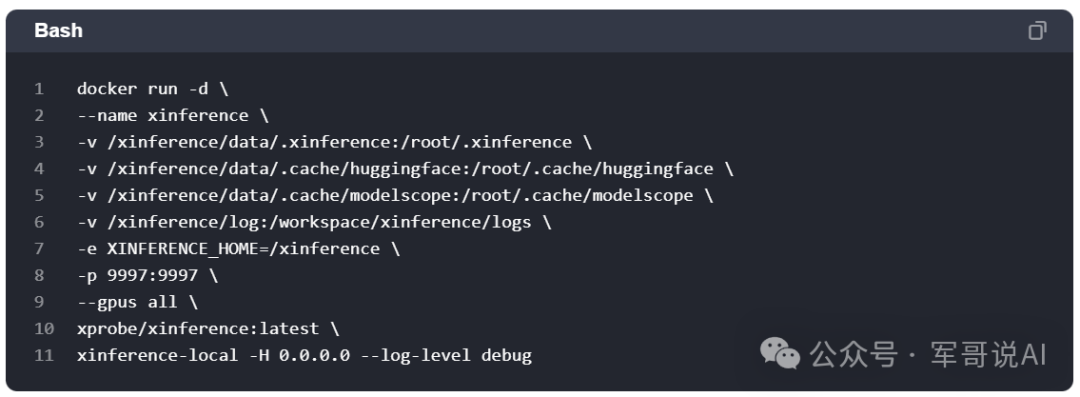

接下來(lái),啟動(dòng)Xinference Docker容器。默認(rèn)情況下,鏡像中不包含任何模型文件,但會(huì)在容器內(nèi)下載所需模型。如果已有下載好的模型,可以通過(guò)掛載宿主機(jī)目錄到容器內(nèi)來(lái)使用這些模型。同時(shí),需要配置一些環(huán)境變量來(lái)指定模型下載源和存儲(chǔ)目錄。

三、Xinference本地運(yùn)行大模型

容器啟動(dòng)后,可以通過(guò)訪問(wèn)公網(wǎng)地址加上9997端口來(lái)啟動(dòng)大模型。例如,啟動(dòng)qwen2-instruct模型,并使用Xinference自帶的圖形化聊天界面進(jìn)行測(cè)試。

此外,還可以測(cè)試其他類(lèi)型的大模型,如圖片生成模型和多模態(tài)模型。啟動(dòng)這些模型時(shí),需要注意GPU資源的需求,并根據(jù)實(shí)際情況選擇合適的GPU配置。

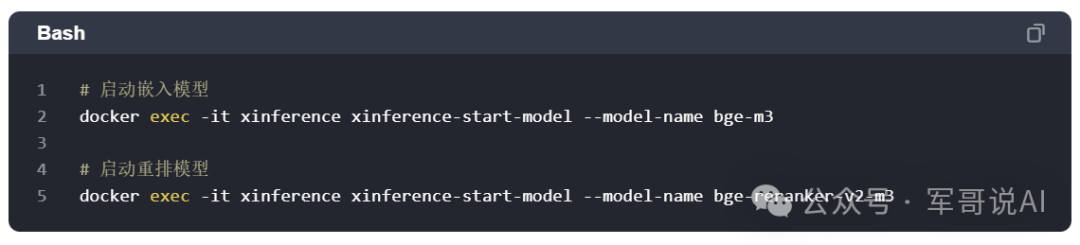

四、Xinference啟動(dòng)嵌入和重排模型

Xinference支持啟動(dòng)嵌入和重排模型,這些模型在后續(xù)的處理中可能會(huì)被其他系統(tǒng)或應(yīng)用調(diào)用。例如,可以啟動(dòng)bge-m3嵌入模型和bge-reranker-v2-m3重排模型,并為后續(xù)調(diào)用做好準(zhǔn)備。

請(qǐng)注意,Xinference目前無(wú)法同時(shí)運(yùn)行多個(gè)大模型(如語(yǔ)言模型、圖片模型、語(yǔ)音模型),但可以同時(shí)啟動(dòng)多個(gè)嵌入模型和重排模型。

本文轉(zhuǎn)載自??軍哥說(shuō)AI??,作者:軍哥說(shuō)AI