內行看Manus!大模型通過Deep ReSearch駕馭Multi-Agent原理深度剖析 原創

這兩天AI產品的頻繁出圈,都把大家整焦慮了,我朋友圈有同學宣布一個月不看AI新聞,閉關了。

為啥,都是Manus鬧的。當然,背后其實是自媒體無底線的尬吹。

我今天一直在考慮要不要蹭Manus的流量,內心糾結了半天,后來看到某大V連續兩天發的文章,就釋懷了。

人家是真本事啊,第一天把Manus吹上天,第二天又發文理性批評,真是妙啊,好人壞人都當了,這流量賺的的是滿滿的。

真是昨天叫人家小甜甜,今天改叫人家牛夫人了,像極了一個滿頭大汗耳鬢廝磨一哆嗦后,進入賢者模式的油膩中年男人。

客觀公正的講,Manus其實是一個成熟度已經非常可以的產品了,理念也非常不錯,再把產品打磨打磨,依然會有很多用戶,就是營銷用力過猛了!

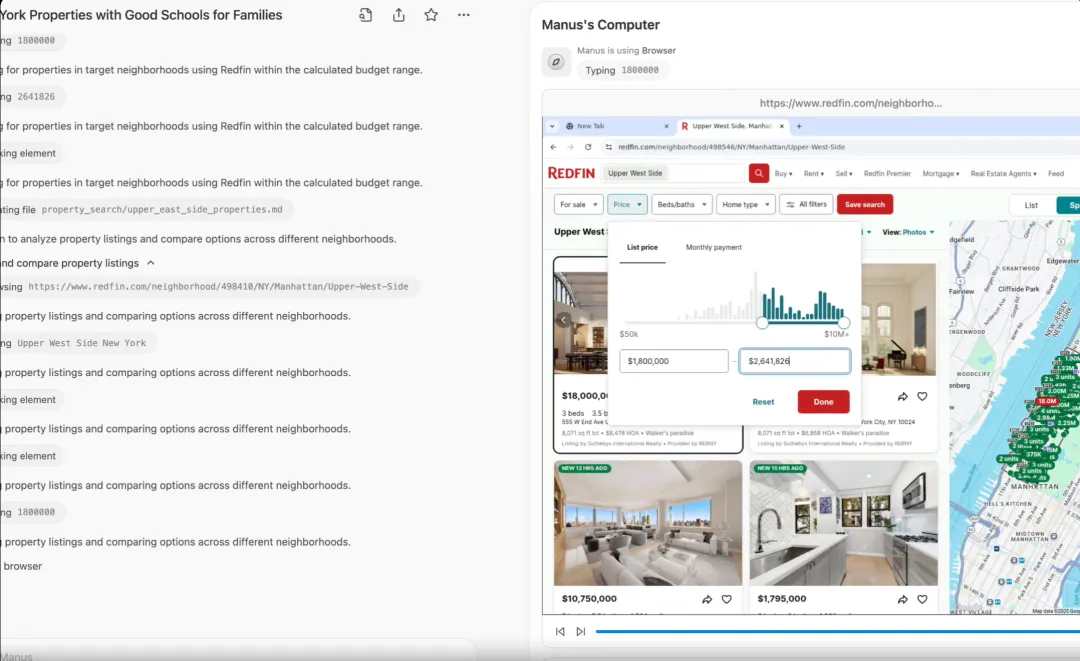

Manus 最大是亮點就是把其他大模型 后臺運行的Deep Research 工作過程,在網頁上通過虛擬機用所見即所得的方式呈現出來了。其實技術壁壘不是很高,而且虛擬機需要大量的硬件資源做支撐,沒錢很難保持技術優勢,算是現象級產品,下一步就是融資吧。

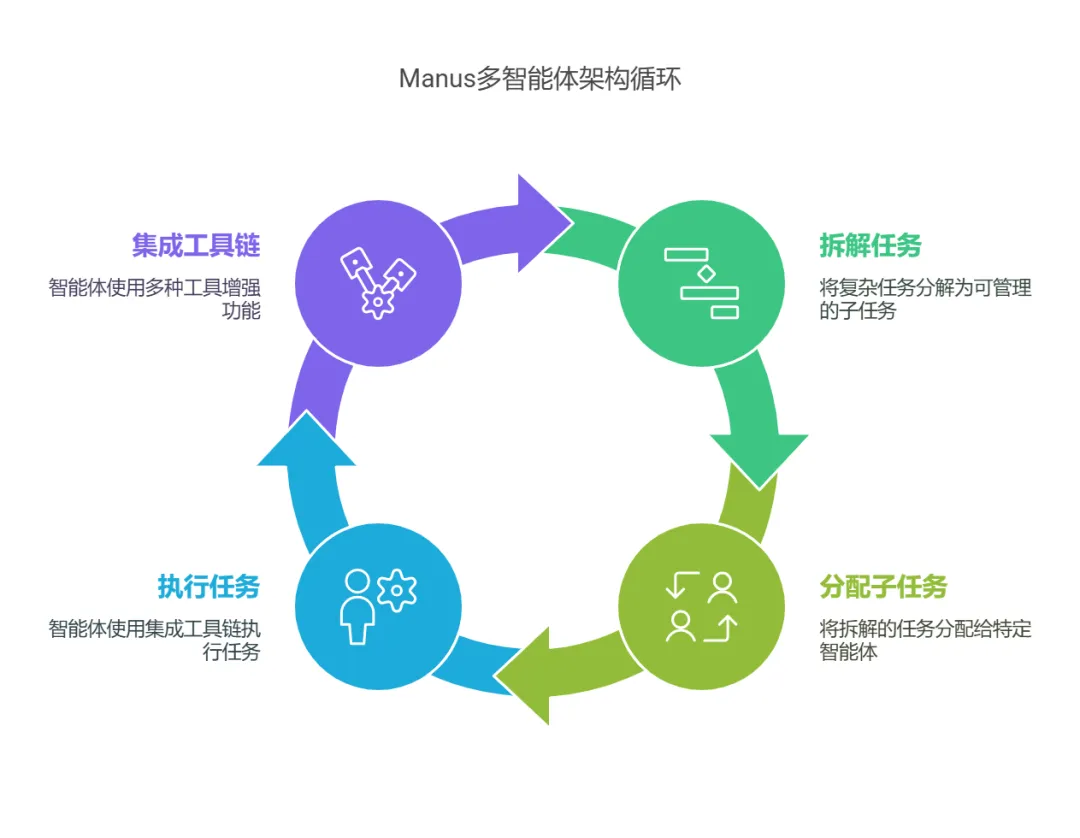

Manus從架構上來講,是一種Multi-Agent(多智能體)架構,功能是能夠將復雜任務拆解為多個子任務,并分配給不同的Agent(智能體)執行,每個智能體均具備工具鏈集成屬性,集成多種工具,如網絡搜索、代碼執行、文件處理等,以增強智能體的功能。

上面這段話是不是很繞,沒讀明白,其實把Manus想成你自己的公司,把里面的智能體想成你自己就明白了。

公司如何管理我們這些員工的呢,每個公司的運行機制可能五花八門,這個運行機制就是我們今天要講的DeepReSearch。

不過這里要強調一下,我們在大模型搜索框下面看到的深度搜索一般是指DeepSearch,DeepSearch和Deep Research還是有區別的,大體可以這么區分,DeepSearch是工蜂,干臟活的,DeepReSearch是蜂后,一大家子都得聽她的,圍著她轉。

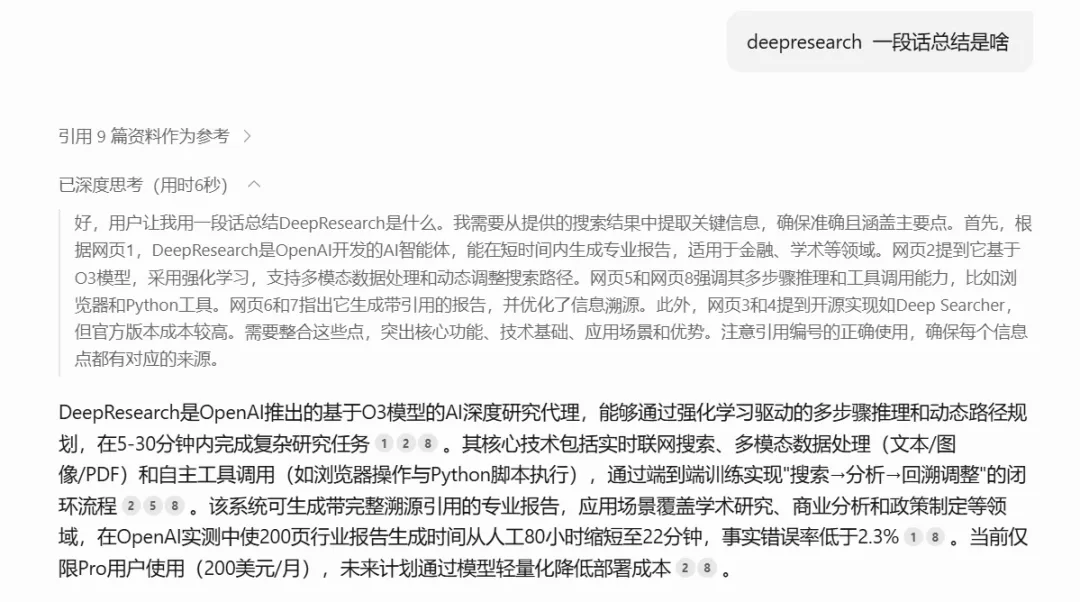

啰嗦了這么多,終于繞道正題了,Deep ReSearch的工作原理到底是啥。我也是個小白(尷尬臉~),要不問問DeepSeek吧!

好家伙,說了這么多高大上的術語,如果DeepSeek是售前經理,還不得把甲方爸爸給忽悠暈了 。讓DeepSeek說人話!

這樣就清晰多了,其實這里面的關鍵詞就三個:深度規劃,深度搜索、深度優化。

(1)深度規劃

深度規劃的作用類似公司的CEO,執行董事會的命令(用戶的需求提示詞),規劃籌謀任務,然后再把這些活分給下面的人去做,下面的人即使反饋結果回來,他能動態的調整任務的規劃。

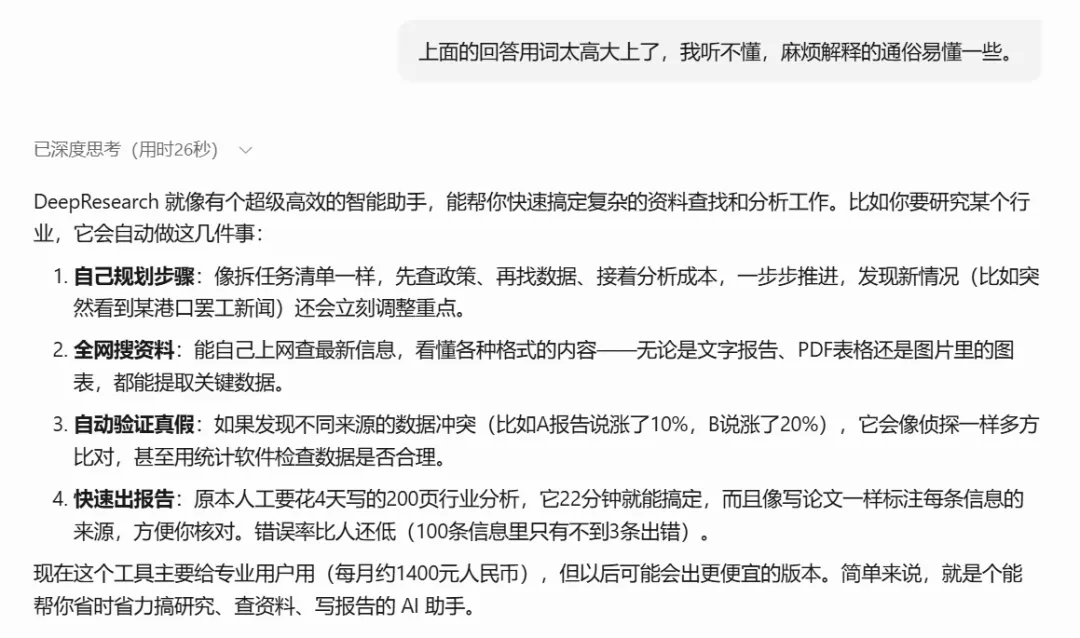

用DeepSeek的話說,就是像拆任務清單一樣,根據需求,先查政策、再找數據、接著分析成本,一步步推進,發現新情況(比如突然看到某港口罷工新聞)還會立刻調整重點。

這就完了嗎?就這么簡單,其實整個事情就是這么回事,但是用我們普通人聽不太懂的專業話術包裝一下就立馬高大上了。

語義拆解算法:基于Deepseek-r1模型的任務樹生成,采用蒙特卡洛樹搜索(MCTS)優化決策路徑。例如在分析"新能源汽車供應鏈"時,系統自動生成包含「鋰電池原料價格預測→充電樁分布熱力圖生成→政策補貼影響建模」的任務節點樹,每個節點附帶執行策略(如調用Wind API獲取鈷價數據)。

實時權重調整:通過Q-learning算法動態更新任務優先級矩陣,當檢測到東南亞鎳礦出口波動時,鎳價預測子任務的權重系數從0.3提升至0.7。

上面的語義拆解算法 本質就是任務清單拆解的技術實現,給甲方爸爸講故事,不可能直白的說,啊那個深度規劃就是分任務,這樣你的產品肯定賣不出去。

作為智能體應用層面的從業者,也只能研究到這個層面了,再深就是數學算法、人工智能底層生態的科研工作者的任務了,而我還不具備那個水平,方向也不在這里,因此也就沒有Fomo的心態!

(2)深度搜索

談下一話題,深度搜索 Deep Search!

最厲害最科學的搜索方式,管它什么深的淺的,就是像真人一樣去搜索。

不知道大家知道Selenium這個能控制瀏覽器的爬蟲庫不,當時看到Manus宣傳片出來的虛擬機,只覺得很眼熟,很親切,因為讓瀏覽器自動刷新頁面,然后從頁面上獲取數據這個流程,我太熟悉了。

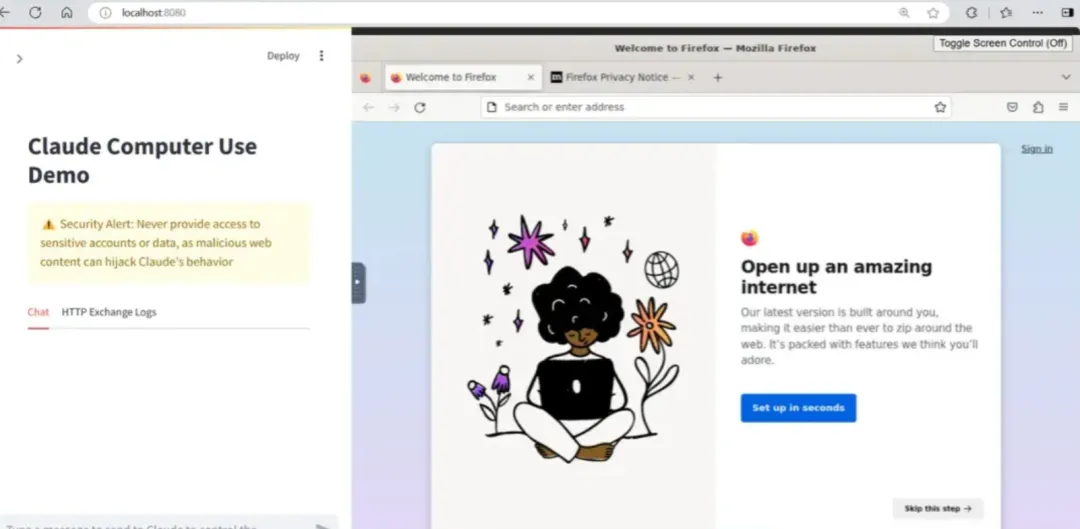

這種直接在瀏覽器操作網頁或者電腦的技術,其實已經很普及了,提出MCP協議,大名鼎鼎的Claude 開源的computer use,能夠與操縱計算機桌面環境的工具進行交互,類似的還有browser use。Manus其實就是將computer use這類的工具進行了深度整合,再加上Deep ReSearch的工程原理,Manus團隊的整合能力和執行能力確實優秀,最后能夠成功出圈,也有種天道酬勤的感覺。

其實不管控制電腦也罷、使用API也罷,本質都是為大模型決策收集能夠利用的數據。

所以深度搜索主要是很多前就攢下來的爬蟲技術棧,現在用LLM這個狗頭軍師重新武裝了一下,沒想到以前游走在擦邊灰產和逆向工程的爬蟲技術,因為AI又煥發了第二春。

深度搜索就好像公司的CMO,干具體活的,有了大模型后,爬蟲技術和搜索技術變得高級一點,可以使用大模型對搜索結果實時判斷了,在搜索過程中不斷判斷結果是否符合用戶需求。如果不符合,就重組關鍵詞,繼續搜索,繼續爬取,直到找到匹配的內容為止。

LLM這個狗頭軍師是怎么和爬蟲框架狼狽為奸的,用了哪些計謀,我這里貼上DeepSeek給我總結的專業術語。

循環控制優化:采用令牌預算感知的早停機制(Early Stopping),當置信度達95%或消耗80%預算時觸發強制終止,避免無效計算。實測顯示該策略降低30%的冗余計算。

多級驗證協議:在半導體產業分析案例中,系統檢測到臺積電財報與SEMI行業數據的產能數據差異18%時,自動啟動三級驗證:①橫向比對8份行業報告;②執行T檢驗(p=0.032);③調用專家知識庫修正數據權重。

已經對多種多樣數據進行處理的能力,專業術語叫異構數據統一表征。

跨模態索引構建:使用CLIP模型將圖像(如港口衛星圖)與文本(貨運報告)映射到同一向量空間,相似度計算誤差控制在5%以內。在分析鹿特丹港擁堵時,系統自動關聯衛星圖像中的船舶密度與文本描述的吞吐量下降數據。

結構化數據轉換:通過SPARQL生成器將Excel表格轉換為RDF三元組,支持知識圖譜的實時更新。某汽車供應鏈分析中,成功將1357行BOM表數據轉化為3789個實體關系。

(3)深度優化

深度優化類似于公司里面的質量監控機制或者公司里面的法務、財務這些合規崗,比如發現不同來源的數據沖突(比如A報告說漲了10%,B說漲了20%),深度優化功能就會像會像偵探一樣多方比對,甚至用統計軟件檢查數據是否合理。

上面功能的實現也是由專干這個事情的智能體組成的。最常見的案例就是我們讓大模型寫了一篇文章,但是不知道這個文章寫的科學與否,那么就可以將這篇文章交給一個專門負責文章科學性檢測的智能體去體檢一下,評個分。

這個智能體使用技術比較簡單,就是長上下文勘誤,使用大模型對整篇文檔進行校驗和優化,確保邏輯連貫、內容準確,當然體檢的項目由你的提示詞來決定。這也就從另一方面告我們,提示詞工程雖然有點玄學,但是作用和地位卻很重要。 ?

具體到技術實現,就看你的算法怎么設計了,簡單的直接用我們的大白話給智能體設置評分標準,專業的則像下面這種專業的AIGC生成質量保證體系。

可信度量化模型

- 四維評估矩陣通過梯度提升樹(GBDT)動態調整權重,當分析醫療行業時,來源權威性權重提升至40%(考慮期刊影響因子)。某創新藥研發報告中,系統識別到預印本論文與臨床試驗數據的矛盾,自動降權處理。

可視化溯源系統

- 雙層注釋系統采用React框架實現交互式報告,用戶點擊"海運成本上漲23%"結論時,可展開查看馬士基財報原文(OCR識別準確率98.7%)和ARIMA預測模型的參數(p=2,d=1,q=1)。

出了對大模型與Agent生成質量的深度優化,也有效率和性能方面的優化。比如下面這種。

混合檢索加速

- 向量檢索(Milvus)與關鍵詞檢索(Elasticsearch)的混合查詢響應時間優化至平均230ms,在查詢"5G基站能耗"時,語義檢索召回率提升至92%,精準率85%。

增量更新策略

- 動態知識圖譜采用差異更新算法,每次搜索僅更新12.7%的節點。在跟蹤俄烏沖突對能源市場影響時,更新效率較全量更新提升8倍。

(4)Deep Research在Manus中的體現

在Manus的演示案例中,Deep Research的能力得到了充分體現。例如,在“分析特斯拉股票”的任務中,Manus通過不斷執行搜索、檢查、勘誤和反思的過程,最終生成了一份高質量的分析報告。這種能力不僅依賴于強大的搜索算法,還需要高效的規劃和整合能力。

示例報告生成流程:

1. 搜索特斯拉的財務數據 -> 填充到“財務分析”章節

2. 搜索特斯拉的市場表現 -> 填充到“市場分析”章節

3. 使用大模型對整篇報告進行校驗和優化沒想到研究這種專業理論只是比去設計個智能體還費時間,這篇文章從中午12點有想法,到搜集資料到落筆寫成一直持續到了晚上10點半。

路漫漫其修遠兮,吾將上下而求索。杭州深度求索,DeepSeek的公司名。

深夜人會更加感性,所以多說幾句。

謝謝你能讀到這里,也謝謝DeepSeek出圈對大模型普及起到的巨大作用,培育了這么多求知欲旺盛的優秀讀者。

本文轉載自公眾號九歌AI大模型 作者:九歌AI