xLSTM:拳打Transformer,腳踢Mamba?! 原創

大模型技術論文不斷,每個月總會新增上千篇。本專欄精選論文重點解讀,主題還是圍繞著行業實踐和工程量產。若在閱讀過程中有些知識點存在盲區,可以回到如何優雅的談論大模型重新閱讀。另外斯坦福2024人工智能報告解讀為通識性讀物。若對于如果構建生成級別的AI架構則可以關注AI架構設計。

記得在《重新審視神經網絡》這篇文章中提及,任何人都可以構建自己心目中的神經網絡。在Transformers、Mamba、KAN之后,長短期記憶 (LSTM) 架構的發明者Sepp Hochreiter和他在NXAI的團隊推出了一種稱為擴展LSTM (xLSTM) 的新變體。

1.xLSTM的背景

LSTM在自然語音處理的領域影響巨大,但它也有局限性。在一些特殊的任務上,比如最臨近鄰搜索的時候,在記憶細胞的更新方面就頗有壓力。來自ELLIS、LIT AI實驗室、奧地利林茨NXAI實驗室的研究人員希望通過解決LSTM語言模型的局限性來增強LSTM。

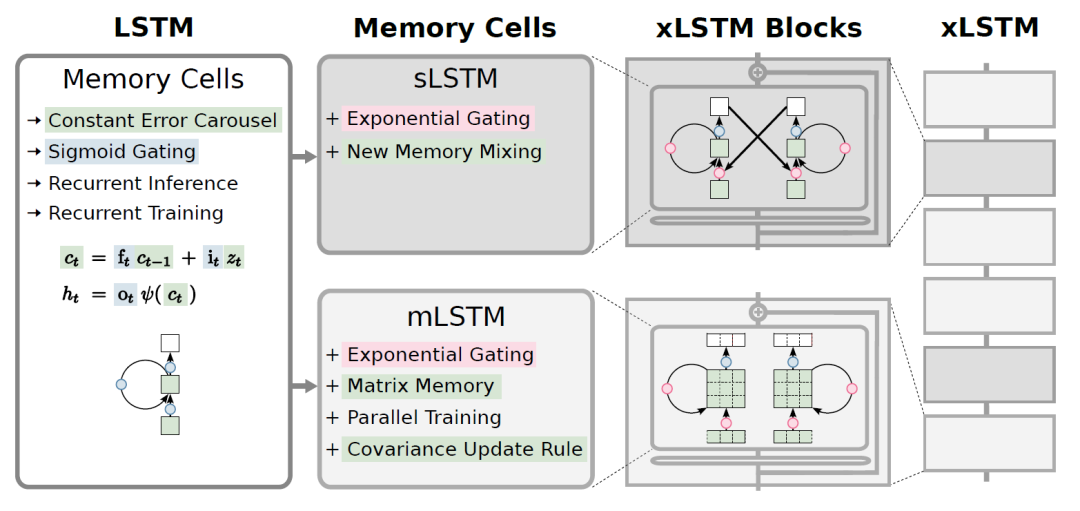

改進點有不少,小編認為沒有LSTM的基礎很難完全看得明白。因此決定初看改進點之后,將一些基本的知識點做回顧,否則只會走馬觀花。xLSTM的改進點:

引入具有適當歸一化和穩定技術的指數門控(可以理解為激活函數)。

修改LSTM記憶結構,推出兩種記憶細胞。第一種是sLSTM,它具有標量記憶、標量更新和新記憶混合的能力,第二種是mLSTM,它擁有矩陣記憶,而且這些記憶可以通過協方差更新且全部具備并行運算

將上面的LSTM擴展體結合殘差網絡設計模式產生xLSTM塊,然后將這些塊堆疊到xLSTM架構。

和Transformer和狀態空間模型相比,指數門控和修改后的記憶結構增強了xLSTM的性能,無論是在性能還是擴展方面表現尚可。這些突破讓LSTM長期在大語言模型上的瓶頸得到解決,也許未來可能會成為新的大語言技術巨頭。

Transformer只是一種大語言模型的架構,核心還是注意力機制,然而計算的復雜度還是擺在那兒。有不少的競爭者例如Synthesizer、Linformer、Linear Transformer和Performer專注于線性開銷的注意力技術。狀態空間模型 (SSM) 因其上下文長度的線性也備受關注,S4、DSS、BiGS和Mamba異軍突起。具有線性單元和門控機制的循環神經網絡 (RNN) 也在掙扎,HGRN和RWKV。xLSTM則利用協方差更新規則、記憶混合和殘差堆疊架構進行關鍵組件的增強,不容小覷。

在xLSTM用于語言建模的實驗評估中,xLSTM的功能在形式語言、聯想回憶任務和遠程競技場場景上進行了測試。與現有方法的比較揭示了xLSTM 在驗證困惑度方面的優越性。

消融研究強調了指數門控和矩陣記憶在xLSTM性能中的重要性。對300B 個token進行的大語言建模驗證了xLSTM的有效性,顯示了其在處理長上下文、下游任務和多樣化文本域方面的魯棒性。縮放行為分析表明,隨著規模的增加,xLSTM與其他模型相比具有良好的性能。隨著序列長度的增加,xLSTM架構的時間復雜度為O(N),內存復雜度為O(1),這點比Transformer更加高效。

2.指數門控

xLSTM論文中引入的指數門控機制是對LSTM中使用的傳統sigmoid門控的重大改進。這里要給大家科普一下,模型輸出數值一般會經過激活函數,sigmoid是其中的一種,任何輸入都會得到0~1期間的數值。一般在LSTM中,0就代表著不通過,1代表允許通過。那么門控的意思大白話就是門閥,它決定著信息的穿透度。

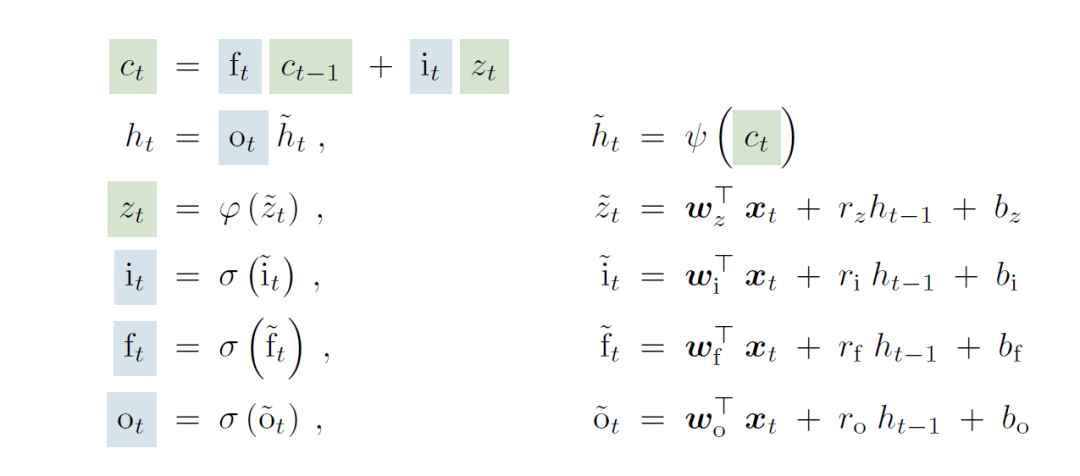

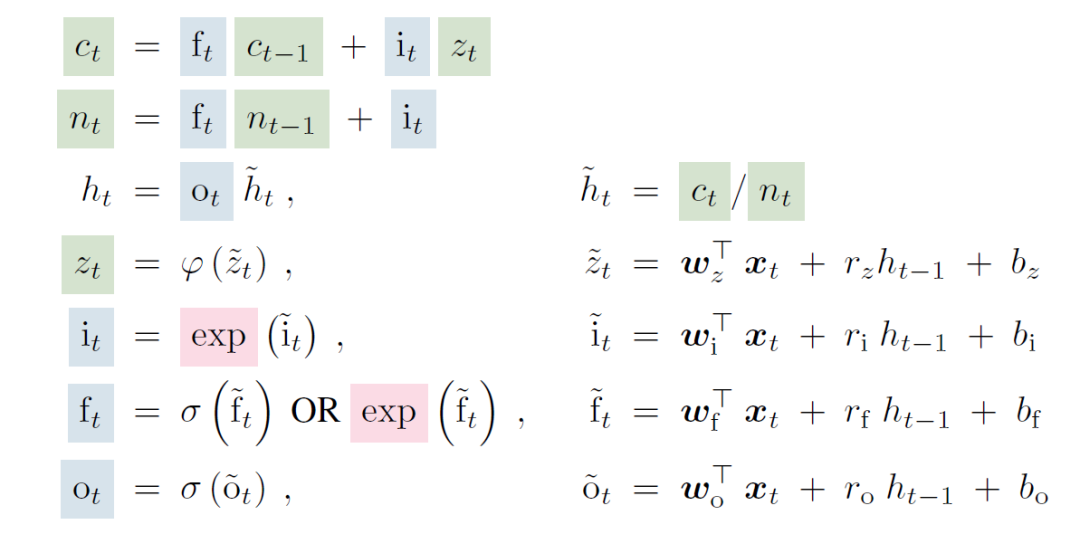

|

|

上圖就對比了原來LSTM和sLSTM的運算公式,新的里面由σ函數被替代為exp函數。原論文對于替換的解釋是由此增強了模型在處理新信息時能有效修改和更新其記憶的能力。

在傳統的 LSTM 中,sigmoid函數限制了模型對記憶單元狀態進行實質性改變的能力,特別是當門值接近0或1時。這種限制阻礙了LSTM快速適應新數據,并可能導致低效的記憶更新。

xLSTM通過用指數激活函數替換sigmoid激活函數來解決此問題。指數門控允許記憶細胞狀態發生更明顯的變化,(指數函數的取值范圍0~+∞)使模型能夠快速整合新信息并相應地調整其記憶。歸一化器有助于穩定指數門控并維持輸入門和遺忘門之間的平衡。

3.矩陣記憶

xLSTM論文的另關鍵貢獻是引入了矩陣記憶體(內存,或者稱之存儲器),它取代了傳統 LSTM中使用的標量存儲單元。在LSTM中,存儲單元由單個標量表示,約束了每個時間步可以存儲和處理的信息量。這種局限性可能會阻礙模型捕獲和保留復雜依賴關系和長期信息的能力。

xLSTM通過采用矩陣存儲器突破這一限制,其中每個存儲器單元由矩陣而不是標量表示。從標量內存到矩陣內存的轉變顯著增強了模型存儲和處理豐富的高維信息的能力。

矩陣內存允許xLSTM捕獲輸入數據中更復雜的關系和依賴關系。它使模型能夠更全面地表示上下文和長期依賴性,從而提高需要理解和生成復雜序列的任務的性能。

4.可并行架構

xLSTM最重要的進步是引入了可并行架構,它解決了傳統LSTM的主要限制。在傳統的LSTM中,令牌的處理是按順序執行的,其中每個令牌一次處理一個,這限制了模型利用并行性的能力,并導致訓練和推理時間變慢。xLSTM 架構引入了mLSTM(矩陣內存LSTM)和sLSTM(標量 LSTM)塊的靈活組合,從而實現令牌的并行處理。

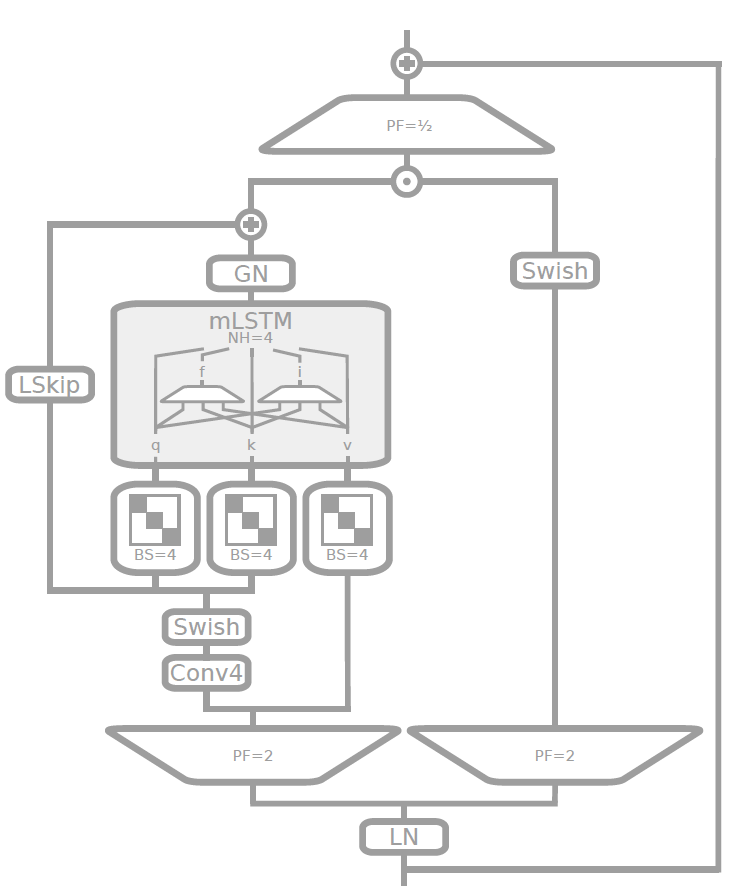

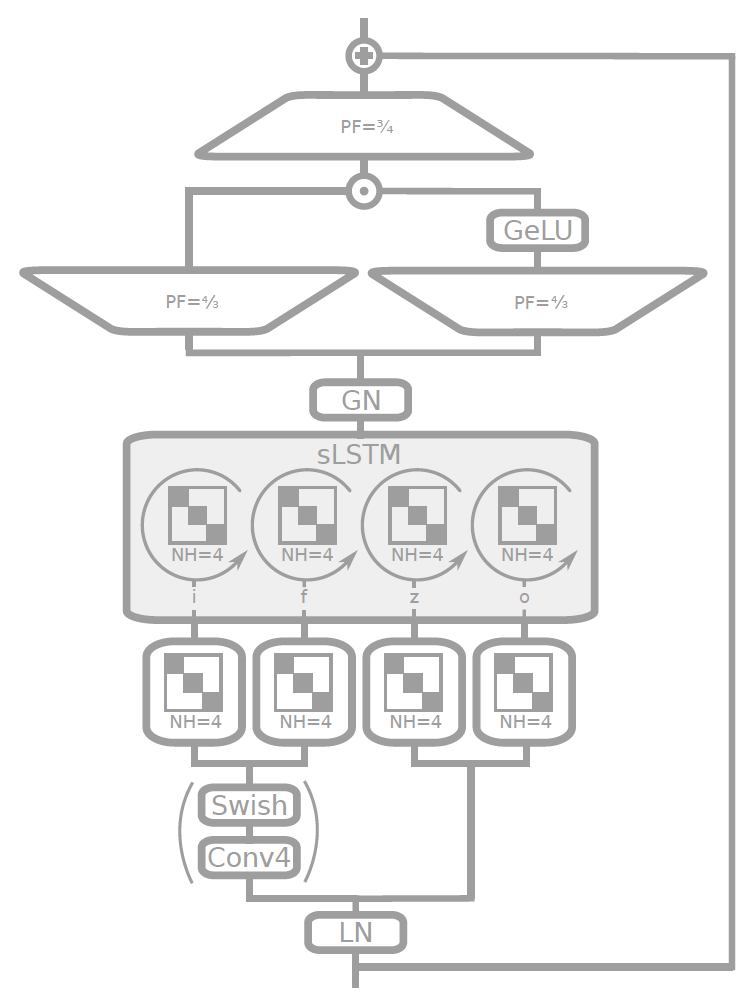

|

|

mLSTM塊 | sLSTM塊 |

mLSTM被設計為同時對整個令牌序列進行操作,從而實現類似于 Transformer 模型實現的并行性的高效并行計算。主要還是利用矩陣存儲機制,使它們能夠并行捕獲和處理所有令牌的豐富、高維信息。這種并行處理能力顯著加快了訓練和推理過程,使 xLSTM 比傳統 LSTM 的計算效率更高。

另一方面,sLSTM 則被設計為保留了傳統LSTM的順序處理性質,允許模型捕獲對于特定任務可能很重要的某些順序依賴性。在 xLSTM 架構中可以靈活的以不同比例堆疊mLSTM和sLSTM塊,提供了并行性和順序建模之間的平衡,從而能夠適應各種語言建模任務。

本文轉載自 ??魯班模錘??,作者: 龐德公