Jamba-1.5:大規(guī)模混合Transformer-Mamba模型

一、結(jié)論寫在前面

論文標(biāo)題:Jamba-1.5: Hybrid Transformer-Mamba Models at Scale

論文鏈接:https://arxiv.org/pdf/2408.12570

模型:https://huggingface.co/ai21labs

論文介紹了Jamba-1.5,基于Jamba架構(gòu)的新型指令調(diào)優(yōu)大型語(yǔ)言模型。Jamba是一種混合Transformer-Mamba專家混合架構(gòu),能夠在不同上下文長(zhǎng)度下提供高吞吐量和低內(nèi)存使用,同時(shí)保持與Transformer模型相同或更好的質(zhì)量。

論文發(fā)布了兩種模型尺寸:Jamba-1.5-Large,具有940億活躍參數(shù),以及Jamba-1.5-Mini,具有120億活躍參數(shù)。這兩種模型都針對(duì)多種對(duì)話和指令遵循能力進(jìn)行了微調(diào),并且具有256Ktoken的有效上下文長(zhǎng)度,是開放權(quán)重模型中最大的。

為了支持成本效益高的推理,論文引入了ExpertsInt8,一種新穎的量化技術(shù),允許在處理256K token上下文時(shí),將Jamba-1.5-Large適配到具有8張80GB GPU的機(jī)器上,而不損失質(zhì)量。在學(xué)術(shù)和聊天機(jī)器人基準(zhǔn)測(cè)試中評(píng)估時(shí),Jamba模型取得了優(yōu)異的成績(jī),同時(shí)提供了高吞吐量,并在長(zhǎng)上下文基準(zhǔn)測(cè)試中超越了其他開放權(quán)重模型。

二、論文的簡(jiǎn)單介紹

2.1 論文的背景?

論文介紹了Jamba-1.5,兩個(gè)基于論文的Jamba架構(gòu)[的新型大語(yǔ)言模型,可供公眾使用。Jamba-1.5-Mini是論文早期Jamba版本的更新和指令調(diào)優(yōu)版本。與其較小的同類產(chǎn)品一樣,Jamba-1.5-Large是一種混合架構(gòu),結(jié)合了Transformer和Mamba層,以及專家混合(MoE)模塊。

自Jamba推出以來(lái),類似的努力已經(jīng)證實(shí)了在高達(dá)8B參數(shù)規(guī)模上結(jié)合Transformer和狀態(tài)空間模型的優(yōu)勢(shì)。Jamba-1.5-Large在更大規(guī)模上展示了這種架構(gòu)的優(yōu)勢(shì)。它具有94B活躍參數(shù),總共398B參數(shù)。即使在這個(gè)大尺寸下,由于Jamba架構(gòu)的效率以及論文開發(fā)的一種新穎量化技術(shù),該模型可以在處理256Ktoken上下文時(shí)適配到具有8張80GB GPU的單臺(tái)機(jī)器上。

Jamba-1.5-Mini和Jamba-1.5-Large均為經(jīng)過指令微調(diào)的模型,通過Post-training賦予了多種能力。論文在廣泛的基準(zhǔn)測(cè)試中評(píng)估發(fā)現(xiàn),它們?cè)谛阅苌吓c同尺寸模型相當(dāng),同時(shí)得益于Jamba架構(gòu)的高效性。特別是,Jamba-1.5模型在長(zhǎng)上下文評(píng)估中表現(xiàn)突出,使其成為唯一在RULER

基準(zhǔn)測(cè)試中有效長(zhǎng)度達(dá)到256K的模型,同時(shí)實(shí)現(xiàn)了KV緩存內(nèi)存減少10倍以及卓越的吞吐量和延遲。

這些模型已公開可用:

Jamba-1.5-Mini: https://huggingface.co/ai21labs/AI21-Jamba-1.5-Mini

Jamba-1.5-Large: https://huggingface.co/ai21labs/AI21-Jamba-1.5-Large

2.2 模型架構(gòu)

Jamba-1.5-Large基于Jamba ,這是一種混合解碼器架構(gòu),融合了Transformer層 與Mamba層(一種狀態(tài)空間模型(state-space model,SSM)),并附加了混合專家(MoE)模塊 。詳見 [24] 對(duì)該架構(gòu)的詳細(xì)描述。

在開發(fā)Jamba [24] 的過程中,論文發(fā)現(xiàn)Transformer、Mamba和MoE元素的結(jié)合有助于平衡吞吐量、內(nèi)存使用和質(zhì)量的需求。Jamba-1.5-Large在大規(guī)模上展現(xiàn)了這種靈活性。

Jamba-1.5-Large 遵循相同的 Jamba 結(jié)構(gòu),但容量更大。它擁有 94B 活躍參數(shù)和 398B 總參數(shù)。它包含 9 個(gè)塊,每個(gè)塊具有以下規(guī)格:

?l= 8每個(gè)block包含 8 層。

?a : m=1 : 7注意力層與 Mamba 層的比例。在論文的 Jamba 研究中,這一比例被發(fā)現(xiàn)是最佳的 [ 2 4 ],后續(xù)工作 [6, 37] 也證實(shí)了類似比例的成功.

?每隔 e=2 層使用 MoE 替代單一 MLP。共有 n=1 6 個(gè)專家,每個(gè)token選擇前 K=2 個(gè)。

?隱藏狀態(tài)維度為 8192。

?注意力查詢頭數(shù)為 64,KV 頭數(shù)為 8。

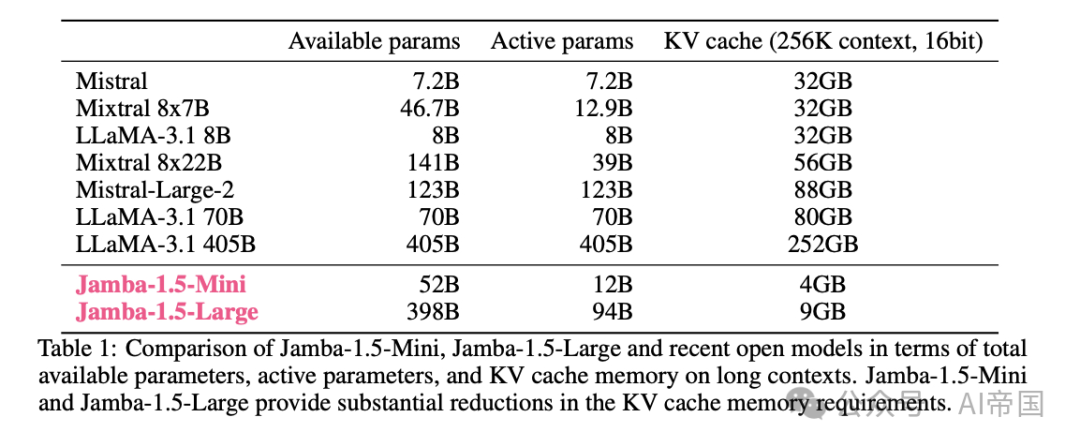

表 1 將 Jamba-1.5 模型與公開可用的類似尺寸模型進(jìn)行了比較。Jamba-1.5-Mini 的活躍參數(shù)數(shù)量與 Mixtral 8x7B 相近,而 Jamba-1.5-Large 的活躍參數(shù)數(shù)量介于 LLaMA-3.1-70B 和 Mistral-Large-2 之間。同時(shí),論文的兩個(gè) Jamba 模型在 KV 緩存內(nèi)存使用(256K token)方面遠(yuǎn)小于所有其他模型,相較于各自的對(duì)應(yīng)模型,大約減少了近一個(gè)數(shù)量級(jí)的內(nèi)存使用。

通過這些設(shè)置以及論文的專用量化(第 3.1 節(jié)),Jamba-1.5-Large 可以在單臺(tái)配備 8 塊 80GB GPU 的機(jī)器上提供服務(wù),上下文長(zhǎng)度可達(dá) 256K token。

表 1:Jamba-1.5-Mini、Jamba-1.5-Large 與近期開放模型在總可用參數(shù)、活躍參數(shù)及長(zhǎng)上下文 KV 緩存內(nèi)存方面的比較。Jamba-1.5-Mini 和 Jamba-1.5-Large 在 KV 緩存內(nèi)存需求上提供了顯著的減少。

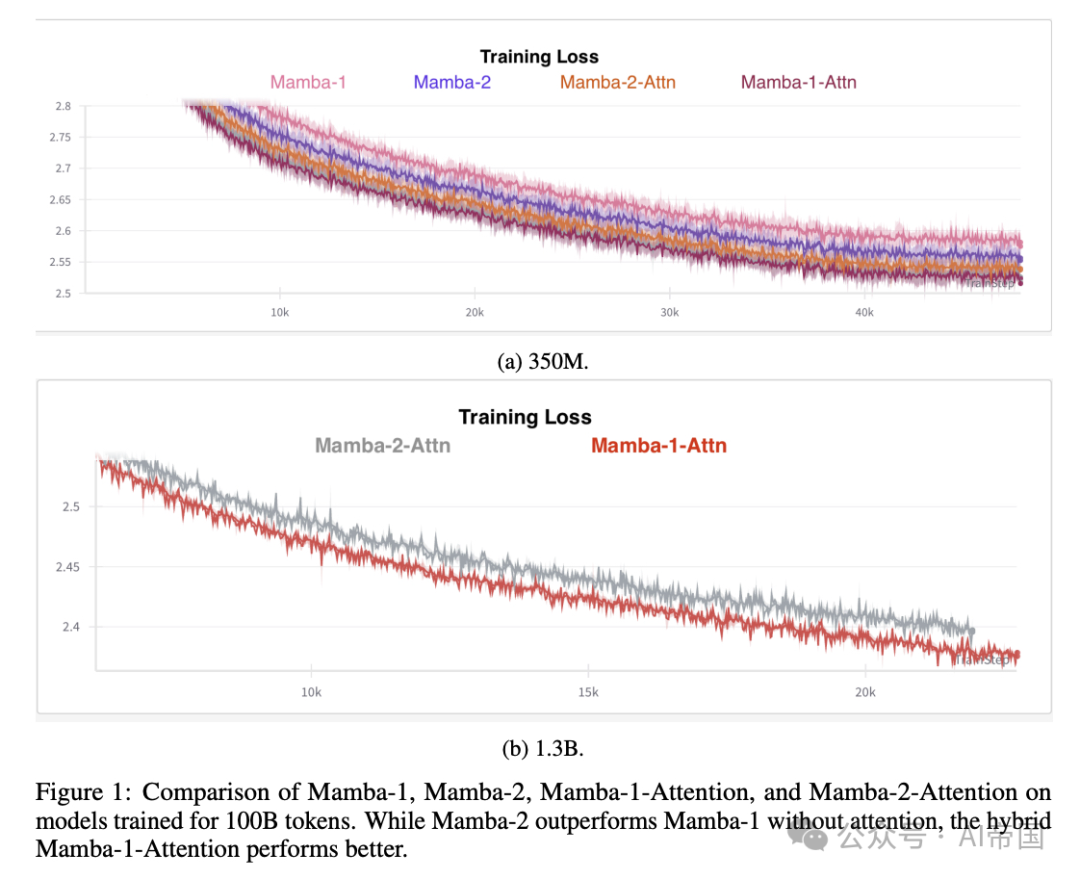

對(duì)于這次發(fā)布,論文還嘗試了Mamba-2 [6],這是Mamba的一個(gè)更快且改進(jìn)的版本,據(jù)報(bào)道其性能優(yōu)于單獨(dú)的Mamba和Transformers。然而,如圖1所示,論文發(fā)現(xiàn),在混合架構(gòu)中,Mamba-1-Attention組合的性能優(yōu)于Mamba-2-Attention,因此論文在Jamba-1.5-Large中采用了Mamba-1。(論文還發(fā)現(xiàn)混合架構(gòu)的性能優(yōu)于純Mamba-2。)論文推測(cè)這是因?yàn)镸amba-2相對(duì)于Mamba-1的一些優(yōu)勢(shì),特別是能夠使用更大的狀態(tài)大小,在論文將全注意力層交錯(cuò)放置在Mamba層之間時(shí),其重要性有所降低,因?yàn)檫@些全注意力層能夠從整個(gè)上下文中匯聚信息。

圖1:Mamba-1、Mamba-2、Mamba-1-Attention和Mamba-2-Attention在訓(xùn)練100B tokens模型上的比較。盡管Mamba-2在沒有注意力機(jī)制的情況下優(yōu)于Mamba-1,但混合的Mamba-1-Attention表現(xiàn)更佳。

2.3 服務(wù)考慮與改進(jìn)

論文分享了一些見解和改進(jìn)措施,以實(shí)現(xiàn)Jamba模型在大規(guī)模上的高效服務(wù)。

2.3.1 專家Int8量化

為了支持Jamba-1.5-Large的高效服務(wù),論文開發(fā)了一種新的量化技術(shù),論文稱之為ExpertsInt8。論文觀察到,超過85%的模型權(quán)重位于MoE層中,超過90%位于MoE或MLP層中。論文希望量化這些權(quán)重,同時(shí)仍然享受快速BF16內(nèi)核的好處。為此,論文將MoE和MLP權(quán)重量化為INT8,以INT8格式保存,并在實(shí)際計(jì)算前將其反量化回BF16。重要的是,反量化步驟直接在vLLM[18]的融合moe內(nèi)核內(nèi)部進(jìn)行。這樣,反量化過程幾乎不增加額外開銷,甚至導(dǎo)致比BF16更低的延遲。論文已經(jīng)將修改后的融合moe內(nèi)核貢獻(xiàn)給了vLLM。

論文的ExpertsInt8方法具有多個(gè)優(yōu)點(diǎn)

?首先,它速度快;量化僅在模型加載時(shí)花費(fèi)幾秒鐘。

?其次,與vLLM中的大多數(shù)其他技術(shù)不同,它不依賴于校準(zhǔn),校準(zhǔn)可能需要數(shù)小時(shí)或數(shù)天,并且可能不穩(wěn)定。

?第三,論文仍然可以使用BF16來(lái)保存大型激活。

?第四,它可以在A100 GPU上使用,而FP8僅在H100上可用。

?最后,論文的量化在延遲上與FP8匹配,同時(shí)超越其他量化技術(shù),且沒有質(zhì)量損失。

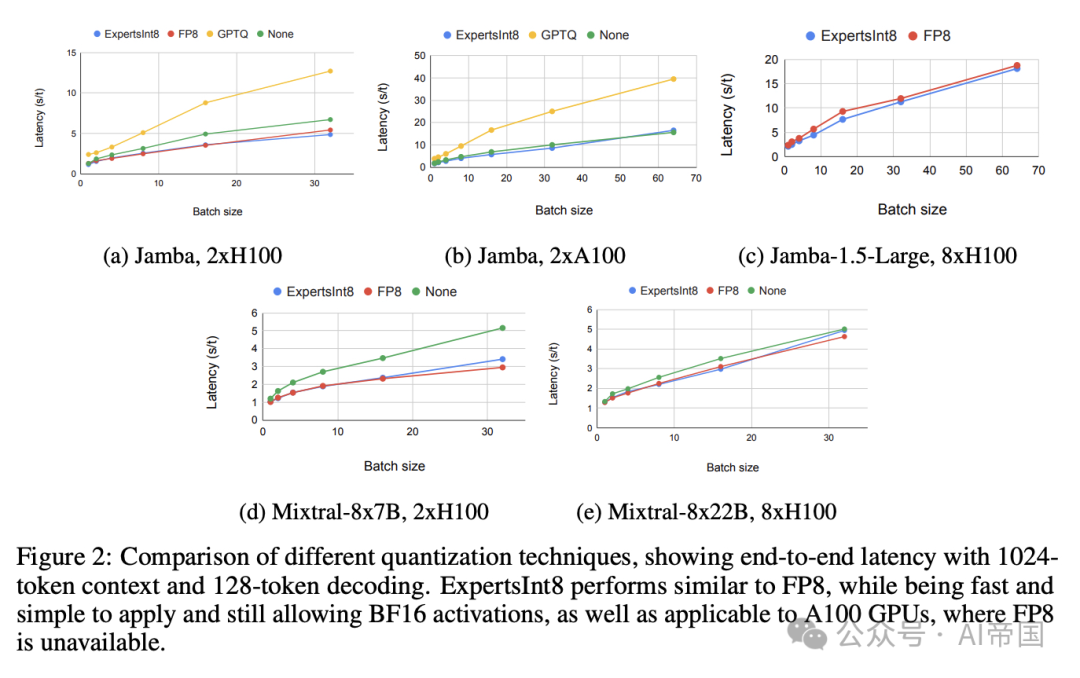

圖2比較了使用Jamba-1.5-Mini、Jamba-1.5-Large以及兩個(gè)Mixtral模型(8x78B和8x22B)的不同量化技術(shù)的延遲。在IH100 GPU上,ExpertsInt8與FP8的延遲相匹配。在A100上,由于FP8不可用,ExpertsInt8是一種有吸引力的技術(shù),大大優(yōu)于GPTQ。結(jié)合上述ExpertsInt8的優(yōu)勢(shì),這使得它成為服務(wù)大型MoE模型的有吸引力的量化技術(shù)。

圖2:不同量化技術(shù)的比較,展示了在1024個(gè)token上下文和128個(gè)token解碼條件下的端到端延遲。ExpertsInt8與FP8表現(xiàn)相似,同時(shí)快速且易于應(yīng)用,仍允許BF16激活,并且適用于A100 GPU,而FP8在這些GPU上不可用。

2.3.2 激活損失

在預(yù)訓(xùn)練過程中,論文發(fā)現(xiàn)某些激活,即特定專家的輸出以及最后Mamba層的輸出,對(duì)于某些輸入token,其幅度逐漸增加,最終達(dá)到高達(dá)4 \times 10^9的值。盡管論文沒有發(fā)現(xiàn)這對(duì)預(yù)訓(xùn)練本身造成傷害,預(yù)訓(xùn)練是在BF16精度下進(jìn)行的,但激活的幅度可能在推理過程中引起數(shù)值問題,因?yàn)槟承┝炕瘞?kù)僅支持FP16精度的激活,其最大范圍為64K。

為了緩解這些擔(dān)憂,論文增加了一個(gè)“激活損失”項(xiàng),與前向傳播中激活的均方成正比,并有一個(gè)可配置的α因子,懲罰較大的激活值。通過實(shí)驗(yàn)論文發(fā)現(xiàn),即使\alpha值高達(dá)至少10^-3,這種輔助損失對(duì)訓(xùn)練也沒有影響。對(duì)于Jamba-1.5-Large,論文使用了α=10^-5,這足以將激活值降低到可接受的范圍(最大2K-3K)。此外,添加這種輔助損失幾乎立即減少了激活值,使其僅在訓(xùn)練結(jié)束時(shí)添加,而不影響訓(xùn)練速度和質(zhì)量。

為了驗(yàn)證這種方法,論文使用FP16激活對(duì)模型進(jìn)行了全面評(píng)估,并獲得了與BF16評(píng)估相同的結(jié)果,沒有任何NaN/溢出。

2.4吞吐量和延遲分析

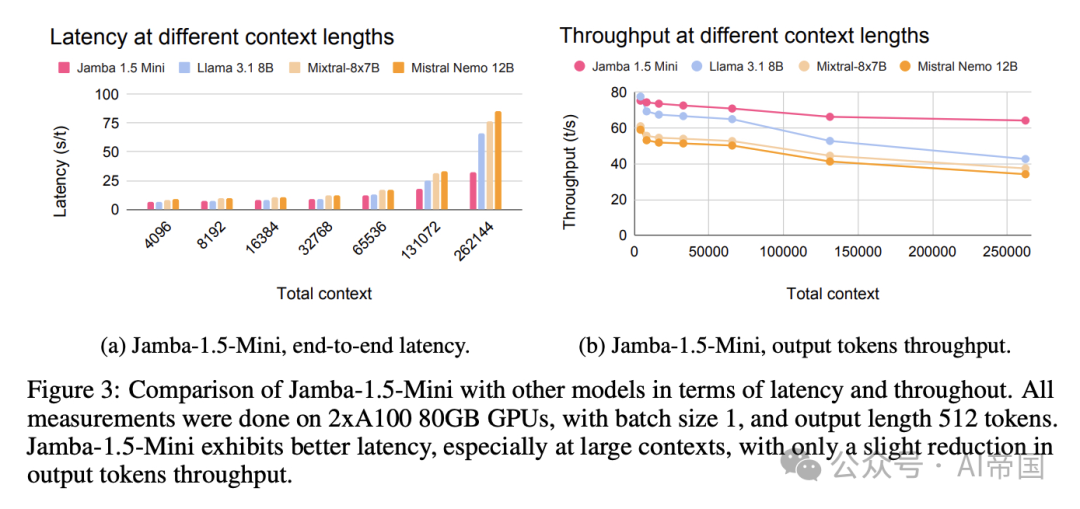

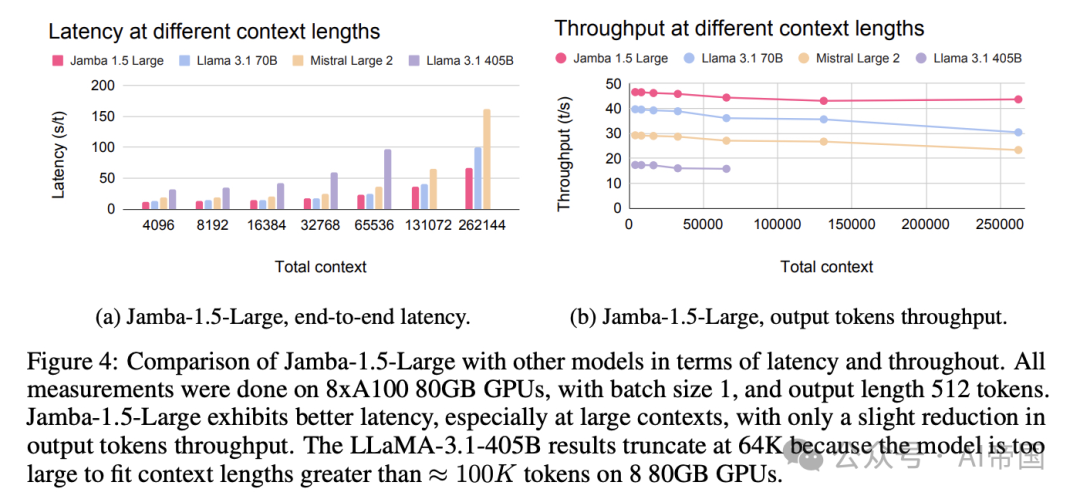

得益于混合Jamba架構(gòu),論文的Jamba-1.5模型提供了出色的吞吐量和延遲。圖3和4分別展示了Jamba-1.5-Mini和Jamba-1.5-Large的情況。如圖所示,論文的模型在延遲和吞吐量方面遠(yuǎn)優(yōu)于類似規(guī)模的模型。它們?cè)陂L(zhǎng)上下文中的優(yōu)勢(shì)尤為明顯,存在顯著差距。重要的是,Jamba-1.5-Large即使在長(zhǎng)上下文中也能高效運(yùn)行,而大型LLaMA3-405B在相同硬件上無(wú)法運(yùn)行。

圖3:Jamba-1.5-Mini與其他模型在延遲和吞吐量方面的比較。所有測(cè)量均在2個(gè)A100 80GB GPU上進(jìn)行,批量大小為1,輸出長(zhǎng)度為512個(gè)token。Jamba-1.5-Mini表現(xiàn)出更好的延遲,尤其是在大型上下文中,輸出token吞吐量?jī)H略有下降。

圖4:Jamba-1.5-Large與其他模型在延遲和吞吐量方面的比較。所有測(cè)量均在8塊A100 80GB GPU上進(jìn)行,批量大小為1,輸出長(zhǎng)度為512個(gè)token。Jamba-1.5-Large在大型上下文中表現(xiàn)出更好的延遲,輸出token吞吐量?jī)H略有下降。LLaMA-3.1-405B的結(jié)果截?cái)嘀?4K,因?yàn)樵撃P驮?塊80GB GPU上無(wú)法適應(yīng)超過100Ktoken的上下文長(zhǎng)度。

2.5 訓(xùn)練

2.5.1 訓(xùn)練基礎(chǔ)設(shè)施和數(shù)據(jù)

Jamba-1.5-Large在NVIDIA H100 GPU上使用論文自有的專有框架進(jìn)行訓(xùn)練,該框架包括FSDP、張量并行、序列并行和專家并行。對(duì)于后者,論文采用了MegaBlocks

2.5.2訓(xùn)練階段

該模型分三個(gè)階段進(jìn)行訓(xùn)練。在預(yù)訓(xùn)練階段,首先在2024年3月更新的自有數(shù)據(jù)集上進(jìn)行訓(xùn)練。論文的預(yù)訓(xùn)練數(shù)據(jù)集是公開可用的

網(wǎng)頁(yè)文檔、代碼、書籍和科學(xué)文章的混合體。

論文的預(yù)處理流程包括解析、質(zhì)量過濾和去重。為了充分利用公開可用數(shù)據(jù),論文開發(fā)了自己的自有解析器,并使用它提取文本和格式。確切的數(shù)據(jù)混合是通過各種消融實(shí)驗(yàn)確定的。這一階段包括多語(yǔ)言數(shù)據(jù),重點(diǎn)是以下語(yǔ)言:

英語(yǔ)、西班牙語(yǔ)、法語(yǔ)、葡萄牙語(yǔ)、意大利語(yǔ)、荷蘭語(yǔ)、德語(yǔ)、阿拉伯語(yǔ)和希伯來(lái)語(yǔ)。然后,在中間訓(xùn)練階段進(jìn)行了一小段時(shí)間的高比例長(zhǎng)文檔訓(xùn)練,以強(qiáng)調(diào)其遠(yuǎn)程能力。最后,模型進(jìn)行了Post-training。

2.5.3 Post-training

論文的Post-training方法旨在同時(shí)實(shí)現(xiàn)兩個(gè)目標(biāo):(i) 賦予模型各種技能和對(duì)話能力;(ii) 保留預(yù)訓(xùn)練尤其是中間訓(xùn)練的長(zhǎng)上下文能力。這兩個(gè)目標(biāo)部分存在沖突,因?yàn)榇蠖鄶?shù)可用的Post-training數(shù)據(jù)集由相對(duì)較短的示例組成。

鑒于這些考慮,論文的Post-training過程包括在高質(zhì)量對(duì)話數(shù)據(jù)、技能特定數(shù)據(jù)和長(zhǎng)上下文數(shù)據(jù)上的監(jiān)督微調(diào)。混合這些不同類型的數(shù)據(jù)旨在保留長(zhǎng)上下文能力并獲取所需技能。如以下評(píng)估所示,論文發(fā)現(xiàn)論文的模型在長(zhǎng)上下文評(píng)估中表現(xiàn)非常出色。

在進(jìn)行監(jiān)督微調(diào)時(shí),論文大量使用合成數(shù)據(jù),這在最近的基石模型中很常見,并且反映了論文構(gòu)建結(jié)構(gòu)化數(shù)據(jù)以構(gòu)建復(fù)合AI系統(tǒng)的方法。論文開發(fā)了多個(gè)不同的數(shù)據(jù)合成流程,針對(duì)不同的模型能力。所有流程都采用以下模式:(i)在目標(biāo)分布中采樣或生成提示;(ii)從語(yǔ)言模型生成響應(yīng);(iii)根據(jù)自動(dòng)驗(yàn)證和評(píng)分對(duì)響應(yīng)進(jìn)行質(zhì)量過濾或排序;以及(iv)后期編輯以去除偽影并適應(yīng)所需的格式。論文為構(gòu)成最終數(shù)據(jù)混合的不同數(shù)據(jù)管道使用不同的模型、提示、采樣、過濾和編輯方法。

論文根據(jù)一系列主要是內(nèi)部的自動(dòng)指標(biāo)選擇了最終的訓(xùn)練配方(數(shù)據(jù)混合和超參數(shù))。Jamba-1.5模型都使用相同的控制標(biāo)記和格式模板進(jìn)行微調(diào),論文將其作為HlF兼容的標(biāo)記器和聊天模板的一部分提供;詳見模型卡。

論文提供了幾個(gè)合成數(shù)據(jù)生成的顯著例子:

基于表格的問答。論文生成表格數(shù)據(jù)和伴隨的問答對(duì),如論文在表格理解工作[20]中所展示的。然后,論文使用語(yǔ)言模型將表格轉(zhuǎn)換為自然語(yǔ)言段落。論文生成的訓(xùn)練示例包括針對(duì)給定表格中特定行或列的文本的提取、聚合和歸因任務(wù)。

文檔問答。給定一個(gè)文檔,論文引導(dǎo)語(yǔ)言模型生成單段落和多段落的問題-答案對(duì)。有時(shí),論文通過添加類似文本來(lái)嵌入這些示例于更長(zhǎng)的上下文中,以鼓勵(lì)帶有歸屬的長(zhǎng)上下文理解。

工具使用。論文以開源的Glaive函數(shù)調(diào)用數(shù)據(jù)集為起點(diǎn),通過各種啟發(fā)式方法和輸出模式的驗(yàn)證進(jìn)行過濾。為了支持并行函數(shù)調(diào)用,論文首先為Glaive中的每個(gè)函數(shù)生成多個(gè)有效的參數(shù)分配。接著,論文從相同函數(shù)和不同函數(shù)中抽取這些有效參數(shù)分配的子集,以生成對(duì)應(yīng)函數(shù)調(diào)用集合的用戶請(qǐng)求。最后,論文引導(dǎo)一個(gè)函數(shù)調(diào)用語(yǔ)言模型響應(yīng)這些生成的用戶請(qǐng)求,并僅保留函數(shù)調(diào)用匹配原始參數(shù)分配的響應(yīng)。

可引導(dǎo)性。論文定義了一組易于驗(yàn)證的指令,并合成了包含通用文檔草擬任務(wù)及一個(gè)或多個(gè)約束條件的提示。論文從語(yǔ)言模型中生成這些提示的完成結(jié)果,并基于細(xì)粒度指令的驗(yàn)證和通用獎(jiǎng)勵(lì)模型進(jìn)行拒絕采樣。為了支持系統(tǒng)消息中的指令,論文選擇了多個(gè)共享細(xì)粒度指令的此類提示。

2.5.4 一些觀察

論文分享了從Jamba-l.5開發(fā)過程中得出的一些觀察。盡管這些觀察并未完全深入探討,但論文希望它們能啟發(fā)社區(qū)進(jìn)一步研究這些問題。

首先,盡管論文僅包含了一小部分非英語(yǔ)數(shù)據(jù),且僅針對(duì)特定技能在微調(diào)階段進(jìn)行了處理,但論文的Jamba-1.5模型在多種語(yǔ)言上表現(xiàn)相當(dāng)出色。如前所述,論文在預(yù)訓(xùn)練階段確實(shí)包含了多語(yǔ)言數(shù)據(jù)。因此,論文推測(cè)模型能夠在主要使用英語(yǔ)進(jìn)行微調(diào)時(shí)利用預(yù)訓(xùn)練階段學(xué)到的知識(shí)。

其次,論文高效的Jamba架構(gòu)降低了在長(zhǎng)上下文上進(jìn)行微調(diào)的成本,使得在給定預(yù)算下能夠進(jìn)行更多實(shí)驗(yàn)。因此,論文能夠在微調(diào)階段嘗試多種不同的訓(xùn)練方案。

最后,盡管像PPO [33]或DPO [29]這樣的偏好調(diào)優(yōu)算法改進(jìn)了模型輸出與人類意圖之間的一致性,但論文發(fā)現(xiàn),精心生成的合成數(shù)據(jù)、數(shù)據(jù)過濾和監(jiān)督微調(diào)的組合對(duì)于獲得強(qiáng)大的微調(diào)模型至關(guān)重要。

2.6 評(píng)估

雖然論文認(rèn)為基準(zhǔn)測(cè)試僅部分相關(guān)于實(shí)際應(yīng)用的成功和用戶滿意度,但論文仍報(bào)告了關(guān)鍵公共基準(zhǔn)的結(jié)果。首先,論文報(bào)告了標(biāo)準(zhǔn)學(xué)術(shù)基準(zhǔn)的結(jié)果。然后,論文在聊天機(jī)器人基準(zhǔn)上評(píng)估模型。最后,論文對(duì)Jamba-1.5-Large進(jìn)行了多項(xiàng)長(zhǎng)上下文評(píng)估和多語(yǔ)言評(píng)估。

論文與近期同尺寸范圍內(nèi)的開放權(quán)重模型進(jìn)行了比較:與Jamba-1.5-Large相比,有LLaMA-3.1 70B和Mistral-Large-2-123B;與Jamba-1.5-Mini相比,有LLaMA-3.1-8B和Gemma-2-9B。

2.6.1 學(xué)術(shù)基準(zhǔn)

論文報(bào)告了一系列標(biāo)準(zhǔn)學(xué)術(shù)基準(zhǔn)的結(jié)果:MMLU、MMLU-Pro、GPQA、ARC-Challence、BBII和HumanEval 。論文還評(píng)估了IFEval指令遵循數(shù)據(jù)集和BFCL v1函數(shù)調(diào)用數(shù)據(jù)集。最后,論文在RealToxicity和TruthfulQA上報(bào)告了安全評(píng)估結(jié)果。

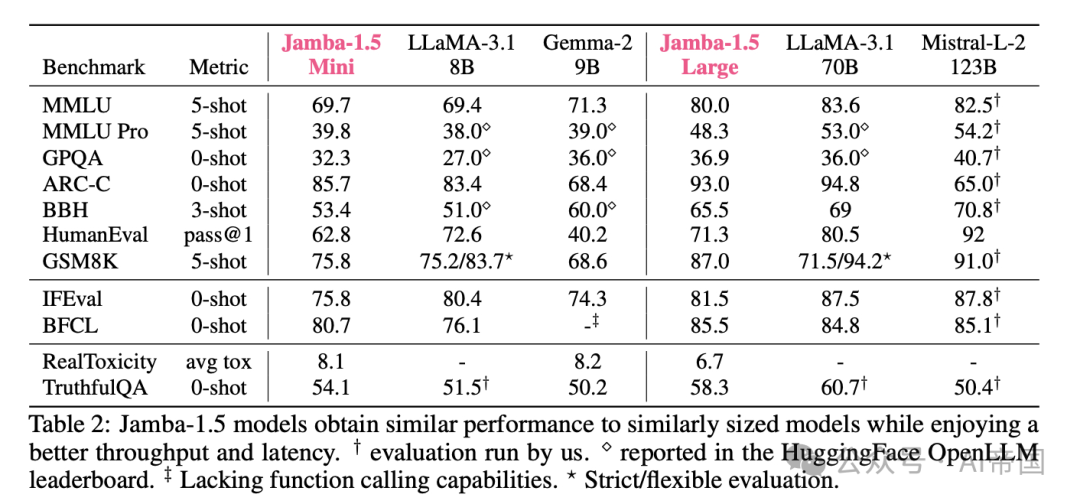

表2將Jamba-1.5-Large與幾個(gè)公開可用且規(guī)模相當(dāng)?shù)哪P瓦M(jìn)行了比較。所有結(jié)果均來(lái)自官方來(lái)源或由論文評(píng)估,如表中所示。論文觀察到,Jamba-1.5模型在包括知識(shí)、推理、指令遵循和功能調(diào)用能力在內(nèi)的標(biāo)準(zhǔn)學(xué)術(shù)基準(zhǔn)上,與近期公開可用的最先進(jìn)模型表現(xiàn)相當(dāng)。論文還觀察到與文獻(xiàn)中報(bào)告的安全指標(biāo)相似。

重要的是,如上所述,Jamba-1.5模型在實(shí)現(xiàn)這些結(jié)果的同時(shí),提供了更好的吞吐量和延遲。

表2:Jamba-1.5模型在獲得與同等規(guī)模模型相似性能的同時(shí),享受到了更好的吞吐量和延遲。

2.6.2 聊天機(jī)器人評(píng)估

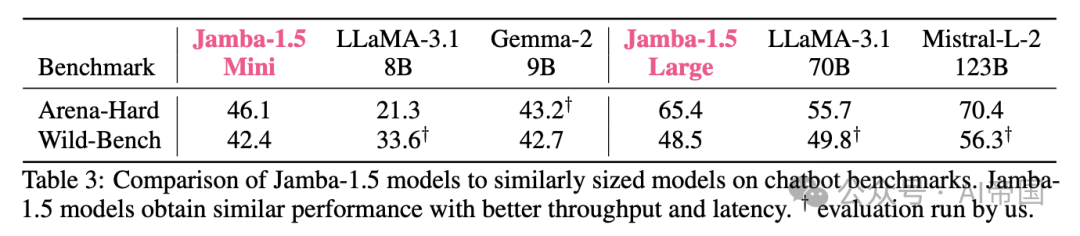

論文評(píng)估了Jamba-1.5模型在兩個(gè)聊天機(jī)器人場(chǎng)景中的表現(xiàn):Arena-Hard ,一組500個(gè)具有挑戰(zhàn)性的用戶查詢,使用GPT4-Turbo作為評(píng)判標(biāo)準(zhǔn),以及WildBench,使用GPT4-Turbo作為評(píng)判標(biāo)準(zhǔn)并進(jìn)行了長(zhǎng)度偏差緩解。如表3所示,Jamba-1.5模型在這些評(píng)估中取得了優(yōu)異的結(jié)果,其中Jamba-1.5-Large超過了LLaMA-3.1 70B,但略遜于Mistral-Large-2 123B,后者擁有大約30%更多的活躍參數(shù)。

表3:Jamba-1.5模型與類似大小模型在聊天機(jī)器人基準(zhǔn)測(cè)試中的比較。Jamba-1.5模型在性能相似的情況下,具有更好的吞吐量和延遲。" 由論文進(jìn)行的評(píng)估。

2.6.3 長(zhǎng)上下文評(píng)估

發(fā)布的模型能夠處理長(zhǎng)達(dá)256K個(gè)標(biāo)記的上下文長(zhǎng)度。在本節(jié)中,論文對(duì)其在測(cè)試其長(zhǎng)上下文能力的合成和自然主義基準(zhǔn)上進(jìn)行了評(píng)估。

2.6.3.1 RULER

論文在RULER基準(zhǔn)上進(jìn)行了評(píng)估,這是一組13個(gè)合成任務(wù),旨在評(píng)估語(yǔ)言模型的長(zhǎng)上下文能力。RULER包括8種針在草堆中的檢索任務(wù)變體,包括多個(gè)‘needles’[2]。它還包括一個(gè)變量跟蹤任務(wù),其中應(yīng)返回一系列變量綁定,兩個(gè)聚合任務(wù),其中一個(gè)需要返回最常見的單詞,以及兩個(gè)問答任務(wù),其中從自然主義數(shù)據(jù)集[30, 41]中插入的段落來(lái)模擬長(zhǎng)上下文。

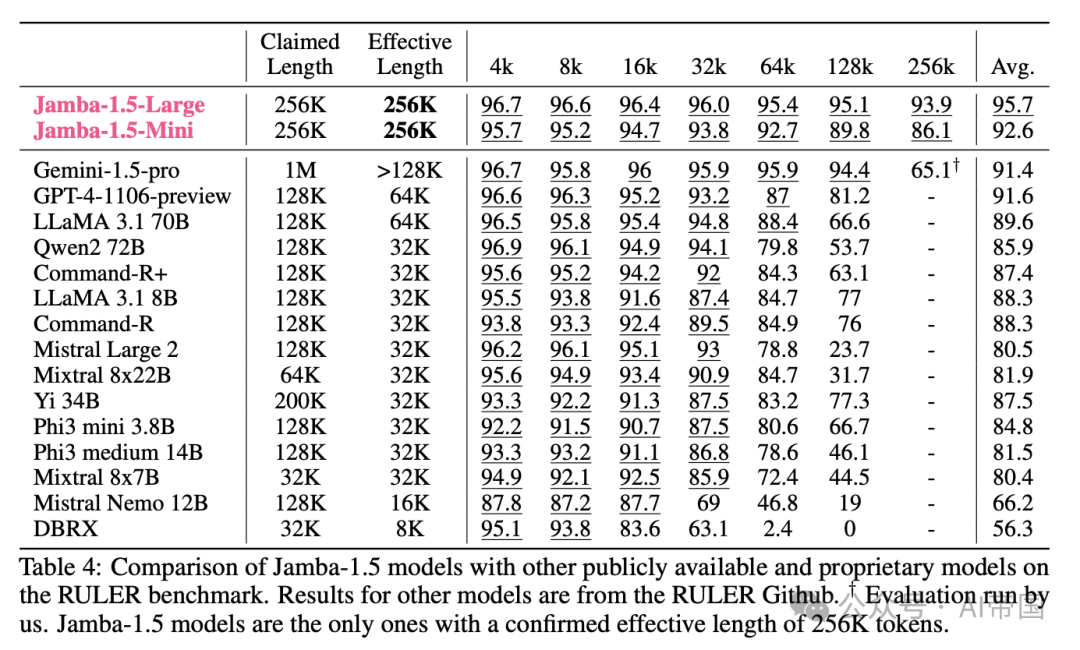

結(jié)果展示在表4中。在所有公開和專有模型中,Jamba-1.5-Mini和Jamba-1.5-Large是唯一確認(rèn)有效長(zhǎng)度為256Ktoken的模型。Gemini-pro在原始RULER論文中報(bào)告了高達(dá)128K的良好結(jié)果。然而,盡管論文付出了很大努力,仍無(wú)法重現(xiàn)這些結(jié)果。論文檢查了Gemini-pro的生成內(nèi)容,發(fā)現(xiàn)該模型經(jīng)常無(wú)法回答或生成拒絕。由于官方RULER結(jié)果來(lái)自預(yù)覽版本,論文假設(shè)Gemini-pro自那時(shí)起經(jīng)歷了更新,這些更新?lián)p害了其在RULER上的性能。

表4:Jamba-1.5模型與其他公開和專有模型在RULER基準(zhǔn)上的比較。其他模型的結(jié)果來(lái)自RULER Github。bigstar 由論文進(jìn)行的評(píng)估。Jamba-1.5模型是唯一確認(rèn)有效長(zhǎng)度為256Ktoken的模型。

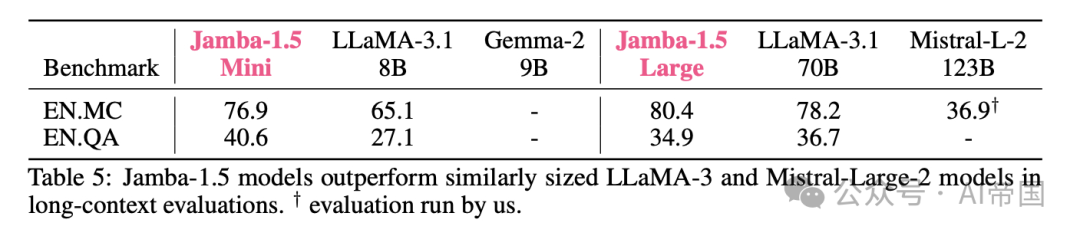

2.6.3.2 Infinite-BENCH

接下來(lái),論文在cOBENCH數(shù)據(jù)集上進(jìn)行評(píng)估,該數(shù)據(jù)集旨在評(píng)估語(yǔ)言模型的長(zhǎng)上下文能力,平均長(zhǎng)度為100K個(gè)標(biāo)記。論文重點(diǎn)關(guān)注理解長(zhǎng)篇小說(shuō)的兩個(gè)英語(yǔ)任務(wù):?jiǎn)柎穑‥N.QA)和多項(xiàng)選擇問答(EN.MC)。如表5所示,Jamba-1.5模型在這種情況下表現(xiàn)非常出色,優(yōu)于同樣大小的LLaMA-3.1和Mistral-Large-2模型。(由于Gemma-2 9B的上下文窗口較短,僅為8K,因此未報(bào)告其結(jié)果。)

表5:Jamba-1.5模型在長(zhǎng)上下文評(píng)估中優(yōu)于同樣大小的LLaMA-3和Mistral-Large-2模型。T評(píng)估由論文進(jìn)行。

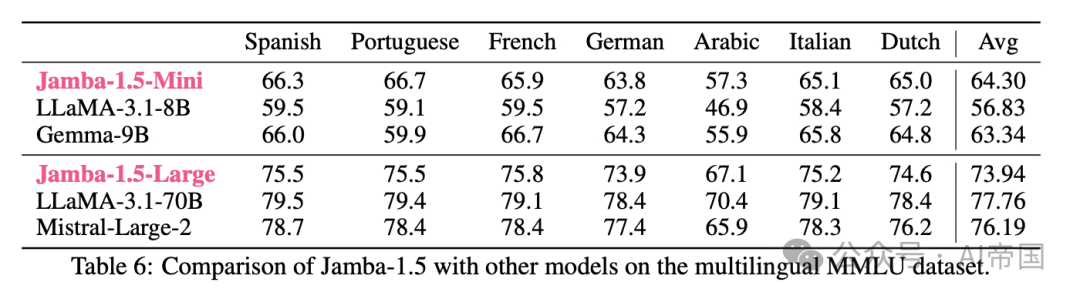

2.6.4 多語(yǔ)言能力

論文對(duì)Jamba-1.5在非英語(yǔ)語(yǔ)言中的能力進(jìn)行了基本評(píng)估。特別是,論文報(bào)告了通過LM Evaluation Harness 分發(fā)的多語(yǔ)言MMLU數(shù)據(jù)集上的結(jié)果。表6顯示了結(jié)果,其中Jamba-1.5-Mini與其比較點(diǎn)相比表現(xiàn)相似或更好。Jamba-1.5-Large略落后于其可比模型,但仍展現(xiàn)出良好的多語(yǔ)言能力。

表6:Jamba-1.5與其他模型在多語(yǔ)言MMLU數(shù)據(jù)集上的比較。

2.7 對(duì)齊與安全考量

論文模型對(duì)齊的方法是通過在模型行為與客戶期望之間建立透明度來(lái)驅(qū)動(dòng)的。論文的模型默認(rèn)遵循基于論文參與行業(yè)標(biāo)準(zhǔn)機(jī)構(gòu)、智庫(kù)以及與客戶直接經(jīng)驗(yàn)的商業(yè)行為準(zhǔn)則。論文認(rèn)為這是一種持續(xù)且不斷發(fā)展的合作關(guān)系。此外,企業(yè)有多種方式來(lái)控制模型行為,以反映其獨(dú)特的價(jià)值觀和文化,例如額外的培訓(xùn)和微調(diào)、系統(tǒng)消息和提示工程。總體而言,論文的AI行為準(zhǔn)則基于以下目標(biāo):

?使模型行為和輸出與公司價(jià)值觀和規(guī)范的商業(yè)禮儀相一致。

?明確聲明預(yù)期行為的條款,以便錯(cuò)誤/漏洞易于識(shí)別。

?與客戶合作,并將行為映射到他們的最佳實(shí)踐。

?持續(xù)收集反饋,以監(jiān)控并積極改進(jìn)行為。

根據(jù)論文在OECD

任務(wù)組中的角色,該任務(wù)組旨在為應(yīng)用G7廣島人工智能系統(tǒng)開發(fā)組織行為準(zhǔn)則開發(fā)一個(gè)監(jiān)控機(jī)制,論文將模型對(duì)齊工作與OECD基于價(jià)值觀的AI原則相結(jié)合:包容性增長(zhǎng)、可持續(xù)發(fā)展與福祉;以人為本的價(jià)值和公平性;透明度和可解釋性;魯棒性、安全性和安全性;以及問責(zé)制。

對(duì)于前四個(gè)原則,論文詳細(xì)闡述了行為預(yù)期或準(zhǔn)則,并提供了可用于訓(xùn)練/對(duì)齊和測(cè)試合規(guī)性的示例。問責(zé)原則側(cè)重于Al21在承擔(dān)模型行為責(zé)任中的角色。論文認(rèn)為,這種問責(zé)主要通過與客戶、監(jiān)管機(jī)構(gòu)和獨(dú)立第三方的透明度和接觸來(lái)體現(xiàn)。論文與經(jīng)合組織(OECD)、斯坦福大學(xué)的HELM [23]和FMTI [3]以及此類文件的接觸,展示了這一承諾,以及論文在FMTI中的高排名(截至2024年5月排名第二)。

論文創(chuàng)建了60個(gè)準(zhǔn)則,這些準(zhǔn)則與OECD原則相對(duì)應(yīng)。這些準(zhǔn)則被表述為論文的模型應(yīng)避免的行為指令。完整列表將公開發(fā)布。

本文轉(zhuǎn)載自??AI帝國(guó)??,作者: 無(wú)影寺 ????