爆!2024‘Meta 推出CTR集成框架 CETNet,多 CTR 模型集成大幅提升預測精度

1. Kimi k1.5: Scaling Reinforcement Learning with LLMs

語言模型預訓練時,通過預測下一個詞來提升計算量的方法效果不錯,可訓練數據量卻限制了它的進一步發展。強化學習(RL)的拓展則為人工智能持續進步提供了新途徑,讓大語言模型(LLMs)有機會通過學習探索擴充訓練數據。不過,之前相關研究成果都不太理想,沒有特別突出的。

基于這樣的情況,我們來分享 Kimi k1.5 的訓練過程。這是我們新研發的多模態 LLM,使用 RL 訓練。我們會講講 RL 訓練技術、多模態數據處理方法,還有基礎設施優化這些內容。長上下文擴展和改良后的策略優化是我們訓練方法的關鍵,搭建出簡單好用的 RL 框架,不用像蒙特卡洛樹搜索、價值函數、過程獎勵模型這些復雜技巧。

特別要提的是,我們的系統在不少基準測試和不同模態里,推理性能都很突出。AIME 測試得 77.5 分,MATH 500 測試得 96.2 分,Codeforces 測試處于 94 百分位,MathVista 測試得 74.9 分,和 OpenAI 的 o1 水平差不多。 另外,我們還找到了好辦法,用長思維鏈(CoT)技術增強短思維鏈模型。在 AIME 中得分 60.8,MATH500 里得 94.6 分,LiveCodeBench 里得 47.3 分,比 GPT-4o、Claude Sonnet 3.5 這些短思維鏈模型強很多,最高領先幅度能達到 550%。

論文: ??https://arxiv.org/pdf/2501.12599??

2. FilmAgent: A Multi-Agent Framework for End-to-End Film Automation in Virtual 3D Spaces

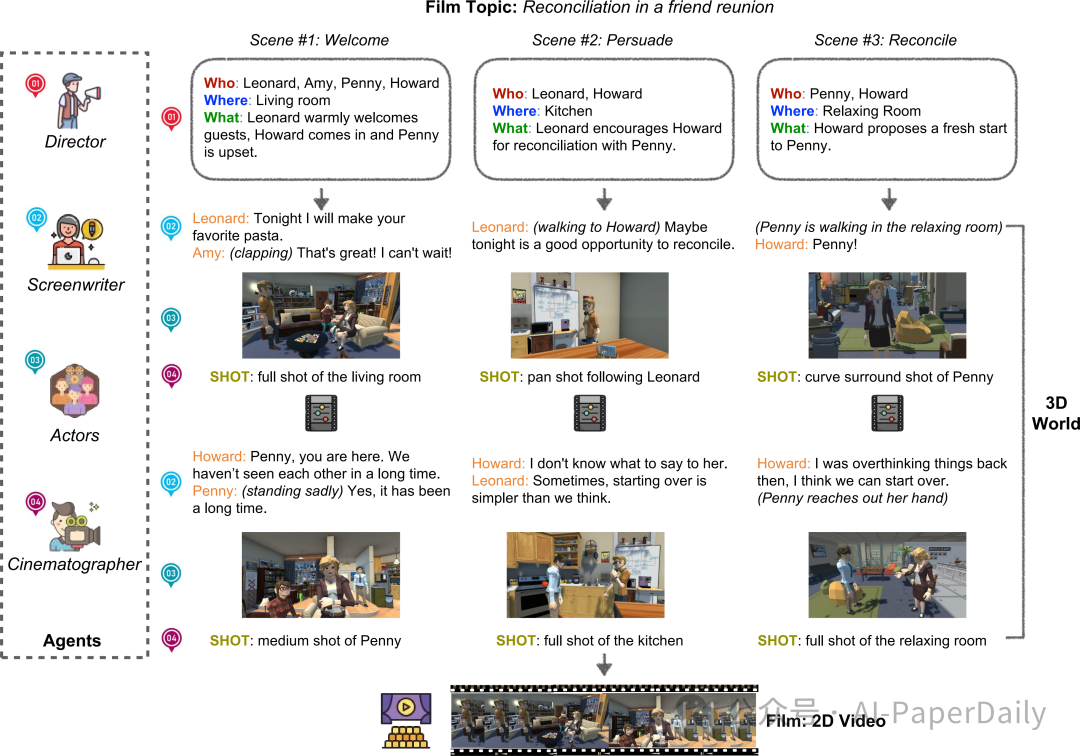

制作虛擬電影,做決策可太復雜了。既要創作劇本,又要進行虛擬攝影,還得精準設計演員的定位和動作。最近,自動決策領域在基于語言 Agent 社會這一塊有了新進展,我們從中受到啟發,提出了 FilmAgent。這是一種基于大語言模型的多 Agent 協作框架,目的是在我們搭建的 3D 虛擬空間里,從頭到尾實現電影制作的自動化。

FilmAgent 能模仿好多劇組里的角色,像導演、編劇、演員、攝像師等等,涵蓋了電影制作的關鍵階段。首先是創意開發,把大家頭腦風暴出來的想法,整理成有條理的故事情節;接著是劇本創作,仔細描述每個場景里角色的對話和動作;然后是攝影環節,確定每個鏡頭的攝像機該怎么擺放。Agent 團隊通過反復地反饋和修改來合作,這樣就能驗證中間生成的劇本,減少那些不合理、不真實內容的出現。

我們針對 15 個創意和 4 個關鍵方面生成的視頻做了評估。經過人工評估,FilmAgent 在各個方面都比其他對比對象表現好,平均得分 3.98 分,這就充分說明多 Agent 協作在電影制作中是可行的。進一步分析發現,就算用的是相對沒那么先進的 GPT - 4o 模型,FilmAgent 的表現還是超過了單 Agento1,這就突出了協調得好的多 Agent 系統的優勢。

論文: ??https://arxiv.org/pdf/2501.12909??

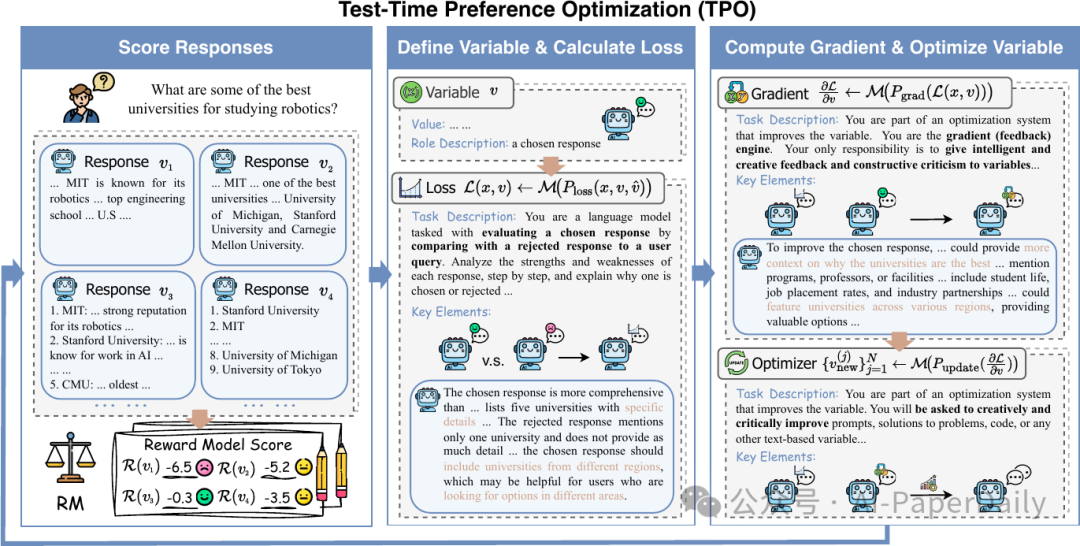

3. Test-Time Preference Optimization: On-the-Fly Alignment via Iterative Textual Feedback

大語言模型(LLMs)展現出的性能令人贊嘆,不過在快速契合人類偏好方面存在短板,除非重新訓練。在這篇文章里,我們提出了測試時偏好優化(TPO)框架,這個框架能在推理過程中,讓 LLM 的輸出結果與人類偏好保持一致,也就無需更新模型參數。

和單純依賴數值獎勵不同,TPO 會把獎勵信號轉變為文本批評,然后將其當作文本獎勵,一步步優化自身的響應。在包含指令跟隨、偏好對齊、安全性以及數學等方面的基準測試中,評估結果顯示 TPO 能逐步提升與人類偏好的契合度。值得一提的是,僅經過幾步 TPO 處理,一開始未對齊的 Llama-3.1-70B-SFT 模型,就能超越已對齊的對應模型 Llama-3.1-70B-Instruct。而且,TPO 在推理時,隨著搜索寬度和深度的增加,能高效擴展。

通過案例研究,我們闡述了 TPO 是如何利用 LLM 自身能力來解讀和執行獎勵信號的。我們的研究成果表明,TPO 是一種實用、輕量級的測試時偏好優化替代方案,能實現實時對齊。我們的代碼已在https://github.com/yafuly/TPO 上公開。

論文: ??https://arxiv.org/pdf/2501.12895??

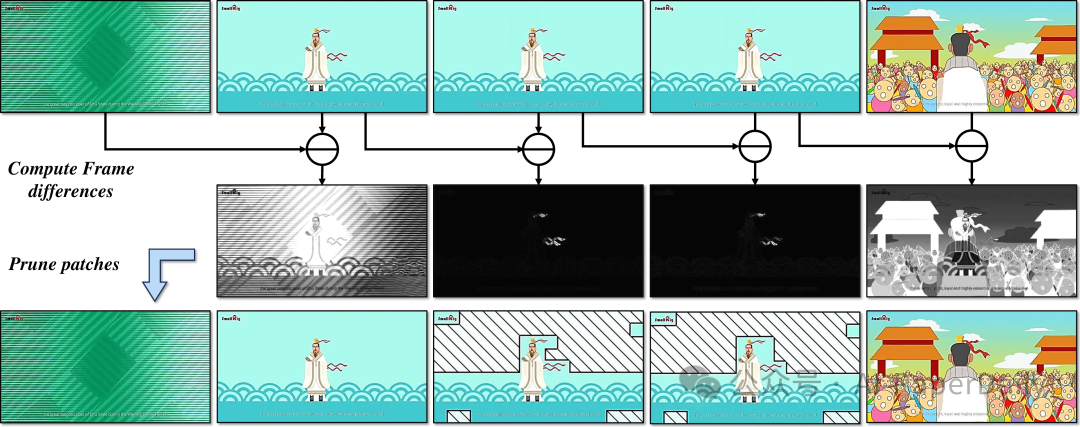

4. VideoLLaMA 3: Frontier Multimodal Foundation Models for Image and Video Understanding

在這篇文章里,我們帶來了VideoLLaMA3,這是一個更厲害的多模態基礎模型,主要用來理解圖像和視頻。VideoLLaMA3的核心設計思路就是以視覺為中心,這里面有兩層含義:一個是視覺為中心的訓練方式,另一個是視覺為中心的框架設計。

為什么采用視覺為中心的訓練方式呢?是因為我們發現高質量的圖像-文本數據,對理解圖像和視頻特別重要。所以,我們沒去搞大規模的視頻-文本數據集,而是把心思花在構建大規模、高質量的圖像-文本數據集上。VideoLLaMA3的訓練分成四個階段:

- 視覺為中心的對齊階段:這個階段主要是讓視覺編碼器和投影器先熱熱身;

- 視覺-語言預訓練階段:一起優化視覺編碼器、投影器和大模型(LLM),用的是大規模的圖像-文本數據,像場景圖像、文檔、圖表這些都有,還有純文本數據;

- 多任務微調階段:把圖像-文本SFT數據和視頻-文本數據用到下游任務里,給視頻理解打下基礎;

- 視頻為中心的微調階段:讓模型理解視頻的能力再上一個臺階。

在框架設計方面,為了能把圖像里的小細節都抓住,我們調整了預訓練的視覺編碼器,讓它能根據圖像大小,編碼出對應的視覺標記數量,而不是固定的數量。對于視頻輸入,我們會根據它們的相似程度,減少視覺標記數量,這樣視頻的表示就更準確、更簡潔了。

多虧了這種以視覺為中心的設計,VideoLLaMA3在圖像和視頻理解的基準測試中,取得了非常不錯的成績。

論文: ???https://arxiv.org/pdf/2501.13106??

本文轉載自 ??AI-PaperDaily??,作者: AI-PaperDaily