3D頭像資產生產又出SOTA! 加州默塞德&Adobe發布FaceLift:身份保持極佳!

文章鏈接:https://arxiv.org/pdf/2412.17812

項目鏈接:https://www.wlyu.me/FaceLift/

亮點直擊

- 本文提出了FaceLift,這是一種兩階段框架,通過視圖生成和大規模重建模型從單張圖像重建高保真3D頭像。

- 結合了用于視圖一致性訓練的合成頭部數據和大型圖像生成基礎模型的豐富先驗,從而實現了強大的泛化能力。

- 通過全面的定量和定性評估,證明了本文的方法在重建精度和身份保持方面達到了SOTA。

總結速覽

解決的問題

當前的3D頭像重建方法存在以下挑戰:

- 細節缺失:傳統的基于參數化網格的模型難以生成高細節和高真實感的面部幾何和紋理。

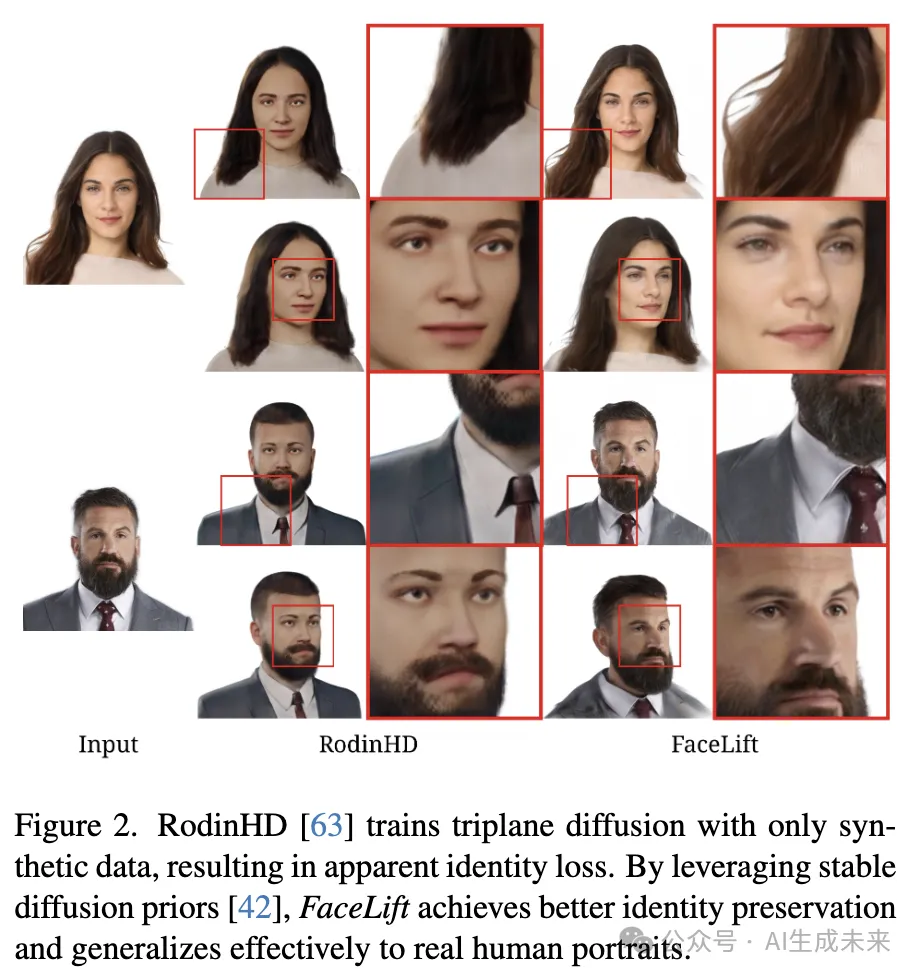

- 身份保持差:僅用合成數據訓練的模型在生成結果中會導致顯著的身份感知損失。

- 視角一致性不足:現有方法難以保證不同視角生成的圖像在幾何和紋理上的一致性。

提出的方案

FaceLift采用兩階段管線實現高質量的3D頭像重建:

- 第一階段:多視角生成

基于擴散模型的多視角生成方法。

通過圖像條件擴散模型生成頭部的側面和背面視圖。

利用多視角一致的合成數據進行模型微調,增強視角一致性和泛化能力。

- 第二階段:3D重建

- 使用最先進的GS-LRM模型,將生成的稀疏多視角圖像融合為完整的3D高斯表示。

- 在Objaverse數據集上初步訓練,并對合成頭像數據進行微調以提高重建精度。

應用的技術

- 擴散模型:以擴散模型為核心,通過大規模基礎模型微調實現多視角生成。

- GS-LRM:利用大規模重建模型,將稀疏視圖轉換為高細節的3D高斯表示。

- 訓練數據:

- 構建了合成多視角頭像數據集。

- 利用Objaverse和合成頭像數據對模型進行分階段訓練。

達到的效果

- 高細節和真實感:生成結果在幾何和紋理上表現出精細的細節。

- 身份保持:有效保留輸入面部的身份特征。

- 視角一致性:多視角生成和重建結果高度一致。

- 廣泛適用性:盡管僅用合成數據訓練,FaceLift在真實人臉圖像上表現出顯著的泛化能力。

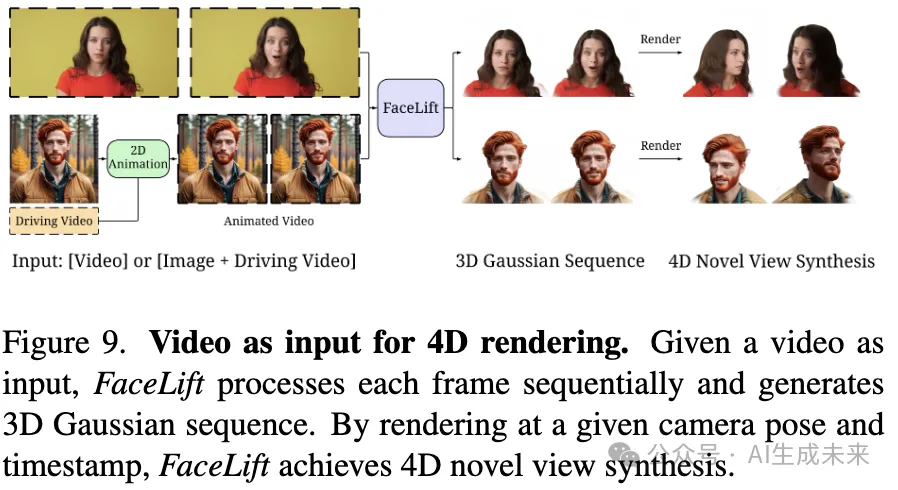

- 擴展功能:支持視頻輸入實現4D新視角合成,并能與2D再動畫技術結合,生成3D面部動畫。

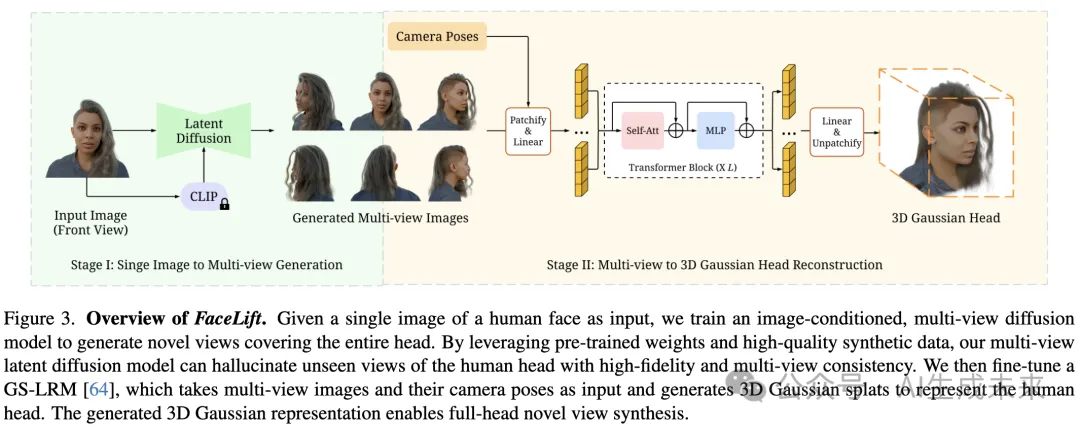

提出的方法

給定一張人臉的正面圖片,本文的目標是以3D高斯點云的形式重建完整的3D頭像模型。生成輸入視角不可見的合理細節(例如頭部后側),同時確保從任意角度都具有一致的視覺效果。本文提出的FaceLift方法遵循兩階段pipeline,如下圖3所示。在第一階段,利用合成頭像多視角圖像,我們訓練了一個基于圖像條件的擴散模型,生成六個視角的頭像圖像,同時保持多視角一致性并保留身份特征。在第二階段,這些生成的視圖及其相應的相機位姿被輸入到一個經過微調的GS-LRM模型中,以重建一組3D高斯點云。

合成頭像數據集

本文實現了一個基于[59]啟發的3D頭像資產生成pipeline。該過程始于一組由藝術家創作的高質量3D頭像網格模型,通過加入詳細的面部組件(如眼睛、牙齒、牙齦、面部和頭皮頭發)對其進行增強。通過綁定實現姿態變化,并通過混合變形實現多樣化的面部表情來增強這些基礎模型。這些最終的頭像模型通過一組PBR紋理貼圖(包括反照率、法線、粗糙度、高光和次表面散射貼圖)進一步豐富。最后為頭像模型搭配了一組服裝資產。整個pipeline在Blender中實現,圖像使用Cycles渲染器進行渲染。

為了訓練,本文以512×512分辨率渲染了200個唯一身份,每個身份具有50種不同外觀(包括發型、膚色、表情、服裝、姿態等)。訓練數據集在兩種光照條件下渲染:(1) 環境光;(2) 隨機HDR環境光。每個主體渲染六個視圖以訓練多視角擴散模型。為了微調GS-LRM,使用隨機相機位姿渲染了32個視圖。

階段一:從單張圖像到多視角生成

近期的3D生成和重建框架通過利用擴散模型生成多視角一致的圖像,展示了令人鼓舞的成果。基于這一方法,本文采用了開源的Stable Diffusion文本到圖像生成器作為視圖生成網絡的基礎。使用了Stable Diffusion V2-1-unCLIP模型,該模型通過在Stable Diffusion V2-1上微調,結合了CLIP圖像 embeddings 作為額外的條件輸入。在pipeline中,CLIP圖像編碼器處理輸入的正面人臉圖像,生成embeddings用作擴散模型的條件信號。

為了確保生成的新視角圖像的一致性,采用了類似于[26, 32]的多視角注意力機制,以促進信息傳播并隱式編碼多視角依賴性。擴散模型通過在注意力層中共享跨視角的信息學習多視角相關性,從而能夠從多個視角生成一致的RGB圖像。

給定的單張近正面人臉圖像,其方位角為 ,多視角擴散模型將生成六個視角圖像,其方位角分別為 ,覆蓋頭像的360度范圍。所有輸入圖像和生成的輸出圖像均保持零仰角,以確保水平視角的一致性。生成的視角包括重建的正面圖像(與輸入圖像一致)、捕捉頭部兩側的左側和右側側面圖像,以及基于正面輸入和學習先驗綜合生成的后視圖(包括頭發結構和顏色)。此外,還生成左前和右前三分視圖,以增強后續重建階段的人臉細節。

第二階段:從多視角到3D高斯頭像重建

第二階段利用第一階段生成的六個視角進行稀疏視角重建。本文使用了GS-LRM,這是一種在從有限視角生成詳細3D模型方面表現卓越的最先進重建模型。GS-LRM采用3D高斯作為其底層表示方式,對于捕捉頭像的復雜細節(如發絲)尤其有效。此外,其前饋架構支持快速重建,使其非常適合實際應用。

GS-LRM使用一種Transformer架構,從一組帶有位姿的圖像中回歸出像素對齊的3D高斯。每個多視角圖像與其相應的Plücker射線坐標(由相機的內參和外參計算得出)拼接在一起,用于位姿條件化。圖像被劃分為不重疊的補丁,每個2D補丁被展平為一個1D向量。然后,一個線性層將這些向量映射為圖像補丁token。所有多視角圖像的token被拼接后,通過一系列Transformer塊進行處理。接著,Transformer的輸出token通過一個線性層解碼為高斯參數,隨后將高斯參數從補丁形式轉化為3D高斯。每個2D像素對應一個3D高斯,高斯的參數化包括以下內容:三通道RGB、三通道尺度、四通道旋轉四元數、單通道不透明度以及單通道射線距離,類似于[23]。

GS-LRM模型的最終輸出是所有輸入視角中3D高斯的合并結果。

在GS-LRM訓練期間,隨機從可用的相機位姿中選擇四個視角來重建總計八個視角(四個輸入視角加上四個新視角)。根據[64],使用均方誤差(MSE)和感知損失的組合來優化模型。在推理階段,GS-LRM處理我們多視角擴散模型的輸出。盡管GS-LRM可以接受任意數量的輸入視角,使用擴散模型生成的全部六個視角以實現最佳的視覺質量。

實驗

為評估單張圖像頭像重建方法,利用公開的多視角頭像數據集,通過已知的相機參數評估新視角合成性能。我們展示了基于這些數據集的定性比較和定量誤差指標。

實驗設置

評估數據集

使用兩個多視角數據集評估本文的方法:

- Cafca 數據集:

這是一個合成數據集,專注于人臉場景,但與本文的訓練數據集有顯著差異。本文的訓練數據集是獨立開發的。用于評估時,選擇了40個主體,每個主體包含30個測試相機視角。由于相機位置是隨機分布的,手動選擇最接近正視圖的圖像作為輸入。 - Ava-256 數據集:

這是一個以真實人類主體為對象的專業拍攝數據集。隨機選取了10個主體,每個主體有10個測試相機視角。為了證明系統的泛化能力,還使用收集到的“野外”人臉圖像集進行定性評估。

對比方法

將結果與以下三種最新方法進行了比較:

- PanoHead: 基于3D GAN的最新3D全頭重建方法。通過GAN反演(GAN-inversion)從單張輸入圖像中獲得重建結果。需要注意的是,該方法只能在特定相機姿態范圍內渲染圖像,且缺乏真實的3D表示,無法實現新視角合成。

- Era3D: 最近提出的一種通用物體重建方法。它采用多視角擴散模型生成六個視角,并使用 NeuS 的 Instant-NSR-PL 實現進行網格提取。

- LGM: 類似于 GS-LRM,該方法在視角生成階段后使用高斯點云作為3D表示。

評估指標

使用以下四個標準指標評估重建質量:

- PSNR(峰值信噪比)

- SSIM(結構相似性)

- LPIPS

- DreamSim

為評估身份保持能力,使用 ArcFace 通過 DeepFace 實現進行人臉驗證。

實現細節

數據集處理

Cafca 和 Ava-256 數據集提供了多視角的 RGB 圖像及其相應的相機位姿。然而,這些數據集的相機系統與 FaceLift 和基線方法所用的相機系統存在差異。因此,為每種方法重新計算測試相機的外參。

為了更精確的比較,使用 Mediapipe 面部關鍵點檢測算法,在目標圖像和渲染輸出中識別面部關鍵點,并根據關鍵點分布進行對齊。需要注意的是,基于面部關鍵點檢測的對齊方法僅適用于捕捉前臉特征的圖像。

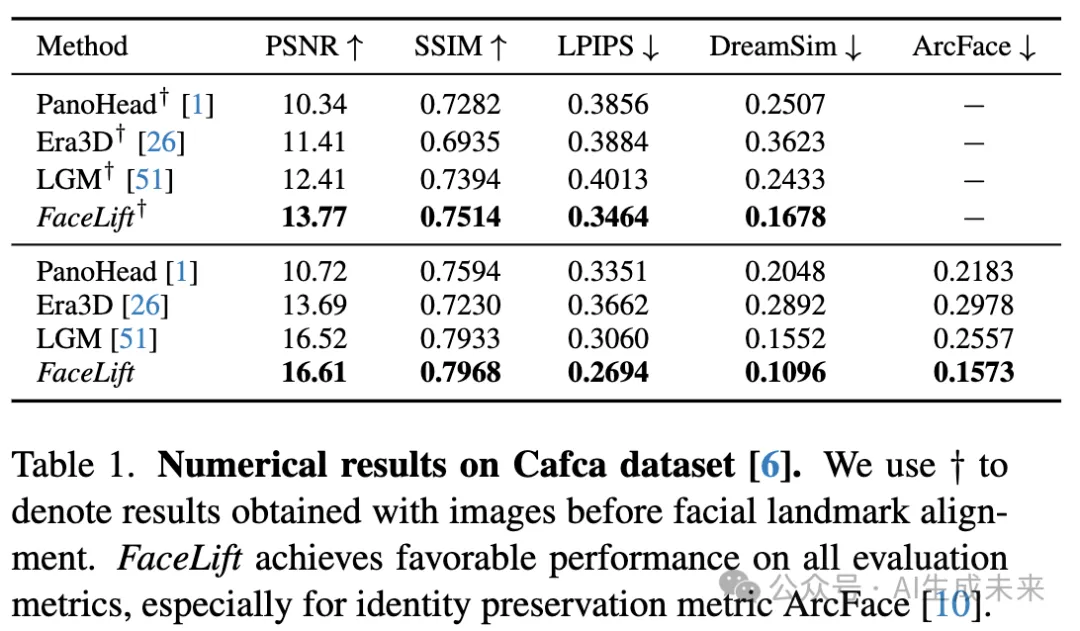

Cafca 數據集的實驗結果

定量結果

在下表 1 中報告了面部關鍵點對齊前后的數值比較結果:

- 在對齊前,Cafca 數據集中的全部 30 個相機視角被用作測試視角,但部分視角未覆蓋面部區域。因此,身份保持指標(ArcFace)僅在對齊后的比較中報告。

- 對齊后,每個主體的測試視角數量為 7 至 19 個。

在兩種比較中,FaceLift 相較于基線方法表現更優,特別是在 DreamSim 指標上,它更符合人類對相似性的判斷。此外,FaceLift 在身份保持方面也表現出色,ArcFace 的面部嵌入距離較低。

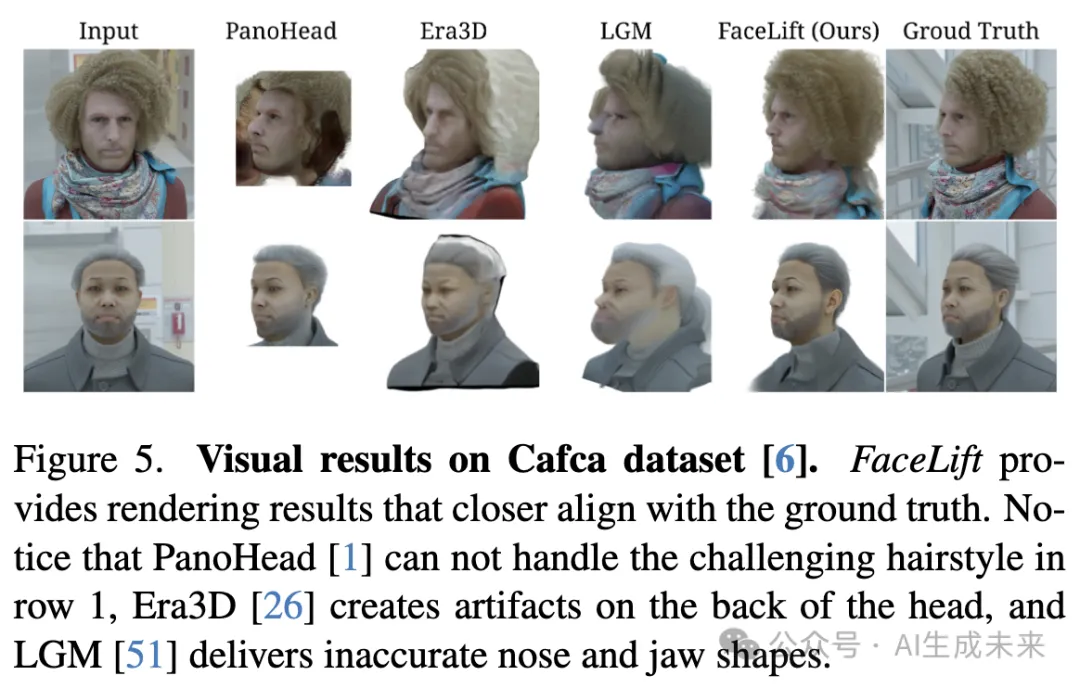

視覺結果

如下圖 5 所示,FaceLift 能夠渲染出更接近真實的新視角圖像,而其他方法在顏色或幾何結構的 3D 頭部重建上經常失敗。

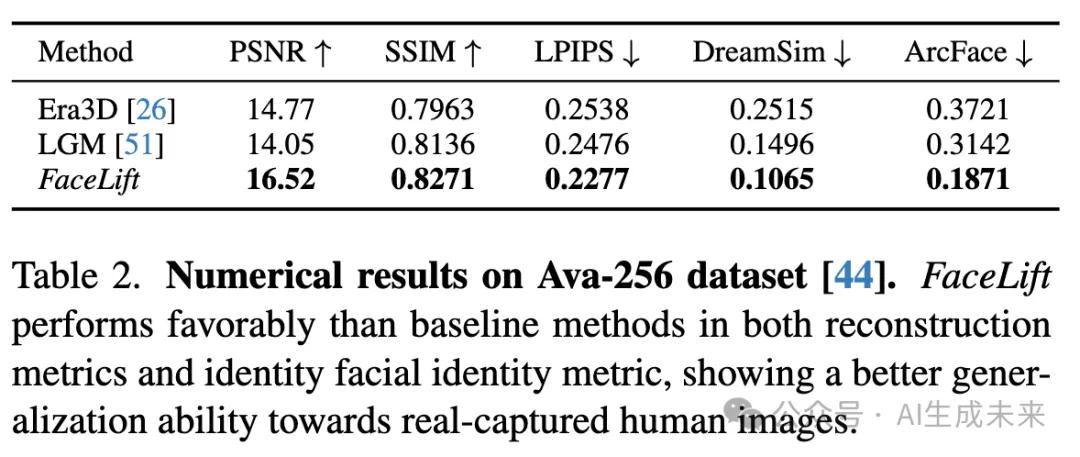

Ava-256 數據集的實驗結果

定量結果

在真實人類拍攝的 Ava-256 數據集上進一步評估了 FaceLift 的性能,與其他基線方法進行比較。由于 PanoHead 在該數據集的測試相機視角下無法生成合理結果,排除了該基線。

下表 2 顯示,FaceLift 在所有評估指標上均優于其他基線方法,展現了卓越的重建質量和身份保持能力。這也證明了 FaceLift 在真實人臉上的強泛化能力。

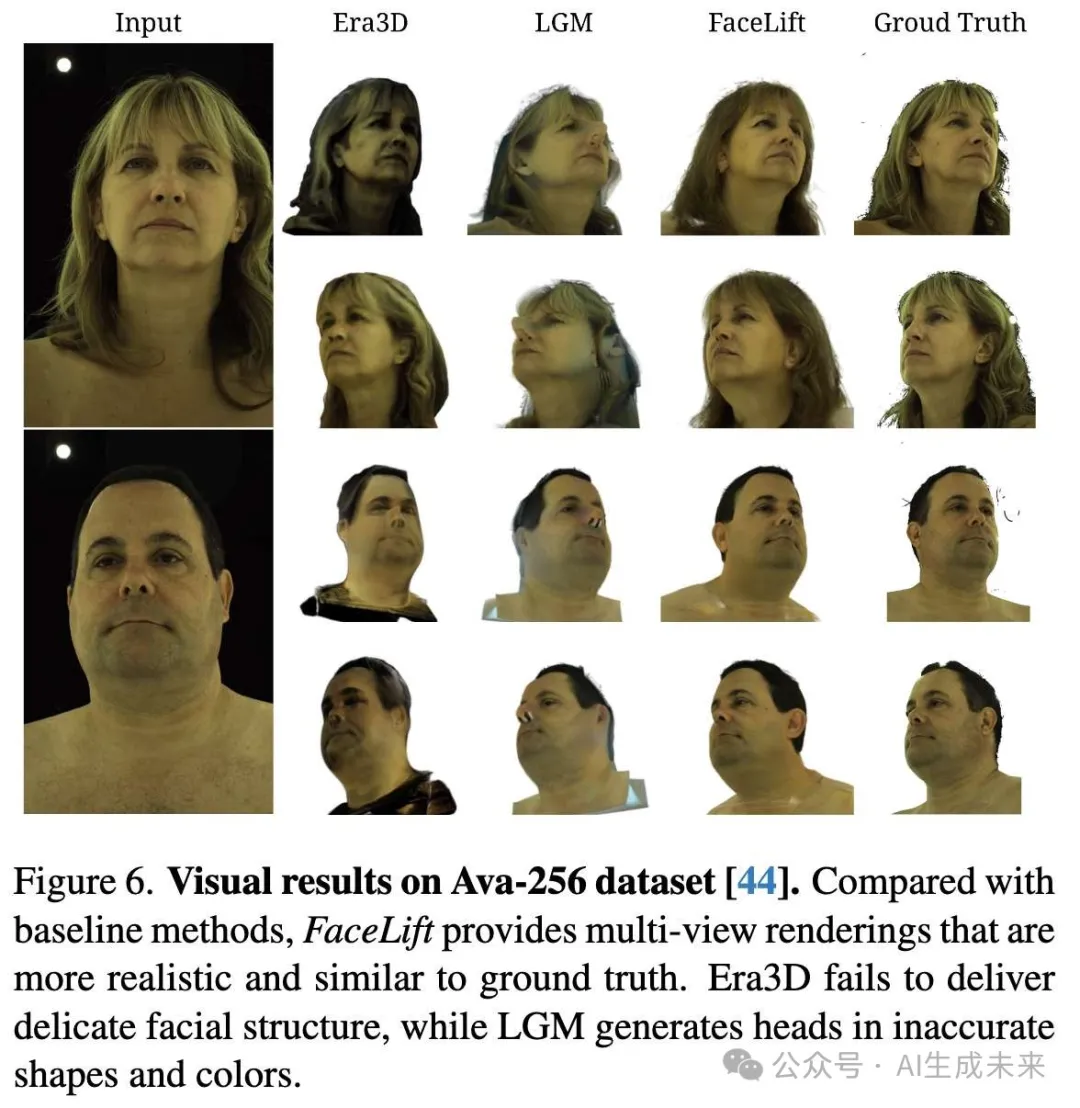

視覺結果

如圖 6 所示,FaceLift 能夠生成更逼真的頭部合成圖像,而 Era3D 在皮膚和頭發紋理以及面部細節上存在缺陷。此外,LGM 在鼻子形狀的重建上表現不準確。

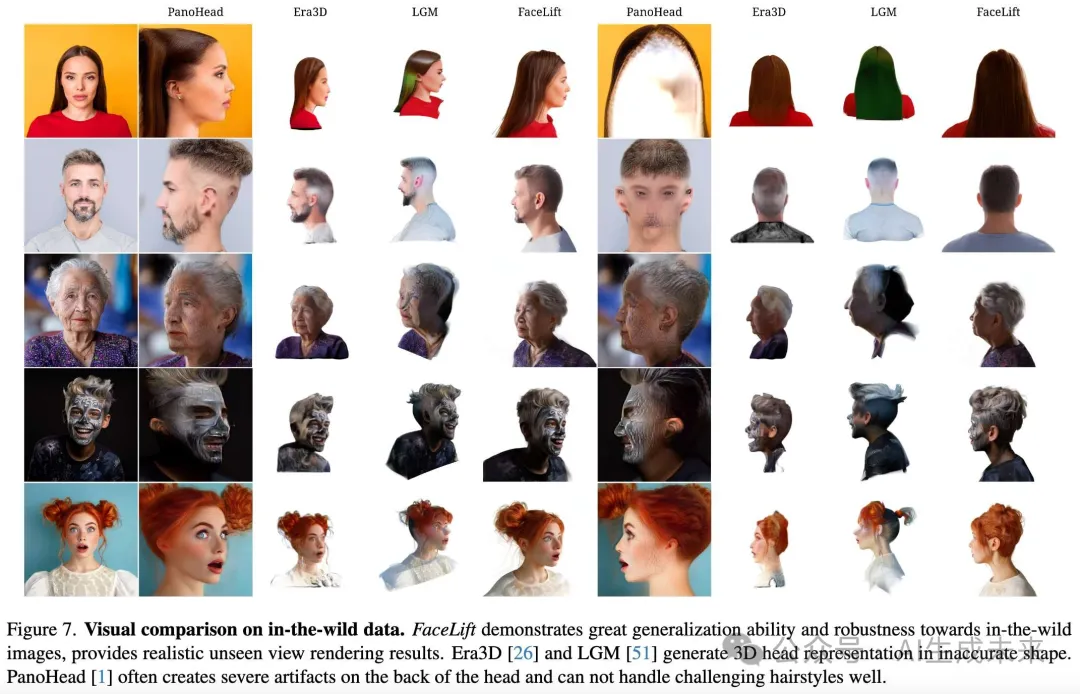

在自然場景圖像上的結果

方法泛化能力

為了進一步展示 FaceLift 的泛化能力并強調其在真實應用中的潛力,我們收集了自然場景中的人臉圖像,與其他基線方法進行定性比較,結果如下圖 7 所示。

- 基線方法問題

- PanoHead經常無法渲染頭部后方,有時甚至會在后腦生成額外的眼睛。此外,它在頭發、陰影、皺紋以及面部涂料的合成上也表現不佳。PanoHead 的輸出缺乏多視角一致性。例如,在最后一行中,盡管相機視角發生了變化,但女孩在新視角 1 中依然面向鏡頭。

- Era3D在生成頭部形狀時常有誤差,尤其是在左側和右側視圖中。此外,相較于 FaceLift,它生成的幾何細節更少。

- LGM所生成的高斯分布顏色和透明度不準確,缺乏對面部幾何的正確理解,導致面部特征扭曲。

- FaceLift 的優勢

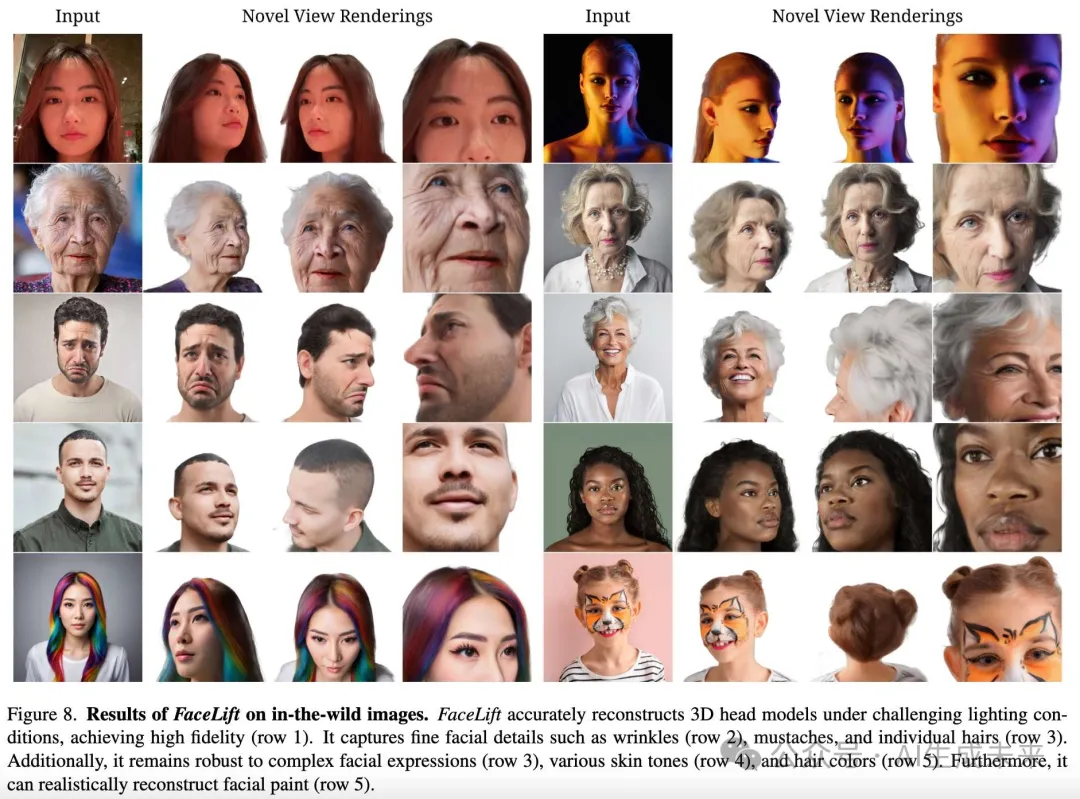

更多渲染結果

下圖 8 中展示了 FaceLift 的新視角渲染結果:

- 不同光照條件

FaceLift 能夠在各種光照條件下處理人臉。例如,在光線較暗的條件下(第 1 行第 1 列,由 iPhone 拍攝的照片),它仍然能渲染出逼真的新視角圖像,突顯了其魯棒性和真實應用潛力。 - 極端表情和細節重建

FaceLift 能夠高保真地重建面部細節,尤其是極端表情導致的面部皺紋和褶皺(第 2 行和第 3 行)。 - 復雜紋理的處理

FaceLift 在重建挑戰性紋理(如胡須和頭發)方面表現優異。此外,即使我們的合成人臉數據集中不包含面部涂料數據,FaceLift 仍能忠實地重建面部涂料,展現了其強大的泛化能力。

應用:視頻作為輸入進行4D新視角渲染

如下圖 9 所示,得益于 FaceLift 的高保真重建能力,該方法能夠從視頻輸入生成一致的 3D 高斯序列,實現 4D 渲染。具體過程如下:

- 幀序列處理:逐幀處理視頻輸入,為每一幀生成一個 3D 高斯表示,形成高斯序列。

- 時間戳渲染:在任意時間戳選擇對應的 3D 高斯表示,可從任何給定視角進行渲染。

盡管未添加約束以保持不同時間戳間的一致性,FaceLift 仍能以極少偽影渲染新視角下的視頻序列。

結合2D人臉動畫方法

通過結合諸如 LivePortrait 等 2D 人臉動畫方法,FaceLift 實現了 3D 人臉動畫。

- 極端表情處理

FaceLift 的魯棒性和強泛化能力允許其將帶有極端表情的人臉提升為 3D 表現,而不會犧牲細節保真度。

消融研究

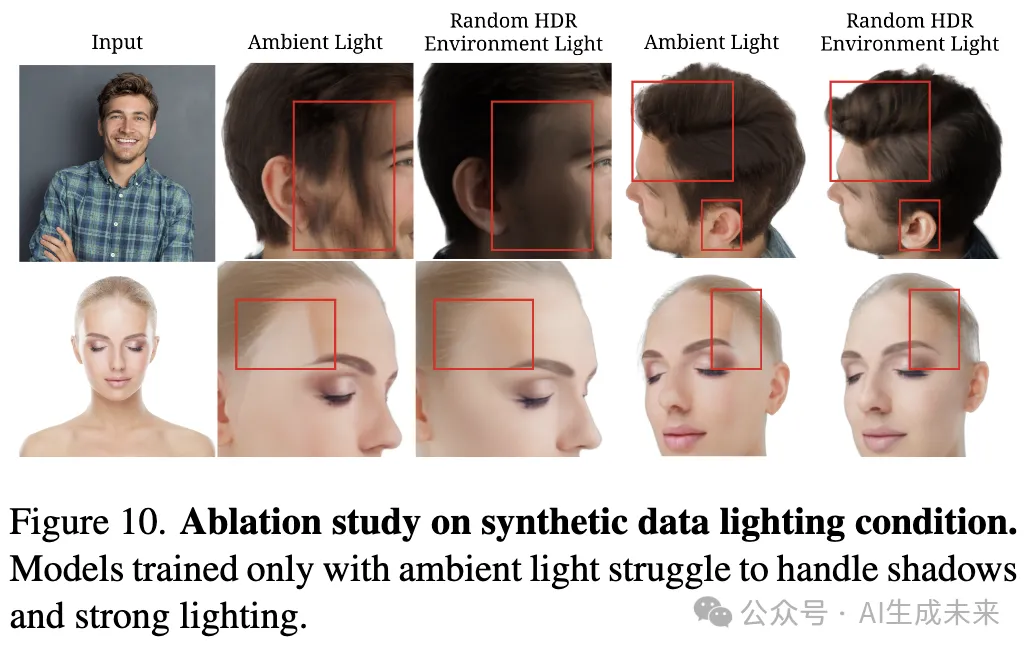

多樣化光照數據的重要性

FaceLift 使用合成數據進行訓練,這帶來了控制光照條件的優勢,使得頭像圖像可以在多種光照場景下渲染。相比之下,真實世界的人臉數據通常在類似環境光的工作室中捕獲,如下圖 2 中的輸入所示。

- 僅環境光渲染的數據

- 隨機 HDR 環境光渲染的數據

結果比較

結果如下圖 10 所示:

- 僅環境光數據訓練的模型

- 難以正確理解陰影,常在面部生成類似頭發的紋理。

- 面對強光照時,面部會出現白色區域。

- 隨機 HDR 環境光數據訓練的模型

- 在不同光照區域之間生成平滑過渡,表現出更強的光照適應能力。

此研究表明,豐富的光照數據是訓練高性能 3D 人臉重建模型的重要因素。

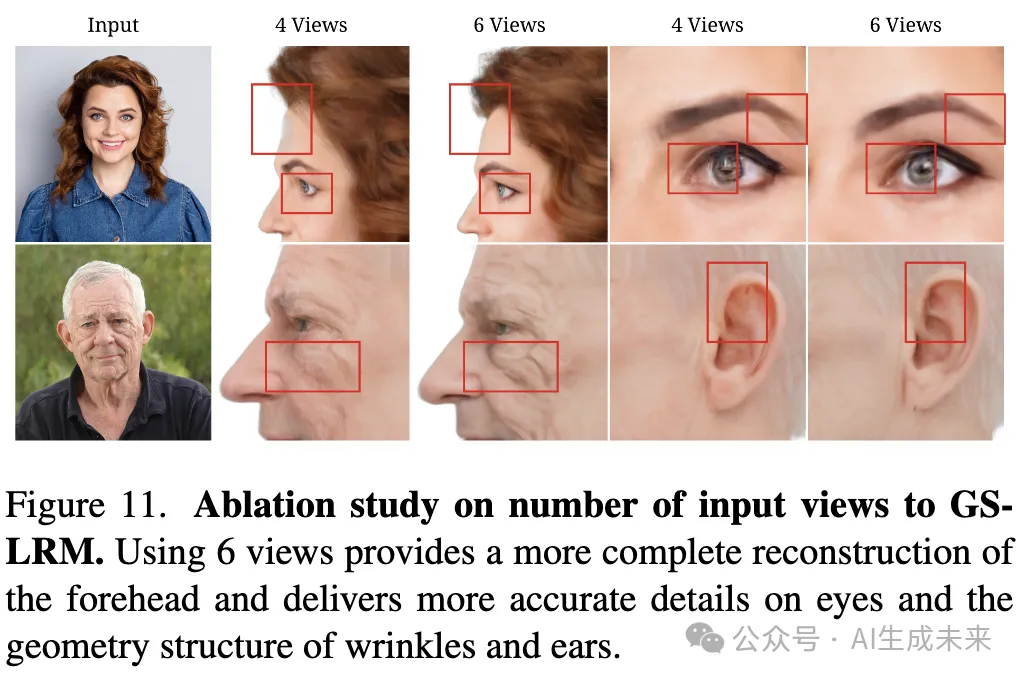

多視角用于 GS-LRM 重建原始 GS-LRM 使用四個視角進行推理。在此基礎上增加了兩個視角(左前方和右前方),以進一步改善面部細節結構的重建能力。

如下圖 11 所示,不同輸入圖像數量對 GS-LRM 重建的影響如下:

- 僅使用四個視角:

- 無法完整重建前額。

- 使用六個視角:

- 更平滑地重建眼睛和眉毛。

- 更真實地呈現諸如面部皺紋和耳部褶皺等復雜紋理。

GS-LRM 微調的有效性

在 FaceLift 中使用的 GS-LRM 是通過在 Objaverse 上使用合成頭像數據進行預訓練的 GS-LRM 檢查點進行微調的。

為了驗證合成頭像數據訓練的重要性,將以下兩種模型的渲染結果進行了對比:

- 僅在 Objaverse 上訓練的 GS-LRM

- 微調后的 GS-LRM

結果顯示:

- 未微調的 GS-LRM

- 難以準確估計面部深度,導致眼部區域出現偽影,并且由于缺乏從頭頂上方投影的高斯點,頭頂呈現扁平狀態。

- 微調后的 GS-LRM

- 學習到了頭部結構的先驗知識,能夠生成更平滑和更真實的渲染結果。

結論與未來工作

FaceLift,這是一種單張人臉圖像到高精度 3D 重建的前饋方法,能夠保留身份特征。FaceLift 通過多視角擴散生成不可見視角,并利用 GS-LRM 重建 3D 高斯點,支持高質量的新視角合成。為了應對捕獲真實世界多視角頭像圖像的困難,本文采用高質量合成數據進行訓練。盡管僅在合成數據上訓練,FaceLift 仍能從真實圖像中高保真地重建 3D 頭像。

相比baseline方法,FaceLift 表現出以下優勢:

- 更精細的幾何與紋理細節

- 更好的身份特征保留能力

此外,還展示了 FaceLift 在視頻輸入場景下支持 4D 新視角合成的能力,驗證了其高保真與魯棒性。盡管如此,仍觀察到跨時間戳的一些不一致性,尤其是在頭發區域。

未來工作方向

為了增強時間一致性,計劃引入 4D 高斯表示,從而更好地約束 3D 高斯點在幀間的位置、形狀、大小及旋轉等屬性。

本文轉自AI生成未來 ,作者:AI生成未來