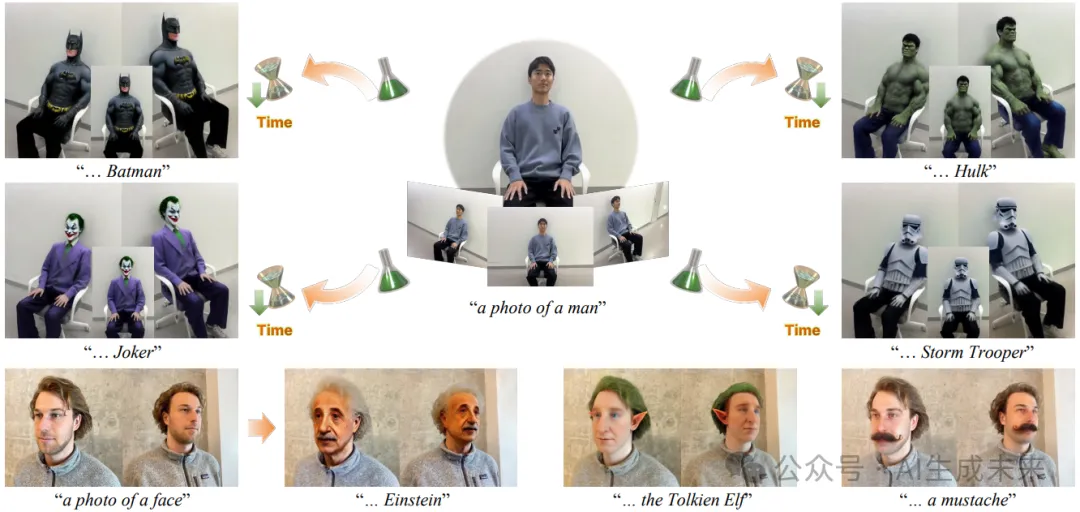

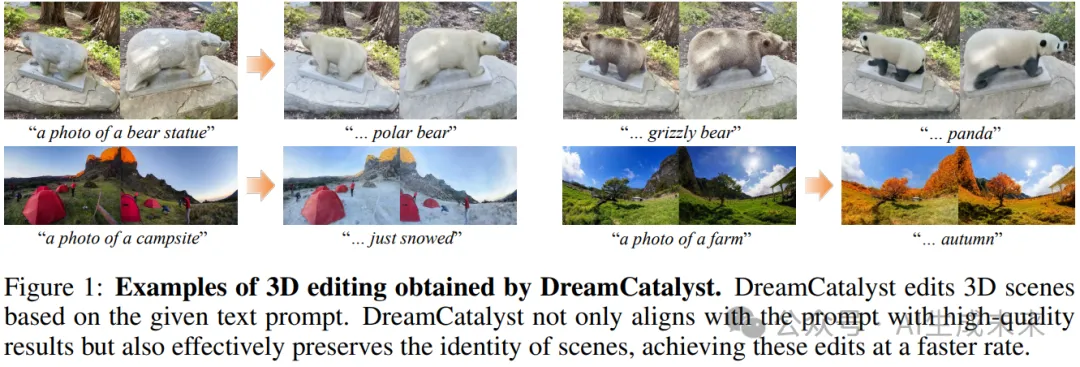

超越所有NeRF方法!快速和高質量的3D編輯和身份保持新策略:DreamCatalyst

論文鏈接:https://arxiv.org/pdf/2407.11394

github鏈接:https://dream-catalyst.github.io/

亮點直擊:

- 本文通過將DDS解釋為SDEdit過程,提出了一種3D編輯的一般公式,并提出了一種用于快速編輯和質量改進的專門公式。

- 在一般的3D編輯任務中采用了遞減時間步采樣,這是一種在3D生成任務中常用的加速訓練速度的采樣算法,解決了以往工作中面臨的挑戰。

- 首次引入FreeU用于3D編輯,以增強可編輯性,克服重新加權編輯目標公式中固有的權衡。

- 編輯的速度和質量優于當前最先進的NeRF編輯方法。

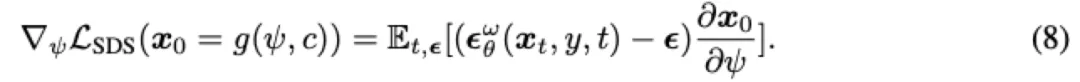

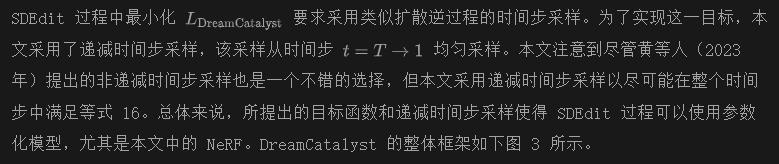

得分蒸餾采樣(SDS)因其固有的3D一致性,在文本驅動的3D編輯任務中已成為一種有效的框架。然而,現有基于SDS的3D編輯方法由于偏離擴散模型的采樣動態,導致訓練時間過長且結果質量低下。在本文中,本文提出了DreamCatalyst,這是一種將基于SDS的編輯解釋為擴散反向過程的新穎框架。本文的目標函數考慮了采樣動態,因此使DreamCatalyst的優化過程成為編輯任務中擴散反向過程的近似。

DreamCatalyst旨在減少訓練時間并提高編輯質量。DreamCatalyst提供了兩種模式:

- 快速模式,僅需約25分鐘即可編輯NeRF場景;

- 高質量模式,在不到70分鐘內產生優質結果。具體來說,本文的高質量模式在速度和質量方面均優于當前最先進的NeRF編輯方法。

DREAMCATALYST

動機

本文旨在設計一個目標函數,類似于PDS(Perceptual Diffusion Sampling),包含一個顯式的強身份保留項,同時與擴散時間步的作用對齊,并允許應用遞減時間步采樣。為了實現這一目標,必須在大噪聲擾動中強調身份保留,并通過重新加權公式12中的每一項,在小擾動水平上不發生偏離。然而,隨機潛在匹配的公式本質上隱含了一個身份保留項和DDS(Diffusion-Denoising Score Matching)損失的梯度,使其無法直接調整系數。因此,本文提供了DDS的新解釋,并通過這一視角引入PDS的一般公式來重新加權這些項。

此外,本文提出了一種專門的公式,與擴散時間步的角色對齊,并支持遞減時間步采樣。這種專門的公式主要有兩個優點:

- 通過考慮擴散時間步的作用,本文的公式可以生成細節豐富的3D編輯結果;

- 通過擴散友好的采樣,遞減時間步采樣極大地減少了訓練時間。

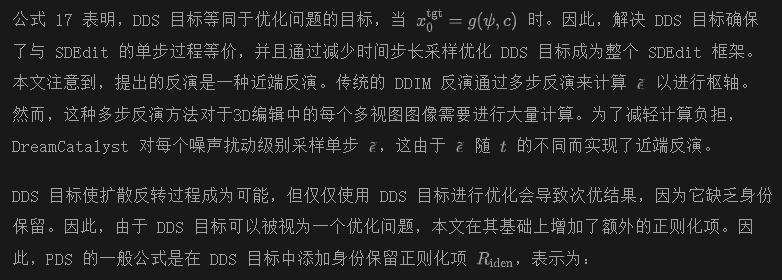

PDS 的一般公式

本文揭示了反向SDEdit過程和DDS(Diffusion-Denoising Score Matching)之間的關系。DreamCatalyst的關鍵見解是,DDS的目標等同于基于單步DDIM(Denoising Diffusion Implicit Models)的SDEdit采樣。

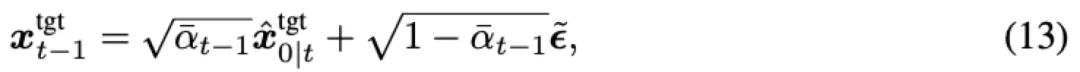

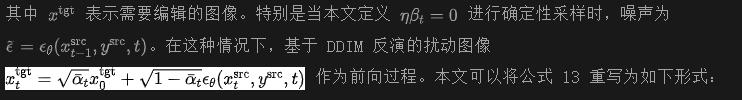

上述公式通過解決隨機采樣噪聲的隨機微分方程(SDEs)實現隨機編輯。然而,最近的編輯研究利用DDIM反演來保留源身份。通過結合SDEdit和DDIM調度來保留源身份,基于DDIM的SDEdit采樣定義為:

盡管SDEdit的單步去噪過程在擴散過程中通過公式13已經很清楚,但受到Dreamsampler(Kim等人,2024年)的啟發,本文可以將該過程解釋為如下的優化問題:

其中:

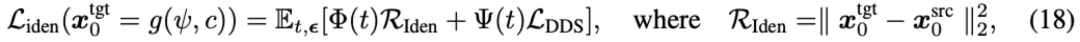

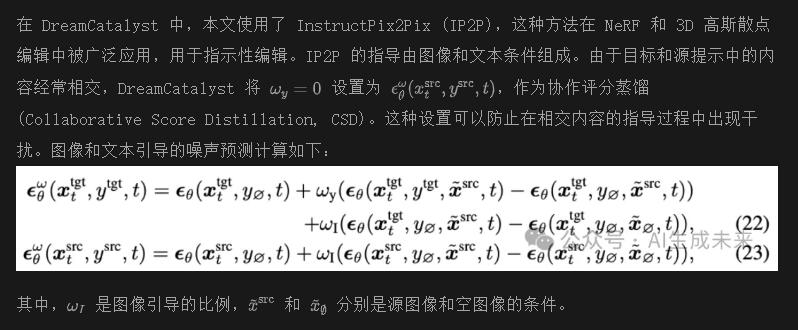

基于 SDS 的擴散友好編輯

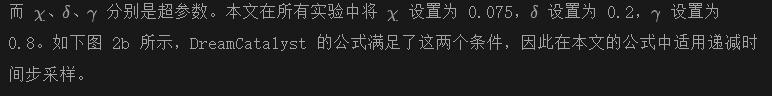

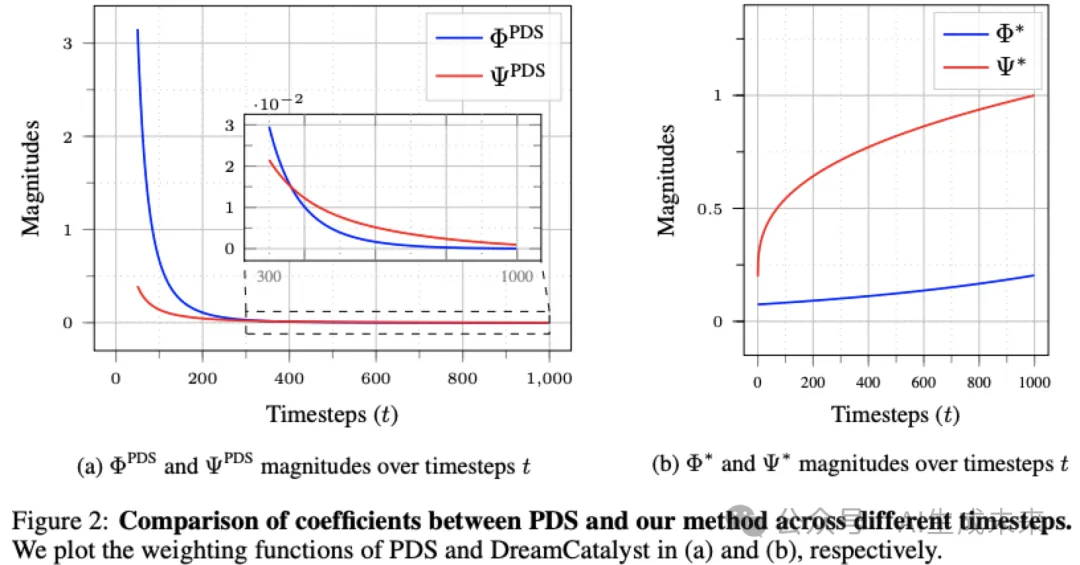

在本節中,本文提出了一個專門的公式(公式18),該公式考慮了擴散時間步的作用以及與遞減時間步采樣的對齊問題。DreamCatalyst中的公式設計旨在滿足兩個條件:

- 在高時間步中強身份保留

- 在低時間步中減少身份保留。

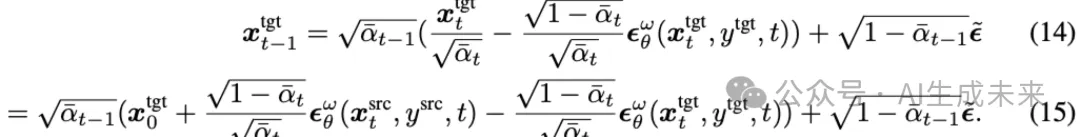

第一個條件是,在高時間步中強身份保留,可以減少源特征在高噪聲擾動水平下的信息丟失。這個條件使得可以利用遞減時間步采樣。第二個條件是,在低時間步中弱身份保留,這有助于在擴散過程中合成細節。滿足這兩個條件的DreamCatalyst專門公式如下:

其中,

本文注意到,滿足兩個條件能夠實現有效的3D編輯,如上圖1所示。本文將更優設計選擇的探索留給未來的工作。

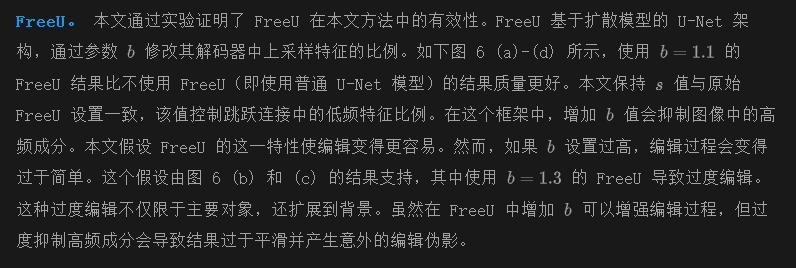

使用 FREEU 增強可編輯性

盡管使用所提出的損失函數的SDEdit過程改善了編輯質量,但目標函數的設計因固有的權衡而僅能帶來有限的改進。在編輯任務中,可編輯性和身份保留是眾所周知的權衡。修改模型架構提供了一種替代方法來增強編輯質量,帶來了僅通過損失函數設計無法實現的性能提升。

本文引入了在3D編輯中使用FreeU,以在不增加額外內存使用和計算成本的情況下增強可編輯性。FreeU通過放大包含大量低頻信息的骨干特征來抑制高頻特征。放大骨干特征強調了低頻特征,從而相對減少了高頻特征的影響。結果,通過抑制高頻特征,提高了可編輯性,因為高頻特征的銳利特性被平滑處理,邊緣特征被削弱。此外,身份保留對應于低頻域,通過放大骨干特征得以維持。綜上所述,FreeU在不犧牲身份保留的情況下增強了可編輯性。

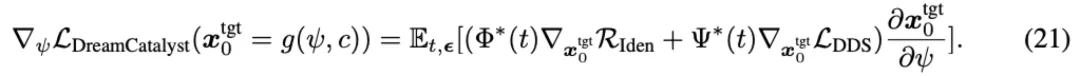

REAMCATALYST 中的文本指導

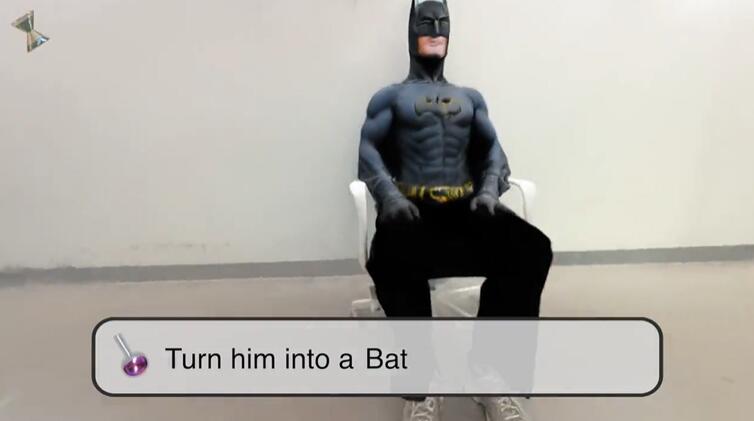

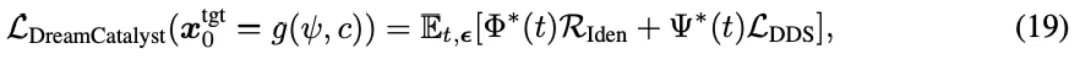

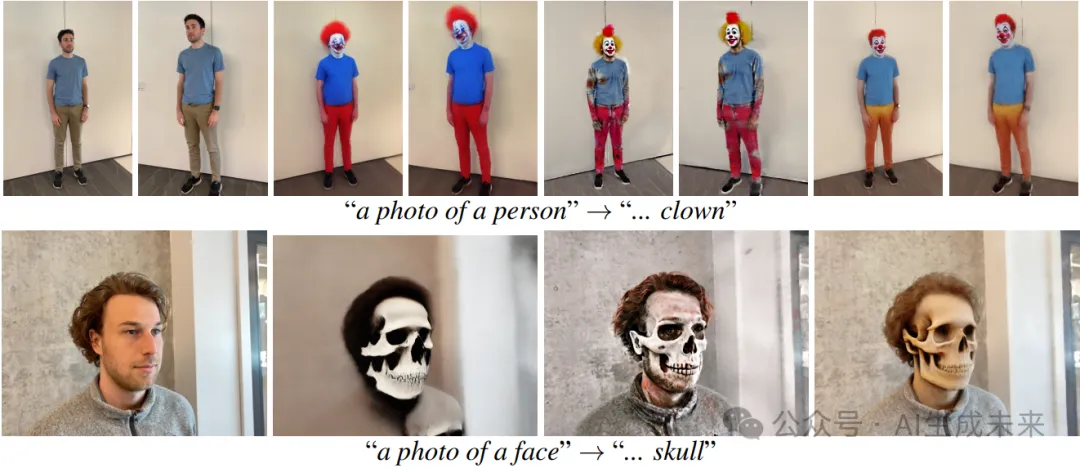

定性評估

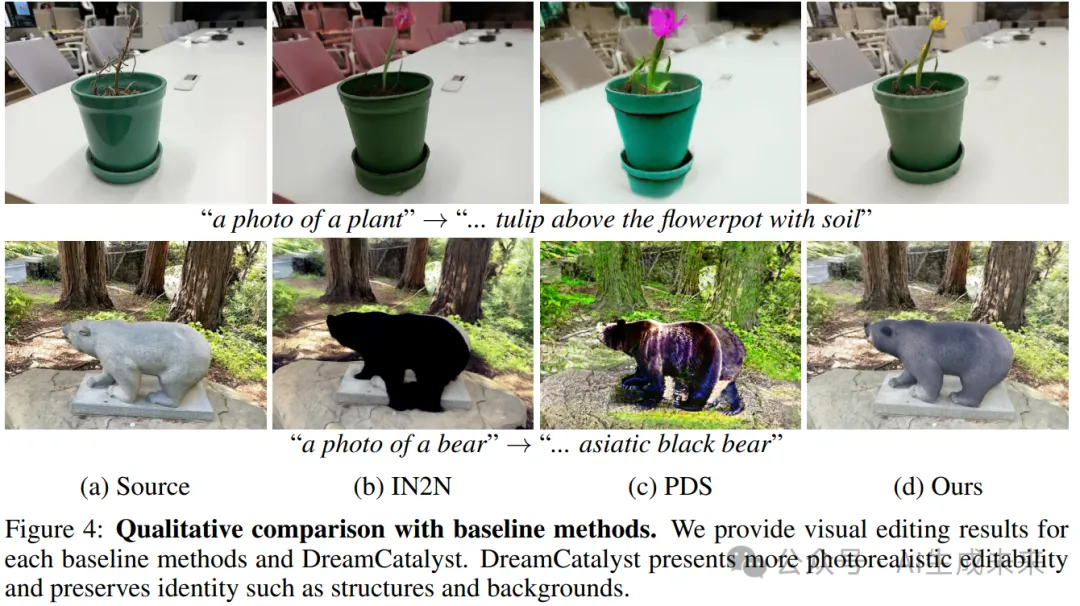

在下圖 4 中,本文展示了與基線方法的定性比較。雖然基線方法產生的背景模糊且過度飽和,但 DreamCatalyst 很好地保留了源場景的背景。此外,與基線方法相比,DreamCatalyst 合成了更詳細、更逼真的編輯結果(例如,基線方法生成的郁金香模糊且缺乏細節)。PDS 似乎可以很好地編輯主體,但其結果往往過度飽和且不夠逼真,背景更容易模糊或改變顏色。因此,DreamCatalyst 在保持源場景身份的同時,具有更優越的可編輯性,超越了其他基線。

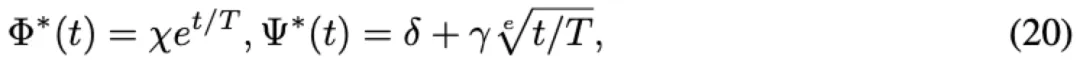

定量評估

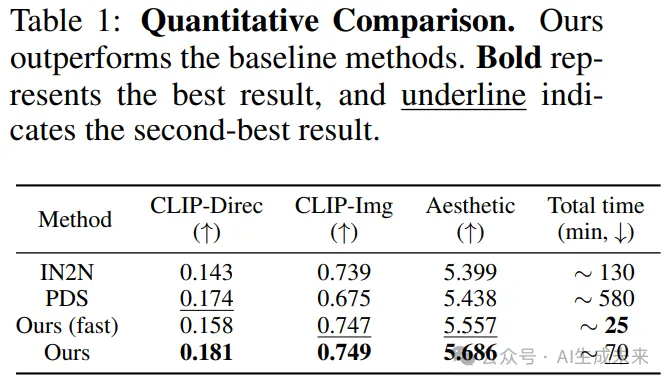

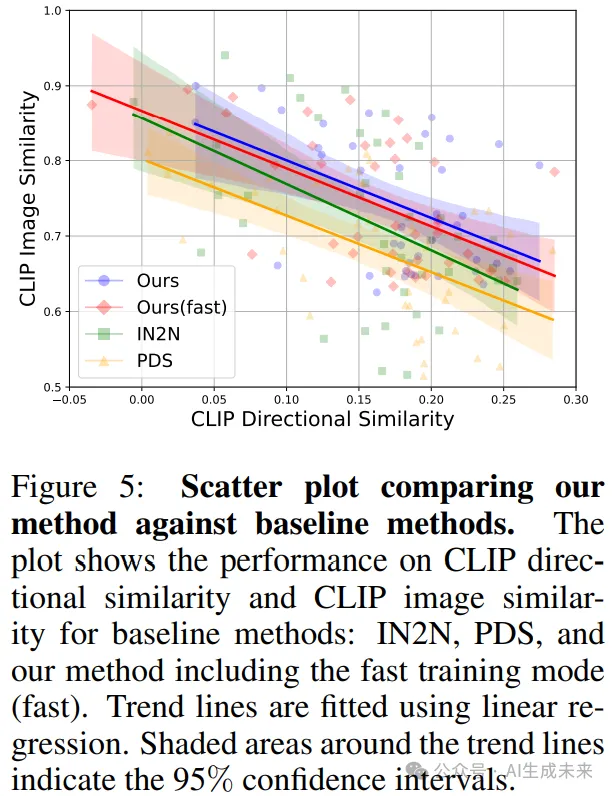

本文使用 CLIP 方向相似度、CLIP 圖像相似度和美學評分來評估 DreamCatalyst 和基線方法。CLIP 方向相似度衡量圖像與文本的對齊程度,CLIP 圖像相似度評估身份保留的水平,美學評分則表示編輯質量。如下表 1 和下圖 5 所示,DreamCatalyst 在所有指標上均獲得最高分。此外,本文還測量了每種方法的編輯時間。為了公平比較,本文將所有方法的分辨率設置為相同。DreamCatalyst 的快速模式比最新的基于 SDS 的編輯方法 PDS 快約 23 倍,高質量模式則比 PDS 快約 8 倍。盡管 IN2N 在二維空間中進行編輯,比直接的三維編輯方法所需時間更少,但即使在高質量模式下,DreamCatalyst 仍比 IN2N 快 1.85 倍。

用戶研究

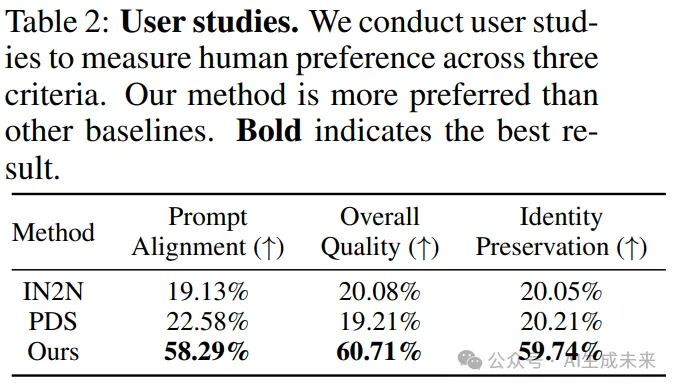

本文進行了用戶研究,如下表 2 所示,因為專門用于評估 2D 圖像的指標不足以評估 3D 場景。對于每個問題,參與者被要求從基線方法和 DreamCatalyst 的結果中選擇最佳視頻。本文選擇了 15 個文本提示來評估三個標準:(1)提示對齊,(2)整體質量和(3)身份保留。每個標準的問題如下:(1)“在編輯視頻時,哪個視頻最符合文本提示并展示高質量?”(2)“在編輯視頻時,哪個視頻展示了最佳的編輯質量?”和(3)“在編輯源視頻時,哪個編輯過的視頻最好地保留了源視頻的背景和身份?”為了收集人類偏好數據,本文利用亞馬遜 Mechanical Turk 對 50 名參與者進行了調查。結果表明,DreamCatalyst 在所有標準上都比基線方法更受歡迎,優勢明顯。

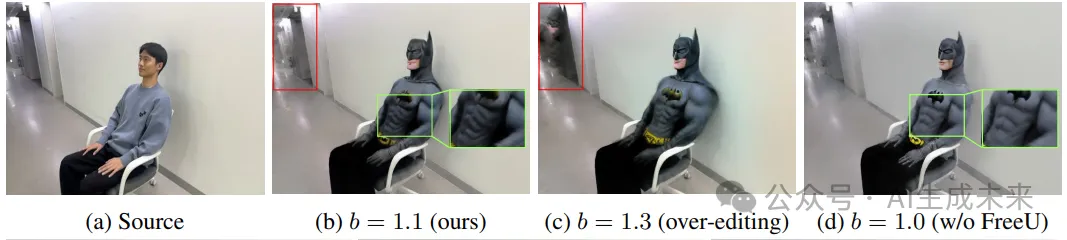

消融實驗

減少時間步采樣。 在本節中,本文展示了減少時間步采樣的有效性。為了公平比較,實驗設置相同,每次使用 500 次迭代,除了時間步采樣算法外。如上圖 6 所示,減少時間步采樣的編輯結果收斂到細節豐富的結果,而隨機時間步采樣的結果則表現出過飽和的顏色,并且在相同編輯時間內未能保持背景一致性。因此,減少時間步采樣可以更快地收斂。

結論

本文提出了一種用于3D編輯的通用公式,通過揭示反向SDEdit過程和DDS之間的關系。基于這一公式,本文引入了DreamCatalyst,它考慮了擴散過程的動態性,通過基于SDS的方法作為反向SDEdit過程來編輯3D場景。此外,本文建議在分數蒸餾中使用FreeU,以克服公式中固有的可編輯性和身份保留之間的權衡。結果表明,DreamCatalyst實現了快速且高質量的3D編輯。通過比較分析和用戶研究,本文證明了DreamCatalyst在性能和編輯速度上均超越了最先進的方法。

本文轉自 AI生成未來 ,作者:AI生成未來