文生圖擊敗所有擴散SOTA方案!智源研究院等提出NOVA:邁向統一的多任務大模型

文章鏈接:https://arxiv.org/pdf/2412.14169

Github鏈接:https://github.com/baaivision/NOVA

亮點直擊:

- 高效的自回歸建模:NOVA提出了不使用向量量化的自回歸視頻生成方法,通過時間步預測和空間集預測的分離,結合雙向建模,在提高生成效率的同時保持較高的視覺保真度和流暢性。

- 顯著降低訓練成本:NOVA在文本到圖像生成任務中超越了最先進的圖像擴散模型,不僅在生成質量上表現出色,而且在訓練成本上大幅降低,使得視頻生成任務更具實用性。

- 良好的zero-shot泛化能力:NOVA能夠處理不同的視頻時長和應用場景,具有強大的zero-shot能力,使其成為一個統一的多功能模型,適應多種生成任務。

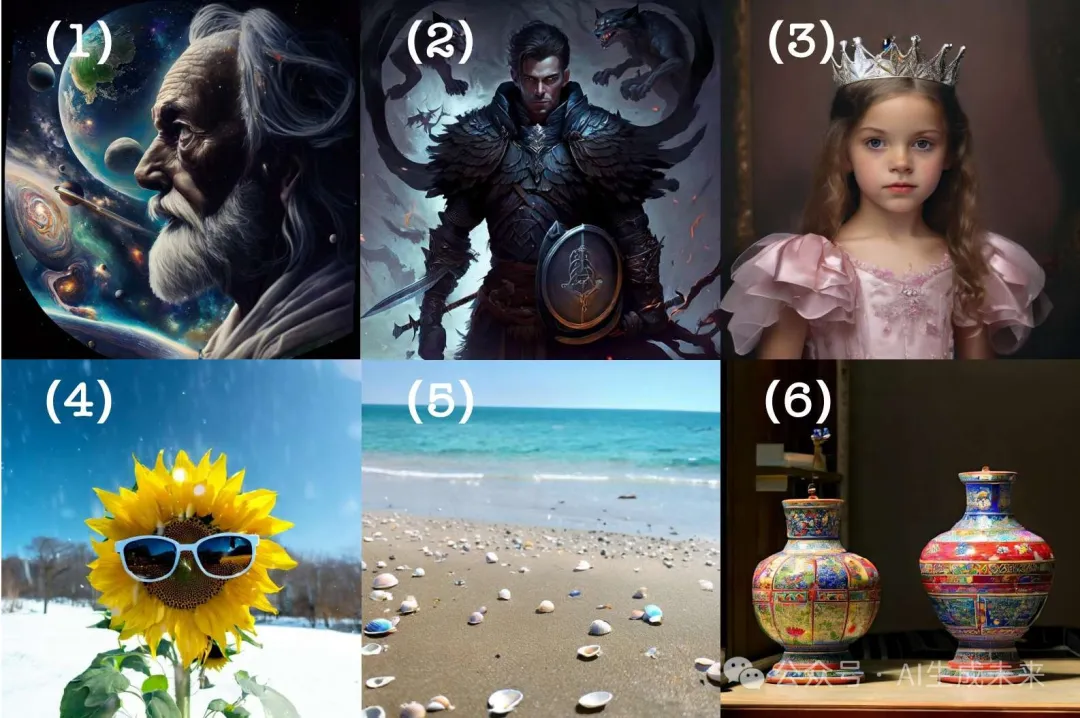

文生圖效果一覽

總結速覽

解決的問題:

- 現有的自回歸視頻生成模型(如圖像或視頻片段通過向量量化轉換為離散值標記空間后進行逐標記預測)面臨著高保真度和高壓縮率難以同時實現的問題。

- 向量量化的標記生成方法需要更多的標記來保證高質量,從而導致圖像分辨率或視頻序列較長時,計算成本顯著增加。

- 在自回歸(AR)視覺生成領域,現有方法通常采用柵格掃描預測,導致生成效率較低,且對于大規模視頻數據的處理能力有限。

提出的方案:

- 提出了一種新的自回歸視頻生成方法,稱為NOVA,通過不使用向量量化的方式進行視頻生成建模。

- 該方法將視頻生成問題重新表述為非量化的自回歸建模,分為時間步預測和空間集預測兩個部分。

- NOVA維持了GPT風格模型的因果特性(Causal Property),確保了靈活的上下文學習能力,同時在單幀內使用雙向建模(Bidirectional Modeling)來提高效率。

應用的技術:

- 自回歸建模(Autoregressive Modeling):通過不使用向量量化來實現幀對幀的時間預測和集對集的空間預測。

- 雙向建模:在單幀內進行雙向建模,以提高生成效率,減少計算資源需求。

- GPT風格因果建模:保持因果關系,使模型能夠靈活地進行上下文學習。

達到的效果:

- NOVA模型比現有的自回歸視頻生成模型在數據效率、推理速度、視覺保真度和視頻流暢性上具有顯著優勢,且模型容量較小,僅為0.6B參數。

- 較低的訓練成本:在文本到圖像生成任務中,NOVA超越了當前最先進的圖像擴散模型,同時降低了訓練成本。

- 廣泛的zero-shot應用能力:NOVA模型在不同的視頻時長和應用場景中具有良好的泛化能力。

方法

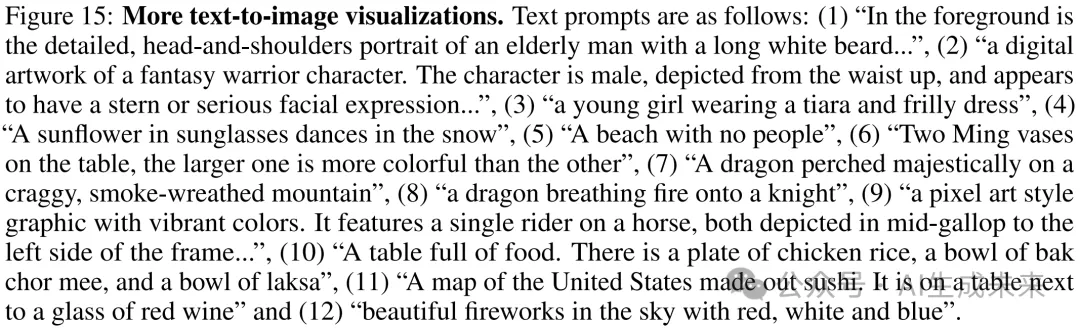

NOVA 框架的pipeline和實現細節,如下圖 2 所示。

重新思考自回歸模型在視頻生成中的應用

本文將文本到視頻生成視為基本任務,將自回歸(AR)模型視為基本手段。自回歸視頻生成方法主要有兩種類型:

(1) 通過柵格掃描順序的逐token生成。這些研究在視頻幀序列中執行因果逐token預測,并按照柵格掃描順序依次解碼視覺token:

(2) 隨機順序的mask集生成方法將每個視頻幀內的所有標記視為平等,使用雙向transformer解碼器進行每組token的預測。然而,這種廣義的自回歸(AR)模型是在大型固定長度的視頻幀上進行同步建模訓練的,這可能導致在上下文上的可擴展性差,并且在較長的視頻時長中存在一致性問題。因此,NOVA 提出了一個新解決方案,通過將單個視頻幀內的每組生成與整個視頻序列中的每幀預測解耦。這使得 NOVA 能夠更好地處理時間因果性和空間關系,提供了一個更靈活、更具可擴展性的 AR 框架。

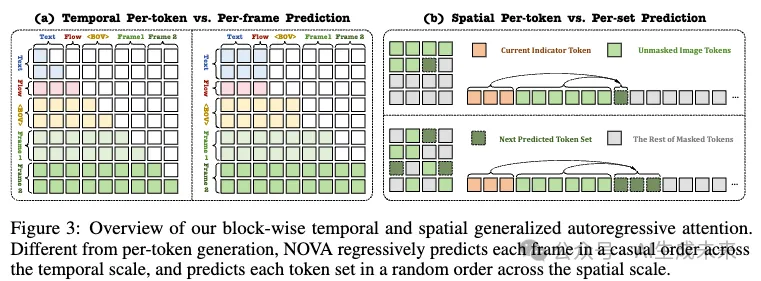

時間自回歸建模通過逐幀預測

使用預訓練的語言模型將文本提示編碼為特征。為了更好地控制視頻動態,使用 OpenCV (cv2)計算采樣視頻幀的光流。平均光流幅度作為運動評分,并與提示信息進行整合。此外,采用開源的 3D 變分自編碼器(VAE),其時間步長為 4,空間步長為 8,將視頻幀編碼到隱空間。增加了一個額外的可學習的補丁嵌入層,空間步長為 4,用以對齊隱視頻通道到后續的transformer。值得注意的是,早期 AR 模型中的下一個標記預測對于單個圖像中的無向視覺補丁似乎是反直覺的,并且在推理過程中存在較高的延遲。相比之下,視頻幀可以自然地看作一個因果序列,每個幀充當自回歸生成的元單元。因此實現了如圖 3(a) 所示的塊級因果遮罩注意力,確保每個幀只能關注文本提示、視頻光流以及其前面的幀,同時允許所有當前幀標記彼此可見:

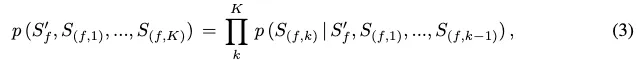

空間自回歸建模通過集對集預測

將每個token集定義為來自隨機方向的多個標記作為元因果標記,如上圖 3(b) 所示,從而促進了一個高效并行解碼的廣義 AR 過程。嘗試利用時間層輸出的目標幀指示特征來輔助空間層,逐漸解碼對應圖像中的所有隨機masked token集。然而,這種方法導致了圖像結構崩塌和隨幀數增加而導致的視頻流暢性不一致。我們假設這種情況的發生是因為來自相鄰幀的指示特征相似,難以在沒有顯式建模的情況下準確學習連續和微小的運動變化。此外,訓練期間從真實框架獲得的指示特征對空間 AR 層的魯棒性和穩定性貢獻較弱,無法有效抵抗累積推理誤差。

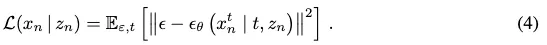

擴散過程去噪用于逐標記預測

在訓練過程中,引入了擴散損失來估算連續值空間中的per-token概率。例如,定義一個真實標記為 ,并且 NOVA 的輸出為 。損失函數可以表述為去噪準則:

實驗

實驗設置

數據集:

我們采用多個多樣化、精心挑選的高質量數據集來訓練我們的 NOVA。對于文本到圖像的訓練,最初從 DataComp、COYO、Unsplash和 JourneyDB收集了 1600 萬個圖像-文本對。為了探索 NOVA 的擴展性,通過從 LAION、DataComp 和 COYO 中選擇更多最低美學評分為 5.0 的圖像,擴展了數據集,最終達到約 6 億個圖像-文本對。對于文本到視頻的訓練,從 Panda-70M的子集和內部視頻-文本對中選擇了 1900 萬個視頻-文本對。進一步從 Pexels收集了 100 萬個高分辨率視頻-文本對,以微調我們的最終視頻生成模型。根據 (Diao et al. (2024)),訓練了一個基于 Emu2-17B模型的字幕引擎,為我們的圖像和視頻數據集創建高質量的描述。最大文本長度設置為 256。

架構:

主要遵循 (Li et al. (2024c)) 構建 NOVA 的空間 AR 層和去噪 MLP 塊,包括 LayerNorm、AdaLN、線性層、SiLU 激活 和另一個線性層。配置了 16 層的時間編碼器、空間編碼器和解碼器,維度分別為 768(0.3B)、1024(0.6B)或 1536(1.4B)。去噪 MLP 由 3 個維度為 1280 的塊組成。空間層采用 MAR的編碼-解碼架構,類似于 MAE。具體來說,編碼器處理可見的圖像塊進行重建,而解碼器進一步處理可見和被遮掩的塊進行生成。為了捕捉圖像的隱空間特征,使用了 (Lin et al. (2024)) 中的一個預訓練并凍結的 VAE,它在時間維度上實現了 4 倍壓縮,在空間維度上實現了 8×8 的壓縮。采用了 (Li et al. (2024c); Nichol & Dhariwal (2021)) 的mask和擴散調度器,在訓練過程中使用 0.7 到 1.0 之間的mask例,并在推理過程中根據余弦調度將其從 1.0 逐漸減少到 0。與常見做法一致 (Ho et al. (2020)),訓練時使用 1000 步的噪聲調度,但推理時默認為 100 步。

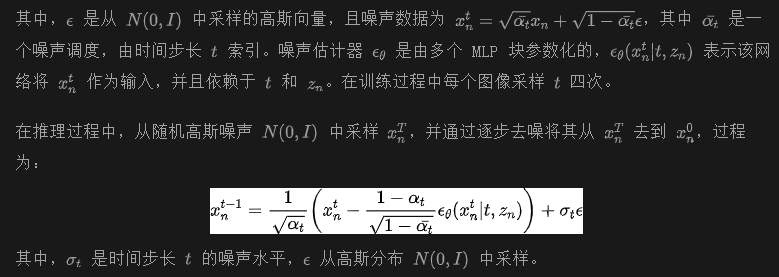

訓練細節:

評估:

使用 T2I-CompBench、GenEval和 DPG-Bench來評估生成圖像與文本條件之間的對齊度。對于每個原始或改寫的文本提示 (Wang et al. (2024)),生成圖像樣本,每個圖像樣本的分辨率為 512×512 或 1024×1024。使用 VBench來評估文本到視頻生成在 16 個維度上的能力。對于給定的文本提示,隨機生成 5 個樣本,每個樣本的視頻大小為 33×768×480。在所有評估實驗中采用了 7.0 的無分類器引導,并結合 128 步自回歸步驟來提高生成圖像和視頻的質量。

主要結果

NOVA 在文本到圖像生成模型中超越了現有的模型,展現出卓越的性能和效率。

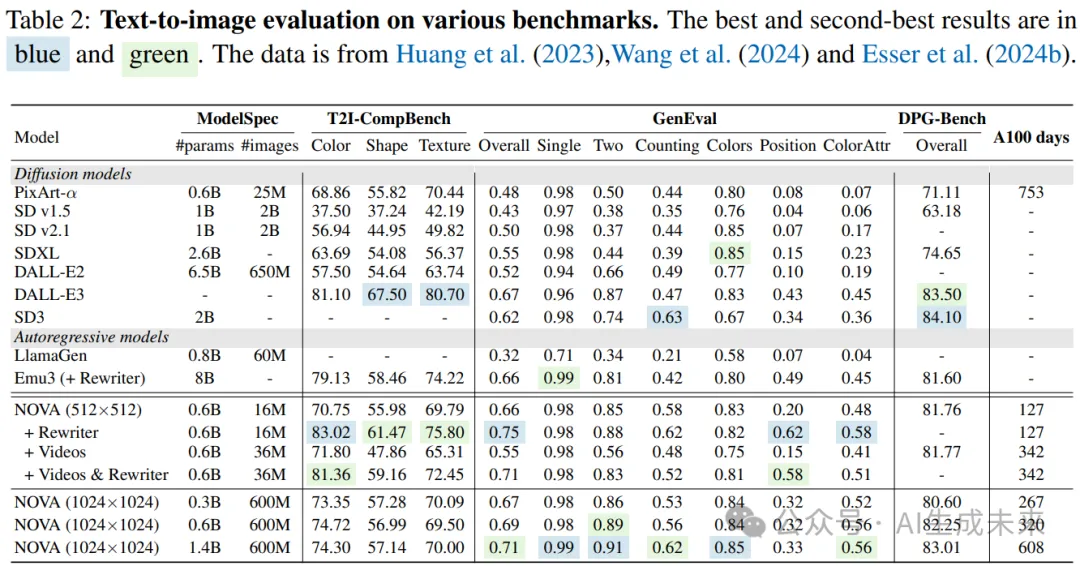

在 表 2 中,將 NOVA 與幾種近期的文本到圖像模型進行比較,包括 PixArt-α、SD v1/v2 、SDXL 、DALL-E2 、DALL-E3、SD3、LlamaGen和 Emu3。經過文本到圖像的訓練后,NOVA 在 GenEval 基準測試中取得了最先進的表現,尤其是在生成特定數量的目標時表現突出。

特別地,NOVA 在 T2I-CompBench 和 DPG-Bench 上也取得了領先的成績,在小規模模型和大規模數據下表現優異(僅需 PixArt-α 最佳競爭者的 16% 訓練開銷)。最后,我們的文本到視頻模型也超越了大多數專門的文本到圖像模型,例如 SD v1/v2、SDXL 和 DALL-E2。這突顯了我們模型在多上下文場景中的魯棒性和多功能性,尤其是在文本到視頻生成這一基本訓練任務上表現尤為突出。

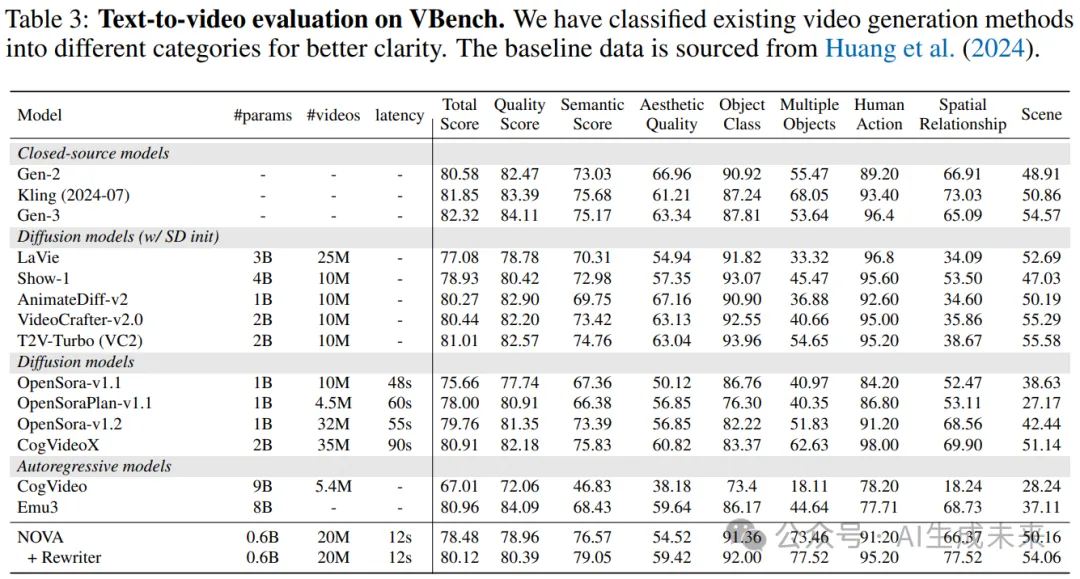

NOVA 在與擴散文本到視頻模型的競爭中表現出色,并顯著抑制了自回歸(AR)對比模型。強調當前版本的 NOVA 設計用于生成 33 幀視頻,并可以通過預填充最近生成的幀來擴展視頻長度。進行了定量分析,將 NOVA 與開源和專有的文本到視頻模型進行比較。如 表 3 所示,盡管其模型規模顯著較小(0.6B 與 9B),NOVA 在多項文本到視頻評估指標中明顯超越了CogVideo。它的性能與最新的 SOTA 模型 Emu3相當(80.12 與 80.96),但其規模遠小(0.6B 與 8B)。

此外,將 NOVA 與最先進的擴散模型進行了比較。包括 Gen-2、Kling、Gen-3等閉源模型,以及 LaVie、Show-1、AnimateDiff-v2、VideoCrafter-v2.0、T2V-Turbo、OpenSora-v1.1、OpenSoraPlan-v1.1/v1.2和 CogVideoX等開源替代方案。結果凸顯了文本到圖像預訓練在我們廣義因果過程中的有效性。值得注意的是,縮小了自回歸與擴散方法在建模大規模視頻文本對中的差距,提升了視頻生成的質量和指令跟隨能力。此外,NOVA 在推理延遲方面展示了相較于現有模型的顯著速度優勢。

定性結果

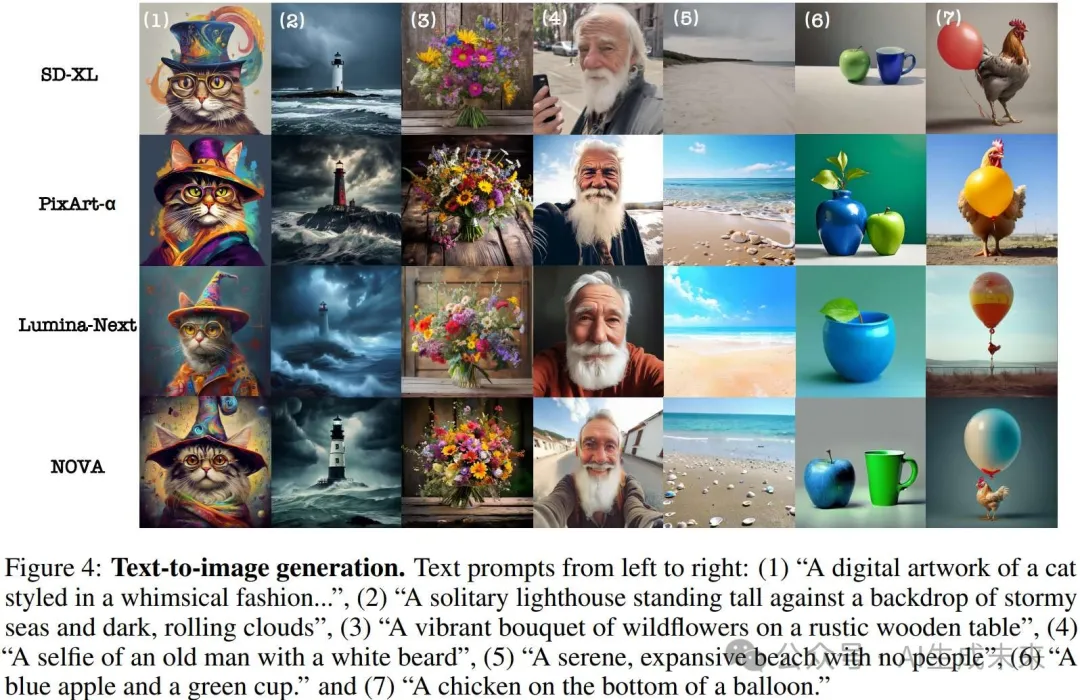

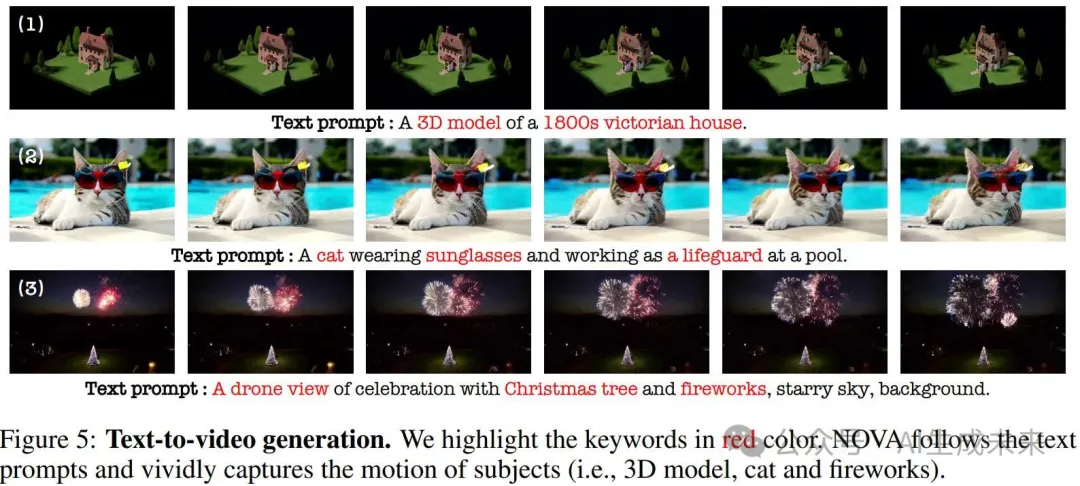

高保真圖像和高流暢度視頻

我們展示了當前領先圖像生成方法的定性比較,如 圖 4 所示。NOVA 在各種提示風格下表現出強大的視覺質量和保真度,尤其在顏色屬性綁定和空間物體關系方面表現出色。在 圖 5 中展示了文本到視頻的可視化,突出展示了 NOVA 捕捉多視角、平滑物體運動以及穩定場景過渡的能力,這些都基于提供的文本提示。

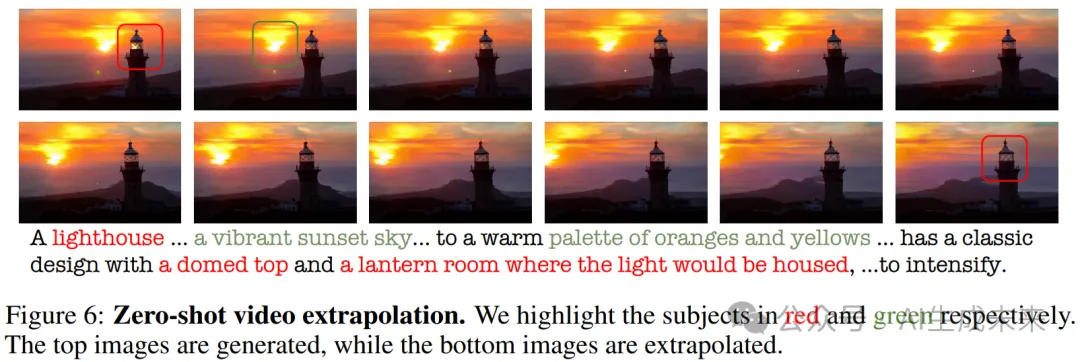

zero-shot 視頻外推的泛化能力

通過預填充生成的幀,NOVA 能夠生成超越訓練長度的視頻。例如,通過調整文本和 BOV 嵌入,我們生成了比原始視頻長兩倍的 5 秒視頻,如 圖 6 所示。在視頻外推過程中,我們觀察到 NOVA 始終保持幀間的時間一致性。例如,當提示描述一個穹頂和一個燈籠房間時,模型準確地展示了屋內的照明效果,并捕捉了日落過渡的細節。這進一步凸顯了因果建模在長時間上下文視頻生成任務中的優勢。

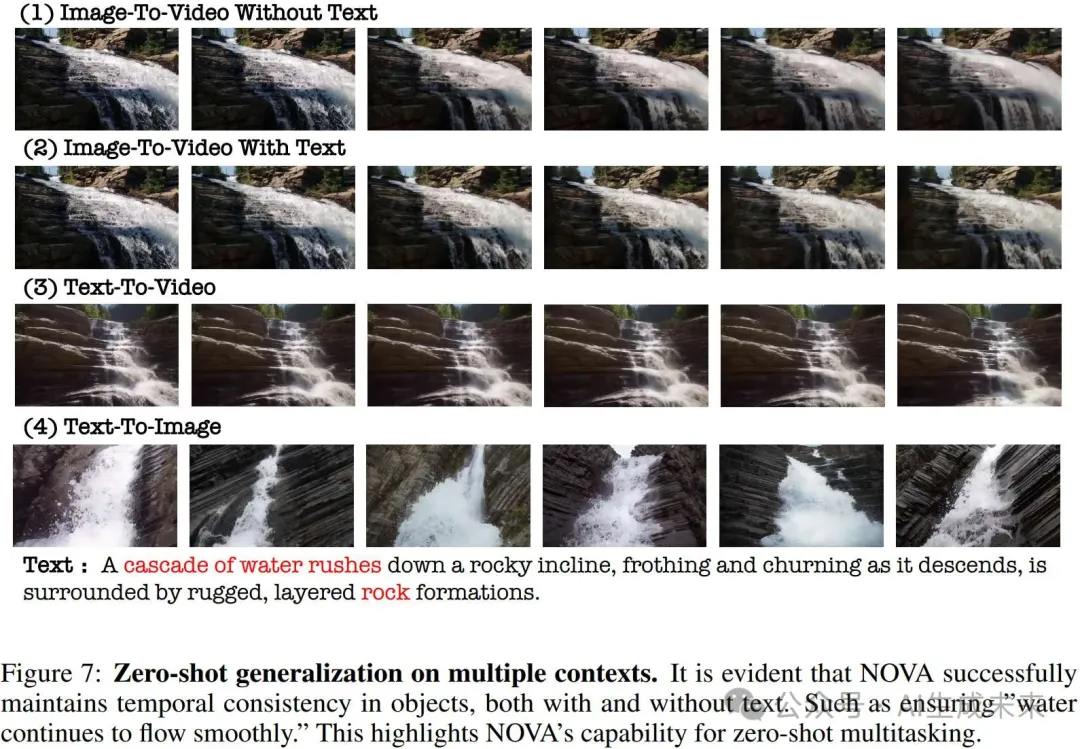

zero-shot 在多個上下文中的泛化能力

通過預填充參考圖像,NOVA 能夠生成圖像到視頻的轉換,無論是否有文本提示。在 圖 7 中,我們提供了一個定性示例,展示了 NOVA 在沒有文本提示的情況下模擬現實運動的能力。此外,當文本提示被包含時,透視運動顯得更加自然。這表明 NOVA 能夠捕捉到基本的物理規律,如相互作用力和流體動力學。

消融實驗

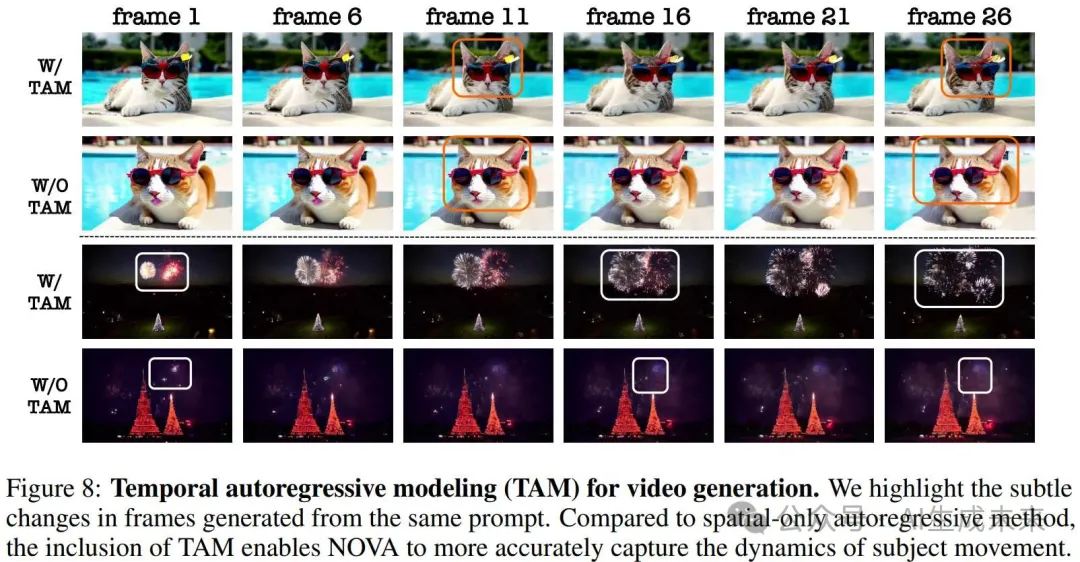

時序自回歸建模的有效性

為了突出時序自回歸建模的優勢,我們讓空間自回歸來完成視頻生成任務。具體來說,我們修改了時序層的注意力掩碼,改為雙向注意力,并使用按集合預測的方式隨機預測整個視頻序列。在相同的訓練迭代下,我們觀察到視頻中的物體運動減少(如 圖 8 所示)。此外,在跨多個上下文的zero-shot 泛化或視頻外推中,網絡輸出出現了更多的偽影和時間一致性問題。此外,這種方法在推理時不兼容 kv-cache 加速,導致隨著視頻幀數的增加,延遲線性增長。這進一步證明了因果建模在視頻生成中的優越性,優于多任務方法。

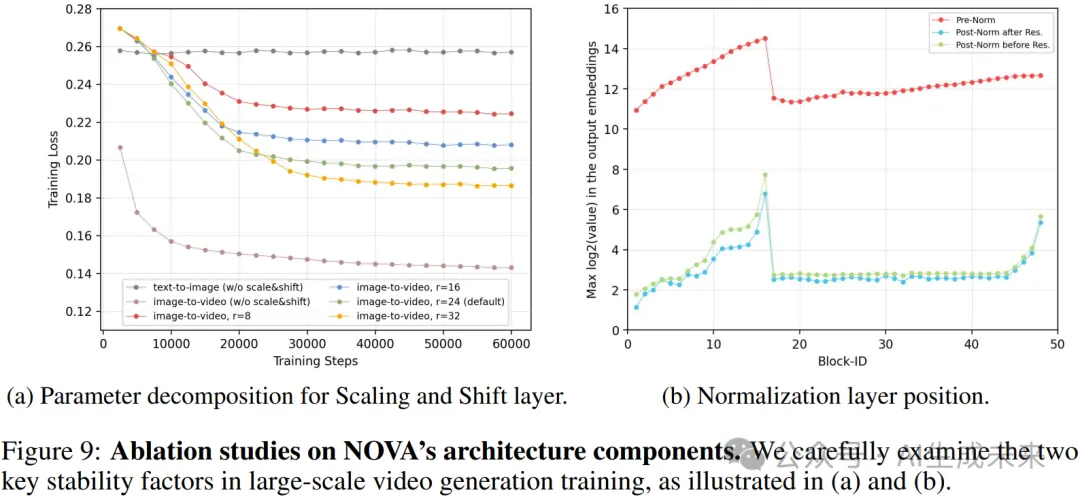

縮放和位移層的有效性

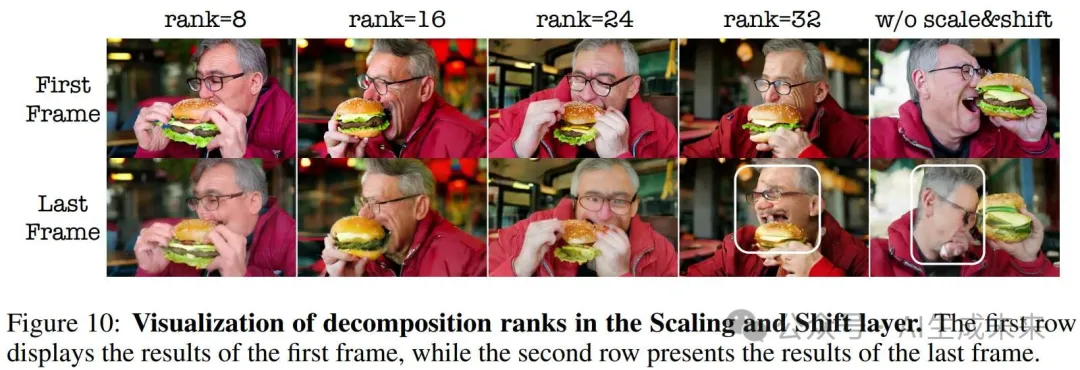

為了捕捉跨幀的運動變化,我們采用了一個簡單但有效的縮放和位移層,顯式地建模了來自 BOV 關注特征空間的相對分布。在 圖 9(a) 中,我們展示了這種方法顯著減少了文本到圖像生成和圖像到視頻生成損失之間的漂移。當我們逐漸減小 MLP 的內部秩時,訓練難度增加,導致網絡進行更加全面和魯棒的學習過程。然而,極低的秩值在運動建模方面會帶來挑戰,因為它們顯著限制了該層的表示能力(如 圖 10 所示)。在所有文本到視頻的實驗中,秩值默認為 24,從而實現了更準確的運動預測。

后歸一化層的有效性

從零開始訓練大規模的圖像和視頻生成模型通常面臨著混合精度的重大挑戰,這在其他視覺識別方法中也有類似表現。如 圖 9(b) 所示,使用預歸一化的訓練過程會遭遇數值溢出和方差不穩定的問題。嘗試了在殘差分支上應用各種正則化技術,如隨機深度和殘差 dropout,但發現這些方法效果較差。受到 (Liu et al. (2022)) 的啟發,引入了后歸一化,并通過實驗證明,后歸一化能夠有效地緩解輸出嵌入的殘差積累問題,相較于預歸一化,它能帶來更加穩定的訓練過程。

結論

NOVA,一種新型的自回歸模型,旨在同時實現文本到圖像和文本到視頻的生成。NOVA 在提供卓越的圖像質量和視頻流暢性的同時,顯著減少了訓練和推理的開銷。關鍵設計包括時間幀逐幀預測、空間集逐集生成,以及跨各種上下文的連續空間自回歸建模。大量實驗證明,NOVA 在圖像生成方面達到了接近商業質量,并在視頻生成中展現出令人滿意的保真度和流暢度。NOVA 為下一代視頻生成和世界模型鋪平了道路,提供了關于實時和無限視頻生成的寶貴見解和可能性,超越了像 Sora 這樣的擴散視頻模型。作為第一步,我們將在未來的工作中繼續進行更大規模的實驗和數據擴展,探索 NOVA 的極限。

本文轉自AI生成未來 ,作者:AI生成未來