微軟研究院MRP:大模型動態(tài)選擇最佳解題策略的元推理提示,比CoT、ToT更有效

大型語言模型(LLMs)在自然語言理解和生成方面表現(xiàn)出色,但面對現(xiàn)實世界問題的多樣性和復(fù)雜性,單一靜態(tài)方法的推理能力有限。現(xiàn)有的推理技術(shù),如思維鏈(Chain-of-Thoughts)、思維樹(Tree-of-Thoughts)等,雖然在特定任務(wù)上有所提升,但未能在不同任務(wù)中持續(xù)實現(xiàn)最佳性能。

人類在認知過程中通過元推理(meta-reasoning)動態(tài)調(diào)整策略,以高效分配認知資源。受此啟發(fā),提出了元推理提示(Meta-Reasoning Prompting, MRP),以賦予LLMs類似的適應(yīng)性推理能力。

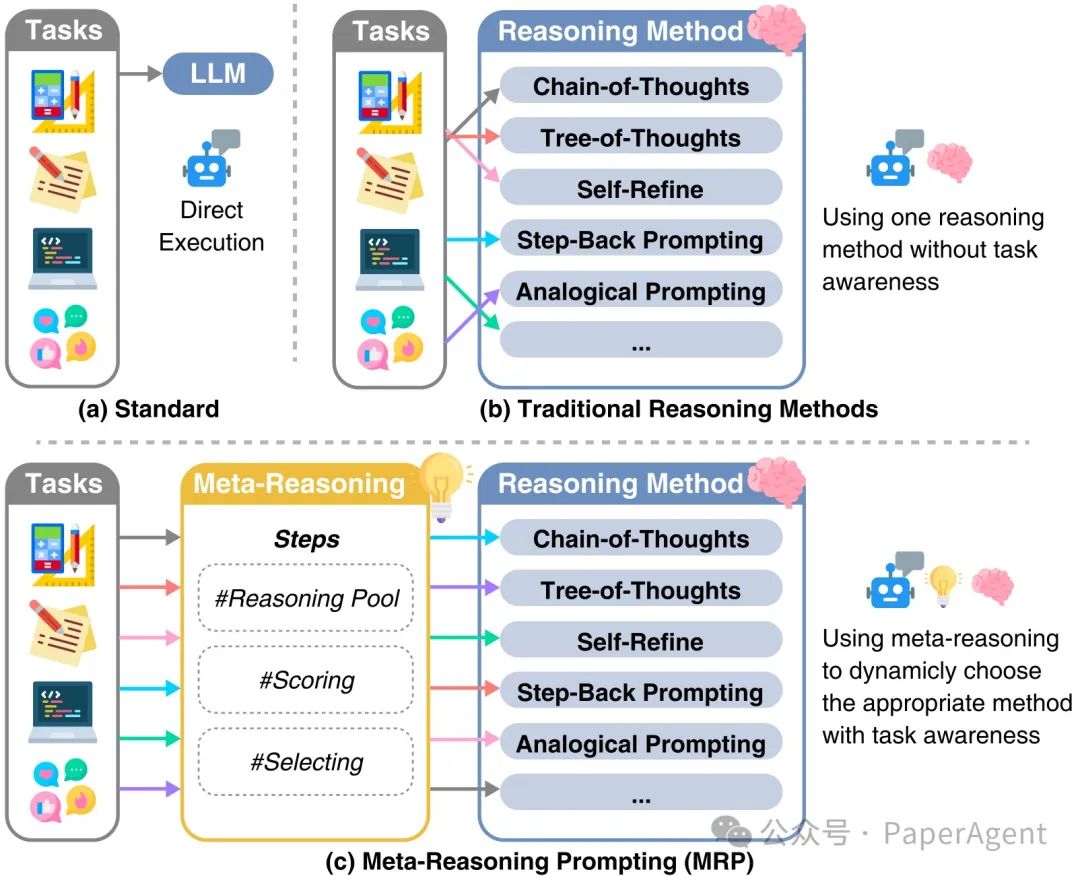

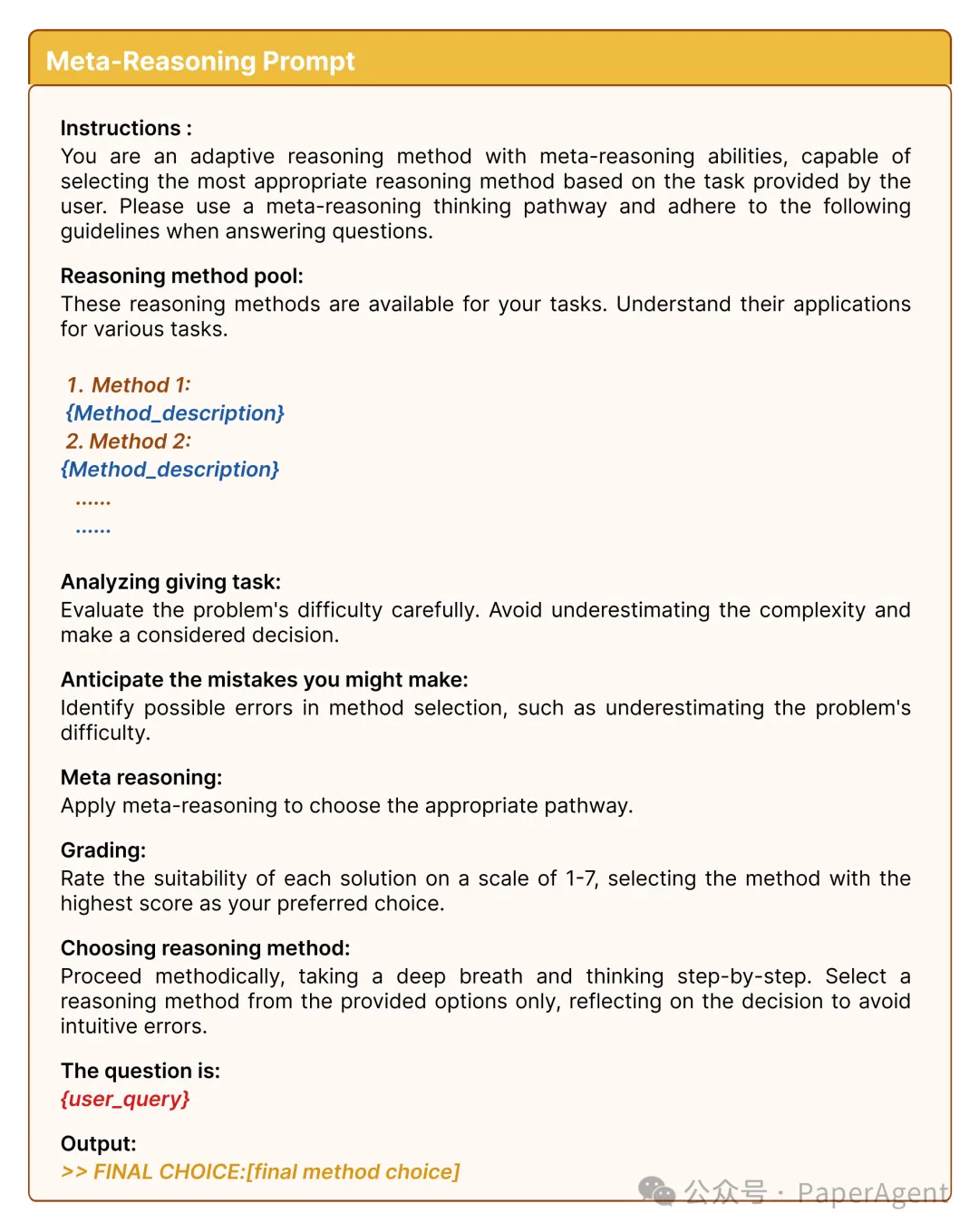

元推理提示(Meta-Reasoning Prompting,簡稱MRP)的示意圖,以及與標準推理和傳統(tǒng)推理方法的比較差異。

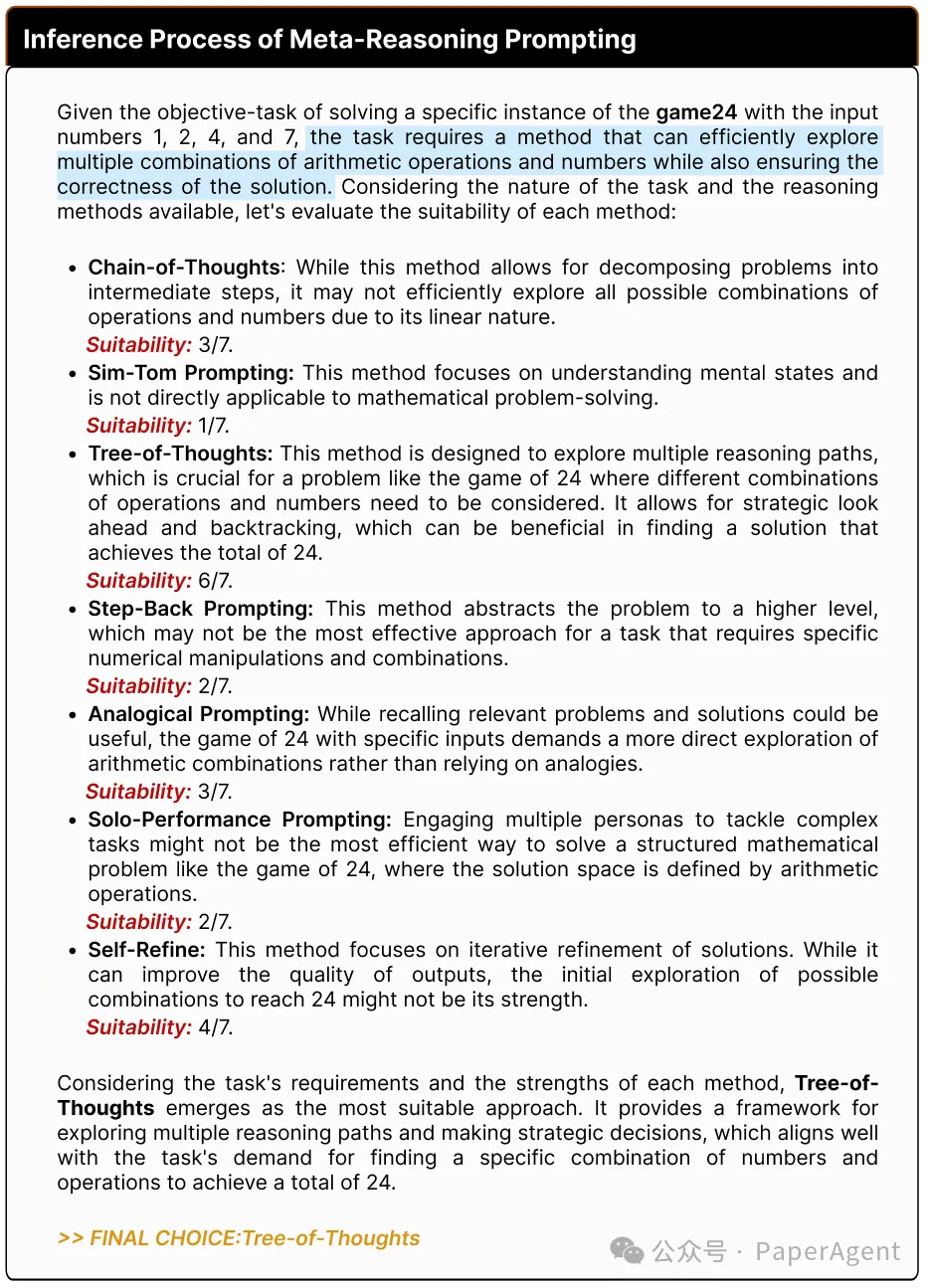

MRP如何工作?

- 評估階段:模型先看看有哪些解題方法可用,然后根據(jù)問題的特點,評估哪種方法可能最有效。

- 選擇階段:模型根據(jù)評估結(jié)果,選擇最合適的解題方法。

- 應(yīng)用階段:使用選定的方法來解決問題。

通過使用多個廣泛使用的基準測試評估MRP的有效性,結(jié)果表明MRP在不同任務(wù)中的表現(xiàn)達到或接近最佳狀態(tài)。MRP特別擅長需要結(jié)合不同推理策略的任務(wù),在更大的模型如GPT-4中表現(xiàn)尤為出色。

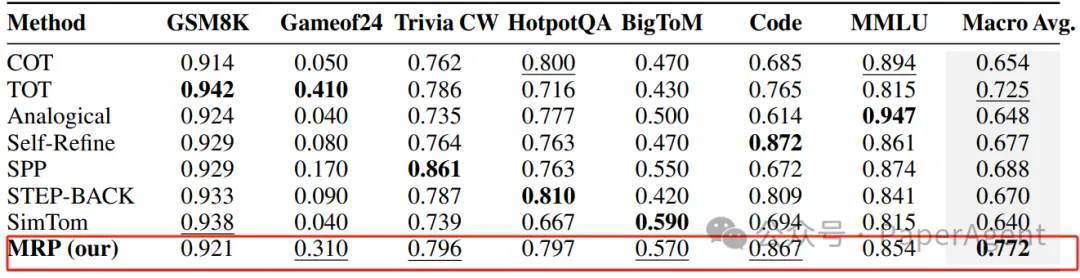

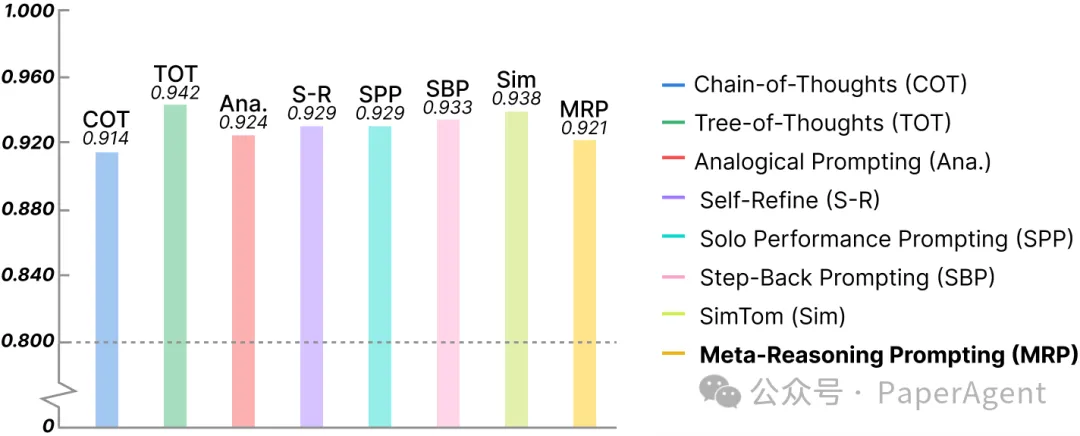

使用GPT4進行的實驗:使用元推理提示(Meta-Reasoning Prompting)與其他獨立方法在基準測試上的性能比較。加粗表示最佳性能,下劃線表示次佳性能。

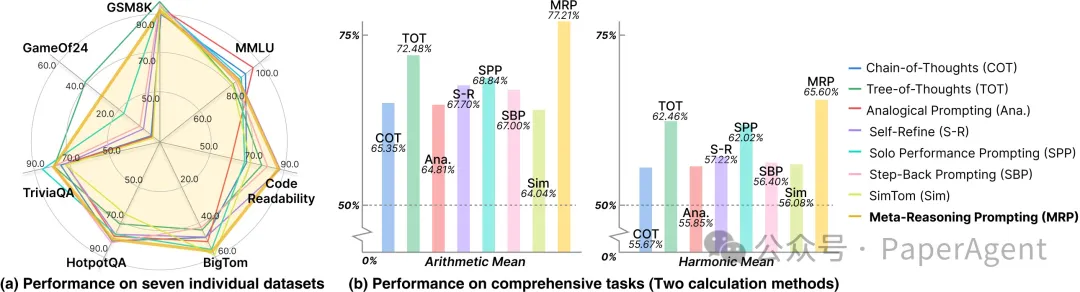

(a) 不同基準測試上的方法比較顯示,引導(dǎo)大型語言模型(LLM)動態(tài)選擇適當(dāng)?shù)耐评矸椒ǎ乖评硖崾荆∕RP)在所有任務(wù)中持續(xù)實現(xiàn)更好的性能。(b) 將特定推理方法應(yīng)用于所有基準測試的算術(shù)平均和調(diào)和平均性能表明,MRP在總體評估中始終表現(xiàn)卓越。

在GSM8K基準測試上的方法性能

Meta Reasoning for Large Language Models

https://arxiv.org/pdf/2406.11698本文轉(zhuǎn)載自??PaperAgent??