Apple 發布 AIMv2:最先進的開放集視覺編碼器系列 原創

01、概述

在計算機視覺領域,我們見證了視覺模型的飛速發展。每一次技術的革新都在解決前一代模型的局限性。然而,如何在復雜性、泛化能力和可擴展性之間找到平衡點,一直是研究者們面臨的挑戰。當前的許多模型在處理多樣化的視覺任務或適應新數據集時仍顯吃力。傳統的大規模預訓練視覺編碼器雖然取得了成功,但在擴展性和參數效率方面存在挑戰。市場急需一種強大而多功能的模型,能夠在不犧牲性能的情況下處理多種模態,如圖像和文本,同時不需要大量的數據篩選。

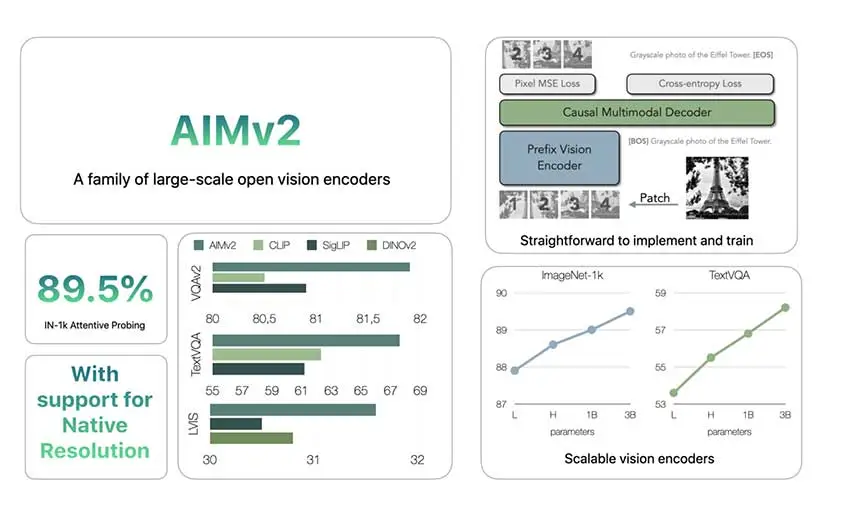

02、AIMv2:蘋果的新解決方案

蘋果公司通過發布AIMv2,迎接了這一挑戰。AIMv2是一系列開放式視覺編碼器,旨在提升現有模型在多模態理解和目標識別任務上的表現。受CLIP等模型的啟發,AIMv2增加了自回歸解碼器,使其能夠生成圖像塊和文本標記。AIMv2家族包含19個不同參數大小的模型——從300M到2.7B,支持224、336和448像素的分辨率。這種模型大小和分辨率的范圍使得AIMv2適用于不同的應用場景,從小型應用到需要大型模型的任務。

03、技術概覽

AIMv2采用了多模態自回歸預訓練框架,這一框架在傳統對比學習方法的基礎上進行了構建。AIMv2的關鍵特性是將視覺變換器(ViT)編碼器與因果多模態解碼器相結合。在預訓練期間,編碼器處理圖像塊,隨后與相應的文本嵌入配對。因果解碼器然后自回歸地生成圖像塊和文本標記,重建原始的多模態輸入。這種設置簡化了訓練過程,并促進了模型的擴展,而無需特殊的批次間通信或極大的批次大小。此外,多模態目標使AIMv2能夠實現比其他方法更密集的監督,增強了其從圖像和文本輸入中學習的能力。

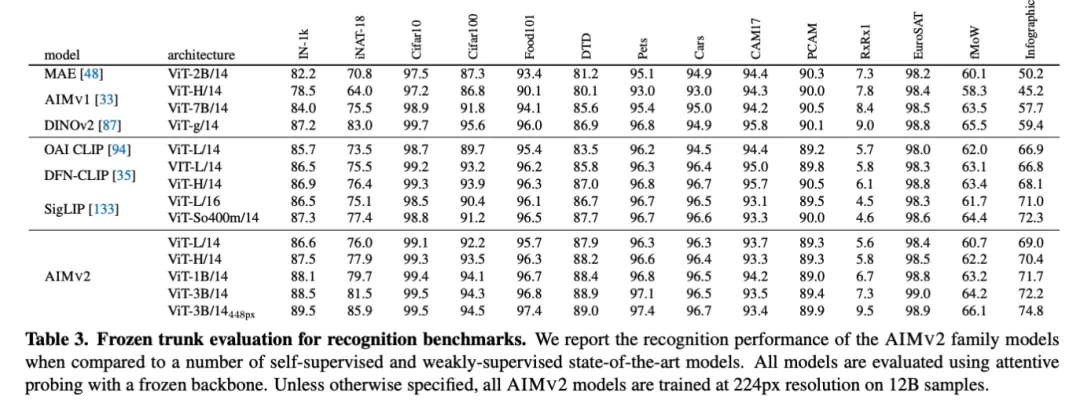

04、性能與可擴展性

AIMv2在大多數多模態理解基準測試中超越了OAI CLIP和SigLIP等主要現有模型。具體來說,AIMv2-3B在凍結樹干的情況下,在ImageNet數據集上達到了89.5%的top-1準確率,顯示出凍結編碼器模型的顯著魯棒性。與DINOv2相比,AIMv2在開放詞匯目標檢測和指代表達理解方面也表現良好。此外,AIMv2的可擴展性顯而易見,其性能隨著數據和模型大小的增加而持續提高。模型的靈活性和與現代工具(如Hugging Face Transformers庫)的集成,使其在各種應用中的實施變得實用且直接。

05、結論

AIMv2代表了視覺編碼器發展的一個重要進步,強調了訓練的簡單性、有效的擴展性和多模態任務的多功能性。蘋果發布AIMv2在多個基準測試上提供了比以往模型更好的改進,包括開放詞匯識別和多模態任務。自回歸技術的使用使AIMv2能夠實現密集監督,從而獲得強大而靈活的模型能力。AIMv2在Hugging Face等平臺上的可用性,使得開發者和研究人員能夠更容易地嘗試先進的視覺模型。AIMv2為開放式視覺編碼器樹立了新的標準,能夠應對現實世界多模態理解日益增加的復雜性。

參考:

- ??https://arxiv.org/abs/2411.14402??

- ??https://huggingface.co/collections/apple/aimv2-6720fe1558d94c7805f7688c??

本文轉載自公眾號Halo咯咯 作者:基咯咯