歐洲人工智能法案即將出臺,或影響全球科技監(jiān)管

人工智能法案旨在為人工智能的使用創(chuàng)建一個共同的監(jiān)管和法律框架,包括它是如何開發(fā)的,公司可以使用它做什么,以及不遵守要求的法律后果。該法案可能會要求公司采用人工智能前,在某些情況下需要獲得批準;并將某些被認為風險太大的人工智能用途定為非法,并創(chuàng)建一個其他高風險人工智能用途的公開清單。

歐盟委員會(European Commission)在一份有關該法律的官方報告中表示,在廣泛的層面上,該法律尋求將歐盟值得信賴的人工智能范式法制化。這一范式“要求人工智能在法律、倫理和技術上強大,同時尊重民主價值觀、人權和法治”。

擬議的人工智能監(jiān)管框架具有以下目標:

1.確保在歐盟市場上部署和使用的人工智能系統(tǒng)是安全的,并尊重現(xiàn)有法律基本權利和歐盟價值觀;

2.確保法律確定性,以促進人工智能的投資和創(chuàng)新;

3.加強治理和有效執(zhí)行有關基本權利和安全的現(xiàn)行法律適用于AI系統(tǒng);

4.促進合法、安全和值得信賴的人工智能應用的統(tǒng)一市場的發(fā)展,防止市場的分化。

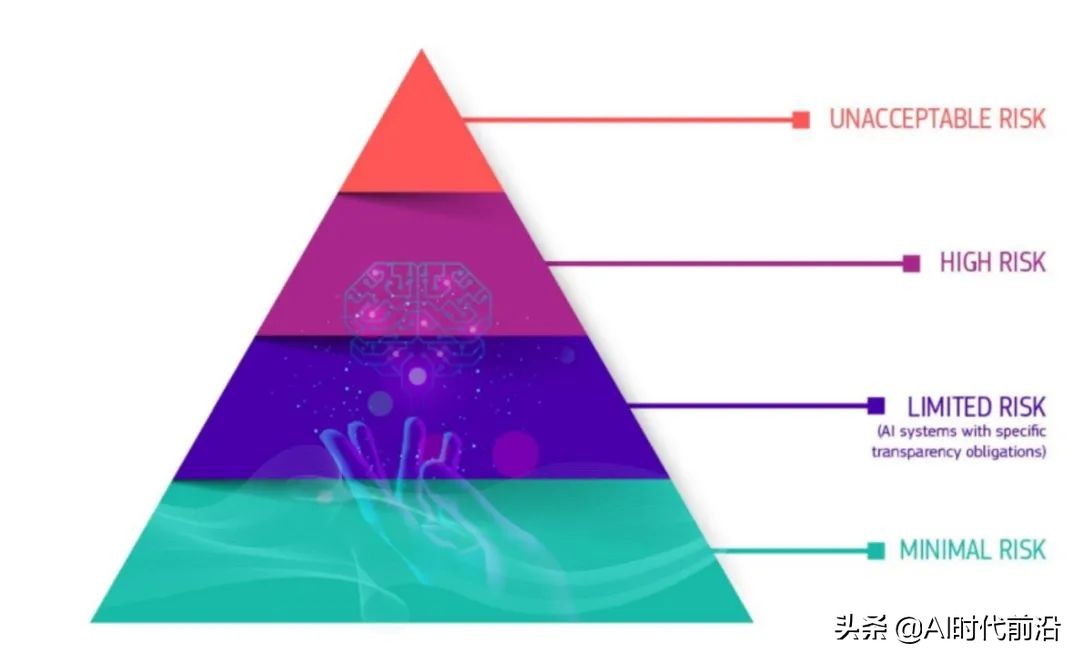

雖然新法律的許多細節(jié)仍懸而未決,關鍵是人工智能的定義,但核心因素似乎是它的“產(chǎn)品安全框架”,它將未來的人工智能產(chǎn)品分為四個安全水平類別,適用于所有行業(yè)。

根據(jù)斯坦福-維也納跨大西洋技術法律論壇的Maruritz Kop匯編的2021年歐盟委員會關于新法律的報告,“臨界金字塔”的底部是風險最小的系統(tǒng)。屬于這一類的人工智能應用不需要遵守風險較高的系統(tǒng)必須通過的透明度要求。在“有限風險”類別中,則對人工智能系統(tǒng)有一些透明度要求,比如聊天機器人。

——歐盟新的AI法案將AI程序分為四類,自下而上分別為:低風險、有限風險、高風險和不可接受風險。

在對透明度有嚴格要求的高風險AI類別中,監(jiān)管會更加嚴苛。根據(jù)介紹,高風險類別包括AI應用在:

- 關鍵基礎設施,如交通,可能危及人的生命或健康(如自動駕駛汽車);

- 影響個人教育或職業(yè)成就的教育或職業(yè)培訓(如考試成績);

- 產(chǎn)品的安全組件(如機器人輔助手術);

- 就業(yè)、員工管理、自主創(chuàng)業(yè)(如簡歷、簡歷分類軟件);

- 基本的私人和公共服務(如信用評分);

- 執(zhí)法用例(如證據(jù)評估);

- 移民、邊防管理(包括護照真實性評估);

- 公正和民主程序(如將法律適用于一組具體事實);

- 監(jiān)控系統(tǒng)(如生物特征監(jiān)測和面部識別)。

塔尖的第四類是“不可接受風險”的人工智能系統(tǒng)。這些應用基本上是非法的,因為它們帶來了太多的風險。這類應用的例子包括操縱行為或人或“特定弱勢群體”的系統(tǒng),社會評分,以及實時和遠程生物識別系統(tǒng)。

高風險類別可能是許多公司將努力確保透明度和合規(guī)的重點。歐盟的人工智能法案將建議企業(yè)在推出屬于高風險類別的人工智能產(chǎn)品或服務之前采取四個步驟。

- 開發(fā)高風險人工智能系統(tǒng),最好內(nèi)部首先使用人工智能影響評估和由包容、多學科團隊監(jiān)督的行為準則。

- 高風險人工智能系統(tǒng)必須經(jīng)過合格評定和批準,并持續(xù)進行在其生命周期內(nèi)遵守歐盟AI法案規(guī)定要求。某些系統(tǒng)外機構將參與合格評定審核。這個動態(tài)的過程確保基準測試、監(jiān)控和驗證。此外,高危AI的動態(tài)系統(tǒng),步驟2必須重復執(zhí)行。

- 獨立高風險人工智能系統(tǒng)的注冊將在一個專用的歐盟數(shù)據(jù)庫中進行。

- 必須簽署合格聲明,高風險AI系統(tǒng)必須帶有CE標記。?