智能體協作進化論,從心智理論到逆向注意力

讓智能體在不斷變化的環境中動態適應、并有效合作是一個巨大的挑戰,特別是當智能體需要與陌生的智能體互動時,傳統訓練方法往往表現不佳。這種情況下,引入逆向注意力智能體(Inverse Attention Agents)成為了一種創新且有效的解決方案。

逆向注意力智能體的核心在于借鑒“心智理論”(Theory of Mind, ToM),通過注意力機制來推斷其他智能體的目標和行為,并據此調整自己的行動。這種方法不僅能夠提升智能體在合作任務中的表現,還能在競爭和混合環境中表現出色。這一創新性的策略為多智能體系統的自發合作提供了新的思路,顯著改善了智能體在面對未見過的智能體時的適應能力。

提出逆向注意力智能體理論的是來自加州大學洛杉磯分校的團隊,他們研究目的在于設計和驗證一種能夠在多變環境中動態適應的新型智能體訓練方法——逆向注意力智能體。通過在多種環境中進行實驗,研究團隊展示了這種方法在提升智能體協作性能方面的顯著效果。逆向注意力智能體的創新點在于其對注意力權重的推斷和更新機制,這一機制使得智能體能夠基于對其他智能體注意力狀態的推斷,調整自身的行動,從而實現更為靈活和高效的合作。他們的論文《Inverse Attention Agent for Multi-Agent System》 10 月 30 日發表于arXiv。

這個研究團隊由來自加州大學洛杉磯分校(UCLA)的五位學者組成,分別來自計算機科學系、統計與數據科學系以及傳播學系。團隊成員包括:Qian Long、Ruoyan Li、

Minglu Zhao、Tao Gao、Demetri Terzopoulos。他們結合了計算機科學、數據科學和傳播學的專業知識,共同探索多智能體系統中的逆向注意力智能體,為該領域的研究提供了新的視角和方法。

相關工作

在多智能體系統(MAS)的發展歷程中,研究者們不斷探索如何提高智能體在復雜環境中的協作和適應能力。心智理論(Theory of Mind, ToM)作為人類理解他人心理狀態的能力,其概念引入MAS,為實現智能體之間的高效合作提供了新的路徑。ToM研究的一個核心目標是讓智能體能夠推測和理解其他智能體的內部狀態,從而制定更為有效的協作策略。在這一領域,注意力機制的引入為改進智能體的決策和協作能力提供了重要工具。

心智理論最早由心理學家提出,旨在解釋人類如何理解和預測他人的心理狀態。它包括對信念、欲望、意圖等心理狀態的推斷能力。在多智能體系統中,ToM被用來設計能夠模擬人類推理和決策過程的智能體,以實現更自然的協作。早期的ToM研究主要采用貝葉斯方法,通過觀測其他智能體的行為來推斷其心理狀態。這種方法提供了一個系統化的推理框架,但由于計算復雜度高,在大規模多智能體系統中應用存在一定困難。

近年來,隨著神經網絡和深度學習的興起,研究者們開始探索將ToM直接整合到神經網絡架構中的可能性。通過數據驅動的方法,智能體可以在互動中學習和表示其他智能體的心理狀態。特別是自注意力機制的發展,為智能體的狀態推斷和行為調整提供了新的手段。自注意力機制允許智能體根據觀察到的信息分配不同的權重,從而在決策過程中突出最重要的信息。這種方法不僅提高了推理的準確性,還增強了智能體在動態環境中的適應能力。

在此基礎上,逆向注意力智能體(Inverse Attention Agents)應運而生。該方法通過逆向推斷其他智能體的注意力狀態,并根據這些推斷結果調整自身的行為。逆向注意力智能體的創新在于其能夠推測其他智能體的目標和行為,并實時調整自己的行動策略,從而在各種復雜環境中表現出色。

即席團隊合作(Ad-Hoc Teaming)是多智能體系統中一個具有挑戰性的研究課題。即席合作要求智能體能夠在沒有預先協調和策略一致性的情況下,與陌生隊友進行高效合作。這種情境在現實世界中非常常見,例如災難救援、無人機編隊以及多智能體機器人系統中。然而,實現即席合作需要智能體具備快速適應和協調的能力,這對傳統的訓練方法提出了巨大挑戰。

現有的即席團隊合作方法主要集中在以下幾個方面。

基于類型的推理:將隊友表示為假設的行為類型,通過推斷隊友屬于哪種類型來選擇合適的行動策略。這種方法在一定程度上解決了陌生隊友之間的協作問題,但其推理過程復雜,且依賴于預先設定的類型分類。

基于神經網絡的推理:通過神經網絡從觀察數據中學習隊友的行為類型。這種方法具有較好的泛化能力,但其訓練過程需要大量數據支持,且在應對動態變化時可能表現不穩定。

共享代理框架:依賴于組級心理狀態的協調,在智能體之間建立對任務和目標的共同理解。這種方法可以有效減少推理的復雜性,但其靈活性和適應性較差,難以應對多樣化和動態變化的環境。

逆向注意力智能體的出現,為解決即席團隊合作中的挑戰提供了新的思路。通過逆向推斷和調整注意力權重,逆向注意力智能體能夠更好地理解隊友的目標和行為,并根據推斷結果實時調整自己的行動策略。這種方法不僅提高了智能體的協作能力,還增強了其在動態環境中的適應性。

馬爾可夫博弈及梯度場表示

在討論逆向注意力智能體的具體方法之前,首先需要了解一些基礎概念,即多智能體馬爾可夫決策過程(MDP)和梯度場(GF)表示。

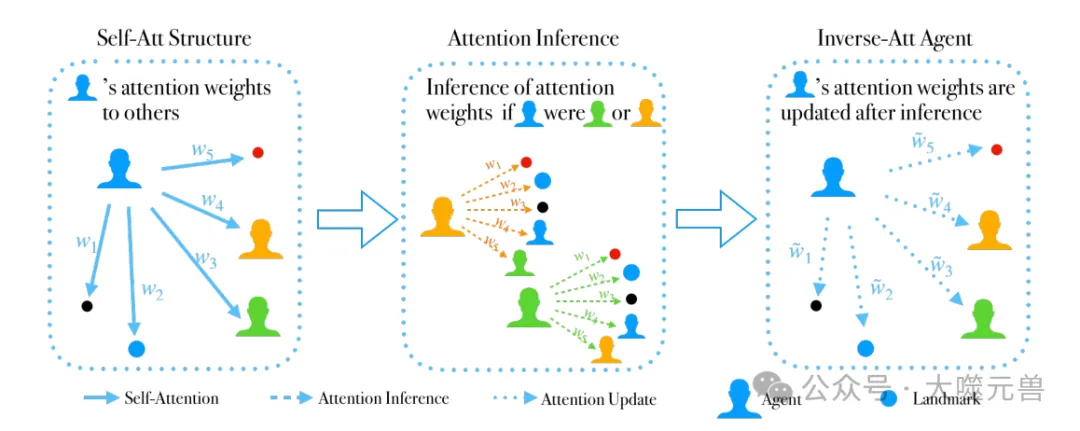

圖1:訓練反向注意力代理的管道:第一階段涉及應用自我注意力機制,其中代理為其觀察值分配注意力權重,并根據這些權重采取行動。在第二階段,智能體使用逆注意力網絡對同類型的其他智能體進行注意力推理。通過將自己置于這些智能體的位置,它推斷出它們的注意力權重,從而了解它們的目標和行為。在最后階段,反向注意力代理使用從上一步推斷出的信息將其原始注意力權重{w1,w2,…,wn}更新為{w^1,w^2,……,w^n},從而導致其最終動作的變化。

多智能體馬爾可夫決策過程(MDP)是一種框架,用于建模多個智能體在環境中的交互過程。MDP通常由以下幾個要素組成:

- 狀態集S:表示環境的所有可能狀態。

- 動作集Ai:每個智能體i的所有可能動作。

- 狀態轉移函數T:描述了在每個狀態下,各智能體選擇不同動作后,環境狀態的變化情況,記為T: S × A1 × · · · × AN → Δ(S)。

- 獎勵函數Ri:每個智能體i根據當前狀態和所有智能體的動作獲得的獎勵,記為Ri: S × A1 × · · · × AN → R。

- 策略πi:智能體i在每個狀態下選擇動作的概率分布,旨在最大化其期望的累計折扣獎勵,記為E[∑γ^t Ri(st, a1,t, ..., aN,t)]。

在多智能體強化學習(MARL)的背景下,智能體通過與環境和其他智能體的互動,不斷學習優化其策略πi,以便在復雜環境中實現最佳的長期收益。

梯度場(GF)表示是一種在多智能體系統中用于增強智能體環境感知和決策能力的高級表示方法。相比于直接使用環境的原始觀察,GF能夠提供更高層次的信息,幫助智能體更好地理解環境并做出更明智的決策。

具體來說,GF通過學習環境中數據的對數密度梯度場,即得分函數,來構建更具代表性的環境表示。這一過程利用去噪得分匹配(DSM)生成模型,通過多個不同噪聲級別的數據來訓練得分網絡,使其能夠近似環境中數據的真實得分函數。GF表示可以看作智能體在特定環境中的目標,與相對坐標等原始觀察相比,GF能夠更直接地表示與智能體目標一致的未來趨勢,從而提高智能體的決策效率和準確性。

理解了MDP和GF的基礎知識后,我們可以更深入地探討逆向注意力智能體的方法。逆向注意力智能體通過引入自注意力機制和逆向注意力推理網絡,實現對其他智能體的注意力狀態的推斷和自身行為的調整。

首先,智能體通過自注意力機制為觀察到的信息賦予不同的權重,從而在決策過程中突出最重要的信息。在訓練過程中,智能體會收集這些權重數據,形成訓練數據集。然后使用這些數據訓練逆向注意力推理網絡,使其能夠根據觀察到的其他智能體的行為和目標,推斷其注意力權重。

一旦逆向注意力網絡完成訓練,智能體就可以將其應用于實時環境中,通過推斷其他智能體的注意力狀態,調整自己的行動策略。這種方法不僅提高了智能體的協作能力,還增強了其在動態環境中的適應性。

為了驗證逆向注意力智能體的有效性,研究團隊在多個復雜環境中進行了實驗。實驗結果表明,逆向注意力智能體在多種任務中表現優越,包括合作、競爭以及混合任務。通過與傳統方法的比較,逆向注意力智能體在適應性和協作效率方面表現出顯著的優勢。

特別是在即席團隊合作的場景中,逆向注意力智能體能夠快速適應新隊友和新環境,實現高效合作。這一結果表明,通過逆向推斷和調整注意力狀態,智能體能夠更好地理解和響應其他智能體的行為,從而在多智能體系統中取得更佳表現。

問題定義

在多智能體系統(MAS)中,各個智能體在環境中自主行動,協調合作以實現共同目標。為了在復雜且動態的環境中有效運作,智能體需要制定去中心化的策略,這意味著每個智能體都能獨立決策,而不依賴于中央控制系統。研究團隊提出了一種創新的逆向注意力智能體(Inverse Attention Agents),旨在提升智能體在這些條件下的協作能力。

在完全可觀察的多智能體環境中,每個智能體可以獲取關于其他智能體的所有信息,包括其行動和狀態。這種全知全能的環境設定為研究逆向注意力智能體提供了理想條件。在這樣的環境中,智能體通過對其他智能體行為的觀察,推斷其內在狀態,從而優化自己的決策過程。然而這也帶來了新的挑戰,需要智能體具備高度的靈活性和適應能力。

去中心化策略目標

去中心化策略的目標是讓每個智能體獨立地學習和執行決策,以實現整體系統的最優性能。在多智能體系統中,這一目標尤其重要,因為各個智能體常常需要在沒有預先協調和統一指令的情況下進行合作。為了實現這一目標,智能體需要在以下幾個方面進行優化:

- 自主決策:每個智能體都能夠基于自身的觀測和經驗,獨立制定最優策略。

- 動態適應:智能體能夠根據環境和其他智能體行為的變化,實時調整其策略。

- 高效協作:智能體能夠在沒有中央控制的情況下,通過推斷和預測其他智能體的行為,實現高效合作。

目標實現所需的條件和挑戰

為了實現去中心化策略目標,逆向注意力智能體需要滿足以下三個條件。

- 全面的環境感知能力:智能體需要能夠全面感知環境中的信息,包括其他智能體的狀態和行動。這要求智能體具備高效的感知和信息處理能力。

- 準確的狀態推斷能力:智能體需要能夠準確推斷其他智能體的內在狀態,包括其目標和意圖。這需要智能體具備強大的推理和預測能力。

- 靈活的策略調整能力:智能體需要能夠根據推斷結果,靈活調整自身的策略,以實現最優決策。這要求智能體具備快速學習和適應能力。

在實現這些條件的過程中,逆向注意力智能體面臨以下幾個主要挑戰:

信息處理的復雜性:在完全可觀察的環境中,智能體需要處理大量的信息,包括其他智能體的狀態和行動。這要求智能體具備高效的信息處理和存儲能力。

狀態推斷的準確性:智能體需要能夠準確推斷其他智能體的內在狀態,這對于實現高效合作至關重要。然而,推斷過程往往涉及復雜的計算和不確定性,可能導致推斷結果的偏差。

策略調整的實時性:智能體需要能夠根據環境變化和推斷結果,實時調整其策略。這要求智能體具備快速響應和適應能力,以應對動態變化的環境。

通過引入逆向注意力機制,研究團隊提出的方法在一定程度上克服了上述挑戰。逆向注意力智能體通過對其他智能體行為的逆向推斷,調整自身的注意力權重,從而優化決策過程。這種方法不僅提高了智能體的協作能力,還增強了其在動態環境中的適應性。

逆向注意力智能體的方法論

為了實現上述目標,研究團隊采用了以下步驟來構建逆向注意力智能體。

通過自我注意機制,智能體能夠為其觀察到的信息分配不同的權重,從而在決策過程中突出最重要的信息。這個階段還為訓練逆向注意力網絡準備了必要的數據。

在收集了足夠的數據對之后,使用這些數據訓練逆向注意力推理網絡。該網絡能夠基于其他智能體的目標和行動,推斷其注意力權重。

使用訓練好的逆向注意力網絡,智能體能夠實時推斷其他智能體的注意力狀態,并根據推斷結果調整自己的策略。

這種方法不僅實現了智能體間的高效協作,還顯著提升了智能體在面對未知環境和未見過的智能體時的適應能力。實驗結果表明,逆向注意力智能體在多種任務中表現優越,無論是合作任務、競爭任務還是混合任務,都表現出了強大的適應性和高效性。

方法介紹

在多智能體系統(MAS)中,各個智能體如何在動態復雜的環境中進行有效合作,是一個重要的研究課題。研究團隊提出了一種創新的逆向注意力智能體(Inverse Attention Agents),通過引入自我注意機制和注意力推理網絡,優化智能體的決策過程

自我注意機制的應用與數據準備

逆向注意力智能體首先利用自我注意機制來處理觀察到的信息。自我注意機制允許智能體根據環境中的不同目標分配注意力權重,從而在決策過程中突出最重要的信息。這一機制的引入,使得智能體能夠更靈活地應對環境變化,并在處理大量信息時保持高效。

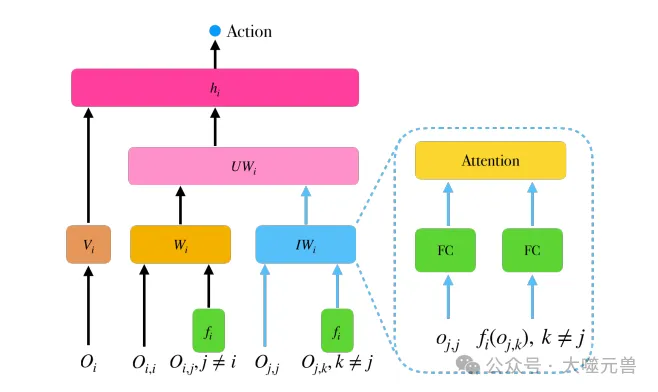

圖2:逆向注意力代理的網絡架構。對于代理i,Wi是觀察嵌入函數,它接收觀察并輸出初始注意力權重。IWi是一個逆向注意力網絡,它接收其他智能體的動作和觀察,并輸出推斷出的注意力權重。UWi考慮了自初始權重和從他人推斷的權重,并更新了ai的注意力權重。hi函數根據更新的權重輸出最終動作。

在具體應用中,智能體通過一個自我注意網絡(Self-Attention Network)來處理其觀測到的狀態信息。該網絡將觀測到的狀態進行嵌入(embedding),并通過注意力機制計算出各個目標的權重。然后,智能體根據這些權重來決定其下一步的行動。

在訓練過程中,智能體會不斷收集其注意力權重和對應的觀察數據對(wi, oi),并將這些數據存儲在一個訓練數據集中(Dataset D)。這些數據為后續訓練注意力推理網絡提供了必要的基礎。

注意力推理網絡的訓練和逆向注意力智能體的構建

有了自我注意機制收集的數據,下一步是訓練注意力推理網絡(Attention Inference Network)。該網絡的目標是根據觀察到的其他智能體的行為,推斷其注意力狀態。

具體而言,注意力推理網絡通過以下步驟進行訓練:

- 數據收集:從自我注意網絡訓練的過程中,收集注意力權重和觀察數據對,并保存在數據集中。

- 訓練目標:利用收集的數據集,訓練一個逆向注意力推理網絡。該網絡的輸入是其他智能體的觀察數據,輸出是推斷的注意力權重。

- 損失函數:通過最小化預測權重和實際權重之間的誤差,來優化推理網絡的性能。

逆向注意力智能體通過逆向注意力推理網絡,將其他智能體的注意力狀態和自身狀態結合起來,形成新的注意力權重。這些更新后的注意力權重,使智能體能夠更好地適應環境變化,并在合作和競爭中做出更優決策。

逆向注意力智能體的整體架構與策略

逆向注意力智能體的整體架構由多個網絡模塊組成,每個模塊在訓練和決策過程中發揮特定的作用。

首先,智能體通過自我注意網絡來處理其觀測到的環境信息,計算并分配注意力權重。這些注意力權重用于決定智能體的初始行動策略。在訓練過程中,智能體會不斷收集這些權重和觀察數據,形成訓練數據集。

接下來,智能體利用這些數據,訓練逆向注意力推理網絡。該網絡基于其他智能體的觀察和行為,推斷其注意力狀態。推理網絡的輸出與智能體的原始注意力權重結合,形成新的注意力權重。

最后,智能體通過一個權重更新模型(Weight Updating Model),將推斷的注意力權重和自身的原始權重結合,并通過一個全連接網絡更新其最終注意力權重。基于這些更新后的權重,智能體能夠在不同環境中實時調整其策略,做出更優的決策。

逆向注意力智能體的策略實現過程如下:

初始階段:應用自我注意機制,對觀測到的環境信息進行處理,并為各個目標分配初始注意力權重。

推理階段:使用逆向注意力推理網絡,基于其他智能體的行為和目標,推斷其注意力狀態。

更新階段:將推斷的注意力權重與自身的原始權重結合,通過權重更新模型,優化最終的注意力權重。

實驗與結果

為了驗證逆向注意力智能體的有效性,研究團隊在多個復雜環境中進行了實驗。這些環境包括完全合作游戲、完全競爭游戲以及混合游戲,每種環境都具有不同的挑戰和特性。實驗結果表明,逆向注意力智能體在這些環境中表現出色,無論是在合作、競爭還是混合任務中,都顯著優于傳統方法。

特別是在即席團隊合作場景中,逆向注意力智能體能夠快速適應新隊友和新環境,實現高效合作。這一結果證明,通過逆向推斷和調整注意力狀態,智能體能夠更好地理解和響應其他智能體的行為,從而在多智能體系統中取得更佳表現。

實驗環境與基線方法的選擇

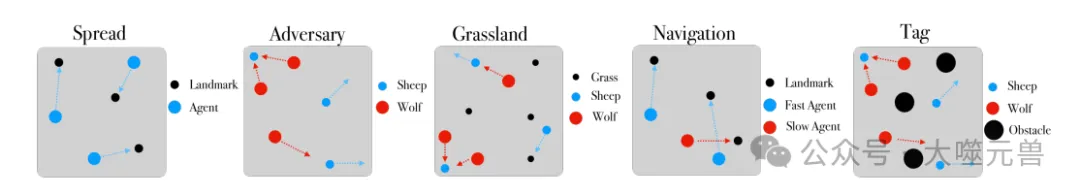

圖3:傳播、對手和草原游戲的環境可視化。

本研究在多個實驗環境中驗證了逆向注意力智能體的性能,這些環境包括:

- Spread:一個完全合作的游戲,智能體需要在多個地標間進行分布。

- Adversary:一個完全競爭的游戲,涉及“狼”和“羊”兩種智能體類型,狼捕捉羊,而羊試圖逃脫。

- Grassland:一個混合游戲,包含“羊”、捕捉它們的“狼”、以及可以收集的“草”。

- Navigation:一個需要智能體導航到不同地標的合作游戲。

- Tag:一個混合游戲,狼追逐羊并盡量避開障礙物。

為了進行比較,研究團隊選擇了幾種基線方法:

- MAPPO:多智能體近端策略優化算法(Multi-Agent Proximal Policy Optimization)。

- IPPO:個體近端策略優化算法(Individual Proximal Policy Optimization)。

- MAA2C:多智能體優勢演員評論算法(Multi-Agent Advantage Actor-Critic)。

- ToM2C*:改編自 Wang 等人的心智理論方法。

- Self-Att:采用研究團隊5.1節提到的自注意力結構。

- Inverse-Att:研究團隊提出的逆向注意力智能體。

所有基線方法均經過相同量的訓練,確保在評估期間不會接觸到其他方法的智能體,以保證公平性。

量化結果分析與討論

在量化分析中,研究團隊對所有實驗環境中的智能體進行了訓練和評估。在Spread游戲中,各個方法的表現如表1所示:

MAPPO、IPPO、MAA2C在合作任務中的表現相對較差。

Self-Att 和 Inverse-Att 的表現顯著優于其他方法,尤其是 Inverse-Att 在多個環境中展現了卓越的合作和競爭能力。

這一結果表明,逆向注意力智能體在多種任務中都能保持穩定且優越的表現,不僅適用于合作任務,也能在競爭和混合任務中展現出色的適應性。

不同規模下的逆向注意力智能體性能測試

為了進一步驗證逆向注意力智能體的可擴展性,研究團隊在不同規模的智能體環境中進行了測試。具體而言,在Spread、Adversary和Grassland游戲中,評估了2、3、4個智能體的情況。

結果顯示,逆向注意力智能體在所有測試規模下均表現出色,特別是在合作相關的游戲中。這一發現證明了逆向注意力智能體不僅能適應多樣化的環境,還能有效擴展到更大規模的多智能體系統中。

與人類參與者的合作實驗結果

為了評估逆向注意力智能體在實際合作場景中的適應性,研究團隊進行了人類實驗。在Spread、Grassland和Adversary游戲中,五名參與者與智能體合作完成任務。實驗結果表明,Self-Att 和 Inverse-Att智能體在多數環境中表現優于人類參與者,尤其是在適應性和穩定性方面。

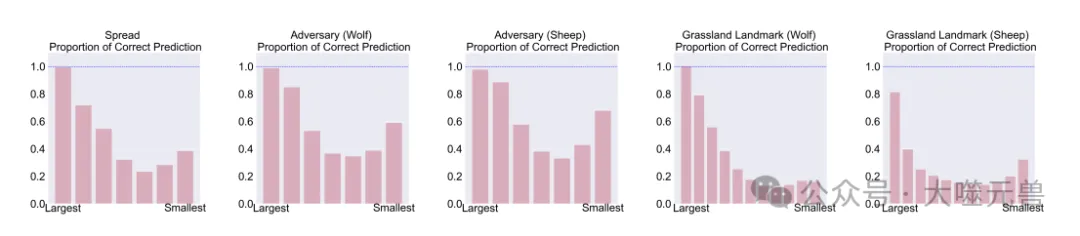

圖4:我們評估了在{傳播:3,對抗:3?3和草原:3-3}的尺度下,反向注意力網絡在傳播、對手和草原環境中的五個角色的預測準確性。在每個條形圖中,從左到右,我們顯示了從參與人數最多的目標到參與人數最少的目標的預測精度。結果表明,逆網絡可以準確地預測其他智能體的注意力,特別是對前兩個感興趣的注意力。

這表明,逆向注意力智能體不僅在模擬環境中表現出色,也能在實際合作場景中與人類有效互動,展示出強大的適應能力和協作潛力。

多個逆向注意力智能體的影響分析

研究團隊還探討了多個逆向注意力智能體同時存在時的影響。通過逐漸替換MAPPO智能體為逆向注意力智能體,實驗發現,隨著逆向注意力智能體數量的增加,團隊總獎勵呈現非線性遞增模式。

這一發現強調了逆向注意力智能體在多智能體系統中的協作優勢,證明了其能夠與其他智能體高效合作,從而在復雜任務中取得更佳的表現。

逆向注意力網絡的預測精度

為了驗證逆向注意力網絡的預測精度,研究團隊收集了大量的權重觀察數據對,作為注意力的基準。通過將這些數據輸入逆向注意力網絡,并比較預測結果與基準的差異,發現逆向注意力網絡能夠準確預測其他智能體的注意力狀態,特別是在最重要的兩個注意力目標上,預測精度接近100%。

這一結果證明了逆向注意力網絡在推斷其他智能體注意力狀態方面的高效性和準確性,為智能體的實時決策提供了可靠支持。

未來工作

雖然研究團隊的研究已經取得了顯著成果,但未來仍有許多值得探索的方向。首先,目前的逆向注意力智能體主要針對同類型智能體的推理,未來可以進一步研究不同類型智能體之間的心智理論建模,以提升智能體在多樣化環境中的適應性和協作能力。此外,研究團隊還計劃開發一種能夠處理任意數量推斷注意力權重的UW網絡模型,從而增強智能體在復雜任務中的靈活性。

逆向注意力智能體的廣泛影響主要體現在其在多智能體強化學習(MARL)中的應用潛力。通過推斷和調整注意力狀態,逆向注意力智能體能夠在動態環境中實現更為高效的協作和決策。這一創新方法有望在多個實際應用場景中發揮作用,如機器人群體協作、智能交通管理、無人機編隊等。

在智能社會的發展中,自主系統的智能化和協作能力至關重要。逆向注意力智能體通過引入心智理論和注意力機制,為自主系統的智能化提供了新的路徑。隨著這一領域研究的不斷深入,未來有望看到更多智能體在實際應用中展現出強大的協作和適應能力,從而推動技術進步和社會發展。(END)

參考資料:https://arxiv.org/abs/2410.21794

本文轉載自 ??大噬元獸??,作者: FlerkenS